李宏毅老师机器学习笔记(第一节--基本概念)

机器学习(Machine Learning)(Looking for Function)

一、The types of Function

1、Regression: The function outputs a scalar 输出一个数量2、Classification :Given options(classes),the funciton outputs the correct one.输出一个正确的选项3、Structured Learning(结构化学习)4、Create something with structure(输出结构化的东西)二、怎样找到一个Function

模型名称:Linear models

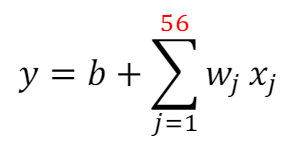

以YouTube的后台推送数量说明

1、Function with Unknown Parameters

设y=b+w*x(1)

y:明天的推送数量

w和b是未知参数

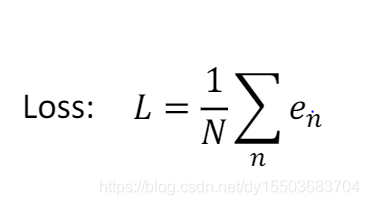

2、定义一个Loss函数L(b,w)

Loss:how good a set of value is

从后台数据中进行比对:

具体做法:将前一天的阅读量为x , b 和w 任取,带入程式后计算与后一天阅读量的差的绝对值e,最后对这些差的绝对值e取平均值L(e可以取差的平方)

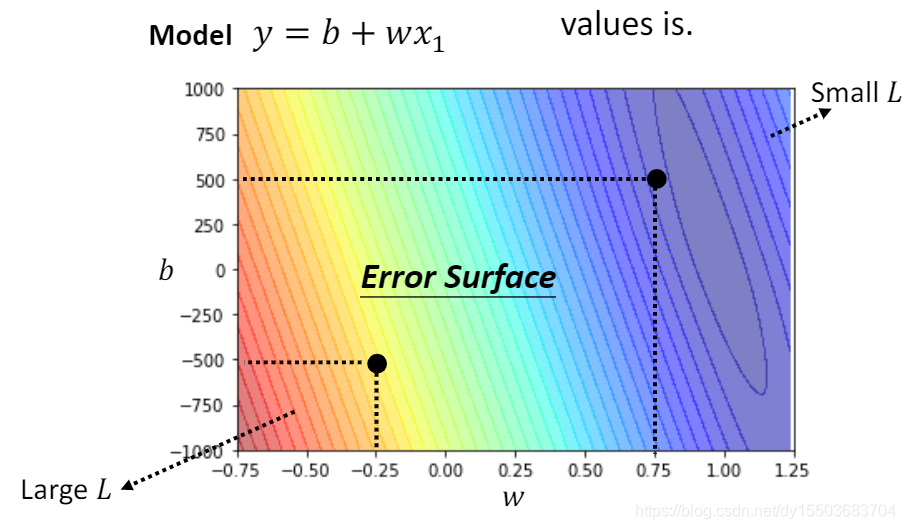

最后通过数据计算出b和w的最佳值

例:YouTube的计算结果:

3、Optimization(最佳化)(只对w进行描述,b的计算方法相同)

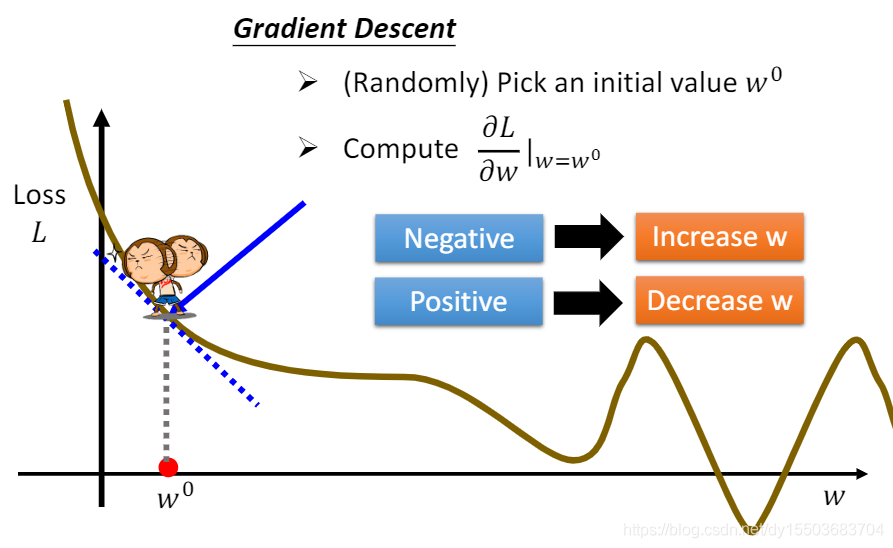

方法:Gradient Descent

1、随机选去一个w0点,计算w0对L的微分(切线斜率)

切线斜率值为负,则表示需要增大w

切线斜率值为正,则表示需要减小w

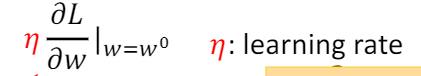

另一个影响因素:learning rate(学习速率)(自己设定)

值过大表示修改的跨度大,值过小表示修改的跨度小

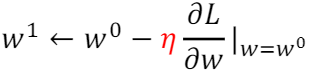

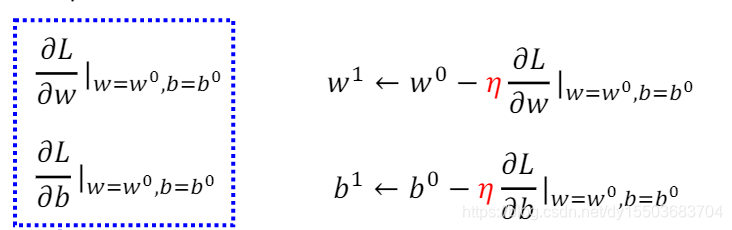

新的计算结果为

在采用之前的方法重复计算,不断更新w的值,直至找到最佳的值

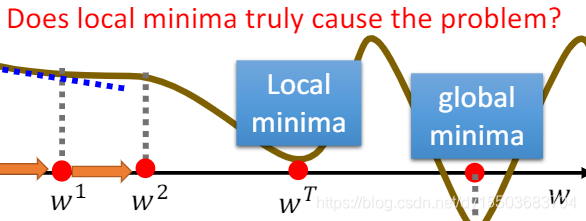

Gradient Descent 的缺点:

当计算到Local minima(局部极小点)会停止计算

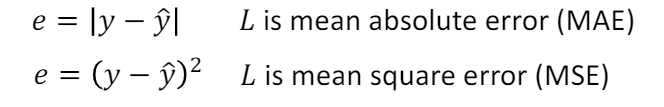

扩展到两个参数时:

不断更新w和b的值,直到找到最佳点

人为干涉作进一步的优化

可以令

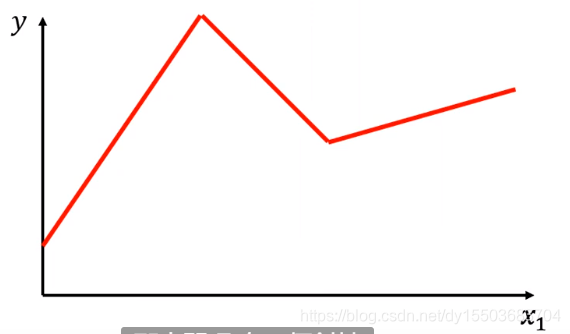

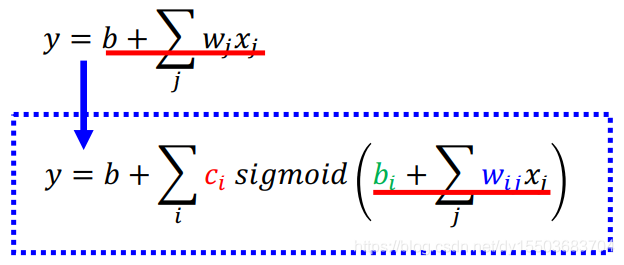

以上可以统称为Linear model(线性模型) 因显示情况的复杂性,我们需要找出一种更加适合的模型

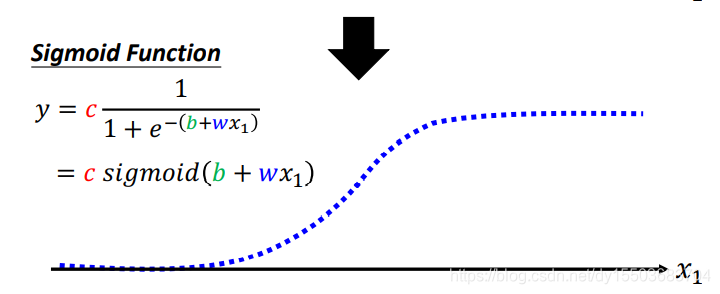

对于一个分段函数 我们就可以将其表示为

我们就可以将其表示为

其中C 表示常数

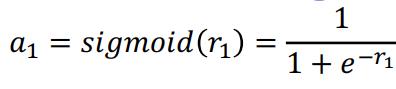

对于分段函数的每一个分段都可以用一个Sifmoid Function来表示,最后将每一个分段进行相加

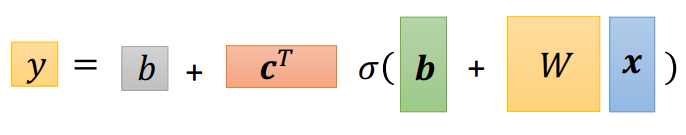

综合之前的线性模型得出的结论后可得

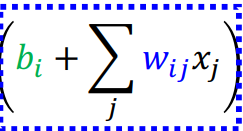

进一步转化,将sigmoid函数中的式子转化为线性代数即

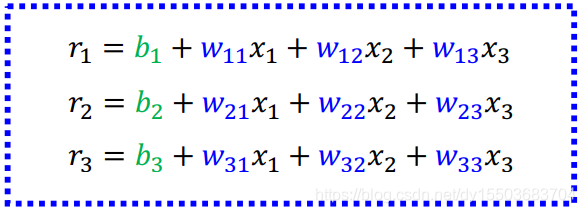

可化为 (i:1,2,3 j:1,2,3)

则可以表示为

r = b + w*x

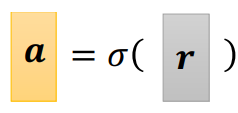

令

故

x表示未知参数

未知变量:w 第一个b表示数值 第二个b表示向量 c

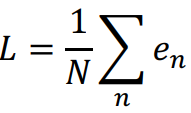

计算Optimization L表示所有的y与标准y^的差的平均值

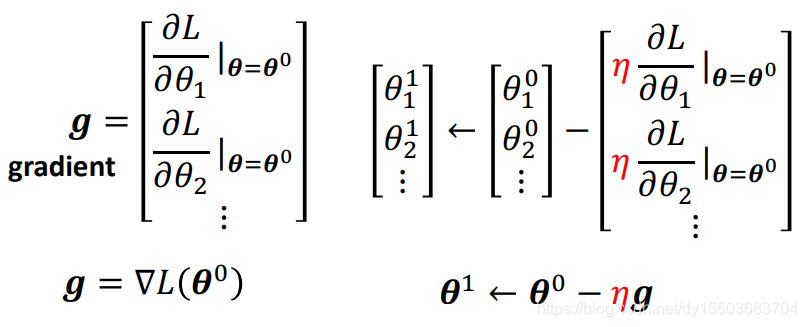

将所有的未知参数放入θ[θ1,θ2,θ3…] 集合数组中

随机取初始的θ0,计算L对于各个θ的微分,如下图所示

循环往复计算θ(1),θ(2),θ(3),θ(4)…直至取得最后的结果