GM DC Monitor v2.1平台部署手册分享

官网有大量的材料可参考,欢迎访问:www.gm-monitor.com 学习与支持 栏目

一、兼容系统(列表已测)

系统版本范围

容器版本范围

测试结果

Centos(7-8)

docker-ce-(19 - 26)

通过

Rockey(8.5-8.10)

docker-ce-(19 - 26)

通过

Ubuntu(18-24)

docker-ce-(20 -28)

通过

Debian(9-10)

docker-ce-(18 -19)

通过

Debian(11-12)

docker-ce-(20 -28)

通过

OpenSUSE(15)

docker-ce-(20 )

通过

Alma(8-9)

docker-ce-(19 -28)

通过

二、环境准备(以centos7.9例)

CPU:4-8C

Memory:16G

Disk: 300-500G (建议使用lvm可扩容模式)

系统:CentOS Linux release 7.9.2009 (Core)

Docker: Server Version: 26.1.4

操作账号:root

平台将会占用端口:TCP:9200,9300,80,5669,5670,6379,8000,8022,3306;UDP:162

三、操作系统和安装环境初始化

3.1、安装操作系统使用:最简模式

3.2、系统安装后

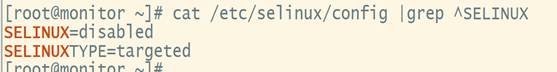

3.2.1、关闭selinux

3.2.2、关闭firewalld

![]()

重启系统:reboot

3.3、在线安装docker

3.3.1、上传docker.repo

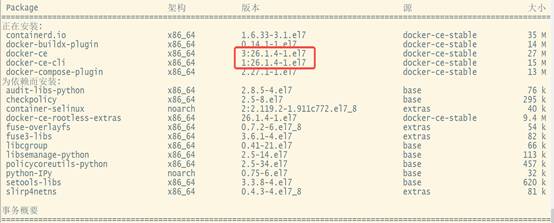

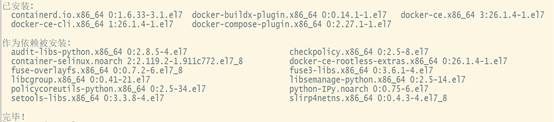

3.3.2、安装docker-ce:

yum –y install docker-ce docker-ce-cli containerd.io docker-buildx-plugin docker-compose-plugin

四、安装步骤

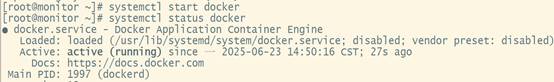

4.1、启动docker服务

配置docker开机自启动:systemctl enable docker

4.2、安装监控系统,操作如下

tar zxvf gm-monitor-v2.1.tar.gz

cd gm-monitor-v2.1

cd db # 安装数据库并初始化数据库

./auto-install.sh xxx (备注:xxx是自定义数据库root密码)

cd ../app # 安装一体化监控预警平台

./auto-install.sh

cd ../es # 安装知识库

./auto-install.sh

五、登陆平台

通过游览器登陆监控平台 http://IP地址

默认账号密码为: admin 密码为:1WSX@qaz!@

至此,一体化监控平台安装部署完毕。

六、安装拨测集群从节点

6.1、环境准备

准备一台独立的服务器

硬件配置:最低配置建议(2-4C/4G内存/50G硬盘)

软件:已安装了docker(可参考文档开头的系统安装及环境初始化)

节点安装时需要准备以下信息:

1:监控系统安装时的数据库root密码,(举例:abc123)

2:监控服务器IP,(举例:192.168.1.1)

3:从节点服务器IP,(举例:192.168.1.2)

6.2、监控系统为从节点授权(监控系统侧执行)

cd gm-monitor-v2.1/dial/

./add_db_user.sh abc123 192.168.1.2

解释:

Abc123: 为上面举例的数据库root密码

192.168.1.2:为上面举例的授权的拨测从节点IP

6.3、从节点安装应用(从服务器侧执行)

将gm-monitor-v2.1/dial/ 目录打包传送到从节点服务器,运行:

./auto-install.sh # 根据提示输入即可,举例如下:

==> 请根据以下提示输入初始化数据 <==

输入监控预警平台数据库IP:192.168.1.1

输入监控预警平台数据库端口:3306

输入监控预警平台REDIS IP:192.168.1.1

输入监控预警平台REDIS端口:6379

输入本机IP(公网):192.168.1.2

脚本将进行一键自动完成从节点的安装。后续如果需要修改以上IP或端口信息,可以通过游览器打开进行修改,例如:http://192.168.1.2

监控预警平台,拨测模块截图如下: