【自然语言处理】-jieba库学习笔记(一)

jieba.cut

import jiebaL = list(jieba.cut('大家好,我是勤奋努力的野指针'))分词效果还是很不错滴

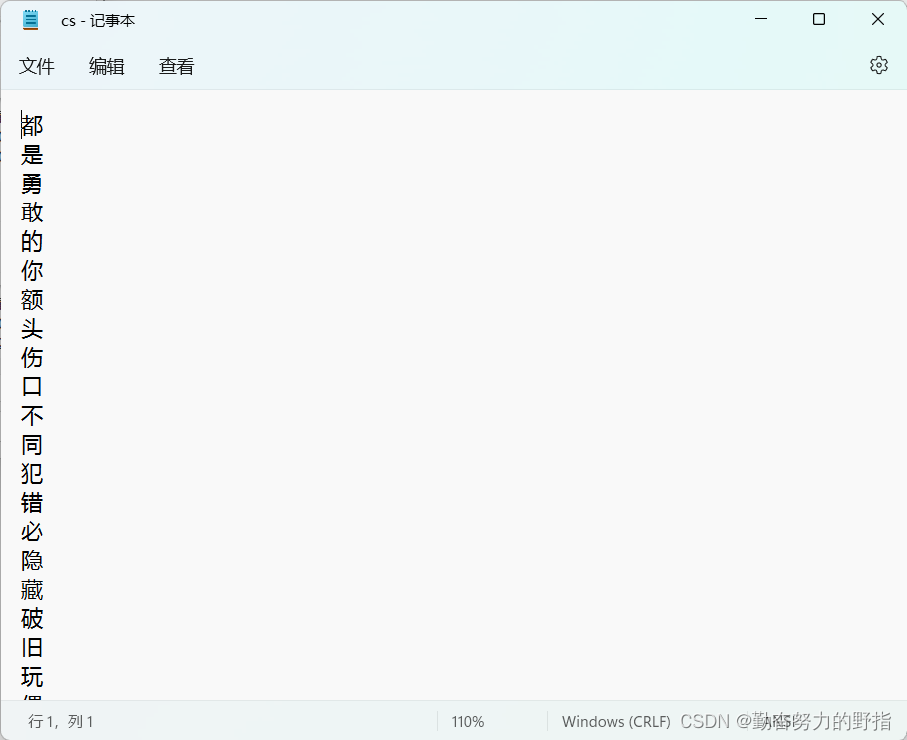

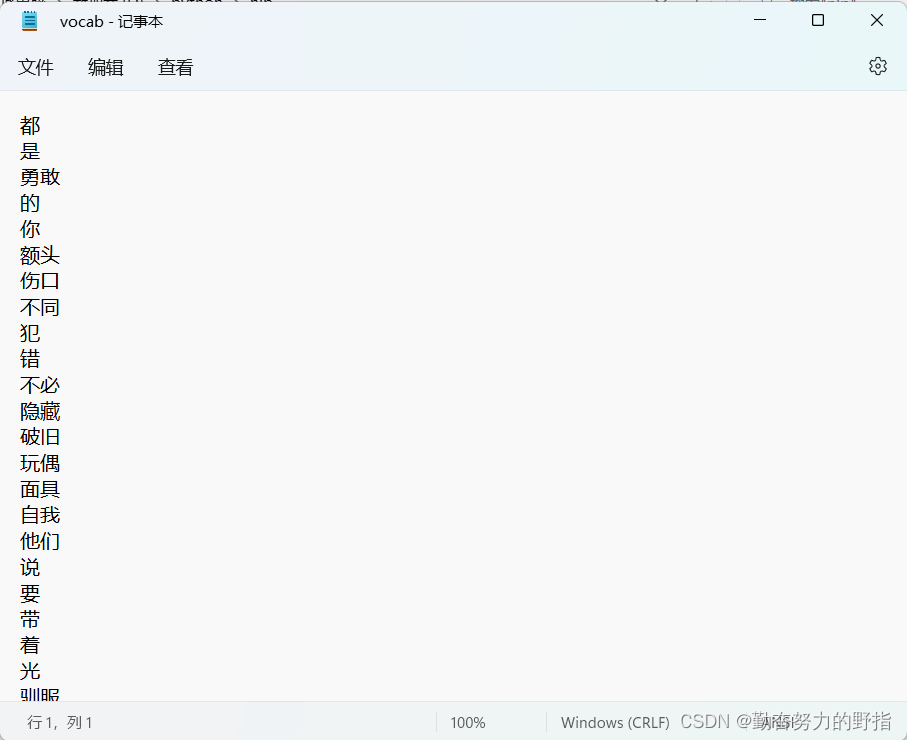

['大家', '好', ',', '我', '是', '勤奋努力', '的', '野', '指针']把分好的词和字整理到文档里面

(整理了孤勇着里面的一段歌词)

import jiebaL = list(jieba.cut('大家好,我是勤奋努力的野指针'))vocab = {} # 词cs = {} # 字text = ''# 字典:去重功能with open('gyz歌词.txt', 'r', encoding='utf-8') as file: for line in file: line = line.strip() text += line # 处理字 for c in line: cs[c] = 0 # 分词 for word in jieba.cut(line): vocab[word] = 0with open('cs.txt', 'w') as csf: for c in cs.keys(): csf.write(c + '\n')with open('vocab.txt', 'w') as vf: for w in vocab.keys(): vf.write(w + '\n')

jieba.analyse

import jieba.analyseH = jieba.analyse.textrank(text, topK=10, withWeight=False) # 出现频率最高的十个词这就是频率最高的十个词啦

['英雄', '衣裳', '对峙', '不算', '玩偶', '孤身', '缝好', '黑夜', '就让', '怪兽']第一次写博客,不算太好,以后会继续努力!