AI+HMI技术栈深度融合:智能语音交互与手势识别的底层实现路径

开车时无需动手,只需说句话就能切换音乐、调整导航;在智能家电前挥挥手,灯光、空调便自动响应指令。这些看似科幻的场景,正通过AI与HMI(人机交互)技术的融合走进现实。但你是否好奇,一句模糊的语音指令,系统如何精准解析?一个简单的手势动作,背后又藏着怎样复杂的运算?在AI+HMI技术栈深度融合的过程中,从语音信号捕捉到手势特征提取,从算法模型训练到指令执行,每一步都充满挑战与突破。接下来,让我们一起探寻智能语音交互与手势识别的底层实现路径。

一、揭开AI+HMI技术融合的神秘面纱

(一)什么是AI+HMI技术栈

在了解智能语音交互与手势识别的底层实现之前,我们得先搞清楚AI+HMI技术栈到底是什么。HMI(人机交互)就像是人与机器之间的“翻译官”,负责把我们的操作、指令转化为机器能理解的语言,同时把机器的反馈呈现给我们。而AI(人工智能)则赋予了这个“翻译官”学习和思考的能力。

AI+HMI技术栈,就是将人工智能技术深度融入人机交互领域,让机器不仅能“听懂”我们的语言、“看懂”我们的动作,还能根据过往经验和实时情况,做出更智能、更人性化的响应。它涵盖了从数据采集、处理,到算法模型构建、应用开发等一系列技术环节,是实现智能人机交互的核心技术体系。

(二)智能语音交互与手势识别的重要性

在日常生活中,我们早已习惯了通过键盘、鼠标、触摸屏与机器交互,但这些方式在某些场景下并不方便。比如在开车时,操作触摸屏会分散注意力;在双手忙碌时,无法使用键盘和鼠标。而智能语音交互和手势识别的出现,完美解决了这些问题。

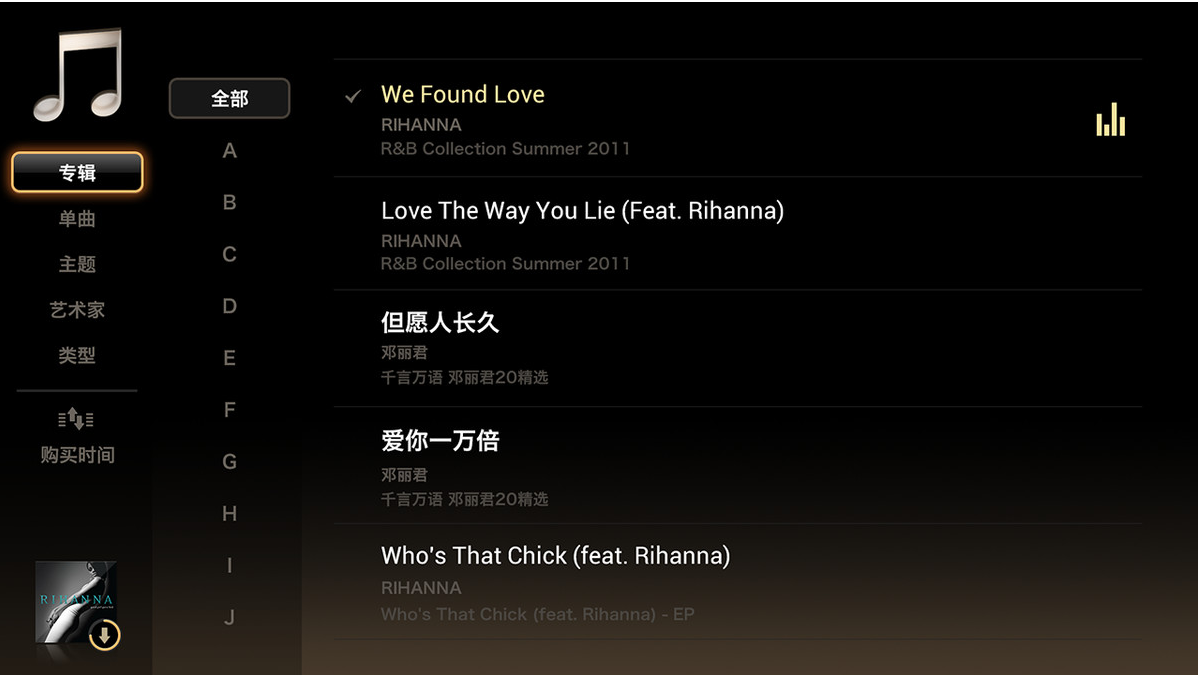

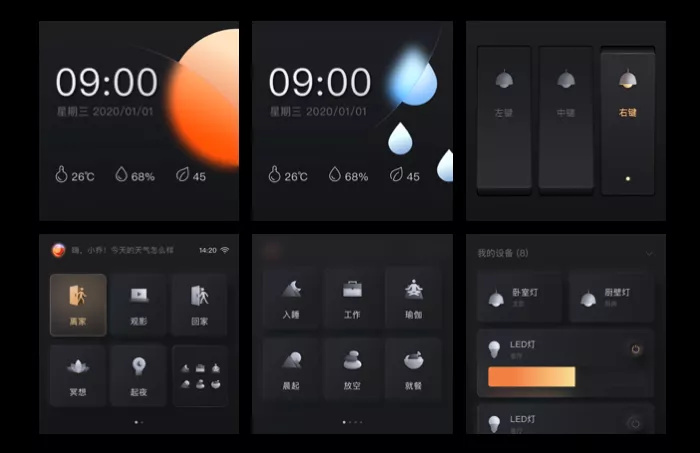

智能语音交互让我们可以“动口不动手”,通过自然语言与机器沟通。无论是查询天气、控制智能家居,还是在智能车载系统中导航,都能轻松实现。手势识别则让我们用简单的肢体动作就能与机器互动,在虚拟现实(VR)、增强现实(AR)场景中,用户可以通过手势抓取虚拟物体、操作菜单;在智能电视上,挥手就能切换频道。这两种交互方式极大地拓展了人机交互的边界,让交互更加自然、便捷,也为各行业带来了新的发展机遇。

二、智能语音交互的底层实现路径

(一)语音信号的采集与预处理

智能语音交互的第一步,是采集我们说话的声音信号。这通常由麦克风完成,麦克风将声音的振动转化为电信号或数字信号。但采集到的原始语音信号往往夹杂着各种噪音,比如环境杂音、设备本身的底噪等,这些噪音会影响后续的语音识别效果。

所以,采集到的语音信号需要进行预处理。预处理包括降噪、端点检测、归一化等操作。降噪是通过算法去除语音信号中的噪音;端点检测则用于确定语音的起始和结束位置,避免把无关的声音也纳入识别范围;归一化是调整语音信号的幅度,让不同音量的语音都能以统一的标准进行处理。

(二)语音识别算法与模型

经过预处理的语音信号,需要转化为机器能理解的文本信息,这就需要用到语音识别算法和模型。目前主流的语音识别模型是基于深度学习的,比如循环神经网络(RNN)及其变体长短时记忆网络(LSTM)、门控循环单元(GRU),以及卷积神经网络(CNN)等。

这些模型通过大量的语音数据进行训练,学习语音信号的特征和规律。训练过程中,模型会不断调整自身的参数,使得预测的文本结果与实际文本尽可能接近。以一个简单的语音识别任务为例,当我们说“打开空调”,语音识别模型会分析语音信号的频率、时长等特征,结合训练学到的知识,将其转化为“打开空调”这四个文字。

(三)语义理解与指令执行

语音识别出文本后,机器还需要理解这些文本的含义,也就是进行语义理解。语义理解会分析文本的语法结构、关键词语,结合上下文和预设的知识图谱,确定用户的真实意图。比如用户说“我有点热”,语义理解系统会结合当前场景,判断用户可能是想让空调降温。

理解用户意图后,系统会将指令发送给相应的设备或应用程序,完成指令执行。在智能家居系统中,指令会传输给空调控制器,空调便自动开启并调整温度。整个过程看似简单,实则涉及多个复杂的技术环节和大量的运算。

三、手势识别的底层实现路径

(一)手势数据的采集方式

手势识别首先要解决的是如何采集手势数据。常见的采集方式有摄像头采集、深度传感器采集和惯性传感器采集。

摄像头采集是通过摄像头拍摄用户的手势动作,获取手势的图像信息。这种方式成本较低,但容易受光照、遮挡等因素影响。深度传感器采集则能获取手势的三维空间信息,比如微软的Kinect传感器,它可以精确捕捉用户的肢体动作和手势,不受光照条件限制。惯性传感器采集一般用于可穿戴设备,如智能手环、智能手套,通过传感器检测设备的加速度、角速度等数据,来判断用户的手势动作。

(二)手势特征提取与模型训练

采集到的手势数据是原始的图像、深度信息或传感器数据,需要提取出有价值的特征,才能用于手势识别。对于图像数据,常用的特征提取方法有边缘检测、角点检测、形状描述子等;对于深度数据,可以提取手势的三维轮廓、关节点位置等特征;惯性传感器数据则可以通过分析加速度、角速度的变化规律来提取特征。

提取到特征后,同样需要使用机器学习或深度学习模型进行训练。常见的手势识别模型有支持向量机(SVM)、随机森林,以及基于深度学习的卷积神经网络(CNN)、递归神经网络(RNN)等。通过大量的手势样本数据训练模型,让模型学会区分不同的手势。

(三)手势识别与交互控制

训练好的模型可以对新采集到的手势数据进行识别。当用户做出一个手势动作,系统提取手势特征后,输入到模型中,模型会输出识别结果,判断用户做出的是何种手势。

识别出手势后,系统会根据预设的交互规则,将手势转化为相应的操作指令。比如在VR游戏中,用户做出抓取的手势,系统会识别这个手势,并执行抓取虚拟物体的操作;在智能电视上,用户挥手表示切换频道,系统识别后就会自动切换到下一个频道。

四、AI+HMI技术融合的优势、挑战与未来展望

(一)融合带来的显著优势

AI与HMI技术的深度融合,带来了诸多优势。首先,交互方式更加自然、便捷,用户无需学习复杂的操作方法,就能轻松与机器互动,大大降低了使用门槛。其次,智能性大幅提升,机器能够理解用户的意图,提供更个性化的服务。比如智能语音助手可以根据用户的日常习惯,主动推荐感兴趣的内容。此外,这种融合还拓展了人机交互的应用场景,在医疗、教育、工业等地方都展现出了巨大的潜力。

(二)面临的挑战

尽管前景广阔,AI+HMI技术融合也面临着不少挑战。在技术层面,语音识别在嘈杂环境下的准确率还有待提高,手势识别在复杂动作和遮挡情况下容易出现误判。此外,不同设备、不同系统之间的兼容性也是一个难题,需要建立统一的标准和规范。在隐私和安全方面,语音和手势数据包含大量用户信息,如何确保数据的安全存储和传输,防止信息泄露,也是亟待解决的问题。

(三)未来展望

随着技术的不断进步,AI+HMI技术融合将迎来更广阔的发展空间。在语音交互方面,多语言、多口音的识别能力会不断增强,语音合成也将更加自然流畅。手势识别技术将朝着更高精度、更复杂动作识别的方向发展,甚至可能实现对微表情、眼神的识别。未来,AI+HMI技术还可能与脑机接口等新技术结合,创造出全新的人机交互方式,彻底改变我们与机器的交互模式。

总结

AI+HMI技术栈的深度融合,为智能语音交互和手势识别的发展提供了强大动力。从语音信号的采集处理到手势数据的识别应用,每一个底层实现路径都凝聚了众多技术的智慧。虽然目前还面临着一些挑战,但不可否认的是,这种融合已经为我们的生活带来了巨大改变,并将在未来持续推动各行业的创新发展。随着技术的不断完善,我们有理由相信,更加智能、便捷的人机交互时代即将全面到来!

如果你对AI+HMI技术融合的某个环节感兴趣,或者还想了解更多相关应用案例,欢迎随时和我交流。

本人是10年经验的前端开发和UI设计资深“双料”老司机,1500+项目交付经历,带您了解最新的观点、技术、干货,下方微信我可以和我进一步沟通。