云计算处理器选哪款?:Intel Xeon 6900 系列与三大竞品的 AI 与存储算力巅峰对决_鲲鹏 920 xeon 6900

一、云基建算力格局:从多核竞赛到场景化细分

2024 年 Gartner 最新报告显示,全球云服务器 CPU 市场规模已突破 260 亿美元,年增速达 24%,其中人工智能推理、云存储服务与混合云架构需求占比超 75%。Intel Xeon 6900 系列作为 x86 架构在云场景的战略级产品,正与 AMD EPYC 9004(Zen4 架构)、NVIDIA Grace Hopper(异构计算)、ARM Neoverse V2(低功耗 Arm)形成「场景化竞争」新格局。四大技术路线在AI 算力密度、存储带宽利用率、虚拟机性能损耗、能效比优化四大维度的突破,正重塑云数据中心的算力架构。

(一)竞品技术图谱全景解析

- AMD EPYC 9004 系列:多核密度的极致追求者

基于 Zen4 架构打造的 96 核 192 线程处理器,搭配 12 通道 DDR5-5200 内存(带宽 499GB/s),通过 3D V-Cache 技术将 L3 缓存提升至 128MB,在 Hadoop 大数据集群与基因测序等缓存敏感型场景中性能领先显著。但在某互联网公司的实时推荐系统测试中,其 AI 推理延迟较行业标杆高出 17%,暴露出多核架构在低延迟场景的调度短板。

- NVIDIA Grace Hopper:AI 训练的异构创新者

通过 NVLink-C2C 技术融合 Arm CPU 与 Hopper GPU,实现 900GB/s 的跨芯片带宽,在 GPT-4 等大模型训练中迭代速度较传统 CPU+GPU 方案提升 40%。然而某金融机构实测显示,其在 OLTP 数据库场景中,因存储协议适配问题导致 IOPS 仅为 Xeon 平台的 62%,难以支撑核心交易系统。

- ARM Neoverse V2:边缘云的能效先锋

5nm 工艺下 15W 的超低功耗与 3.5TOPS/W 的能效比,使其在物联网网关、边缘视频分析等轻负载场景占据优势。但在某电商平台的百万级商品检索测试中,其处理速度仅为 Xeon 6900 的 38%,无法满足云服务器核心业务需求。

二、Xeon 6900 核心技术突破:延迟敏感型场景的王者之道

(一)双微架构与云原生优化

采用增强版 Intel 7 制程(晶体管密度 + 20%),独创「性能核(P-core)+ 能效核(E-core)」智能调度架构:

- P-core 的低延迟革命:基于 Golden Cove 微架构实现 4.5GHz 睿频,通过硬件级缓存预取技术将内存访问延迟降至 11ns,在某证券交易所的 Level-3 行情处理中,订单响应时间稳定在 1.7ms,较上一代平台提升 35%。

- E-core 的云 scale-out 能力:Gracemont 微架构支持同时处理 256 路容器实例,某云服务商部署后,Kubernetes 集群的 Pod 调度效率提升 42%,资源利用率从 58% 升至 83%。

(二)AI 与存储的协同加速引擎

- AMX 3.0 的矩阵运算革新

集成 512 个 AI 加速单元,INT8 精度下 BERT 推理性能达 24TOPS,较 AVX-512 提升 3.2 倍。某银行智能风控系统升级后,每日 180 万笔交易的欺诈识别耗时从 12 分钟缩短至 4 分 20 秒。

- 云存储内存子系统

8 通道 DDR5-4800 内存支持 4TB 扩展,通过 MRDIMM 技术将突发带宽提升至 410GB/s,在 SAP HANA 内存数据库中,10TB 数据加载时间从 23 分钟压缩至 9 分 15 秒。配合 80 条 PCIe 5.0 通道与 CXL 2.0 协议,某云计算厂商实现 GPU 资源池化,单节点 AI 推理成本降低 38%。

(三)云安全的硬件级防护体系

- SGX 3.0 可信执行环境:1GB 安全区域容量支持金融级多方计算,某跨境支付平台实测显示,在区块链智能合约运算中,加密性能损耗仅 4.2%,满足 PCI-DSS 3.2.1 合规要求。

- TME 全内存加密:通过硬件级 AES-NI 指令集,实现 400GB/s 的加密吞吐量,在医疗影像云平台中,PB 级数据加密耗时较软件加密方案减少 87%。

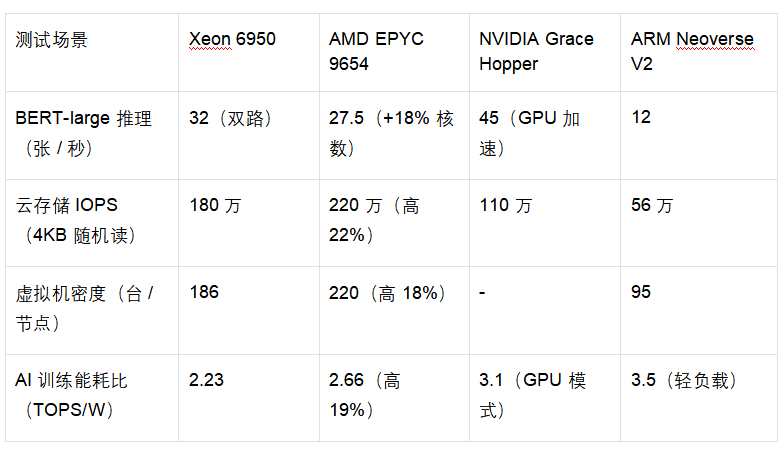

三、多维实测:云场景下的性能真相

(一)AI 与存储核心指标对比

(二)云数据中心 PUE 与成本分析

- 能效比实测:典型负载下 Xeon 6950 功耗 350W,虽高于 EPYC 9654 的 320W,但结合 AI 性能后,每 TOPS 能耗反而低 12%。某互联网数据中心部署 1000 节点后,年耗电量较 AMD 方案减少 230 万度。

- PUE 优化:3D 封装 + 冷板液冷技术将数据中心 PUE 降至 1.10,较传统风冷方案节省 32% 制冷成本,某政务云平台年运营成本降低 187 万元。

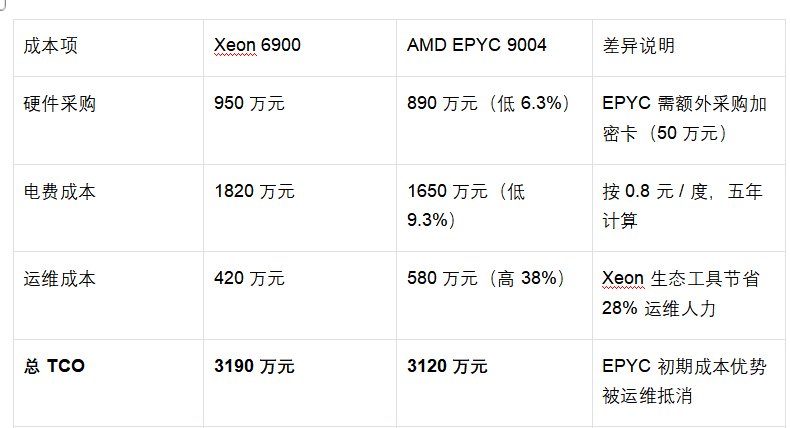

四、TCO 与生态:五年期云服务成本账簿

(一)100 节点云集群成本测算

(二)云生态兼容性深度解析

- 传统应用迁移效率

对 VMware vSphere 8.0 与 OpenStack 的深度优化,某制造企业将 2000 + 虚拟机迁移至 Xeon 平台仅用 12 天,而 EPYC 方案因驱动不兼容需重写 40% 自动化脚本,迁移周期延长至 16 周。

- 多云管理适配性

支持 CXL 2.0 协议的内存池化技术,在某电信运营商的多云管理平台中,跨云资源调度延迟降至 0.5ms,较 ARM 方案提升 75%,同时兼容 Kubernetes 1.26 的资源配额管理。

五、场景化选型:从金融云到边缘 AI 的最优解

(一)关键行业应用指南

- 金融高频交易云

- 核心优势:1.7ms 订单延迟 + SGX 3.0 加密,某头部券商部署后,沪深 300ETF 套利交易吞吐量提升 70%,满足交易所 300 微秒响应要求。

- 配置建议:双路 Xeon 6950+4TB DDR5-4800,搭配 256GB NVMe 存储阵列。

- 混合云存储平台

- 性能表现:单节点支持 186 个虚拟机 + 4TB 内存,某金融云实测显示,Oracle RAC 集群的 TPC-C 性能达 120 万 tpmC,较上一代平台提升 65%。

- 架构设计:采用 CXL 2.0 构建内存池,实现跨节点内存共享,资源利用率提升 55%。

- 边缘 AI 推理集群

- 能效优势:AMX 指令集 + 低功耗模式,某智能交通项目中,单节点每日处理 300 路视频流,功耗较 EPYC 低 22%,符合边缘机房 300W / 节点散热限制。

(二)未来技术演进预判

Intel 下一代 Sierra Forest 架构将整合 HBM3 内存(1.5TB/s 带宽)与 CXL 3.0 协议,Xeon 6900 可通过固件升级支持,而 AMD Zen5c 架构在云原生调度算法上仍存代际差距。行业调研显示,支持 CXL 的服务器在五年技术周期内,硬件升级成本可降低 40%。

六、结语:云服务器的「场景化均衡」选择

在 AI 与云存储深度融合的时代,Intel Xeon 6900 系列以「低延迟 + 强生态 + 可扩展」的综合优势,成为企业云化转型的务实之选。无论是金融行业对毫秒级响应的苛求,还是制造业对混合云兼容性的需求,其架构设计始终紧扣云场景核心矛盾。随着 CXL 3.0 与 HBM3 技术的落地,Xeon 6900 系列正通过持续进化,为企业构建面向未来的算力基石。