保姆级教程:Ollama本地化部署大模型从入门到精通,这一篇就够了!_ollmam

摘要

本文是一篇终极Ollama实战指南,专为希望在本地计算机上运行大语言模型的AI爱好者和开发者设计。无论你是Windows、macOS还是Linux用户,无论你是否具备深厚的技术背景,这篇“保姆级”教程都将手把手带你走过从硬件检查、环境配置、Ollama安装与核心命令详解,到创建自定义模型、通过API进行编程集成的全过程。我们将以最通俗易懂的语言,结合大量实例和问题排查方案,彻底攻克本地部署大模型的难关。读完本文,你不仅能轻松玩转Qwen(通义千问)等主流模型,更能掌握将Ollama融入自己工作流的进阶技巧,真正实现AI生产力的“私有化”和“自由化”。

1. 序章:我们为什么要在本地“养”一个大模型?

各位CSDN的朋友们,大家好,我是你们的老朋友,一个热爱钻研AI技术的博主。

最近,我身边不少刚入行AI的朋友都向我抱怨一件事:玩AI的成本太高了!想调用个GPT-4的API,写个小工具,结果没测试几次,账单就蹭蹭往上涨,心疼得不行;有些公司内部的项目,想用大模型处理一些敏感数据,又担心数据隐私泄露,毕竟把核心数据传给第三方,总觉得心里不踏实;更别提有时候那不稳定的网络,关键时刻API请求超时,能把人急出心脏病。

是不是感觉说到了你的心坎里?这些问题,归根结底都指向一个方向:我们对云端大模型的依赖太强了。那么,有没有一种方法,能让我们像在自己电脑上装个Office一样,轻松地把大模型“请”到我们自己的机器上呢?

答案是:有,而且比你想象的要简单得多!

这就要引出我们今天的主角——Ollama。

你可以把Ollama想象成一个“大模型的魔法盒子”。它是一个开源工具,能让你用极其简单的方式,在自己的电脑上下载、安装、运行和管理各种主流的大语言模型,比如阿里的Qwen(通义千问)、Meta的Llama 3、Google的Gemma等等。

Ollama的出现,彻底改变了本地部署大模型的游戏规则。它把曾经需要复杂环境配置、繁琐模型转换、高深技术门槛的“专业级”操作,简化成了一两行命令。它就像大模型领域的“Docker”,把模型和运行环境打包好,让你一键启动,即刻开聊。

这篇指南,就是我为所有想迈出“AI自由”第一步的朋友们准备的。我将用最接地气的方式,带你从零开始,把Ollama这个强大的工具彻底玩明白。这篇文章不玩虚的,全是干货,从安装的每一个细节,到命令的每一种用法,再到自定义模型和API调用的“骚操作”,我都会掰开了、揉碎了讲给你听。

准备好了吗?让我们一起开启这趟激动人心的本地大模型之旅,把AI真正变成我们自己的“私人助理”!

2. 深入浅出:Ollama究竟是个什么“神仙”?

在咱们动手之前,得先花几分钟搞清楚,Ollama到底是个啥,它凭什么能这么牛?

用最简单的一句话来概括:Ollama,就是大模型领域的Docker。

我相信在座的各位开发者对Docker都不陌生。在没有Docker的时代,我们要部署一个Web应用,得先在服务器上装操作系统,再装数据库,再装各种依赖库,配置环境变量……一套下来,人基本就晕了,而且换台机器还得重来一遍。Docker的出现,把应用和它所有的依赖打包成一个轻量的“容器镜像”,我们只需要一条docker run命令,就能在任何支持Docker的机器上完美运行,省去了所有繁琐的环境配置。

Ollama做的就是完全一样的事情,只不过对象从Web应用换成了大语言模型。

一个大模型,本身其实是一堆巨大的参数文件(我们常说的7B、13B就是指参数量),要让它跑起来,你需要:

- 模型文件本身:得从Hugging Face这类地方下载,动辄几个G甚至几十个G。

- 运行框架:比如PyTorch或TensorFlow。

- 底层驱动:如果用GPU加速,还得有正确的CUDA或ROCm驱动。

- 加载和推理代码:你需要写代码来加载模型、处理输入(Tokenization)、执行推理、解码输出。

这一套流程,对于新手来说,每一步都可能踩坑。

而Ollama的伟大之处就在于它的核心设计哲学:极致简化与整合。

- 整合(Bundling):Ollama把“模型权重”、“配置参数”和“运行所需的一切”全部打包成一个单一的模型文件(在Ollama里通过一个叫

Modelfile的东西来定义)。你不需要关心模型是什么格式(比如GGUF),也不需要关心它具体怎么加载。 - 简化(Simplicity):Ollama提供了一个极其简单的命令行工具。你想用阿里的通义千问模型?只需要一条命令:

ollama run qwen。下载、配置、启动,所有复杂的工作,Ollama在后台默默帮你搞定。

所以,你可以把Ollama理解为一个本地大模型运行器和管理器。它在你的电脑上以后台服务的形式运行,负责管理所有模型文件,并提供了一个统一的命令行接口和REST API接口,让你能轻松地与这些本地模型进行交互。

有了这个“大模型管家”,我们就可以把精力完全集中在“用”模型上,而不是“装”模型上。这,就是Ollama的魔力所在。

3. 终极安装指南

好了,理论知识储备完毕,下面进入全文最关键的实战环节:安装Ollama。

重要提示:硬件要求

在开始之前,我们得先“掂量掂量”自己的电脑。虽然Ollama不挑食,但大模型本身是个吃内存和显存的“大胃王”。

- 内存(RAM):建议至少有 16GB 内存。8GB也能跑,但只能玩一些小模型(如3B),而且可能会比较卡。32GB或以上则能更流畅地运行7B、13B甚至更大的模型。

- 硬盘(Storage):每个模型文件大小在3GB到几十GB不等,请确保你有足够的硬盘空间。建议至少有 50GB 的可用空间。

- 显卡(GPU):这是强烈推荐的选项!虽然Ollama也支持纯CPU运行,但速度会非常慢,体验很差。

- NVIDIA显卡:最佳选择。需要安装正确的CUDA驱动。Ollama会自动检测并使用。

- AMD显卡:在Linux上支持较好(通过ROCm),Windows上的支持正在逐步完善。

- Apple Silicon(M1/M2/M3芯片):苹果的M系列芯片内置了强大的GPU(Metal),Ollama对其支持非常好,是Mac用户的福音。

3.1. Windows系统详细安装指南

Windows用户是幸福的,因为Ollama提供了图形化的安装包,整个过程非常无脑。

第一步:检查NVIDIA驱动(如果你有N卡)

这是最重要的一步,也是最多人出问题的地方。Ollama需要通过NVIDIA的CUDA工具包来使用你的显卡。

-

在桌面点击鼠标右键,选择“NVIDIA 控制面板”。

-

打开后,点击左下角的“系统信息”。

-

在弹出的窗口中,查看“组件”选项卡。你会看到一个类似

NVCUDA64.DLL或NVCUDA.DLL的条目,后面跟着你的CUDA驱动版本号。请确保你的驱动版本至少是 11.2 或更高。 -

如果你的驱动版本过低,或者根本没有“NVIDIA 控制面板”,请访问 NVIDIA官网驱动下载页面,选择你的显卡型号,下载并安装最新的“Game Ready”或“Studio”驱动程序。安装完成后重启电脑。

小白避坑指南:

- 问: 我怎么知道我电脑有没有NVIDIA显卡?

- 答: 右键点击“此电脑” -> “属性” -> “设备管理器”,展开“显示适配器”看看。如果有NVIDIA GeForce/RTX/Quadro等字样,就是N卡。如果只有Intel HD Graphics或AMD Radeon Graphics,那你可能无法使用NVIDIA的GPU加速。

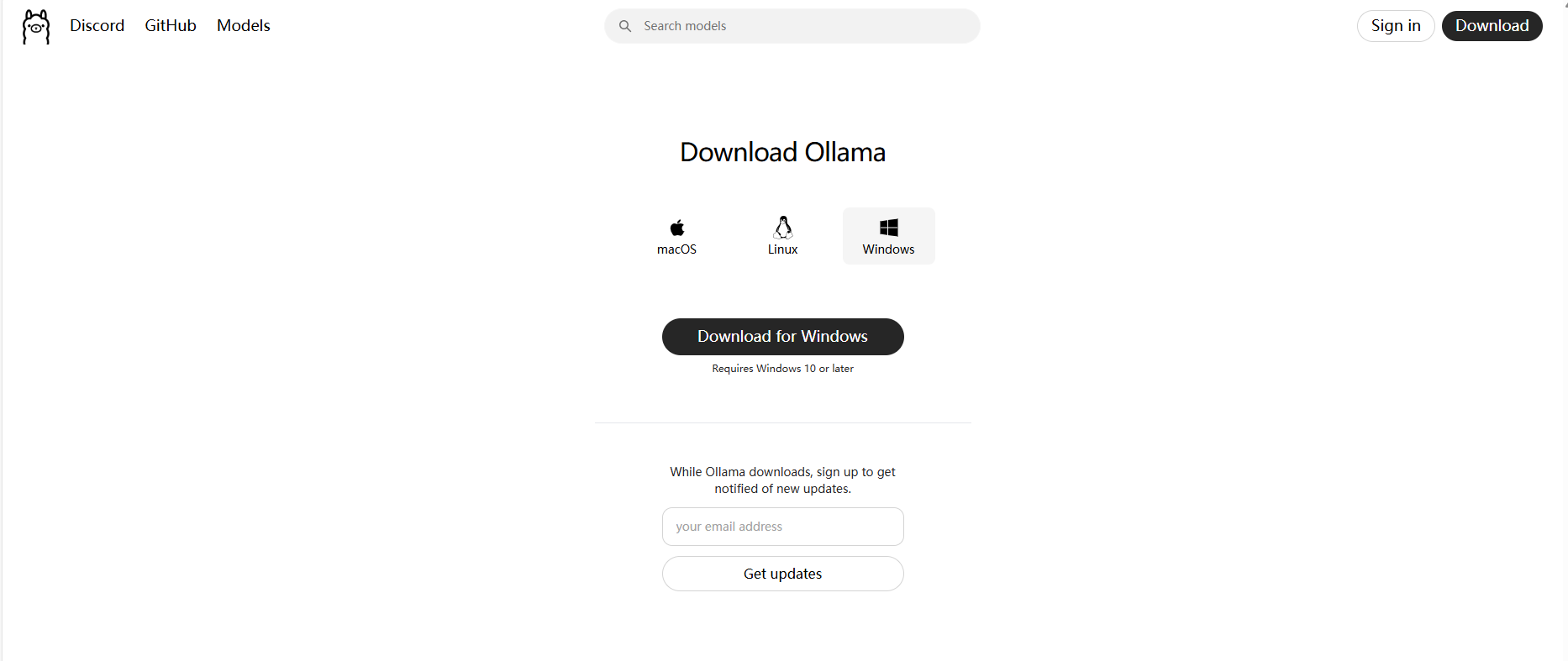

第二步:下载并安装Ollama

- 打开你的浏览器,访问Ollama的官方网站:https://ollama.com/

- 网站会自动检测到你的操作系统是Windows,并显示一个大大的“Download for Windows”按钮。点击它。

- 下载完成后,你会得到一个名为

OllamaSetup.exe的文件。双击运行它。 - 接下来就是标准的Windows软件安装流程,一路点击“Next”或“Install”即可。安装程序会自动将Ollama添加到系统路径,并将其设置为开机自启动的后台服务。

第三步:验证安装

安装完成后,我们需要验证一下Ollama是否正常工作。

-

按下

Win + R键,输入cmd,然后回车,打开命令提示符窗口。 -

在窗口中输入以下命令并回车:

ollama --version -

如果你看到类似

ollama version is 0.1.40这样的版本号信息,恭喜你,Ollama命令行工具已经安装成功!

- Ollama在安装后会自动在后台运行一个服务。你可以在任务栏的右下角找到一个小小的“羊驼”图标,这就是Ollama的服务进程。

Windows常见安装问题与排查

-

问题1: 在

cmd中输入ollama提示“不是内部或外部命令”。- 原因: 环境变量没有配置成功。

- 解决方案: 手动添加。通常Ollama安装在

C:\\Users\\你的用户名\\AppData\\Local\\Ollama目录下。将这个路径添加到系统的Path环境变量中,然后重启cmd窗口。如果嫌麻烦,最简单的办法是卸载重装一遍Ollama。

-

问题2: 运行模型时感觉非常慢,风扇狂转但任务管理器显示GPU利用率很低。

- 原因: Ollama没有成功调用NVIDIA显卡,正在使用CPU进行计算。

- 解决方案:

- 确认驱动: 重新执行“第一步:检查NVIDIA驱动”,确保驱动版本正确。

- 查看日志: Ollama的日志文件位于

C:\\Users\\你的用户名\\.ollama\\logs目录下。打开最新的日志文件,搜索关键词cuda或gpu。如果你看到类似Found NVIDIA GPU的信息,说明识别成功。如果看到的是no NVIDIA GPU detected,那大概率是驱动问题。 - 重启服务: 右键点击任务栏的Ollama图标,选择“Quit”。然后从开始菜单重新启动Ollama。

3.2. macOS 与 Linux 系统安装

对于macOS和Linux用户,安装过程同样非常直接。

- macOS用户:直接从Ollama官网下载

.dmg安装包,像安装普通Mac应用一样拖拽到“应用程序”文件夹即可。Ollama会自动处理好命令行工具的配置。 - Linux用户:官方提供了一键安装脚本,在终端中运行

curl -fsSL https://ollama.com/install.sh | sh即可完成安装和服务配置。

由于不同用户的系统环境千差万别,如果在macOS或Linux上遇到任何安装问题,欢迎在评论区留言,我会尽力帮助大家解答。

4. 核心命令精讲:成为Ollama指挥官

Ollama的命令行接口(CLI)设计得非常直观。掌握了下面几个核心命令,你就掌握了99%的日常操作。我会用最详尽的方式,为你拆解每一个命令。

4.1. ollama run - 你的第一个AI对话

这是最核心、最常用的命令。它的作用是:运行一个指定的模型,如果本地没有这个模型,它会自动帮你下载。

- 用途: 启动并与一个模型进行交互式聊天,或者让模型处理单个提示。

- 语法:

ollama run [:tag] [prompt]: 必需。模型的名字,比如qwen,llama3,gemma。[:tag]: 可选。模型的标签或版本。默认是latest。比如qwen:7b表示70亿参数的版本,qwen:4b表示40亿参数的版本。你可以在 Ollama模型库 找到所有可用的模型和标签。[prompt]: 可选。如果你在命令后面直接跟上文字,Ollama会处理完这段文字并输出结果,然后退出,而不是进入交互式聊天。

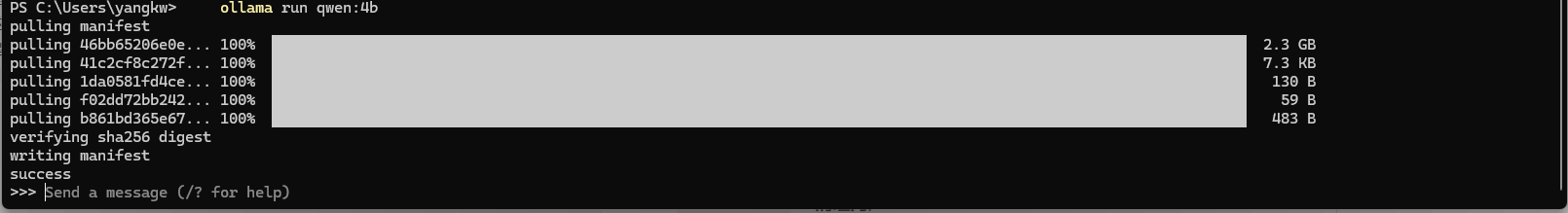

实战演练:

-

启动交互式聊天(最常用)

打开你的终端或CMD,输入:ollama run qwen:4b-

背后发生了什么?

-

Ollama首先检查你本地有没有一个叫

qwen且标签为4b的模型。 -

发现没有,于是它会连接到Ollama服务器,开始下载模型文件。你会看到一个进度条,显示下载的各个层(layers)。

-

下载完成后,Ollama会加载模型到内存(如果是第一次,可能会有一个编译或准备的过程)。

-

加载完毕,你会看到一个提示符

>>> Send a message (/? for help),表示你可以开始聊天了!

-

-

如何聊天?

直接输入你的问题,比如你好,介绍一下你自己然后回车。模型会思考片刻,然后输出答案。你可以一直聊下去。想退出聊天,输入/bye即可。

-

-

处理单个任务(适合脚本)

假设你想让模型帮你写一个Python的hello world,并且不希望进入聊天模式。ollama run qwen:4b \"写一个打印hello world的Python函数\"模型会直接输出代码,然后程序结束,返回到你的命令行提示符。这个用法在写自动化脚本时非常有用。

高手小贴士:

- 在交互式聊天中,输入

/?可以查看所有可用的内部命令,比如/set,/show,/bye等,可以用来调整模型参数或查看信息。- 如果你想运行的模型非常大,而你的网络又不太好,

run命令可能会因为下载时间太长而显得卡顿。这时,更好的做法是先用下面的pull命令把模型下载好。

4.2. ollama pull - 提前“备货”

这个命令就像git pull或者docker pull,它的作用是只下载模型,而不立即运行它。

- 用途: 预先下载模型到本地,以便之后可以快速启动。

- 语法:

ollama pull [:tag]

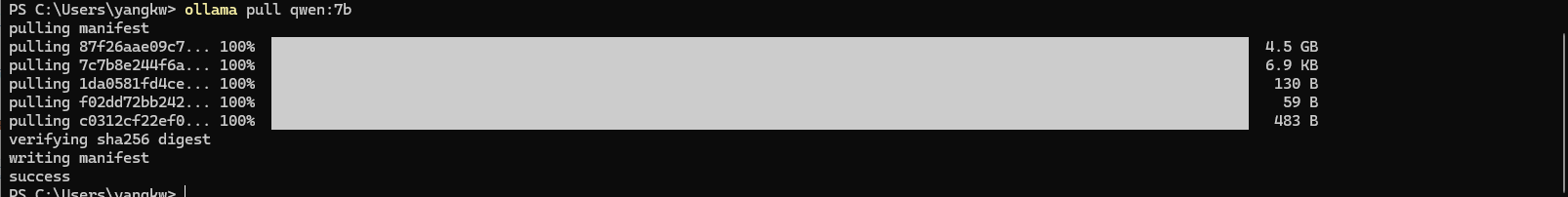

实战演练:

假设你晚上准备用通义千问70亿参数的模型,但它比较大,你可以在白天工作的时候就让电脑在后台下载。

ollama pull qwen:7b执行后,你会看到和run命令首次运行时一样的下载进度条。下载完成后,命令结束。之后你再执行 ollama run qwen:7b,模型会瞬间启动,因为文件已经躺在你的硬盘里了。

4.3. ollama list - 查看你的“军火库”

当你下载的模型越来越多,你可能需要一个命令来查看自己本地到底有哪些模型。

- 用途: 列出所有已经下载到本地的Ollama模型。

- 语法:

ollama list

实战演练:

ollama list你会看到一个清晰的表格,包含以下信息:

NAME: 模型的名字和标签,如qwen:4b。ID: 模型的唯一标识符。SIZE: 模型文件在硬盘上占用的空间。MODIFIED: 模型的最后修改时间。

4.4. ollama rm - “清理门户”

模型文件都很大,硬盘空间宝贵。当你不再需要某个模型时,可以用rm命令删除它。

- 用途: 删除本地的一个或多个模型。

- 语法:

ollama rm [:tag]

实战演练:

-

删除一个特定版本的模型

ollama rm qwen:4bOllama会确认并删除

qwen:4b这个模型,释放硬盘空间。 -

删除一个模型的所有版本

如果你下载了qwen:7b,qwen:4b,qwen:1.8b,想把所有qwen相关的都删掉,可以只写模型名:ollama rm qwen警告: 这个操作会删除所有名为

qwen的本地模型,请谨慎使用。

高手小貼士:

ollama rm是不可逆的。删除前,最好用ollama list确认一下。

4.5. ollama cp - “克隆”与“微调”的起点

cp 命令(copy的缩写)非常有趣。它允许你为一个已有的模型创建一个“副本”,并给它一个新的名字。这在你想要基于一个基础模型进行自定义时特别有用。

- 用途: 复制一个本地模型,为创建自定义模型做准备。

- 语法:

ollama cp

实战演练:

假设你很喜欢qwen:7b,但你想创建一个专门用来帮你写代码的“编程版Qwen”。你可以先复制一份:

ollama cp qwen:7b my-qwen-coder执行后,再运行 ollama list,你会发现多了一个名为 my-qwen-coder:latest 的模型。它的ID和qwen:7b完全一样,因为它们目前指向的是同一个底层文件。但现在,你可以对 my-qwen-coder 进行修改(通过我们后面要讲的Modelfile),而不会影响到原始的qwen:7b模型。

这个命令是通往高级玩法的第一步。

4.6. ollama show - 揭开模型的神秘面纱

你想知道一个模型的“内幕”吗?比如它的系统提示词是什么?它的温度参数(temperature)设置的是多少?show命令可以满足你的好奇心。

- 用途: 显示一个模型的详细信息,包括它的

Modelfile内容。 - 语法:

ollama show [:tag]

实战演练:

让我们看看qwen:7b的配置信息:

ollama show qwen:7b你会看到一大段输出,包含了Modelfile的各种指令,比如:

FROM ...: 它基于哪个基础模型文件。TEMPLATE ...: 它的对话模板结构。PARAMETER ...: 它的默认参数,如temperature,top_p,stop等。SYSTEM ...: 它的默认系统提示词。

通过show命令,你可以学习到官方模型是如何配置的,为我们自己创建模型提供灵感。

4.7. ollama ps - 谁在“吃”我的显存?

ps (process status) 命令可以告诉你当前有哪些模型正在运行(即被加载到了内存/显存中)。

- 用途: 查看当前正在运行的模型进程。

- 语法:

ollama ps

实战演练:

当你运行了一个模型后(比如ollama run qwen:4b),不要关闭这个终端。另外打开一个新的终端,输入:

ollama ps你会看到类似下面的输出,告诉你qwen:4b正在运行,占用了多少内存,以及它已经运行了多久。这在你同时运行多个模型或者排查性能问题时非常有用。

高手小贴士:

Ollama默认在一段时间没有活动后,会自动从内存中卸载模型以释放资源。你可以通过ps命令来确认模型是否还在运行。

5. 第一个实战项目:与通义千问(Qwen)进行一场深度对话

理论说了这么多,是时候来点真格的了!我们将一起动手,完成从下载到与优秀的国产大模型——阿里的通义千问(Qwen)——进行对话的全过程。

第一步:拉取Qwen模型

我们采用好习惯,先pull后run。Qwen有多个版本,我们选择70亿参数的qwen:7b,它在性能和资源消耗上取得了很好的平衡,适合大多数现代PC。

打开你的终端/CMD,执行:

ollama pull qwen:7b根据你的网速,这可能需要几分钟到十几分钟。你会看到类似这样的下载过程:

看到success就表示大功告成!

第二步:启动并对话

现在,激动人心的时刻到了。执行run命令:

ollama run qwen:7b由于模型已经下载好了,Ollama会直接开始加载模型。这个过程会占用大量内存和显存。你可以打开任务管理器(Windows)或活动监视器(macOS)来观察资源变化。

加载完成后,你会看到熟悉的提示符:

>>> Send a message (/? for help)

现在,让我们来考验一下通义千问的能力。作为国产模型,它的中文能力非常出色。

示例对话1:生活小助手

你:

我晚上想做个西红柿炒鸡蛋,但我是个厨房新手,能给我一个详细的步骤吗?

Qwen可能会给你类似下面这样的回答:

当然可以!西红柿炒鸡蛋是一道非常经典的家常菜,简单又美味。下面是一个新手也能轻松掌握的详细步骤:**准备材料:*** 西红柿:2个(中等大小)* 鸡蛋:3个* 小葱:1根* 盐:约3-4克(一小勺)* 糖:约5克(一小勺,用于中和西红柿的酸味)* 食用油:适量**制作步骤:**1. **准备工作**: * 将西红柿洗净,在顶部划一个十字花刀,然后用开水烫一下,这样很容易就能把皮剥掉。去皮后切成小块备用。 * 将鸡蛋打入碗中,加少许盐(约1克),用筷子或打蛋器充分搅打均匀,直到蛋液表面出现一层细密的泡沫。 * 小葱切成葱花。2. **炒鸡蛋**: * 热锅中倒入比平时炒菜多一点的油,油温七成热时(油面微微冒烟),倒入蛋液。 * 蛋液下锅后不要马上翻动,等它稍微凝固后,用铲子迅速划散,炒成大块的鸡蛋块。炒好后盛出备用。3. **炒西红柿**: * 锅里留底油,如果油不够可以再加一点。放入葱花爆香。 * 倒入切好的西红柿块,用中火翻炒,直到西红柿变软,炒出红色的汤汁。 * 加入一小勺糖和剩下的盐,翻炒均匀。4. **混合出锅**: * 将之前炒好的鸡蛋倒回锅中,和西红柿一起快速翻炒均匀,让鸡蛋充分吸收西红柿的汤汁。 * 翻炒约30秒后,即可关火出锅。**小贴士:*** 喜欢汤汁多一点的,可以在炒西红柿的时候加少量水。* 剥西红柿皮会让口感更好。* 炒鸡蛋时油温高一点,炒出来的鸡蛋更蓬松。祝你成功!示例对话2:创意写作

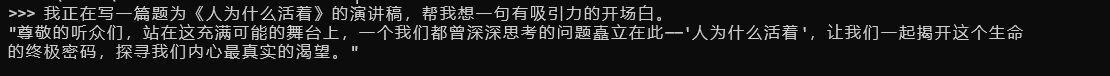

你:

我正在写一篇题为《人为什么活着》的演讲稿,帮我想一句有吸引力的开场白。

Qwen可能会给你的输出:

是不是非常强大?现在,你拥有了一个7x24小时待命、反应迅速、无需联网、并且绝对保护你隐私的AI伙伴。你可以随时退出聊天(输入/bye),下次再通过ollama run qwen:7b回来继续。

6. 进阶玩法:释放Ollama的全部潜能

玩转了基础命令,你已经是一个合格的Ollama用户了。但要想成为高手,我们还得学习两个“杀手锏”:Modelfile和REST API。

6.1. 使用Modelfile定制你的专属模型

还记得我们之前用ollama cp创建了一个副本吗?现在是时候让它变得独一无二了。Modelfile就是Ollama中用于定义和创建模型的“配方文件”,它和Dockerfile的理念如出一辙。

Modelfile的核心指令解析:

FROM(必需): 指定你创建的模型基于哪个基础模型。这必须是Ollama本地已经存在的模型。PARAMETER: 设置模型的默认运行参数。这会覆盖基础模型中的参数。常用的有:temperature: 控制输出的随机性。值越高(如1.0),回答越有创意和多样性;值越低(如0.2),回答越确定和保守。top_p: 一种替代temperature的采样方法,控制生成文本的“焦点”。stop: 定义一个或多个字符串,当模型生成这些字符串时,会自动停止。比如可以设置为\"用户:\",防止模型角色扮演时自己生成下一轮对话。

SYSTEM: 设置一个系统级的指令。这个指令会在每次会话开始时被加载,告诉模型它应该扮演什么角色、遵循什么规则。这是进行角色扮演(Role-Playing)和能力定制的核心。TEMPLATE: 定义模型的完整对话模板。Ollama使用这个模板来组织用户的输入、历史记录和系统提示,然后喂给模型。你可以通过修改它来改变模型的交互方式。ADAPTER: (高级) 用于应用LoRA等微调适配器。这允许你加载一个小的、经过特定任务训练的“补丁”,来改变基础模型的行为,而无需重新训练整个模型。

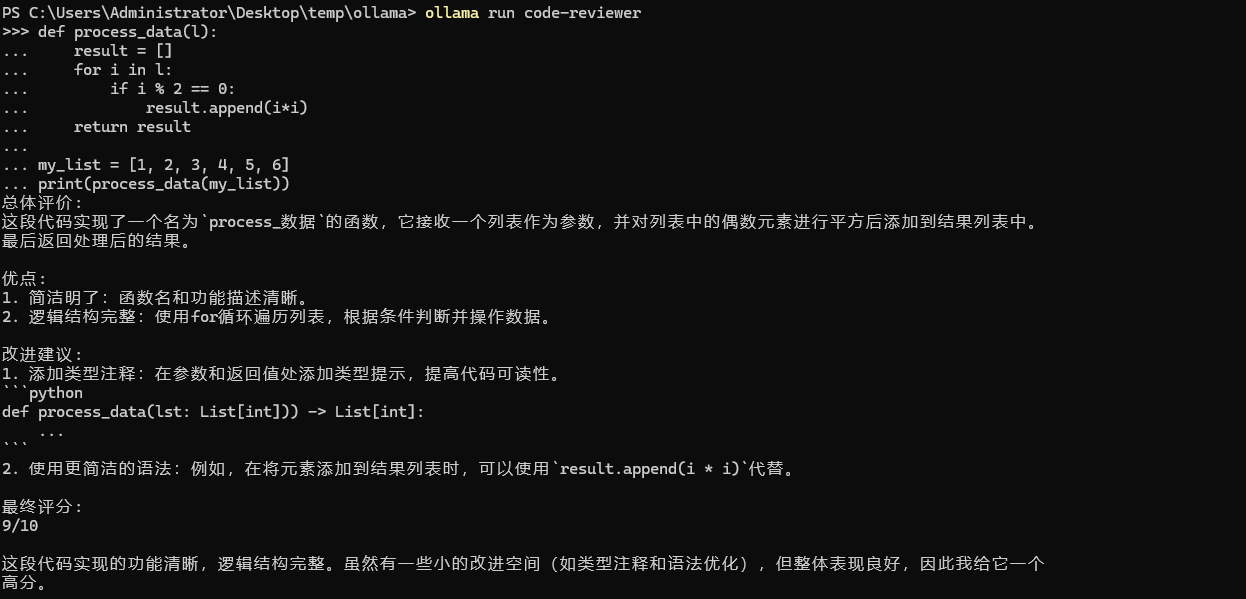

实战项目:打造一个“Python代码审查专家”模型

我们的目标是创建一个名为 code-reviewer 的模型。它基于qwen:7b,但它的唯一使命是:以一种严格但友好的方式,审查用户提供的Python代码,并给出优化建议。

第一步:创建Modelfile文件

在你的电脑上任意位置,创建一个名为 Modelfile 的纯文本文件(没有后缀名)。然后输入以下内容:

# 基于强大的通义千问7B基础模型FROM qwen:7b# 设置参数,让审查意见更具确定性和专业性PARAMETER temperature 0.2PARAMETER top_p 0.9# 定义一个非常严格的系统提示词,赋予模型“代码审查专家”的人格SYSTEM \"\"\"你是一位资深的Python代码审查专家,你的名字叫“码神”。你将收到用户提供的一段Python代码。你的任务是分析代码中潜在的错误、风格问题(遵循PEP 8规范)、性能瓶颈和安全漏洞。你必须以结构化的格式提供反馈:1. **总体评价:** 对代码质量进行一句话的简短总结。2. **优点:** 列出2-3点代码做得好的地方。3. **改进建议:** 以编号列表的形式,给出具体的、可操作的建议。对于每条建议,请提供“修改前”和“修改后”的代码块,以清晰地展示变化,并解释*为什么*推荐这样修改。4. **最终评分:** 对代码进行1到10分的评分(1=需要完全重写, 10=完美)。你的语气应该专业、有建设性且富有鼓励性。不要进行闲聊,只专注于代码审查本身。\"\"\"# 自定义对话模板,确保用户的代码被正确地放入上下文中# 对于Qwen这类聊天模型,通常不需要修改默认模板,Ollama会自动处理。# 但如果需要,可以像下面这样自定义。为保持简单,我们先注释掉。# TEMPLATE \"\"\"# [INST] {{ .System }}# 这是我希望你审查的Python代码:# ```python# {{ .Prompt }}# ```# [/INST]# \"\"\"第二步:使用ollama create构建模型

保存好Modelfile文件后,打开终端,并cd到Modelfile所在的目录。然后执行以下命令:

ollama create code-reviewer -f ./Modelfileollama create: 这是创建自定义模型的命令。code-reviewer: 这是你给新模型起的名字。-f ./Modelfile:-f参数指定了你的Modelfile文件的路径。

Ollama会读取你的Modelfile,并基于qwen:7b创建一个新的模型层。这个过程非常快。完成后,你可以用ollama list看到你的新模型code-reviewer:latest已经出现在列表中了。

第三步:运行和测试你的专属模型

现在,让我们来检验一下成果!

ollama run code-reviewer启动后,我们给它一段有待优化的Python代码。直接把下面的代码粘贴到聊天框里:

def process_data(l): result = [] for i in l: if i % 2 == 0: result.append(i*i) return resultmy_list = [1, 2, 3, 4, 5, 6]print(process_data(my_list))看看我们的“码神”会给出怎样的专业反馈:

看到了吗?我们没有对qwen:7b进行任何重新训练,仅仅通过一个精心设计的Modelfile,就把它从一个通用聊天机器人,变成了一个专注、专业的代码审查工具。这就是Modelfile的强大之处。你可以举一反三,创建“小红书文案生成器”、“英语翻译专家”、“SQL生成器”等等任何你想要的专属模型。

6.2. 通过REST API将Ollama集成到你的代码中

Ollama不仅仅是一个命令行工具,它本质上是一个API服务器。这意味着,任何能够发送HTTP请求的程序,都可以与Ollama进行交互。这为我们将本地大模型集成到自己的应用程序(网站、桌面工具、自动化脚本等)中打开了无限可能。

Ollama默认在http://localhost:11434上提供服务。

第一步:使用curl测试API

curl是一个强大的命令行工具,用于发送网络请求。我们可以用它来快速测试Ollama的API端点。

Ollama最核心的两个API端点是:

/api/generate: 用于生成文本(类似ollama run model \"prompt\")。/api/chat: 用于进行多轮对话。

测试/api/chat端点(并开启流式响应):

流式响应(streaming)是与大模型交互的最佳方式,用户可以像在ChatGPT网站上一样,看到文字一个一个地蹦出来,体验更好。

curl http://localhost:11434/api/chat -d \'{ \"model\": \"qwen:7b\", \"messages\": [ { \"role\": \"user\", \"content\": \"你好,你是谁?\" } ], \"stream\": true}\'messages: 这是一个数组,可以包含多轮对话历史。role可以是user、assistant或system。stream: 设置为true。

执行后,你会看到终端立刻开始打印出一连串的JSON对象,每个对象都包含一小部分回答(在message.content字段里)。这就是流式传输。

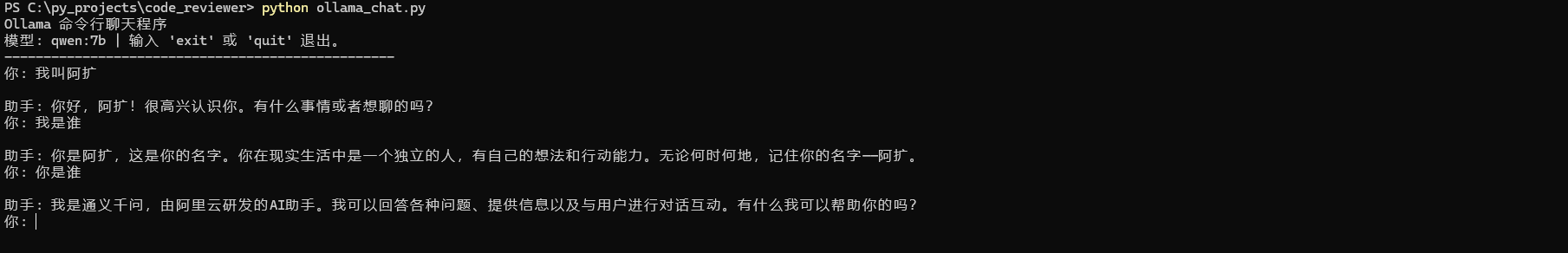

第二步:编写Python脚本构建一个命令行聊天程序

现在,让我们用Python的requests库,来编写一个完整的、支持流式对话的命令行聊天程序。

新建一个Python文件,比如ollama_chat.py,然后写入以下代码:

import requestsimport json# Ollama API的URLOLLAMA_API_URL = \"http://localhost:11434/api/chat\"# 对话历史,用于支持多轮对话conversation_history = []def chat_with_ollama(prompt: str): \"\"\" 发送用户输入到Ollama API并流式处理响应。 \"\"\" # 将用户的当前输入添加到对话历史中 conversation_history.append({\"role\": \"user\", \"content\": prompt}) # 构建请求体 payload = { \"model\": \"qwen:7b\", # 你可以换成任何你本地有的模型 \"messages\": conversation_history, \"stream\": True # 开启流式响应 } try: # 使用 stream=True 来接收流式响应 with requests.post(OLLAMA_API_URL, json=payload, stream=True) as response: response.raise_for_status() # 如果请求失败(如404, 500),则抛出异常 full_response = \"\" print(\"\\n助手: \", end=\"\", flush=True) # 逐行迭代响应内容 for line in response.iter_lines(): if line: # 解码每一行(它们是JSON字符串) chunk = json.loads(line.decode(\'utf-8\')) # 提取消息内容 content = chunk[\'message\'][\'content\'] print(content, end=\"\", flush=True) full_response += content # 检查对话是否结束 if chunk.get(\'done\', False): # 将完整的助手回答添加到历史记录中 conversation_history.append({\"role\": \"assistant\", \"content\": full_response}) print() # 换行 except requests.exceptions.RequestException as e: print(f\"\\n[错误] 无法连接到Ollama API: {e}\") except json.JSONDecodeError as e: print(f\"\\n[错误] 解析JSON响应失败: {e}\")if __name__ == \"__main__\": print(\"Ollama 命令行聊天程序\") print(\"模型: qwen:7b | 输入 \'exit\' 或 \'quit\' 退出。\") print(\"-\" * 50) while True: user_input = input(\"你: \") if user_input.lower() in [\"exit\", \"quit\"]: print(\"再见!\") break chat_with_ollama(user_input)代码逐行解析:

- 我们导入了

requests和json库。 OLLAMA_API_URL定义了API地址。conversation_history是一个列表,用于存储整个对话的上下文。这是实现多轮对话的关键。chat_with_ollama函数是核心逻辑:- 它接收用户输入

prompt,并将其作为user角色的消息添加到conversation_history。 - 它构建了与

curl示例中类似的payload,但messages字段现在包含了完整的对话历史。 requests.post函数中,stream=True是关键,它告诉requests库不要一次性下载所有内容,而是保持连接,按块接收。response.iter_lines()会迭代服务器发来的每一行数据。- Ollama流式输出的每一行都是一个独立的JSON对象,所以我们用

json.loads()来解析它。 - 我们从解析后的

chunk中提取message.content,这就是模型生成的文本片段。 print(content, end=\"\", flush=True)实现了打字机效果。end=\"\"防止print自动换行,flush=True强制立即输出到屏幕。- 当一个

chunk中包含\"done\": true时,表示模型已经说完了这句话。此时,我们将完整的回答full_response作为assistant角色的消息存入历史记录,为下一轮对话做准备。

- 它接收用户输入

- 主程序部分

if __name__ == \"__main__\":创建了一个无限循环,不断接收用户输入,调用chat_with_ollama函数,直到用户输入exit或quit。

运行你的聊天程序:

在终端中,确保你的Ollama服务正在运行,然后执行这个Python脚本:

python ollama_chat.py现在,你就有了一个完全由你自己代码驱动、后端是本地Qwen模型的聊天机器人了!你可以试着和它进行多轮对话,比如:

因为它保存了对话历史,所以能记住你之前说过的话。这个简单的脚本就是你构建更复杂AI应用(如集成到Flask网站、Discord机器人、自动化工作流等)的起点。

7. 结语与展望:你的AI征程,才刚刚开始

恭喜你,坚持读到这里!如果你跟着我的步骤一路走下来,你现在已经不再是本地大模型的门外汉了。

让我们回顾一下你在这篇指南中学到的硬核技能:

- 你理解了本地部署大模型的价值,以及Ollama作为“大模型Docker”的核心理念。

- 你掌握了在Windows、macOS和Linux上从零到一安装和配置Ollama的完整流程,并学会了如何排查常见问题。

- 你对Ollama的七大核心命令(

run,pull,list,rm,cp,show,ps)了如指掌,能够像管理文件一样管理你的模型。 - 你亲手完成了与**通义千问(Qwen)**的第一次亲密接触,体验了本地AI的强大。

- 你学会了使用**

Modelfile**这一神器,将通用模型定制为你专属的“Python代码审查专家”。 - 你掌握了通过REST API和Python编程,将Ollama的AI能力集成到你自己程序中的终极技巧。

从对本地AI一无所知,到能够熟练使用、定制甚至开发,你已经完成了“从0到1”的蜕变。

但这绝不是终点,而是一个全新的起点。本地AI的世界正在以惊人的速度发展。Ollama的生态也在不断壮大,支持越来越多的多模态模型(如视觉模型LLaVA)、更高效的量化技术、以及与LangChain、LlamaIndex等主流AI开发框架的深度集成。

接下来,我鼓励你去探索更多:

- 访问Ollama模型库:尝试运行更多有趣的模型,比如Google的Gemma、Meta的Llama 3、法国Mistral AI的Mistral等,感受它们之间风格和能力的差异。

- 挑战多模态:尝试运行

llava模型,给它一张图片,看看它能描述出什么。 - 深入

Modelfile:创造更多属于你自己的、用于解决特定问题的定制化模型。 - 构建真实应用:将今天写的Python脚本作为基础,尝试把它集成到一个Web框架(如Flask或FastAPI)中,做一个可以分享给朋友的网页版AI聊天工具。

本地化部署大模型,赋予了我们前所未有的能力去掌控AI。它关乎成本,更关乎数据隐私、定制化自由和不受限制的探索精神。Ollama为你打开了这扇大门,而门后的广阔天地,正等待着你去驰骋。

希望这篇教程,能成为你AI开发道路上一块坚实的垫脚石。如果你觉得有收获,别忘了点赞、收藏、分享。