LLaMA-Factory安装教程(详细版)_llamafactory安装

本机显卡双3090

使用wsl中ubuntu

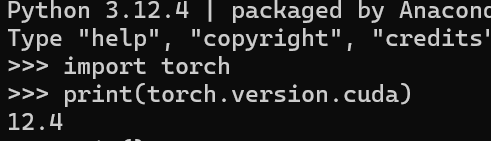

torch==2.6.0

conda==24.5.0

cuda==12.4

python==3.12.4(python安装不做赘述,有需要我会另开一篇文章)

一、准备工作

首先,在 https://developer.nvidia.com/cuda-gpus 查看您的 GPU 是否支持CUDA。

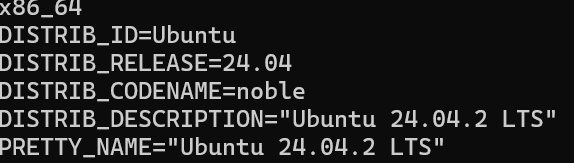

保证当前 Linux 版本支持CUDA. 在命令行中输入

uname -m && cat /etc/*release输出如下,不一定完全一样,类似即可

检查是否安装了 gcc . 在命令行中输入 gcc --version ,应当看到类似的输出

![]()

二、pytorch和cuda安装

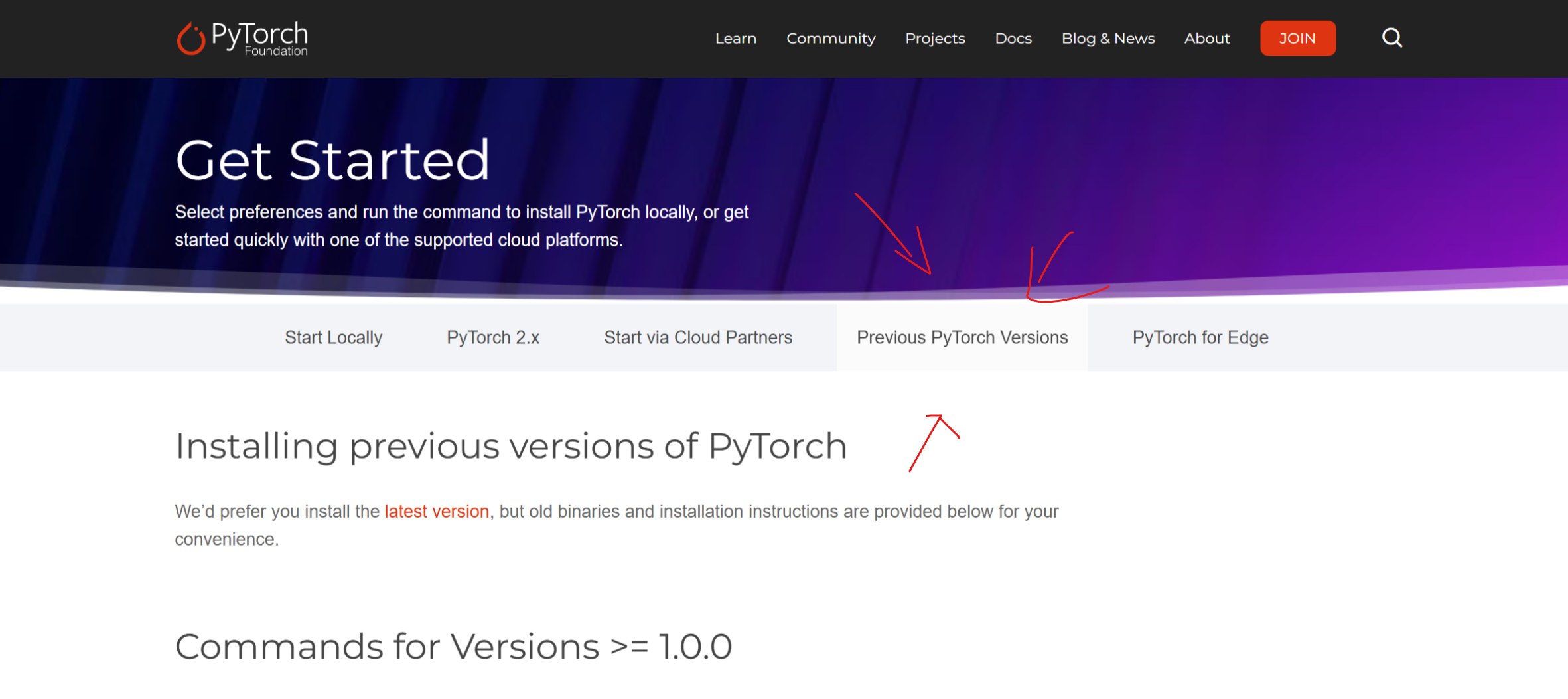

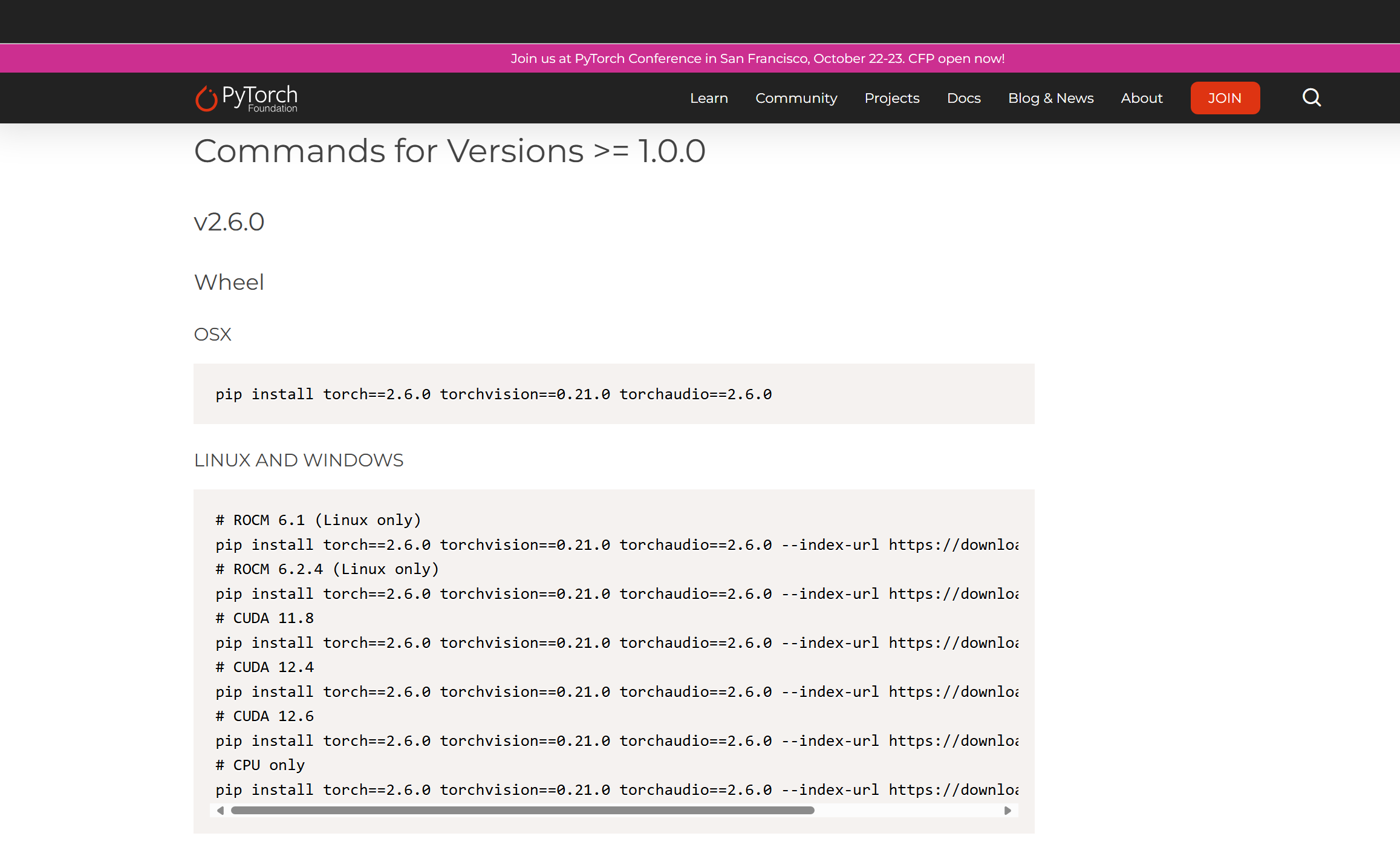

使用官网版本2.6.0 官网链接:Previous PyTorch Versions 箭头一栏可以看到历史版本

根据其指令安装对应版本

# ROCM 6.1 (Linux only)pip install torch==2.6.0 torchvision==0.21.0 torchaudio==2.6.0 --index-url https://download.pytorch.org/whl/rocm6.1# ROCM 6.2.4 (Linux only)pip install torch==2.6.0 torchvision==0.21.0 torchaudio==2.6.0 --index-url https://download.pytorch.org/whl/rocm6.2.4# CUDA 11.8pip install torch==2.6.0 torchvision==0.21.0 torchaudio==2.6.0 --index-url https://download.pytorch.org/whl/cu118# CUDA 12.4pip install torch==2.6.0 torchvision==0.21.0 torchaudio==2.6.0 --index-url https://download.pytorch.org/whl/cu124# CUDA 12.6pip install torch==2.6.0 torchvision==0.21.0 torchaudio==2.6.0 --index-url https://download.pytorch.org/whl/cu126# CPU onlypip install torch==2.6.0 torchvision==0.21.0 torchaudio==2.6.0 --index-url https://download.pytorch.org/whl/cpu三、校检torch和cuda版本

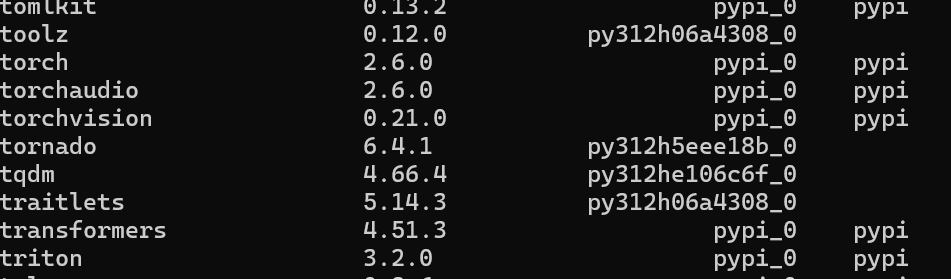

安装完查看自己的torch版本

conda list

cuda版本则需要进入python

import torchprint(torch.version.cuda)

四、LLaMA-Factory 安装

运行以下指令以安装 LLaMA-Factory 及其依赖:

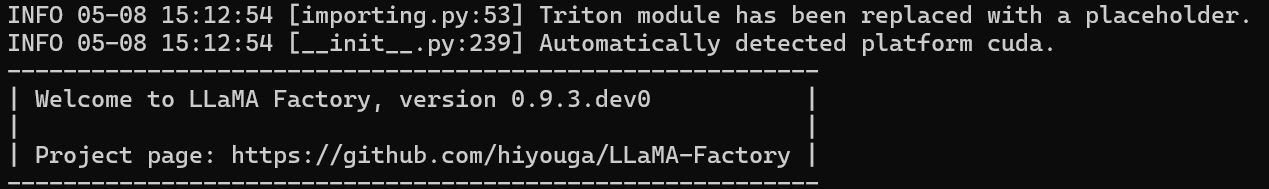

git clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.gitcd LLaMA-Factorypip install -e \".[torch,metrics]\"五、LLaMA-Factory 校验

完成安装后,可以通过使用以下命令。

llamafactory-cli version如果您能成功看到类似下面的界面,就说明安装成功了。

六、LLaMA-Factory 网页版

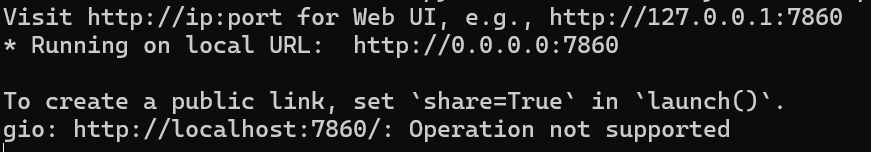

LLaMA-Factory 支持通过 WebUI 零代码微调大语言模型。 在完成 安装 后,通过以下指令进入 WebUI:

llamafactory-cli webui

其中 http://127.0.0.1:7860就是你的可视化网址。

注:该网址只限于本机使用,如需联网多人服务器使用则需使用内网穿透。

ps.需要更详细的LLaMA-Factory参数详解,请点击关注催更留言,觉得内容不错留个赞再走吧,您的认可就是我更新的动力。