低代码+AI大脑:Open-WebUI 智能体构建全攻略_openwebui

分享话题:

今天想跟大家聊的话题是——把 Open-WebUI 装进本机 Docker Desktop:一条命令跑起来的极简秘籍。

1:什么是open-webui

Open-WebUI 是一个开源、可扩展、支持完全离线运行的「自托管 AI 聊天平台」,用浏览器就能和本地或云端的大语言模型(LLM)对话。

它原本叫 “Ollama WebUI”,后来独立出来,定位相当于「ChatGPT 网页版的私有化平替」。

-

支持的后端:Ollama、OpenAI 兼容 API(LMStudio、Groq、Mistral、OpenRouter…)。

-

内置功能:RAG 知识库、网页浏览、语音/图像/多模态、Markdown+LaTeX、角色权限、PWA 移动端、插件流水线等。

-

部署方式:Docker 一条命令即可,数据全部落在本地,隐私可控。

-

使用体验:打开浏览器 → 选模型 → 开聊,UI 与 ChatGPT 类似,零代码上手

就在本地!Open-WebUI 是一款高度可定制的自托管 AI 门户,集优雅界面与强大功能于一身。无论你是想私有化运行大模型,还是深度定制智能交互体验,它都能让你一键启航,玩转本地LLM世界

2:安装所需要的流程

安装过程依托本地 Docker Desktop 平台,通过容器化方式高效部署 Open-WebUI 及相关 AI 服务组件。

第一步拉取代码:

git clone https://github.com/open-webui/open-webui.gitcd open-webui

切换到 open-webui 项目目录,执行 docker-compose up 命令,一键构建并启动所有相关容器服务。

![]()

只要 Docker 不闹脾气,一键拉好镜像,浏览器马上就能用:localhost:3000 直接开聊,连端口都不用改!

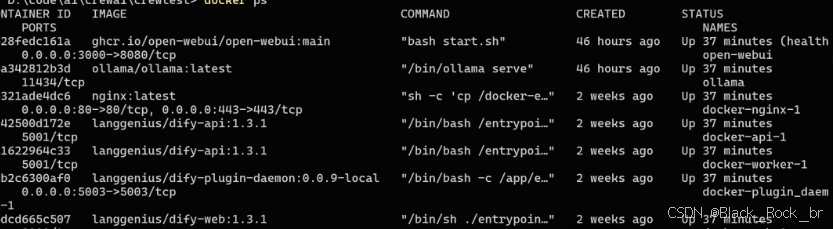

可以通过docker ps 命令 查看安装运行状况:

本地运行效果:

镜像跑起来后,下一步是「喂」给它能说话的模型。

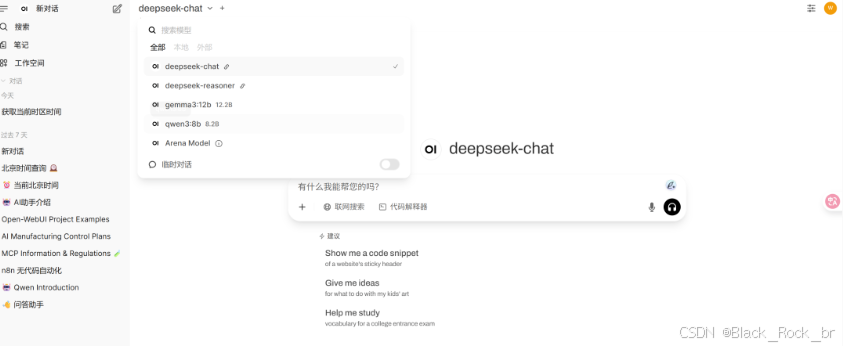

打开浏览器里的 3000 端口,第一次进入会弹出设置向导,把下面三件事一次性搞定即可:

-

选后端

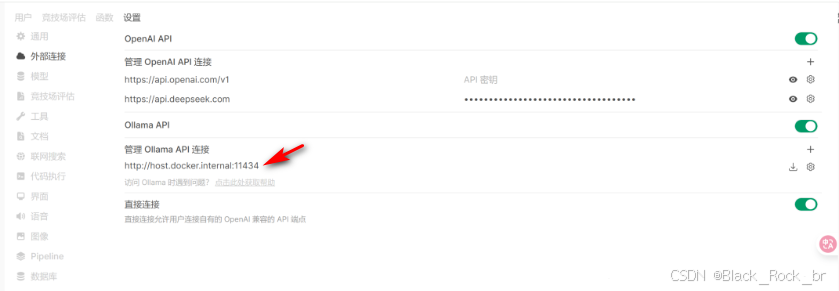

• 本地已有 Ollama:填 http://host.docker.internal:11434

• 想用 OpenAI / Groq / Mistral:直接填官方或中转的 API endpoint

• 多后端可以同时挂,聊天时随时切换 -

填密钥(需要就填)

如果后端要求 token,把 key 粘进去;本地 Ollama 空着就行。 -

拉模型

在「模型管理」里输入名字,例如 llama3:8b,点「Pull」,等进度条跑完即可。

不想在线拉,也可以把提前下好的 .gguf 文件丢进挂载目录,UI 里会秒识别。

设置完刷新一下,左上角模型列表就能选到刚拉好的模型,直接对话!

注意事项一:Docker 环境中的服务地址配置

由于系统通过 Docker 容器运行,在配置外部服务(如 Ollama)连接地址时,需特别注意网络环境。若直接使用 http://localhost:11434,容器将无法访问宿主机服务。正确做法是使用 http://host.docker.internal:11434 —— 这是 Docker 提供的特殊 DNS 名称,用于从容器内部访问宿主机。

注意事项二:本地 Ollama 服务启动方式

请确保在宿主机上已启动 Ollama,并通过运行 ollama serve 命令激活服务。只有在服务正常运行的前提下,Open-WebUI 才能成功与其通信并调用模型。

以上即为 Open-WebUI 在本地环境下的完整部署流程。基于这一自托管平台,我们将持续构建一系列高效、安全、可定制的 AI 智能体应用,开启本地化大模型实践的新篇章。