5个值得推荐的AI大模型API(超级详细)_ai大模型的api

前言

环球日报将2024年称为“AI元年”,各种AI应用开始深入到我们日常生活的方方面面。随着AI的不断被挖掘,各种行业细分的AI模型也层出不穷,如果有一个API平台可以将这些形形色色的模型整合到一起,那么绝对是对开发者最大的福报。

环球时报将2024年成为“AI元年”。生成式AI正以前所未有的速度,在文本、图像、音频和视频等地方掀起一场创作革命。在文字领域,AI写作工具已不再局限于生成新闻报道,而是能够驾驭小说、诗歌等复杂的文学创作。在视觉领域,DALL·E等工具能将文字描述即时转化为惊艳的图像,深刻影响着设计、广告和娱乐行业,并为品牌与客户的互动带来更生动的体验。此外,其影响力还延伸至交互领域,AI助手在客户支持中展现出处理复杂查询的能力,日益智能。展望未来,生成式AI必将在创意产业、教育及科研中获得大规模应用,成为推动知识生产和内容创作效率实现飞跃的核心引擎。

本文将深入分析这些前沿的AI大模型API接口,为读者展示2025年最值得关注的推荐选择。

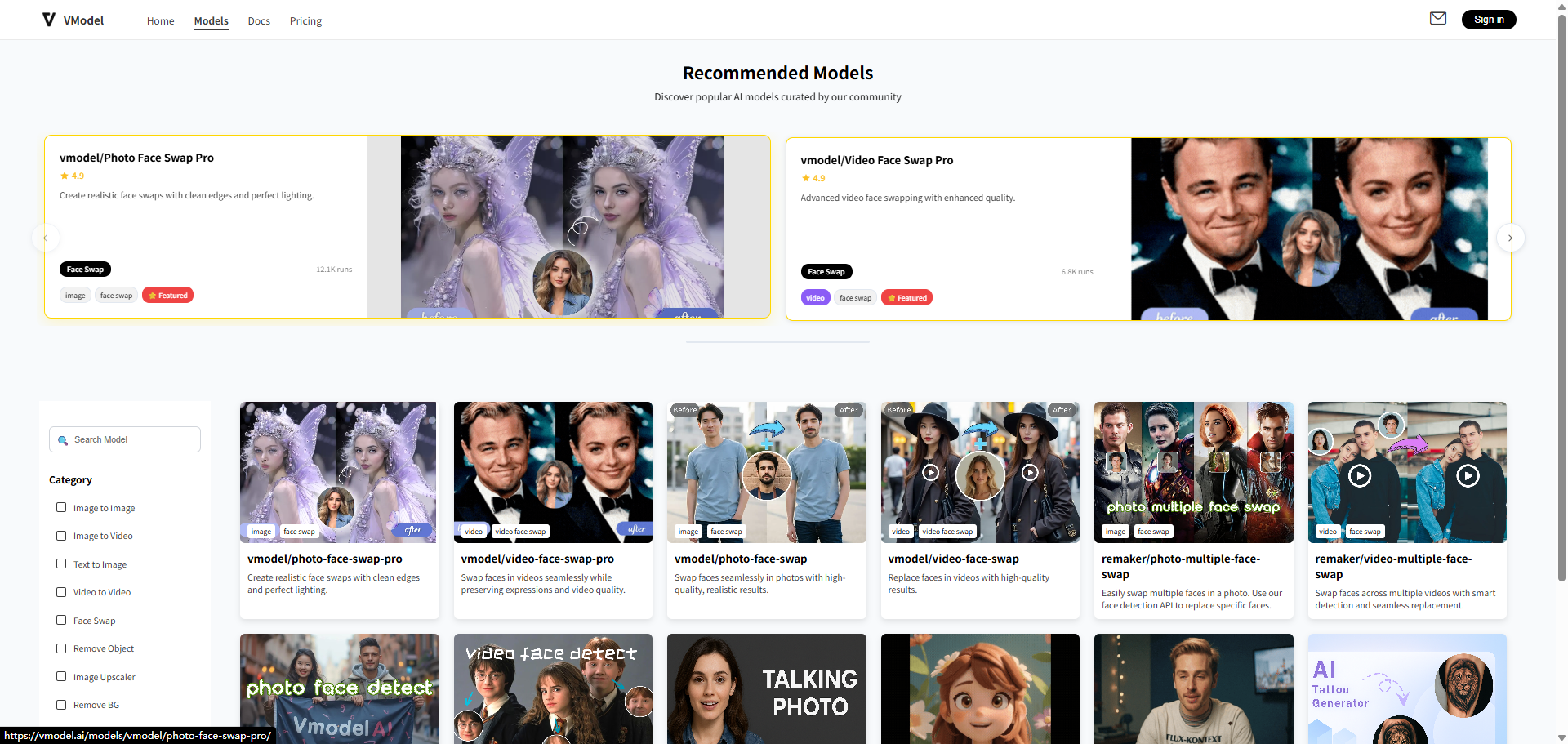

Vmdoel AI

vmodel是我近期正在使用的一个AI API平台。这个平台提供的模型都是从功能上封装好的,比如AI数字人,AI口播,换脸,写真这些模型,我可以直接拿来使用,不用自己再去写复杂的prompt了,方便我的产品快速上线,然后验证结果。如果向传统的api那样,我需要通过prompt不断调整我的输出结果,但是最后验证阶段可能不通过,白白浪费很多时间。

核心功能:

- 注册即送10$体验金,可以用来体验所有模型,没有限制

- 提供各种风格、类型的模型,开箱即用,可以快速集成

- 标准的API接口,提供了统一的API接口,方便继承封装

- 支持webhook(回调通知)

- one to one的客服,对接过程中给了很大支持

- 支持定制化,私有化模型部署

Replicate

目前AI API行业中的翘楚,和fal ai大概瓜分了80%的市场(或者更多)。Replicate它的核心卖点在于开发者无需自行管理基础设施 。什么意思呢,就是你不需要自己管理任务排队,机器伸缩这些问题 ,这些replicate都会替你做了,这一特性对希望快速高效集成AI能力的开发者而言,具有显著的吸引力。同时它还支持用户自己上传模型,使用cog命令部署自己模型。

主要功能:

- 开源模型集成:支持大部分的开源模型,包括Stable Diffusion等图像生成器、音频处理器和语言模型

- 自定义模型部署:开发者可以部署自己的机器学习模型并将其作为API公开

- 按需付费定价:大部分模型是按gpu使用时间收费,价格比自己部署贵一些,但是人家帮咱管理机器了么,多花点值!

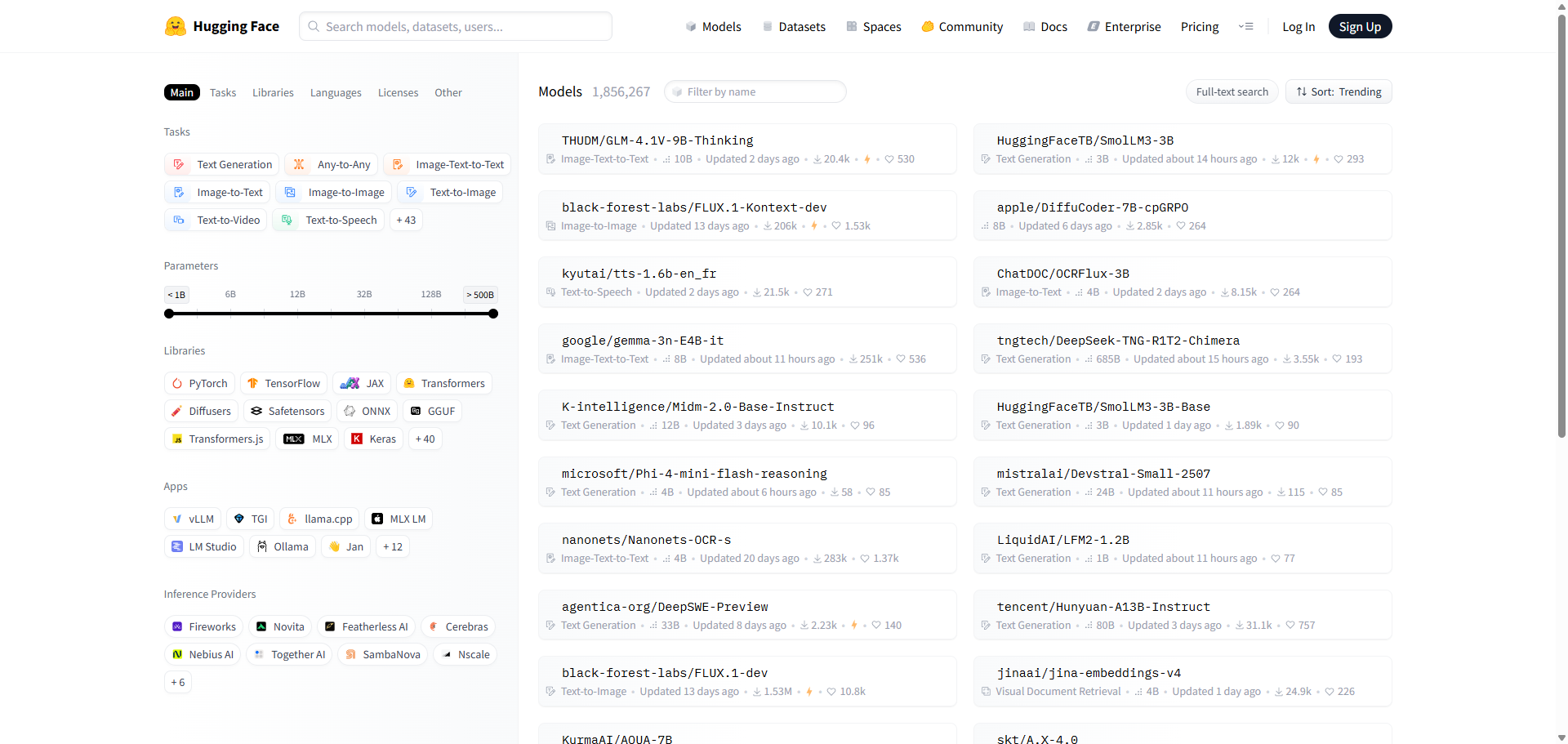

Huggingface

Hugging Face其实我更愿意称它为是一个社区。它不仅提供API来简化预训练机器学习模型的访问和使用,更重要的是,它建立了一个强大的社区,让研究人员、数据科学家和开发者能够共享数据集、模型和应用程序,共同推动AI技术的发展。很多新的模型你都可以在hugginface上找到。

-

庞大的模型库与Transformer库: Hugging Face通过其“transformers库”提供了对GPT、BERT、CLIP、Google的Gemma、Microsoft Phi、DeepSeek的R1等前沿模型的访问 。该库提供了即用型API,极大地加速了开发进程 。

-

易于集成与可扩展性: 平台支持将预训练模型无缝集成到应用程序中,既适用于小型项目,也适用于企业级部署 。

-

自定义模型托管: 用户可以轻松托管和访问自己训练的自定义模型 。

-

API访问与管理: 提供推理API用于高级集成,并提供生成API密钥和发起请求的清晰步骤 。同时提供Python和JS客户端库 。

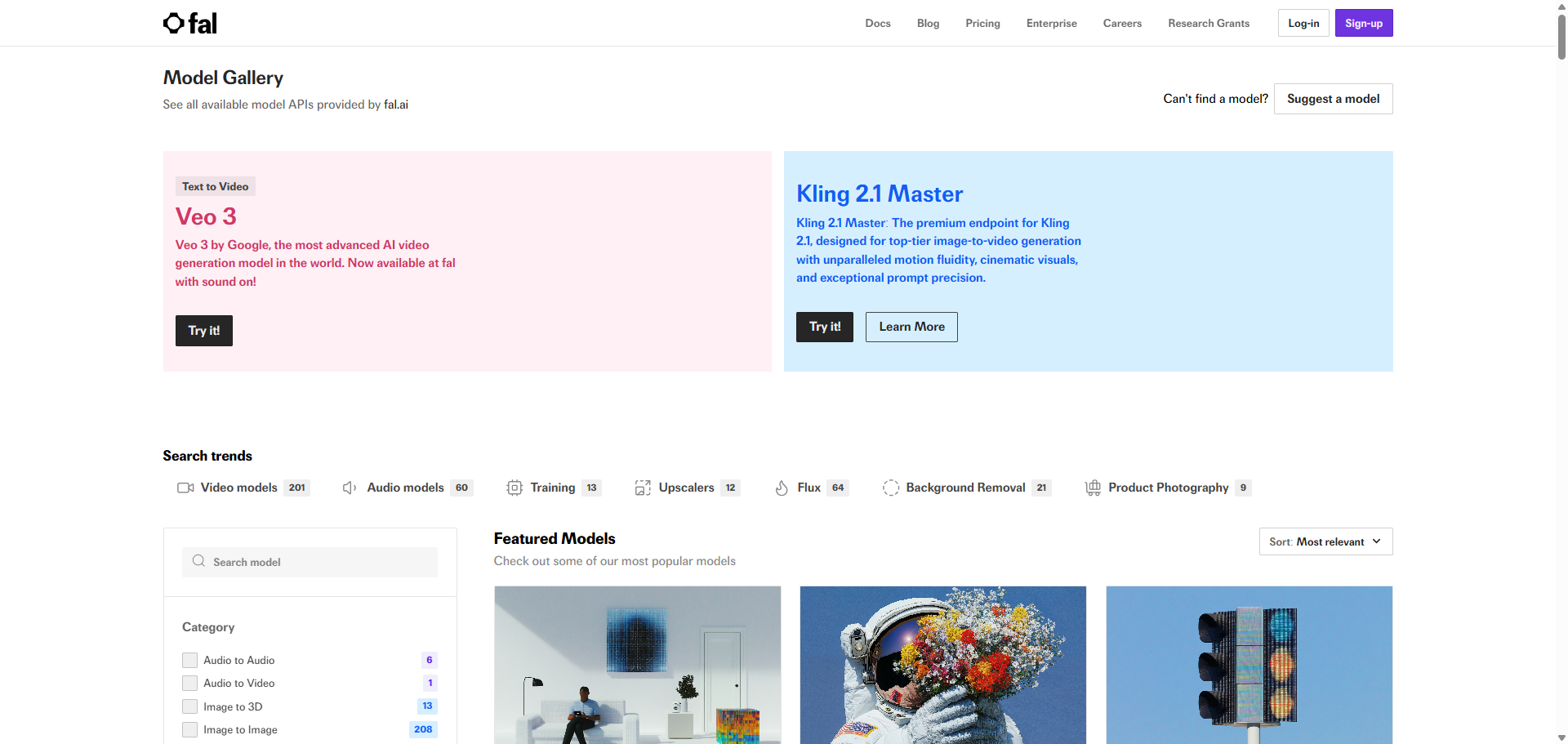

Fal.ai

Fal.ai是一个专为开发者设计的生成式媒体平台,其核心优势在于“加速生成式媒体”,什么意思呢,就是sd本来需要10s出图,你用它优化后的模型3s出图。同时它也提供了各式各样的图像、视频类模型。

它独特的“fal推理引擎™”可以让扩散模型能够比其他替代方案快4倍,FLUX模型甚至能快400% 。这种速度优势对于需要实时AI应用、实时内容生成或高吞吐量媒体生产的场景至关重要。

主要功能:

-

闪电般快速的推理: 声称扩散模型速度可达4倍,FLUX模型速度可达400%,这得益于其专有的“fal推理引擎™” 。这种速度能够实现实时用户体验 。

-

优化性能: 模型通过Fal推理引擎™进行优化,在不牺牲质量的前提下实现峰值性能 。

-

全面的生成式媒体模型: 支持广泛的生成式媒体模型,包括文本到视频(Veo 3、Kling 2.1)、图像到视频(MiniMax Hailuo 02、Pixverse)、文本到图像(FLUX.1、AuraFlow、Recraft V3)、图像到图像(FLUX.1 Kontext)以及转录(Whisper、Wizper) 。

-

LoRA训练能力: 提供“业内最佳的FLUX LoRA训练器”,允许用户在5分钟内训练和个性化模型(例如,新风格) 。Fal.ai的AI研究负责人被认为是第一个实现扩散模型LoRA的人 。

-

私有模型推理: 支持运行自定义扩散transformer模型,推理速度可提高50% 。

-

可扩展架构: 设计上可扩展至数千个GPU,确保在高负载下也能保持高可用性和性能 。

-

开发者友好集成: 提供JavaScript、Python和Swift客户端库,可直接集成到应用程序中 。支持通过API密钥、基础URL、头部信息和自定义fetch进行可定制的提供商实例配置 。

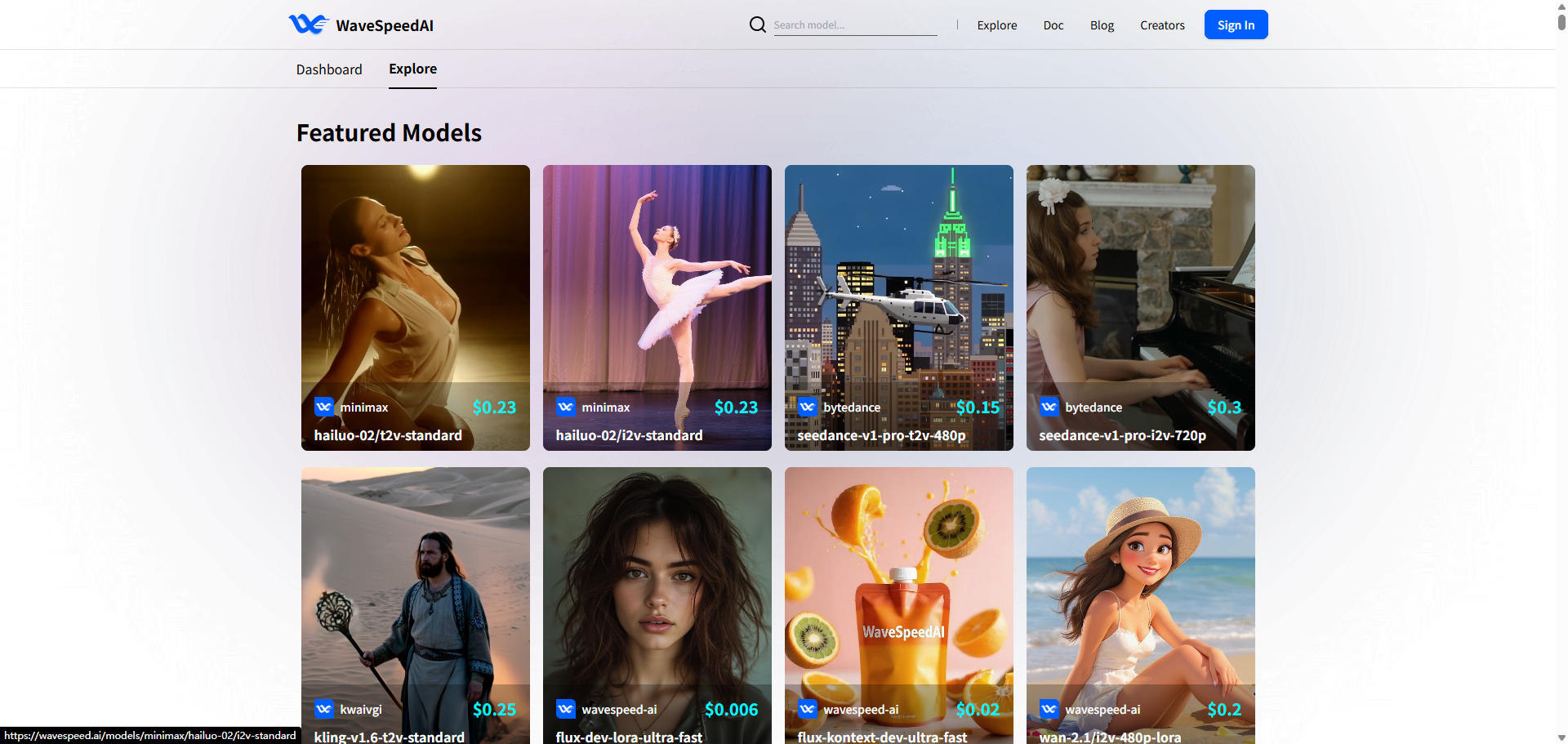

Wavespeed AI

Wavespeed AI也是一个主打“模型加速”的平台,这点和fal很像,这里就不多赘述了。

主要功能:

-

高性能图像与视频生成: 为AI图像和视频提供行业领先的生成速度 。声称“极速”以最大化生产力 。

-

ComfyUI集成: 为ComfyUI提供了自定义节点,允许用户在ComfyUI工作流中直接使用WaveSpeed AI API 。这对于熟悉或偏好ComfyUI节点式界面的用户而言是一个重要功能。

-

通过URL支持LoRA: 与本地LoRA文件不同,Wavespeed AI支持通过URL加载LoRA,包括“WaveSpeedAi Wan Loras”和“WaveSpeedAi Flux Loras” 。这提供了灵活性,并可能简化远程模型的集成。

-

特色模型: 包括

kwaivgi、kling-v1.6-t2v-standard(视频生成)、flux-dev-lora-ultra-fast(支持LoRA的图像生成)、flux-kontext-dev-ultra-fast(图像编辑)、wan-2.1/i2v-480p-lora(图像到视频)以及MiniMax的hailuo-02/i2v-standard(高效视频生成) 。还支持Seedance用于视频创作 。

总结

- 如果你不想调试复杂的prompt,想快速验证产品可行性,选vmodel没错。丰富的模型,可以适配各种业务,简单的对接方式,可以让你快速上线功能,从而腾出时间去做其他的事情

- 如果你需要一个强大,稳定,可靠的api平台,那么replicate和fal是你不错的选择,但是价格略贵

- 如果你想学习更多的ai知识,并且想上手实操,那么huggingface最适合你,它有完善的社区,各种问题都有人为你解答