RabbitMQ中如何保证消息不被重复消费_rabbitmq如何保证消息不重复消费

前引

什么情况下会导致消息被重复消费呢?

1.生产者:生产者可能会重复推送一条数据到MQ中,比如Controller接口被重复调用了2次,没有做接口幂等性导致;

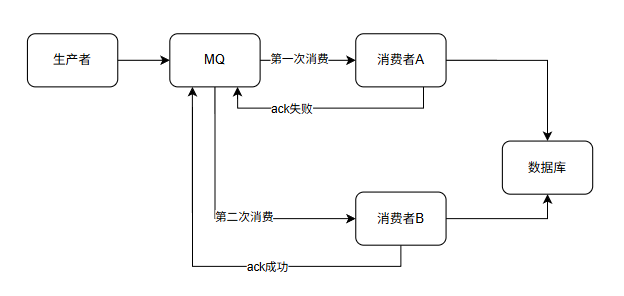

2.MQ:在消费者消费完准备相应ack消息消费成功时,MQ突然挂了,导致MQ以为消费者还未消费该条数据,MQ恢复后再次推送了该条消息。

3.消费者:消费者已经消费完消息,正准备但是还未响应给ack消息时,此时消费者挂了,服务器重启后MQ以为消费者还没有消费该消息,再次推送了该条消息。

在 RabbitMQ 里,消息重复消费通常由网络波动、确认机制超时、消费者故障重试等引发。解决该问题,核心思路是让消费逻辑具备 “幂等性”(多次执行同一操作,结果与单次执行一致,无额外副作用 ),结合以下方案保障:

一、基于 “唯一标识 + 记录消费状态” 去重

- 生成唯一消息 ID

生产者发送消息时,为每条消息附加全局唯一标识(如 UUID、业务单号 + 操作码 ),随消息传递到消费者。示例(伪代码):

// 生产者String msgId = UUID.randomUUID().toString();Message message = MessageBuilder.withBody(\"业务内容\".getBytes()) .setHeader(\"msgId\", msgId) .build();rabbitTemplate.send(\"exchange\", \"routingKey\", message);- 记录已消费的消息 ID

消费者消费前,先查询 “已消费 ID 列表”(存 Redis、数据库等),判断是否处理过:

- 用 Redis 存储(推荐,读写快):以消息 ID 为 Key,值标记为已处理(如存

processed),并设置合理过期时间(结合业务最大重试周期,避免内存堆积 )。

// 消费者@RabbitListener(queues = \"queueName\")public void consume(Message message) { String msgId = message.getHeader(\"msgId\"); // 检查是否已消费 if (redisTemplate.hasKey(\"consumed_msg:\" + msgId)) { return; // 重复消息,直接丢弃 } // 业务处理 handleBusiness(message); // 标记为已消费 redisTemplate.opsForValue().set(\"consumed_msg:\" + msgId, \"processed\", 3600, TimeUnit.SECONDS); }- 用数据库存储:建表(如

msg_consume_record),存消息 ID、消费时间,消费前查库判断。适合需持久化记录、业务对 Redis 依赖弱的场景,但要注意查询性能(加索引)。

二、利用消费逻辑的 “幂等性”

让业务操作本身具备重复执行无影响的特性,无需额外去重,常见场景:

- Redis 写操作:如

SET key value(重复设置同值,结果不变 )、INCR(需业务容忍重复递增时不适用,若业务是 “计数 +1”,重复消费会超预期,需结合 ID 去重 )。 - 数据库唯一键约束:若消息是 “新增订单”,订单号设为唯一主键,重复消费时触发主键冲突,数据库直接拒绝,不影响数据一致性。

- 状态机控制:业务操作依赖状态判断,如订单 “待支付→已支付”,重复消费时检查状态,已变更则跳过。

三、优化 RabbitMQ 确认与重试机制

- 合理设置手动 ACK 与重试策略

启用手动 ACK(autoAck = false),消费者处理完业务再手动确认(channel.basicAck)。若处理中消费者宕机,RabbitMQ 会将未 ACK 消息重新入队。同时:

- 控制重试次数:配置死信队列(DLQ),消费重试超限后,将消息丢入死信队列,避免无限制重复投递。

- 缩短 ACK 超时:RabbitMQ 服务端可设置

channel.basicQos控制未确认消息数量,或调整消费者侧超时,减少因超时而触发的重复投递。

- 避免生产者重复发消息

结合 “生产者确认机制(Confirm)”,确保消息仅成功发往 MQ 一次。若生产者未收到 MQ 的 ACK 响应,再重试发送(需保证消息 ID 不变,否则消费者侧去重逻辑失效 )。

四、复杂场景补充:分布式锁

若消费操作涉及多个资源协同修改(如扣减库存 + 生成订单),仅靠消息 ID 去重可能不够(高并发下,不同消费者同时处理同消息,ID 查询可能有延迟 )。可引入分布式锁:

- 消费时,以消息 ID 为锁 Key,尝试获取锁(如 Redis 的

SET key value NX EX)。 - 拿到锁则处理业务,处理完释放锁;未拿到锁则放弃消费(或重试),避免并发重复处理。

总结方案选择

- 简单业务:优先用 “唯一 ID + Redis 记录”,搭配消费逻辑幂等性(如 Redis 写操作、DB 唯一键 )。

- 高并发场景:在 ID 去重基础上,用分布式锁兜底,或依赖 MQ 手动 ACK + 死信队列控制重试。

- 极端严格场景:组合 “ID 去重 + 幂等逻辑 + 分布式锁”,确保重复消费绝对不影响业务结果。

本质上,消息重复消费无法完全避免(网络、系统故障是常态 ),但通过让消费逻辑 “幂等” + 精准记录 / 校验消费状态,可彻底屏蔽重复消费的影响~