系统优化:docker当中的/dev/shm共享内存问题_docker shm

文章目录

-

- Docker中的`/dev/shm`共享内存问题详解

-

- 1. **什么是共享内存(/dev/shm)?**

- 2. **Docker容器中的`/dev/shm`**

- 3. **Docker `/dev/shm` 问题产生的原因**

-

- 3.1 默认分配过小

- 3.2 长时间未释放内存

- 3.3 高并发应用场景

- 4. **如何诊断和解决 Docker `/dev/shm` 问题**

-

- 4.1 检查共享内存使用情况

- 4.2 增加共享内存大小

- 4.3 容器重启和垃圾回收

- 5. **实际应用场景中的优化策略**

-

- 5.1 RocketMQ 场景下的优化

- 5.2 数据库容器中的优化

- 6. 实战问题解决

-

- 0. 问题背景

- 1. 问题排查

- 2. 问题原因

- 3. 解决方案

-

- 方案一:重新运行容器,增大共享内存

- 方案二:修改配置,重新运行容器

- 方案三:定期监控和优化

- 4. 实战经验总结

Docker中的/dev/shm共享内存问题详解

在容器化应用程序的开发和运维中,内存管理是一个不可忽视的重要话题。而其中,/dev/shm(共享内存)作为进程间通信的重要机制,在 Docker 容器中也扮演了关键角色。本文将从共享内存的基本概念出发,深入探讨 Docker 中 /dev/shm 的问题、配置与优化策略,并结合实际应用案例提供解决方案。

1. 什么是共享内存(/dev/shm)?

共享内存是一种高效的进程间通信(IPC)机制。多个进程可以通过访问相同的内存区域来共享数据,而不必像通过管道或消息队列那样频繁复制数据。这种方式减少了内存复制的开销,并且提供了更快的数据传递速度。

在 Linux 系统中,/dev/shm 目录用于存储共享内存段。它是一个虚拟文件系统,通常挂载在内存中,因此读写速度极快。共享内存的大小通常是物理内存的一部分,默认为总内存大小的一半(50%)。

2. Docker容器中的/dev/shm

当我们在 Docker 中运行应用程序时,Docker 容器中的 /dev/shm 默认是以 tmpfs 文件系统的方式挂载的,也就是说它存在于内存中,而非硬盘上。Docker 默认为每个容器分配 64MB 的共享内存,这对于一些应用来说可能是足够的,但对于某些需要大量内存进行进程间数据共享的应用(如数据库、消息队列等),这个大小可能会非常有限,导致性能瓶颈甚至容器异常。

/dev/shm 目录在 Docker 容器内的用途与宿主机相同,用于进程间通信。如果这个目录满了,容器中相关的进程可能会崩溃或无法正常工作。

3. Docker /dev/shm 问题产生的原因

在 Docker 中,常见的共享内存相关问题通常表现为:

- 容器的共享内存被耗尽,导致应用程序崩溃或性能下降。

- 应用程序尝试使用的共享内存大于容器的默认配置(64MB),导致无法分配内存。

- 长时间运行的容器,由于没有释放或清理共享内存,导致内存逐渐耗尽。

这些问题主要源于以下几点:

3.1 默认分配过小

Docker 容器默认只分配了 64MB 的共享内存,这个默认值对于许多应用场景(如大型数据库、消息队列等)来说远远不够。假如某个应用程序需要大量的共享内存来处理任务,而分配的内存不足,那么这个应用程序会遇到内存溢出或无法分配内存的错误。

3.2 长时间未释放内存

某些服务可能在运行过程中未能有效释放或清理共享内存,特别是当应用程序有内存泄漏时,未释放的共享内存会不断累积,最终耗尽容器的共享内存分配,进而导致服务崩溃。

3.3 高并发应用场景

在高并发或高负载的应用场景下(如消息队列系统),共享内存的使用需求激增。如果 Docker 容器中的共享内存配置不足,系统性能可能会急剧下降,甚至应用程序会因内存耗尽而无法继续运行。

4. 如何诊断和解决 Docker /dev/shm 问题

4.1 检查共享内存使用情况

当遇到与共享内存相关的问题时,首先可以通过以下几种方式检查当前共享内存的使用情况:

-

通过

df查看共享内存使用情况:

在容器内部,可以使用以下命令检查/dev/shm的使用情况:df -h /dev/shm这将显示

/dev/shm的总大小和已使用的空间。 -

通过

du命令分析具体文件占用:

如果想了解哪些文件正在占用共享内存,可以使用:du -sh /dev/shm/* -

Docker stats 命令:

docker stats可以查看容器的资源使用情况,包括内存和 CPU 使用情况。如果某个容器消耗了大量的共享内存,这可能是问题的源头。

4.2 增加共享内存大小

如果发现 /dev/shm 的默认 64MB 不足以满足应用需求,可以在启动 Docker 容器时通过 --shm-size 参数来增大共享内存大小。例如:

docker run --shm-size=256m your_image这将为容器分配 256MB 的共享内存。根据应用的需求,你可以调整为更大的值。

4.3 容器重启和垃圾回收

如果容器中的共享内存已经满了,并且没有办法通过调整来解决,最直接的方法是重启容器。重启容器后,/dev/shm 会被清空,所有的共享内存都会被释放。

docker restart <container_id>此外,对于一些长期运行的服务,定期重启容器或者引入内存垃圾回收机制也是一种有效的维护策略。

5. 实际应用场景中的优化策略

5.1 RocketMQ 场景下的优化

以 RocketMQ 为例,RocketMQ 是一个分布式消息中间件,它可能会使用共享内存进行消息缓存。假如你在运行 RocketMQ 容器时发现 /dev/shm 空间不足,解决方法包括:

-

调大

/dev/shm的大小:

使用--shm-size选项为 RocketMQ 容器分配更大的共享内存空间,防止内存耗尽。docker run --shm-size=512m rocketmq_image -

定期清理无效的消息或日志:

通过设置消息过期策略或日志清理策略,减少共享内存的占用。

5.2 数据库容器中的优化

对于像 PostgreSQL、MySQL 这样的数据库系统,往往需要较大的共享内存来提升查询效率。为了避免容器因为共享内存不足导致查询失败或性能下降,可以:

-

增加

/dev/shm的大小:

数据库通常需要较大的共享内存,例如:docker run --shm-size=1g postgres_image -

配置内存管理:

数据库系统本身通常支持配置共享内存参数,合理配置数据库内部的共享内存设置可以有效减少内存问题。

6. 实战问题解决

0. 问题背景

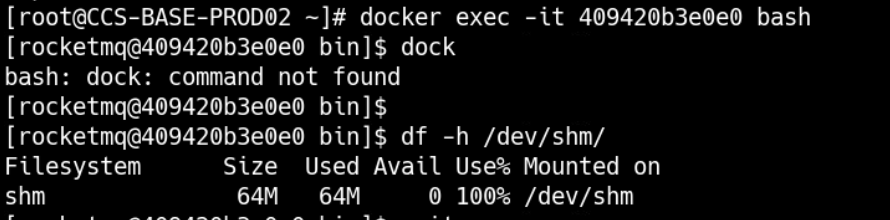

在我们生产环境中,一个运行了 15 个月的 RocketMQ 容器(ID: 409420b3e0e0,镜像为 foxiswho/rocketmq:broker)遇到了共享内存耗尽的问题。通过查看容器的 /dev/shm 挂载点,发现其容量已满:

shm 64M 64M 0 100% /data/docker/containers/409420b3e0e0e300a42f7b56b0606fa5f716afaf07cb3e5dfff373ce9c66113a/mounts/shmRocketMQ 服务使用的共享内存默认大小是 64MB,而 df -h 的输出显示共享内存已经耗尽,这导致了服务的性能下降甚至可能引发宕机。

1. 问题排查

首先,通过 docker inspect 查看容器的共享内存配置:

docker inspect 409420b3e0e0 | grep ShmSize结果显示,该容器的共享内存大小为 64MB:

\"ShmSize\": 67108864, # 64MB然后,进入容器docker exec -it 409420b3e0e0 bash,通过查看宿主机的 df -h /dev/shm:

df -h /dev/shm发现宿主机的 /dev/shm 仅占用 1.1MB,这与容器内的共享内存使用并不一致。这是因为宿主机和容器的共享内存是分开的,Docker 为每个容器单独分配了共享内存区域。

通过 docker ps 查看 RocketMQ 容器的运行状态和日志,进一步确认该容器长时间运行,没有进行适当的内存释放和共享内存的调整,导致资源耗尽。

2. 问题原因

RocketMQ 在消息处理过程中可能会利用共享内存(/dev/shm)进行进程间通信和消息缓存。由于该容器已经运行了 15 个月,随着消息的不断生产和消费,消息缓存以及日志处理等操作可能导致共享内存被逐渐耗尽。RocketMQ 默认使用的 64MB 共享内存对于长时间运行的高并发生产环境来说显然不足,尤其是在消息积压时,共享内存的需求更大。

3. 解决方案

方案一:重新运行容器,增大共享内存

为了避免共享内存耗尽,可以重新启动容器并为其分配更大的共享内存。例如,增加到 512MB 或更高:

docker stop 409420b3e0e0docker rm 409420b3e0e0docker run --shm-size=512m -d <other-arguments> foxiswho/rocketmq:broker通过 --shm-size 选项调整共享内存大小,这样可以为容器提供更多的空间,确保长时间运行时不会再出现共享内存耗尽的问题。

方案二:修改配置,重新运行容器

步骤概述:

- 找到需要修改的容器 ID。

- 获取该容器的详细信息。

- 进入容器配置文件目录。

- 停止 Docker 服务。

- 修改

hostconfig.json文件中的共享内存配置。 - 验证修改结果。

第一部:找到要修改的容器 ID

使用以下命令列出所有容器:

docker ps -a在输出中找到对应的容器 ID,例如:

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES2f2162403489 foxiswho/rocketmq \"mqbroker -c /etc/ro…\" 23 months ago Up 15 months 0.0.0.0:10909->10909/tcp prod-rocketmq-broker第二步:获取容器详细信息

使用以下命令获取容器的详细信息:

docker inspect 2f2162403489 | grep Id输出中会显示需要的被修改的目录 ID,例如:

\"Id\": \"2f2162403489c3cff8bfbe52b17ff0c9d64cc7ad2905e318fdb2d298b806ndslanld\",第三步:进入容器配置文件目录

以最高权限进入系统:

su输入密码后,进入对应的容器 ID 目录:

cd /var/lib/docker/containers/2f2162403489c3cff8bfbe52b17ff0c9d64cc7ad2905e318fdb2d298b8然后列出该目录下的文件,找到 hostconfig.json 文件:

ls第四步:停止 Docker 服务

在修改配置文件之前,需要停止 Docker 服务:

systemctl stop docker或者使用:

service docker stop第五步:修改 hostconfig.json

使用文本编辑器打开 hostconfig.json 文件:

vi hostconfig.json找到以下行,其中 67108864 表示 64MB:

\"ShmSize\": 67108864,直接修改为所需的内存大小(注意:这里的内存大小是以字节为单位),例如将其改为 512MB:

\"ShmSize\": 536870912,保存并退出编辑器。

第六步:验证修改

重启 Docker 服务:

systemctl start docker然后,进入 Docker 容器并使用 df 命令检查共享内存的使用情况:

docker exec -it 2f2162403489 df -h /dev/shm确保新的共享内存配置已经生效。

注意事项

- 修改容器配置文件时要非常小心,错误的配置可能导致容器无法启动。

- 在生产环境中进行此类操作时,请务必做好备份,以防万一。

- 以上方法适用于 Linux 系统,确保你有相应的权限执行这些操作。

方案三:定期监控和优化

为了防止类似问题再次发生,可以:

- 定期监控容器的

/dev/shm使用情况:通过脚本定期检查共享内存使用情况,如果发现使用量接近上限,提前预警并采取措施。 - 优化 RocketMQ 配置:检查 RocketMQ 的内存和缓存管理配置,优化消息的缓存机制,避免过多消息积压在内存中。

- 日志管理:定期清理或归档日志文件,避免日志堆积占用过多内存。

4. 实战经验总结

本次问题的核心在于长时间运行的容器中,RocketMQ 服务的共享内存没有得到合理的分配和监控。在高并发的生产环境下,默认的 64MB 共享内存配置很容易耗尽,导致服务性能下降甚至宕机。

通过重新分配更大的共享内存并加强监控,我们可以确保 RocketMQ 在长时间运行时仍然保持高效稳定。