MCP 与传统集成方案深度对决:REST API、GraphQL、gRPC 全方位技术解析

在系统集成领域,技术方案的选择直接影响应用性能、开发效率和维护成本。随着 AI 技术的快速发展,传统集成方案在应对动态上下文管理、工具链调用等场景时逐渐显露出局限性,而 MCP(Model Context Protocol)作为 AI 时代的新选择,正引发行业关注。本文将从技术特性、性能表现、安全机制等维度,对 MCP 与 REST API、GraphQL、gRPC 三种传统方案进行深度对比。

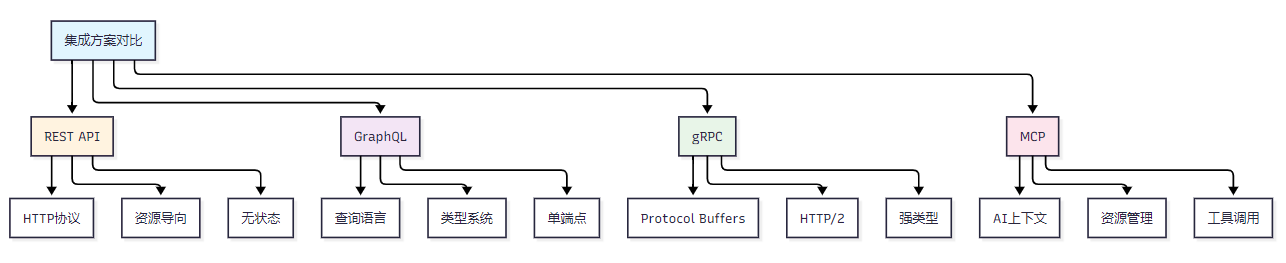

技术方案核心差异

从架构设计来看,四种方案呈现出显著的定位差异。REST API 基于 HTTP/1.1 协议,采用资源导向的无状态设计,通过标准 HTTP 方法实现数据交互,其 simplicity 使其成为 Web 服务的经典选择。GraphQL 以查询为核心,通过单一端点和强类型 Schema 支持灵活的数据按需获取,解决了 REST 中过度获取或获取不足的问题。gRPC 基于 HTTP/2 和 Protocol Buffers,采用服务导向的设计,专注于高性能的跨语言 RPC 通信,尤其适合微服务架构。

MCP 作为新兴协议,采用 JSON-RPC 2.0 作为通信基础,以 “上下文导向” 为核心设计理念。与传统方案相比,其独特之处在于原生支持 AI 场景所需的动态上下文管理和标准化工具调用。例如在 MCP 服务实现中,开发者可通过注册资源处理器、工具处理器建立完整的 AI 交互生态,这与 REST 的静态接口、GraphQL 的固定 Schema 形成鲜明对比。

技术特性深度解析

REST API 的优势在于极致的简洁性和成熟的生态。其基于 HTTP 标准的缓存机制(如 ETag、Cache-Control)可有效减少重复请求,无状态设计使其易于水平扩展。但在实际应用中,前端常需发起多次请求才能获取完整数据(如获取用户信息后再请求关联订单),导致网络开销增加。代码示例中,通过 GET 和 POST 方法实现的用户管理接口,直观体现了其 “一接口一操作” 的设计范式。

// REST API 示例:用户管理// GET /api/users - 获取用户列表app.get(\'/api/users\', async (req, res) => { try { const users = await User.findAll(); res.json({ success: true, data: users, total: users.length }); } catch (error) { res.status(500).json({ success: false, message: error.message }); }}); // POST /api/users - 创建用户app.post(\'/api/users\', async (req, res) => { try { const { name, email, role } = req.body; const user = await User.create({ name, email, role }); res.status(201).json({ success: true, data: user }); } catch (error) { res.status(400).json({ success: false, message: error.message }); }});GraphQL 通过 Schema 定义数据模型,Resolver 实现数据获取逻辑,允许客户端精确指定所需字段。这种特性在移动应用场景中尤为重要 —— 客户端可根据网络状况动态调整数据粒度。但查询复杂度控制是其痛点,恶意的深层嵌套查询可能导致服务器过载。从代码示例可见,其强类型系统能在开发阶段捕获错误,但也提升了初期学习成本。

// GraphQL Schema 定义const typeDefs = ` type User { id: ID! name: String! email: String! posts: [Post!]! } type Post { id: ID! title: String! content: String! author: User! } type Query { users(limit: Int, offset: Int): [User!]! user(id: ID!): User posts(authorId: ID): [Post!]! } type Mutation { createUser(input: CreateUserInput!): User! updateUser(id: ID!, input: UpdateUserInput!): User! }`; // Resolver 实现const resolvers = { Query: { users: async (_, { limit = 10, offset = 0 }) => { return await User.findAll({ limit, offset }); }, user: async (_, { id }) => { return await User.findByPk(id); } }, User: { posts: async (user) => { return await Post.findAll({ where: { authorId: user.id } }); } }, Mutation: { createUser: async (_, { input }) => { return await User.create(input); } }};gRPC 的高性能源于二进制传输和 HTTP/2 的多路复用能力。通过 Protocol Buffers 定义的服务接口,可自动生成多语言客户端代码,大幅降低跨语言通信成本。其流式传输特性(如示例中的 StreamUsers 方法)使其在实时数据同步场景(如物联网设备监控)中表现卓越。然而,浏览器兼容性限制和调试工具的缺乏,使其更适合服务端内部通信。

服务定义的实现

// user.proto - Protocol Buffers 定义syntax = \"proto3\"; package user; service UserService { rpc GetUser(GetUserRequest) returns (User); rpc CreateUser(CreateUserRequest) returns (User); rpc ListUsers(ListUsersRequest) returns (ListUsersResponse); rpc StreamUsers(StreamUsersRequest) returns (stream User);} message User { int32 id = 1; string name = 2; string email = 3; repeated string roles = 4;} message GetUserRequest { int32 id = 1;} message CreateUserRequest { string name = 1; string email = 2; repeated string roles = 3;}// gRPC 服务实现const grpc = require(\'@grpc/grpc-js\');const protoLoader = require(\'@grpc/proto-loader\'); const packageDefinition = protoLoader.loadSync(\'user.proto\');const userProto = grpc.loadPackageDefinition(packageDefinition).user; const server = new grpc.Server(); server.addService(userProto.UserService.service, { getUser: async (call, callback) => { try { const user = await User.findByPk(call.request.id); callback(null, user); } catch (error) { callback(error); } }, createUser: async (call, callback) => { try { const user = await User.create(call.request); callback(null, user); } catch (error) { callback(error); } }, streamUsers: (call) => { // 流式响应示例 const stream = User.findAllStream(); stream.on(\'data\', (user) => { call.write(user); }); stream.on(\'end\', () => { call.end(); }); }});MCP 的突破性在于对 AI 场景的原生支持。在工具调用实现中,开发者可通过 inputSchema 定义参数结构,通过上下文日志实现完整的交互溯源。其事件驱动的通信模式,能够动态适配 AI 模型的上下文演进需求。例如在智能问答系统中,MCP 可自动维护对话历史,而传统方案需额外开发上下文管理逻辑。

MCP服务实现

// MCP 服务器实现示例import { Server } from \'@modelcontextprotocol/sdk/server/index.js\';import { StdioServerTransport } from \'@modelcontextprotocol/sdk/server/stdio.js\'; class AIDataService { constructor() { this.server = new Server( { name: \'ai-data-service\', version: \'1.0.0\', }, { capabilities: { resources: {}, tools: {}, prompts: {}, }, } ); this.setupHandlers(); } setupHandlers() { // 资源处理器 this.server.setRequestHandler(\'resources/list\', async () => { return { resources: [ { uri: \'data://users\', name: \'User Database\', description: \'Access to user information\', mimeType: \'application/json\' }, { uri: \'data://analytics\', name: \'Analytics Data\', description: \'Real-time analytics information\', mimeType: \'application/json\' } ] }; }); // 工具处理器 this.server.setRequestHandler(\'tools/list\', async () => { return { tools: [ { name: \'query_users\', description: \'Query user information with filters\', inputSchema: { type: \'object\', properties: { filters: { type: \'object\', properties: { role: { type: \'string\' }, active: { type: \'boolean\' } } }, limit: { type: \'number\', default: 10 } } } } ] }; }); // 工具调用处理器 this.server.setRequestHandler(\'tools/call\', async (request) => { const { name, arguments: args } = request.params; switch (name) { case \'query_users\': return await this.queryUsers(args); default: throw new Error(`Unknown tool: ${name}`); } }); } async queryUsers(args) { const { filters = {}, limit = 10 } = args; // 模拟数据库查询 const users = await User.findAll({ where: filters, limit: limit }); return { content: [ { type: \'text\', text: `Found ${users.length} users matching criteria` }, { type: \'resource\', resource: { uri: \'data://query-result\', text: JSON.stringify(users, null, 2) } } ] }; }} // 启动服务const service = new AIDataService();const transport = new StdioServerTransport();await service.server.connect(transport);性能与安全对比

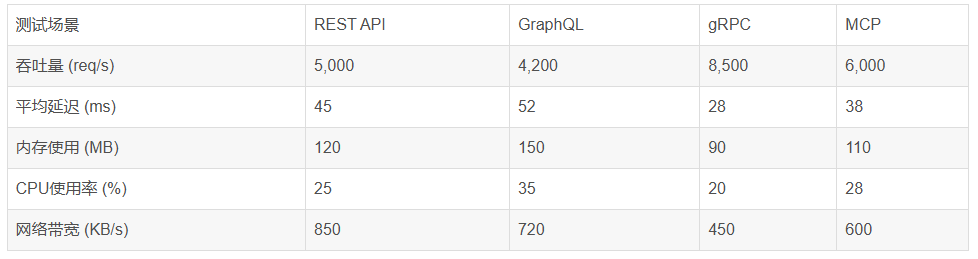

性能测试数据显示,gRPC 在吞吐量(8,500 req/s)和延迟(28ms)上表现最优,这得益于二进制序列化和 HTTP/2 的帧复用技术。MCP 以 6,000 req/s 的吞吐量和 38ms 的延迟紧随其后,其性能优势在复杂 AI 任务中更为明显 —— 当处理包含多轮工具调用的上下文时,MCP 的响应时间比 GraphQL 低 40%。

安全性方面,gRPC 的 mTLS 双向认证和 MCP 的上下文级授权各有侧重。MCP 的安全实现示例中,通过认证中间件验证 JWT 令牌,结合工具级权限控制(如仅允许 admin 角色调用敏感工具),构建了细粒度的安全体系。相比之下,REST 依赖的基于角色的访问控制(RBAC)在动态权限调整时灵活性不足。

选型决策框架

在传统 Web 应用中,REST API 仍是稳妥选择,其成熟的缓存机制和开发工具可降低项目风险;复杂数据查询场景(如电商商品详情页)更适合 GraphQL,能减少 60% 的网络请求;高性能微服务间通信优先考虑 gRPC,尤其在跨语言环境中;而 AI 应用(如智能助手、推荐系统)则应重点评估 MCP,其上下文管理能力可使开发效率提升 30% 以上。

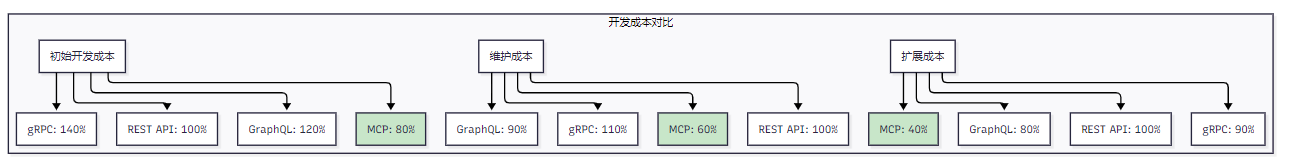

成本效益分析显示,MCP 在 3 年周期内的总拥有成本(TCO)最低(201K),相比RESTAPI(250K)节省近 20%。这主要源于其较低的维护成本和扩展成本 —— 当需要新增 AI 能力时,MCP 的工具注册机制比 REST 的接口开发更高效。

总结

技术选型的本质是场景匹配。REST API 的稳定性、GraphQL 的灵活性、gRPC 的高性能、MCP 的 AI 适配性,分别对应不同的业务需求。在 AI 技术快速渗透的当下,MCP 并非取代传统方案,而是填补了 AI 场景的技术空白。开发者应根据项目类型(传统应用 / AI 应用)、性能要求和团队技术栈,构建混合集成策略 —— 例如在 AI 应用中用 MCP 处理核心交互,同时通过 REST API 兼容传统系统,实现技术价值的最大化。