【AI大模型前沿】GLM-4.5:智谱打造的开源SOTA模型,推理、代码与智能体能力融合先锋

系列篇章💥

目录

- 系列篇章💥

- 前言

- 一、项目概述

- 二、技术特点

-

- (一)多能力融合

- (二)混合专家(MoE)架构

- (三)混合推理模式

- (四)高效的训练流程

- (五)参数效率优化

- 三、性能优势

-

- (一)综合性能卓越

- (二)更高的参数效率

- (三)低成本、高速度

- 四、应用场景

-

- (一)全栈开发任务

- (二)代码生成与编程辅助

- (三)内容生成

- (四)学术研究

- 五、快速使用

-

- (一)体验平台

- (二)API 调用

- (三)本地部署

- 六、结语

- 七、项目地址

前言

在人工智能领域,大语言模型(LLM)的发展日新月异,不断推动着技术的边界。智谱推出的 GLM-4.5 模型,作为开源领域的新星,凭借其在推理、代码生成和智能体能力上的卓越表现,为技术探索者和开发者带来了全新的可能性。本文将深入探讨 GLM-4.5 的技术特点、性能优势、应用场景以及快速使用方法,旨在为读者提供一个全面且实用的参考。

一、项目概述

GLM-4.5 是智谱推出的新一代旗舰模型,专为智能体应用打造,是首款原生融合推理、代码和智能体能力的开源 SOTA(State-of-the-Art)模型。它采用混合专家(MoE)架构,有两个版本:GLM-4.5(3550 亿参数,320 亿激活)和 GLM-4.5-Air(1060 亿参数,120 亿激活)。该模型在多个评测基准中表现卓越,综合性能达到开源模型的顶尖水平,尤其在代码智能体场景中表现优异。它支持混合推理模式,提供“思考模式”和“非思考模式”,兼顾复杂任务和即时响应需求,为智能体应用提供了强大的支持。

二、技术特点

(一)多能力融合

GLM-4.5 首次在一个模型中实现了推理、代码生成和智能体能力的原生融合。这种融合使得模型能够满足复杂智能体应用的需求,例如在智能体任务中处理网页浏览、工具调用等多模态交互场景。这种多能力的集成不仅提高了模型的通用性,还为开发者提供了更灵活的应用开发选项。

(二)混合专家(MoE)架构

GLM-4.5 采用了混合专家(Mixture of Experts, MoE)架构,这是一种高效的模型扩展方法。MoE 架构通过将模型参数划分为多个专家模块(Experts),在每个前向传播过程中动态选择部分专家进行激活,实现参数的稀疏激活。这种架构在保持模型强大表达能力的同时,显著降低了计算成本和内存占用。具体来说,GLM-4.5 的总参数量为 3550 亿,激活参数为 320 亿;而 GLM-4.5-Air 的总参数量为 1060 亿,激活参数为 120 亿。

(三)混合推理模式

GLM-4.5 提供两种推理模式:“思考模式”和“非思考模式”。思考模式适用于复杂推理和工具使用场景,模型会进行更深入的思考和推理,以生成更准确的结果;非思考模式则适用于即时响应场景,模型会快速生成结果,满足低延迟的需求。这种灵活的推理模式设计使得 GLM-4.5 能够在不同的应用场景中发挥最佳性能。

(四)高效的训练流程

GLM-4.5 的训练流程包括三个阶段:通用数据预训练、针对性训练和强化学习优化。在通用数据预训练阶段,模型在 15 万亿 token 的通用数据上进行预训练,以学习语言和知识的基础表示;在针对性训练阶段,模型在代码、推理、智能体等地方的 8 万亿 token 数据上进行针对性训练,以增强模型在特定任务上的表现;最后通过强化学习进一步优化模型的推理、代码生成和智能体能力,以提升模型在实际应用中的表现。

(五)参数效率优化

尽管 GLM-4.5 的参数量仅为 DeepSeek-R1 的 1/2 和 Kimi-K2 的 1/3,但在多项标准基准测试中表现更为出色。例如,在 100B 总参数 – 10B 激活参数规模的模型系列中,

GLM-4.5 在 Artificial Analysis 基准测试中的推理性能媲美甚至超越了其他国际顶级模型。这种参数效率的提升使得 GLM-4.5 在性能和成本效益之间取得了良好的平衡。

三、性能优势

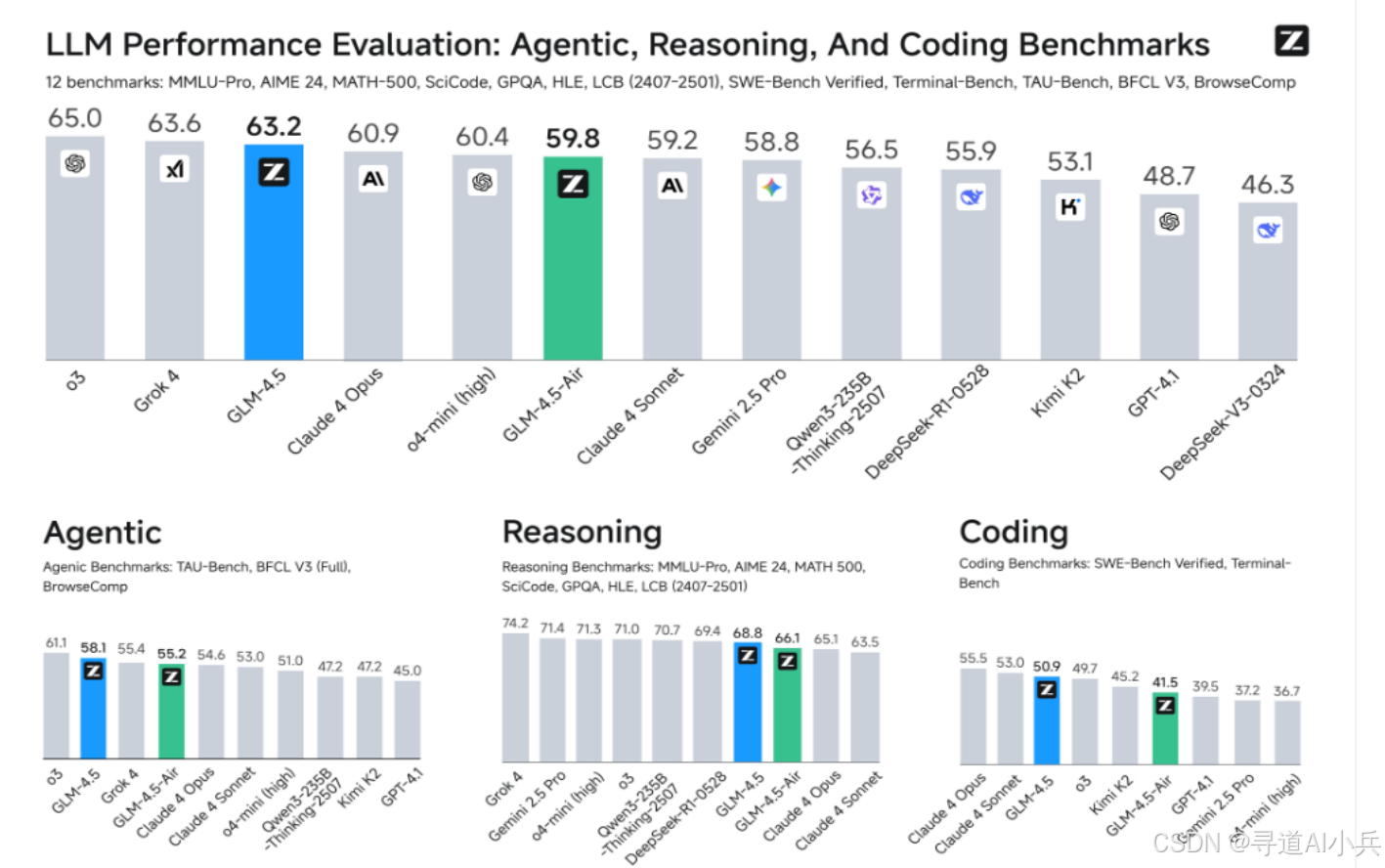

(一)综合性能卓越

在 12 个行业标准评测基准中,GLM-4.5 取得了全球模型第三、国产模型第一、开源模型第一的成绩。这些评测基准涵盖了推理、代码生成、智能体等多个领域,充分证明了 GLM-4.5 的综合性能达到了开源模型的顶尖水平。

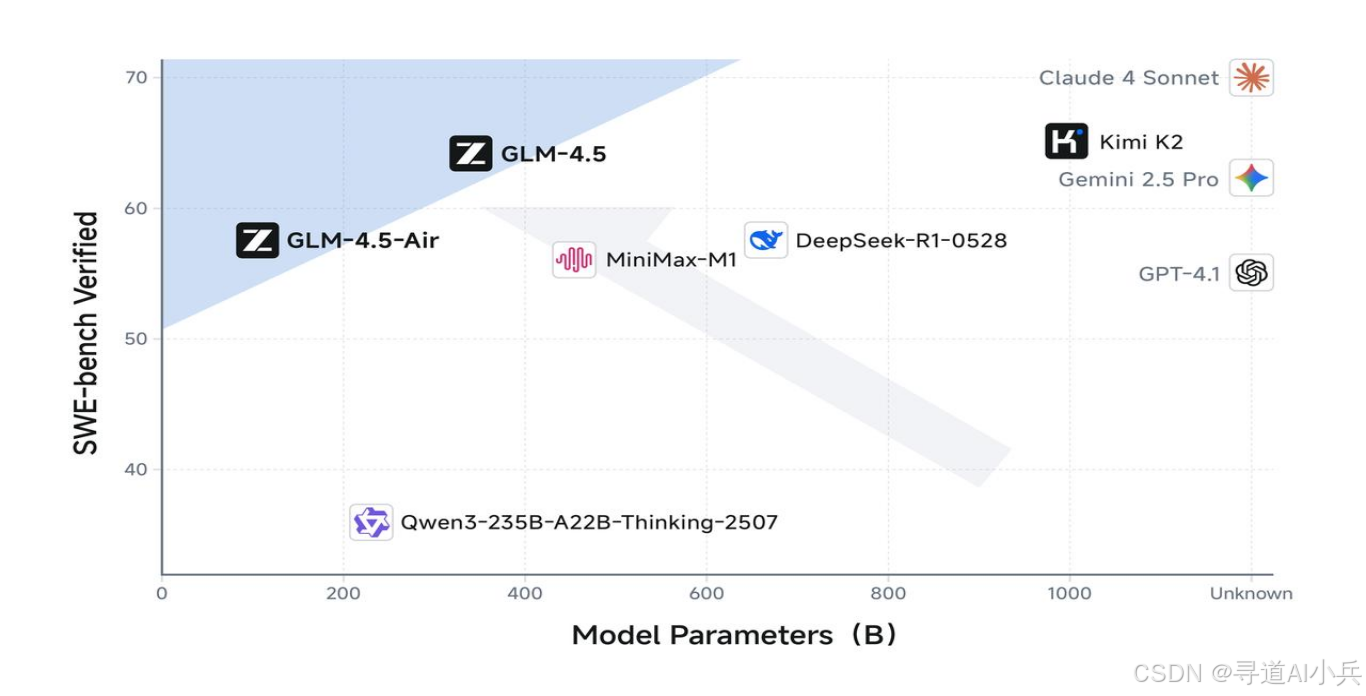

(二)更高的参数效率

GLM-4.5 在参数效率上实现了显著提升。在衡量模型代码能力的 SWE-bench Verified 榜单上,GLM-4.5 系列位于性能/参数比帕累托前沿,这表明在相同规模下,GLM-4.5 系列实现了最佳性能。这种高效的参数利用方式使得 GLM-4.5 在保持强大性能的同时,降低了模型的计算资源需求。

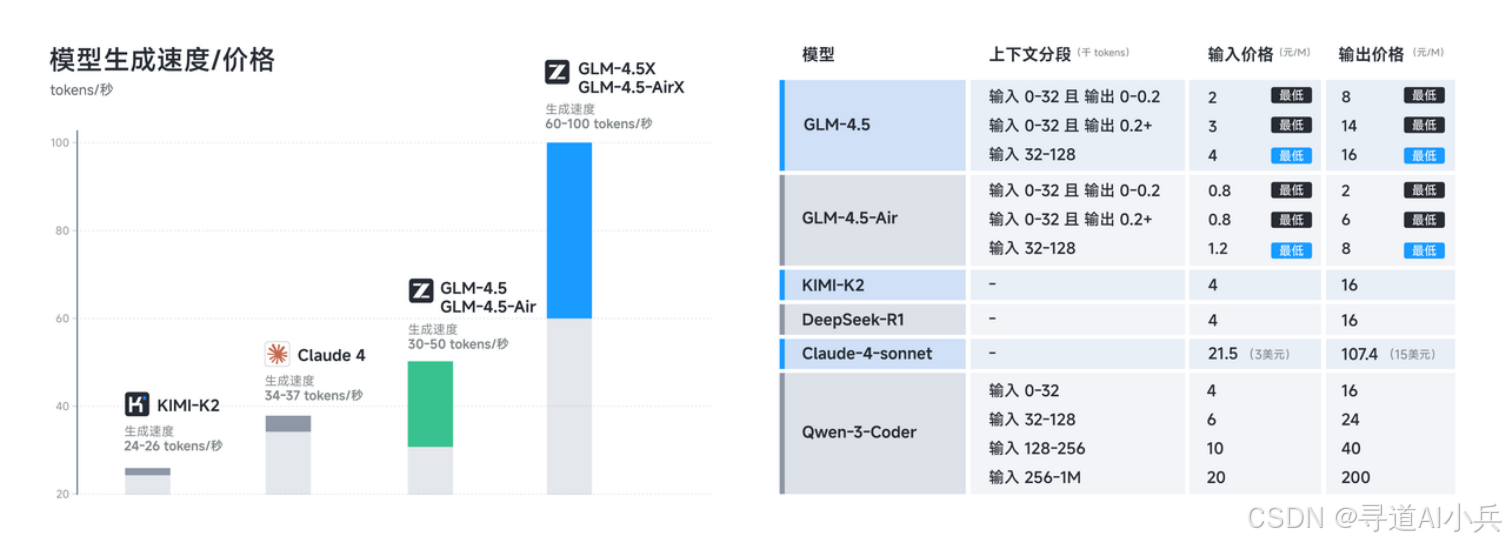

(三)低成本、高速度

GLM-4.5 系列在成本和效率上实现了突破。API 调用价格低至输入 0.8 元/百万 tokens,输出 2 元/百万 tokens,生成速度最高可达 100 tokens/秒。这种低成本、高速度的特性使得 GLM-4.5 非常适合实际部署,能够满足低延迟、高并发的需求,兼顾成本效益与交互体验。

四、应用场景

(一)全栈开发任务

GLM-4.5 能胜任复杂的全栈开发任务,支持编写较为复杂的应用、游戏、交互网页等。它可以帮助开发者快速生成代码框架、修复代码错误、优化代码结构等,极大地提高了开发效率。

(二)代码生成与编程辅助

GLM-4.5 在代码生成方面表现出色,能生成高质量的代码片段,支持多种编程语言。它可以作为编程辅助工具,提供代码补全、代码生成建议、代码注释等功能,帮助开发者更高效地完成编程任务。

(三)内容生成

GLM-4.5 可以生成各种类型的内容,如文章、新闻报道、创意文案等,适用于内容创作、文案撰写等场景。它能够根据用户的需求生成高质量的文本内容,为内容创作者提供了强大的支持。

(四)学术研究

GLM-4.5 可以用于学术研究,帮助研究人员探索自然语言处理、人工智能等地方的前沿问题。其强大的推理能力和多模态处理能力为学术研究提供了丰富的实验素材和研究方向。

五、快速使用

(一)体验平台

用户可以通过以下体验平台直接使用 GLM-4.5 的功能:

- 智谱清言 (chatglm.cn):可以直接访问智谱清言平台,免费体验 GLM-4.5 的满血版功能。用户可以进行对话生成、代码生成、推理任务等多种操作,感受模型的强大能力。

- Z.ai:用户也可以通过 Z.ai 平台体验 GLM-4.5 的功能。

(二)API 调用

智谱 AI 提供了 API 接口,用户可以通过 BigModel 平台进行 API 调用。API 接口支持多种功能,包括文本生成、代码生成、推理任务等。API 调用价格低至输入 0.8 元/百万 tokens,输出 2 元/百万 tokens,生成速度最高可达 100 tokens/秒。

(三)本地部署

用户还可以通过以下步骤在本地部署 GLM-4.5 模型:

- 安装依赖

根据 requirements.txt 安装所需的 Python 包:

pip install -r requirements.txt- 使用 transformers 进行推理

参考 trans_infer_cli.py 代码,使用 transformers 库进行模型推理。

- 使用 vLLM 进行推理

使用 vLLM 进行推理时,可以使用以下命令启动服务:

vllm serve zai-org/GLM-4.5-Air \\ --tensor-parallel-size 8 \\ --tool-call-parser glm45 \\ --reasoning-parser glm45 \\ --enable-auto-tool-choice \\ --served-model-name glm-4.5-air如果使用 8x H100 GPUs 运行 GLM-4.5 模型时内存不足,可以添加 --cpu-offload-gb 16 参数。

- 使用 SGLang 进行推理

使用 SGLang 进行推理时,可以使用以下命令启动服务:

- BF16 模式

python3 -m sglang.launch_server \\ --model-path zai-org/GLM-4.5-Air \\ --tp-size 8 \\ --tool-call-parser glm45 \\ --reasoning-parser glm45 \\ --speculative-algorithm EAGLE \\ --speculative-num-steps 3 \\ --speculative-eagle-topk 1 \\ --speculative-num-draft-tokens 4 \\ --mem-fraction-static 0.7 \\ --served-model-name glm-4.5-air \\ --host 0.0.0.0 \\ --port 8000- FP8 模式

python3 -m sglang.launch_server \\ --model-path zai-org/GLM-4.5-Air-FP8 \\ --tp-size 4 \\ --tool-call-parser glm45 \\ --reasoning-parser glm45 \\ --speculative-algorithm EAGLE \\ --speculative-num-steps 3 \\ --speculative-eagle-topk 1 \\ --speculative-num-draft-tokens 4 \\ --mem-fraction-static 0.7 \\ --disable-shared-experts-fusion \\ --served-model-name glm-4.5-air-fp8 \\ --host 0.0.0.0 \\ --port 8000六、结语

GLM-4.5 作为智谱推出的开源 SOTA 模型,凭借其多能力融合、高效的 MoE 架构、灵活的推理模式、卓越的性能以及广泛的应用场景,为人工智能领域带来了新的突破。无论是开发者、研究人员还是企业用户,都可以通过 GLM-4.5 的强大能力实现更高效、更智能的应用开发和研究探索。希望本文的介绍能够帮助读者更好地了解 GLM-4.5,并在实际工作中发挥其价值。

七、项目地址

- GitHub 仓库:https://github.com/zai-org/GLM-4.5

- HuggingFace 仓库:https://huggingface.co/collections/zai-org/glm-45-687c621d34bda8c9e4bf503b

- ModelScope 仓库:https://modelscope.cn/collections/GLM-45-b8693e2a08984f

- 在线体验:https://chat.z.ai/

🎯🔖更多专栏系列文章:AI大模型提示工程完全指南、AI大模型探索之路(零基础入门)、AI大模型预训练微调进阶、AI大模型开源精选实践、AI大模型RAG应用探索实践🔥🔥🔥 其他专栏可以查看博客主页📑

😎 作者介绍:资深程序老猿,从业10年+、互联网系统架构师,目前专注于AIGC的探索(CSDN博客之星|AIGC领域优质创作者)

📖专属社群:欢迎关注【小兵的AI视界】公众号或扫描下方👇二维码,回复‘入群’ 即刻上车,获取邀请链接。

💘领取三大专属福利:1️⃣免费赠送AI+编程📚500本,2️⃣AI技术教程副业资料1套,3️⃣DeepSeek资料教程1套🔥(限前500人)

如果文章内容对您有所触动,别忘了点赞、⭐关注,收藏!加入我们,一起携手同行AI的探索之旅,开启智能时代的大门!