「Mac畅玩AIGC与多模态03」部署篇02 - 在 Mac 上部署 Dify_mac部署dify

一、概述

本篇介绍如何在 macOS 环境下本地部署 Dify 平台,作为多模型协同与工作流集成的可视化应用服务。Dify 提供了模型调用、对话管理、知识库问答、插件服务等功能,可与 Ollama、OpenAI、DeepSeek 等推理后端集成,适用于本地智能体应用的快速搭建与扩展。

二、部署流程

1. 环境准备

- 启动 Docker Desktop(已在部署篇01中安装):

点击菜单栏中的 🐳 图标,确保 Docker Desktop 正常运行:

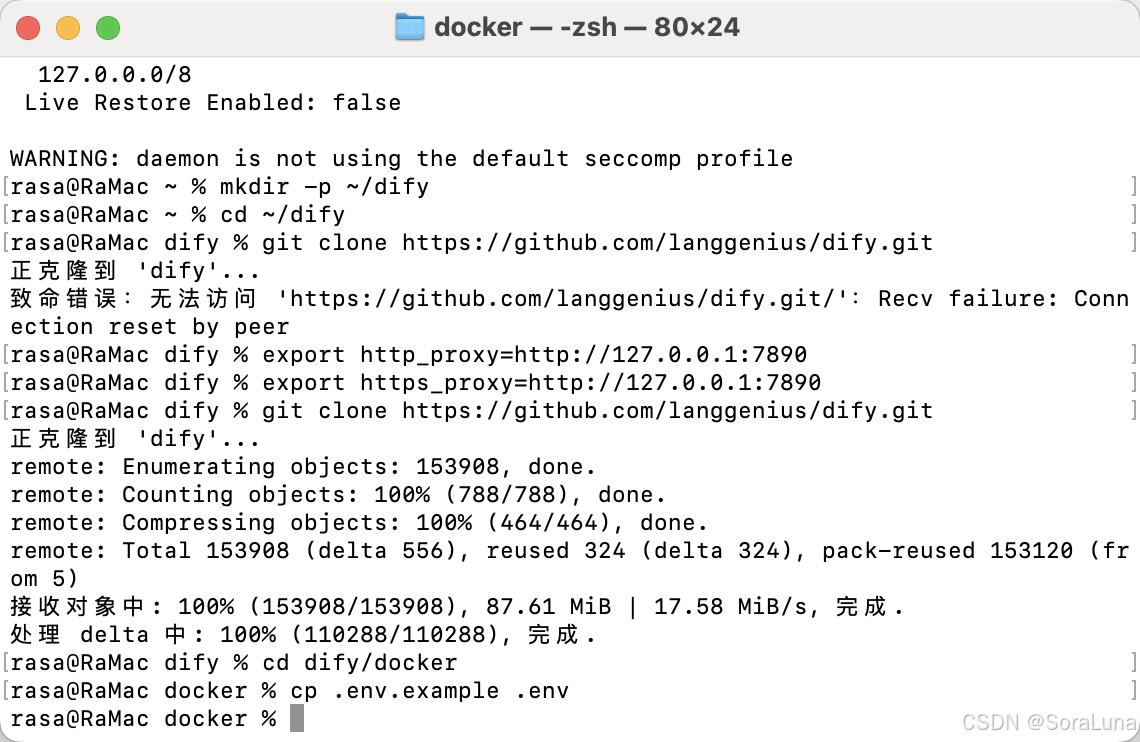

docker info- 准备本地运行目录:

mkdir -p ~/difycd ~/dify- 拉取官方 Docker Compose 项目:

git clone https://github.com/langgenius/dify.gitcd dify/docker💡 如出现如下错误,说明终端未配置代理环境:

git clone https://github.com/langgenius/dify.git正克隆到 \'dify\'...致命错误:无法访问 \'https://github.com/langgenius/dify.git/\':Failed to connect to github.com port 443 after 27 ms: Couldn\'t connect to server请临时配置代理后再次执行:

export http_proxy=http://127.0.0.1:7890export https_proxy=http://127.0.0.1:7890git clone https://github.com/langgenius/dify.gitcd dify/docker- 准备

.env配置文件(必须存在):

cp .env.example .env然后根据需要调整 .env 中的数据库、Redis 地址等配置项。

💡 .env 文件缺失或配置错误将导致容器启动失败。

2. 修改配置文件

修改 docker-compose.yaml 文件中 Dify 后端的模型服务地址:

找到配置:

OPENAI_API_BASE: ${OPENAI_API_BASE:-https://api.openai.com/v1}替换为本地 Ollama 服务地址:

OPENAI_API_BASE: http://localhost:11434/v1💡 若 .env 文件中存在 OPENAI_API_KEY,建议同步修改为任意非空字符串(如 dify)。

3. 启动 Dify 服务

执行以下命令启动 Dify:

docker compose up -d💡 首次启动将拉取镜像并构建容器,时间较长,请耐心等待。 💡 若提示端口占用或冲突,可提前释放对应端口,或在 docker-compose.yaml 中调整端口映射。

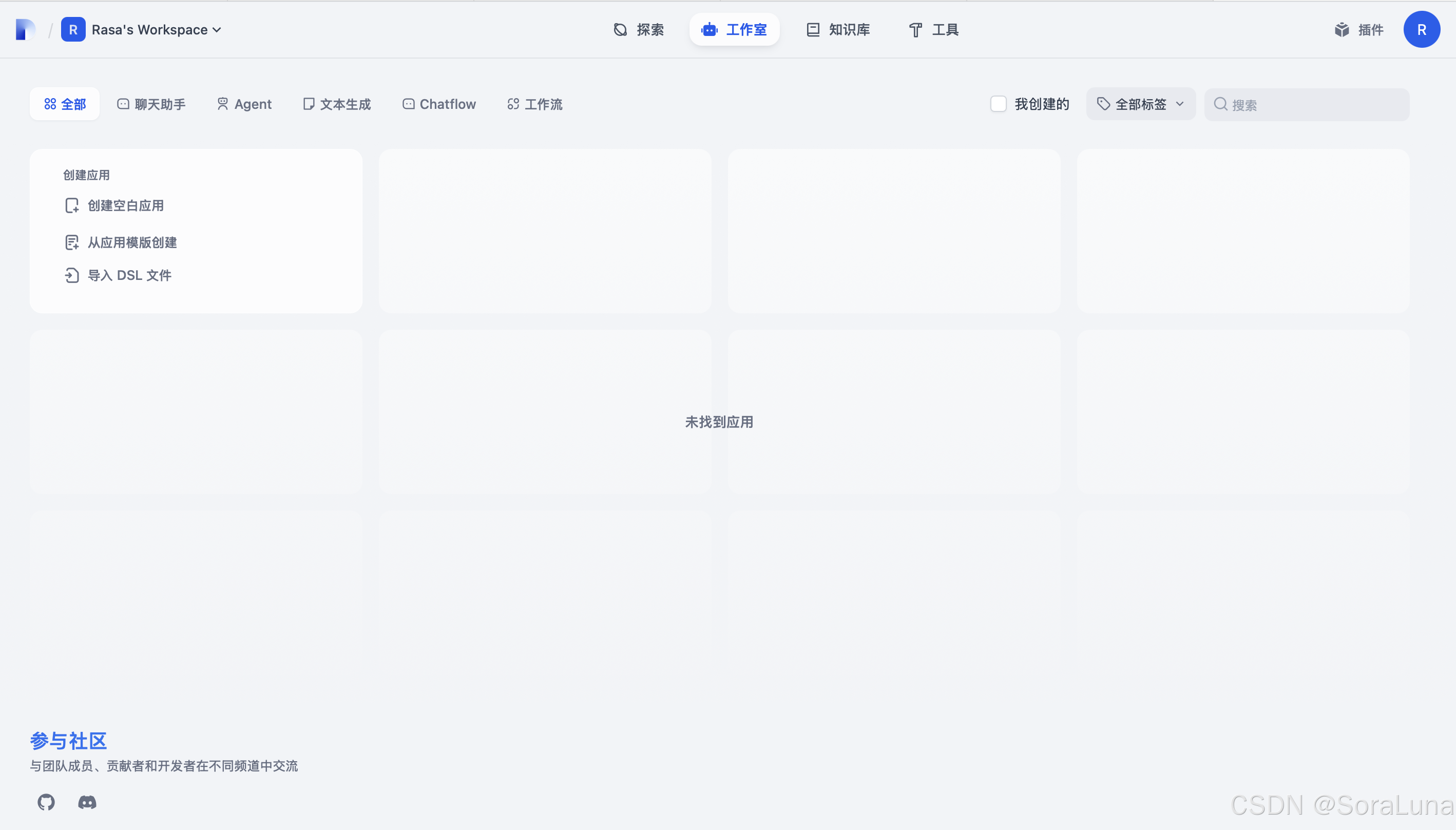

4. 访问 Dify 页面

- 默认端口访问:

http://localhost- 如调整端口(例如

8181:80),访问:

http://localhost:8181首次访问将进入注册页面,设置管理员账户后进入后台管理界面。

💡 若页面无法打开,可通过以下方式排查:

- 查看容器状态:

docker ps- 检查端口监听状态

- 尝试使用本机 IP 地址访问

5. 配置模型服务

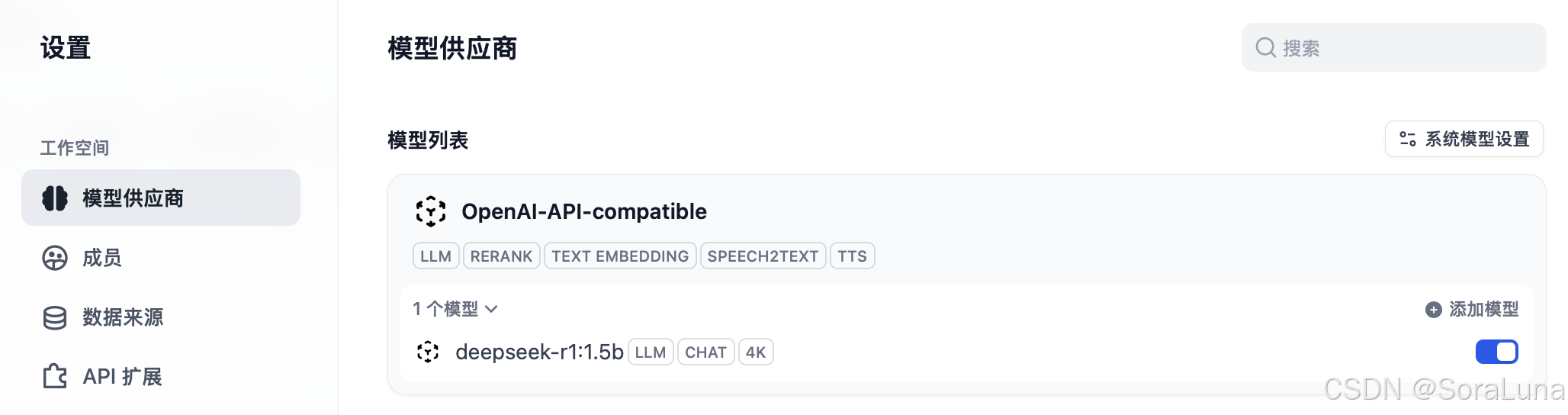

进入后台管理页面,导航至「模型供应商」,安装「OpenAI-API-compatible」插件。

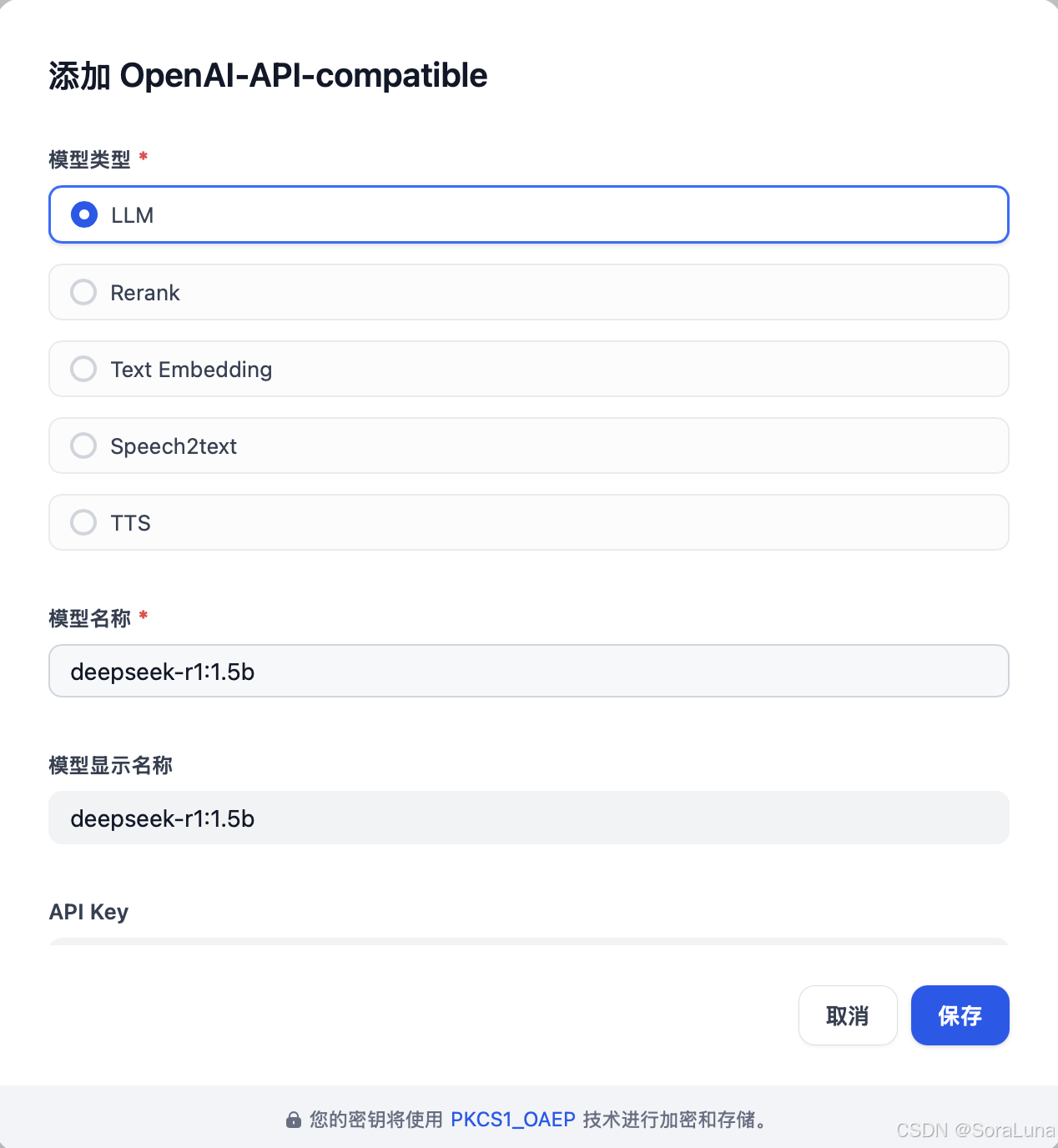

- 进入「OpenAI-API-compatible」插件,点击「添加模型」。

填写信息:

- 模型类型:选择「LLM」

- 模型名称:填写已拉取的模型名,如 deepseek-r1:1.5b、qwen2.5:0.5b

- API Key:填写任意非空字符串,如 dify

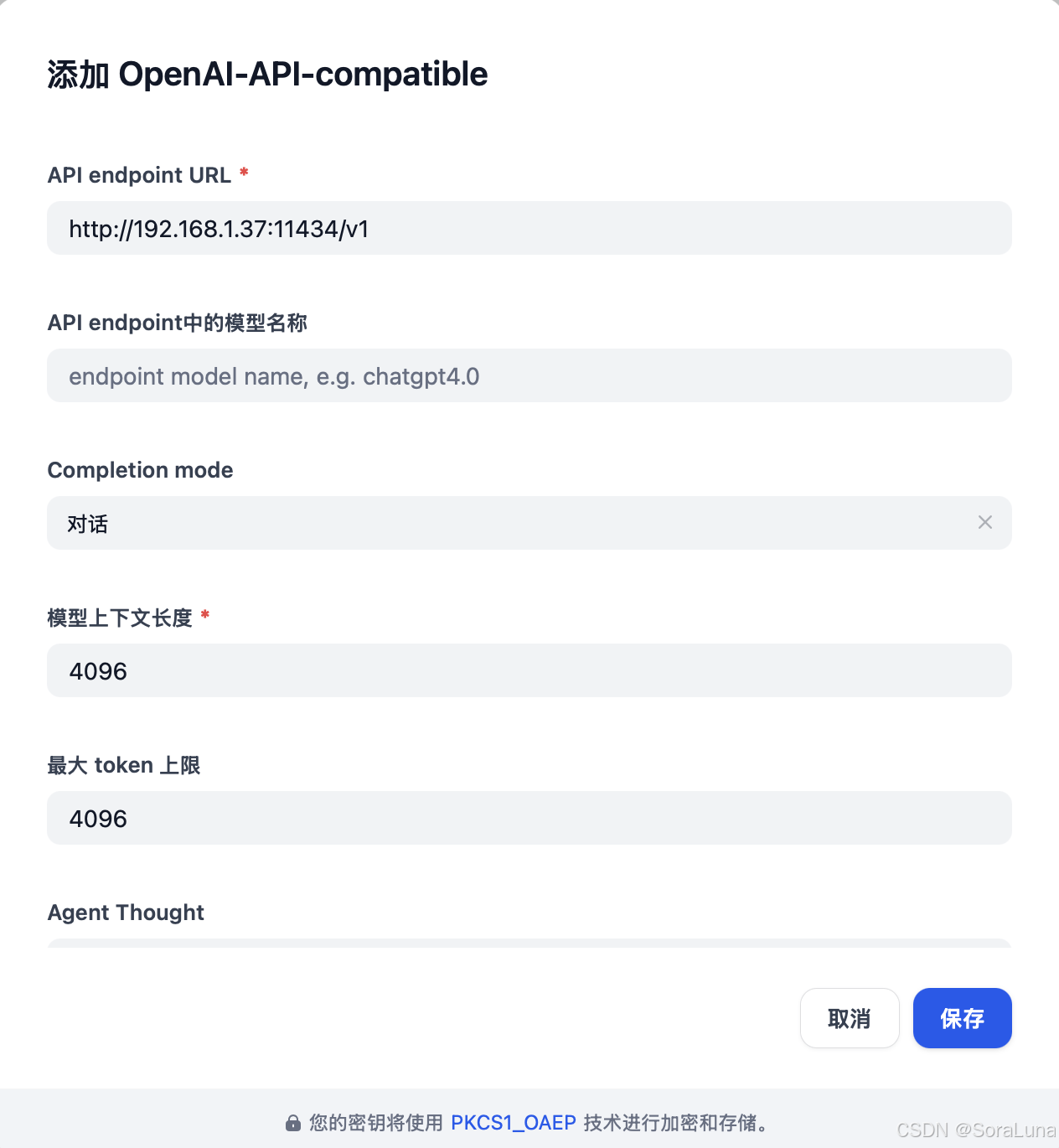

- 接口地址:填写本机 IP 地址加端口,例如:

http://192.168.1.37:11434/v1⚠️ 注意:不可使用 localhost,容器无法解析宿主机 localhost。

- 启用 Stream Function Calling:选择「支持」

填写示例:

点击保存,Dify 将自动验证接口。

💡 若出现如下错误提示:

An error occurred during credentials validation: HTTPConnectionPool(host=\'192.168.1.37\', port=11434): Max retries exceeded with url: /v1/chat/completions请按以下步骤排查:

- 清除代理环境变量:

unset http_proxyunset https_proxy- 确认本地 Ollama 服务已正常运行:

ollama run deepseek-r1:1.5b配置完成后,系统模型列表如下所示:

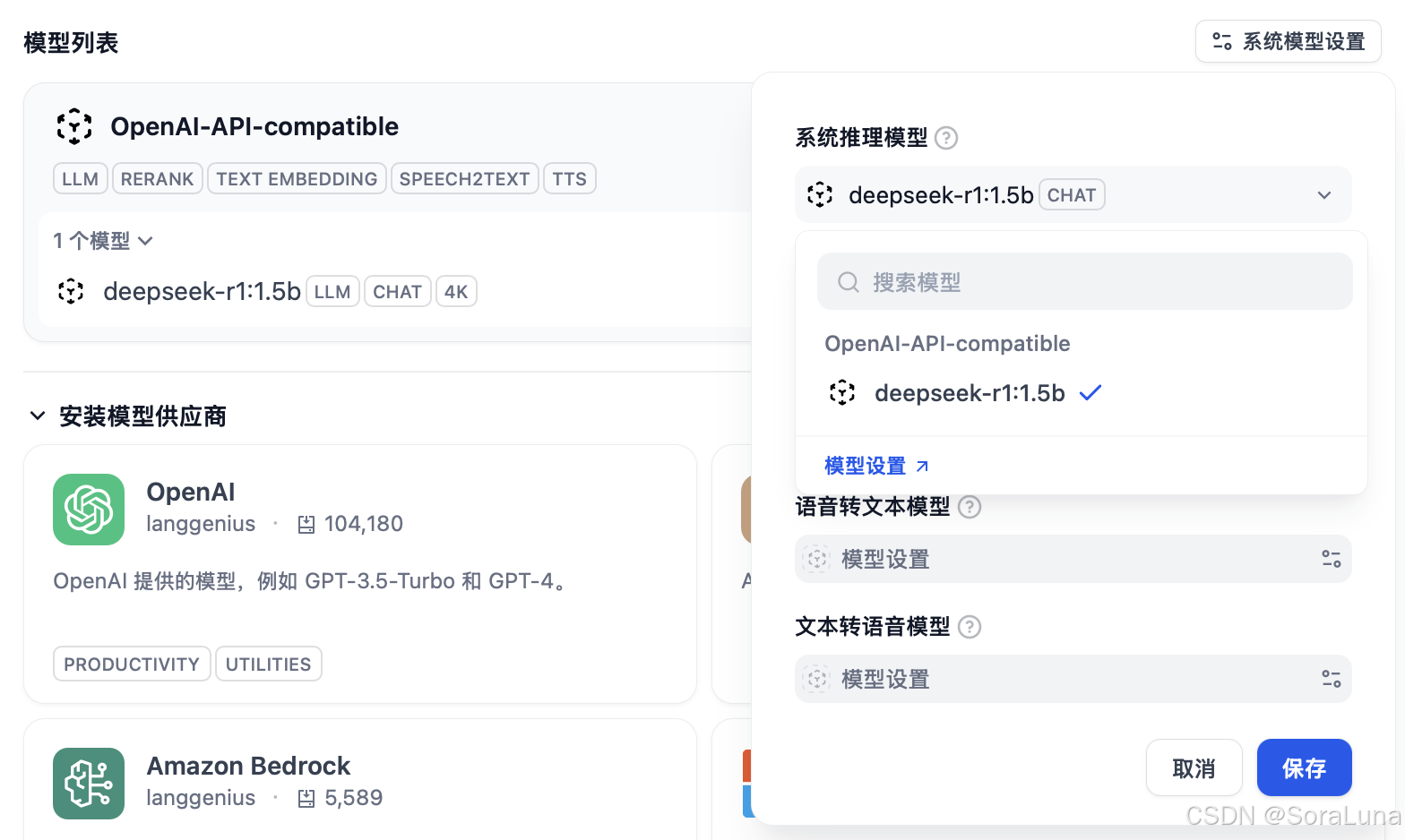

- 再点击「系统模型设置」,添加配置好的模型:

6. 资源释放

停止 Dify 服务并释放容器资源:

docker compose down如需停止本地模型服务(Ollama):

killall ollama三、总结

通过本篇部署流程,已完成在 macOS 环境下基于 Docker 启动 Dify 服务,并成功接入本地 Ollama 推理接口,构建具备多模型协作与智能体开发能力的 AIGC 平台。Dify 支持统一接入多个推理后端,适合用于知识库问答、智能工作流、插件系统与 Agent 应用开发。