使用trae进行本地ai对话机器人的构建

前言

在人工智能技术快速发展的今天,构建本地AI对话机器人已成为开发者和技术爱好者的热门选择。使用 trae可以高效地实现这一目标,确保数据隐私和响应速度。本文将详细介绍如何利用 Trae 搭建本地AI对话机器人,涵盖环境配置、模型加载、对话逻辑实现以及优化技巧,帮助读者从零开始构建一个功能完整的AI助手。

本地化AI对话机器人的优势在于完全离线运行,避免网络延迟和数据泄露风险,同时支持自定义训练模型以适应特定场景需求。无论是用于个人助理、客服系统,还是智能家居控制,Trae 都能提供灵活的解决方案。

获取api相关信息

打开蓝耘进行登录,如果你是新人的话需要进行注册操作,输入你相关的信息就能进行注册成功

在平台顶部导航栏可以看到Maas平台,点击进入模型广场

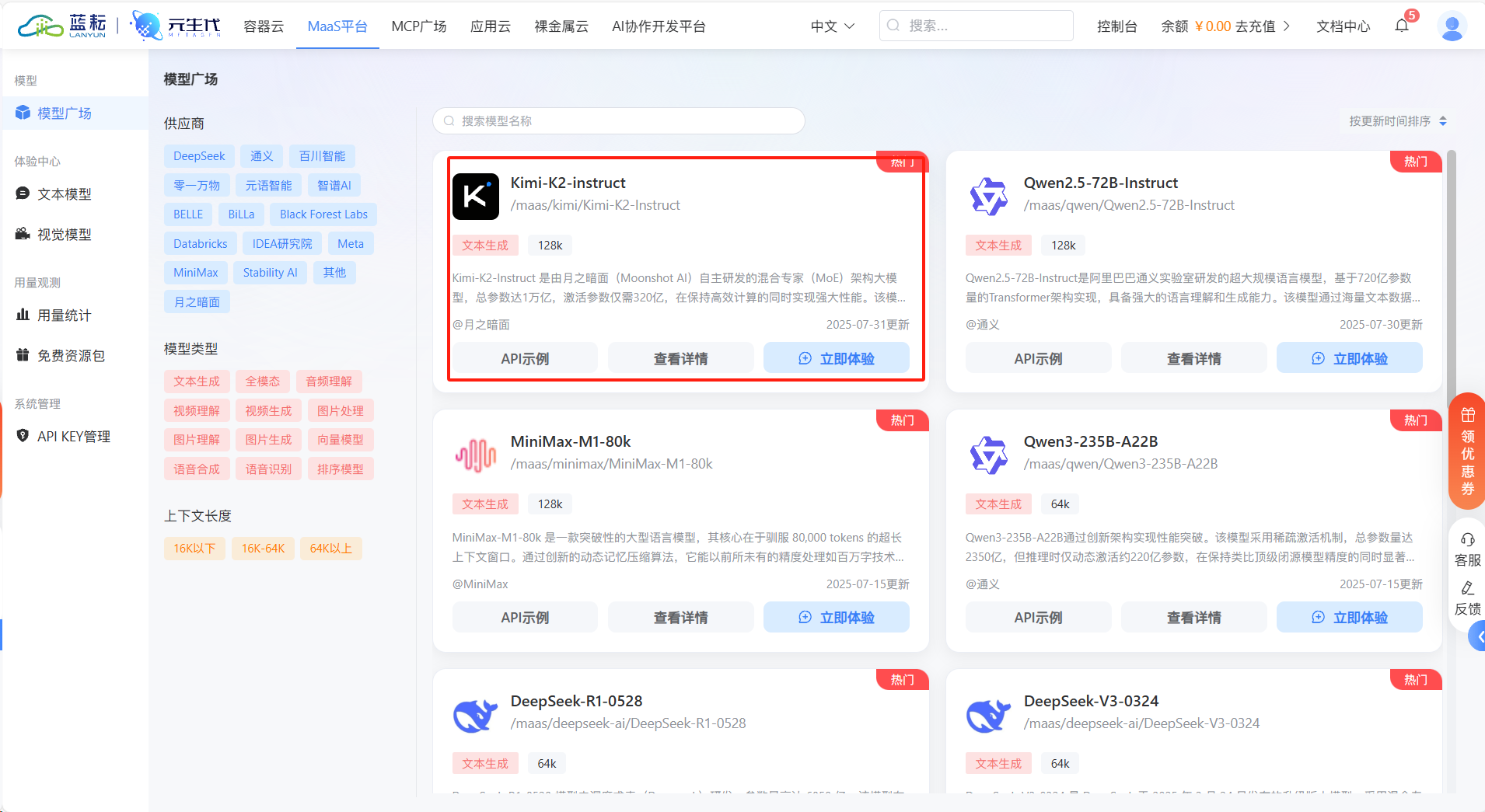

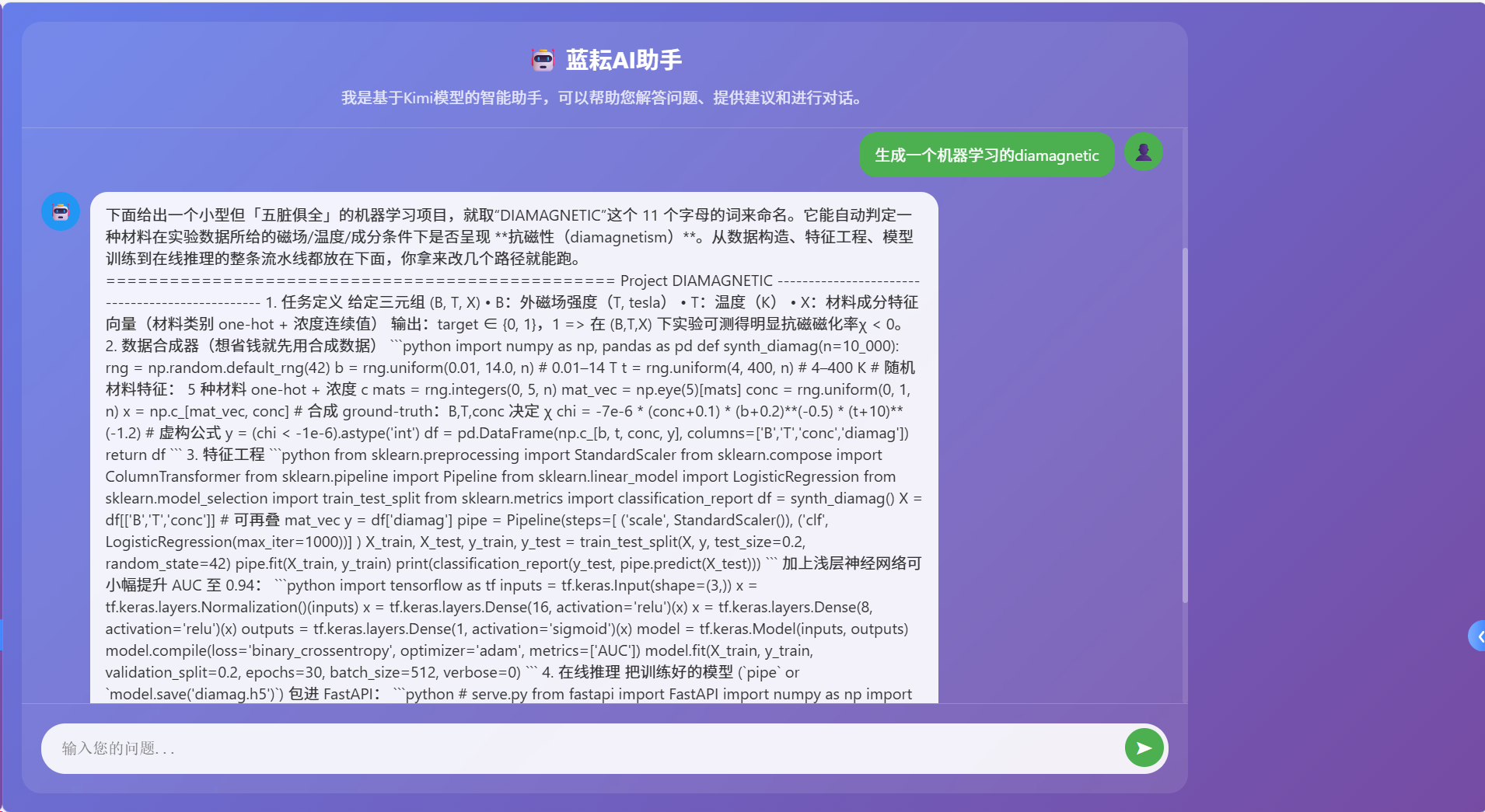

来到模型广场可以看到很多的ai模型,比如就有我们的kimi k2模型

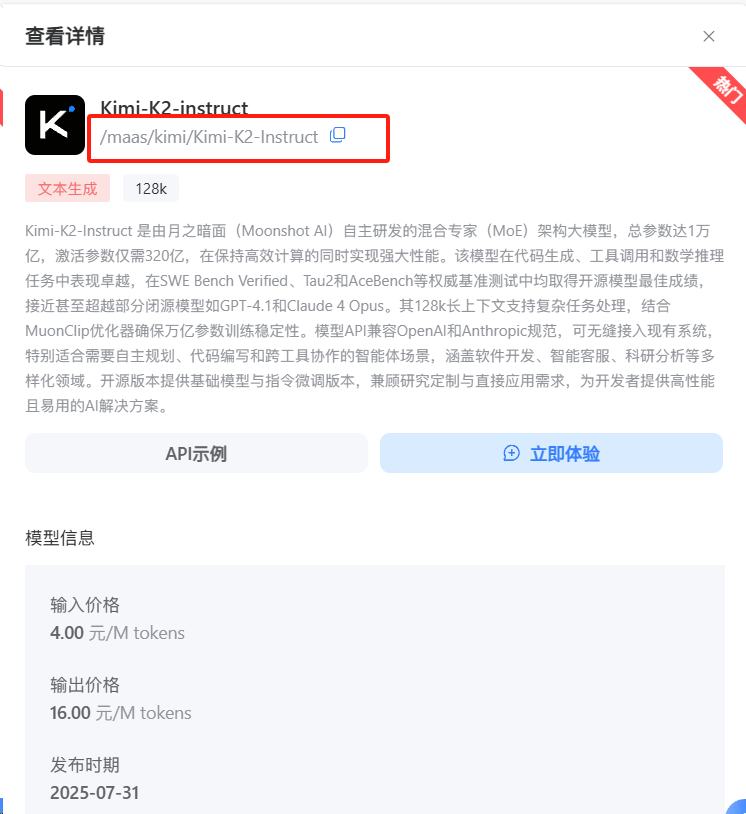

点击进去可以看到kimi k2模型的相关信息,我们将模型的id进行复制,等会儿我们是要用到的

/maas/kimi/Kimi-K2-Instruct

并且这里还具有在线体验的功能,生成回答速度快

https://archive.lanyun.net/#/maas/%E6%96%87%E6%9C%AC%E6%A8%A1%E5%9E%8BAPI这里还有详细的api调用方法,我们这里使用python进行调用,这里可以看到我们框出来的两个变量,等调用的时候我们是需要进行更改的,model我们填写/maas/kimi/Kimi-K2-Instruct

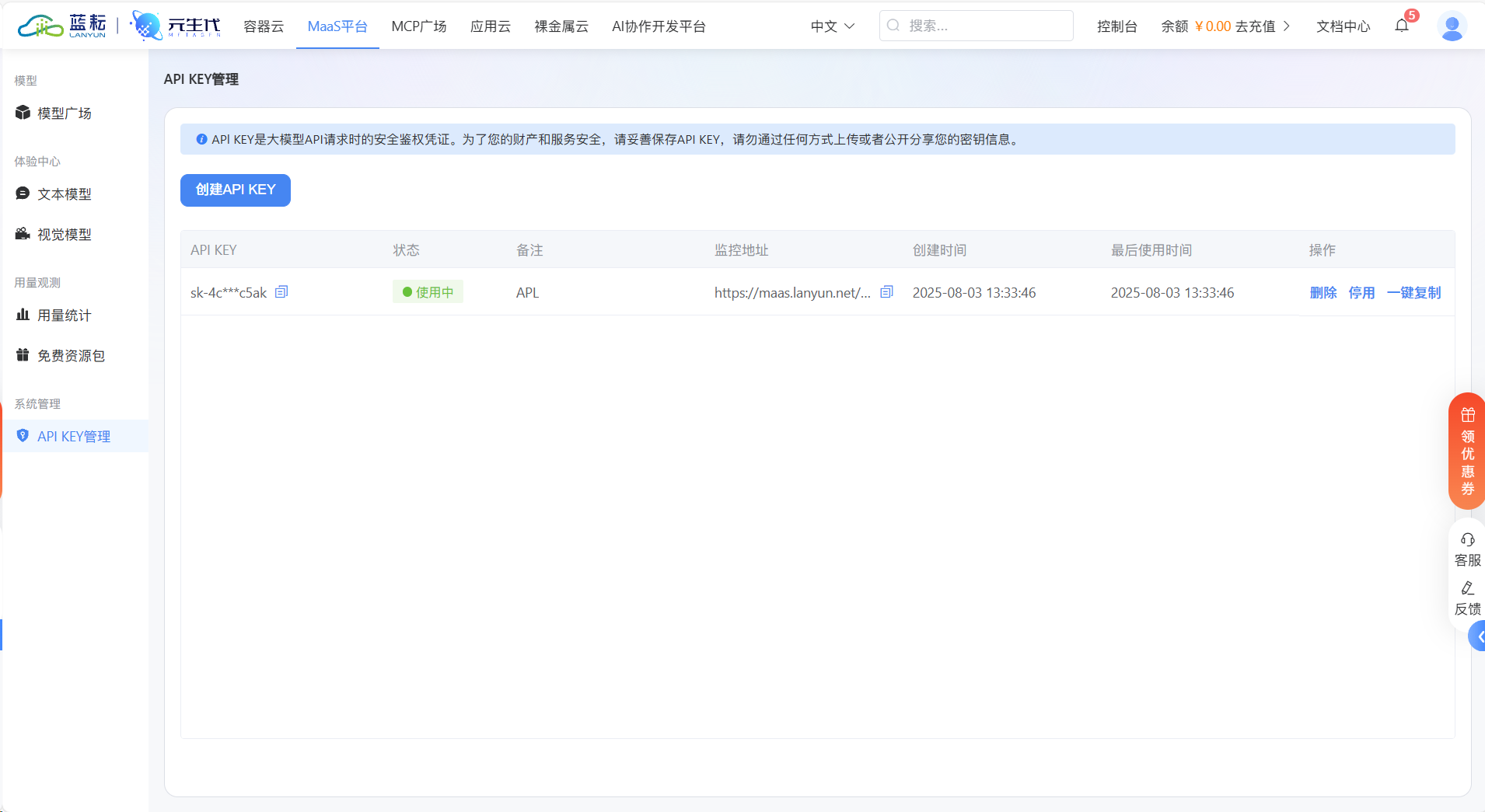

api我们在Maas平台首页的api创建页就能进行生成

固然示例代码如下:

from openai import OpenAI# 构造 clientclient = OpenAI( api_key=\"sk-xxxxxxxxxxx\", # APIKey base_url=\"https://maas-api.lanyun.net/v1\",)# 流式stream = True# 请求chat_completion = client.chat.completions.create( model=\"/maas/kimi/Kimi-K2-Instruct\", messages=[ { \"role\": \"user\", \"content\": \"你是谁\", } ], stream=stream,)if stream: for chunk in chat_completion: # 打印思维链内容 if hasattr(chunk.choices[0].delta, \'reasoning_content\'): print(f\"{chunk.choices[0].delta.reasoning_content}\", end=\"\") # 打印模型最终返回的content if hasattr(chunk.choices[0].delta, \'content\'): if chunk.choices[0].delta.content != None and len(chunk.choices[0].delta.content) != 0: print(chunk.choices[0].delta.content, end=\"\")else: result = chat_completion.choices[0].message.content使用trae进行实战

在获取到了调用的示例代码之后我们就可以让ai帮我们生成对应的程序了

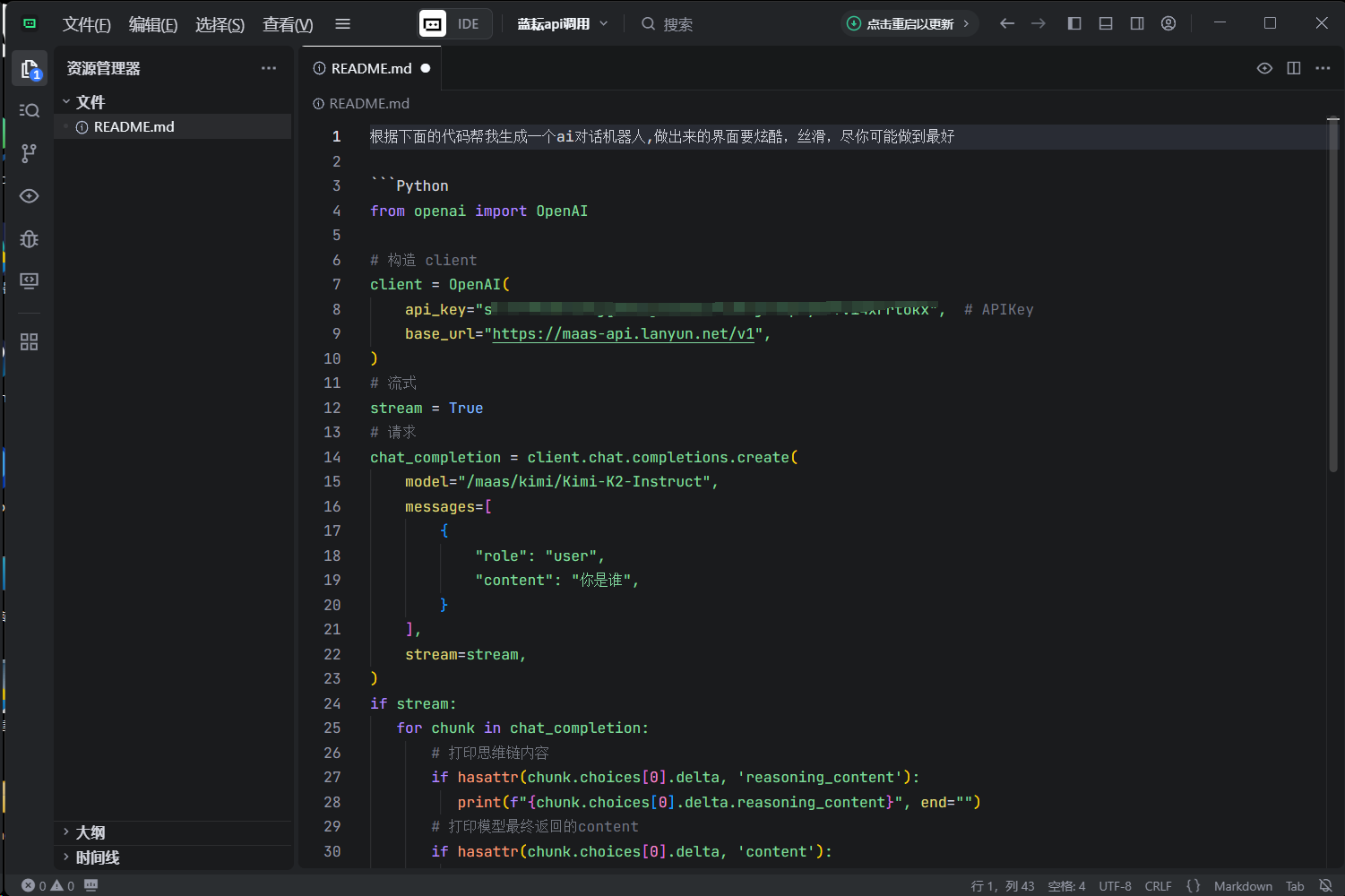

打开trae,将我们的需求写入到README文件中,效果如下:

接下来我们就可以开始进行提问了,如果你们有其他新鲜的想法都是可以写到这个README文件中的,这里他是给我们生成一个网页端的

我们这里首先得先进行代码依赖的安装操作

Flask==2.3.3openai==1.3.0Werkzeug==2.3.7在终端输入命令将文件中对应的依赖进行安装

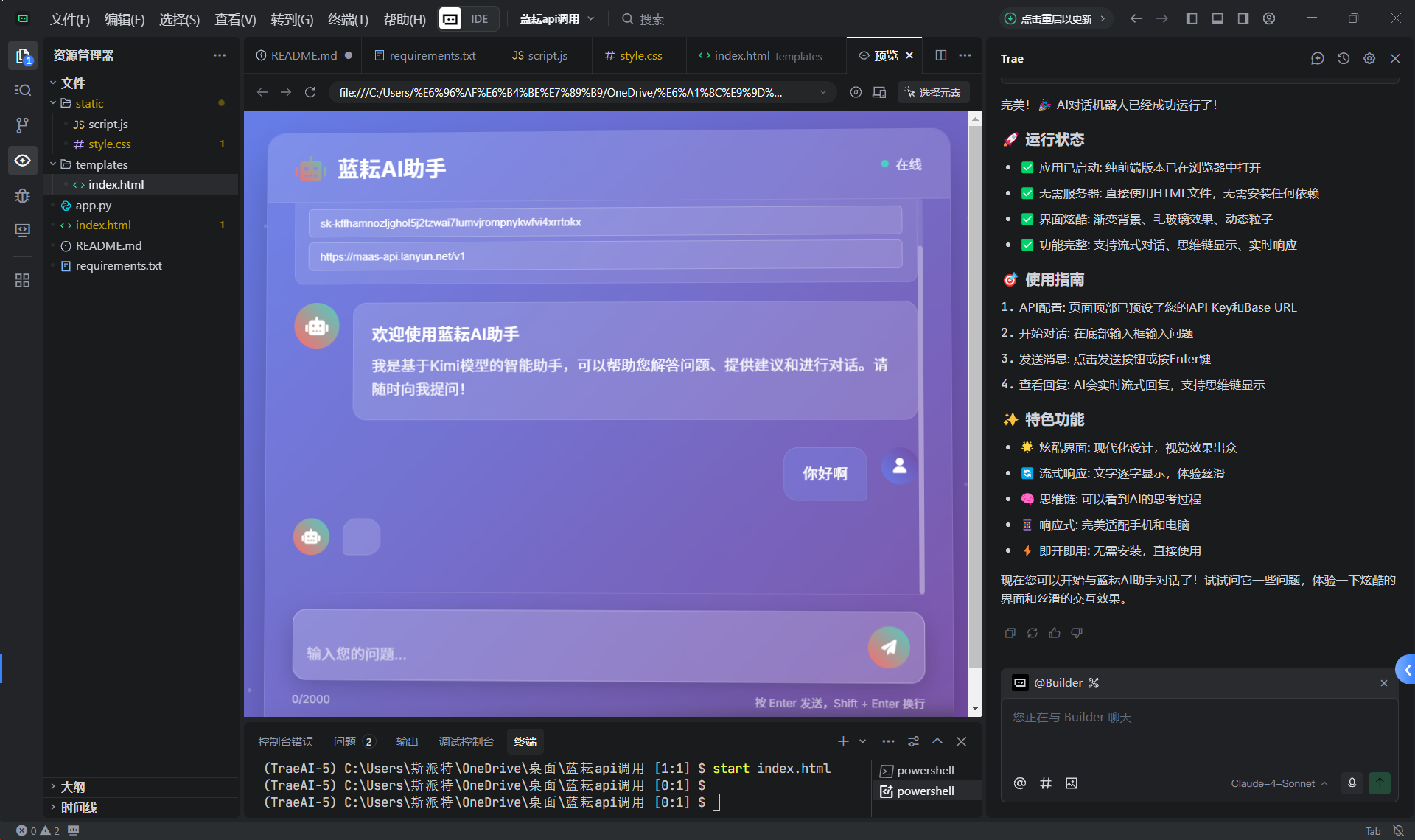

pip install -r requirements.txt 然后我们运行对应的文件,效果如下

可以在终端输入命令

python simple_server.py 这样我们就能在网页端进行体验了,在本机的8080端口开放

- 主要地址 : http://localhost:8000/index.html

- 服务器地址 : http://localhost:8000

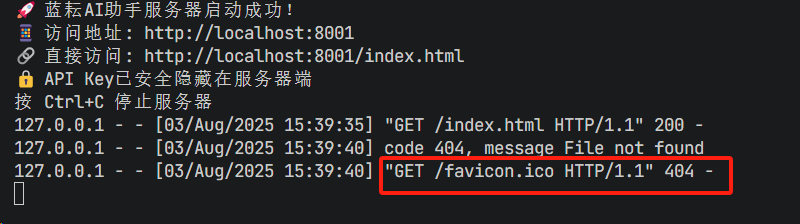

这里我们可以在终端看到我们的程序是正常运行的,但是因为favicon.ico导致了报错现象,所以我们让ai改改代码忽略下这个文件

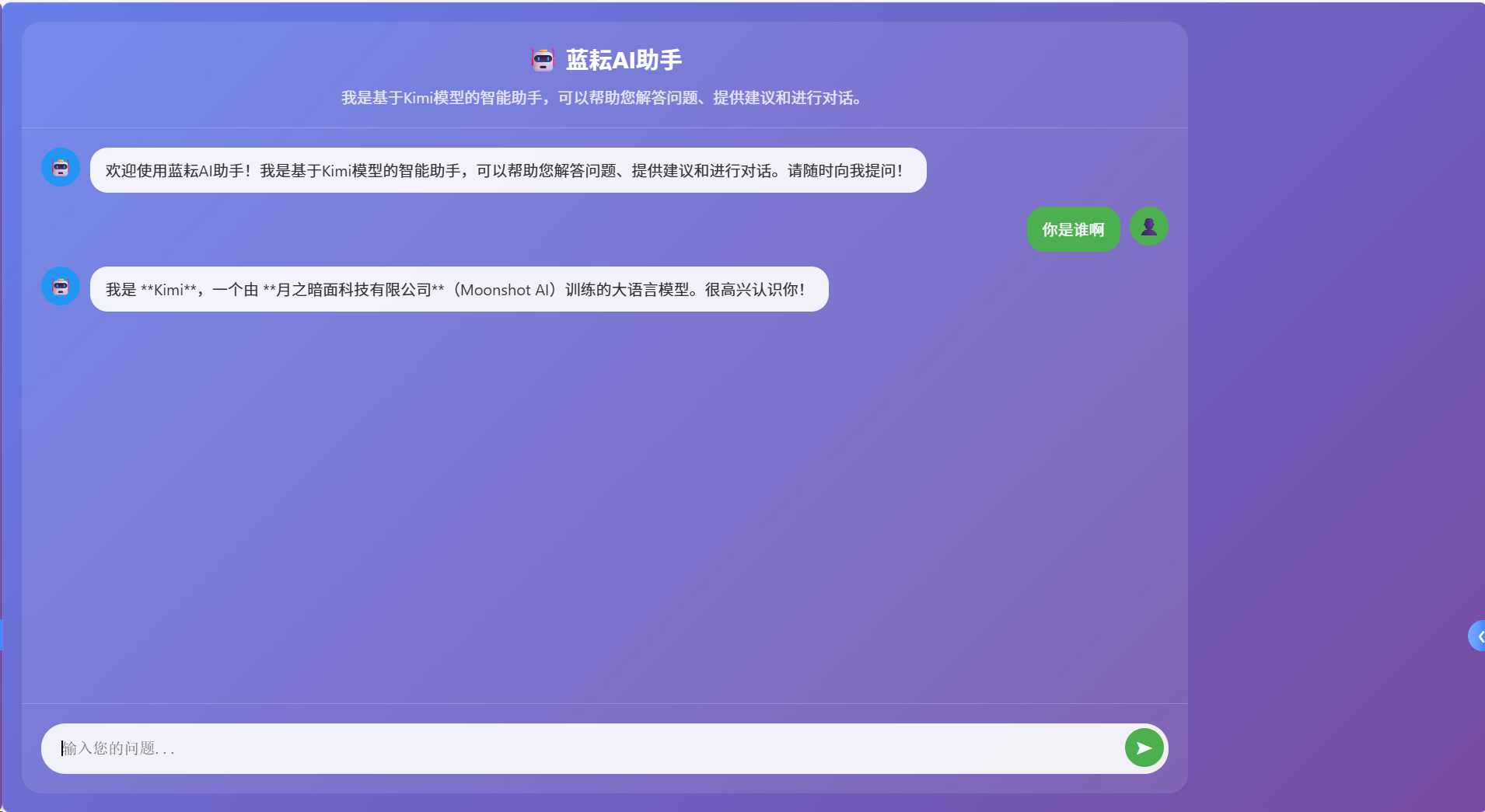

修改后的效果如下:

后期稍微把生成的效果格式改改就差不多了,有一说一这个生成的速度还是很快的

总结

蓝耘深刻理解到了企业在智能化转型中的痛点:部署难、成本高、效率低。蓝耘以极致的易用性和卓越的性价比破局而来!平台界面非常的清晰直观,功能模块化设计,让非技术背景的人员也能轻松驾驭AI的力量,大幅降低技术门槛。同时,其智能化的资源管理和弹性伸缩能力,进一步确保了每一分投入都精准高效,显著降本增效,加速业务价值落地。蓝耘致力于打破技术鸿沟,让先进的算力与智能如同水电般触手可及。

在蓝耘,通过 trae 构建本地AI对话机器人不仅能提升技术能力,还能深入理解自然语言处理和机器学习模型的底层逻辑。本文详细介绍了环境搭建、模型集成、交互逻辑设计等关键步骤,帮助开发者快速实现本地化AI对话应用。

最后,希望本文能为读者提供清晰的指引,助力实现更强大的本地AI应用。如果有任何问题或改进建议,欢迎进一步交流探讨!