【GitHub开源AI精选】VRAG-RL:阿里通义推出的多模态RAG推理框架,助力视觉信息理解与生成

系列篇章💥

目录

- 系列篇章💥

- 前言

- 一、项目概述

- 二、技术原理

-

- (一)视觉感知动作空间

- (二)强化学习框架

- (三)综合奖励机制

- (四)多轮交互训练

- (五)数据扩展和预训练

- 三、主要功能

-

- (一)视觉感知增强

- (二)多轮交互推理

- (三)综合奖励机制

- (四)可扩展性

- 四、应用场景

-

- (一)智能文档问答

- (二)视觉信息检索

- (三)多模态内容生成

- (四)教育与培训

- (五)智能客服与虚拟助手

- 五、快速使用

-

- (一)环境准备

- (二)部署搜索引擎

- (三)部署模型服务

- (四)运行Demo

- (五)自定义使用

- 六、结语

- 项目地址

前言

随着人工智能技术的飞速发展,多模态交互和深度学习逐渐成为研究热点。在视觉与语言融合领域,如何让模型更好地理解和生成视觉丰富信息是一个关键问题。阿里巴巴通义大模型团队推出的VRAG-RL框架,通过视觉感知驱动的多模态RAG推理,为这一问题提供了全新的解决方案。本文将详细介绍VRAG-RL的技术原理、主要功能、应用场景以及快速使用实践。

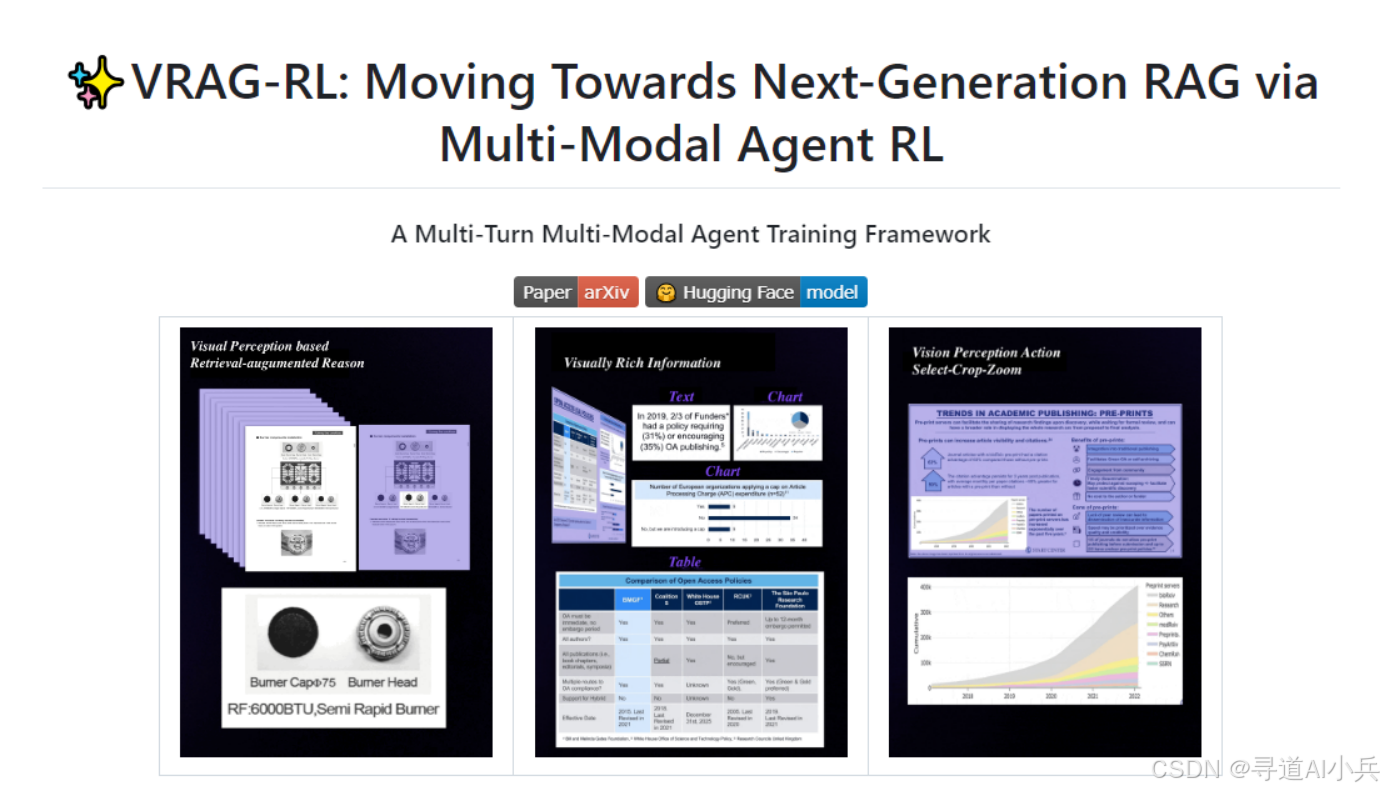

一、项目概述

VRAG-RL是阿里巴巴通义大模型团队推出的视觉感知驱动的多模态RAG推理框架。它专注于提升视觉语言模型(VLMs)在处理视觉丰富信息时的检索、推理和理解能力,通过定义视觉感知动作空间,让模型从粗粒度到细粒度逐步获取信息,激活推理能力。该框架引入综合奖励机制,结合检索效率和基于模型的结果奖励,优化模型的检索和生成能力,在多个基准测试中显著优于现有方法,展现出强大的视觉信息理解潜力。

二、技术原理

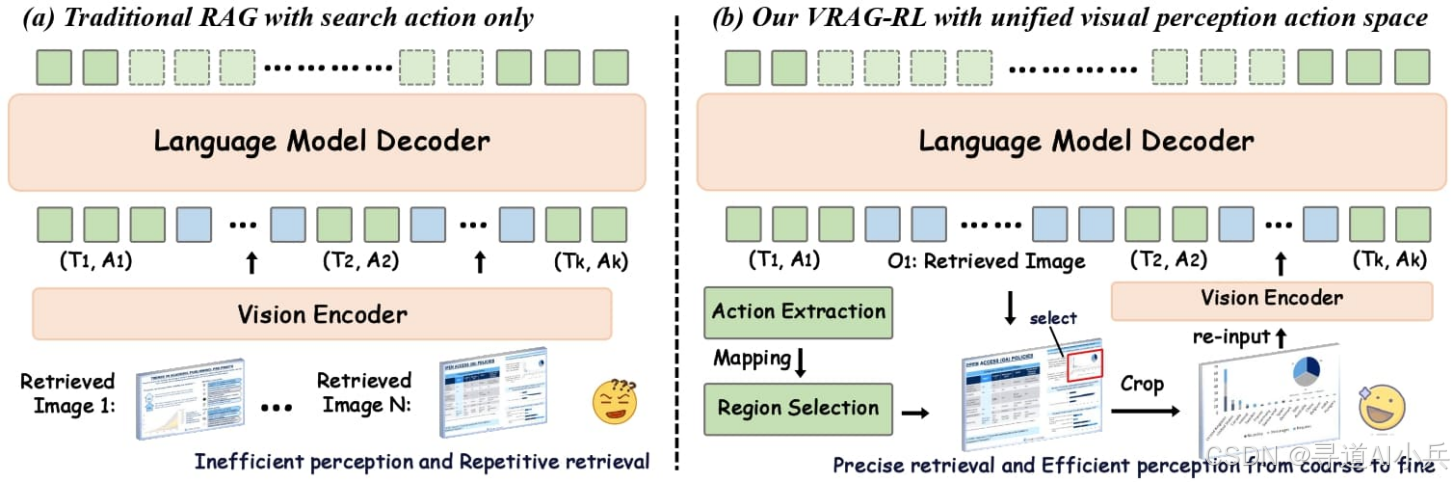

(一)视觉感知动作空间

- 动作定义:VRAG-RL定义了一组视觉感知动作,包括选择感兴趣区域、裁剪和缩放。这些动作使模型能够逐步从粗粒度到细粒度获取信息,更有效地关注信息密集区域。

- 信息获取:通过视觉感知动作空间,模型可以逐步聚焦于关键信息,避免一次性处理过多无关信息,从而提高推理效率和准确性。

(二)强化学习框架

- 优化目标:VRAG-RL采用强化学习(RL)优化模型的推理和检索能力。基于与搜索引擎的交互,模型自主采样单轮或多轮推理轨迹,并基于样本进行持续优化。

- 交互优化:强化学习框架使模型能够在多轮交互中逐步优化推理过程,提升推理的稳定性和一致性。

(三)综合奖励机制

- 奖励函数设计:VRAG-RL设计了一种综合奖励函数,包括检索效率奖励、模式一致性奖励和基于模型的结果奖励。奖励机制关注最终结果,优化检索过程,使模型更有效地获取相关信息。

- 优化指导:综合奖励机制全面指导模型优化推理和检索能力,让模型更贴近实际应用场景。

(四)多轮交互训练

- 训练策略:基于多轮交互训练策略,模型在与外部环境的持续交互中逐步优化推理过程,提升推理的稳定性和一致性。

- 动态调整:多轮交互训练使模型能够根据反馈动态调整推理策略,进一步提高推理效果。

(五)数据扩展和预训练

- 多专家采样策略:基于多专家采样策略扩展训练数据,确保模型在预训练阶段学习到有效的视觉感知和推理能力。

- 预训练优势:通过数据扩展和预训练,模型能够更好地适应不同类型的视觉信息,提升泛化能力。

三、主要功能

(一)视觉感知增强

- 逐步信息获取:通过定义视觉感知动作空间,模型能够从粗粒度到细粒度逐步获取信息,更有效地激活推理能力。

- 信息聚焦:模型能够聚焦于关键信息,避免处理过多无关信息,提高推理效率。

(二)多轮交互推理

- 持续交互:支持多轮交互,让模型能够与搜索引擎进行持续交互,逐步优化推理过程。

- 动态调整:模型根据反馈动态调整推理策略,进一步提高推理效果。

(三)综合奖励机制

- 全面优化:结合检索效率和基于模型的结果奖励,全面指导模型优化推理和检索能力。

- 贴近实际:奖励机制关注最终结果,优化检索过程,使模型更贴近实际应用场景。

(四)可扩展性

- 工具集成:框架具有良好的可扩展性,支持多种工具和模型的集成。

- 自定义扩展:方便用户自定义和扩展,满足不同需求。

四、应用场景

(一)智能文档问答

- 高效检索:快速从PPT、报告等文档中检索和理解信息,高效回答问题。

- 信息整合:结合视觉和文本信息,生成图文并茂的总结和报告。

(二)视觉信息检索

- 快速定位:从大量图表、图片中快速定位并提取相关视觉信息。

- 精准匹配:通过视觉感知动作空间,模型能够更精准地匹配目标信息。

(三)多模态内容生成

- 图文结合:结合视觉和文本信息,生成图文并茂的总结、报告等。

- 创意生成:支持创意内容生成,满足多样化需求。

(四)教育与培训

- 辅助教学:辅助教学,帮助学生更好地理解和分析视觉材料。

- 个性化学习:根据学生需求生成个性化学习内容。

(五)智能客服与虚拟助手

- 视觉问题处理:处理用户提出的涉及视觉内容的问题,提供准确回答。

- 多模态交互:支持多模态交互,提升用户体验。

五、快速使用

(一)环境准备

- 创建环境:使用以下命令创建Python环境:

conda create -n vrag python=3.10- 克隆项目:克隆VRAG项目到本地:

git clone https://github.com/alibaba-nlp/VRAG.gitcd VRAG- 安装依赖:安装运行demo所需的依赖:

pip install -r requirements.txt(二)部署搜索引擎

- 启动搜索引擎:运行以下命令启动搜索引擎服务:

python search_engine/search_engine_api.py(三)部署模型服务

- 下载模型:下载并部署7B模型服务:

vllm serve autumncc/Qwen2.5-VL-7B-VRAG --port 8001 --host 0.0.0.0 --limit-mm-per-prompt image=10 --served-model-name Qwen/Qwen2.5-VL-7B-Instruct(四)运行Demo

- 启动Demo:使用Streamlit启动VRAG的Demo:

streamlit run demo/app.py(五)自定义使用

- 构建索引数据库:运行以下命令构建索引数据库:

python ./search_engine/ingestion.py- 运行多模态检索器:使用以下代码运行多模态检索器:

from search_engine import SearchEnginesearch_engine = SearchEngine(dataset_dir=\'search_engine/corpus\', node_dir_prefix=\'colqwen_ingestion\', embed_model_name=\'vidore/colqwen2-v1.0\')recall_results = search_engine.batch_search([\'some query A\', \'some query B\'])- 集成到应用:将VRAG集成到自己的应用中,示例代码如下:

from vrag_agent import VRAGvrag = VRAG(base_url=\'http://0.0.0.0:8001/v1\', search_url=\'http://0.0.0.0:8002/search\', generator=False)answer = vrag.run(\'What is the capital of France?\')六、结语

VRAG-RL作为阿里巴巴通义大模型团队推出的多模态RAG推理框架,通过视觉感知驱动的推理机制和强化学习优化,显著提升了视觉语言模型在视觉丰富信息理解领域的表现。其强大的功能和良好的可扩展性使其在智能文档问答、视觉信息检索、多模态内容生成等多个场景中具有广泛的应用前景。未来,随着更多模型的发布和训练代码的开源,VRAG-RL有望为多模态人工智能领域带来更多的创新和突破。

项目地址

- GitHub仓库:https://github.com/Alibaba-NLP/VRAG

- HuggingFace模型库:https://huggingface.co/collections/autumncc/vrag-rl

- arXiv技术论文:https://arxiv.org/pdf/2505.22019

🎯🔖更多专栏系列文章:AI大模型提示工程完全指南、AI大模型探索之路(零基础入门)、AI大模型预训练微调进阶、AI大模型开源精选实践、AI大模型RAG应用探索实践🔥🔥🔥 其他专栏可以查看博客主页📑

😎 作者介绍:资深程序老猿,从业10年+、互联网系统架构师,目前专注于AIGC的探索(CSDN博客之星|AIGC领域优质创作者)

📖专属社群:欢迎关注【小兵的AI视界】公众号或扫描下方👇二维码,回复‘入群’ 即刻上车,获取邀请链接。

💘领取三大专属福利:1️⃣免费赠送AI+编程📚500本,2️⃣AI技术教程副业资料1套,3️⃣DeepSeek资料教程1套🔥(限前500人)

如果文章内容对您有所触动,别忘了点赞、⭐关注,收藏!加入我们,一起携手同行AI的探索之旅,开启智能时代的大门!