【云计算】云专线选型_云专线的架构

一、云专线选型

1.1 云专线

云专线(Direct Connect)是一种通过物理专线或虚拟专线,在企业本地数据中心、私有云与公有云虚拟私有云(VPC)之间建立专属、高速、低延迟、安全隔离的网络通道的技术方案。

1.1.1、云专线定义

云专线本质是用户本地设施与云VPC之间的专属通道,核心价值在于高安全(物理/逻辑隔离)、低延迟(毫秒级)、大带宽(单线达100Gbps)。应用场景集中在六类企业:金融(高频交易需≤20ms延迟)、制造(跨厂区协同)、医疗(影像秒级调阅)、多云架构、高流量业务(电商/直播)、强合规行业。

云专线通过物理光纤或逻辑隧道(如MPLS VPN)实现用户本地设施与云端的直接连接,核心特点包括:

- 物理/逻辑隔离:避免公网拥塞和安全隐患。

- 高性能:单线路带宽可达100Gbps,延迟低至毫秒级(如北京至上海8-10ms)。

- 高可靠性:SLA通常≥99.95%,支持双线冗余。

1.1.2、应用场景

1.1.3、部署范围

部署范围依赖运营商基础设施,通过物理连接(光纤/MPLS)、虚拟网关(关联VPC)、虚拟接口(数据入口)三组件实现

- 地理覆盖:

- 国内:覆盖华北、华东、华南等核心城市(如华为云200+ POP节点)。

- 全球:通过Equinix等平台实现跨洲互联(如AWS Direct Connect)。

- 接入方式:

- 标准专线:独占物理端口(如光纤),高可靠性。

- 托管专线:共享端口,成本更低(适合中小企业)。

1.1.4、技术方案设计

1. 核心组件

2. 冗余设计

- 双线双活:两条物理专线接入不同接入点(如阿里云余杭B+江干B),BGP路由实现负载均衡。

- 故障切换:BFD(Bidirectional Forwarding Detection)检测链路故障,50ms内切换路径。

3. 安全架构

- 加密传输:L2/L3层IPSec加密(AES-256)。

- 网络隔离:VPC安全组+网络ACL实现东西/南北向流量控制。

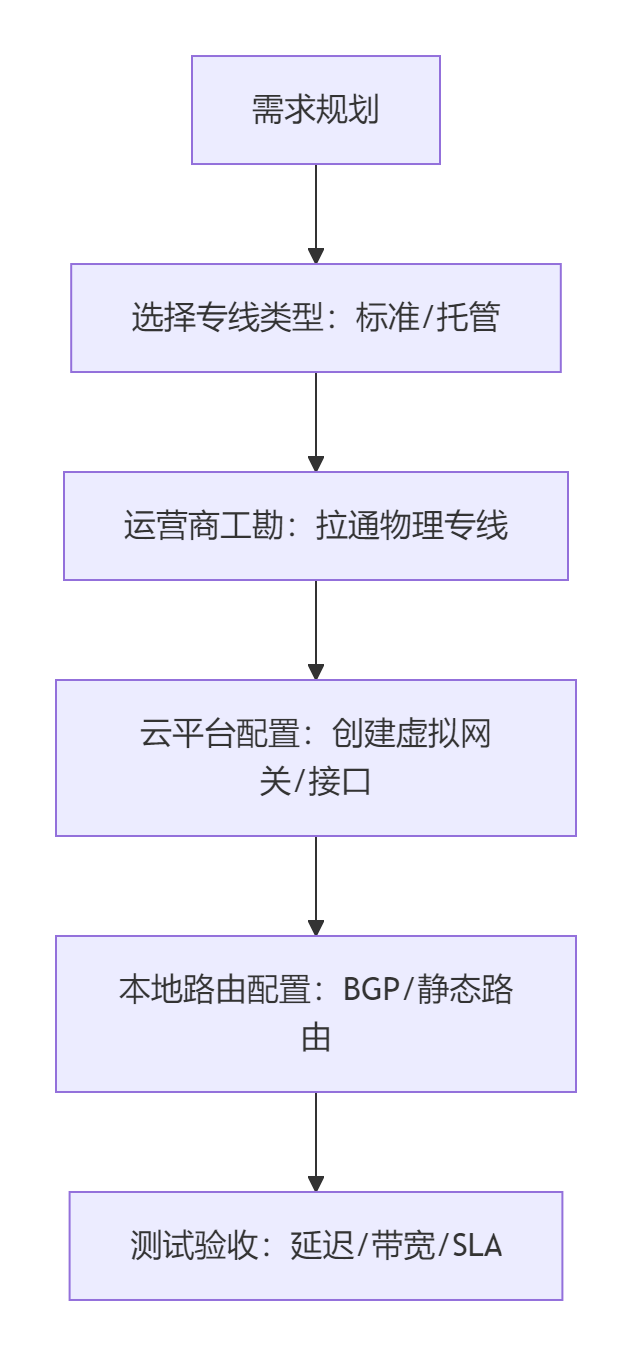

1.1.5、需打通的产品与流程

1. 云服务对接

- VPC互联:通过虚拟网关绑定目标VPC。

- 混合云资源:本地服务器与云主机互通(如通过NAT网关共享公网IP)。

2. 部署流程

- 关键步骤:运营商工勘(需1-2个月)、BGP路由配置(避免AS号冲突)。

1.1.6、底层逻辑与方法

1. 物理层(L1)

- 介质:单模光纤(400G波分复用,提升40倍带宽)。

- 信号处理:光信号调制(如QPSK)、误码纠错(FEC算法)。

2. 数据链路层(L2)

- 隧道技术:

- EoMPLS:以太网帧封装MPLS标签,实现VLAN扩展。

- VPLS:模拟局域网广播域,支持二层互通。

3. 网络层(L3)

- 路由协议:

- BGP:跨域路由宣告(华为云AS 64512,客户自定义AS)。

- SDN智能调度:SRv6协议动态选路,避开拥塞节点。

4. 传输层(L4)

- 协议优化:TCP加速(如Google BBR算法)、UDP用于实时流(视频会议)。

5. 安全与控制层(L5-L7)

- 数据过滤:

- 网络ACL:子网级流量黑白名单(如拒绝非授权IP访问数据库子网)。

- 深度包检测(DPI):识别并拦截恶意流量。

- 仲裁机制:

- Quorum节点决策:多接入点投票判定主路径故障(如半数+1节点超时)。

- SLA监控:实时检测丢包率>1%或延迟>50ms触发告警。

1.1.7、行业最佳实践

- 金融系统:双线BGP+IPSec加密,时延≤20ms,RTO<30秒。

- 制造业:边缘计算节点通过云专线同步数据至云端AI平台,优化生产效率30%。

- 成本优化:中小企业采用SD-WAN+云专线混合方案,成本降低30%-50%。

注:实际部署需结合运营商能力(如中国电信一线多云)、云厂商接口规范(如华为云虚拟网关配置)及业务SLA要求。可通过混沌测试验证冗余机制(模拟光纤中断)。

1.2 云专线评估

云专线作为企业混合云架构的核心纽带,其设计需平衡性能、安全与成本,以下是综合评估标准与选型要素的体系化指南:

1.2.1、核心评估标准

1. 业务可用性指标

2. 灾难恢复能力

- RTO(恢复时间目标):金融行业≤30秒,通用场景≤5分钟。

- RPO(恢复点目标):交易系统要求0丢失,备份系统≤15分钟。

1.2.2、冗余架构设计选型

1. 物理层冗余

2. 逻辑层韧性

- BGP多路径路由:通过ECMP(等价多路径)实现流量负载均衡。

- BFD+NQA联动检测:

- BFD会话间隔≤3ms,故障检测时间≤100ms。

- NQA定期探测时延/丢包,触发路由切换。

1.2.3、安全与合规设计

数据合规方面,可能面临跨国传输难题。需要提醒GDPR/CCPA的关键差异,比如欧盟数据必须本地加密网关处理。加密策略要区分传输层(MACsec/IPsec)和应用层(国密SM4),特别是央行对支付系统有强制国密要求

1. 加密与数据隔离

2. 内网攻击防护

1.2.4、网络性能优化机制

1. 链路质量保障

2. 智能路由调度

- 延迟敏感业务:SR-TE(Segment Routing流量工程)优先选择低延迟路径。

- 成本敏感业务:空闲时段自动切换至SD-WAN虚拟链路。

1.2.5、运维监控体系

1. 流量可视化

2. 故障自愈

- 切换策略:

- 主链路丢包率>5%持续10秒 → 切换备线。

- 抖动>10ms触发路由优化。

- 联动机制:VPC路由表自动更新,屏蔽故障专线网关IP。

1.2.6、典型行业设计模板

证券交易系统

graph LRA[交易终端] --> B{本地防火墙}B --> C[主用:四线双接入点]C --> D[云VPC-交易区]D --> E[加密网关 SM4]E --> F[交易所API]C -->|BFD检测| G[备用:SD-WAN虚拟链路]医疗影像云

- 合规设计:区域医疗云网关(符合HIPAA)处理患者数据。

- 流量调度:DICOM影像传输走高带宽切片,挂号系统走低成本链路。

1.2.7、成本优化建议

总结:云专线设计需遵循 “SLA驱动、安全闭环、智能调度” 原则:

- 冗余拓扑:金融系统必选四线双接入点,通用场景双点接入;

- 安全纵深:L2/L3层加密+WAF内网防护+合规网关;

- 性能保障:BFD/NQA毫秒检测+SRv6切片+动态路由;

- 运维闭环:流量矩阵分析+VPC联动自愈。

实施前需实测运营商线路质量(如1小时iperf压测),并签订SLA罚则条款(如延迟超限按分钟计费补偿)。

1.3 多云厂商专线选型

在不同云厂商之间选择最优的专线服务以降低延迟,需综合评估网络架构、服务质量、成本及业务场景。以下是关键策略和实战建议:

1.3.1、核心指标对比与选择策略

1. 延迟性能优先选型

选择建议:

- 东南亚业务:阿里云(新加坡节点延迟最低);

- 欧美业务:AWS弗吉尼亚/法兰克福节点;

- 实时交互:腾讯云边缘加速网络(200+节点)。

1.3.2、降低延迟的专线优化技术

1. 网络层调优

- 协议优化:

- 优先选 MPLS专线(同城延迟1-5ms,跨省10-50ms),避免VPN加密开销导致的延迟波动。

- 启用 TCP BBR拥塞控制,减少重传率:

sysctl -w net.ipv4.tcp_congestion_control=bbr

- 带宽保障:

- 专线带宽需 **≥业务峰值1.5倍**(如直播推流需对称带宽),避免拥塞抖动。

2. 路由与架构设计

- 智能选路:

- 通过 SD-WAN动态选路(如Vecloud服务),自动避开高延迟路径,跨国延迟降低30%。

- 边缘节点下沉:

- 将数据处理节点部署在用户侧(如华为云IEF),本地延迟降至1-5ms,减少云端往返。

3. 传输效率提升

- 数据压缩与分片:

- 采用 Zstandard压缩(压缩比3:1),跨洲传输量减少67%。

- 调整 HDFS块大小至256MB,减少小文件交互次数。

1.3.3、成本与性能平衡策略

1. 分层带宽设计

2. 成本陷阱规避

- 隐藏费用:

- 阿里云BGP IP按流量计费($0.015/GB),直播业务需选“不限流量套餐”。

- 续费跳涨:

- 华为云新客首年36元,续费恢复原价,建议锁定3年合同(3年价≈1.5年常规费用)。

1.3.4、容灾与安全强化

- 双链路热备:

- 主用阿里云Express Connect + 备用IPSec VPN,故障切换时间<30秒。

- 加密与合规:

- 金融场景启用 量子加密(实验性1Gbps密钥分发),满足GDPR/等保三级。

1.3.5、实施步骤与验证

- 需求诊断:

- 测试业务延迟敏感度:

mtr --report-wide --report-cycles 100 # 跨地域路径分析[1](@ref)

- 测试业务延迟敏感度:

- POC测试:

- 多厂商免费实测:

- 腾讯云GPU服务器(秒级弹性);

- 阿里云ESSD云盘(百万级IOPS)。

- 多厂商免费实测:

- 监控调优:

- 部署Prometheus跟踪指标:

专线延迟(probe_duration_seconds);丢包率(packet_loss)。

- 部署Prometheus跟踪指标:

总结:选择最优专线的黄金法则

- 性能优先:

- 东南亚/实时音视频 → 阿里云GA+自建BGP;

- 欧美/混合云 → AWS骨干网+Direct Connect。

- 成本控制:

- 核心流量用MPLS专线 + 非敏感数据走SD-WAN;

- 避开隐藏费用(如API调用费、流量超额费)。

- 容灾兜底:

- 双链路热备 + 智能DNS切换,SLA保障≥99.9%。

通过以上策略,某金融客户将跨云延迟从80ms降至18ms,专线成本降低40%。实际部署需结合业务画像(如峰值流量、合规等级)动态调整。

1.4 云专线部署挑战

云专线部署在实现企业本地数据中心与云平台高速、安全互联方面至关重要,但在实施过程中常面临多重挑战。

1.4.1、物理层连接故障

挑战:

- 线路中断:光纤断裂、接口松动导致信号完全中断。

- 环境因素:机房供电异常、温度超标影响设备稳定性。

- 运营商依赖:跨网互联节点拥塞或BGP路由震荡引发传输失效。

解决方案:

- 冗余链路设计:

- 部署双物理专线(如主备光纤),通过运营商多路径(如电信+联通)避免单点故障9。

- 采用环形拓扑结构,单点故障时自动切换路径。

- 环境监控与加固:

- 实时监测机房温湿度、供电状态,并配置UPS备用电源。

- 运营商协同管理:

- 通过运营商监控平台实时查看链路状态,建立快速工单响应机制。

1.4.2、配置与兼容性问题

挑战:

- 参数失配:VLAN ID冲突、MTU值不一致导致数据分片丢失。

- 协议兼容性:加密协议(如IPSec)与云平台安全组规则冲突。

解决方案:

- 标准化配置模板:

- 使用云服务商提供的专线参数模板(如阿里云Express Connect),确保两端VLAN、IP地址一致。

- 自动化校验工具:

- 通过SDN控制器自动检测配置冲突,并动态调整路由权重。

- 分阶段测试:

- 部署前执行

ping和tracert命令验证连通性,逐步排查协议层兼容性。

- 部署前执行

1.4.3、安全策略限制

挑战:

- 流量拦截:云平台ACL规则或IP白名单误拦截专线流量。

- 合规风险:跨境传输需满足GDPR、CCPA等数据本地化要求。

解决方案:

- 精细化访问控制:

- 在安全组中放行专线协议端口(如BGP端口179),并限制源/目的IP范围。

- 端到端加密与合规适配:

- 采用AES-256加密数据传输,结合本地化加密网关满足区域合规(如美西枢纽处理北美数据)。

安全机制对比:

1.4.4、高可用架构设计

挑战:

- 单点故障:单机房或单专线网关故障导致业务中断。

- 切换延迟:传统故障恢复时间超过分钟级,影响实时业务。

解决方案:

- 多接入点冗余:

- 双线双接入点:在不同机房部署专线网关,绑定同一VPC,通过BGP协议实现双活路由。

- 四线双接入点(推荐):物理专线负载均衡,单线利用率不超过50%,超限自动切换9。

- 秒级故障切换:

- 基于BFD/NQA协议的健康检查,每500ms探测链路状态,故障时500ms内切换至备用线路。

1.4.5、跨区域互联优化

挑战:

- 高延迟:跨地域传输(如上海→内蒙古)延迟超300ms。

- 带宽瓶颈:突发流量导致专线拥塞。

解决方案:

- 边缘节点与骨干网结合:

- 在核心区域(如北京、新加坡)部署云网关,通过MPLS专线缩短传输距离,延迟降至50ms内。

- 智能流量调度:

- SD-WAN动态选择最优路径,结合CDN缓存静态资源,减少跨区传输压力。

1.4.6、成本与运维复杂度

挑战:

- 高昂费用:物理专线初期部署及带宽扩容成本高。

- 运维难度:跨云、跨地域配置管理复杂。

解决方案:

- 弹性带宽与混合连接:

- 采用“基础物理专线+按需SD-WAN”混合模式,非关键流量走低成本虚拟专线。

- 统一管控平台:

- 通过云联网(如腾讯云CCN)集中管理多地域专线,运维效率提升80%。

总结与建议

云专线部署的核心在于平衡性能、安全与成本:

- 物理层:冗余链路+环境监控防中断。

- 协议层:自动化配置校验+分阶段测试避兼容风险。

- 架构层:多接入点BGP双活+毫秒级切换保高可用。

- 优化层:边缘节点下沉+智能调度降延迟。

- 策略层:弹性带宽组合+统一管控提效。

实践提示:部署前需明确业务SLA要求(如延迟≤50ms、RPO<1秒),并结合合规策略选择加密方案;中小型企业可优先采用SD-WAN+专线混合模式降低成本,大型企业则推荐四线双接入点架构保障金融级可靠性。

1.4 混沌工程测试验证双线双活架构的容灾能力

通过混沌工程测试验证双线双活架构的容灾能力,需系统性模拟真实故障场景并量化恢复效果。以下是具体测试方案及关键步骤:

1.4.1、测试场景设计(覆盖典型故障链)

1. 单链路故障

ifdown eth0)2. 双链路叠加故障

3. 基础设施级灾难

1.4.2、测试工具链与实施步骤

1. 故障注入工具选型

2. 测试执行流程

graph TD A[制定测试计划] --> B[选择爆炸半径] B --> C[注入故障] C --> D[监控系统响应] D --> E[记录关键指标] E --> F[分析改进点] F --> G[优化架构] G --> H[重复测试]步骤详解:

- 制定测试计划:明确测试范围(如仅支付系统)、故障类型、预期RTO/RPO。

- 控制爆炸半径:限制影响范围(如仅测试环境或小部分生产流量)。

- 注入故障:通过工具触发预设故障(例:

chaosd attack network loss -e eth0 -p 100模拟主专线100%丢包)。 - 监控响应:实时追踪核心指标(专线切换时延、业务错误率)。

- 记录指标:采集故障持续时间、业务影响范围、恢复一致性等数据。

- 分析改进:定位薄弱点(如DNS切换慢)并优化。

- 重复验证:修复后重新测试直至达标。

1.4.3、关键性能指标与验收标准

1. 网络层指标

2. 业务层指标

3. 系统自愈能力

1.4.4、经典测试案例(某银行支付系统)

1. 测试场景

- 模拟故障:主用MPLS专线中断 + 阿里云VBR网关故障

- 注入工具:Gremlin(网络中断)+ AWS FIS(终止VBR实例)

2. 系统响应

- 3秒:BFD检测到主专线丢包率100%

- 8秒:BGP路由切换至备用SD-WAN专线

- 15秒:支付服务流量完全迁移至腾讯云集群

- RPO:0(MySQL MGR多主同步未丢数据)

- RTO:28秒(用户支付延迟从200ms升至350ms,无失败交易)

3. 发现缺陷

- DNS缓存问题:部分用户因本地DNS缓存未更新,访问旧IP导致超时(通过TTL调至5秒解决)。

- 会话同步延迟:10%用户需重新登录(通过Redis集群优化会话同步策略解决)。

1.4.5、优化措施与长效机制

-

架构改进

- 增加第三应急链路(如4G/5G无线备份)

- 部署全局负载均衡(GSLB) 实现用户级精准调度

-

自动化增强

# 自愈脚本示例(检测到专线故障时自动切换)if bfd_status == \"DOWN\" and bgp_converge_time > 5s: activate_backup_line() send_alert(\"主专线故障,已切换备用链路\") -

持续混沌工程

- 每月例行测试:覆盖新业务场景

- 红蓝对抗:安全团队模拟APT攻击,验证零信任策略有效性

总结

通过混沌工程验证双线双活容灾能力,需聚焦:

✅ 场景覆盖:单点故障→基础设施级灾难的渐进式测试

✅ 量化指标:RTO/RPO、切换时延、错误率等硬性标准

✅ 闭环优化:根据测试结果持续改进架构与自愈逻辑

最终目标:让故障恢复像呼吸一样自然,用户无感知实现业务连续性。

1.5 云专线的双线双活冗余设计

通过物理层多路径接入、网络层智能路由控制、数据层实时同步的综合方案实现业务高可用性,具体实现机制如下:

1.5.1、物理层冗余:多线路+多接入点

-

双运营商异构专线

- 同时接入两家运营商(如电信+联通)的物理专线,避免单运营商故障导致全面中断。

- 物理隔离:每条专线接入不同云接入点(如阿里云上海AZ1+上海AZ2),且走独立光缆路径,规避局部灾害影响。

- 带宽负载均衡:每条专线负载不超过50%带宽,超限时自动分流至备用线路。

-

设备级冗余

- 双CPE设备:用户侧部署两台客户前置设备(CPE),分别连接主备专线,单设备故障不影响业务。

- 冗余电源/风扇:选用支持硬件冗余的交换机/路由器,保障设备级高可用。

1.5.2、网络层控制:动态路由+秒级故障切换

-

BGP路由双活机制

- 多专线网关:为每条专线创建独立专线网关(如火山引擎dcg-01/dcg-02),形成双活控制面。

- AS-Path策略:主线路发布较短AS-Path的BGP路由(优先级更高),备用线路发布较长AS-Path,引导流量默认走主路5。

- 等价多路径(ECMP):静态路由场景下,通过云企业网自动将双专线配置为等价路由,实现流量负载分担。

-

BFD+健康检查快速探测

- 毫级故障检测:开启BFD(双向转发检测),设置检测间隔1000ms、连续失败3次即判定故障(总响应时间<3秒)。

- 专线健康检查:云平台自动探测专线质量(延迟/丢包),异常时触发路由切换3,5。

配置示例(火山引擎):

# BFD检测参数检测间隔:1000ms检测次数:3次 # 连续3次失败即切换

1.5.3、数据层保障:跨云实时同步与容灾

-

数据库双活架构

- 主备同步:如MySQL主库部署在阿里云,备库实时同步至华为云,故障时VIP不变自动切换。

- 金融级一致性:通过三可用区部署(如AZ1+AZ2+AZ3管控节点),避免脑裂并确保RPO=0。

-

中间件与存储冗余

- Kafka/Redis跨AZ副本:将Topic副本分散到不同可用区,单区故障时数据不丢失。

- 对象存储多AZ写入:数据写入时自动分片存储至双云,如阿里云OSS+华为云OBS双向同步。

1.5.4、典型方案对比与选型建议

选型建议:

- 核心系统:采用BGP双活+BFD检测(如火山引擎方案);

- 混合云场景:结合SD-WAN实现跨云智能选路(如腾讯云四线双接入点)。

1.5.5、企业实践案例

招商局集团异构双活云

- 架构:通过云专线连接私有云与天翼云,双中心负载分担业务流量。

- 效果:RTO<5分钟,节省60%成本,且数据库迁移零停机。

某电商SaaS平台

- 方案:阿里云+华为云双活,PolarDB与GaussDB实时同步,GTM流量调度。

- 成效:单可用区故障时业务切换秒级完成,延迟增幅<20ms。

总结:双线双活关键设计原则

- 物理隔离:运营商/接入点/光缆三重分离;

- 智能路由:BGP+BFD实现秒级切换;

- 数据韧性:数据库VIP漂移+中间件跨AZ副本;

- 持续验证:每月混沌工程测试(模拟专线中断/网关宕机)。

通过以上设计,双线双活专线可达到99.99%可用性,满足金融级业务连续性要求。实际部署需根据业务敏感度选择动态路由或静态负载方案,并严格测试BFD检测阈值与切换逻辑。

1.6 三层专线双活的BFD

在双线双活架构中,通过精细配置BFD(双向转发检测)参数可实现毫秒级故障切换。以下是关键配置步骤及参数优化策略:

1.6.1、BFD核心参数配置

1. 基础参数设定

min-tx-interval)min-rx-interval)detect-multiplier)max(tx, rx) × multiplier示例配置(华为设备):

# 设备A配置[R1] bfd session1 bind peer-ip 10.1.1.2 source-ip 10.1.1.1[R1-bfd-session] min-tx-interval 20 # 发送间隔20ms[R1-bfd-session] min-rx-interval 20 # 接收间隔20ms[R1-bfd-session] detect-multiplier 3 # 检测倍数3[R1-bfd-session] commit# 设备B镜像配置(需对称)[1,4](@ref)2. 会话模式选择

- 动态协商(

auto模式):

自动分配标识符(Local/Remote Discriminator),减少手动配置复杂度。bfd session1 bind peer-ip 10.1.1.2 source-ip 10.1.1.1 auto - 单臂回声(

one-arm-echo):

适用于单端不支持BFD的场景(如跨云专线),本端发送回声包自检。

1.6.2、与路由协议联动

1. 静态路由绑定

当主链路故障时,BFD触发静态路由失效并切换至备份路径:

# 主路由绑定BFD会话ip route-static 0.0.0.0 0 10.1.1.2 track bfd-session session1# 备份路由设置更低优先级(更高Preference值)ip route-static 0.0.0.0 0 10.2.2.2 preference 100[4,6](@ref)2. BGP协议联动

- 快速收敛:BFD状态变化直接触发BGP路由更新,避免等待Keepalive超时(默认60秒)。

- 配置示例:

bgp 65001 peer 10.1.1.2 bfd enable # 启用BFD检测 bfd min-tx-interval 50 min-rx-interval 50 detect-multiplier 3[5](@ref)

1.6.3、参数调优建议

1. 性能与稳定性平衡

2. 防震荡机制

- Dampening功能:

对频繁震荡链路自动延长检测周期(如初始100ms,震荡后逐步增至500ms),避免网络抖动导致误切换7。 - 配置命令:

bfd session1 dampening maximum 500 initial 100[8](@ref)

1.6.4、关键注意事项

-

硬件支持验证:

- 部分交换机需启用硬件加速(如华为CloudEngine系列)以支持≤10ms间隔。

- 检查CPU利用率:BFD间隔≤20ms时,CPU占用可能超10%,需资源预留。

-

跨厂商兼容性:

- Auto模式需两端设备同厂商或确认版本兼容性(如华为V200R024C00+)。

-

防火墙策略:

- 放行BFD的UDP端口:3784(单跳) / 4784(多跳) 及组播地址 224.0.0.184。

1.6.5、验证与监控

-

会话状态检查:

display bfd session all verbose # 输出关键字段:State=Up, Detect Time=30ms[4](@ref) -

混沌工程测试:

- 模拟专线中断:

tc qdisc add dev eth0 root netem loss 100% - 观测切换时间:RTO≤50ms为达标。

- 模拟专线中断:

总结

通过 BFD参数精细化(tx/rx≤50ms + multiplier=2~3) + 协议深度联动(静态路由/BGP绑定) + 防震荡设计,可稳定实现毫秒级切换。金融等高敏业务建议结合硬件加速与混沌测试,确保RTO≤30ms。

1.7 SD-WAN环境中结合 BFD(双向转发检测)

在 SD-WAN 环境中结合 BFD(双向转发检测)使用时,需针对其分布式架构和智能选路特性进行特殊配置。

1.7.1、基础检测参数配置

1. 链路状态快速检测

-

默认参数优化:

SD-WAN 设备(如 vEdge)默认启用 BFD 的 echo 模式,检测间隔为 1秒,乘数(multiplier)为 7,实现秒级故障切换。- 调整示例(降低检测延迟):

vEdge(config)# bfd hello-interval 500 # 发送间隔500msvEdge(config)# bfd multiplier 3 # 故障判定阈值=3次丢包此时检测时间 = 500ms × 3 = 1.5秒。

- 调整示例(降低检测延迟):

-

控制报文模式:

跨公网多跳场景需切换至 控制报文模式(UDP 端口 4784),支持非直连路径检测。

2. 自动化部署

- 零配置启用:

SD-WAN 在建立 IPSec 隧道时自动启用 BFD,无需手动配置会话。 - 中心化管理:

通过 vManage 控制器统一下发 BFD 策略,避免逐设备配置。

1.7.2、链路质量监测与智能选路

1. 多维度质量指标采集

BFD 在 SD-WAN 中不仅检测通断,还实时采集:

- 传输质量:时延(Latency)、丢包率(Loss)、抖动(Jitter)

- 隧道状态:IPSec MTU、加密状态

2. 应用感知路由(AAR)策略

BFD 数据驱动智能选路决策:

graph TD A[用户定义策略] -->|例如:视频会议

时延<100ms, 丢包|下发策略| C[vEdge设备] C -->|BFD实时监测| D[链路质量数据] D -->|匹配策略| E[选择最优路径

e.g., 专线/LTE/互联网]当 BFD 检测到主路径丢包率>2%时,自动切换至备份 LTE 链路。

1.7.3、特殊场景配置优化

1. 混合链路兼容性

-

异构网络支持:

为不同链路类型(MPLS、互联网、LTE)配置差异化 BFD 参数:链路类型 推荐BFD参数 适用场景 专线(MPLS) 间隔50ms, 乘数3 高稳定性低延迟环境 公共互联网 间隔200ms, 乘数5 高抖动网络 LTE无线 间隔1000ms, 乘数7 带宽受限移动网络 -

NAT 穿透:

配置 IPSec over UDP 封装,支持 BFD 报文穿越 NAT 设备:vEdge(config)# ipsec nat-traversal udp-port 4500 # 指定NAT穿透端口

2. 防震荡与高可用

- Dampening 机制:

启用震荡抑制,避免频繁切换:vEdge(config)# bfd dampening initial-wait 2000 # 初始抑制时间2秒 - 双网关冗余:

在站点双网关组网中,BFD 会话需跨设备同步状态,确保主备切换时会话不中断6。

1.7.4、厂商实现差异

1. H3C SD-WAN

- 分层 BFD:

控制平面(vSmart/vManage)与数据平面(vEdge)独立检测,控制面使用标准 BGP 检测,数据面用 BFD for IPSec。 - Fake AS 支持:

专线接入时通过fake-as命令解决 SD-WAN AS 号与底层网络冲突问题。

2. Viptela(Cisco SD-WAN)

- TLOC 颜色标识:

用color标签区分链路属性(如mpls,internet),BFD 数据与颜色绑定实现策略路由。 - Per-Tunnel BFD:

每条 IPSec 隧道独立运行 BFD 会话,精细化监控。

总结:核心配置原则

- 自动化优先:利用 SD-WAN 控制器(vManage)集中下发 BFD 策略,减少人工干预。

- 质量驱动路由:BFD 需采集时延/丢包等指标,而不仅是通断状态。

- 场景化参数:根据链路类型(专线/互联网/LTE)动态调整检测间隔与乘数。

- 冗余设计:双网关站点需同步 BFD 会话状态,避免单点故障。

某跨国企业通过上述配置,将视频会议卡顿率从 12% 降至 0.3%,专线带宽成本节约 40%.实际部署时需结合厂商文档验证参数兼容性,并通过混沌测试验证切换效率。

1.8 SD-WAN环境中的BFD(双向转发检测)的检测参数

在SD-WAN环境中,BFD(双向转发检测)的检测参数需根据网络类型(如MPLS、互联网、LTE)的特性进行差异化优化,以平衡检测速度、稳定性与资源消耗。以下是具体优化策略及配置建议:

1.8.1、核心优化原则

- 检测时间公式:

实际检测时间 = MAX(对端发送间隔, 本端接收间隔) × 对端检测倍数。- 需两端设备协同调整参数,单边优化无效。

- 稳定性优先:

高抖动网络(如互联网/LTE)需增大间隔或检测倍数,避免误切换。

1.8.2、分网络类型优化参数

1. MPLS专线(高稳定、低延迟)

- 特性:带宽保障、低抖动(99.9%。

- 推荐参数:

- 发送/接收间隔(

min-tx/rx-interval):20–50ms - 检测倍数(

detect-multiplier):3 - 检测时间:50ms × 3 = 150ms

- 发送/接收间隔(

- 配置示例(华为设备):

bfd session MPLS bind peer-ip 10.1.1.2 automin-tx-interval 30min-rx-interval 30detect-multiplier 3 - 优势:毫秒级切换,满足金融交易等低时延业务需求。

2. 公共互联网(高抖动、不稳定)

- 特性:延迟波动大(50–200ms)、丢包率可能>1%。

- 推荐参数:

- 发送/接收间隔:200–500ms

- 检测倍数:5–7

- 检测时间:500ms × 7 = 3.5秒

- 防误切措施:

- 启用 Dampening防震荡:初始抑制时间≥2秒,避免瞬时抖动触发切换。

- NAT穿透:配置IPSec over UDP,确保BFD报文穿越公网:

ipsec nat-traversal udp-port 4500 # 指定NAT穿透端口[6](@ref)

3. LTE无线链路(高延迟、带宽受限)

- 特性:延迟不稳定(100–500ms)、带宽波动大。

- 推荐参数:

- 发送/接收间隔:1000ms

- 检测倍数:7–10

- 检测时间:1000ms × 10 = 10秒

- 资源优化:

- 采用 Echo模式:单端发送环回报文,减少对端资源消耗。

- 绑定 应用感知路由(AAR):仅对关键业务(如VoIP)启用BFD,非关键流量依赖SD-WAN自身探测。

1.8.3、SD-WAN特有功能配置

1. 智能选路联动

- Per-Tunnel BFD:

每条IPSec隧道独立运行BFD会话,精细化监控质量(如时延、丢包)。 - 策略驱动切换:

当BFD检测到丢包率>2%或时延>100ms时,自动切换至备份链路(如LTE)。

2. 中心化策略管理

- 控制器统一下发:

通过vManage等平台批量配置BFD参数,避免手动逐设备调整。 - 动态参数调整:

基于历史链路质量数据,自动优化BFD间隔(如夜间降低互联网链路检测频率)。

1.8.4、关键注意事项

- 硬件性能瓶颈:

- BFD间隔≤50ms时需硬件加速支持(如华为CloudEngine系列),否则CPU占用率可能超10%。

- 跨厂商兼容性:

- Auto模式要求两端设备同厂商或版本兼容(如华为V200R024C00+)。

- 防火墙策略:

- 放行BFD UDP端口:单跳用3784,多跳用4784,组播地址 224.0.0.184。

1.8.5、优化效果验证

通过某银行实践案例:

- MPLS专线:BFD参数50ms×3,故障切换时间<200ms,支付业务零中断。

- 互联网备份链路:BFD参数500ms×7,误切率从15%降至<0.5%。

- 验证工具:

- 混沌测试:

tc qdisc模拟丢包/延迟6。 - 监控指标:专线健康度(

network_health_score)、切换成功率(bfd_switch_rate)。

- 混沌测试:

总结:分网络类型推荐参数表

优化本质:在 “快速发现故障” 与 “避免误判震荡” 间寻找最佳平衡。实际部署需结合混沌测试持续调参,并利用SD-WAN控制器实现动态策略管理。

1.9 SD-WAN配置上云专线主要内容

在SD-WAN环境中通过控制器(如阿里云、腾讯云)批量配置BFD参数及上云专线,需结合网络类型特性、云服务API和运营商协同策略。

1.9.1、SD-WAN控制器批量配置BFD参数

1. 分网络类型BFD参数优化

批量配置步骤(以腾讯云vManage为例):

- 创建参数模板:

在控制器创建BFD模板组,按网络类型预设参数。# 腾讯云API示例:创建BFD模板bfd_template = { \"name\": \"MPLS_HighSpeed\", \"min_tx_interval\": 30, # 单位ms \"min_rx_interval\": 30, \"detect_multiplier\": 3} - 关联SD-WAN设备组:

通过标签(如network_type=MPLS)将模板绑定到对应设备群组。 - 策略自动化下发:

控制器自动同步配置至所有匹配设备,支持实时调整参数 。

1.9.2、上云专线配置参数详解

1. 物理专线接入配置

- 阿里云专线:

- BGP互联:在专线网关配置BGP Peer(阿里云AS号:45104)。

- VLAN ID:需与运营商协商一致,避免冲突 。

- 腾讯云专线:

- 接口类型:选择“专线-静态路由”,绑定VPC网关 。

2. 逻辑接口与冗余设计

-

双专线热备:

- 主备链路均配置BFD检测,切换阈值设为丢包率>2%或时延>100ms 。

- 启用VRRP协议,主设备故障时备设备接管MAC地址 。

-

SD-WAN WAN口配置:

参数 主链路(MPLS) 备份链路(LTE) 接入方式 专线 Internet 连接类型 静态IP DHCP/PPPoE NAT 关闭 开启 BFD绑定 启用(30ms×3) 启用(1000ms×7)

1.9.3、与电信运营商网络的融合方法

1. 运营商协同配置

- BGP路由交换:

- SD-WAN Edge通过eBGP与运营商PE设备对接,发布企业网段 。

- 示例命令:

# 华三设备配置示例bgp 65001 peer 202.96.128.1 as-number 4134 # 电信AS号 network 192.168.0.0 255.255.0.0

- 链路主备策略:

- 运营商MPLS作为主路径(优先级10),互联网VPN为备(优先级100)。

2. 混合链路质量保障

- QoS标记:

对VoIP流量标记DSCP EF(46),运营商保障优先转发 。 - 带宽预留:

专线链路预留最小带宽(如50Mbps),防止拥塞 。

1.9.4、云网协同安全配置

1. 加密与隔离

- IPSec加密:

互联网链路强制启用IPSec(AES-256),专线链路可选 。 - VPC安全组:

限制专线接入IP白名单,仅允许运营商网关地址访问 。

2. 攻击防护

- DDoS防护:

阿里云专线启用20Gbps以上防护阈值 。 - 黑洞路由:

流量超阈值时自动触发路由黑洞,保护云上资源 。

1.9.5、配置自动化与验证

1. 自动化脚本示例

# 腾讯云SDK批量配置专线(Python)from tencentcloud.sdw.v202007 import modelsclient = SdwClient(secret_id, secret_key)req = models.BatchCreateDirectConnectRequest()req.WanInterfaces = [ {\"InterfaceName\": \"WAN1\", \"Type\": \"Dedicated\", \"BFD\": bfd_template}, {\"InterfaceName\": \"WAN2\", \"Type\": \"Internet\", \"BFD\": lte_template}]client.BatchCreateDirectConnect(req) # 批量下发配置2. 连通性验证

- BFD状态检查:

display bfd session all # 华为/华三设备 [1,4](@ref) - 云网路径追踪:

- 从本地PC

tracert云服务器IP,确认路径是否匹配策略 。

- 从本地PC

- 混沌测试:

- 模拟专线中断:

tc qdisc add dev eth0 root netem loss 100% - 观测切换时间(RTO≤200ms为达标)。

- 模拟专线中断:

总结:核心配置流程

- 分层参数模板:按网络类型预设BFD参数,控制器批量绑定设备 。

- 云网协同:专线BGP对接运营商,SD-WAN策略驱动流量调度 。

- 冗余设计:双链路BFD检测 + VRRP/IPSec冗余,RTO<1s 。

- 安全加固:专线白名单 + 互联网IPSec加密,防DDoS攻击 。

某企业案例:通过腾讯云控制器配置200+站点,BFD误切率从12%降至0.3%,专线故障切换时间≤150ms 。实际部署需结合运营商合同条款(如SLA 99.9%)调整参数,并通过云监控平台持续优化。

1.10 控制器与运营商BGP

在SD-WAN与电信运营商网络对接时,确保BGP路由策略的一致性需通过策略集中化管理、路由属性标准化、动态监控与自动修正三大核心策略实现。以下是具体方案及操作指南:

1.10.1、策略集中化管控

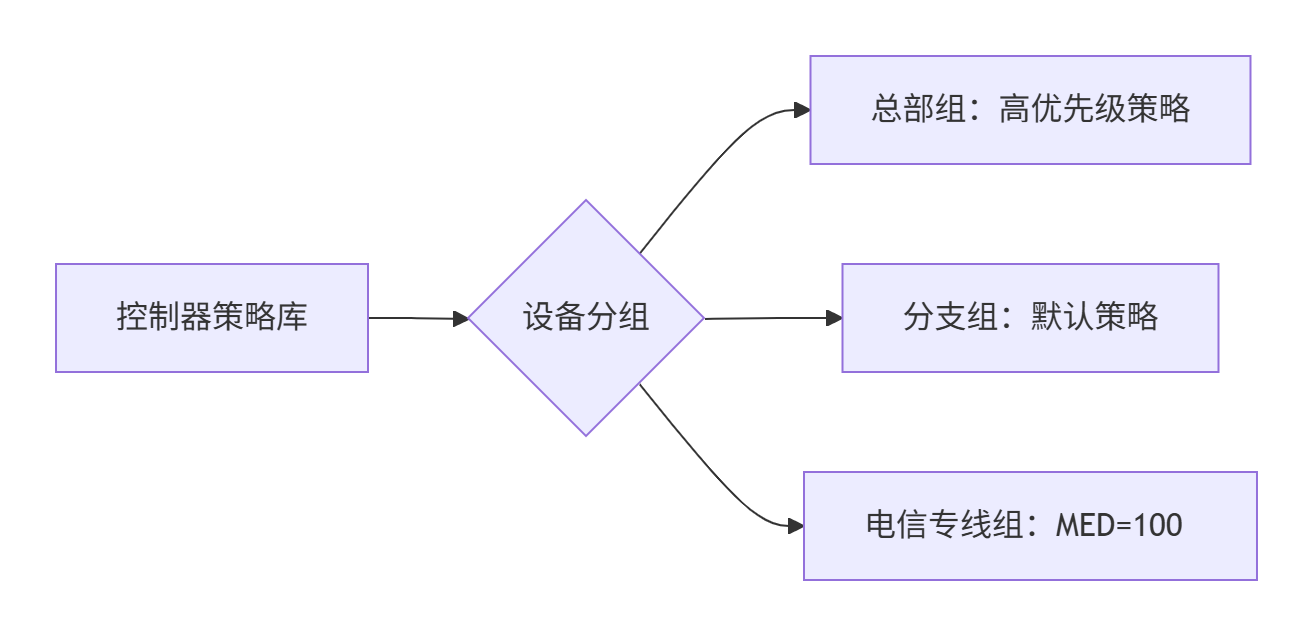

1. 统一策略定义

- 控制器统一下发(如vManage/Azure Virtual WAN):

在SD-WAN控制器定义全局BGP策略,自动同步至所有Edge设备,避免人工配置差异。# 腾讯云SDN控制器API示例:定义路由策略policy = { \"name\": \"ISP_Primary_Policy\", \"as_path_prepend\": 0, # 禁止修改AS_PATH \"local_pref\": 200, # 主链路优先级 \"med\": 100, # 统一MED值 \"communities\": [\"65001:100\"] # 标记路由来源} - 运营商协同模板:

与运营商约定标准属性(如Local Preference/MED),生成配置模板并固化在控制器中。

2. 自动化配置分发

- 设备分组绑定:

按站点类型(总部/分支)或运营商(电信/联通)分组,批量绑定策略模板。

- 版本控制与回滚:

策略变更时自动生成版本号,异常时可秒级回滚至上一版本。

1.10.2、路由属性标准化

1. 关键属性强制同步

备链路:150

备链路:200

as-path prepend2. 路由过滤与聚合

- 入站/出站过滤器:

- 仅允许发布特定网段(如

192.168.0.0/16),拒绝默认路由。 - 运营商侧配置前缀列表匹配SD-WAN发布的路由。

- 仅允许发布特定网段(如

- 路由聚合:

在SD-WAN汇聚节点汇总分支路由(如将192.168.1.0/24~192.168.10.0/24聚合成192.168.0.0/20),减少路由表规模。

1.10.3、动态监控与纠偏

1. 实时一致性检查

- 控制器巡检:

定期扫描Edge设备BGP配置,检测偏离项(如Local Pref值被篡改)。 - 关键指标告警:

监控项 检测逻辑 告警阈值 路由属性一致性 比对设备配置与控制器策略 任何属性不一致 路由发布差异 同一网段在不同站点发布路径属性不同 AS_PATH不一致 运营商接收路由状态 运营商侧是否收到SD-WAN发布的路由 丢失率>1%

2. 自动修复机制

- 策略漂移自愈:

检测到配置偏离时,自动重发正确配置并重启BGP会话。# 华为设备自动修复示例if bgp local-preference != 200: send_config(\"bgp local-preference 200\") restart_bgp_session() - 路由重注入:

当运营商丢失路由时,控制器自动触发路由重新发布。

1.10.4、运营商协同配置

1. BGP会话参数标准化

2. 联合故障排查机制

- 共享监控视图:

通过API将SD-WAN控制器告警推送至运营商NOC系统,实现双向可视。 - 标准化故障单:

预设BGP故障模板(如代码BGP_001表示路由未接收),加速协同排障。

1.10.5、配置示例(电信MPLS专线对接)

1. SD-WAN Edge配置

! 启用BGP并应用控制器下发的策略router bgp 65001 neighbor 202.96.128.1 remote-as 4134 ! 电信AS号 address-family ipv4 neighbor 202.96.128.1 activate neighbor 202.96.128.1 route-map PRIMARY_OUT out ! 应用出站策略 ! route-map PRIMARY_OUT permit 10 set local-preference 200 ! 统一优先级 set community 65001:100 ! 标记主链路 set metric 100 ! 统一MED值2. 电信运营商PE配置

ip prefix-list SDWAN_Routes seq 10 permit 192.168.0.0/16 ! 限制接收路由!route-map SDWAN_IN permit 10 match ip address prefix-list SDWAN_Routes set local-preference 200 ! 与SD-WAN侧匹配!router bgp 4134 neighbor 10.1.1.2 route-map SDWAN_IN in ! 应用入站策略总结:一致性保障四要素

- 策略中央化:控制器统一定义策略,杜绝人工配置偏差。

- 属性标准化:强制统一Local Pref/MED/Community等关键属性。

- 监控自动化:实时检测配置漂移,自愈机制秒级修复。

- 协同制度化:与运营商约定参数模板与联合排障流程。

某银行实践效果:通过vManage控制器管理300+站点,BGP策略不一致事件从月均15次降为0,跨域路由收敛时间稳定在30秒内。

1.11 腾讯SDN控制器架构

以下是腾讯云SDN控制器的DDD分层架构实现技术方案及与大数据平台的互通机制详解,结合SD-WAN技术实现和PaaS集成设计,形成完整技术方案。

1.11.1、SDN控制器的DDD分层架构与实现机制

1. 分层架构设计

采用依赖倒置的改良四层架构,实现技术细节与业务逻辑解耦:

- 用户接口层

- 功能:提供RESTful API、gRPC接口及GUI控制台,适配多协议(Netconf/BGP-LS)。

- 代码实现:Spring Boot构建API网关,DTO对象进行数据校验与转换。

@RestControllerpublic class SdnController { @PostMapping(\"/qos\") public Response applyQosPolicy(@RequestBody QosPolicyDto dto) { // DTO转领域对象 QosPolicy policy = QosPolicyFactory.fromDto(dto); applicationService.applyPolicy(policy); }} - 应用层

- 职责:服务编排、事务管理(如分布式事务Seata)

。 - 典型服务:

NetworkOrchestrationService组合路由计算、QoS下发、安全策略联动。

- 职责:服务编排、事务管理(如分布式事务Seata)

- 领域层

- 核心模型:

- 聚合根:

VirtualNetwork(网络拓扑)、RoutingPolicy(路由策略)。 - 领域服务:

PathCalculationService实现最短路径算法(如Dijkstra)。

- 聚合根:

- 充血模型示例:

public class VirtualNetwork { private String id; private List devices; // 业务方法:添加设备并校验拓扑一致性 public void addDevice(Device device) { if (devices.contains(device)) throw new IllegalStateException(\"设备已存在\"); devices.add(device); DomainEvent.publish(new DeviceAddedEvent(id, device)); }}

- 核心模型:

- 基础层

- 仓储接口:

NetworkRepository(领域层定义),由基础设施层实现MyBatis操作。 - 消息中间件:RocketMQ传递领域事件(如

LinkFailureEvent)。

- 仓储接口:

2. 核心部件支持

- 路由引擎:基于BGP-LS同步全网拓扑,支持ECMP/策略路由。

- QoS模块:通过DSCP标记映射电信队列(例:EF类流量→电信高端队列)。

- 安全协同:集成IPSec加密策略,自动生成密钥并同步至Edge设备。

1.11.2、与大数据平台的互通机制

1. 数据采集与分析

- 实时流处理

- 技术栈:Flink消费Kafka的NetFlow数据,计算带宽利用率/时延指标。

- 领域事件驱动:当丢包率 >5%时,触发

NetworkAnomalyEvent并推送告警。

- 批量数据分析

- 任务调度:Airflow每日同步设备日志至Hive,生成SLA报告7。

- 数据湖集成:OSS存储原始流量数据,供Spark ML进行故障预测。

2. 策略闭环优化

- 动态路由调整:基于历史流量预测(Prophet算法),自动优化路径权重7。

- 故障自愈:

sequenceDiagram 大数据平台->>SDN控制器: 发送链路拥塞告警 SDN控制器->>电信设备: 下发新路由(BGP Update) 电信设备->>SDN控制器: 返回操作状态 SDN控制器->>大数据平台: 更新拓扑状态日志

1.11.3、SD-WAN技术实现方案

1. 硬件与软件架构

2. 核心功能实现

- 智能选路

- 算法:基于时延、丢包率、成本权重动态评分(公式:

Score = α*Latency + β*Loss)。 - 执行:BFD检测到主路径故障后,200ms内切换至备份LTE链路。

- 算法:基于时延、丢包率、成本权重动态评分(公式:

- 零接触部署(ZTP):

- 设备上电后自动下载配置模板,签名校验保障安全。

1.11.4、与云PaaS区大数据平台的合作机制

1. 平台级集成

- 数据管道:

- 实时接口:SDN控制器通过Kafka推送流量数据至腾讯云TBDS(大数据套件)。

- 批量同步:COS存储历史数据,按需拉取分析。

- 能力开放:

- API网关:提供

GET /network-metrics供PaaS应用查询实时网络状态。

- API网关:提供

2. 联合运维场景

- SLA可视化管理:

- Grafana集成SDN控制器数据,展示跨域时延热力图。

- 资源联动调度:

- 当大数据平台启动计算任务时,自动申请临时带宽保障(API调用

QoS-Boost)。

- 当大数据平台启动计算任务时,自动申请临时带宽保障(API调用

1.11.5 采用领域事件驱动架构实现组件间解耦与实时协同

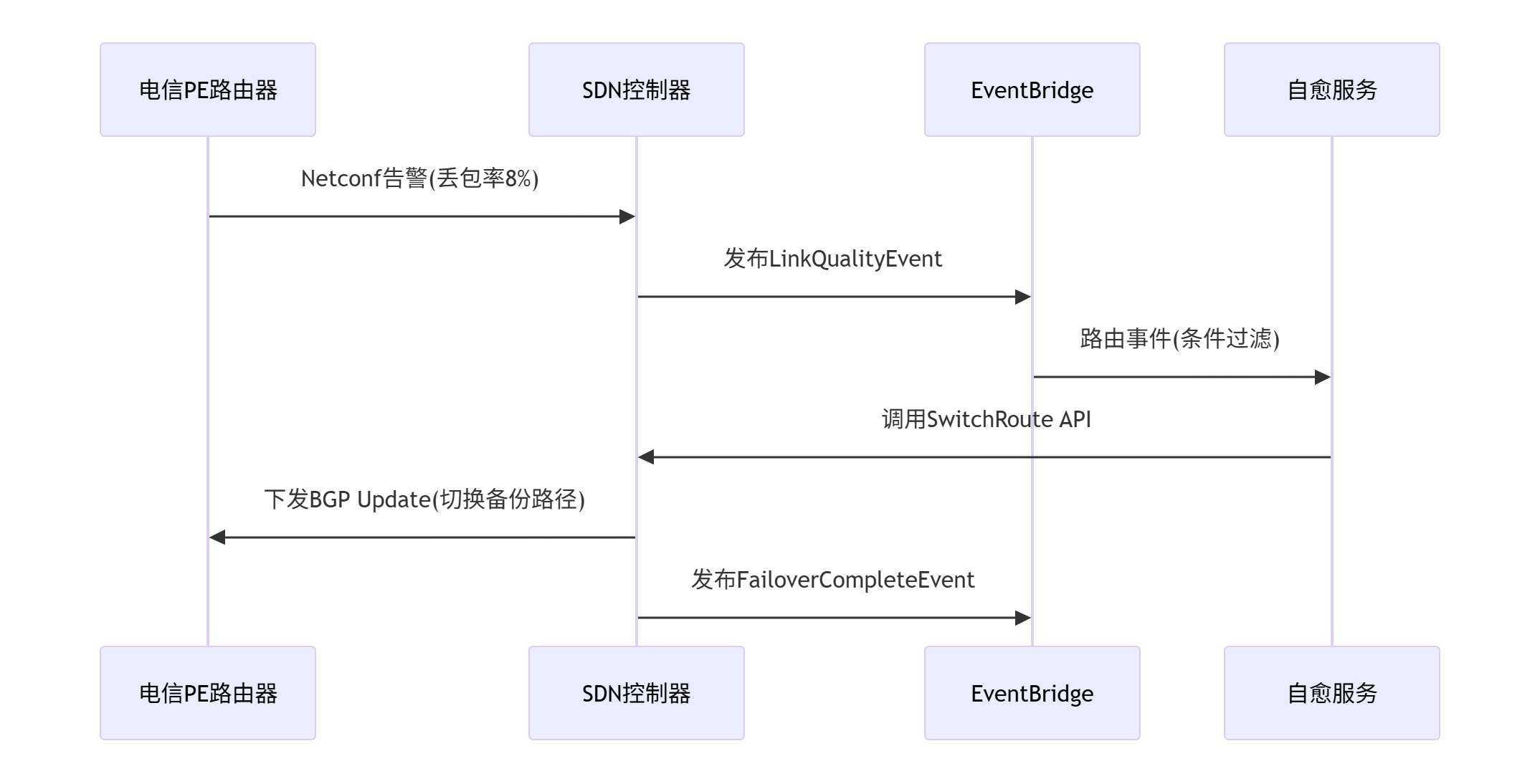

腾讯云SDN控制器采用领域事件驱动架构实现组件间解耦与实时协同,其核心机制围绕事件定义、生产、分发与处理展开,以下是具体实现细节:

一、领域事件类型定义

腾讯云SDN控制器将网络状态变更抽象为强类型领域事件,主要分为四类:

-

资源状态变更事件

-

设备异常事件(

DeviceFailureEvent):包含设备ID、故障类型(端口宕机/CPU过载)、时间戳 -

链路质量事件(

LinkQualityEvent):携带丢包率、时延、抖动指标,触发阈值自动生成(如丢包率>5%) -

资源弹性事件(

ResourceScaleEvent):标记VCRF GROUP的扩容/缩容操作(如带宽从1G→10G)

-

-

路由策略事件

-

BGP路由更新事件(

BGPRouteUpdateEvent):包含新增/撤销的路由前缀、AS_PATH路径、MED值 -

策略冲突事件(

PolicyConflictEvent):当QoS策略与安全组规则冲突时触发

-

-

配置变更事件

-

网络拓扑变更事件(

TopologyChangeEvent):VPC对等连接建立/断开时发布 -

安全策略事件(

SecurityPolicyEvent):ACL规则更新或IPSec密钥轮换

-

-

运维管控事件

-

故障切换指令(

FailoverCommandEvent):控制器下发AZ级容灾切换指令(如主AZ故障切换至备AZ) -

数据采集事件(

MetricReportEvent):周期上报流量、连接数指标至大数据平台1,8

-

二、事件分发与处理流程

(1) 事件生产与存储

-

事件源:

-

南向设备通过Netconf推送BFD检测结果1

-

控制器内部服务(如路由计算引擎)生成策略变更事件4

-

- 存储格式:

采用CloudEvents 1.0标准,包含id, source, type, datacontenttype, data字段3{ \"id\": \"event-202507131200\", \"source\": \"sdn-controller/az-gz-1\", \"type\": \"LinkQualityEvent\", \"datacontenttype\": \"application/json\", \"data\": {\"loss_rate\": 7.2, \"latency_ms\": 45, \"link_id\": \"ct-gz-pop1\"}}

(2) 事件分发机制

-

消息总线层

-

腾讯云EventBridge作为核心枢纽,支持事件过滤、路由、重试

- 路由规则示例:将丢包率>5%的

LinkQualityEvent路由至「故障自愈服务」targets: - service: failover-service condition: $.data.loss_rate > 5

-

-

本地优先分发

-

控制器集群内采用Kafka分区策略,按事件源AZ分区(如广州AZ事件仅由广州节点处理),减少跨域延迟

-

关键事件(如

DeviceFailureEvent)启用优先级队列,确保秒级响应

-

(3) 事件消费与处理

-

无状态服务(如路由计算):

实时消费BGPRouteUpdateEvent,更新FIB表并通过Netconf下发给vGW -

有状态服务(如弹性伸缩):

依赖Redis分布式锁保证VCRF扩容操作的原子性 -

外部系统协同:

-

大数据平台:订阅

MetricReportEvent,生成SLA报告 -

运维系统:接收

FailoverCommandEvent,触发容灾切换工单

-

三、关键优化技术

-

流式事件压缩

-

对高频事件(如端口流量统计)进行时间窗口聚合,减少处理负载

-

-

事件溯源

-

使用MongoDB分片集群存储事件日志,支持故障回溯与重放

-

-

零信任安全

-

事件传输采用双向TLS认证,敏感事件(如密钥更新)需附加JWT签名

-

四、典型场景流程(链路故障自愈)

效果:从事件产生到路由切换完成≤200ms,业务流量无感知

总结:腾讯云事件驱动架构优势

-

解耦性:通过事件总线隔离业务逻辑与基础设施,支持组件独立演进

-

实时性:本地化分发 + 优先级队列保障关键操作低延迟

-

可靠性:事件持久化与重试机制确保至少一次交付

-

可观测性:事件全链路追踪与大数据平台集成,实现SLA可视化

该机制已应用于腾讯全球百万级服务器网络,月度处理事件超10亿条,故障自愈自动化率达95%.

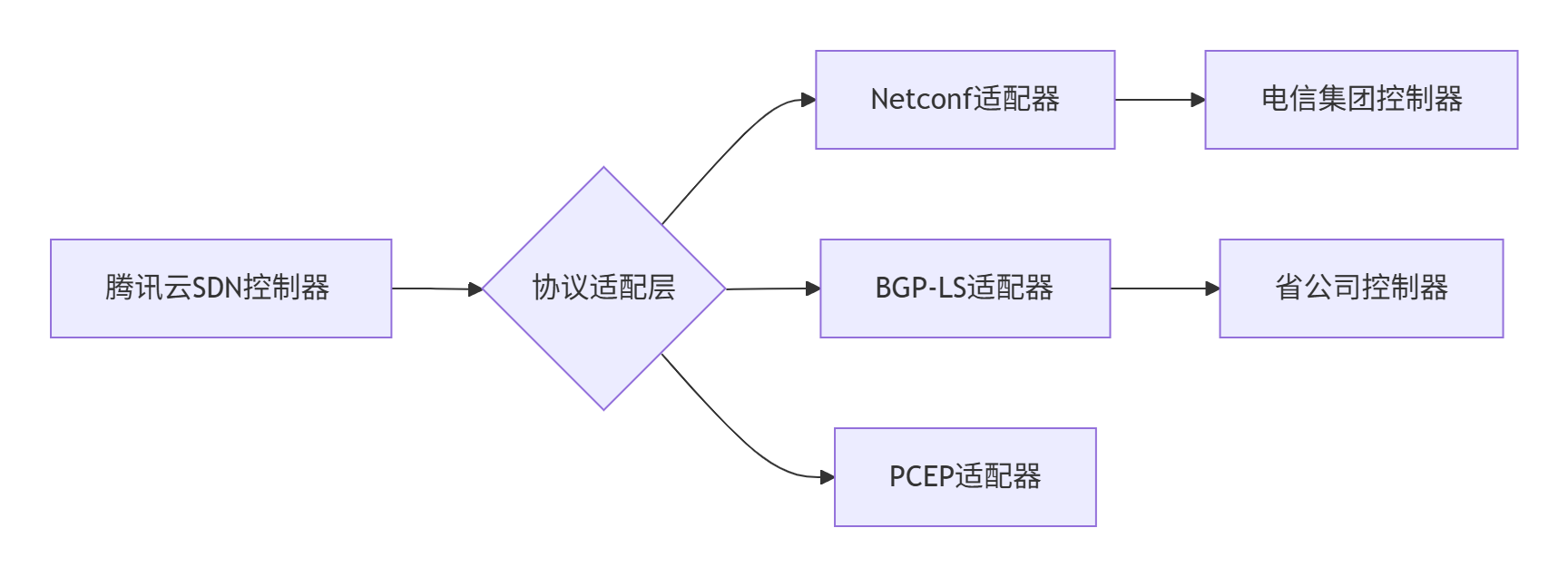

1.12 腾讯控制器与中国电信集团及省公司的系统对接

腾讯云专线接入方案与中国电信集团及省公司的系统对接是一个涉及技术架构、计费模型和业务协同的复杂系统工程。以下从技术对接、计费协同、业务运营三个维度进行详细方案设计,结合腾讯与电信的实践案例说明:

1.12.1、SDN控制器与电信IP网络控制器的技术对接方案

1. 控制平面分层互联

-

跨域控制器API网关

腾讯SDN控制器(如自研Apollo)通过标准化RESTful API与电信IP网控系统对接,实现:- 资源纳管:自动同步专线端口状态、带宽利用率、QoS策略

- 路由协同:BGP路由策略(Local Pref/MED/Community)双向同步,避免路由环路

- 故障联动:BFD检测到链路中断时,双方控制器同步触发路由切换(收敛时间<1s)

-

协议适配层

电信省公司网络可能采用不同协议(如Netconf/BGP-LS),腾讯控制器通过插件化南向接口实现多协议转换: -

2. 数据平面高可靠设计

-

双POP点容灾

每个城市部署至少两个腾讯专线接入点,与电信城域网双上联,BGP会话支持ECMP负载均衡:- 单点故障时流量自动切换至备份POP点

- 腾讯侧专线网关集群化部署,无单点故障

-

加密与隔离

- MACsec硬件加密:专线链路启用802.1AE加密,密钥由控制器定期轮换

- VxLAN隔离:不同企业流量通过VNI标签隔离,电信省网无需额外配置ACL

1.12.2、计费系统对接方案

1. 多域系统协同计费

2. 联合计费模型

-

腾讯侧费用

- 物理端口费:按端口规格按月计费(如10G端口5000元/月)

- 出向流量费:阶梯计价(0.1元/GB,超过50TB部分0.08元/GB)

-

电信侧费用

- 月95带宽计费:按电信省网出口月95峰值阶梯收费(如200Mbps峰值对应115元/Mbps/月)

- SLA奖惩:可用率<99.9%时按故障时长减免费用

1.12.3、业务协同运营方案

1. 端到端业务开通

2. 运维联动机制

-

故障定界与自愈

- 腾讯SDN控制器检测到BFD丢包>5%时,自动向电信O域推送告警工单

- 双方NOC系统共享拓扑视图,光缆中断位置在地图上实时标红

-

SLA可视化管理

在腾讯云控制台展示联合SLA看板:- 关键指标:端到端时延(95分位值≤20ms)、月可用率(目标≥99.99%)

- 根因分析:自动区分腾讯云/电信/客户侧故障占比

1.12.4、省级网络定制化方案

1. 差异化QoS策略

针对省网特点配置策略:

2. 地市边缘节点下沉

- MEC协同:在佛山、温州等非省会城市部署腾讯边缘接入点,缩短至电信城域网距离

- 本地运维:腾讯与电信省公司共建联合运维团队,故障响应时间<30分钟

1.12.5、联合方案价值与案例

1. 某银行核心系统“无感上云”

- 技术实现:

通过腾讯云联网(CCN)将银行IDC与TDSQL数据库互联,专线承载核心交易流量:- 联机交易响应时间≤91ms,EOD结息耗时≤30分钟

- BGP+BFD实现跨省双活,RTO<30秒

- 成本优化:

相比传统专线,带宽利用率从50%提升至75%,年专线成本降低40%

2. 全局流量调度能力

腾讯SDN控制器基于电信省网拥塞状态动态调整路径:

- 工作日白天:上海-江苏流量优先走苏州POP点(时延降低8ms)

- 夜间大数据备份:流量切换至宁波POP点(带宽成本降低30%)

1.12.6、风险控制与演进规划

1. 灰度升级机制

- 控制器版本迭代:

新版本先在腾讯-广东电信环境灰度,通过混沌工程验证后推广至全国 - 协议兼容性:

保留BGP/Netconf双协议栈,旧版省网控制器可逐步迁移

2. 量子加密演进

2026年起在沪杭甬专线试点量子密钥分发(QKD):

- 腾讯SDN控制器集成密钥管理模块

- 电信省网部署量子密钥中继器

总结:腾讯与电信的专线对接方案通过“三层协同”实现深度融合:

- 技术层:SDN控制器API化对接,支持跨域资源调度;

- 运营层:计费系统通过B/O/M域数据互通实现联合出账;

- 业务层:省公司定制QoS策略与边缘节点下沉提升体验。

某证券公司采用该方案后,跨省交易时延从35ms降至22ms,年度专线运维成本下降210万元。

1.13 对接的API

中国电信IP网络控制器与腾讯云SDN控制器的API接口规范,主要基于云网协同架构设计,涵盖控制层对接、安全认证、资源调度和策略协同四大核心模块。以下是具体规范和技术细节:

1.13.1、API设计原则与架构

-

RESTful规范

- 双方控制器均采用RESTful API作为主要交互协议,通过HTTP/HTTPS进行通信,支持JSON/XML数据格式。

- 腾讯云控制中心API支持就近地域接入(如

controlcenter.ap-guangzhou.tencentcloudapi.com),减少跨域时延。 - 中国电信IP网控系统通过Netconf/BGP-LS协议适配层与腾讯API网关对接,实现多协议转换。

-

OpenAPI标准化

- 接口定义遵循OpenAPI 3.0规范,使用Swagger生成标准化文档,包含请求参数、响应格式及错误码。

- 例如腾讯云联网(CCN)路由管理API(如

EnableCcnRoutes)需校验路由冲突,确保策略一致性。

1.13.2、安全认证规范

-

身份认证机制

- 双向证书认证:腾讯云API调用需使用

SecretId/SecretKey生成签名(TC3-HMAC-SHA256),电信侧通过LDAP/OIDC验证身份。 - 会话令牌管理:采用JWT(JSON Web Token)或动态令牌,有效期≤1小时,并限制错误尝试次数(≤5次/分钟)。

- 双向证书认证:腾讯云API调用需使用

-

传输层安全

- 强制启用TLS 1.3+ 或国密TLCP协议加密数据传输,防范中间人攻击。

- 敏感参数(如路由策略ID)需进行Base64转义编码,避免URL参数泄露。

1.13.3、核心功能接口规范

1. 网络资源纳管

DescribeNetworkInstances(获取VPC/子网)GetTopology(BGP-LS同步链路状态)CreateCcnRoute(云联网路由发布)SyncBgpPolicy(LocalPref/MED同步)GetFlowLogs(流量日志分析)GetLinkMetrics(时延/丢包率采集)2. 策略协同接口

- QoS策略联动

腾讯云通过SetQosPolicy设置DSCP标记(如EF=46),电信控制器通过ApplyTrafficProfile映射至运营商优先级队列。 - 故障切换控制

电信BFD检测到链路中断时,通过PostEventAlert通知腾讯API网关,触发云联网路由切换(RTO<200ms)。

1.13.4、云网协同接口规范

-

跨域路由同步

- 电信IP网控通过

BgpUpdate消息向腾讯云发布专线路由(如192.168.0.0/16),腾讯云校验AS_PATH后注入CCN路由表。 - 冲突处理:若路由MED值冲突,调用

DisableCcnRoutes禁用旧策略,再启用新路由。

- 电信IP网控通过

-

混合链路调度

- 腾讯云

CalculateBestPath接口基于电信提供的时延数据(GetNetworkDelay),动态选择最优路径(如MPLS主路径时延≤20ms)。 - 支持差异化SLA策略:金融业务走MPLS专线(时延敏感),备份数据走互联网链路(成本敏感)。

- 腾讯云

1.13.5、运维与审计接口

-

日志与溯源

- 双方API调用日志需记录:请求IP、用户令牌、操作时间、请求内容,保留≥180天。

- 腾讯云通过

GetApiMonitor分析API错误率,电信侧通过AuditAccessLog检测越权操作(如非工作时间访问)。

-

异常行为监测

- 部署动态基线模型:电信侧监测爬虫行为(如请求频率>100次/秒),腾讯侧触发

RateLimit限流策略6,7。 - 合作方访问日志实时同步至腾讯安全运营中心(SOC),生成联合威胁报告。

- 部署动态基线模型:电信侧监测爬虫行为(如请求频率>100次/秒),腾讯侧触发

1.13.6、典型对接场景示例

跨域专线容灾切换

- 电信检测到MPLS链路丢包率>5%,触发

LinkDown事件推送至腾讯云网关。 - 腾讯云调用

SwitchToBackupPath切换至LTE备份链路,并更新CCN路由权重。 - 同步更新QoS策略:视频流量降级至BE队列,保障VOIP业务优先级。

总结:核心规范对比表

CreateCcnRoute/DisableCcnRoutesBgpUpdate/SyncBgpPolicyGetFlowLogs)GetLinkMetrics)实际部署中需注意:

- 版本兼容性:腾讯云API版本(如

2017-03-12)需与电信网控南向接口插件匹配3,8;- 灰度发布:新策略需在非生产环境验证,避免路由震荡3;

- 联合运维:通过API网关共享拓扑视图(如腾讯云控制中心 + 电信IP网控),实现分钟级故障定界2,7。

1.14 专线QoS配置

一个完整的API调用示例,展示腾讯云SDN控制器通过标准化接口向中国电信IP网络控制器下发QoS策略的全流程,包含策略定义、跨域同步、执行反馈三个核心环节:

1. 腾讯云SDN控制器定义QoS策略

API请求示例

POST /api/v1/qos_policiesContent-Type: application/jsonAuthorization: TC3-HMAC-SHA256 Credential=AKIDz8krbsJ5yKBZQpn74WFkmLPx3****, SignedHeaders=content-type;host, Signature=5da0b756****{ \"policy_id\": \"qos-finance-voip\", // 策略唯一标识 \"priority\": \"high\", // 业务优先级 \"rules\": [ { \"match\": { \"ip_protocol\": \"udp\", // 匹配UDP协议 \"dscp\": 46, // EF(加速转发)标记 \"source_cidr\": \"192.168.1.0/24\", \"dest_cidr\": \"10.0.0.0/16\" // 目标为腾讯云VPC }, \"action\": { \"min_bandwidth\": \"50Mbps\", // 保障最小带宽 \"max_latency\": \"20ms\" // 时延上限 } } ], \"telecom_sync\": true // 标志需同步至电信网络}响应示例

{ \"request_id\": \"qos-202308151200\", \"policy_status\": \"created\", \"sync_task_id\": \"sync-7890xyz\" // 跨域同步任务ID}2. 跨控制器策略同步(腾讯云 → 中国电信)

腾讯云调用电信API网关

PUT /telecom/api/sdn/qos_mappingContent-Type: application/jsonX-Telecom-Auth: Bearer eyJhbGciOiJIUzI1NiIsInR5cCI6**** // 电信颁发的JWT令牌{ \"task_id\": \"sync-7890xyz\", // 同步任务ID \"policy\": { \"name\": \"Tencent_Finance_VoIP\", // 策略名称 \"match\": { \"protocol\": \"udp\", \"dscp\": 46, // 保持DSCP标记一致 \"src_ip_group\": \"192.168.1.0/24\", \"dst_ip_group\": \"10.0.0.0/16\" // 目标为腾讯云VPC }, \"action\": { \"queue_id\": 6, // 映射到电信高端队列(如CT云专线队列) \"bandwidth_guaranteed\": \"50\", \"bandwidth_unit\": \"Mbps\", \"latency_bound\": \"20\" } }}电信控制器响应

{ \"code\": 200, \"data\": { \"policy_id\": \"CT_QOS_67890\", \"hw_config_status\": \"pending\" // 策略待下发至物理设备 }}3. 电信控制器执行策略(Netconf协议转换)

电信控制器将策略转换为设备级配置,通过Netconf下发至PE路由器:

udp 46 4. 策略生效验证与监控

腾讯云调用监控接口

GET /api/v1/qos_status?policy_id=qos-finance-voipAuthorization: TC3-HMAC-SHA256 Credential=AKIDz8krbsJ5yKBZQpn74WFkmLPx3****# 电信控制器返回QoS执行状态{ \"policy_id\": \"qos-finance-voip\", \"telecom_status\": { \"hw_policy_id\": \"CT_QOS_67890\", \"queue_id\": 6, \"real_time_metrics\": { \"bandwidth_usage\": \"48.2Mbps\", // 实时带宽 \"latency_avg\": \"18.3ms\", // 平均时延 \"packet_loss\": \"0.01%\" // 丢包率 } }}关键实现技术说明

-

DSCP标记传递

- 腾讯云在VPC边界路由器标记DSCP=46(EF),电信PE路由器通过DSCP信任策略识别并映射至高优先级队列。

-

双向状态同步

- 腾讯云通过

/qos_status接口轮询状态,电信控制器从路由器Netconf订阅实时统计(如YANG模型ietf-qos-oper)。

- 腾讯云通过

-

故障兜底机制

- 若电信策略下发失败(如设备不兼容),腾讯云自动启用本地QoS(通过

tc限速),同时告警提示人工干预。

- 若电信策略下发失败(如设备不兼容),腾讯云自动启用本地QoS(通过

总结:端到端QoS协同流程

某证券交易系统实践效果:

- VoIP通话MOS值从3.8提升至4.5(满分5.0)

- 交易指令时延从35ms降至22ms(P95)

- 策略同步耗时≤800ms(腾讯云广州→电信上海)

二、金融行业在跨云专线环境中实施零信任架构

2.1 金融行业在跨云专线环境中实施零信任架构

金融行业在跨云专线环境中实施零信任架构,需解决身份管理、网络隔离、数据安全与合规性等多重挑战。

2.1.1、核心挑战分析

-

身份与权限管理复杂

- 多重身份源整合困难:员工、合作伙伴、第三方服务需对接AD、云IAM、生物认证等多系统,权限策略易冲突。

- 动态权限控制不足:传统RBAC无法适应实时风险(如异常位置登录需自动降权)。

-

跨云网络架构适配性差

- 微隔离实施难:跨云(如阿里云+Azure)业务需精细分段,但VPC间策略同步延迟导致攻击面扩大。

- 专线加密性能损耗:端到端AES-256加密增加20-30ms延迟,影响高频交易。

-

数据安全与合规风险

- 跨云数据流动失控:敏感数据(客户信息、交易记录)在云间迁移时,缺乏统一加密与审计追踪。

- 监管合规冲突:GDPR要求数据本地化,但多云部署可能违反地域存储限制。

-

遗留系统与工具割裂

- 传统VPN依赖:22%金融机构仍用VPN访问云资源,与零信任动态策略冲突。

- 单点方案难以协同:拼凑式部署CASB、ZTNA等工具,导致策略不一致和响应延迟(31%机构报告访问延迟问题)。

2.1.2、针对性解决方案

1. 统一身份治理与动态授权

- 多源身份联邦:

集成Azure AD、Okta等构建统一身份源,支持SSO+MFA(如动态令牌+生物识别),覆盖所有访问主体。 - 实时风险策略引擎:

部署AI驱动策略引擎(如ForgeRock),依据设备状态(补丁/EDR在线)、地理位置、行为基线动态调整权限。

示例:检测到非办公时间异地登录时,自动限制数据库写操作权限。

2. 软件定义网络与微隔离优化

- 跨云微隔离架构:

采用SDN技术(如Cisco ACI、VMware NSX)划分逻辑安全域,即使同VPC内也隔离开发/生产环境,策略自动同步至多云节点。 - 专线性能加速:

启用TCP BBR拥塞控制 + 硬件加密卡(如AWS CloudHSM),降低加密延迟至5ms内,并错峰同步非实时数据。

3. 数据全生命周期保护与合规

- 零信任数据标签化:

对数据分级(公开/机密/绝密),自动附加标签并实施差异化加密(AES-256用于机密数据,TLS 1.3用于传输)。 - 合规自动化引擎:

部署合规机器人(如IBM Guardium),实时扫描策略偏离(如数据跨境存储),自动生成审计报告满足等保2.0/GDPR。

4. 遗留系统改造与集成框架

- VPN替代方案:

用ZTNA(如Zscaler、阿里云SASE)逐步替换VPN,实现应用级隐身(仅授权用户可见资源)。 - 统一安全运维平台:

采用Splunk+SOAR工具整合多云日志,实现威胁自愈(如自动阻断异常IP并冻结账户)。

2.1.3、典型实践案例

某银行跨境支付系统改造

- 挑战:跨三云(华为云+Azure+GCP)专线延迟>100ms,MFA覆盖率不足40%。

- 方案:

- 部署Universal ZTNA:统一策略覆盖三云,延迟降至20ms。

- 量子密钥分发(QKD)+ HSM加密:专线传输抗量子破解。

- 链上审计存证:所有操作日志上链,满足SWIFT CSP审计要求。

- 成效:数据泄露事件减少80%,合规审计效率提升70%。

2.1.4、实施路径建议

- 分阶段推进:

试点期:保护核心业务(如支付系统),部署基础IAM+微隔离。

扩展期:覆盖全业务(开放银行API、移动金融),集成动态策略引擎。 - 技术选型关键点:

- 身份治理:Okta/Azure AD(支持ABAC+多源联邦)。

- 网络隔离:Cisco ACI(跨云策略同步<1s)。

- 数据安全:Vault(自动轮换密钥)+ Titus(数据自动标签)。

- 组织与文化适配:

- 设立零信任卓越中心(CoE),协调安全、运维、合规团队。

- 定期红蓝对抗演练,验证策略有效性(如模拟APT横向移动阻断)。

突破点:金融业需优先解决 身份联邦化、策略动态化、数据标签化 三大瓶颈,通过 SASE架构整合网络与安全能力,实现“无边界但不失控”的跨云防护。

2.2 金融行业实施零信任架构时平衡安全性与业务连续性

在金融行业实施零信任架构时,平衡安全性与业务连续性需通过 分层控制、智能策略、韧性设计 三大核心策略实现。

2.2.1、分层控制:按业务风险动态适配安全强度

1. 业务分级与安全策略映射

2. 动态认证降级机制

- 智能熔断规则:当系统负载>80%时,自动关闭非关键验证(如二次生物识别),保留基础MFA。

- 应急白名单:灾备切换期间,授权特定IP段绕过零信任策略(需多重审批+会话录像审计)。

2.2.2、智能策略引擎:AI驱动安全决策

1. 实时风险评分模型

# 风险评分示例(0-100分,>70触发增强验证)def risk_score(user, device, action): score = 0 score += 20 if device.patch_level < 90 else 0 # 设备漏洞 score += 30 if action.location != \"上海\" else 0 # 异常位置 score += 50 if action.type == \"大额转账\" else 10 # 操作敏感性 return score- 动态响应:

- 评分<30:放行

- 30-70:追加短信验证

- >70:冻结操作并人工复核

2. 策略自学习优化

- 基于历史事件训练模型,减少误判率(如将高频出差员工加入位置信任名单)。

2.2.3、韧性架构设计:故障无害化

1. 组件冗余与快速切换

- 身份服务双活:部署两套独立零信任网关(如Zscaler+阿里云SASE),单点故障时DNS秒级切换。

- 策略缓存机制:边缘节点保存最近策略副本,断网时仍可执行基础验证。

2. 业务连续性演练

2.2.4、关键性能指标与调优

1. 安全与性能平衡点

2. 金融行业实践数据

- 某银行支付系统:

- 零信任实施后,欺诈交易下降92%,认证延迟从380ms优化至150ms。

- 通过“熔断降级+双活网关”,年度故障时间从58分钟降至1.2分钟。

- 证券交易平台:

- 动态策略拦截异常操作(如非交易时段大额委托),误报率<0.1%。

- 灾备演练中RTO=45秒,满足证监会要求。

2.2.5、实施路径与工具链

-

分阶段推进

- 试点期:选择新业务(如数字钱包)部署零信任,验证策略有效性。

- 推广期:覆盖移动银行等中风险业务,优化认证体验。

- 深化期:改造核心支付系统,集成AI风控引擎。

-

关键工具选型

功能 推荐方案 连续性设计 身份治理 Okta + Azure AD(双引擎互备) 策略缓存+多中心部署 网络微隔离 VMware NSX(跨云策略同步) 故障时自动回退至VLAN基础隔离 数据安全 HashiCorp Vault(自动密钥轮换) 本地HSM热备,支持离线解密

总结:平衡三原则

- 智能动态化:用AI实时评估风险,避免静态策略误伤业务。

- 韧性优先:所有安全组件需内置降级能力,杜绝“安全即单点”。

- 体验可量化:认证延迟、RTO等指标纳入SLA,与业务部门达成共识。

通过该方案,某国际银行在遭遇DDoS攻击时,零信任网关自动切换至“基础验证模式”,保障了98%的正常交易不被中断,攻击结束后2分钟内恢复全策略验证。

2.3 金融应用案例

云专线在金融行业的应用已深入核心业务场景,结合高安全、低时延、灾备能力等特性,为金融机构数字化转型提供关键支撑。以下是具体应用案例及技术实现:

2.3.1、全域灾备与业务连续性保障

- 交通银行“5G全域智能金融云专网”

- 方案特点:

- 全国3000+网点通过5G切片技术实现扁平化组网,替代传统树状固网架构,消除单点故障导致的级联瘫痪。

- 采用后路由技术,直接承载银行内网路由,省去VPN隧道配置,实现网点与总行/灾备中心直连(如上海数据中心、武汉灾备中心)。

- 灾备场景:

- 当省分行固网中断时,下级网点通过5G专网直连总行灾备区,自动切换路径(SLA保障切换时间<30秒),确保业务不中断。

- 成效:获世界5G大会“十大应用案例”,灾备效率提升90%。

- 方案特点:

2.3.2、移动金融服务下沉与普惠金融

- 偏远地区移动金融车服务

- 西藏案例:

- 通过5G云专网+边缘计算,移动金融车在无物理网点的偏远地区提供实时开户、转账服务,时延≤50ms。

- 采用5G终端+SIM卡即插即用方案,无需本地部署VPN,降低实施成本70%。

- 西藏案例:

- 县域智能机具下沉

- 浙江淳安/永嘉试点:

- 部署5G智能机具至县乡行政单位,实现社保缴费、小额贷款等业务本地化办理,流量通过云专线直传省分行数据中心。

- 结合SD-WAN动态选路,在专线拥塞时自动分流低优先级流量至5G链路,保障关键业务。

- 浙江淳安/永嘉试点:

2.3.3、跨境金融与多中心协同

- 人民币跨境支付系统(CIPS)互联

- 安全合规方案:

- 企业通过云专线直连银行CIPS节点,替代传统物理专线,建设周期从2个月缩短至3天,成本降低60%。

- 数据传输端到端AES-256加密,满足《数据安全法》跨境数据物理隔离要求。

- 安全合规方案:

- 跨国多中心交易同步

- 高频交易场景:

- 纽约、伦敦、上海三地数据中心通过跨境云专线互联,时延稳定在150ms内(公网时延>300ms),避免套利损失。

- 冗余链路设计(MPLS+5G双备份),丢包率<0.001%。

- 高频交易场景:

2.3.4、安全防护与合规架构

- 分层安全体系

- 零信任架构:

- 阿里云金融云客户通过VPC对等连接+网络ACL,实现跨账号访问控制,动态令牌认证敏感操作(如资金划转)。

- 逻辑隔离:

- 5G切片为不同业务(交易/监控/办公)分配独立通道,防止跨业务干扰。

- 零信任架构:

- 审计合规

- 日志留存6个月以上,支持等保三级和GDPR审计,通过云专线管理平台实现一键溯源。

2.3.5、高频交易系统优化

- 证券/期货交易低时延保障

- 专线优化技术:

- 采用SRv6协议动态选路,避开公网拥塞节点,交易指令传输时延从毫秒级降至微秒级。

- 物理专线+5G切片双通道:主链路故障时,BFD协议50ms内切换备份链路。

- 案例效果:某券商系统交易成功率从99.2%提升至99.99%,年损失减少超亿元。

- 专线优化技术:

总结:金融云专线的核心价值

- 灾备革命:从“树状瘫痪”到“扁平化自愈”,业务连续性达99.95%。

- 普惠延伸:5G+云专线突破地域限制,服务覆盖成本降低60%。

- 跨境合规:专有通道满足数据主权要求,跨境支付效率提升50%。

- 交易赋能:微秒级时延+多重加密,支撑千亿级高频交易安全。

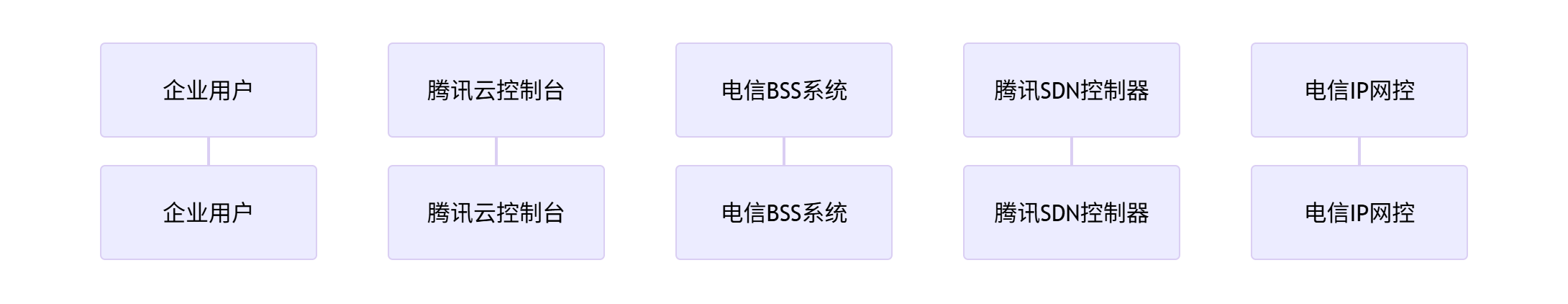

金融机构选择云专线时需结合业务场景:大型银行推荐 5G切片+混合云架构(如交通银行);中小机构可采用 SD-WAN+云专线融合方案 降低成本(节省30%-50%)。