大模型可视化终极指南:Open WebUI全解析,一文掌握核心技巧!_openwebui

Open WebUI 是一款专为大模型设计的开源可视化交互工具,它通过类 ChatGPT 的直观界面,让用户无需代码即可管理、调试和调用本地或云端的大语言模型(LLMs)。

Open WebUI 通过可视化交互与大模型技术结合,成为私有化部署的标杆工具。其开箱即用的特性适合开发者快速验证模型、企业构建合规 AI 平台及个人用户探索 AI 应用。随着插件生态的扩展(如视频生成、语音交互),未来可进一步降低多模态应用的开发门槛。

一、Open WebUI

什么是Open WebUI?Open WebUI 是一个开源的、可扩展且用户友好的自托管 AI 平台,专为生成式人工智能模型交互而设计。

Open WebUI 旨在为用户提供一个简单易用、功能强大且高度定制化的界面,使其能够轻松与各种 AI 模型(如文本生成、图像生成、语音识别等)进行交互。

-

直观交互体验:提供类似 ChatGPT 的自然语言对话界面,支持Markdown 格式渲染(如加粗、列表、代码块等)和代码高亮显示,提升内容可读性。

-

多轮对话管理:内置对话历史记录功能,用户可随时回顾上下文,避免重复输入,确保对话连贯性。

-

全平台兼容性:采用响应式设计,无论是桌面端还是移动端,界面均能自适应屏幕尺寸,提供一致的使用体验。

-

低门槛操作:通过简化交互流程和优化视觉设计,大幅降低非技术用户的使用难度,真正实现“零学习成本”上手。

Open WebUI + vLLM如何实现DeepSeek本地部署并可视化?在本地部署 DeepSeek 模型并结合 Open WebUI 和 vLLM 实现可视化,可通过以下步骤完成。

1. 下载 DeepSeek 模型

从 HuggingFace 下载模型文件

git lfs installgit clone https://huggingface.co/deepseek-ai/DeepSeek-7B

2. 安装 vLLM

使用 vLLM 加速推理

pip install \"vllm>=0.4.2\" --extra-index-url https://download.pytorch.org/whl/cu1183. 安装 Open WebUI

通过 Docker 快速部署

docker pull ghcr.io/open-webui/open-webui:main4. 启动 vLLM 服务

加载 DeepSeek 模型并启动 API 服务

python -m vllm.entrypoints.openai.api_server \\--model /path/to/DeepSeek-7B-Chat \\--trust-remote-code \\--tensor-parallel-size 1 \\--max-model-len 4096 \\--port 8000

5. 启动 Open WebUI

配置 Docker 容器并连接 vLLM

docker run -d \\-p 3000:8080 \\-e OLLAMA_API_BASE_URL=http://host.docker.internal:8000/v1 \\-e WEBUI_SECRET_KEY=your_secret_key \\-v open-webui:/app/backend/data \\--name open-webui \\ghcr.io/open-webui/open-webui:main

二、OpenAI API

OpenAI API 如何接入大语言模型?OpenAI API 是 OpenAI 提供的一组编程接口,允许开发者通过代码调用其先进的大语言模型。

# Please install OpenAI SDK first: `pip3 install openai`from openai import OpenAIclient = OpenAI(api_key=\"\", base_url=\"https://api.deepseek.com\")response = client.chat.completions.create(model=\"deepseek-chat\",messages=[{\"role\": \"system\", \"content\": \"You are a helpful assistant\"},{\"role\": \"user\", \"content\": \"Hello\"},],stream=False)print(response.choices[0].message.content)

Open WebUI 如何接入大语言模型?Open WebUI 支持通过 OpenAI API 兼容接口 接入多种大语言模型(LLM)。

-

本地部署的模型(如 vLLM、Transformers 运行的模型)

-

云端 API 服务(如 OpenAI GPT-4、DeepSeek API、Anthropic Claude 等)

1. 接入本地部署的模型

vLLM 提供高性能推理,并兼容 OpenAI API 格式。

pip install vllmvllm serve deepseek-r1 --port 8000

2. 通过 Transformers 部署

适用于 Hugging Face 模型(需自行封装 API),启动服务后,在 Open WebUI 填写对应的 API 地址即可。

from transformers import AutoModelForCausalLM, AutoTokenizerfrom fastapi import FastAPIapp = FastAPI()model = AutoModelForCausalLM.from_pretrained(\"deepseek-r1\")tokenizer = AutoTokenizer.from_pretrained(\"deepseek-r1\")@app.post(\"/v1/chat/completions\")async def generate(request: dict):response = model.generate(**request)return {\"choices\": [{\"message\": {\"content\": response}}]}

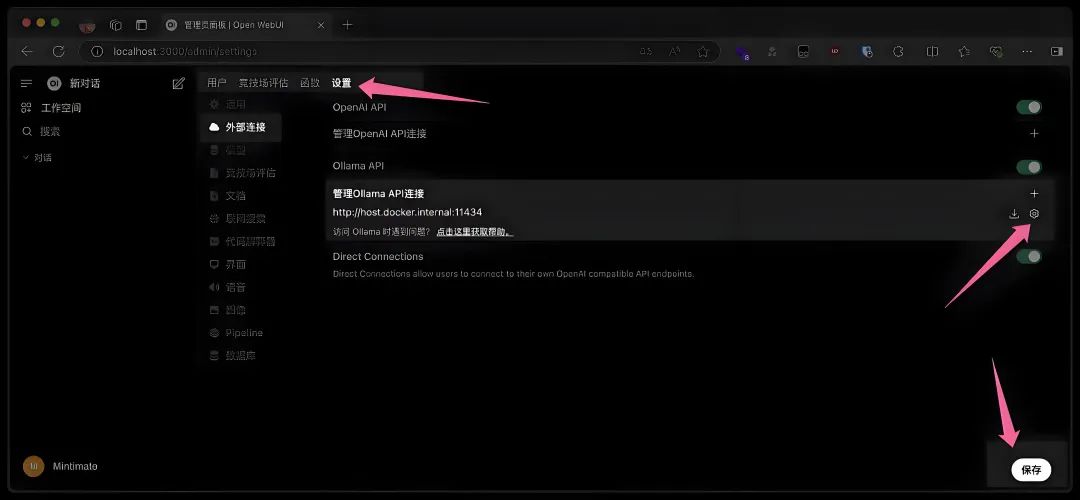

3. 在 Open WebUI 中配置

进入 设置 > 模型,填写 API 地址:http://localhost:8000/v1,选择模型名称(如 deepseek-r1)

大模型&AI产品经理如何学习

求大家的点赞和收藏,我花2万买的大模型学习资料免费共享给你们,来看看有哪些东西。

1.学习路线图

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

2.视频教程

网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己整理的大模型视频教程,上面路线图的每一个知识点,我都有配套的视频讲解。

(都打包成一块的了,不能一一展开,总共300多集)

因篇幅有限,仅展示部分资料,需要点击下方图片前往获取

3.技术文档和电子书

这里主要整理了大模型相关PDF书籍、行业报告、文档,有几百本,都是目前行业最新的。

4.LLM面试题和面经合集

这里主要整理了行业目前最新的大模型面试题和各种大厂offer面经合集。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集***

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓