【Datawhale AI 夏令营】模型蒸馏学习笔记(一)让baseline跑起来

目录结构

- 整体目标:将大模型能力迁移至小模型

-

- 当前进度目标:Task01

- 具体实现过程

-

- 天才第一步

-

- 分数计算

- 基础环境准备

- 平台使用步骤

为AI找一位专业的导师,通过更聪明的大模型,教会你的大模型解决具体问题,通过生成清晰、严谨的解题过程和参考答案,将大型模型对应的能力高效地转移到轻量级模型中。

整体目标:将大模型能力迁移至小模型

-

跑通baseline

-

让AI学会数学推理

-

持续实践大模型推理,提高组委会评估得分

当前进度目标:Task01

- 精细化学习精调数学推理模型

- 蒸馏出自己的模型

具体实现过程

天才第一步

通过夏令营的描述,进行环境准备,需要注册讯飞开放平台,并报名参加赛事,以便于后续使用讯飞的模型和算力资源用于推理蒸馏模型。讯飞maas平台会通过报名参加链接赠送20元的算力资源礼品卡直接到账户中,用于本次的推理训练。

分数计算

通过讯飞开放平台的介绍,需要注意评估最终蒸馏模型的效果的分数计算规则,整体来说有以下三个方面进行加权计算。

- 答案准确率(Accuracy Score, AS):在测试集上,对所有数据的correctnessᵢ 取平均值,得到答案正确比例,再映射到0-100;

- CoT 推理质量(Chain-of-Thought Quality Score, CQS):对每条数据中模型生成的推理链进行评分,反映推理链的完整性、逻辑性与可解释性,得分越高表示生成的CoT链越符合标准推理过程。应用折扣策略对所有数据取平均得分,经预先校准后将分值映射至0-100;

- 推理解题效率(Efficiency Score, ES):首先对于测试集上的每条数据,基于模型推理过程中使用的token数量,通过预设的最小值、目标值和最大值,采用分段函数计算出原始效率得分。随后采用硬门槛策略,对所有数据取平均得分,经预先校准后将分值映射至0-100;

- 模型轻量化(Model Lightweight Score, MLS):根据模型文件大小评估轻量化程度,得分范围0-100;

基础环境准备

- 数据集下载地址:点击这里下载

- 使用的模型:DeepSeek-R1-Distill-Qwen-7B

- 进入到精调页面:点击这里跳转

平台使用步骤

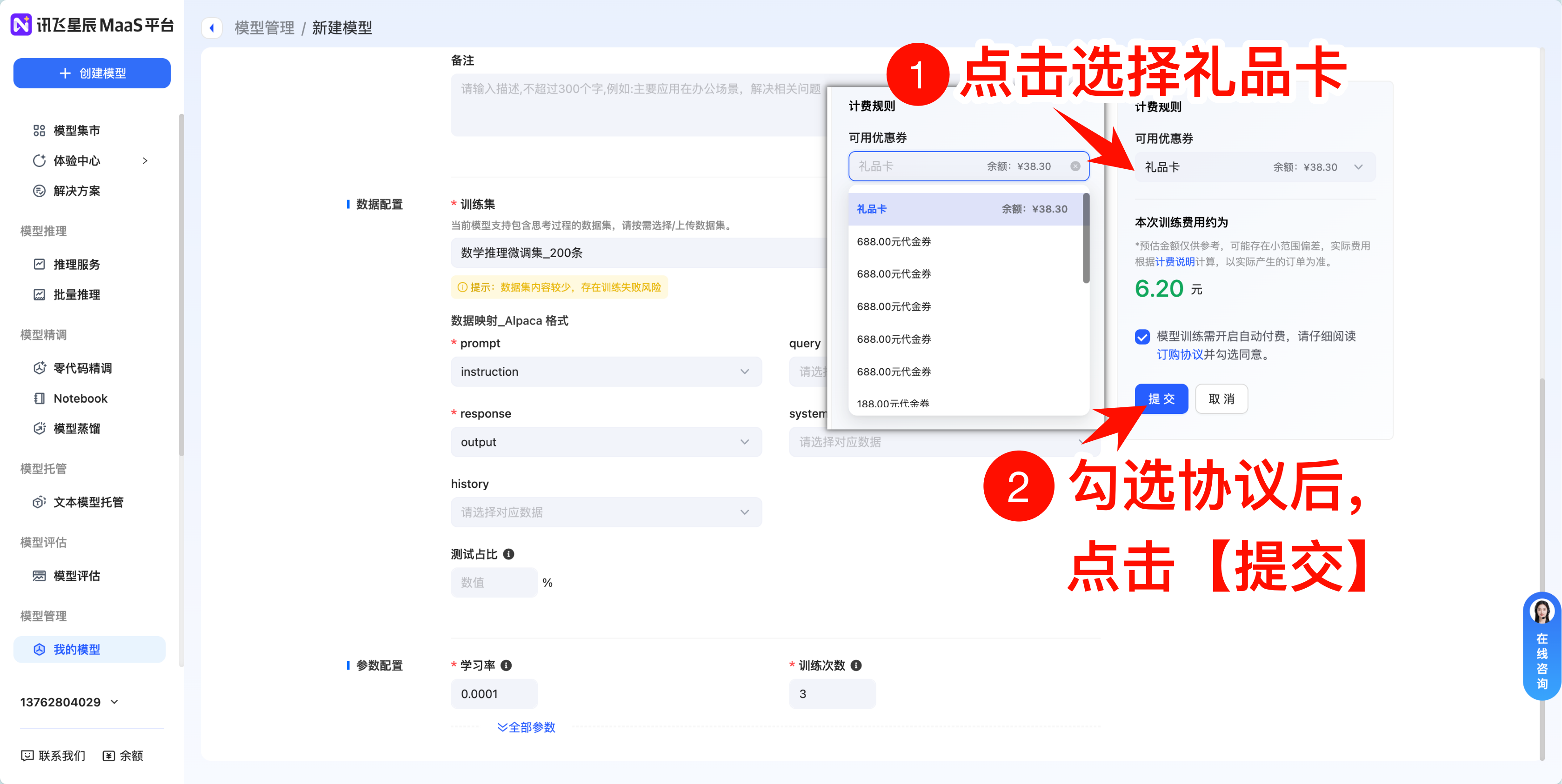

选择完成后点击右侧的提交按钮,会直接跳到需要传入数据的输入项。

点击确定之后就可以了,可以看到需要的训练资费了。

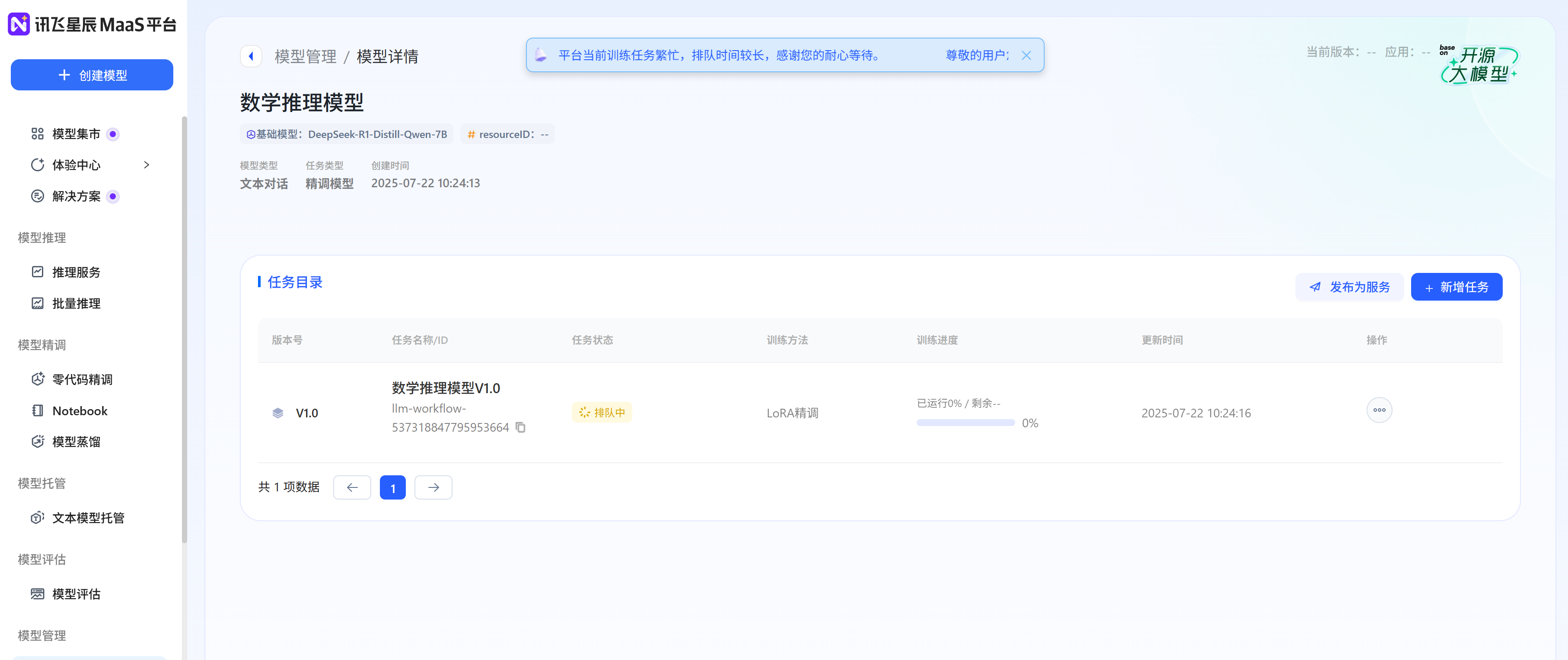

完成之后点击提交就可以了,页面会跳转到排队页面,可以看到微调的进度。

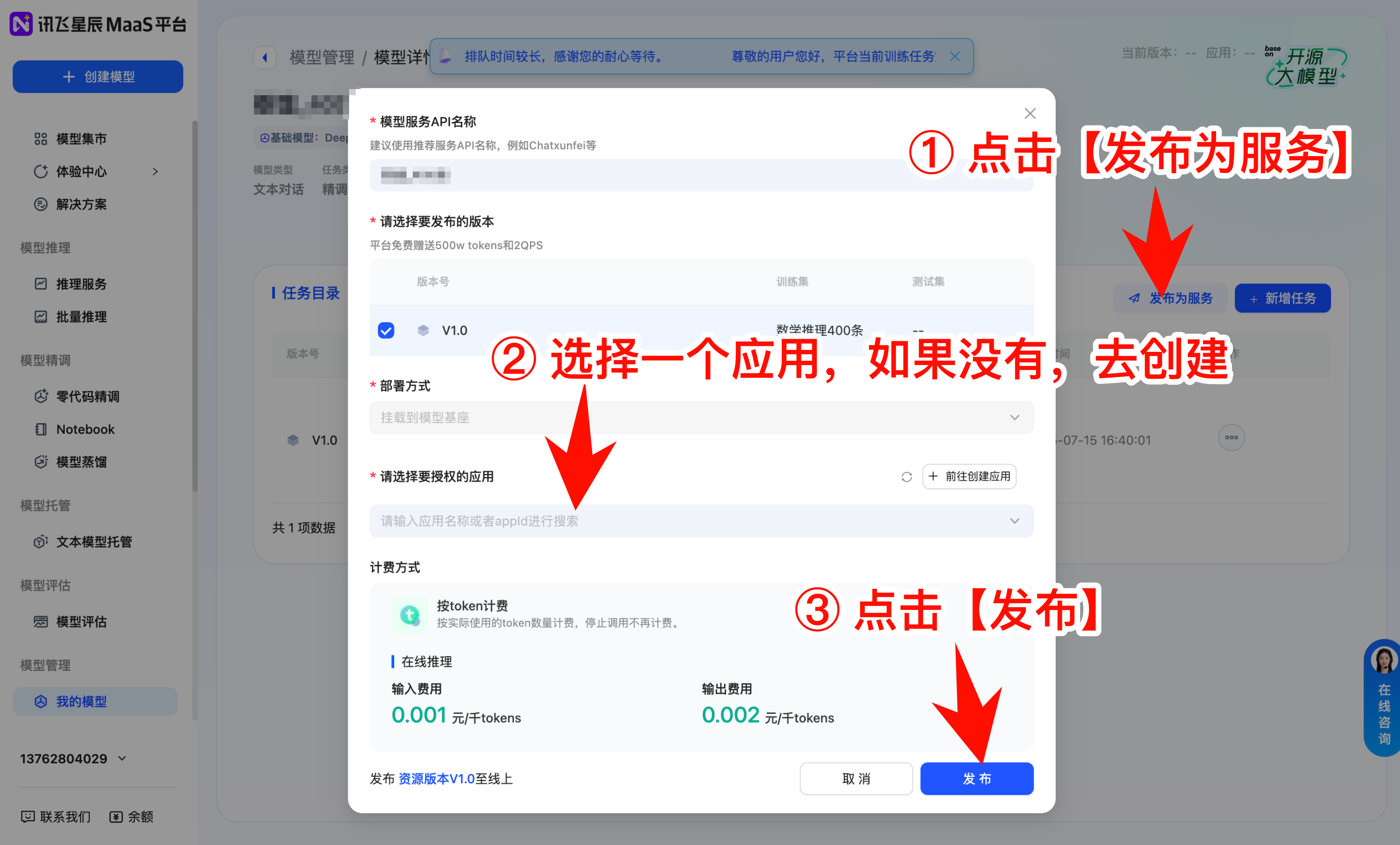

如果lora精调结束了,可以将当前微调结果发布为服务(也就是后面说到的应用的功能)。

总体来说没啥难度,而且针对开发者来说,这些都是一些傻瓜式操作,只要知道你干的是啥就可以了。当然,当前task也只是为了清楚我们当前要跑通baseline的流程。