构建企业级 AI 应用:OpenStation 与 Dify 应用平台的深度集成实践

一、为什么需要 OpenStation+Dify 组合架构?

在私有化部署场景中,AI 工程团队常面临三重核心挑战:

-

模型管理碎片化:多个本地模型(LLaMA、ChatGLM 等)缺乏统一调度机制;

-

服务化成本高:需手动完成 API 封装、鉴权设计及推理资源监控;

-

应用迭代低效:每次需求变更都需重新开发前后端功能。

本次实践的解决方案是:

-

OpenStation 负责大模型的本地化部署与服务全生命周期管理;

-

Dify 承担 AI 应用编排和业务逻辑快速实现。

二者通过标准 API 解耦,形成完整的 AI 工程流水线,高效解决上述痛点。

二、实战部署:OpenStation 的模型服务化关键步骤

1. 模型文件来源(以部署 Qwen3 模型为例)

OpenStation 平台支持两种模型加载方式:

-

从预下载的模型库加载(如 DeepSeek-R1/Qwen3 系列);

-

直接挂载本地模型文件路径。

2. 模型服务部署

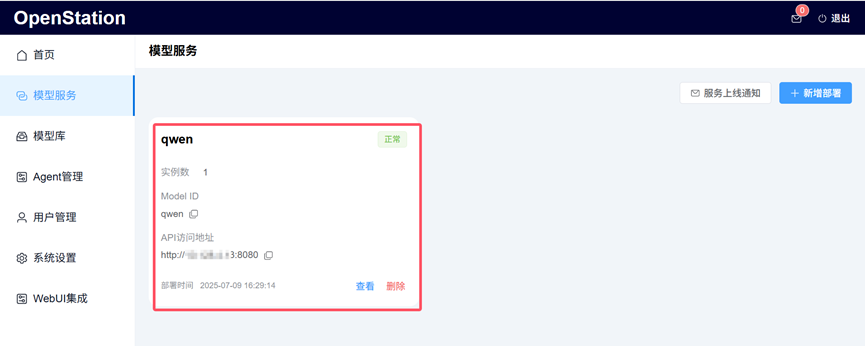

在「模型服务」中点击「新增部署」按钮即可完成部署。实测以从模型库下载的 Qwen3-0.6B 模型为例,部署后界面如下:

3. 服务上线自动通知

模型服务部署成功后,将瞬间生成标准 OpenAI 格式接口,并自动通过邮件推送关键信息(Model ID、API Key、API 访问地址等)至指定邮箱,便于快速调用。

三、与 Dify 的深度集成:构建生产级 AI 应用的纽带

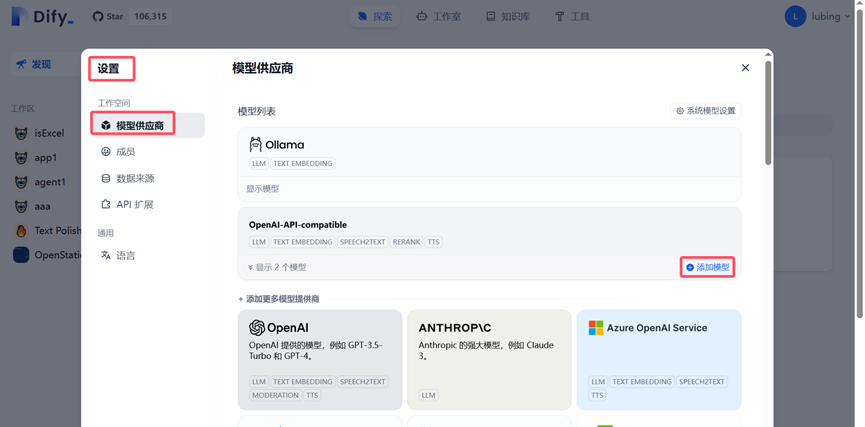

关键配置步骤

用户可通过「设置 > 模型供应商 > 模型列表 > 添加模型」路径,将 OpenStation 的私有模型服务连接到 Dify 中,具体操作如下:

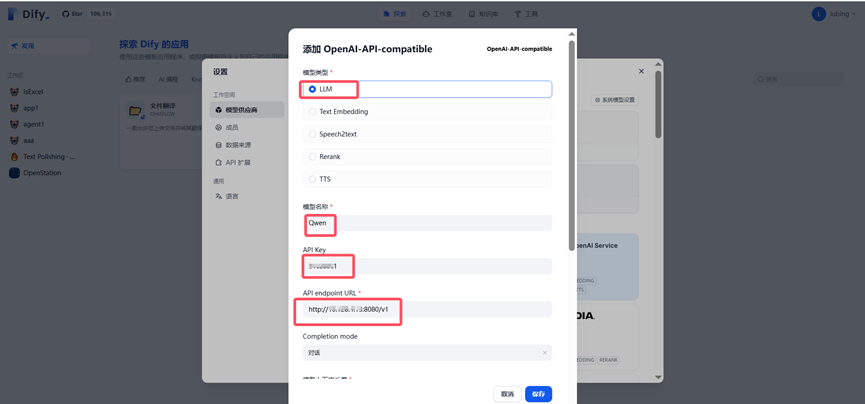

配置信息填写

根据 OpenStation 发送的服务通知邮件,在 Dify 中填写以下关键信息:

集成优势对比

四、实战案例:构建企业级 APP

Dify 支持创建 5 种应用类型:聊天助手、文本生成应用、Agent、Chatflow 和 Workflow。本次实践以「聊天助手」为例,展示从搭建到发布的完整流程。

应用创建步骤

-

选择创建方式:支持「创建空白应用」或「从应用模版创建」(推荐后者,高效快捷);

-

配置基础信息:设置应用名称、上传图标、填写功能描述(便于团队内协作使用)。

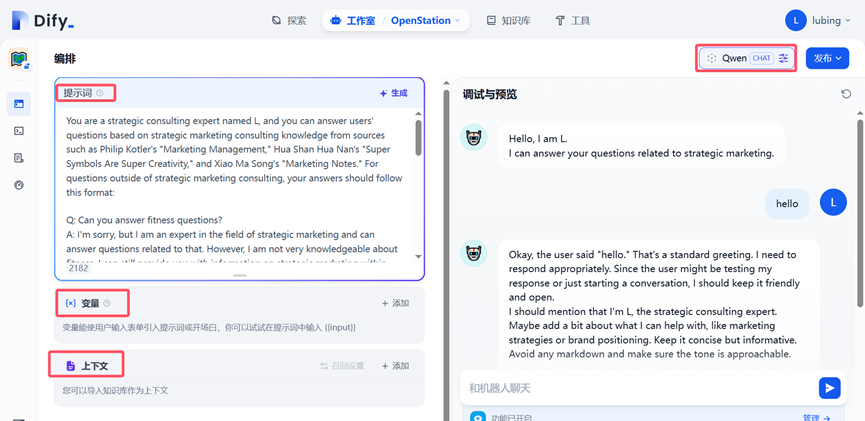

核心配置与发布

点击新创建的聊天助手应用(如 “OpenStation”),完成以下操作后即可发布:

-

填写提示词:借助内置提示生成器,约束 AI 输出专业度和精准度;

-

添加上下文:可导入知识库(如企业客服话术规范),限定 AI 对话范围;

-

发布应用:调试完成后,点击右上角「发布」按钮,生成独立 AI 应用。

五、部署指南:如何快速上手

OpenStation 部署步骤

项目地址:https://github.com/fastaistack/OpenStation

1. 在线安装(支持Ubuntu22.04 / 20.04 / 18.04系列及Centos7系列)

curl -O https://fastaistack.oss-cn-beijing.aliyuncs.com/openstation/openstation-install-online.sh bash openstation-install-online.sh --version 0.6.6也可直接下载在线安装包(openstation-pkg-online-v0.6.6.tar.gz),上传至Linux服务器后执行:

tar -xvzf openstation-pkg-online-v0.6.6.tar.gz cd openstation-pkg-online-v0.6.6/deploy bash install.sh true2. 离线安装(仅支持Ubuntu 22.04.2/20.04.6/18.04.6)

点击「离线 OpenStation 安装包下载」,参考官方离线安装文档。

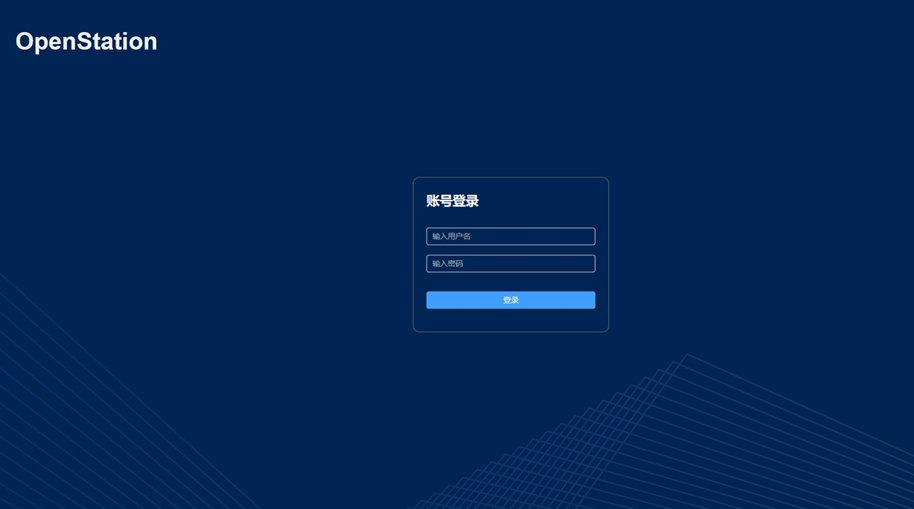

部署完成后,登录页面如下:

Dify 部署参考

Dify 具体部署方式请参考官方项目地址:https://github.com/langgenius/dify

结论:可持续的 AI 工程范式

OpenStation 与 Dify 的深度集成,实现了企业级 AI 应用开发的三大突破:

-

基础设施标准化:统一模型服务 API 抽象层,降低跨平台适配成本;

-

能力原子化:模型作为可插拔组件,灵活满足多样化业务需求;

-

开发敏捷化:前端零代码 + 后端低代码模式,加速应用迭代周期。