大数据MapReduce架构:分布式计算的经典范式

大数据MapReduce架构:分布式计算的经典范式

🌟 你好,我是 励志成为糕手 !

🌌 在代码的宇宙中,我是那个追逐优雅与性能的星际旅人。 ✨

每一行代码都是我种下的星光,在逻辑的土壤里生长成璀璨的银河;

🛠️ 每一个算法都是我绘制的星图,指引着数据流动的最短路径; 🔍

每一次调试都是星际对话,用耐心和智慧解开宇宙的谜题。

🚀 准备好开始我们的星际编码之旅了吗?

目录

- 大数据MapReduce架构:分布式计算的经典范式

-

- 探索MapReduce的星际旅程

- MapReduce的核心思想

-

- Map与Reduce:宇宙的两大基本力

- 一个简单的WordCount示例

- MapReduce架构详解

-

- MapReduce工作流程详解

- Shuffle过程详解

- MapReduce应用场景分析

-

- 典型应用场景

- 行业应用分布

- MapReduce与现代大数据框架对比

-

- 性能对比分析

- MapReduce的优势与局限

-

- 优势

- 局限

- MapReduce最佳实践

-

- 性能优化技巧

- MapReduce的演进与未来

- 星际编码之旅的终点:我的MapReduce实践心得

- 参考链接

- 关键词标签

探索MapReduce的星际旅程

作为一名数据工程师,我一直在寻找处理海量数据的最佳方法。还记得我第一次接触MapReduce时的震撼,那种简单而强大的编程模型彻底改变了我对大数据处理的认知。在过去几年中,我深入研究了MapReduce架构,从最初的概念理解到实际项目应用,再到与新兴框架的对比分析。

MapReduce就像宇宙中的引力法则,看似简单却能驾驭复杂的数据星系。它将复杂的大数据处理任务分解为Map和Reduce两个基本操作,使得即使是普通开发者也能轻松驾驭分布式计算的力量。在我看来,理解MapReduce不仅是掌握一项技术,更是领悟分布式计算的哲学思想。

在这篇文章中,我将带你深入探索MapReduce的核心原理、架构设计、工作流程以及实际应用场景。我们会通过生动的图表、代码示例和实际案例,揭示这一经典框架的魅力所在。同时,我也会分享我在实际项目中积累的经验和最佳实践,帮助你避开常见陷阱,充分发挥MapReduce的潜力。

无论你是大数据领域的新手,还是寻求深入理解的资深工程师,这篇文章都将为你提供全面而深入的MapReduce知识,让我们一起踏上这段星际编码之旅吧!

MapReduce的核心思想

MapReduce是由Google在2004年提出的一种编程模型,旨在解决大规模数据集的并行计算问题。其核心思想可以概括为\"分而治之\":将复杂的大数据处理任务分解为两个主要阶段。

Map与Reduce:宇宙的两大基本力

- Map阶段:将输入数据集分割成独立的数据块,交由Map函数处理,产生中间结果(键值对)

- Reduce阶段:对Map阶段产生的所有中间结果进行合并和处理,生成最终输出

这种简单而强大的模型使开发者能够专注于业务逻辑,而将分布式计算的复杂性交给框架处理。

一个简单的WordCount示例

让我们通过经典的单词计数示例来理解MapReduce的工作原理:

// Map函数:将文本分割为单词,每个单词输出的键值对public static class TokenizerMapper extends Mapper<Object, Text, Text, IntWritable> { private final static IntWritable one = new IntWritable(1); private Text word = new Text(); public void map(Object key, Text value, Context context) throws IOException, InterruptedException { // 将输入文本分割为单词 StringTokenizer itr = new StringTokenizer(value.toString()); while (itr.hasMoreTokens()) { word.set(itr.nextToken()); // 输出的键值对 context.write(word, one); // 核心输出操作 } }}// Reduce函数:汇总每个单词的计数public static class IntSumReducer extends Reducer<Text, IntWritable, Text, IntWritable> { private IntWritable result = new IntWritable(); public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException { int sum = 0; // 累加同一个单词的所有计数 for (IntWritable val : values) { sum += val.get(); // 累加计数 } result.set(sum); // 输出的键值对 context.write(key, result); // 最终结果输出 }}在这个例子中,Map函数将文本分割为单词并输出的键值对,而Reduce函数则汇总每个单词的计数,输出的结果。这个简单的例子展示了MapReduce编程模型的核心思想。

MapReduce架构详解

#mermaid-svg-Zy1x1omZF1z3PFVb {font-family:\"trebuchet ms\",verdana,arial,sans-serif;font-size:16px;fill:#ccc;}#mermaid-svg-Zy1x1omZF1z3PFVb .error-icon{fill:#a44141;}#mermaid-svg-Zy1x1omZF1z3PFVb .error-text{fill:#ddd;stroke:#ddd;}#mermaid-svg-Zy1x1omZF1z3PFVb .edge-thickness-normal{stroke-width:2px;}#mermaid-svg-Zy1x1omZF1z3PFVb .edge-thickness-thick{stroke-width:3.5px;}#mermaid-svg-Zy1x1omZF1z3PFVb .edge-pattern-solid{stroke-dasharray:0;}#mermaid-svg-Zy1x1omZF1z3PFVb .edge-pattern-dashed{stroke-dasharray:3;}#mermaid-svg-Zy1x1omZF1z3PFVb .edge-pattern-dotted{stroke-dasharray:2;}#mermaid-svg-Zy1x1omZF1z3PFVb .marker{fill:#f5a742;stroke:#f5a742;}#mermaid-svg-Zy1x1omZF1z3PFVb .marker.cross{stroke:#f5a742;}#mermaid-svg-Zy1x1omZF1z3PFVb svg{font-family:\"trebuchet ms\",verdana,arial,sans-serif;font-size:16px;}#mermaid-svg-Zy1x1omZF1z3PFVb .label{font-family:\"trebuchet ms\",verdana,arial,sans-serif;color:#ccc;}#mermaid-svg-Zy1x1omZF1z3PFVb .cluster-label text{fill:#F9FFFE;}#mermaid-svg-Zy1x1omZF1z3PFVb .cluster-label span{color:#F9FFFE;}#mermaid-svg-Zy1x1omZF1z3PFVb .label text,#mermaid-svg-Zy1x1omZF1z3PFVb span{fill:#ccc;color:#ccc;}#mermaid-svg-Zy1x1omZF1z3PFVb .node rect,#mermaid-svg-Zy1x1omZF1z3PFVb .node circle,#mermaid-svg-Zy1x1omZF1z3PFVb .node ellipse,#mermaid-svg-Zy1x1omZF1z3PFVb .node polygon,#mermaid-svg-Zy1x1omZF1z3PFVb .node path{fill:#1f2020;stroke:#81B1DB;stroke-width:1px;}#mermaid-svg-Zy1x1omZF1z3PFVb .node .label{text-align:center;}#mermaid-svg-Zy1x1omZF1z3PFVb .node.clickable{cursor:pointer;}#mermaid-svg-Zy1x1omZF1z3PFVb .arrowheadPath{fill:lightgrey;}#mermaid-svg-Zy1x1omZF1z3PFVb .edgePath .path{stroke:#f5a742;stroke-width:2.0px;}#mermaid-svg-Zy1x1omZF1z3PFVb .flowchart-link{stroke:#f5a742;fill:none;}#mermaid-svg-Zy1x1omZF1z3PFVb .edgeLabel{background-color:hsl(0, 0%, 34.4117647059%);text-align:center;}#mermaid-svg-Zy1x1omZF1z3PFVb .edgeLabel rect{opacity:0.5;background-color:hsl(0, 0%, 34.4117647059%);fill:hsl(0, 0%, 34.4117647059%);}#mermaid-svg-Zy1x1omZF1z3PFVb .cluster rect{fill:hsl(180, 1.5873015873%, 28.3529411765%);stroke:rgba(255, 255, 255, 0.25);stroke-width:1px;}#mermaid-svg-Zy1x1omZF1z3PFVb .cluster text{fill:#F9FFFE;}#mermaid-svg-Zy1x1omZF1z3PFVb .cluster span{color:#F9FFFE;}#mermaid-svg-Zy1x1omZF1z3PFVb div.mermaidTooltip{position:absolute;text-align:center;max-width:200px;padding:2px;font-family:\"trebuchet ms\",verdana,arial,sans-serif;font-size:12px;background:#2b2b2b;border:1px solid rgba(255, 255, 255, 0.25);border-radius:2px;pointer-events:none;z-index:100;}#mermaid-svg-Zy1x1omZF1z3PFVb :root{--mermaid-font-family:\"trebuchet ms\",verdana,arial,sans-serif;}#mermaid-svg-Zy1x1omZF1z3PFVb .client>*{fill:#e6c35a!important;stroke:#e6c35a!important;color:#000!important;}#mermaid-svg-Zy1x1omZF1z3PFVb .client span{fill:#e6c35a!important;stroke:#e6c35a!important;color:#000!important;}#mermaid-svg-Zy1x1omZF1z3PFVb .master>*{fill:#5a5ce6!important;stroke:#5a5ce6!important;color:#fff!important;}#mermaid-svg-Zy1x1omZF1z3PFVb .master span{fill:#5a5ce6!important;stroke:#5a5ce6!important;color:#fff!important;}#mermaid-svg-Zy1x1omZF1z3PFVb .workers>*{fill:#e65a7c!important;stroke:#e65a7c!important;color:#fff!important;}#mermaid-svg-Zy1x1omZF1z3PFVb .workers span{fill:#e65a7c!important;stroke:#e65a7c!important;color:#fff!important;}#mermaid-svg-Zy1x1omZF1z3PFVb .storage>*{fill:#5ae6a3!important;stroke:#5ae6a3!important;color:#000!important;}#mermaid-svg-Zy1x1omZF1z3PFVb .storage span{fill:#5ae6a3!important;stroke:#5ae6a3!important;color:#000!important;} 存储层 工作节点 主节点 客户端 提交MapReduce作业 初始化作业 分配资源 分配Map任务 分配Reduce任务 执行 执行 读取输入数据 写入中间结果 Shuffle 写入最终结果 监控任务状态 HDFS/分布式存储 TaskTracker/NodeManager Map任务 Reduce任务 JobTracker/ResourceManager 作业调度 资源分配 任务监控 提交作业

图1:MapReduce架构流程图 - 展示了MapReduce框架的核心组件及其交互流程

MapReduce框架(以Hadoop MapReduce为例)由以下核心组件构成:

- Client:提交MapReduce作业

- JobTracker/ResourceManager:作业调度和监控

- TaskTracker/NodeManager:执行具体的Map和Reduce任务

- HDFS/分布式存储:提供数据存储

MapReduce工作流程详解

#mermaid-svg-5IKdW0Tivh3xDiZW {font-family:\"trebuchet ms\",verdana,arial,sans-serif;font-size:16px;fill:#ccc;}#mermaid-svg-5IKdW0Tivh3xDiZW .error-icon{fill:#a44141;}#mermaid-svg-5IKdW0Tivh3xDiZW .error-text{fill:#ddd;stroke:#ddd;}#mermaid-svg-5IKdW0Tivh3xDiZW .edge-thickness-normal{stroke-width:2px;}#mermaid-svg-5IKdW0Tivh3xDiZW .edge-thickness-thick{stroke-width:3.5px;}#mermaid-svg-5IKdW0Tivh3xDiZW .edge-pattern-solid{stroke-dasharray:0;}#mermaid-svg-5IKdW0Tivh3xDiZW .edge-pattern-dashed{stroke-dasharray:3;}#mermaid-svg-5IKdW0Tivh3xDiZW .edge-pattern-dotted{stroke-dasharray:2;}#mermaid-svg-5IKdW0Tivh3xDiZW .marker{fill:#f5a742;stroke:#f5a742;}#mermaid-svg-5IKdW0Tivh3xDiZW .marker.cross{stroke:#f5a742;}#mermaid-svg-5IKdW0Tivh3xDiZW svg{font-family:\"trebuchet ms\",verdana,arial,sans-serif;font-size:16px;}#mermaid-svg-5IKdW0Tivh3xDiZW .actor{stroke:#81B1DB;fill:#1f2020;}#mermaid-svg-5IKdW0Tivh3xDiZW text.actor>tspan{fill:lightgrey;stroke:none;}#mermaid-svg-5IKdW0Tivh3xDiZW .actor-line{stroke:lightgrey;}#mermaid-svg-5IKdW0Tivh3xDiZW .messageLine0{stroke-width:1.5;stroke-dasharray:none;stroke:lightgrey;}#mermaid-svg-5IKdW0Tivh3xDiZW .messageLine1{stroke-width:1.5;stroke-dasharray:2,2;stroke:lightgrey;}#mermaid-svg-5IKdW0Tivh3xDiZW #arrowhead path{fill:lightgrey;stroke:lightgrey;}#mermaid-svg-5IKdW0Tivh3xDiZW .sequenceNumber{fill:black;}#mermaid-svg-5IKdW0Tivh3xDiZW #sequencenumber{fill:lightgrey;}#mermaid-svg-5IKdW0Tivh3xDiZW #crosshead path{fill:lightgrey;stroke:lightgrey;}#mermaid-svg-5IKdW0Tivh3xDiZW .messageText{fill:lightgrey;stroke:lightgrey;}#mermaid-svg-5IKdW0Tivh3xDiZW .labelBox{stroke:#81B1DB;fill:#1f2020;}#mermaid-svg-5IKdW0Tivh3xDiZW .labelText,#mermaid-svg-5IKdW0Tivh3xDiZW .labelText>tspan{fill:lightgrey;stroke:none;}#mermaid-svg-5IKdW0Tivh3xDiZW .loopText,#mermaid-svg-5IKdW0Tivh3xDiZW .loopText>tspan{fill:lightgrey;stroke:none;}#mermaid-svg-5IKdW0Tivh3xDiZW .loopLine{stroke-width:2px;stroke-dasharray:2,2;stroke:#81B1DB;fill:#81B1DB;}#mermaid-svg-5IKdW0Tivh3xDiZW .note{stroke:hsl(180, 0%, 18.3529411765%);fill:hsl(180, 1.5873015873%, 28.3529411765%);}#mermaid-svg-5IKdW0Tivh3xDiZW .noteText,#mermaid-svg-5IKdW0Tivh3xDiZW .noteText>tspan{fill:rgb(183.8476190475, 181.5523809523, 181.5523809523);stroke:none;}#mermaid-svg-5IKdW0Tivh3xDiZW .activation0{fill:hsl(180, 1.5873015873%, 28.3529411765%);stroke:#81B1DB;}#mermaid-svg-5IKdW0Tivh3xDiZW .activation1{fill:hsl(180, 1.5873015873%, 28.3529411765%);stroke:#81B1DB;}#mermaid-svg-5IKdW0Tivh3xDiZW .activation2{fill:hsl(180, 1.5873015873%, 28.3529411765%);stroke:#81B1DB;}#mermaid-svg-5IKdW0Tivh3xDiZW .actorPopupMenu{position:absolute;}#mermaid-svg-5IKdW0Tivh3xDiZW .actorPopupMenuPanel{position:absolute;fill:#1f2020;box-shadow:0px 8px 16px 0px rgba(0,0,0,0.2);filter:drop-shadow(3px 5px 2px rgb(0 0 0 / 0.4));}#mermaid-svg-5IKdW0Tivh3xDiZW .actor-man line{stroke:#81B1DB;fill:#1f2020;}#mermaid-svg-5IKdW0Tivh3xDiZW .actor-man circle,#mermaid-svg-5IKdW0Tivh3xDiZW line{stroke:#81B1DB;fill:#1f2020;stroke-width:2px;}#mermaid-svg-5IKdW0Tivh3xDiZW :root{--mermaid-font-family:\"trebuchet ms\",verdana,arial,sans-serif;} 客户端 JobTracker/RM TaskTracker/NM HDFS 1. 提交MapReduce作业 2. 初始化作业 3. 分配Map任务 4. 读取输入数据块 5. 执行Map任务 6. 写入中间结果 7. 分配Reduce任务 8. 读取中间结果(Shuffle) 9. 执行Reduce任务 10. 写入最终结果 11. 报告任务完成 12. 通知作业完成 Map阶段 Shuffle阶段 Reduce阶段 客户端 JobTracker/RM TaskTracker/NM HDFS

图2:MapReduce执行时序图 - 展示了MapReduce作业从提交到完成的完整流程

- 作业提交:客户端提交作业到JobTracker

- 作业初始化:JobTracker初始化作业,创建作业执行计划

- 任务分配:JobTracker将Map和Reduce任务分配给TaskTracker

- Map执行:TaskTracker执行Map任务,处理数据分片,生成中间结果

- Shuffle和Sort:将Map输出按Key分组,排序,并传输到执行Reduce任务的节点

- Reduce执行:执行Reduce任务,处理中间结果,生成最终输出

- 结果存储:将结果写入HDFS或其他存储系统

Shuffle过程详解

Shuffle是MapReduce中最复杂也是最关键的环节,它连接Map和Reduce阶段,负责将Map输出的中间结果传输给Reduce任务。

// Map端Shuffle过程public class MapOutputBuffer<K, V> { // Map输出被分区 private int partitionFunction(K key) { return (key.hashCode() & Integer.MAX_VALUE) % numReduceTasks; } // Map输出被排序 private void sortAndSpill() { // 根据键排序 IndexedSorter sorter = new QuickSort(); sorter.sort(comparator, 0, count); // 写入磁盘 FSDataOutputStream out = rfs.create(filename); // ...写入排序后的数据 }}// Reduce端Shuffle过程public class Fetcher<K, V> { // 从Map任务获取中间结果 public void fetchOutputs() { // 从多个Map任务获取属于此Reduce任务的数据 // ... } // 合并多个Map输出 private void mergeSort() { // 合并多个排序好的Map输出 // ... }}Shuffle过程包含分区、排序、合并等多个步骤,是MapReduce性能优化的关键点。

MapReduce应用场景分析

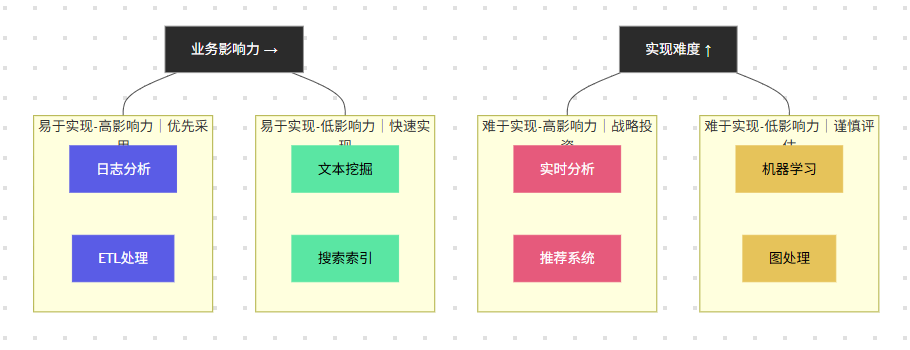

图3:MapReduce应用场景象限图 - 展示不同应用场景在实现难度和业务影响力维度的分布

从上图可以看出,MapReduce在ETL处理和日志分析等场景中具有高影响力且相对容易实现,而在实时分析等场景中虽有高影响力但实现难度较大。

从上图可以看出,MapReduce在ETL处理和日志分析等场景中具有高影响力且相对容易实现,而在实时分析等场景中虽有高影响力但实现难度较大。

典型应用场景

- 日志分析:处理大量服务器日志,提取有价值的信息

- ETL处理:数据抽取、转换和加载,为数据仓库准备数据

- 文本挖掘:处理大规模文本数据,进行情感分析、关键词提取等

- 搜索索引:构建搜索引擎的倒排索引

- 推荐系统:处理用户行为数据,生成推荐模型

行业应用分布

#mermaid-svg-ubrM1fbIto4FmpQ9 {font-family:\"trebuchet ms\",verdana,arial,sans-serif;font-size:16px;fill:#ccc;}#mermaid-svg-ubrM1fbIto4FmpQ9 .error-icon{fill:#a44141;}#mermaid-svg-ubrM1fbIto4FmpQ9 .error-text{fill:#ddd;stroke:#ddd;}#mermaid-svg-ubrM1fbIto4FmpQ9 .edge-thickness-normal{stroke-width:2px;}#mermaid-svg-ubrM1fbIto4FmpQ9 .edge-thickness-thick{stroke-width:3.5px;}#mermaid-svg-ubrM1fbIto4FmpQ9 .edge-pattern-solid{stroke-dasharray:0;}#mermaid-svg-ubrM1fbIto4FmpQ9 .edge-pattern-dashed{stroke-dasharray:3;}#mermaid-svg-ubrM1fbIto4FmpQ9 .edge-pattern-dotted{stroke-dasharray:2;}#mermaid-svg-ubrM1fbIto4FmpQ9 .marker{fill:#f5a742;stroke:#f5a742;}#mermaid-svg-ubrM1fbIto4FmpQ9 .marker.cross{stroke:#f5a742;}#mermaid-svg-ubrM1fbIto4FmpQ9 svg{font-family:\"trebuchet ms\",verdana,arial,sans-serif;font-size:16px;}#mermaid-svg-ubrM1fbIto4FmpQ9 .pieCircle{stroke:black;stroke-width:2px;opacity:0.7;}#mermaid-svg-ubrM1fbIto4FmpQ9 .pieTitleText{text-anchor:middle;font-size:25px;fill:hsl(28.5714285714, 17.3553719008%, 86.2745098039%);font-family:\"trebuchet ms\",verdana,arial,sans-serif;}#mermaid-svg-ubrM1fbIto4FmpQ9 .slice{font-family:\"trebuchet ms\",verdana,arial,sans-serif;fill:#ccc;font-size:17px;}#mermaid-svg-ubrM1fbIto4FmpQ9 .legend text{fill:hsl(28.5714285714, 17.3553719008%, 86.2745098039%);font-family:\"trebuchet ms\",verdana,arial,sans-serif;font-size:17px;}#mermaid-svg-ubrM1fbIto4FmpQ9 :root{--mermaid-font-family:\"trebuchet ms\",verdana,arial,sans-serif;} 35% 25% 15% 12% 8% 5% MapReduce在各行业的应用分布 互联网 金融 电信 零售 医疗 其他

图4:MapReduce行业应用分布饼图 - 展示MapReduce技术在不同行业的应用占比

MapReduce与现代大数据框架对比

随着大数据技术的发展,出现了许多新的处理框架,如Spark、Flink等。下面我们对比一下MapReduce与这些现代框架的异同。

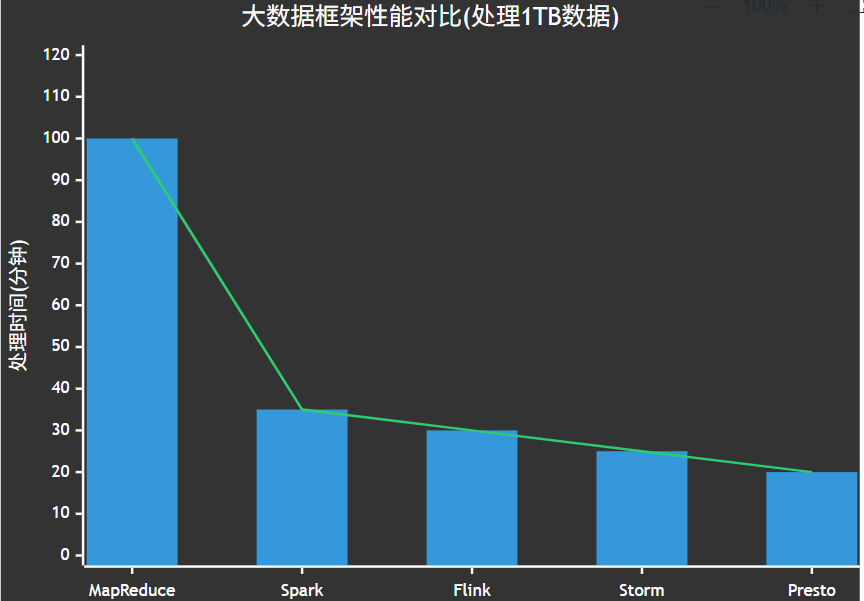

性能对比分析

图5:大数据框架性能对比XY图 - 展示不同框架处理相同数据量的时间对比

从图表可以看出,MapReduce在处理相同数据量时需要的时间明显多于其他现代框架,这主要是因为其基于磁盘的处理模式,而Spark、Flink等框架采用了内存计算模型,大大提高了处理效率。

MapReduce的优势与局限

优势

- 高可扩展性:可以轻松扩展到数千节点

- 高容错性:任务失败自动重试,数据多副本存储

- 编程模型简单:只需实现Map和Reduce函数

- 适合批处理:对大规模数据批处理效果好

局限

- 高延迟:不适合实时或交互式分析

- 迭代计算效率低:每次迭代都需要读写磁盘

- 仅支持批处理:不支持流处理

- 编程模型受限:复杂算法实现困难

MapReduce最佳实践

“MapReduce的真正力量不在于它的性能,而在于它使普通程序员能够利用分布式系统的强大功能,而无需成为分布式系统专家。”

— Jeffrey Dean,Google高级研究员,MapReduce论文作者

性能优化技巧

- 合理设计键值对:键的设计直接影响数据分布和处理效率

// 不良实践:使用时间戳作为键,可能导致数据倾斜public void map(Object key, Text value, Context context) { // 使用时间戳作为键 context.write(new Text(System.currentTimeMillis()), value);}// 良好实践:使用复合键或哈希键,确保均匀分布public void map(Object key, Text value, Context context) { // 使用哈希值作为键的一部分,确保分布均匀 int partition = Math.abs(value.hashCode() % numPartitions); context.write(new Text(partition + \"_\" + originalKey), value);}- 使用Combiner减少数据传输:在Map端进行局部聚合,减少网络传输

// 配置Combiner,与Reducer使用相同的类job.setCombinerClass(IntSumReducer.class);// Combiner示例(与Reducer相同)public static class IntSumReducer extends Reducer<Text, IntWritable, Text, IntWritable> { private IntWritable result = new IntWritable(); public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException { int sum = 0; for (IntWritable val : values) { sum += val.get(); } result.set(sum); context.write(key, result); }}- 避免数据倾斜:确保键的分布均匀,避免热点

// 处理数据倾斜的策略:键加盐public void map(Object key, Text value, Context context) { // 对热点键添加随机前缀 if (isHotKey(key)) { int salt = new Random().nextInt(10); // 0-9的随机数 context.write(new Text(salt + \"_\" + key), value); } else { context.write(new Text(key), value); }}// 在Reduce阶段去除盐值public void reduce(Text key, Iterable<IntWritable> values, Context context) { // 提取原始键(去除盐值) String originalKey = key.toString().substring(key.toString().indexOf(\"_\") + 1); // 处理逻辑...}- 合理设置任务数:根据集群规模和数据量调整Map和Reduce任务数

// 设置Map任务数(通过控制输入分片大小)job.getConfiguration().setLong(\"mapreduce.input.fileinputformat.split.minsize\", 128 * 1024 * 1024); // 128MB// 设置Reduce任务数job.setNumReduceTasks(10); // 根据集群规模和数据量设置合适的值MapReduce的演进与未来

图6:大数据处理框架演进时间线 - 展示大数据技术从MapReduce到现代框架的发展历程

这条时间线展示了大数据处理技术从MapReduce开始的演进历程,反映了从批处理到流处理、从单一框架到生态系统的发展趋势,以及与AI技术的深度融合。

虽然MapReduce已不再是大数据处理的唯一选择,但它的思想和原则仍然影响着现代大数据框架的设计。随着Spark、Flink等新一代框架的兴起,MapReduce的应用场景逐渐聚焦于特定的批处理任务。

星际编码之旅的终点:我的MapReduce实践心得

作为一名数据工程师,我在多个项目中应用了MapReduce技术,从最初的摸索到如今的熟练应用,这段旅程让我收获颇丰。MapReduce就像是大数据处理的\"Hello World\",它不仅是一种技术,更是一种思维方式。

在我看来,MapReduce最大的魅力在于它的简单与强大的平衡。通过简单的Map和Reduce两个操作,我们就能构建出复杂的数据处理流程。这种\"分而治之\"的思想不仅适用于MapReduce,也是解决各种复杂问题的通用方法。

在实际项目中,我发现MapReduce虽然在性能上不如新兴框架,但在稳定性和可靠性方面仍有其独特优势。特别是在处理超大规模数据时,MapReduce的容错机制能够确保作业的可靠完成。我曾经处理过一个包含数十亿条记录的日志分析任务,尽管过程耗时较长,但MapReduce框架的稳定性让我能够安心等待结果,而不必担心中途失败。

当然,随着技术的发展,我们也需要与时俱进。在新项目中,我已经开始更多地使用Spark和Flink等现代框架,它们在性能和灵活性方面确实提供了更好的体验。但是,理解MapReduce的原理和思想,对于掌握这些新框架仍然至关重要。

如果你正在学习大数据技术,我强烈建议你从MapReduce开始,理解其核心思想和工作原理,这将为你后续学习更复杂的框架奠定坚实基础。就像我们需要先学会走路,才能跑步一样,MapReduce是你大数据之旅的第一步,也是最重要的一步。

让我们在代码的宇宙中继续探索,用技术的力量解决更多实际问题,创造更大的价值!

🌟 我是 励志成为糕手 ,感谢你与我共度这段技术时光!

✨ 如果这篇文章为你带来了启发:

✅ 【收藏】关键知识点,打造你的技术武器库

💡【评论】留下思考轨迹,与同行者碰撞智慧火花

🚀 【关注】持续获取前沿技术解析与实战干货

🌌 技术探索永无止境,让我们继续在代码的宇宙中:

• 用优雅的算法绘制星图

• 以严谨的逻辑搭建桥梁

• 让创新的思维照亮前路

📡 保持连接,我们下次太空见!

参考链接

- MapReduce: Simplified Data Processing on Large Clusters

- Apache Hadoop Official Documentation

- Understanding the MapReduce Paradigm

- Hadoop MapReduce vs. Apache Spark

- Evolution of Big Data Processing Frameworks

关键词标签

#MapReduce #Hadoop #分布式计算 #大数据处理 #批处理