论文笔记 | EmbodiedGen: Towards a Generative 3D World Engine for Embodied Intelligence

论文链接:EmbodiedGen: Towards a Generative 3D World Engine for Embodied Intelligence

代码仓库:HorizonRobotics/EmbodiedGen: Towards a Generative 3D World Engine for Embodied Intelligence (github.com)

📌 导语

在构建具身智能系统时,高质量、物理真实、可交互的3D资产是基础资源。然而,传统3D资产依赖人工建模,不仅成本高、效率低,还缺乏真实性和扩展性。为了解决这些问题,EmbodiedGen 提出了一整套生成式3D世界引擎框架,助力从图像、文本到交互式3D场景的自动构建,为具身智能的研究和应用打开了新的通路。

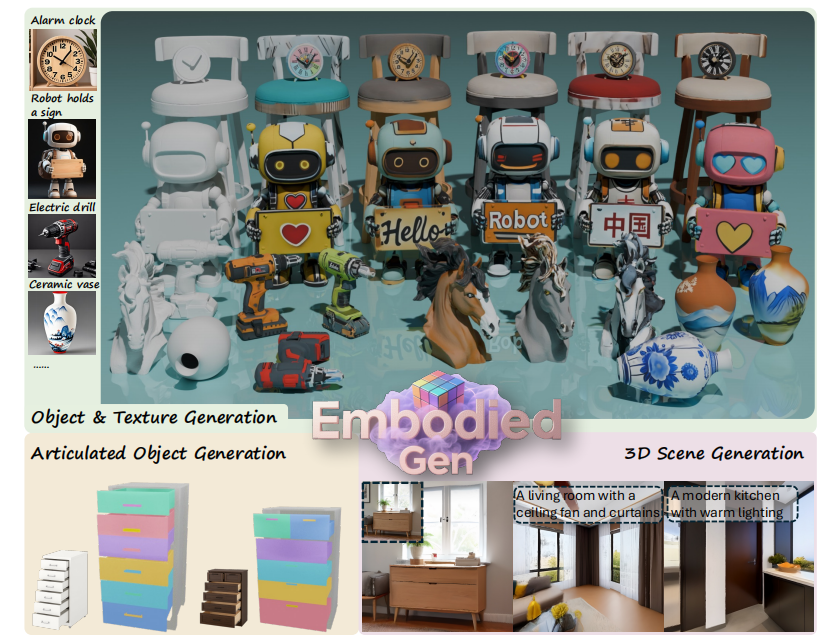

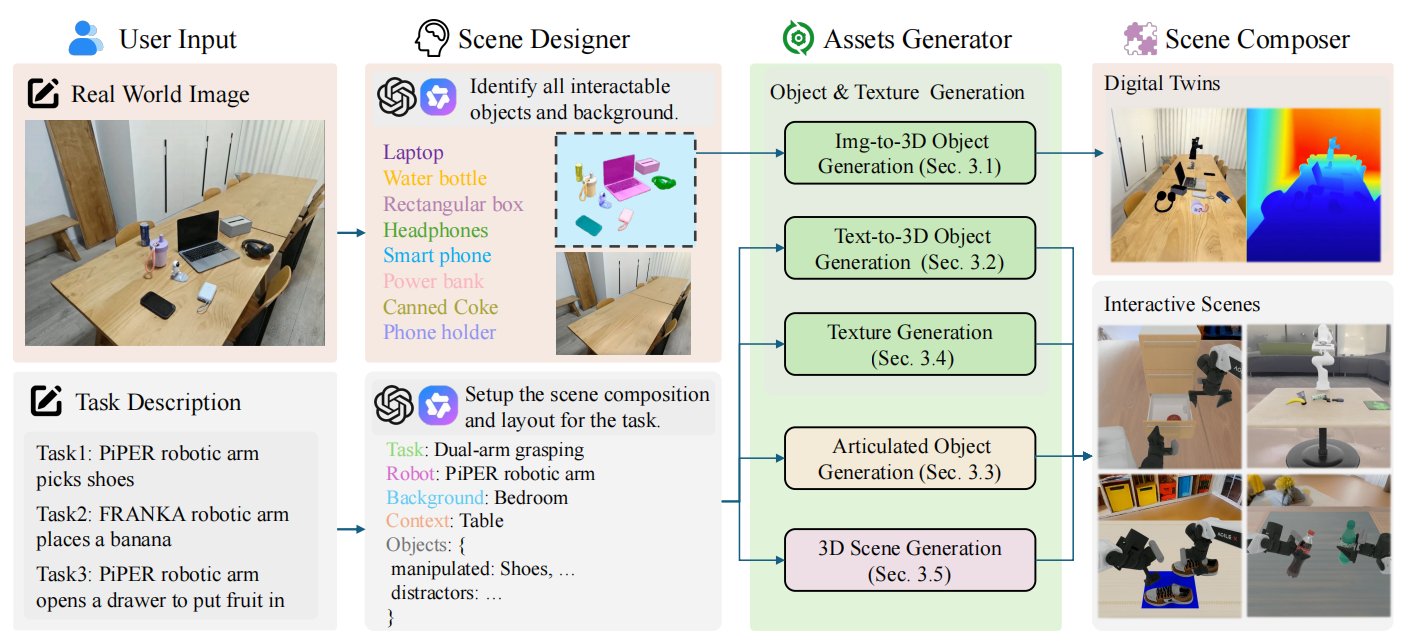

EmbodiedGen 是一个面向具身智能研究的生成式 3D 世界引擎,通过六个核心模块(Image-to-3D、Text-to-3D、Texture Generation、Articulated Object Generation、3D Scene Generation、Layout Generation)生成高质量、交互式 3D 世界,包含高保真 3D 资产(网格和 3DGS)及合理物理属性,支持 URDF 格式并适配多种模拟器(如 OpenAI Gym、MuJoCo)。其核心优势在于解决传统 3D 资产成本高、真实性有限的问题,通过生成式 AI 技术实现物理真实、尺度准确的资产,支持数字孪生、大规模数据增强及具身智能任务(如操控、导航)的训练与评估。

一、核心定位:生成式3D世界引擎,服务具身智能研究

EmbodiedGen 是首个专为具身智能设计的通用3D生成引擎,具备以下三大核心能力:

-

✅ 支持低成本生成大规模3D资产(包括刚体、可动物体、完整场景等);

-

✅ 资产具备真实物理属性与真实世界尺度(支持URDF标准);

-

✅ 可无缝集成至主流物理模拟器(如 OpenAI Gym、MuJoCo、Isaac Lab 等),用于操控、导航、抓取等任务。

二、六大模块构成完整生成链路

EmbodiedGen 提供了从输入(图像/文本/任务描述)到输出(3D资产/可交互场景)的完整流水线,涵盖以下六个模块:

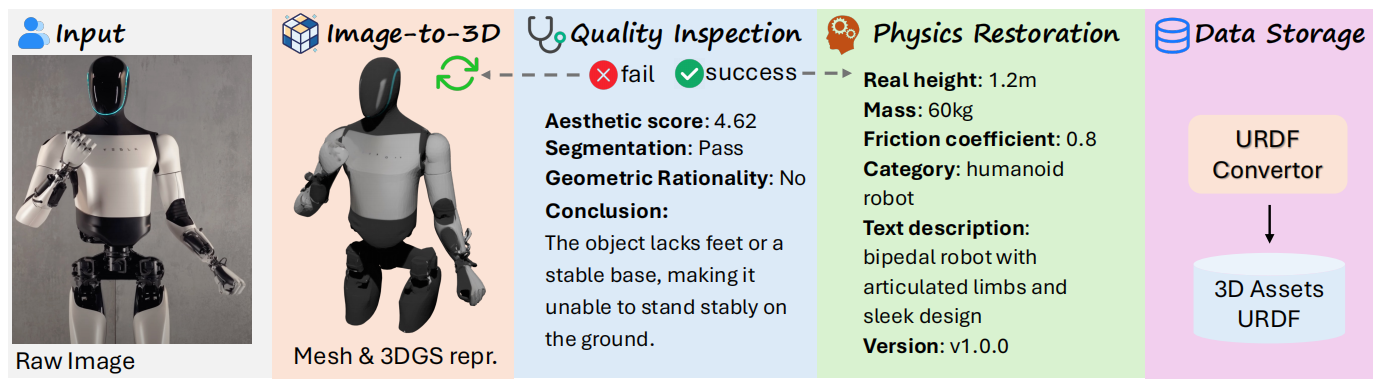

1. Image-to-3D:从图像构建真实世界3D资产

-

基于 Trellis 生成 Mesh 和 3DGS;

-

引入 GPT-4o + Qwen 构建的物理专家系统,估计高度、质量、摩擦系数等;

-

通过自动质检模块(AestheticChecker、ImageSegChecker、MeshGeoChecker)筛查并重试不合格样本;

-

支持生成高保真纹理(使用去高光+超分辨率,2K分辨率UV贴图);

-

输出符合 URDF 格式的资产,可直接用于物理模拟。

📌 实测中,质检模块可实现 68.7% 精确率、76.7% 召回率。

2. Text-to-3D:从自然语言提示生成3D资产

-

采用“两阶段”设计:文本 → 图像(Kolors)→ 3D(复用Image-to-3D);

-

支持中英文提示词,具有较高生成一致性;

-

可扩展性强、模块化好,易于后续替换文本图像模型;

-

支持大规模批量生成 + 自动筛选。

🆚 与 Trellis-text-xlarge 相比,本方法在质量和控制性上均有明显提升。

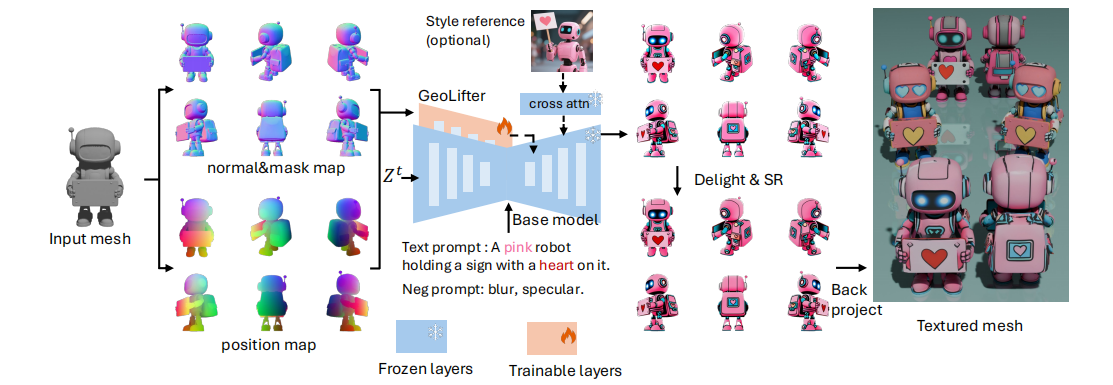

3. Texture Generation:高质量、多风格纹理生成与编辑

-

提出 GeoLifter 模型:将几何控制(法线图、位置信息、遮罩)注入扩散模型;

-

支持文本、图像或两者混合方式控制纹理风格;

-

保证跨视图纹理一致性;

-

支持英文、中文文本直接生成纹理标注(如在机器人身上生成 \"Hello\" 或 “中国”)。

4. Articulated Object Generation:生成可动关节物体

-

基于 DIPO 框架,输入静态+动作图像对,预测物体关节结构;

-

引入 PM-X 数据集(600类多样化关节物体)用于增强训练;

-

支持家具、抽屉、机械臂等复杂结构生成;

-

包含结构推理模块(图注意力),提高连接合理性。

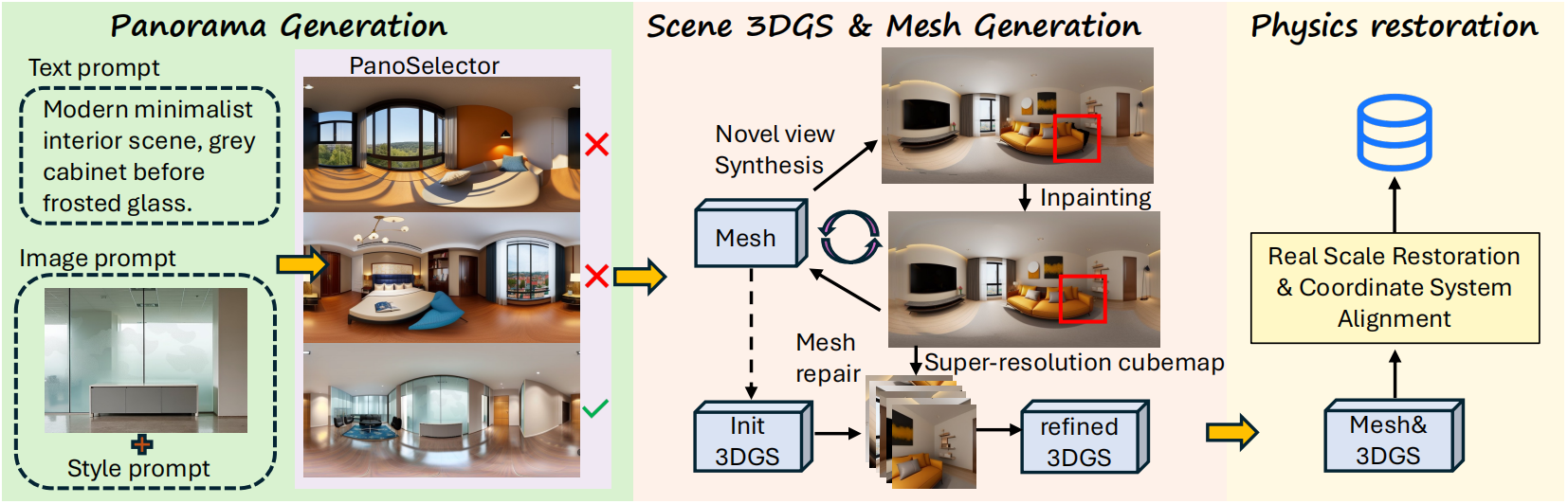

5. 3D Scene Generation:从文本或图像生成完整场景

-

使用 Diffusion360 模型从文本/图像生成全景图;

-

使用 Pano2Room + Qwen 完成物理尺度还原、坐标对齐;

-

输出 Mesh + 3DGS 双表示;

-

使用超分辨率增强视觉细节;

-

引入 Panorama Selector 自动筛除结构质量差的场景。

6. Layout Generation:根据任务描述生成物体布局

-

支持通过任务自然语言(如“机械臂抓取香蕉”)生成物体位置、朝向与物理约束;

-

可快速构建可交互场景,减少人工建模成本。

📌 六大模块小结:

- 物理专家模块恢复真实尺度(如高度、质量)

- 自动化质量检测(美学评分≥4.62 为合格)

- 质量检测召回率 76.7%、精确率 68.7%

- 支持中英双语提示词

- 去高光和超分辨率处理(2K 分辨率)

- PM-X 数据集(600 个多样化关节物体)

- 转换为 3DGS 和网格表示

三、关键技术亮点

四、核心应用场景

✅ 数字孪生

-

从真实图像快速恢复场景/物体,并导入模拟器中;

-

支持闭环评估,如在 Isaac Lab 中进行真实抓取策略仿真测试。

✅ 大规模数据增强

-

支持一次性生成数百类风格资产(如杯子、工具、机器人),提升模型的泛化能力;

-

生成资产具备完整物理属性,可直接用于 RL 或强化学习训练。

✅ 具身智能训练

-

支持导航、操控、抓取等任务场景构建;

-

提供 layout 生成,降低搭建复杂场景的成本;

-

适配主流物理模拟平台如 MuJoCo、OpenAI Gym、Isaac Lab 等。

✅ 高保真模拟渲染:RoboSplatter 模块

-

将 3DGS 渲染与物理模拟结合,兼顾视觉真实与交互物理准确性;

-

替代传统基于 OpenGL 的重建渲染方案,支持高效实时交互。

五、总结:一站式具身智能内容生成平台

EmbodiedGen 不只是一个3D生成工具,而是面向具身智能全流程研究的内容生产基础设施。

它打通了从图像、文本到3D资产、场景再到交互模拟的完整链条,解决了长期制约具身智能研究的数据瓶颈问题,降低了构建高质量仿真环境的门槛,是数字孪生、机器人学习、虚拟环境构建等地方的关键加速器。

📚 参考论文

Xinjie W, Liu L, Yu C, et al. EmbodiedGen: Towards a Generative 3D World Engine for Embodied Intelligence[J]. arXiv preprint arXiv:2506.10600, 2025.