Kafka Connect集群节点异常监控与邮件告警Shell脚本

本文还有配套的精品资源,点击获取

简介:在大数据领域,管理和监控分布式系统至关重要。Kafka Connect用于高效可靠地在Kafka和其他系统间传输数据,需要监控来预防系统故障。本文介绍的shell脚本可以定期检查Kafka Connect集群状态,并在节点出现异常时发送邮件通知。脚本步骤包括状态检查、异常检测、邮件通知、配置化、日志记录和持续运行。通过cron定时任务实现持续监控,压缩包文件包含完整脚本及配置文件,便于用户根据环境修改后直接使用。

1. Kafka Connect集群监控概述

1.1 监控的必要性

在现代企业级应用中,Kafka Connect已成为数据集成和流处理的关键组件。随着业务需求的增长,集群规模扩大,确保集群的高可用性和稳定性变得至关重要。监控Kafka Connect集群不仅可以帮助我们及时发现和解决问题,而且有助于优化性能和资源利用率。

1.2 监控的目标

监控的目标是全面、实时地了解集群的状态,包括节点健康状况、任务进度、数据流入流出情况等关键指标。通过对这些数据的收集和分析,可以建立数据驱动的决策过程,提前预防可能发生的故障,提升用户体验。

1.3 监控的维度

监控可分为多个维度,如性能监控、可用性监控、安全性监控等。性能监控关注集群的吞吐量、延迟和资源使用情况;可用性监控确保集群的持续在线状态;安全性监控则涉及数据的加密和权限控制。各个维度相辅相成,共同构建起全面的集群监控体系。

在接下来的章节中,我们将深入探索节点状态检查与异常检测的理论基础,并逐步介绍如何构建邮件通知机制、设计脚本的可配置性、管理监控脚本的日志记录,以及如何利用定时任务自动化执行监控脚本等关键实践。让我们一起深入了解并掌握Kafka Connect集群的监控之道。

2. 节点状态检查与异常检测的理论基础

在IT行业中,系统的高可用性和稳定性是至关重要的。随着系统的规模不断扩大,我们需要依靠高效的监控系统来确保系统的健康运行。Kafka作为一款高性能的分布式消息系统,Kafka Connect作为其生态系统的一部分,提供了强大的数据集成能力。在本章节中,我们将深入探讨如何对Kafka Connect集群进行节点状态检查和异常检测。

2.1 Kafka Connect集群架构解析

2.1.1 集群组件与工作原理

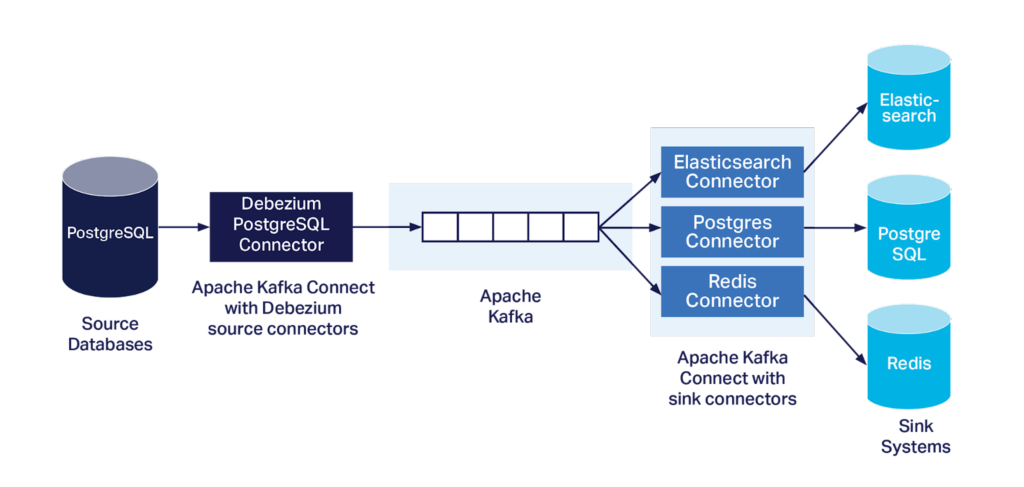

Kafka Connect集群是通过一系列的Connector来实现数据的输入和输出。每个Connector由一个或多个Task组成,每个Task负责实际的数据传输工作。集群中的每个节点都运行一个或多个Connector实例。当一个节点失效时,其他节点上的Connector可以接管失败节点的任务。

集群的工作原理基于以下几个核心组件:

- Source Connector : 从外部系统读取数据并发送给Kafka。

- Sink Connector : 从Kafka读取数据并写入到外部系统。

- Worker Node : 运行Connector任务的节点。

- REST API : 允许用户和外部系统管理和监控Connectors。

- Distributed Mode : Connect集群的工作模式,可以实现故障转移和负载均衡。

2.1.2 节点角色及其重要性

在Kafka Connect集群中,每个节点都扮演着不同的角色,具体包括:

- Coordinator : 负责分配任务给各个节点,同时跟踪任务的状态。它对于保证集群的负载均衡和故障转移至关重要。

- Connector : 作为数据流的入口或出口,负责数据的接入和推送。

- Worker : 运行实际的Connector实例,执行数据传输的任务。

节点的重要性体现在它们共同确保了Kafka Connect集群的高可用性和数据的连续性。如果任何节点失效,集群应能够迅速做出响应,重新分配任务以避免数据丢失。

2.2 节点状态监控的指标与方法

2.2.1 常用监控指标

对Kafka Connect节点进行状态检查时,需要关注以下几个关键指标:

- 任务状态 : 每个任务的运行状态,是否正常运行。

- 队列大小 : 任务队列中的消息数量,若队列过大可能指示性能瓶颈。

- 延迟指标 : 任务处理消息的平均延迟时间。

- 资源使用情况 : 如CPU和内存使用率,以便检测系统是否接近资源限制。

2.2.2 监控方法与技术选型

监控方法的选择依赖于多种因素,比如成本、易用性、扩展性等。以下是一些主流的监控技术:

- Prometheus + Grafana : 这是一种组合方案,Prometheus用于收集指标,Grafana用于可视化展示。

- ELK Stack : Elasticsearch、Logstash和Kibana的组合可以实现日志的聚合、分析和可视化。

- JMX Exporter + Prometheus : 利用Java Management Extensions导出器可以将JMX指标转换为Prometheus格式。

每种技术都有其优势,但总体而言,选择一个稳定且社区支持良好的解决方案对于构建一个可靠的监控系统至关重要。

2.3 异常检测的理论与实践

2.3.1 异常检测算法概述

异常检测是指在海量数据中识别出异常行为或模式的过程。以下是一些基本的异常检测算法:

- 统计学方法 : 使用统计模型如高斯分布来定义正常行为的范围,任何偏离这个范围的行为都被视为异常。

- 基于距离的方法 : 计算数据点与正常数据点之间的距离,如果距离超过阈值则认为是异常。

- 机器学习方法 : 利用分类算法来识别异常,例如随机森林、支持向量机等。

2.3.2 实现异常检测的关键步骤

实现异常检测的关键步骤包括:

- 数据收集 : 收集Kafka Connect节点的性能指标和日志数据。

- 数据预处理 : 清洗和规范化数据,以便模型能更准确地处理。

- 特征选择 : 确定哪些数据特征对于异常检测最为重要。

- 模型训练 : 使用历史数据训练异常检测模型。

- 模型测试 : 在实际数据上测试模型的准确性。

- 模型部署 : 将经过验证的模型部署到生产环境中进行实时异常检测。

通过上述步骤,可以构建一个有效的异常检测系统,该系统能及时发现并响应Kafka Connect集群中的异常行为,保障系统的稳定运行。

3. 异常情况邮件通知机制的实现

3.1 邮件通知机制的原理

3.1.1 邮件发送流程解析

邮件发送是一个涉及多个组件和步骤的复杂过程,从用户的角度来看,邮件发送通常只需要点击一个发送按钮即可完成,但背后涉及的技术和流程要复杂得多。一般而言,邮件发送流程包括以下几个关键步骤:

- 用户邮件客户端(MUA, Mail User Agent) :用户通过邮件客户端(如Outlook, Thunderbird等)撰写邮件,并点击“发送”按钮。

- 邮件传输代理(MTA, Mail Transfer Agent) :邮件客户端将邮件提交到本地的MTA,通常是用户机器上运行的SMTP(简单邮件传输协议)服务。

- 互联网邮件访问协议(IMAP/POP3) :MTA会将邮件传输到接收方邮件服务器,接收方通过IMAP或POP3协议从邮件服务器中获取邮件。

- 用户邮件存储 :接收用户的邮件客户端从邮件服务器下载邮件,并存储在用户的本地设备上。

邮件发送流程通常通过特定的端口来完成,如使用端口25(SMTP)、465或587(SMTP over SSL/TLS)以及110或995(POP3)或143或993(IMAP)。

3.1.2 邮件服务器配置要点

为了能够发送和接收邮件,必须正确配置邮件服务器。这包括设置DNS记录,配置MTA,以及保证服务器安全等。关键配置要点如下:

- MX记录 :确保你的域名有正确的邮件交换(MX)记录。MX记录指明了邮件应该被发送到哪个邮件服务器。

- SPF记录 :设置发件人策略框架(SPF)记录来防止电子邮件地址被伪造。

- DKIM签名 :使用域名密钥标识邮件(DKIM)签名来验证发件人的身份。

- TLS/SSL加密 :使用传输层安全(TLS)或安全套接字层(SSL)来保护邮件内容在传输过程中的安全。

配置邮件服务器是一个细致的工作,需要考虑到服务器的安全性、邮件传输的可靠性以及与其他邮件服务商的兼容性。

3.2 编写邮件发送脚本

3.2.1 脚本中的邮件格式设计

邮件格式设计关系到邮件的呈现方式,包括纯文本和HTML两种格式。纯文本邮件简单明了,适用于所有邮件客户端;HTML邮件则可以包含富文本,包括格式排版、图片等元素。

邮件格式通常由以下部分组成:

- 头部信息 :包括发送者、接收者、邮件主题等。

- 正文内容 :邮件的主体部分,可以是纯文本也可以是HTML格式。

- 附件 :如果有文件需要发送,还可以包括附件。

为了保持邮件内容的可读性和专业性,邮件格式设计应遵循以下原则:

- 使用清晰的标题和主题;

- 确保文字大小、字体和颜色的可读性;

- 适当使用列表和段落,不要过于拥挤;

- 避免发送不必要的附件,减少邮件体积。

3.2.2 脚本中的邮件发送函数实现

脚本中实现邮件发送功能通常依赖于特定的库,例如在Python中可以使用 smtp 库或第三方服务如SendGrid、Amazon SES等来发送邮件。以下是一个使用Python标准库 smtp 发送邮件的简单示例:

import smtplibfrom email.mime.text import MIMETextdef send_email(smtp_server, port, sender_email, sender_password, receiver_email, subject, message): # 创建一个SMTP连接 server = smtplib.SMTP(smtp_server, port) server.starttls() # 对传输的数据进行加密 server.login(sender_email, sender_password) # 登录邮件服务器 # 将文本消息转换为MIMEText对象 msg = MIMEText(message, \'plain\', \'utf-8\') msg[\'From\'] = sender_email msg[\'To\'] = receiver_email msg[\'Subject\'] = subject # 发送邮件 server.sendmail(sender_email, receiver_email, msg.as_string()) # 关闭连接 server.quit()# 邮件发送示例send_email( \'smtp.example.com\', 587, \'sender@example.com\', \'yourpassword\', \'receiver@example.com\', \'Test Subject\', \'This is a test email message.\') 在这个函数中,首先使用SMTP协议创建了一个到邮件服务器的连接,然后使用 starttls() 方法加密了这个连接。通过 login() 方法提供了身份验证,然后创建了一个MIMEText对象,包含邮件的主体内容,之后调用 sendmail() 方法发送邮件。最后,关闭了连接以释放资源。

3.3 异常通知的定制化处理

3.3.1 通知内容与格式的定制

为了使异常通知更具有可读性和实用性,需要对通知的内容和格式进行定制。定制化处理的关键在于根据不同的异常类型和接收者的角色定制不同的通知内容。

通知内容的定制通常包括以下几个方面:

- 异常摘要 :提供异常的简洁摘要,方便接收者快速了解问题。

- 详细信息 :提供异常的详细信息,包括错误代码、时间戳、异常堆栈跟踪等。

- 建议措施 :根据异常的类型提供相应的解决方案或建议的应对措施。

- 后续步骤 :指导用户如何跟踪问题,或者如何将问题上报给相应的技术人员。

通知格式的定制则需要确保格式的可读性,以及在不同设备上的一致性。例如,HTML格式的邮件可以更好地控制布局和样式,适应多种设备和邮件客户端。

3.3.2 多用户告警策略的实现

在许多应用场景中,单一接收者模式的邮件通知往往不足以满足需求。例如,可能需要同时通知多个相关用户,或者根据用户的职责来确定通知内容。因此,实现多用户告警策略是至关重要的。

以下是实现多用户告警策略的几种方式:

- 邮件列表 :创建一个邮件列表,并将所有相关用户添加到这个列表中。发送邮件到这个列表即可同时通知所有成员。

- 条件分发 :根据接收者的角色或职责来决定发送通知的条件。可以编写逻辑判断来确定哪些用户应该收到通知。

- 动态订阅 :允许用户根据自己的需要订阅或取消订阅特定的异常通知。

在实现这些策略时,还应该考虑到邮件的优先级设置,如高优先级邮件应该立即通知,低优先级邮件则可安排在非工作时间发送。这样既保证了紧急问题的及时通知,也避免了不必要的打扰。

4. 脚本的可配置性设计

在复杂的IT环境中,监控脚本的灵活性和可维护性是至关重要的。脚本的可配置性设计不仅可以帮助管理员轻松地修改脚本行为,以适应不同的监控需求,还可以提高脚本的安全性和可靠性。本章将深入探讨配置文件的作用与结构,实现脚本参数的动态配置,以及配置信息的安全管理。

4.1 配置文件的作用与结构

4.1.1 配置文件的必要性分析

配置文件是监控脚本灵活性的核心所在。它们允许管理员指定参数,如连接信息、阈值、告警规则等,而无需修改代码本身。这种解耦合的方法不仅简化了维护工作,还加快了新环境的部署过程。例如,如果监控脚本需要在多个不同的Kafka集群上运行,管理员只需更改配置文件中的连接细节,而无需重新编写代码。

配置文件还提供了灵活性,允许脚本根据不同的环境或策略执行不同的操作。此外,配置文件可以集中管理,这意味着可以统一控制多个脚本实例的配置,这对于大型分布式系统尤为重要。

4.1.2 配置文件的结构设计

配置文件通常由一系列键值对组成,这些键值对定义了监控脚本运行所需的参数。结构设计应该遵循易于理解、易于维护和扩展性好的原则。

假设我们使用JSON格式的配置文件,下面是一个简化的配置文件示例:

{ \"kafka_connect\": { \"server\": \"localhost:8083\", \"username\": \"admin\", \"password\": \"admin123\", \"poll_interval\": 30 }, \"alerting\": { \"email\": { \"from\": \"monitor@example.com\", \"to\": [\"admin@example.com\"], \"smtp\": { \"server\": \"smtp.example.com\", \"port\": 587, \"credentials\": { \"username\": \"alert_user\", \"password\": \"alert_pass\" } } } }} 在这个结构中,我们定义了两个主要部分: kafka_connect 和 alerting 。 kafka_connect 部分包含连接到Kafka Connect集群所必需的信息,而 alerting 部分则包含了所有与异常邮件通知相关的配置。这种结构不仅逻辑清晰,而且易于扩展。例如,如果将来需要支持其他类型的告警方式,我们可以简单地在这个配置文件的 alerting 部分添加新的配置项。

4.2 实现脚本参数的动态配置

4.2.1 参数读取机制

为了实现参数的动态配置,监控脚本需要具备读取配置文件的能力。在Python中,这可以通过标准库中的 json 模块或第三方库如 configparser 实现。下面是一个读取JSON格式配置文件的示例代码:

import jsondef load_config(config_path): with open(config_path, \'r\') as config_file: config_data = json.load(config_file) return config_dataconfig_data = load_config(\'monitoring_config.json\')4.2.2 动态配置对脚本的灵活性提升

动态配置的引入显著提升了脚本的灵活性。例如,如果我们想改变检查连接的间隔时间,我们不需要重新启动监控脚本,只需要在配置文件中修改 kafka_connect 部分的 poll_interval 值,并保存文件。下一次脚本执行时,将自动读取新的值并使用它。

此外,动态配置也使得监控脚本能够适应不同环境的变化,不需要每次都进行手动干预。这意味着监控策略可以根据实际需要快速调整,提升了监控系统的响应速度和适应性。

4.3 配置信息的安全管理

4.3.1 加密存储配置信息

由于配置文件中可能包含敏感信息,如数据库密码或API密钥,因此必须保证这些信息的安全。一种常见的做法是使用加密技术来保护配置文件。

在Python中,可以使用 cryptography 库来加密和解密文件。下面是一个使用AES加密算法加密JSON格式配置文件的示例:

from cryptography.fernet import Fernet# 生成密钥key = Fernet.generate_key()cipher_suite = Fernet(key)# 加密数据encrypted_data = cipher_suite.encrypt(json.dumps(config_data).encode())# 将密钥和加密后的数据保存到文件with open(\'encrypted_config.key\', \'wb\') as key_file: key_file.write(key)with open(\'encrypted_config.bin\', \'wb\') as file: file.write(encrypted_data)4.3.2 权限控制与访问管理

除了加密配置信息外,还应该实施权限控制和访问管理,以确保只有授权的用户才能访问配置文件。这可以通过Linux的文件权限系统来实现。例如,可以限制对配置文件的访问权限,只允许监控服务的运行用户和管理员读取配置文件。

chmod 640 monitoring_config.json这将设置配置文件的权限,使得文件所有者和所属组的成员可以读写,而其他用户只能读取。这样的权限设置可以避免不相关用户偶然地或恶意地查看或修改配置信息。

通过上述的章节内容,我们不仅介绍了配置文件在监控脚本中的重要作用,还展示了如何实现脚本参数的动态配置,以及如何安全地管理配置信息。这些内容对任何希望提高其IT监控系统的灵活性和安全性的管理员来说都是宝贵的资源。

5. 监控脚本的日志记录机制

在实现高效和可靠的监控系统时,日志记录是一项基础且关键的任务。它能够记录系统的运行状态、记录错误信息、以及跟踪各种异常情况。日志的使用不仅仅限于问题发生时的诊断,还涉及到性能分析、统计、合规性检查等多个方面。监控脚本在这一过程中扮演着至关重要的角色,其日志记录机制需要经过精心设计和优化。

5.1 日志记录的重要性与目的

5.1.1 日志记录在监控中的作用

日志记录是监控系统的眼睛和耳朵,它为系统管理员提供了关键信息,包括但不限于:

- 系统运行状态 :通过日志文件,管理员可以了解系统在各个时间点的运行状态和行为。

- 错误诊断 :在遇到错误或者异常时,日志记录是查找和解决问题的主要手段。

- 性能分析 :通过分析日志记录,可以发现系统运行瓶颈和性能问题。

- 安全审计 :日志可以记录敏感操作和访问,帮助进行安全审计和事故追溯。

- 合规性保证 :对于需要符合特定合规性标准的系统,日志记录是必不可少的。

5.1.2 日志级别与日志格式设计

有效的日志记录需要有良好的结构和清晰的级别划分。典型的日志级别包括:

- DEBUG :提供详细的调试信息,主要用于开发和测试阶段。

- INFO :记录系统运行的基本信息,如正常启动、停止等。

- WARN :记录潜在的问题,可能不一定是错误,但需要引起注意。

- ERROR :记录错误和异常情况,通常需要人工介入处理。

- FATAL :记录严重的错误,导致系统无法继续运行。

日志格式设计应该包含时间戳、日志级别、日志消息和可能的其他元数据(如来源文件名、行号等),以便于分析和自动化处理。例如:

{ \"timestamp\": \"2023-04-05T12:00:00.000Z\", \"level\": \"ERROR\", \"message\": \"Failed to connect to database.\", \"source\": \"monitor_script.py:102\"}5.2 日志文件的管理策略

5.2.1 日志轮转与压缩机制

随着时间推移,日志文件会迅速增长,消耗大量的存储空间,因此日志轮转(log rotation)是必要的。轮转操作通常包括以下几个步骤:

- 归档 :将当前正在写的日志文件进行归档处理,便于后续的查阅和备份。

- 新文件创建 :开始一个新的日志文件继续记录日志。

- 压缩 :旧的归档日志文件可以进行压缩处理以节省存储空间。

大多数系统和日志管理工具都支持自动轮转功能。例如,使用 logrotate 工具,可以通过配置文件设置轮转的条件,如时间、大小和保留的归档数量。

5.2.2 日志分析与审计

日志的分析和审计工作通常使用专门的日志分析工具完成,比如 Elasticsearch、Splunk、Graylog 等。这些工具不仅可以帮助进行实时的日志搜索和分析,还能够利用机器学习等先进技术预测系统未来的运行趋势。

审计过程中,需要关注以下几个方面:

- 合规性 :确保日志记录满足相关的法律法规要求。

- 安全性 :监控非法访问和操作,确保系统安全。

- 性能 :分析日志以发现性能瓶颈和优化点。

- 可用性 :监控系统的健康状态和可用性指标。

5.3 实现日志的分级记录与报警

5.3.1 日志分级记录方法

根据日志级别不同,可以将日志记录到不同的文件或系统中。例如,可以设置一个文件专门记录所有级别高于或等于 ERROR 的日志,而另一个文件记录所有级别的日志。这种分级记录的方法可以降低后期分析的复杂度,并帮助更快地定位问题。

在实现时,监控脚本通常通过配置文件来控制日志的记录级别和目标,这样在不同的运行环境或者维护阶段可以灵活地调整日志策略。

5.3.2 异常日志的实时报警机制

实时报警是监控系统的关键特性之一。当监控脚本检测到异常级别的日志时,应当立即触发报警通知。这可以通过多种方式实现,如:

- 邮件通知 :将异常信息通过邮件发送给管理员或相关责任人。

- 短信或即时通讯工具 :使用 API 将报警信息发送到 SMS 或 Slack、微信等即时通讯工具。

- 运维监控平台 :将报警信息推送到运维监控平台,如 Prometheus Alertmanager、Zabbix 等。

下面是一个简单的 Python 脚本示例,用于发送电子邮件通知:

import smtplibfrom email.mime.text import MIMETextfrom email.header import Headerdef send_email(host, port, sender, receivers, subject, text): msg = MIMEText(text, \'plain\', \'utf-8\') msg[\'From\'] = Header(sender) msg[\'To\'] = Header(receivers) msg[\'Subject\'] = Header(subject, \'utf-8\') try: server = smtplib.SMTP_SSL(host, port) server.login(sender, \'your_password\') server.sendmail(sender, receivers, msg.as_string()) server.quit() print(\"Mail Send Successfully\") except smtplib.SMTPException as e: print(\"Error: unable to send email\", e)if __name__ == \"__main__\": # 配置信息 host = \'smtp.example.com\' port = 465 sender = \'admin@example.com\' receivers = \'receiver@example.com\' subject = \'Kafka Connect Cluster Alert\' text = \'An alert has been triggered in the Kafka Connect cluster.\' # 发送邮件 send_email(host, port, sender, receivers, subject, text) 在使用以上代码时,需要替换相应的地方以配置正确的主机、端口、发送者、接收者以及邮件内容。代码中通过 smtplib 库提供了发送邮件的功能,使用 MIMEText 来创建邮件的正文,并通过 SMTP_SSL 保证传输过程的安全性。

通过这样的日志记录和报警机制,监控脚本能够在问题发生时迅速通知相关人员,从而减少系统故障对业务的影响。

6. 定时任务自动执行监控脚本

在自动化监控系统中,定时任务是关键组件,它负责按照预定的时间间隔自动执行监控脚本,以确保实时跟踪集群状态并及时发现潜在的问题。本章将详细探讨定时任务的配置与优化,以及监控脚本在不同环境下的部署策略。

6.1 定时任务的必要性与配置

6.1.1 自动执行监控脚本的必要性分析

在日常维护中,手动运行监控脚本是一种低效且容易出错的做法。定时任务可以确保监控脚本在没有人工干预的情况下按计划执行,从而减少人为的疏漏和误操作。它还支持监控脚本的连续执行,这对于实时监控系统来说至关重要。

6.1.2 定时任务配置方法(如Cron的使用)

Linux系统中常见的定时任务配置工具是Cron。Cron通过编辑crontab文件来设置定时任务。下面是一个Cron配置的简单示例:

# 进入Cron编辑模式crontab -e# 添加定时任务(例如,每天凌晨1点执行一次脚本)0 1 * * * /path/to/your/script.shCron表达式由六个或七个字段组成,表示分钟、小时、日、月、星期几(可选),和年份(可选):

* * * * * *| | | | | || | | | | +-- Year (optional)| | | | +---- Day of the Week (0 - 7) (Sunday=0 or 7)| | | +------ Month (1 - 12)| | +-------- Day of the Month (1 - 31)| +---------- Hour (0 - 23)+------------ Minute (0 - 59)6.2 监控脚本与定时任务的协同工作

6.2.1 脚本的后台运行与调度

为了使监控脚本在后台运行,通常需要将其设置为守护进程。这可以通过在脚本中添加特定的命令来实现,或者将其配置为服务来管理。在Cron任务中,可以通过在命令末尾添加 & 符号使脚本在后台运行。

6.2.2 监控频率与执行时间的优化

监控频率的设置对于系统性能和准确性至关重要。频率设置得太低,可能会导致异常情况无法及时发现;设置得太高,可能会对系统资源造成不必要的负担。通常,监控频率需要根据实际业务需求、系统性能和监控脚本的执行时间来决定。

6.3 监控脚本在不同环境下的部署

6.3.1 单机部署与集群部署的区别

单机部署适用于小型系统,所有的监控脚本都在同一台机器上运行。而在集群部署中,监控脚本需要分配到不同的节点上执行。集群部署可以显著提高监控的可靠性和扩展性。

6.3.2 分布式监控的实施策略

分布式监控策略要求监控任务能够在整个集群中均匀分布,这样可以避免单点故障并提高监控效率。这可能需要集成更高级的调度工具,如Ansible、Kubernetes或其他自动化部署工具,以实现任务的智能调度和故障转移。

分布式监控的流程图

下面是一个简单的流程图,展示了分布式监控任务的调度过程:

graph TD; A[开始] --> B{检查集群状态} B --> |状态正常| C[分配监控任务] B --> |状态异常| D[执行故障处理] C --> E[监控脚本执行] E --> F{任务完成} F --> |是| G[记录监控结果] F --> |否| C[重新分配监控任务] D --> H[警报系统] H --> I[通知管理员] I --> J[手动干预或自动修复] J --> K[任务完成] K --> B[检查集群状态]分布式监控脚本的配置示例

#!/bin/bash# 分布式监控脚本配置示例# 节点列表NODE_LIST=(\"node1\" \"node2\" \"node3\")# 节点监控函数monitor_node() { local node=$1 echo \"开始监控节点: $node\" # 执行监控操作 # 此处添加实际监控命令}# 主循环,分配监控任务到各个节点for node in \"${NODE_LIST[@]}\"; do monitor_node $node &done以上是一个简单的分布式监控脚本示例,脚本使用了后台进程来并行监控多个节点。

在本章中,我们详细分析了定时任务的配置方法和监控脚本的协同工作,并探讨了不同环境下监控脚本的部署策略。通过合理配置定时任务和监控脚本,可以极大地提升Kafka Connect集群的监控效率和可靠性。

7. 综合案例分析与优化建议

7.1 实际案例分析

7.1.1 集群监控脚本的部署与运行

在实际环境中,Kafka Connect集群监控脚本的部署与运行是确保系统稳定性和可靠性的重要一环。部署监控脚本通常涉及到配置文件的编辑、执行权限的调整以及监控计划的设置。

# 示例:在Linux环境下部署监控脚本cp kafka_connect_monitor.sh /opt/kafka_connect/bin/chmod +x /opt/kafka_connect/bin/kafka_connect_monitor.shecho \"*/5 * * * * /opt/kafka_connect/bin/kafka_connect_monitor.sh\" > /etc/cron.d/kafka_connect_monitor上述代码块显示了如何将监控脚本部署到指定目录,并通过Cron定时任务来每五分钟执行一次监控脚本,确保对集群的持续监控。

7.1.2 邮件通知与日志记录的实际应用

邮件通知和日志记录在监控脚本中扮演了非常重要的角色。邮件通知机制可以确保异常情况能够迅速被管理员知晓,而日志记录则为事后的分析和审计提供了基础数据。

# 邮件通知脚本示例send_email() { local message=$1 echo \"To: admin@example.com\" | mail -s \"Kafka Connect Alert\" \"$message\"}# 日志记录示例log_event() { local message=$1 echo \"$(date \'+%Y-%m-%d %H:%M:%S\') - Kafka Connect Alert: $message\" >> /var/log/kafka_connect.log}以上代码展示了如何设计邮件发送函数和日志记录函数,将关键信息及时通知给管理员并记录在系统日志中。

7.2 监控效果评估与优化

7.2.1 效果评估方法

监控效果的评估需要关注多个方面,如监控范围的完整性、告警准确率、日志信息的详尽程度以及系统响应时间等。通过对这些方面进行定期的检查与评估,可以保证监控系统的效果始终符合预期。

graph TD A[开始评估] --> B[检查监控范围] B --> C[分析告警准确性] C --> D[评估日志记录完整性] D --> E[监测系统响应时间] E --> F[输出评估报告]7.2.2 优化建议与实施步骤

优化建议的制定应基于评估结果。例如,若发现某些重要指标未被纳入监控范围,需要添加相应的监控指标。若发现告警准确率不高,应考虑优化异常检测算法或调整告警阈值。

**步骤 1**: 识别监控盲点**步骤 2**: 优化异常检测算法**步骤 3**: 调整告警阈值**步骤 4**: 重新部署监控脚本**步骤 5**: 进行效果再评估7.3 未来发展方向与展望

7.3.1 监控技术的最新趋势

随着技术的进步,未来监控技术可能会包括机器学习在内的人工智能技术,以实现更智能的异常行为预测和自动故障定位。这些技术能够减少人为干预,并提高整体的监控效率。

7.3.2 长期监控与维护策略

在长期监控的过程中,应制定一套周密的维护策略,包括定期更新监控脚本、持续教育维护人员以及建立健全的变更管理流程。此外,还应考虑监控系统的可扩展性,确保在系统规模增长时能够快速适应新的监控需求。

在维护策略中,还要确保监控系统的安全性,定期进行安全审计和漏洞检测,以防止安全事件的发生。

本文还有配套的精品资源,点击获取

简介:在大数据领域,管理和监控分布式系统至关重要。Kafka Connect用于高效可靠地在Kafka和其他系统间传输数据,需要监控来预防系统故障。本文介绍的shell脚本可以定期检查Kafka Connect集群状态,并在节点出现异常时发送邮件通知。脚本步骤包括状态检查、异常检测、邮件通知、配置化、日志记录和持续运行。通过cron定时任务实现持续监控,压缩包文件包含完整脚本及配置文件,便于用户根据环境修改后直接使用。

本文还有配套的精品资源,点击获取