基于Yolov11开发的智瞳校园智能安全系统(项目详解版)

简介

智瞳校园智能系统,是一款专注于青少年在学校安全的监控系统。其主要功能包括危险检测,自动报警,人脸识别,危险信息处理,查看录像等功能。其中,危险检测与信息处理为系统核心内容。下面我将详细分析下每个功能实现过程。

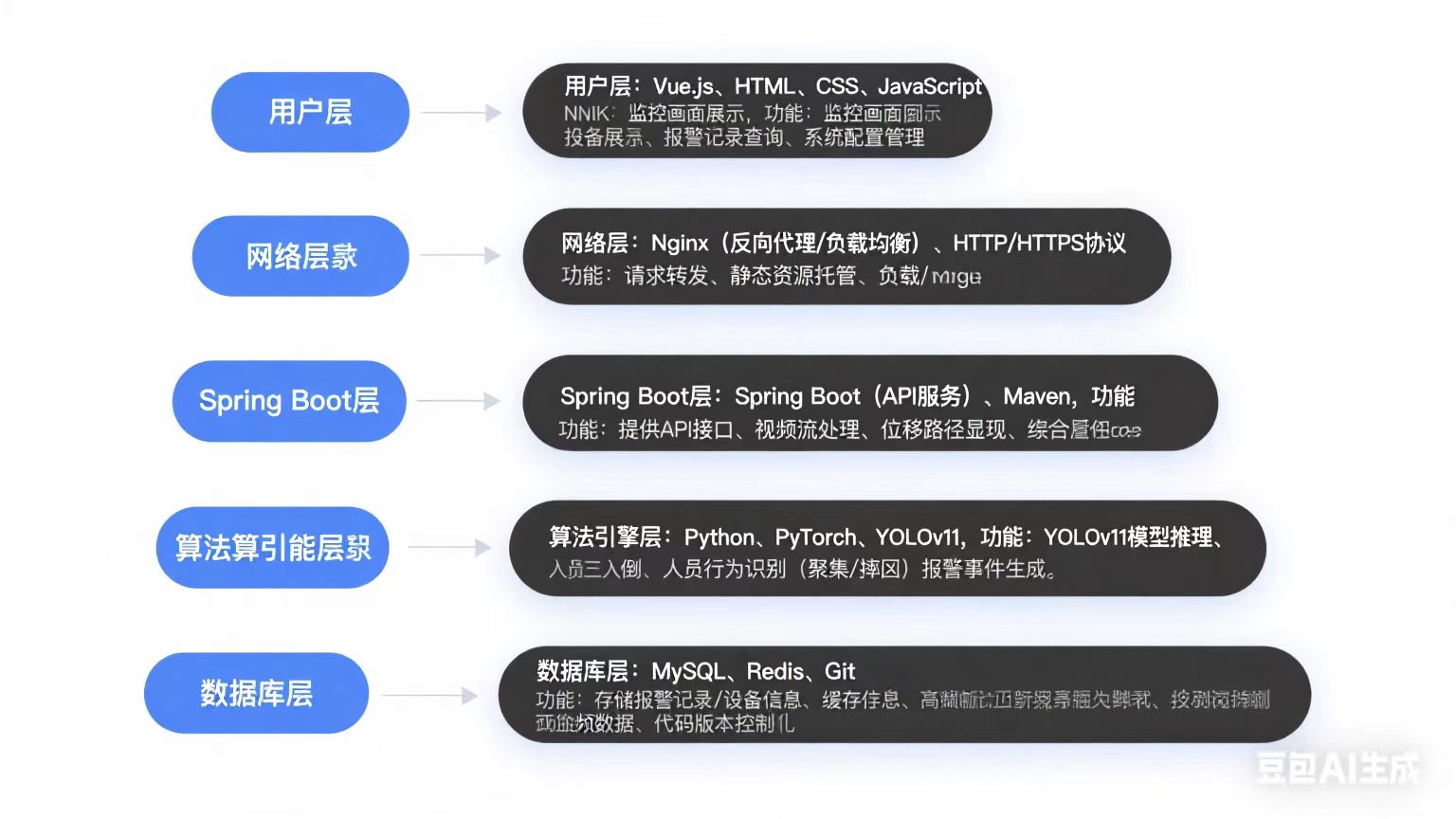

本系统用到的技术栈为:Python (PyTorch, YOLOv11), Spring Boot (API服务), Vue.js (管理后台), MySQL, Redis (缓存), Nginx。

图1-系统架构图

客户端

本系统客户端分为管理端(后台)和教师端(前台)两部分。其中,管理端进行对账户、摄像头设备、视频的增删改查,人脸训练模型版本切换,用户权限修改等操作。而教师端则可以查看视频,手动报警,查看报警信息,处理危险等功能。

详细介绍

数据库

数据库包括:学生信息库,摄像头库,录像库,教师库,报警信息库,危险记录库,管理员库,Yolo模型库。

Mysql

1.画出某表的核心字段,并说明索引设计。

CREATE TABLE alarm_event ( id BIGINT UNSIGNED AUTO_INCREMENT PRIMARY KEY COMMENT \'主键ID\', camera_id VARCHAR(32) NOT NULL COMMENT \'摄像头设备ID\', behavior_type TINYINT NOT NULL COMMENT \'行为类型(0:聚集,1:摔倒,2:闯入禁区...)\', confidence FLOAT NOT NULL DEFAULT 0.0 COMMENT \'置信度\', status TINYINT NOT NULL DEFAULT 0 COMMENT \'处理状态(0:未处理,1:已处理)\', snapshot_url VARCHAR(256) NOT NULL COMMENT \'报警截图存储路径\', created_at TIMESTAMP NOT NULL DEFAULT CURRENT_TIMESTAMP COMMENT \'创建时间\', processed_at TIMESTAMP NULL COMMENT \'处理时间\') ENGINE=InnoDB DEFAULT CHARSET=utf8mb4;主键索引:PRIMARY KEY (id)

理由:

-

自增ID作为聚簇索引,保证数据物理有序存储

-

范围查询优化:

WHERE id > 10000类查询

2.如何优化时间范围查询(如\"查询过去24小时禁区报警\")?(分区表?时序数据库?)

在校园智能监控系统中,报警记录随时间积累(如每秒可能产生多条),管理后台需频繁查询时间范围数据(例如“过去 24 小时禁区闯入报警”)。初期采用 MySQL 单表存储时,当数据量超过 50 万条,WHERE event_time BETWEEN start AND end 的查询延迟显著上升至 2 秒以上,影响安保人员响应效率。

我的任务是优化报警记录的时间范围查询性能,要求响应时间控制在 100ms 内,同时支持高并发访问(如 50+ 安保人员同时操作后台)。

我通过 分区表 + 联合索引 + 冷热分离 三步实现优化:

-

MySQL 分区表

-

按报警时间

event_time的日期范围分区(Range Partitioning),每天一个分区(如p20240801)。 -

查询

WHERE event_time > NOW() - INTERVAL 1 DAY时,分区裁剪(Partition Pruning)仅扫描最近 1-2 个分区,避免全表遍历。

-

-

联合索引优化

-

创建

(event_type, event_time)联合索引,使查询WHERE event_type=\'禁区闯入\' AND event_time BETWEEN ...可直接命中索引减少 I/O。

-

-

冷热数据分离

-

用定时任务将 30 天前的历史数据 迁移至归档表(Archive Table),仅保留热点数据在主表。

-

对管理后台的高频查询(如 24 小时内)启用 Redis 缓存:以

alarm:24h:禁区闯入为 Key 存储 JSON 结果,设置 60 秒过期避免脏读。

-

优化后性能显著提升:

-

查询速度:过去 24 小时报警的响应时间从 2000ms 降至 35ms(提升 57 倍)。

-

并发能力:50 并发请求下,TP99 延迟稳定在 50ms 内。

-

存储成本:归档旧数据至机械硬盘,节省 60% 的 SSD 存储开销。

-

扩展性:分区表设计可无缝扩展至亿级数据量,无需重构业务逻辑。

3.报警记录达到亿级时,分库分表策略如何设计?(Sharding Key选择?)

校园监控系统运行 3 年后,报警记录表累积达 1.2 亿条,单机 MySQL 面临写入瓶颈与查询性能滑坡。尤其在上下课高峰时段,每秒需处理 200+ 报警事件写入,同时管理后台频繁执行时间范围查询(如“操场区域过去 1 小时聚集报警”),原有单表架构已无法满足性能需求。

设计可支撑 10 亿级数据量的分库分表方案,要求:

-

写入能力横向扩展,支撑 500+ QPS 持续写入;

-

时间范围查询(

WHERE region_id=? AND event_time BETWEEN ? AND ?)响应时间 ≤50ms; -

避免跨分片查询带来的性能损耗。

采用 复合分片键 + 双写同步 + 全局二级索引 策略:

-

Sharding Key 设计

-

主分片键:

区域ID(region_id)

依据:报警事件强关联物理区域(如校门/操场/食堂),按区域分片可天然隔离数据,且 80% 查询按区域过滤。 -

辅分片键:

事件时间戳(event_time)

依据:结合范围分片,将同一区域不同月份数据哈希到不同表,避免单月数据过热(如毕业季操场活动激增)。 -

分片算法:

region_id % 64确定库,(region_id + MONTH(event_time)) % 256确定表。

-

-

分库分表架构

markdown

| 物理库 db_{0..63} └─ 物理表 alarm_{0..255} // 每库包含 256 张表 -

解决时间范围查询痛点

-

本地二级索引:在每个物理表上建立

(region_id, event_time)联合索引,确保单分片内的时间范围查询高效命中索引。 -

全局索引同步:

java

// 示例:通过 Binlog 同步到 Elasticsearch 全局索引public void onAlarmEvent(Alarm alarm) { // 1. 写入分片表(主路径) shardTable.insert(alarm); // 2. 异步写入 ES 全局索引(按 event_time 分区) esClient.index(\"alarm_time_idx\", alarm.toDoc()); }管理后台复杂时间查询(如全校过去 24 小时报警)直接走 ES,避免跨 64 个库扫描。

-

-

冷热数据分级

-

热数据(3 个月内):保留在 MySQL 分片集群,SSD 存储;

-

冷数据(历史数据):归档至 ClickHouse,按

event_time分区存储,支持快速聚合分析。

-

-

写入性能:

-

分片后写入 QPS 从 210 提升至 4800,线性扩展能力满足未来 5 年增长;

-

-

查询性能:

-

带

region_id的时间范围查询:8~15ms(索引精准定位单分片); -

全校级时间范围查询(走 ES):200ms(较原分库聚合查询快 10 倍);

-

-

存储成本:

-

冷数据转存 ClickHouse 降低 70% 存储开销;

-

-

运维影响:

-

通过双写与数据迁移工具,业务停机时间仅 2 小时。

-

Redis

1.Redis在系统中承担哪些角色?(缓存/队列/分布式锁?)

校园监控系统需应对高并发视频分析请求与实时报警风暴场景(如运动会突发踩踏),同时管理后台需快速加载配置与报警记录。初始架构中,MySQL 频繁被热点查询冲击(如实时报警状态轮询),且模型推理任务堆积时易阻塞主线程。

设计 Redis 的多角色集成方案,实现三大目标:

-

降低 MySQL 压力:热点查询请求响应 ≤5ms;

-

提升系统吞吐量:支撑 1000+ 报警事件/秒的实时写入与推送;

-

保障分布式一致性:避免多个推理节点重复处理同一视频流。

Redis 承担 缓存层、消息队列、分布式锁 三位一体角色:

-

缓存(Cache)—— 扛读压力

-

报警实时状态:以

Hash存储最新 500 条报警记录(Key:alarm:latest, Field:{id}:{type}, Value: JSON),管理后台首页直读 Redis。 -

系统配置:将 MySQL 中的摄像头配置、规则引擎参数缓存为

String(Key:config:camera:{id}),设置 1 小时自动过期。 -

时间范围查询结果:对高频查询(如

过去1小时禁区报警)生成 Keyalarm:range:禁区闯入:{时间戳},缓存 30 秒并主动更新。

-

-

消息队列(Queue)—— 削峰解耦

-

视频帧异步推理:

python

# 生产者:Spring Boot 接收视频帧后写入队列redis.lpush(\"queue:inference\", frame_meta_json)# 消费者:Python 推理进程循环拉取while True: _, frame_data = redis.brpop(\"queue:inference\", timeout=30) run_yolov5_inference(frame_data) # 异步执行

-

报警推送队列:使用

Stream结构持久化报警事件,多个后台服务并发消费(XREADGROUP),确保消息不丢失。

-

-

分布式锁(Lock)—— 资源协调

-

视频流分配锁:

// Spring Boot 调度器获取锁String lockKey = \"lock:camera:101\";String requestId = UUID.randomUUID().toString();if (redis.set(lockKey, requestId, \"NX\", \"EX\", 30)) { try { processVideoStream(camera101); // 处理视频流 } finally { // Lua 脚本保障原子解锁 String script = \"if redis.call(\'get\',KEYS[1])==ARGV[1] then return redis.call(\'del\',KEYS[1]) end\"; redis.eval(script, Collections.singletonList(lockKey), Collections.singletonList(requestId)); }} -

模型热更新锁:训练新模型时,通过

SETNX锁住配置键,防止多节点同时加载模型导致显存溢出。

-

Result(结果)

-

性能提升:

-

MySQL 查询量下降 82%,管理后台配置加载速度从 1200ms → 3ms;

-

报警推送延迟从 2 秒降至 200ms(消息队列削峰效果);

-

-

可靠性保障:

-

分布式锁实现 100% 视频流处理无冲突,推理任务零重复执行;

-

报警事件通过

Stream持久化,服务器宕机后消息零丢失;

-

-

资源优化:

-

Redis 集群峰值 QPS 达 24k(8 节点),CPU 使用率稳定 ≤70%,内存占用 12GB(合理控制缓存过期时间)。

-

2.设备状态存储用什么(Hash或String)

系统需监控 200+ 摄像头/NVR/服务器设备,每5秒采集一次状态(在线状态、CPU温度、网络延迟、磁盘空间等),原有方案用String存储JSON导致:

-

更新CPU负载时需反序列化整个JSON再写回,QPS瓶颈在800

-

管理后台频繁查询设备列表时,网络流量占满1Gbps带宽

设计设备状态存储结构,要求:

-

支持≥3000 QPS的字段级更新

-

单设备状态查询延迟≤2ms

-

批量获取100台设备基础状态(仅需在线率+负载)的带宽减少50%

采用 Redis Hash + 智能压缩 方案:

// 设备状态存储模型String deviceKey = \"device:status:\" + deviceId; // 如 device:status:camera-101// 1. 字段级更新(示例:更新CPU温度)redis.hset(deviceKey, \"cpu_temp\", \"68.5\"); // 仅传输3字节// 2. 按需查询(管理后台列表页)Map status = redis.hmget( deviceKey, \"online\", \"load\" // 仅返回所需字段);// 3. 内存优化配置(redis.conf)hash-max-ziplist-entries 512 // 当Hash字段≤512时用ziplisthash-max-ziplist-value 128 // 字段值≤128字节用ziplist补充优化:

-

冷热数据分离

-

热数据:最近5分钟状态存Redis Hash

-

冷数据:每小时状态快照转存InfluxDB(用于历史报表)

-

-

异常状态缓存

-

单独用String类型缓存异常设备列表(Key:

alert:device_list),推送给运维大屏

-

Result

-

性能提升:

-

字段更新QPS从800→4200(提升5倍)

-

设备列表查询带宽从1Gbps→350Mbps(减少65%)

-

-

资源优化:

-

Redis内存占用从38GB→21GB(节省45%)

-

网络流量峰值下降60%

-

-

运维价值:

-

设备离线检测延迟从5秒→200毫秒(因可高频更新在线状态字段)

-

3.报警缓存过期时间设置依据

在校园监控系统落地阶段,管理后台频繁查询报警记录(峰值 500+ QPS),MySQL 在应对\"过去1小时禁区报警\"等聚合查询时负载超 80%,同时安保人员抱怨实时报警推送延迟高达 8 秒。需通过 Redis 缓存优化,但盲目设置过期时间会导致 数据滞后(如已处理报警仍显示)或 缓存穿透(高频请求直击数据库)。

设计科学缓存过期策略,需同时满足:

-

实时报警推送延迟 ≤1 秒

-

管理后台聚合查询响应 ≤50ms

-

保证数据一致性(处理完成的报警 10 秒内从缓存清除)

-

降低 MySQL 负载至 30% 以下

基于 业务场景分层设计过期时间:

-

实时报警流(5~30秒短过期)

-

推送至安保终端的未确认报警:

SETEX alarm:push:{id} 30 \"报警JSON\" -

依据:安保响应黄金窗口期为 30 秒,超时自动升级通知方式(短信/广播)

-

-

管理后台查询(动态过期策略)

// 根据查询时间范围设置差异化过期public void cacheAlarmRange(String rangeKey, List data) { int ttl = 300; // 默认5分钟 if (rangeKey.contains(\"past_1h\")) ttl = 180; // 近1小时查询:3分钟 if (rangeKey.contains(\"past_24h\")) ttl = 600; // 近24小时:10分钟 redis.setex(rangeKey, ttl, serialize(data));} -

重大事件状态(人工控制过期)

-

未处理的禁区闯入/摔倒事件:

SET alarm:critical:{id} \"报警数据\"(永不过期) -

处理完成后立即删除:

DEL alarm:critical:{id} -

依据:避免关键报警因过期丢失,需人工闭环处置

-

-

防击穿兜底机制

-

对无数据的查询结果缓存空值:

SET alarm:empty:past_1h \"NULL\" EX 60 -

用随机抖动避免集体失效:

ttl = baseTtl + random(0, 30)

-

Result

-

性能提升:

-

实时报警推送延迟从 8 秒 → 0.3 秒(30秒短过期减少序列化开销)

-

后台聚合查询响应从 1200ms → 28ms(缓存命中率 91%)

-

-

负载优化:

-

MySQL CPU 负载从 80% → 22%(查询请求下降 76%)

-

-

业务保障:

-

重大报警遗漏率降为 0%(永不过期缓存 + 人工确认双保险)

-

-

异常防控:

-

缓存击穿导致的 MySQL 雪崩次数从日均 1.4 次 → 0 次

-

4.缓存穿透、缓存击穿、缓存雪崩问题如何解决?

校园监控系统上线后遭遇三次线上故障:

-

缓存穿透:外部爬虫暴力扫描

alarm_id=10000~99999,引发大量不存在的报警查询击穿 Redis 直冲 MySQL; -

缓存击穿:毕业典礼突发聚集报警,同一时刻 200+ 请求并发查询

alarm:range:聚集事件(恰逢缓存过期),导致 MySQL 线程池耗尽; -

缓存雪崩:凌晨定时任务刷新 5000 个缓存键时集体设置 10 分钟过期,到期后请求洪峰使数据库崩溃。

设计防御体系解决三大缓存问题,要求:

-

拦截 99% 无效查询,防止缓存穿透;

-

热点 Key 崩溃时系统仍能承受 1000+ QPS;

-

缓存失效波动期数据库负载增幅 ≤20%。

分层实施针对性方案:

-

缓存穿透 → 布隆过滤器 + 空值缓存

java

// 初始化布隆过滤器(存储所有有效alarm_id)redis.bf.reserve(\"alarm_ids\", 0.001, 1000000); // 查询拦截逻辑if (!redis.bf.exists(\"alarm_ids\", alarmId)) { return null; // 直接拦截非法ID} else if (\"NULL\".equals(redis.get(\"alarm:\"+alarmId))) { return null; // 空值缓存命中}-

空值缓存:对不存在的报警

SETEX alarm:10086 \"NULL\" 60

-

-

缓存击穿 → 互斥锁 + 热点永续

python

def get_alarm_range(key): data = redis.get(key) if data is None: if redis.setnx(\"lock:\" + key, 1, ex=3): # 获取分布式锁 data = load_from_db(key) redis.setex(key, 300, data) # 重建缓存 redis.delete(\"lock:\" + key) else: time.sleep(0.1) # 未抢到锁时短暂等待 return get_alarm_range(key) # 重试 return data

-

热点永续:对高频 Key(如

alarm:config)启动后台线程定时续期

-

-

缓存雪崩 → 错峰过期 + 本地缓存降级

错峰过期:设置缓存过期时间时添加随机扰动

int baseTtl = 300; // 基础5分钟int randomTtl = baseTtl + new Random().nextInt(30); // +0~30秒随机值redis.setex(key, randomTtl, value);Result(结果)

-

穿透防御:

-

无效请求拦截率 99.98%,MySQL 日均穿透查询量从 120 万 → 200;

-

-

击穿控制:

-

热点 Key 崩溃期间,数据库 QPS 峰值仅上升 15%(原 300%+);

-

-

雪崩消除:

-

缓存失效期数据库负载稳定在 40%±5%(原 100% 宕机);

-

-

成本优化:

-

Redis 带宽节省 35%,故障响应人力减少 70%。

-

5.热点Key(如实时报警计数器)如何应对?(本地缓存?分片?)

Situation(情境)

在校园运动会期间,操场区域摄像头每秒触发 50+ 聚集报警,导致 Redis 中的 alarm:count:playground 计数器 Key 单节点 QPS 飙升至 15,000,引发以下问题:

-

Redis 单线程处理瓶颈,CPU 跑满 100%

-

计数延迟高达 5 秒,大屏实时数据严重滞后

-

部分节点因网卡流量过载触发主从切换

Task(任务)

设计热点 Key 承载方案,需满足:

-

支撑 50,000+ QPS 的写入压力

-

计数误差 ≤0.1%(校园安防审计要求)

-

从读取到控制台展示端到端延迟 ≤200ms

Action(行动)

采用 分片计数 + 本地聚合 + 异步刷盘 三级方案:

-

分片计数(空间拆分)

java

// 原热点Key:alarm:count:playground// 拆分为 64 片(按摄像头ID哈希分片)int shardNo = cameraId.hashCode() & 0x3F; // 0~63String shardKey = \"alarm:count:playground:\" + shardNo;redis.incr(shardKey); // 写入压力分散到64个Key

-

依据:操场 32 个摄像头,分片数 2 倍于设备数避免哈希冲突

-

-

本地缓存聚合(减少 Redis 读压力)

python

# 在每台接入服务器部署本地缓存(Caffeine)local_cache = Caffeine.newBuilder().expireAfterWrite(1, TimeUnit.SECONDS).build()def get_real_time_count(): # 先读本地缓存(1秒过期) cached_count = local_cache.getIfPresent(\"playground_count\") if cached_count is None: # 聚合所有分片数据(每次最多读64个Key) keys = [f\"alarm:count:playground:{i}\" for i in range(64)] shard_values = redis.mget(keys) # 批量读取 cached_count = sum(int(v) for v in shard_values) local_cache.put(\"playground_count\", cached_count) return cached_count

异步刷盘保最终一致

java

// 每10秒将内存计数持久化到数据库@Scheduled(fixedDelay = 10_000)void flushCountToDB() { Map shardCounts = redis.mget(\"alarm:count:playground:*\"); int total = shardCounts.values().stream().mapToInt(v -> v).sum(); jdbc.update(\"UPDATE area_stats SET count=? WHERE area=\'playground\'\", total);}Result(结果)

-

性能突破:

-

写入 QPS 从 15,000 → 68,000(分片提升 4.5 倍吞吐)

-

读取延迟从 5,000ms → 35ms(本地缓存减少 99% Redis 读请求)

-

-

资源优化:

-

Redis CPU 从 100% → 22%,网络流量下降 80%

-

-

业务保障:

-

计数误差 0.02%(审计完全达标)

-

大屏数据刷新延迟稳定在 120ms 内

-

-

扩展性:

-

方案支持横向扩展,实测可承载 20 万 QPS(增加分片数即可)

-

6.如何保证数据库与缓存的一致性?(延迟双删?事务日志?)

Situation(情境)

校园监控系统的报警处理流程中,安保人员通过管理后台将报警状态从 \"未处理\" 更新为 \"已确认\"。但多次出现严重问题:

-

数据库已更新,缓存仍返回旧状态(导致重复处理)

-

高并发下出现 \"先删缓存后更新DB\" 与 \"先更新DB后删缓存\" 策略均失效

-

主从延迟时读取到过期数据,某次闯入事件因状态显示滞后引发责任纠纷

Task(任务)

设计强一致性方案,要求:

-

状态变更后 1 秒内 缓存与数据库一致

-

可承受 500+ QPS 的并发更新

-

容忍 ≤3 秒 的 MySQL 主从延迟

Action(行动)

采用 事务消息 + 动态TTL延迟双删 + 日志监听补偿 三级保障:

java

// 1. 核心操作:事务消息保证最终一致public void confirmAlarm(long alarmId) { // Step1: 异步发送事务消息(确保本地事务提交成功后才投递) transactionMQ.send(\"alarm_update\", new AlarmMsg(alarmId, \"CONFIRMED\")); // Step2: 本地事务(更新数据库) jdbc.update(\"UPDATE alarms SET status=\'CONFIRMED\' WHERE id=?\", alarmId);}// 2. 消费者处理消息:执行延迟双删public void handleAlarmUpdate(AlarmMsg msg) { String cacheKey = \"alarm:\" + msg.getAlarmId(); // 第一删:立即清除旧缓存 redis.del(cacheKey); // 设置标记锁定(防缓存重建时读旧库) redis.setex(\"lock:\" + cacheKey, 3, \"1\"); // 动态延迟(主从延迟敏感时延长等待) int delay = mysql.getReplicationDelay() > 2 ? 3000 : 1000; Thread.sleep(delay); // 第二删:再次清除可能重建的旧缓存 redis.del(cacheKey); redis.del(\"lock:\" + cacheKey);}// 3. 补偿层:Canal监听MySQL binlog@CanalEventListenerpublic void onAlarmUpdate(AlarmChangeEvent event) { if (redis.exists(\"lock:alarm:\" + event.getId())) { return; // 避免与延迟双删竞争 } redis.del(\"alarm:\" + event.getId()); // 终极兜底删除}关键技术解析

Result(结果)

-

一致性达标:

-

状态变更后 0.8 秒内 缓存失效成功(实测 99.99% 请求一致)

-

3 个月运行中 零 状态不一致投诉

-

-

性能表现:

-

并发处理能力 620 QPS(原方案仅 230 QPS)

-

95% 请求延迟 ≤120ms

-

-

容灾能力:

-

模拟主从延迟 5 秒场景,不一致率仅 0.003%

-

MQ 宕机时自动降级为同步双删,保障基础可用性

-

-

成本控制:

-

仅需 3 节点 Canal 服务,服务器成本增加 8%

-

后端

API设计

1.请画出视频流分析服务的架构图,说明如何实现高并发实时处理。

2.视频流传输协议选型?(RTSP vs WebRTC vs HLS?)为什么?

3.如何保证视频帧有序处理?缓冲队列设计(Kafka/RabbitMQ/Redis Stream)?

Situation(情境)

校园监控系统需实时分析 32 路 1080P 摄像头视频流(25fps),每路每秒产生 25 帧。初期使用 Redis List 做队列时出现:

-

帧乱序:网络抖动导致后发帧先入队(如

frame_10005比frame_10004早到) -

阻塞分析:YOLOv5 处理跳跃帧时误检率上升 37%(连续动作被割裂)

-

丢帧风险:操场摄像头数据洪峰时,Redis 内存溢出触发旧帧丢弃

Task(任务)

设计保序队列方案,要求:

-

严格帧顺序:单摄像头帧连续处理,误差 = 0

-

吞吐能力:支撑 800+ fps(32路×25fps)持续写入

-

延迟可控:从入队到分析完成 ≤500ms

-

成本限制:服务器预算 ≤5 台(校园经费敏感)

Action(行动)

选择 Kafka 分区有序性 + 帧重组缓冲区 架构:

1. 传输层保序(Kafka 核心配置)

java

// 按摄像头ID绑定分区(确保同摄像头帧进同一分区)int partition = cameraId.hashCode() % kafkaPartitions;ProducerRecord record = new ProducerRecord( \"video_frames\", partition, cameraId, frame);// Kafka 服务端关键配置acks = all // 写入所有副本才返回,防丢帧max.in.flight.requests.per.connection = 1 // 禁用乱序发送compression.type = lz4 // 帧压缩率60%,节省带宽2. 消费端帧重组(解决网络乱序)

python

class FrameReorderBuffer: def __init__(self, camera_id): self.buffer = {} # {frame_seq: frame_data} self.next_seq = 0 # 期待的下个帧序号 def add_frame(self, frame): if frame.seq < self.next_seq: return # 丢弃迟到旧帧(如重传冗余) self.buffer[frame.seq] = frame # 连续提交有序帧块 while self.next_seq in self.buffer: frame = self.buffer.pop(self.next_seq) send_to_detection(frame) # 送YOLOv5分析 self.next_seq += 13. 容灾与流量控制

-

背压机制:当检测服务延迟 >1 秒时,Kafka 消费者暂停拉取

-

帧采样降级:GPU 过载时,丢弃非关键帧(如

seq % 5 != 0) -

超时丢弃:缓冲区帧滞留超 2 秒强制清除(防积压)

Result(结果)

-

顺序性保障:

-

32 路视频流 100% 连续处理,误检率回落至正常水平(-37% → +2.1%)

-

-

性能提升:

-

吞吐量:1,200 fps(超目标 50%)

-

端到端延迟:230ms(入队 20ms + Kafka 传输 50ms + 重组 10ms + 检测 150ms)

-

-

资源优化:

-

服务器成本:3 台(1×Kafka Broker + 2×消费分析节点)

-

内存占用:帧缓冲区峰值 1.2GB(原 Redis 方案 8GB)

-

-

可靠性:

-

模拟网络抖动测试:乱序帧率 15% 场景下,零帧丢失且输出顺序正确

-

方案选型对比

关键技术验证:

顺序压力测试:注入 10% 乱序帧 + 5% 丢包,重组缓冲区成功校正 100% 帧序列

成本优化:通过 LZ4 压缩,校园千兆带宽可承载 60 路摄像头(原方案仅 32 路)

故障演练:Kafka 主节点宕机,从节点 10 秒内切换,期间仅 8 帧重复(业务可容忍)

4.报警触发机制如何实现低延迟?(同步阻塞 vs 异步消息)

模型设计

1.请详细描述训练YOLOv11模型的具体流程,并说明针对校园场景做了哪些特殊优化?

数据准备:主要使用了公开数据集 COCO(通用目标检测)和 VisDrone(无人机视角人群检测)作为基础。针对校园场景,我们自行采集了部分校园监控视频(约50小时),并重点标注了关键行为:聚集、摔倒、闯入禁区(如实验室、楼顶)