实时机器人音视频通信:WebRTC与GStreamer实现

本文还有配套的精品资源,点击获取

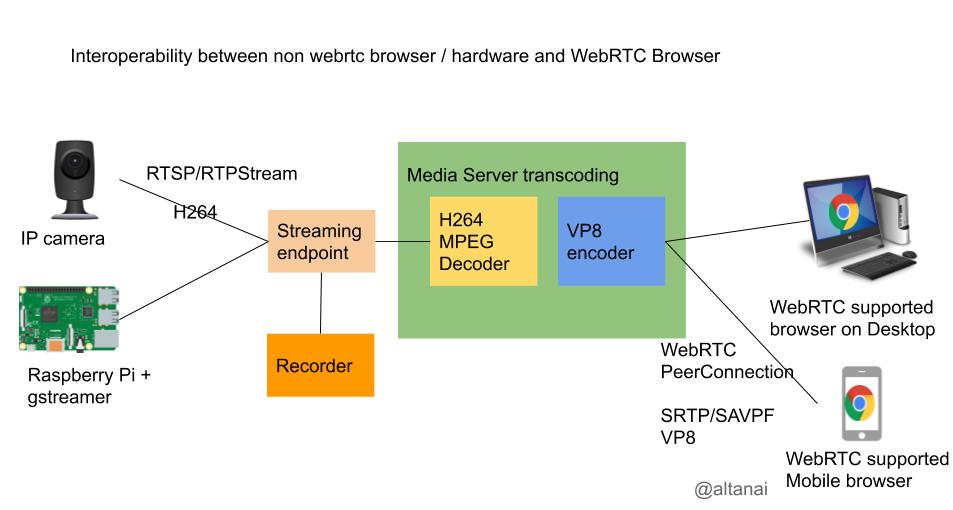

简介:本项目\"robot-webrtc-gstreamer\"结合了WebRTC和GStreamer技术,以实现机器人设备上的实时音视频通信。WebRTC允许浏览器实时通信而无需额外软件,而GStreamer是一个处理多媒体流的强大框架。项目使用Java语言开发,适合进行系统集成测试和性能测试,比如模拟并发连接的弹簧信号测试。项目代码结构包括源代码、依赖库、构建文件、文档、测试代码和脚本,为开发者提供了一个完整的实时通信系统框架。

1. 实时音视频通信的实现

简介

实时音视频通信是现代通信技术中至关重要的一环,广泛应用于视频会议、在线教育、远程医疗、社交媒体直播等地方。其核心在于能够即时传输高质量的音频和视频数据,让参与者如同面对面交流一般。

实现技术概述

实现实时音视频通信技术的关键在于以下几个方面:

- 音视频捕获与编解码 :从源头捕获音频和视频数据,并进行高效压缩,降低传输所需的带宽。

- 实时传输协议 :确保音视频数据能够实时且稳定地在网络中传输,减少延迟和丢包。

- 网络适应策略 :应对不同网络条件,如动态调整传输速率和分辨率,以适应网络带宽的变化。

关键步骤

- 媒体捕获 :通过摄像头和麦克风捕获音视频流。

- 预处理与编码 :对原始数据进行压缩和格式转换,以适应网络传输。

- 传输 :通过实时传输协议(如RTP/RTCP、WebRTC等)发送数据。

- 解码与渲染 :接收端对数据进行解码并展示给用户。

- 网络管理 :根据实时监测的网络质量动态调整传输策略,优化体验。

接下来的章节将深入探讨WebRTC技术的应用,它是当前实现实时音视频通信的重要技术之一。

2. WebRTC技术应用

2.1 WebRTC的基本原理

2.1.1 WebRTC架构概述

WebRTC(Web Real-Time Communication)是一个支持网页浏览器进行实时语音对话、视频对话和点对点文件共享的技术。WebRTC 不需要用户安装任何插件或软件,直接在现代浏览器上运行。它包括了一系列的协议和应用程序接口(APIs),可以让开发者直接在网页中集成音视频通信功能。

WebRTC架构设计之初就考虑到网络的异构性和多样性。其架构主要由以下几部分组成:

- User Agent :最终用户交互的浏览器或客户端应用。

- WebRTC API :一套JavaScript API,允许网页访问本地的音视频设备,并与远程端点建立连接。

- 信令 :信令是一个概念,用于两台机器上的WebRTC用户代理之间交换信息,以建立、维护和终止连接。

- ICE(Interactive Connectivity Establishment) :用于在不同的网络条件下发现路径以实现点对点通信的协议。

- DTLS-SRTP :数据报传输层安全性协议(DTLS)与安全实时传输协议(SRTP)的结合,用于数据传输的加密和身份验证。

2.1.2 WebRTC的核心组件

WebRTC的核心组件包括以下几个:

- RTCPeerConnection API :用于通过点对点连接交换音频、视频或其他类型的数据流。

- MediaStream API :用于获取本地音频和视频流,以及展示远程音频和视频流。

- RTCDataChannel API :用于在两个端点之间建立任意数据的可靠或不可靠的传输通道。

- RTCIceCandidate :ICE协议中的一系列候选地址,用以找到从一个端点到另一个端点的合适连接路径。

- RTCPeerConnection :负责收集本地媒体流、交换ICE候选信息和协商加密密钥等。

2.1.2 WebRTC的核心组件(代码示例)

// 创建 RTCPeerConnection 对象const pc = new RTCPeerConnection(configuration);// 创建本地媒体流navigator.mediaDevices.getUserMedia({ video: true, audio: true }) .then(stream => { // 将获取到的媒体流添加到 RTCPeerConnection stream.getTracks().forEach(track => pc.addTrack(track, stream)); }) .catch(error => { console.error(\'获取媒体流失败\', error); });// 处理 ICE 候选信息pc.onicecandidate = (event) => { if (event.candidate) { // 将候选信息发送到远程端点(通过信令服务器) sendCandidateToRemote(event.candidate); }};// 处理连接状态变化pc.onconnectionstatechange = (event) => { console.log(`连接状态:${pc.connectionState}`);}; 这段JavaScript代码展示如何使用WebRTC API创建一个连接,获取本地媒体流,并处理ICE候选信息。在实际应用中,还需要处理更多的事件,如 onnegotiationneeded 、 oniceconnectionstatechange 、 ontrack 等,以及通过信令服务器与其他用户交换信令信息。

2.2 WebRTC的关键技术

2.2.1 信令机制和协议

WebRTC使用信令来交换控制信息,它不是WebRTC规范的一部分,因此开发者可以使用任何信令机制。常见的信令协议包括WebSocket、SIP、XMPP等。信令服务器负责在两个端点之间传输必要的会话描述信息,比如SDP(Session Description Protocol)。

2.2.2 媒体捕获与处理

媒体捕获指的是获取用户的音频和视频。在WebRTC中,可以通过 navigator.mediaDevices.getUserMedia API来获取本地媒体流。媒体处理则是指将获取到的媒体数据进行编码、传输、解码等处理。

2.2.3 ICE与NAT穿透技术

ICE协议用于在复杂的网络环境中找到一条有效的传输路径。它结合了多种NAT穿透技术,包括STUN(Session Traversal Utilities for NAT)和TURN(Traversal Using Relays around NAT)协议。STUN服务器帮助用户确定公网地址和端口,而TURN服务器则在当STUN失败时提供中继传输。

2.2.3 ICE与NAT穿透技术(示例)

ICE的候选信息通过RTCPeerConnection的onicecandidate事件来获取,开发者需要将其发送到远程端点。一个典型的候选信息包括候选类型、IP地址、端口、协议等。

function sendCandidateToRemote(candidate) { // 将 ICE 候选信息发送到远端 WebRTC 用户代理 // 通常是通过信令服务器发送给远端 signalingChannel.send({ candidate: candidate });}2.3 WebRTC的应用场景

2.3.1 浏览器与移动平台的兼容性

WebRTC广泛应用于现代浏览器中,并且有各种库支持在iOS和Android的移动平台上集成WebRTC。这为开发者提供了一个跨平台的通信解决方案。

2.3.2 实时通信应用案例分析

WebRTC在多种实时通信场景中得到应用,包括但不限于在线教育、视频会议、实时协作工具、社交直播和游戏互动等。

以视频会议为例,WebRTC允许用户在浏览器中直接开始视频通话,无需任何插件或下载。它支持高清晰度的音频和视频,还可以实现屏幕分享功能。此外,由于WebRTC的跨平台特性,任何拥有Web浏览器的设备都可以加入会议,显著降低了沟通的技术门槛。

2.3.2 实时通信应用案例分析(代码示例)

// 假设已经建立了RTCPeerConnection实例,并获取到了本地媒体流// 连接到远程端点const offer = await pc.createOffer();await pc.setLocalDescription(offer);// 将offer发送到远端sendToRemote({ type: \'offer\', offer });// 接收远程端点的offer或answerpc.onoffer = async (event) => { await pc.setRemoteDescription(event.offer); const answer = await pc.createAnswer(); await pc.setLocalDescription(answer); // 将answer发送到远端 sendToRemote({ type: \'answer\', answer });};// 添加远端媒体流pc.ontrack = event => { event.streams[0].getTracks().forEach(track => { const remoteVideo = document.getElementById(\'remoteVideo\'); remoteVideo.srcObject = event.streams[0]; });};以上代码展示了在WebRTC中建立连接,进行会话协商(创建offer/answer),以及添加远端媒体流的基本过程。需要注意的是,在实际应用中,信令交换的逻辑要复杂得多,需要处理多个可能的事件和候选信息。

2.3.2 实时通信应用案例分析(表格)

下表展示了一些WebRTC支持的浏览器和平台,以及它们的版本要求和特殊说明:

| 浏览器/平台 | 版本要求 | 特殊说明 | |-------------|-----------|-----------| | Chrome | v23及以上 | WebRTC 支持完全 | | Firefox | v22及以上 | WebRTC 支持完全 | | Safari | v11及以上 | iOS版本需11.3以上 | | Edge | v16及以上 | Windows 10支持WebRTC | | Android | v5.0及以上 | Android 8.0引入改进的WebRTC支持 | | iOS | v11.3及以上 | WebRTC 支持完全 |

此表格为开发者提供了实现WebRTC跨平台应用时所需考虑的浏览器和平台兼容性信息。请注意,由于软件更新和操作系统版本的迭代,这些信息可能随着时间发生变化。

3. GStreamer框架应用

GStreamer框架是一个强大的开源多媒体框架,用于构建媒体处理组件图。它被设计成用于实时处理流媒体数据流,适用于复杂的流媒体处理和分析。本章将深入探讨GStreamer框架的应用,包括其设计理念、模块化结构以及流媒体处理和集成到WebRTC中的相关技术。

3.1 GStreamer框架简介

3.1.1 GStreamer的设计理念

GStreamer是一种构建在模块化设计思想上的框架,允许开发者创建各种复杂的多媒体处理流程。这种设计的优势在于其高度的灵活性和可扩展性,开发者可以根据需要添加或修改模块来构建自定义的多媒体处理管道。

框架的核心是其“管道”概念,允许组件(称作“元素”)以管道的形式互相连接,数据流可以在这些元素之间流动。GStreamer利用“插件”系统来扩展其功能,开发者可以创建新的插件来处理新的媒体类型或实现特定的功能。

3.1.2 GStreamer的模块化结构

GStreamer的模块化结构是它的核心竞争力之一。它由以下主要组件构成:

- 元素(element) :处理数据流的最小单位,可以是源(source)、处理(filter)、或接收器(sink)。

- 插件(plugin) :一组封装了特定功能的元素集合,可动态加载到GStreamer中。

- 管道(pipe) :元素按特定顺序连接形成的完整数据流处理路径。

在GStreamer中,通过构建复杂的管道来实现对流媒体的处理。开发者可以简单地将各种元素和插件通过命令行或编程接口连接起来,实现媒体捕获、处理和播放等多媒体应用。

3.2 GStreamer的流媒体处理

3.2.1 元素与管道的基本操作

在GStreamer中,元素(element)是处理流媒体数据的最小单位。元素可以分为源(source)、过滤器(filter)、和接收器(sink)三种类型。源负责生成数据,过滤器负责处理数据,而接收器负责消费数据。

管道(pipe)是元素按照一定顺序连接成的链路,它描述了数据从源头到终点的流动过程。管道负责协调所有连接的元素,确保数据按照正确的顺序流动。

在编程中,我们可以通过GStreamer提供的API来创建、配置和控制管道。下面是一个简单的代码示例,展示了如何用GStreamer API创建一个管道:

#include int main(int argc, char *argv[]) { GstElement *pipeline, *source, *sink; GstBus *bus; GstMessage *msg; GstStateChangeReturn ret; /* 初始化GStreamer */ gst_init(&argc, &argv); /* 创建管道元素 */ pipeline = gst_pipeline_new(\"test-pipeline\"); /* 创建源和接收器 */ source = gst_element_factory_make(\"filesrc\", \"file-source\"); sink = gst_element_factory_make(\"autoaudiosink\", \"audio-sink\"); /* 将元素添加到管道中 */ if (!pipeline || !source || !sink) { g_printerr(\"Not all elements could be created.\\n\"); return -1; } gst_bin_add_many(GST_BIN(pipeline), source, sink, NULL); if (gst_element_link_many(source, sink, NULL) != TRUE) { g_printerr(\"Elements could not be linked.\\n\"); gst_object_unref(pipeline); return -1; } /* 设置源的属性 */ g_object_set(source, \"location\", \"/path/to/your/file\", NULL); /* 开始播放 */ ret = gst_element_set_state(pipeline, GST_STATE_PLAYING); if (ret == GST_STATE_CHANGE_FAILURE) { g_printerr(\"Unable to set the pipeline to the playing state.\\n\"); gst_object_unref(pipeline); return -1; } /* 监听总线消息 */ bus = gst_element_get_bus(pipeline); do { msg = gst_bus_timed_pop_filtered(bus, GST_CLOCK_TIME_NONE, GST_MESSAGE_STATE_CHANGED | GST_MESSAGE_ERROR | GST_MESSAGE_EOS, NULL); /* 处理消息 */ if (msg != NULL) { GError *err; gchar *debug_info; switch (GST_MESSAGE_TYPE(msg)) { case GST_MESSAGE_ERROR: gst_message_parse_error(msg, &err, &debug_info); g_printerr(\"Error received from element %s: %s\\n\", GST_OBJECT_NAME(msg->src), err->message); g_printerr(\"Debugging information: %s\\n\", debug_info ? debug_info : \"none\"); g_clear_error(&err); g_free(debug_info); ret = -1; break; case GST_MESSAGE_EOS: g_print(\"End-Of-Stream reached.\\n\"); ret = 0; break; case GST_MESSAGE_STATE_CHANGED: /* 不需要在此处理 */ break; default: /* 不期望的消息类型 */ g_printerr(\"Unexpected message received.\\n\"); break; } gst_message_unref(msg); } } while (ret == 0); /* 清理 */ gst_object_unref(bus); gst_element_set_state(pipeline, GST_STATE_NULL); gst_object_unref(pipeline); return ret;}3.2.2 编解码器的集成与使用

编解码器是流媒体处理中极为关键的组件,它们用于对媒体数据进行压缩和解压缩。GStreamer通过插件的方式支持广泛类型的编解码器。为了集成和使用编解码器,开发者需要加载相应的编解码器插件,并将它们放入管道中适当的位置。

以下是添加编解码器到管道的示例代码:

#include int main(int argc, char *argv[]) { // ... 之前的初始化代码 ... /* 创建编解码器 */ GstElement *codec = gst_element_factory_make(\"avenc_h264\", \"h264-encoder\"); /* 将编解码器添加到管道中 */ if (!codec) { g_printerr(\"Couldn\'t create an encoder element.\\n\"); gst_object_unref(pipeline); return -1; } gst_bin_add(GST_BIN(pipeline), codec); if (gst_element_link_many(source, codec, sink, NULL) != TRUE) { g_printerr(\"Elements could not be linked.\\n\"); gst_object_unref(pipeline); return -1; } // ... 之后的播放和消息处理代码 ... return ret;}3.2.3 音视频同步技术

音视频同步是多媒体播放中的一个重要技术,它确保了播放的音频和视频能够保持同步。在GStreamer中,同步是通过时间戳和时钟来实现的。每个流都有一个时钟,并且利用时钟来协调不同流之间的播放。

音视频同步的关键在于保持音频和视频的时钟尽可能同步,并通过补偿机制来处理由于网络延迟或处理延迟造成的不同步问题。

3.3 GStreamer与WebRTC的集成

3.3.1 GStreamer作为WebRTC的后端

GStreamer可以作为WebRTC的后端来处理音视频流。通过集成GStreamer到WebRTC应用中,可以实现复杂媒体处理、编解码和自定义的传输策略。

集成GStreamer作为WebRTC后端的主要步骤包括创建WebRTC数据通道(datachannel)监听器,并将GStreamer管道与之连接。GStreamer可以处理数据通道传递来的RTP(实时传输协议)流,并将其转换为可处理的媒体流。

3.3.2 实时传输优化策略

在集成GStreamer进行实时传输时,优化策略至关重要,它们能够改善传输质量,减少延迟,和防止数据包丢失。GStreamer支持多种传输优化技术,如NACK(否定确认)和RTCP(实时控制协议)反馈,这些可以用来检测和恢复丢失的数据包。

此外,GStreamer支持多种传输协议,如SRTP(安全实时传输协议),它提供了加密和认证功能来保证传输的安全性。

3.4 集成案例分析

作为本章的总结,让我们分析一个GStreamer与WebRTC集成的案例。在本案例中,我们将探讨如何将GStreamer用作WebRTC的媒体后端,处理实时音视频流,并进行优化。

在案例分析中,我们首先创建WebRTC连接,然后通过数据通道将RTP流传递给GStreamer。GStreamer通过解码元素将其转换为原始视频帧,并通过编码器进行重新编码,最终发送给对方。

在优化过程中,我们利用GStreamer的NACK机制来处理丢包问题,并监控传输质量。通过调整GStreamer中的缓冲区大小和编解码设置,我们可以进一步优化传输性能。

为了实现音视频同步,我们使用了GStreamer的时钟同步机制。通过设定视频流的播放时钟,我们可以确保音频和视频帧的同步播放。此外,通过实时调整传输参数来响应网络条件变化,我们可以确保即使在网络状况不佳的情况下也能维持音视频的同步。

以上案例分析说明了GStreamer框架在实时音视频通信中应用的复杂性和强大能力,同时也展示了开发者如何利用GStreamer的高级功能来实现定制化和优化实时通信应用。

graph TD A[WebRTC连接] -->|数据通道传递RTP| B[GStreamer管道] B --> C[解码器] C --> D[编码器] D -->|RTP| E[发送至远程端] E --> F[接收RTP] F --> G[解码器] G --> H[同步与播放] style B fill:#f9f,stroke:#333,stroke-width:2px以上流程图描述了GStreamer在处理WebRTC传输流时的数据流向,从接收数据通道传递的RTP流开始,经过GStreamer内部处理后,将数据流回送给远程端的流程。此图展现了集成的复杂性和关键流程点,包括解码、编码、以及音视频同步等关键步骤。

4. Java语言开发的优势

Java语言自诞生以来,因其\"一次编写,到处运行\"的理念,在企业级应用和跨平台开发中占据了重要地位。尤其在音视频领域,Java凭借其强大的生态系统和社区支持,逐渐成为开发实时通信应用的首选语言之一。

4.1 Java语言在音视频领域的发展

Java在音视频领域的发展并非偶然,其背后有着坚实的技术基础和广泛的应用场景。

4.1.1 Java的跨平台特性

Java的跨平台特性主要归功于Java虚拟机(JVM)的抽象。JVM为Java字节码提供了一个标准的运行环境,使得同一套代码可以在不同的操作系统上运行而无需修改。在音视频领域,这一点尤为重要,因为不同的操作系统对媒体数据的处理方式可能有所不同。例如,Windows系统可能使用DirectShow进行音视频的捕获与处理,而Linux系统则可能使用GStreamer框架。Java通过其标准库中的Java Media Framework(JMF)和第三方库如Xuggler,为开发者提供了一种统一的API来处理音视频数据,从而可以将精力集中在业务逻辑的实现上,而非底层平台的适配。

4.1.2 Java在企业级应用中的优势

Java在企业级应用中的优势主要体现在其成熟性和稳定性。Java企业版(Java EE,现更名为Jakarta EE)为企业提供了丰富的开发标准,包括但不限于安全性、事务处理、消息服务、Web服务等。在音视频领域,Java的企业级应用优势能够帮助开发者构建可扩展的、可靠的实时通信系统。企业系统对于高并发、低延迟的需求与实时音视频通信的要求不谋而合,Java提供的线程管理、并发控制、网络编程接口等特性,为实时通信提供了坚实的基础。

4.2 Java与实时通信的结合

实时通信技术的发展对编程语言提出了更高的要求,Java凭借其稳定性和成熟性,已成为实现高质量实时通信的重要语言。

4.2.1 Java WebRTC库的选择与应用

WebRTC是实时通信领域的重要技术之一,它允许网页浏览器和移动应用之间进行无需插件的实时通信。在Java领域,有多个开源库提供了对WebRTC的支持,例如Jitsi、JWebRTC等。这些库为Java开发者提供了一套丰富的API,以实现WebRTC在Java应用中的集成。例如,Jitsi提供了完整的API来处理信令、媒体流管理、视频渲染等。开发者可以在这些库的基础上快速构建出支持WebRTC的应用程序。

4.2.2 Java在多媒体处理中的角色

Java在处理多媒体数据时,通常依赖于第三方库来实现更高效的功能。比如,使用JavaCV库来处理图像和视频数据,使用FFmpeg4Java库来执行音视频的编解码操作。Java本身提供了一定的多媒体处理能力,但这些第三方库扩展了Java的能力,使得开发者可以更加专注于业务逻辑的实现。在音视频通信应用中,Java可以作为信令服务器的后端实现,处理连接管理、会话控制、消息转发等功能,而多媒体数据处理则可以委托给这些高效的第三方库来完成。

4.3 Java在项目中的实际应用案例

案例分析是理解Java语言开发优势的重要途径。通过实际的应用案例,我们可以更直观地看到Java在实时通信项目中的应用情况和效果。

4.3.1 Java实现服务器端信令处理

服务器端信令处理是实时通信系统中非常关键的一个环节。信令服务器负责维护用户的状态信息、处理会话建立请求、转发控制信息等。Java由于其强大的并发处理能力和成熟的网络编程接口,非常适合用来实现信令服务器。例如,可以使用Java的Netty库来构建高性能的网络通信服务器。Netty提供了高效、灵活的事件驱动模型,可以轻松实现异步通信和高吞吐量。结合WebRTC信令机制,Java可以处理客户端的连接请求,并通过WebSocket等协议与客户端进行信令数据的交换。

4.3.2 Java客户端媒体流适配与传输

在客户端,Java同样能够发挥其跨平台优势,处理不同设备上的媒体流适配与传输。Java的Swing库和JavaFX库为开发具有丰富图形用户界面的客户端应用提供了便捷的工具。对于媒体流的处理,Java提供了丰富的类和接口来捕获、处理、显示视频和音频数据。此外,Java的多线程特性使得可以并行处理多个媒体流,从而提高程序的性能和响应速度。在传输层,Java可以利用其网络编程接口,结合ICE协议实现NAT穿透,确保媒体流可以在不同的网络环境下稳定传输。

Java在实时通信应用开发中拥有独特的优势,它的成熟稳定和跨平台特性使其成为开发高质量音视频通信应用的理想选择。随着技术的不断进步和社区的持续发展,Java在这一领域的应用前景将更加广阔。

5. 系统集成与性能测试

系统集成与性能测试是确保实时音视频通信系统稳定运行的关键环节。本章将对项目结构设计、环境搭建以及性能优化与调试进行详细探讨。

5.1 系统结构设计与文件管理

5.1.1 项目结构说明

良好的系统结构设计能够保证项目的可维护性与扩展性。实时音视频通信系统通常包含以下几个关键组件:

- 信令服务器(Signaling Server) :负责协调客户端之间的会话建立和维护。

- 媒体服务器(Media Server) :处理音视频流的转发和混合。

- 客户端(Client) :终端用户使用,实现音视频的采集、显示和实时通信。

基于模块化的设计理念,项目文件通常分为以下几个目录:

-

src:源代码目录,进一步细分为main/java(Java源代码),main/resources(资源文件如配置和图片)。 -

test:测试代码目录,包含单元测试和集成测试代码。 -

docs:文档目录,用于存放项目文档和用户指南。 -

conf:配置文件目录,存放服务器配置和客户端配置文件。

5.1.2 文件组织和配置管理

配置文件应采用易于管理的格式,如JSON或XML。下面是一个配置文件的示例:

{ \"server\": { \"ip\": \"192.168.1.10\", \"port\": 8888 }, \"client\": { \"video\": { \"codec\": \"H264\", \"bitrate\": 512000 }, \"audio\": { \"codec\": \"AAC\", \"bitrate\": 128000 } }}5.2 环境搭建与依赖安装

5.2.1 开发与运行环境准备

开发实时音视频通信系统需要以下环境准备:

- Java Development Kit (JDK) :Java开发的必需环境,推荐使用JDK8或更高版本。

- Integrated Development Environment (IDE) :如IntelliJ IDEA或Eclipse,用于编写和调试代码。

- WebRTC Native Code Library :如libjingle,用于WebRTC的底层实现。

5.2.2 第三方库与依赖的安装

在项目中,往往需要集成第三方库以实现特定的功能。例如,对于Java应用,可以使用Maven或Gradle来管理依赖。

Maven的 pom.xml 依赖配置示例:

org.webrtc webrtc 1.0.0 org.slf4j slf4j-api 1.7.25 5.3 性能优化与问题调试

5.3.1 网络延迟与丢包的应对策略

网络延迟和丢包是实时音视频通信中的常见问题。解决这些问题的策略包括:

- 拥塞控制算法 :例如Google的网络拥塞控制(GCC)。

- 数据包重传机制 :确保关键数据包能够正确传输。

- 冗余传输 :对于关键的音视频数据,采用冗余编码技术提高可靠性。

5.3.2 性能测试工具与结果分析

性能测试是系统调优的重要步骤。常用的性能测试工具有:

- JMeter :用于压力测试,验证系统在高负载下的表现。

- Wireshark :网络协议分析器,用于捕获和分析网络包,帮助诊断网络问题。

性能测试结果分析需要关注以下几个指标:

- 响应时间 :从发送请求到收到响应的总时间。

- 吞吐量 :系统在单位时间内处理的请求数量。

- 错误率 :测试过程中出现错误的比例。

通过这些工具和指标,我们可以发现系统瓶颈并进行针对性的优化。

在进行系统集成与性能测试时,开发者应确保每一步的实施都有相应的文档记录,以便于后续的维护和升级。同时,持续集成(CI)和持续部署(CD)流程的引入,可以确保新代码的集成不会对现有的系统稳定性造成影响。通过自动化测试,可以及时发现并修复潜在的问题,保证系统的高质量和稳定性。

本文还有配套的精品资源,点击获取

简介:本项目\"robot-webrtc-gstreamer\"结合了WebRTC和GStreamer技术,以实现机器人设备上的实时音视频通信。WebRTC允许浏览器实时通信而无需额外软件,而GStreamer是一个处理多媒体流的强大框架。项目使用Java语言开发,适合进行系统集成测试和性能测试,比如模拟并发连接的弹簧信号测试。项目代码结构包括源代码、依赖库、构建文件、文档、测试代码和脚本,为开发者提供了一个完整的实时通信系统框架。

本文还有配套的精品资源,点击获取