基于VLM的视频内容理解系统的设计与实现

目录

1 绪论

1.1 研究背景和意义

1.2 研究现状

1.2.1 国外研究现状

1.2.2 国内研究现状

2 相关技术和原理

2.1 视频数据预处理——video-analyzer

2.2 视觉特征提取——Visual Transformer(ViT)

2.3 多模态语义融合技术

2.3.1 CLIP

2.3.2 VideoBERT

2.4 视频理解——讯飞大模型

3 系统的设计与实现

3.1 模型的推理框架

3.1.1 视频数据预处理

3.1.2 视频帧处理

3.1.3 多模态融合与语义建模

3.1.4 视频内容理解与文本润色

3.2 系统架构设计

3.3 Django框架

4 实验结果与分析

4.1 数据集

4.2 评估指标说明

4.3 实验结果分析

4.4 模型生成内容的对比分析

4.5 不足之处

5 系统功能展示

5.1 交互与可视化

5.1.1 登录页面

5.1.2 首页页面

5.1.3 用户信息管理页面

5.1.4 视频理解分析页面

5.1.5 数据可视化页面

5.1.6 系统监控页面

6 结论

7 致谢

参考文献

- 绪论

- 研究背景和意义

现今,在人工智能和深度学习技术的飞速发展下,视频语言模型(Video Language Model,VLM)已成为计算机视觉和自然语言处理交叉领域的重要研究热点。VLM技术将视觉信息和语言模型结合起来,通过多模态学习,实现对视频内容的精准分析和理解。当前,全球视频数据的增长速度极快,涵盖了社交媒体、智能监控、短视频平台、自动驾驶等多个领域,如何准确、有效地分析和挖掘视频信息已成为亟待解决的问题。传统的视频处理方法,主要依赖于目标检测、语义分割等计算机视觉技术,无法深入理解视频中的事件、情感、行为等高层语义信息。而大规模预训练的视觉语言模型,如iFlytek讯飞大模型、CLIP、Video BERT等,能够学习视频内容与文本描述之间的复杂关系,为视频智能分析提供了新的解决方案。

本研究致力于开发一款智能视频内容理解系统,后端采用Python和Django,前端使用Vue和Axios进行交互,并结合讯飞大模型对视频数据进行分析,同时利用ECharts进行可视化展示。该系统可用于视频监控、自动字幕生成、短视频推荐和情感分析等多个场景,能够精准解析视频内容,并以结构化的方式呈现。基于深度学习技术,系统通过对人物、场景、动作进行自动识别,再生成相应的文字表述,使视频处理更具智能性和高效性。该研究的价值意义体现在以下几点。第一,它减少了人工标注的依赖,提高了视频分析的自动化水平和数据处理效率。第二,该技术在智能安防、影视推荐、在线教育等地方有广泛应用,可实现更精准的内容分析和推荐,提升用户体验。此外,本研究还探索了大模型在不同任务中的适应能力,为未来的视频智能分析提供技术支持。采用前后端分离架构和优化的推理方式,使系统具备更强的扩展性和实时处理能力,在实际应用中更加高效、实用。

-

- 研究现状

- 国外研究现状

- 研究现状

近年来,视频内容理解(Video Content Understanding, VCU)在国际上受到广泛关注,研究重点主要集中在多模态学习、大语言模型(LLM)与视频理解的结合、视频-文本对齐以及视频内容生成等方面。

在多模态学习方面,Transformer架构的引入极大推动了视频语言模型(VLM)的发展。Vaswani等人提出的Transformer模型[18],为视频与文本的联合学习提供了强大的序列建模能力。基于此,Wu等人提出的VILA-U模型[1],通过融合视觉理解与生成能力,实现了统一的多模态视频处理框架,提高了视频内容分析的准确性。

在大模型与视频理解的结合上,Tang等人对大语言模型在视频分析任务中的应用进行了系统性调查,指出LLM能够提升视频语义解析与推理能力[2]。Wang等人提出的GPT4Video[17],将指令微调和多模态数据对齐相结合,使视频处理更加智能化,并能够更精准地生成文本描述。此外,Zhou等人研究了生成式人工智能(Generative AI)在视频生成、理解和流媒体分析中的应用,表明大模型在视频摘要、事件预测和自动字幕生成等任务上具有巨大潜力[5]。

在视频-文本对齐方面,Sun等人提出的VideoBERT[6],首次将BERT应用于视频和语言的联合学习,利用自监督学习方法提高了视频内容的表示能力。Lei等人进一步研究了对比学习在视频理解任务中的应用,证明了该方法在多模态预训练中的有效性[7]。此外,Singer等人提出的Make-A-Video[13],通过文本驱动的视频生成,提高了短视频推荐的个性化程度。

尽管国际上关于VLM的视频理解研究取得了诸多进展,但仍然面临数据稀缺、计算开销大、推理效率低等挑战。Zhou等人指出,未来的发展方向应包括更高效的多模态预训练策略、视频与文本的深度融合以及自监督学习方法的优化[12]。

-

-

- 国内研究现状

-

国内关于VLM的视频内容理解研究主要集中在多模态预训练、视频分析应用以及大模型推理优化等方面。

在多模态预训练方面,国内研究者也在致力于视频-文本对齐能力的提升。例如,赵鑫等人提出了一种基于大语言模型提取视频特征的视频语义理解方法,提升了视频内容分析的精度[20]。此外,研究者也在针对中文语境的视频理解任务开展研究,试图结合中文语言特性实现视频字幕生成、情感分析等任务的优化完成[7]。

在视频分析应用方面,国内企业和研究机构广泛应用大模型技术,实现智能安防、短视频推荐和自动字幕生成等任务的落地。例如,讯飞大模型(iFlytek)在语音识别、图像理解和自然语言处理方面具有较强的能力,并已应用于视频内容分析领域。国内相关研究表明,结合大模型的多模态学习方法在视频内容结构化解析、视频推荐和情感分析上均有不同程度的提升作用。

在大模型推理方面,国内研究者提出对大模型进行轻量化处理以降低计算成本,提高模型实时性。例如,部分研究提出基于知识蒸馏和模型剪枝的方法,使大模型能够在边缘设备上进行推理,以提升系统的适应性与扩展性。另外,在视频理解的自监督学习方面,国内研究者也提出新的预训练方法来降低标注数据的依赖,提高视频内容理解的泛化能力[5]。

综上所述,国内外关于VLM的视频内容理解研究均取得了显著进展。国外研究在多模态预训练、大模型优化以及视频-文本对齐等方面处于领先地位,而国内研究更多关注大模型在视频分析任务中的实际应用,并在中文视频内容理解、大模型轻量化优化等方向进行了深入探索。未来,随着多模态学习技术的进一步发展,VLM在视频内容理解领域的应用将更加广泛,并推动智能视频分析技术的发展。

-

- 研究目标与主要工作

本文旨在利用视频语言模型(Video Language Model,VLM)实现对视频内容的深度语义理解。重点通过提升视频理解过程中的多模态融合、语义提取和推理分析能力,来捕捉出人物行为、场景信息及情感等复杂语义信息。这样不仅能,显著提供对视频内容理解的全面性和准确性,还能让视频内容理解技术往更多的应用方向拓展,如安防监控、视频推荐、内容审核等应用场景,实现更全面化的方向发展、是一个具有重要研究价值和实际意义的探索领域。

本论文搭建了一套前后端分离的视频内容理解系统:后端采用Django框架,前端结合Vue和ECharts实现交互与可视化。系统集成了视频数据预处理(利用video-analyzer提取关键帧并转录音频)、视觉特征提取(采用ViT获取帧级特征)、多模态对齐(通过CLIP和VideoBERT融合视觉与文本语义)以及视频内容推理分析(调用讯飞大模型进行语义推理与描述生成)等关键技术模块,使最终输出的理解文本更加全面准确。

- 相关技术和原理

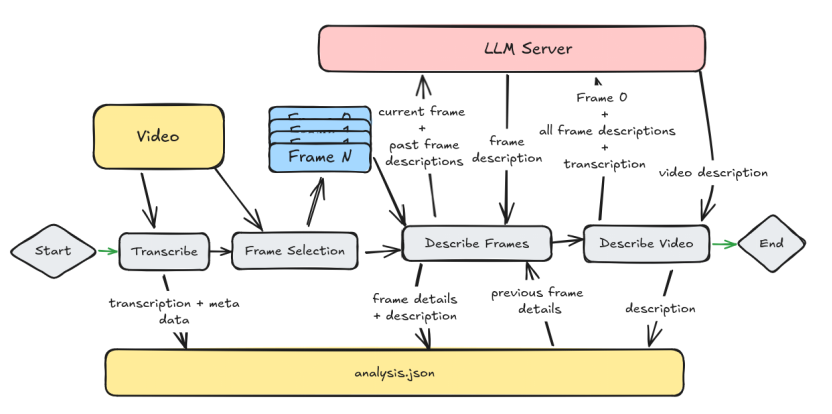

- 视频数据预处理——video-analyzer

在视频解码与帧抽取、音频提取与语音识别这方面,本系统采用了video-analyzer,一款开源的视频分析工具,它结合了Llama的11B视觉模型和OpenAI的Whisper模型,能够从视频中提取关键帧、转录音频内容,并生成高质量的帧细节。

video-analyzer首先使用OpenCV库对视频进行解码,并智能地选取关键帧,这些帧通过图像分析的方式提取出重要的视觉信息,以供后续模型进行深度理解。其中,这些关键帧的提取不仅会依据图像内容的变化,还考虑到时间上的连贯性,从而保证视频信息的完整性和准确性。

然后对于音频部分,video-analyzer利用Whisper模型进行高质量的音频转录,将视频中的语音内容转化为文本。Whisper模型具备强大的噪声鲁棒性,能够在各种低质量音频环境下,依然提供准确的转录结果。在此基础上,系统还可对音频进行处理,增强其清晰度,以进一步提高转录的准确性。视频的关键帧图像与音频转录文本通过Llama的11B视觉模型进行融合,后者对每一帧图像进行深度分析,提取出物体、场景和人物等信息。最终,生成的多模态数据将作为后续视频理解任务的输入,支持事件识别、情感分析、视频摘要等高层次的任务。

图2.1 video-analyzer工作流[25]

-

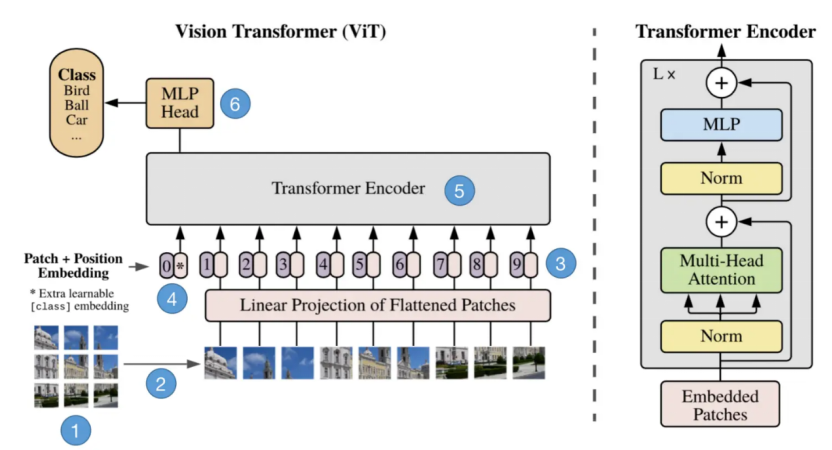

- 视觉特征提取——Visual Transformer(ViT)

对于视频帧的细节分析,本系统选用的是Visual Transformer(ViT)模型。ViT通过将图像划分为多个小块并将其编码为嵌入向量,能够捕捉图像中的空间关系。与传统的CNN模型相比,ViT具有更强的长程依赖建模能力,适合处理复杂的视觉任务。通过ViT提取的视觉特征不仅可以用于目标识别,还能为后续的多模态融合提供基础。

图2.2 ViT工作流[26]

- 输入的图形预处理

输入图像将会被切分为固定大小的不重叠图像块(例如 18×18像素),类似于一个句子中单词的个数。最后这些图像块随后被展平为一维向量成为1D序列。相关公式:

其中,X表示Token,Z表示输入的嵌入式补丁序列,(H,W)是输入图像分辨率,C是通道数,(P,P)是Token的分辨率,N则表示Token的总数。

2.Token的线性映射与特征融合

每个图像块对应的Token通过可学习的线性变换层进行降维处理,将原始高维像素数据压缩为统一尺度的低维嵌入表示。在此过程中,模型额外引入一个可优化的全局语义标记(Class Token),并将其插入图像块嵌入序列的起始位置。该标记通过端到端训练逐步学习图像的整体语义特征,最终作为分类任务的核心依据。为了弥补Transformer对空间关系建模的不足,模型为每个Token融合了位置编码向量(Position Embedding),通过显式注入图像块的二维坐标信息,增强模型对局部结构与全局布局的感知能力。

3.Transformer 编码器

经过线性投影和嵌入后,Token序列被传入Transformer编码器(Encoder)进行处理。编码器由多层Encoder堆叠和迭代计算,不从而断提炼输入Token的特征表示。其中Encoder主要以下3个模块组成。

多头自注意力机制(Multi-Head Self-Attention,MSA):

该模块通过多个注意力头(heads)进行计算每个Token与其他Token之间的注意力分数,从而捕获图像块之间的全局赖关系。多头机制允许模型同时关注多个特征或关系,提高表示能力。

残差连接与归一化(Add & Norm):

残差连接通过将自注意力层的输出与输入的嵌入补丁(Embedded Patches)相加(Add),允许模型学习到输入和输出之间的残差映射,而不是直接学习映射本身,通过此涉及来缓解深层网络训练中的梯度消失问题,增强稳定性。归一化(Norm)通过计算该层所有激活值的均值和方差来对激活值进行分布调整,使得模型的内部表示更加稳定,有助于加速训练过程并提高模型的泛化能力。

多层感知机块(MLP Block):

MLP Block是用于提取ClassToken。它包含两个线性层,这两个线性层之间穿插着非线性激活函数(如GELU)和Dropout层。第一个线性层对输入数据进行初步的线性变换,随后GELU激活函数引入非线性,使得模型能够学习更复杂的特征。接着,第一个Dropout层通过随机丢弃神经元的输出来减少过拟合。第二个线性层进一步对数据进行线性变换,而第二个Dropout层再次应用,以进一步正则化模型。

-

- 多模态语义融合技术

本系统通过结合图像特征与语音识别文本,采用先进的视觉-语言对齐模型,CLIP与VideoBERT,实现视频内容的联合语义建模,辅助讯飞大模型生成高质量的描述和结构化理解结果。

-

-

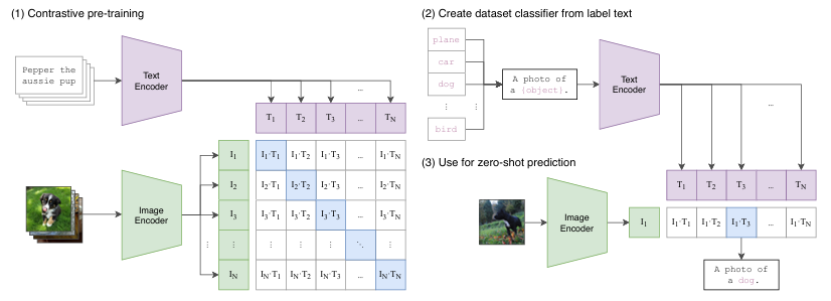

- CLIP

-

CLIP是一个多模态视觉模型。它通过创建图像与文本间的多模态嵌入空间,将视觉与文本的特征直接连接在一起。它训练的方法是使用对比学习,将正确的图像-文本对之间的相似度最大化,错误的图像-文本对之间的相似度最小化,因此它能够同时处理图像和文本数据。CLIP通过训练图像和对应文本的嵌入来学习图像与文本之间的关系,这使得模型能够理解图像和文本的语义。

图2.3 CLIP工作流[27]

如图2.3所示,CLIP的主要结构是一个文本编码器Text Encoder和一个图像编码器Image Encoder,然后计算文本向和图像向量的相似度来预测他们是否是一对。CLIP将图像和文本先分别输入一个图像编码器(image encoder)和一个文本编码器(text encoder),得到图像和文本的向量表示I-f和T_f。然后将图像和文本向量表示映射到一个联合的多模态空间(joint multimodal space),得到新的可直接进行比较的图像和文本向量表示I_e和T_e(这是多模态学习中常见的一种方法,不同模态数据表示之间可能存在gap),无法进行直接的比较,因此计算图像和文本向量之间的cosine相似度。

-

-

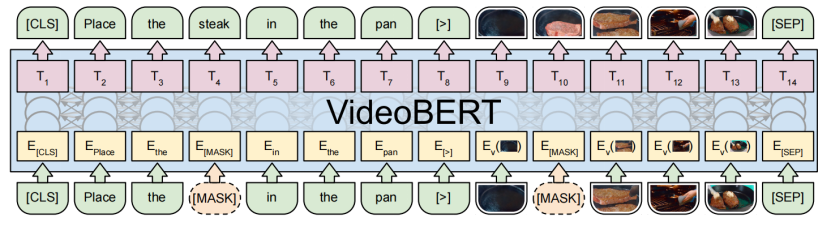

- VideoBERT

-

VideoBERT是Google提出的一种用于视频-语言联合建模的预训练框架,它借鉴了 BERT 的双向语言建模思想,将视频中的视觉信息转换为“视觉单词”,与语言文本共同输入 Transformer 架构中,并且将视频帧序列与对应文本串联建模,实现跨模态的时序建模与语义学习,挖掘出“时序+语义”信息。

图2. 4 VideoBERT架构图[28]