实现网页播放海康RTSP视频的详细指南

本文还有配套的精品资源,点击获取

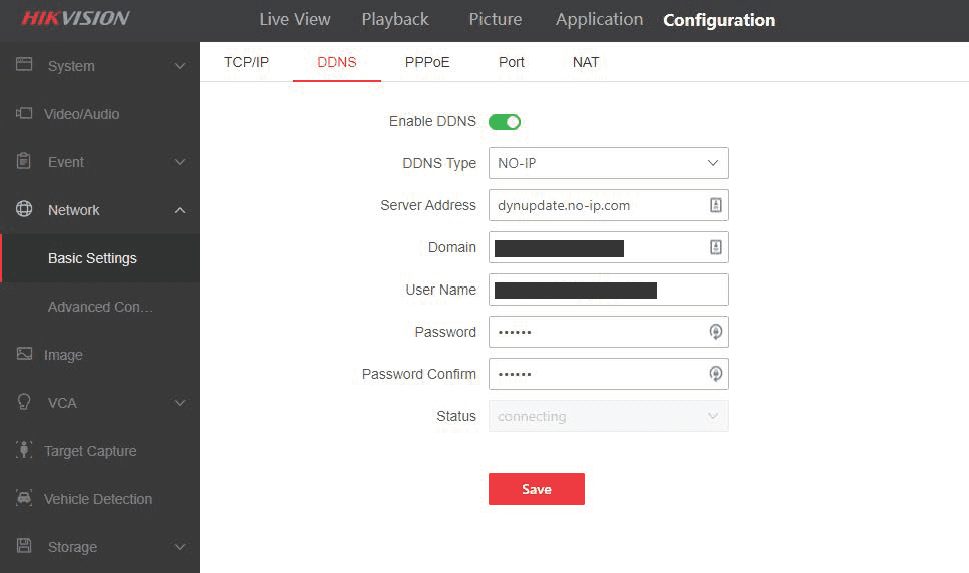

简介:本文介绍了如何在Web浏览器中展示海康威视网络摄像机的RTSP视频流。重点在于理解RTSP协议和解决浏览器兼容性问题。由于现代浏览器安全限制,不能直接嵌入RTSP视频流,所以需要借助HTML5 MSE或WebRTC技术。本文详细解释了将RTSP视频转换为浏览器可接受格式的过程,包括使用ffmpeg和可能需要的第三方库,并提供了配置服务器和JavaScript控制的步骤。压缩包”hk-master”中可能包含实现这些技术的示例代码。读者需要注意,实现过程中可能需要根据具体环境调整代码,例如处理防火墙和NAT问题。

1. 海康RTSP视频流介绍

海康威视与RTSP视频流概述

海康威视作为全球领先的视频监控设备生产商,提供了一系列高质量的视频监控解决方案。实时流协议(Real Time Streaming Protocol, RTSP)作为这类设备传输视频流的通用协议,允许客户端控制流媒体服务器上的媒体流,使得视频监控更加灵活、高效。在本章节中,我们将探索RTSP视频流的基础知识及其在海康威视产品中的应用。

RTSP视频流的特点和应用场景

RTSP视频流是一种网络控制协议,其特点在于它提供了一种用于控制时间同步和媒体流传输的机制。它采用标准端口6973,允许视频流在IP网络上进行实时传输,这对于需要低延迟的视频监控场景尤为重要。RTSP视频流的应用场景包括但不限于远程视频监控、在线教育、视频会议等。接下来的章节,我们将深入了解RTSP协议的细节以及如何解决它在现代网络中的兼容性问题。

2. RTSP协议基础

2.1 RTSP协议的基本概念

2.1.1 RTSP协议的作用与地位

实时流协议(Real Time Streaming Protocol, RTSP)是一种网络控制协议,用于控制具有实时属性的数据流。RTSP的主要作用是控制多媒体会话,允许客户端发送播放、暂停和其他指令给服务器。与HTTP不同的是,RTSP协议被设计为独立于传输层协议,而HTTP则是基于TCP/UDP之上的。

在媒体流传输领域中,RTSP扮演着“指挥家”的角色。媒体服务器可以根据RTSP指令如播放、暂停、快进或倒退等,来调整流媒体的传输。尽管RTSP不直接传输媒体数据,但它是实现流媒体控制和会话管理的基础。

2.1.2 RTSP协议的数据传输机制

RTSP协议主要基于请求/响应模型,它使用TCP或UDP作为传输层协议。通常,RTSP控制连接使用6970端口,而媒体数据传输通常采用RTP协议,基于UDP进行传输。

数据传输机制方面,RTSP协议首先通过建立控制连接来完成会话初始化。一旦控制连接建立,客户端可以发送SETUP请求来确定传输参数,如媒体格式和传输端口。随后,客户端可发送PLAY请求,服务器将根据设置的参数开始发送媒体数据。最后,客户端或服务器都可以发送TEARDOWN请求来终止会话。

2.2 RTSP协议的消息交互流程

2.2.1 请求和响应的详细步骤

RTSP交互过程涉及到多个消息类型,包括OPTIONS, DESCRIBE, SETUP, PLAY, PAUSE, TEARDOWN等。下面是请求和响应交互的基本步骤:

- OPTIONS - 客户端使用OPTIONS请求来了解服务器所支持的方法。

- DESCRIBE - 客户端发送DESCRIBE请求来获取媒体属性和描述。响应通常包含会话描述协议(SDP)数据。

- SETUP - 通过SETUP请求,客户端指定数据传输的端口和传输参数。

- PLAY - 客户端发送PLAY请求,服务器开始传输媒体流。

- PAUSE - 客户端可以暂停媒体流,而服务器保持媒体会话状态。

- TEARDOWN - 客户端或服务器发送TEARDOWN请求终止会话。

2.2.2 常见的RTSP方法与使用场景

RTSP提供了一系列方法来进行有效的媒体流控制,下面列出了一些常见的RTSP方法:

- PLAY - 用于开始媒体流的传输。客户端发送这个请求后,服务器开始以连续的方式发送数据包。

- PAUSE - 当需要暂停媒体流时使用,允许数据的接收者在不终止会话的情况下临时停止接收数据。

- TEARDOWN - 用于终止整个媒体会话。发送这个请求后,服务器会停止发送媒体数据,并且会话中的资源将被释放。

在不同场景中,这些方法的具体使用会有所不同。例如,在视频监控系统中,PAUSE和PLAY可用于切换录像回放的暂停和继续。在视频会议中,PLAY用于启动会议的视频流,而TEARDOWN则用于会议结束时断开连接。

2.3 RTSP协议的安全性考虑

2.3.1 加密和认证机制的介绍

由于RTSP协议经常用于传输敏感数据,因此安全性是不可或缺的。RTSP协议通过整合其他安全机制来实现加密和认证。其中,最常见的是使用传输层安全性协议(TLS),它提供了数据加密、数据完整性和身份验证。

为了实现认证,RTSP可以和简单的认证方法如HTTP基本认证(Basic Access Authentication)结合使用。这种方法通过客户端发送用户名和密码进行验证,虽然实现简单,但在安全性方面有局限。

2.3.2 实际部署中的安全策略

在实际部署中,一个有效的安全策略不仅包括数据加密和认证,还应该包括以下几点:

- 防火墙配置 :确保防火墙允许RTSP协议相关的端口通信,但同时也要限制不必要的访问。

- 使用SRTP :建议使用安全实时传输协议(SRTP)对RTP数据包进行加密,以提供更高级别的数据传输安全。

- 安全的认证机制 :部署更高级的认证方法,如数字证书或摘要认证,以加强安全性。

综上所述,RTSP协议在提供高效媒体流控制的同时,必须结合有效的安全措施来防止数据泄露和未授权访问。通过对安全性机制的合理配置,可以在确保数据安全的同时,实现媒体流的稳定传输。

3. 浏览器兼容性问题解析

3.1 浏览器对RTSP视频流的支持现状

3.1.1 不同浏览器厂商的实现差异

浏览器对RTSP(Real Time Streaming Protocol)的支持度各异,主要是由于RTSP协议通常需要额外的插件或中间件来处理。早期,像Adobe Flash Player或Microsoft Silverlight这样的插件在处理RTSP流上扮演了重要角色,但它们在现代Web应用中已逐渐被淘汰。当前,大多数现代浏览器更倾向于原生支持HTML5的MediaSource Extensions(MSE)和WebRTC,这些技术可以提供无需插件的流媒体服务。

- Chrome : Google的Chrome浏览器曾经支持通过NPAPI插件方式使用RTSP,但由于安全性和性能的考虑,这一支持已从Chrome 53开始被移除。Chrome现在更推荐使用WebRTC和MSE。

- Firefox : Firefox浏览器在其较新版本中已经不再支持NPAPI插件,包括那些用于RTSP流的插件。但Firefox通过WebRTC提供流媒体的支持。

- Safari : Apple的Safari浏览器对RTSP的支持有限,主要通过QuickTime插件实现,但随着Safari 12的发布,该插件已经被移除,导致RTSP流的支持也一同被移除。

- Microsoft Edge : 新版的Microsoft Edge基于Chromium,与Chrome有着相似的支持策略,不再支持NPAPI插件,并推荐使用WebRTC和MSE。

3.1.2 兼容性问题的常见表现

当尝试在现代浏览器中播放RTSP视频流时,通常会遇到以下几种兼容性问题:

- 加载失败 : 浏览器无法识别或加载RTSP URL,通常显示为无法播放视频或“找不到资源”等错误信息。

- 播放中断 : 在某些情况下,浏览器可以开始播放视频流,但会在短时间内中断,无法实现流畅播放。

- 格式不支持 : 即使某些浏览器可能支持某种视频编解码格式,但对于RTSP协议本身并不支持,从而导致不能正常播放。

3.2 兼容性问题的解决策略

3.2.1 使用转码服务和流媒体服务器

由于原生浏览器对RTSP的支持有限,一种常见的解决方案是使用支持RTSP的流媒体服务器,如Nginx配合RTMP模块或使用专业的流媒体服务器软件如Wowza Streaming Engine、Red5 Pro等。这些服务器可以将RTSP流转码为浏览器可接受的格式(如HLS或DASH),然后通过HTML5的 标签进行播放。

3.2.2 前端代码的兼容性适配技术

为了在不同的浏览器环境下提供一致的用户体验,前端开发者可以采用多种技术手段:

- 探测支持 : 使用JavaScript探测浏览器对RTSP流的支持情况,根据结果采取不同的播放策略。

- polyfill : 虽然RTSP没有官方的polyfill,但可以通过JavaScript来模拟某些浏览器对RTSP流的行为。

- WebRTC shim : 由于WebRTC在不同浏览器间的兼容性较好,可以通过shim技术,让WebRTC充当RTSP流的容器。

3.3 未来浏览器兼容性的发展趋势

3.3.1 Web标准的发展对RTSP的支持

随着Web技术的发展,Web标准组织正在考虑如何在不需要插件的情况下支持更多的媒体协议。MSE和WebRTC的完善和推广预示了未来浏览器对实时视频流支持的可能方向。

3.3.2 新兴技术对兼容性的改善

- WebSockets : 可以用于建立一个长连接的持久通道,这在实现客户端与服务器间稳定传输实时视频数据时非常有用。

- Media Source Extensions (MSE) : MSE允许JavaScript动态地构建媒体流供

- WebTransport : 新兴的WebTransport协议旨在提供低延迟、可靠的通信通道,对于实时视频流传输也可能有重要意义。

通过采用这些新兴技术和标准化的Web API,开发者可以为RTSP视频流提供更好的跨浏览器兼容性,并且能够在不牺牲性能和用户体验的前提下,实现更为广泛的应用。

4. HTML5 MediaSource Extensions (MSE) 应用

4.1 MSE技术概述

4.1.1 MSE在实时视频流中的角色

MediaSource Extensions (MSE) 是一个允许网页直接控制媒体轨道的媒体流API,它为HTML5视频元素添加了动态的媒体轨道构建能力。MSE为实时视频流带来了显著的优势,尤其是在网络延迟和自定义媒体流行为方面。传统上,浏览器仅支持有限的媒体流格式,例如MPEG-DASH和HLS,这些格式依赖于特定的服务器端组件和预处理步骤。MSE打破了这种限制,它让开发者可以编写代码来动态地将媒体片段添加到视频播放器的缓冲区中,从而提供更为灵活的实时视频处理能力。

MSE通过提供对媒体源的完全控制,使得开发者可以构建自己的流媒体传输协议,从而实现更为复杂和实时的视频处理场景。例如,在实时视频监控、视频会议和交互式直播中,MSE能够即时地处理和播放由服务器端推送的媒体片段。这种方式使得播放延迟降低,并且可以根据用户的网络条件动态调整视频的质量。

MSE的主要优势在于其对多种媒体格式的支持,以及对视频流的细粒度控制。它将视频流的接收和播放分解为一系列的媒体片段(media segments),播放器可以无缝地处理这些片段,从而实现流畅的播放体验。MSE的灵活性使得开发者可以构建更为复杂的应用逻辑,如视频点播服务、实时转码和多分辨率视频流的支持。

4.1.2 MSE与传统流媒体技术的比较

与传统的流媒体技术相比,MSE最大的差异在于它支持的媒体片段不需要遵循特定的格式规范,因此它能够更好地适应实时视频流的场景。而传统的流媒体技术,如HLS和MPEG-DASH,需要媒体文件被分割成多个小文件,并且每个小文件都有特定的格式和编码方式,这通常需要事先的转码和预处理。

MSE的另一个重要特点是它的兼容性和易用性。由于MSE是HTML5标准的一部分,它自然地被当前的现代浏览器所支持,这意味着开发者可以无需额外的插件或第三方库即可使用MSE来构建复杂的视频应用。相比之下,一些传统的流媒体技术可能需要额外的插件支持,这会限制用户群体并增加部署的复杂度。

此外,MSE的使用更为直接和灵活,它允许开发者直接通过JavaScript来处理媒体片段,提供了更多的编程控制点。传统的流媒体技术通常需要服务器端的配合,以便生成符合规范的媒体文件,这增加了系统的复杂性,并可能限制了某些实时操作的可能性。

4.2 MSE的编程实践

4.2.1 MSE的API介绍和基本用法

MSE提供了一组用于操作媒体源的API,其中最关键的是 MediaSource 对象。这个对象可以被添加到 元素的 srcObject 属性中,或者作为 MediaElementSourceNode 的一个来源节点。通过这种方式,开发者可以将媒体片段动态地提供给播放器。

下面是一个简单的MSE用法的例子:

// 创建一个新的MediaSource实例const mediaSource = new MediaSource();// 将MediaSource实例赋值给video元素的srcObjectconst video = document.querySelector(\'video\');video.src = URL.createObjectURL(mediaSource);// 创建一个sourceBuffer,可以是不同的类型,例如video/webmconst sourceBuffer = mediaSource.addSourceBuffer(\'video/webm; codecs=\"opus,vp8\"\');// 使用fetch API获取媒体片段fetch(\'path/to/your/media/segment.webm\').then(function(response) { return response.arrayBuffer();}).then(function(arrayBuffer) { // 将媒体片段添加到sourceBuffer中 sourceBuffer.appendBuffer(arrayBuffer);}); 上述代码展示了如何创建一个 MediaSource 实例,并将其与 元素关联起来。之后,通过异步请求媒体片段,并将其添加到 sourceBuffer 中,视频播放器就可以播放这些片段。

4.2.2 实际场景中MSE的优化技巧

在实际应用中,优化MSE的使用至关重要,以确保视频播放的流畅性、稳定性和质量。以下是一些常见的优化技巧:

-

智能缓冲管理 :通过监听

sourceopen,sourceended,sourceclose,updatestart,update,updateend,error事件,智能管理媒体片段的缓冲和播放。 -

自动适应网络变化 :根据网络状况动态调整媒体片段的大小和质量,以适应带宽变化。

-

错误处理和恢复 :实现健壮的错误处理逻辑,以便在

sourceBuffer更新失败时能够恢复播放。 -

视频质量选择 :允许用户根据自己的网络状况选择视频质量,以改善播放体验。

-

延迟减少 :通过减少媒体片段的长度来降低延迟,使得实时视频流的体验更加接近于实时。

-

预加载和预解析 :在视频播放之前预先加载和解析媒体片段,以减少初始延迟和缓冲时间。

4.3 MSE的高级应用

4.3.1 MSE在多媒体播放器中的集成

在现代的多媒体播放器中,MSE的集成提供了一个强大的平台,允许播放器支持更广泛的视频格式并且更灵活地处理视频数据。通过MSE,可以将从不同来源(如流媒体服务器、点播服务、本地文件等)获取的视频片段组合在一起,形成一个连续的视频播放体验。这种集成方式为播放器带来以下优势:

- 格式支持 :播放器可以支持更多的视频格式,包括那些服务器端不提供特殊支持的格式。

- 实时流处理 :对实时视频流进行处理,例如在直播场景下,可以实时插入广告或提醒。

- 视频质量动态切换 :根据用户的网络状态动态切换视频质量,提高播放的适应性和用户体验。

- 自定义视频处理 :播放器可以添加额外的视频处理,例如字幕叠加、实时滤镜应用等。

4.3.2 MSE与WebRTC结合的可能性与优势

WebRTC是另一个HTML5标准,它允许浏览器之间进行实时通信(RTC),例如视频通话。WebRTC主要专注于点对点的通信,而MSE提供了处理流媒体的强大工具,两者结合将大幅提升Web应用的视频功能。

WebRTC与MSE结合的可能性主要体现在以下方面:

- 实时视频流的录制和回放 :利用MSE可以将WebRTC捕获的实时视频流录制下来,并且可以被存储、回放或进一步处理。

- 混合视频流处理 :在WebRTC的视频通话中引入MSE,可以实现在通话过程中实时切换不同的媒体源,实现更丰富的功能,如虚拟背景、多视频拼接等。

- 优化和扩展WebRTC功能 :通过MSE对WebRTC捕获的视频流进行优化和处理,例如添加视频滤镜、文字或图像水印等。

通过将WebRTC和MSE技术相结合,开发者可以创建更为丰富和动态的Web视频应用,既能够实现实时通信,也能够对视频内容进行深度的定制和优化。

5. WebRTC技术用于实时视频流传输

实时通信(RTC)在现代网络应用中变得越来越重要,特别是在视频会议、在线教育、远程医疗等地方。WebRTC(Web Real-Time Communication)是一个支持网页浏览器进行实时语音对话、视频对话和点对点文件共享的开源项目。WebRTC的核心优势在于其无需安装任何插件,即可在几乎所有的现代浏览器上运行,支持跨平台的实时通信。

5.1 WebRTC技术简介

5.1.1 WebRTC的核心组件与优势

WebRTC技术包括一系列的API、协议和原生代码,使得开发者能够在网页上实现点对点的通信。WebRTC的核心组件包括:

- getUserMedia:这一API可以用来捕获用户的音频和视频输入。

- RTCPeerConnection:该API用于在网页浏览器之间建立连接,进行音视频数据的实时交换。

-

RTCDataChannel:用于在连接的浏览器之间交换任意数据。

WebRTC的优势在于: -

即插即用: 由于其内置于现代浏览器中,用户不需要安装任何插件或客户端。

- 跨平台兼容性: 可以在不同的操作系统和设备上使用。

- 端到端加密: WebRTC支持加密通信,保证了数据传输的安全性。

5.1.2 WebRTC在实时视频通信中的应用

WebRTC被广泛应用于各种实时通信场景中,包括但不限于:

- 视频会议:企业或个人通过浏览器进行远程视频交流。

- 社交网络:增加实时视频聊天功能,增强用户互动体验。

- 在线教育:实时的师生互动,以及在线课堂直播。

- 远程医疗咨询:实现远程诊断和病人咨询。

- 游戏:多人在线互动游戏,提高玩家的互动体验。

5.2 WebRTC的实践应用

5.2.1 WebRTC在浏览器中的实现细节

WebRTC在浏览器中通过JavaScript进行控制和实现,主要步骤包括:

- 获取媒体流 :通过getUserMedia API获取用户的音频和视频流。

- 建立连接 :使用RTCPeerConnection API建立与远程用户的连接。

- 数据传输 :通过RTCPeerConnection交换音频、视频以及任意数据。

- 会话控制 :包括会话描述协议(SDP)交换,以及各种信令过程。

// 示例代码:通过RTCPeerConnection建立连接const peerConnection = new RTCPeerConnection(configuration);// 添加音频和视频流navigator.mediaDevices.getUserMedia({ audio: true, video: true }) .then(stream => { stream.getTracks().forEach(track => peerConnection.addTrack(track, stream)); });// 添加监听器以处理连接事件peerConnection.onicecandidate = event => { if (event.candidate) { // 发送候选人信息给远程对端 }};// 当远程对端接受连接时的处理peerConnection.ontrack = event => { // 处理接收到的媒体流};5.2.2 WebRTC视频流的传输控制和性能优化

在WebRTC中,视频流的传输控制和性能优化主要关注以下几个方面:

- 带宽估计和拥塞控制 :WebRTC通过发送RTCP报告来估计可用带宽,并调整视频流的质量以适应网络条件。

- 视频编码优化 :使用适应性比特率(Adaptive Bitrate)流可以动态调整视频的质量,确保在网络条件变化时保持流的流畅性。

- NACK和FEC策略 :通过否定确认(Negative Acknowledgement,NACK)来重新传输丢失的数据包,通过前向纠错(Forward Error Correction,FEC)来减少数据包丢失的影响。

5.3 WebRTC与RTSP视频流的结合

5.3.1 WebRTC与RTSP的协议转换

由于WebRTC和RTSP使用不同的协议,为了将RTSP视频流转换为WebRTC流,需要一个中间件来处理协议转换。通常,这涉及到一个支持RTSP的服务器端,将RTSP流转换为WebRTC可识别的格式。这可以通过使用媒体服务器(如Janus、Kurento等)来实现。

5.3.2 实例分析:RTSP转WebRTC流的案例研究

在本案例研究中,我们将展示如何使用Janus媒体服务器将RTSP视频流转换为WebRTC流。以下步骤概述了该过程:

- 配置Janus服务器 :设置Janus以监听RTSP流,并配置相应的插件来转发为WebRTC兼容格式。

- 建立WebRTC连接 :在客户端通过WebRTC API与Janus服务器建立连接。

- 传输流 :Janus将RTSP流转换后,通过WebRTC发送给客户端浏览器。

graph LR A[RTSP Video Source] -->|RTSP Stream| B(Janus Server) B -->|WebRTC Stream| C(WebRTC Client)在上述流程中,Janus服务器充当了协议转换和流媒体分发的中心节点。实际的部署需要配置和优化Janus服务器以保证最佳性能和最低延迟。

通过这种转换方式,原本只支持RTSP协议的设备和应用也能够轻松接入现代的WebRTC兼容系统,拓宽了RTSP视频流的应用范围,并提高了其在不同平台之间的兼容性。

6. 服务器端与客户端代码的结合使用

6.1 服务器端处理RTSP视频流的策略

服务器端视频流的抓取和转码

在服务器端处理视频流,首要任务是从RTSP视频源获取视频数据,并且将其转码为适合网络传输的格式。例如,原始的视频流可能使用H.264编码,而网络传输更适合使用更加适应高压缩率的编码格式,比如H.265或VP9。

下面的代码片段展示了如何使用FFmpeg进行视频流的抓取和转码操作:

# FFmpeg命令行示例ffmpeg -i rtsp://IP:PORT/stream -c:v libx265 -preset fast -maxrate 500k -bufsize 500k -c:a libfdk_aac output.mp4-

-i rtsp://IP:PORT/stream是输入的RTSP流地址。 -

-c:v libx265指定视频编码器为H.265。 -

-preset fast和-maxrate 500k -bufsize 500k为编码预设和码率控制参数。 -

-c:a libfdk_aac指定音频编码器为FDK AAC。

服务器端可以使用如Node.js、Python等后端语言结合FFmpeg的API进行流媒体处理。此外,还可以利用Nginx配合RTMP模块进行实时视频流的转发和转码。

服务器端视频流的分发与管理

视频流处理完毕后,接下来的工作是将视频流分发给不同的客户端。这通常涉及到流媒体服务器的搭建与配置。常用的流媒体服务器有Nginx-RTMP、Red5、Wowza Streaming Engine等。这些服务器不仅支持多路并发传输,还提供对不同协议的支持,如RTMP、HLS、DASH等。

Nginx配置示例:

rtmp { server { listen 1935; application live { live on; exec_push ffmpeg -i rtmp://localhost/app/$name -c:v libx265 -c:a aac -f flv rtmp://localhost/show/$name; } }}-

listen 1935;表示RTMP服务器监听在1935端口。 -

live on;开启了实时推流。 -

exec_push后面是FFmpeg命令,用于将RTSP源转码并推送至HLS或RTMP等协议。

6.2 客户端代码的编写与实现

客户端视频播放器的设计

客户端视频播放器可以使用HTML5的 标签或者JavaScript库如Video.js、hls.js等来设计。这些库提供了对多种视频格式的支持,比如MSE (Media Source Extensions) 和WebRTC,它们还提供更加丰富的接口以供开发者控制视频的播放、缓存和其他行为。

Video.js示例代码:

Video.js - RTSP via MSE var player = videojs(\'myVideo\'); player.play(); 客户端与服务器端交互机制的构建

客户端与服务器端的交互涉及到HTTP请求、WebSocket连接等技术。客户端通过这些技术从服务器端获取视频流地址、播放状态、元数据等信息,并且可将用户的操作如播放、暂停、调整分辨率等信息反馈给服务器端。

示例流程:

- 客户端通过HTTP请求获取服务器端提供的视频流播放URL列表。

- 客户端选择一个视频流并通过

- 客户端播放器反馈播放状态给服务器端(可选)。

- 用户交互(如切换清晰度)通过JavaScript事件处理,并通过HTTP请求告知服务器端。

6.3 服务器端与客户端协同工作流程

实时视频流的处理和传输流程

在实时视频流的处理和传输流程中,服务器端主要负责流媒体的采集、转码、分发等操作,客户端则负责视频内容的展示、播放控制等。整个过程涉及到以下几个关键步骤:

- 视频源采集 :使用摄像头、手机等设备捕获视频流,或者从网络上获取RTSP流。

- 视频流转码 :将视频流转码为适合网络传输的格式,如H.264压缩后的MP4或FLV流。

- 流媒体分发 :使用流媒体服务器将转码后的视频流分发到网络,使得客户端可以访问。

- 客户端接收 :客户端使用HTML5、Flash Player或其他播放器接收并播放流媒体。

- 实时控制与反馈 :客户端可以实时控制播放器的行为,并且可以将播放状态和用户操作反馈给服务器端。

代码实现中可能遇到的问题与对策

在实现服务器端与客户端协同工作时,可能会遇到网络延迟、带宽限制、视频缓冲、协议兼容性等问题。对于这些问题,我们有以下几种对策:

- 优化转码设置 :根据网络环境调整视频码率,使用适应性码率流(Adaptive Bitrate Streaming,ABR)技术。

- 使用内容分发网络(CDN) :通过CDN降低延迟和缓解带宽压力。

- 客户端缓冲优化 :合理设置播放器缓冲时间,使用HLS或DASH等支持动态码率自适应的协议来减少缓冲。

- 使用WebRTC进行传输 :利用WebRTC的P2P技术,可以有效减少传输延迟,提高视频质量。

通过上述的介绍,我们可以看出服务器端与客户端协同工作的复杂性和技术深度。对于开发者来说,深入理解和掌握这些技术对于开发高质量的实时视频流应用至关重要。在下一章节中,我们将深入分析和研究示例代码和配置文件,以帮助读者更深入地了解实时视频流开发中的应用细节。

7. 示例代码或配置文件的分析与研究

在现代的IT开发实践中,理解并运用代码和配置文件对于保证系统性能至关重要。在本章节中,我们将深入探讨示例代码和配置文件的具体应用和分析方法。

7.1 示例代码的选取与解读

示例代码提供了一个具体实现的起点,但要真正理解其工作原理,我们必须深入研究代码的基本结构以及关键功能模块。

7.1.1 代码的基本结构与功能模块

首先,我们以一个简单的Python脚本作为例子,该脚本用于从RTSP视频流获取数据并显示在网页上。

from flask import Flask, Responseimport cv2app = Flask(__name__)def gen_frames(): camera = cv2.VideoCapture(\'rtsp://admin:password@192.168.1.64:554/Streaming/Channels/1\') while True: success, frame = camera.read() # read the camera frame if not success: break else: ret, buffer = cv2.imencode(\'.jpg\', frame) frame = buffer.tobytes() yield (b\'--frame\\r\\n\' b\'Content-Type: image/jpeg\\r\\n\\r\\n\' + frame + b\'\\r\\n\') # concat frame one by one and show result@app.route(\'/video_feed\')def video_feed(): return Response(gen_frames(), mimetype=\'multipart/x-mixed-replace; boundary=frame\')if __name__ == \'__main__\': app.run(host=\'0.0.0.0\', port=\'5001\')这段代码包含以下关键部分:

- Flask框架初始化:创建一个Flask应用实例。

- 视频帧生成器

gen_frames:从RTSP视频流中读取视频帧,并将其转换为JPEG格式。 - 视频流路由

video_feed:设置一个端点,允许通过HTTP流传输视频帧。

7.1.2 关键代码段的详细分析

让我们深入分析 gen_frames 函数,了解它是如何工作的:

-

cv2.VideoCapture:使用OpenCV的VideoCapture类从指定的RTSP URL获取视频流。 - 循环读取帧:循环确保连续获取视频帧。

- 帧编码:将视频帧编码为JPEG格式,以便通过HTTP传输。

- 帧数据生成器:使用

yield返回包含边界信息的MJPEG帧。

通过逐行分析代码,我们可以看到实现视频流传输的过程是如何分解成一系列有序的操作。

7.2 配置文件的作用与设置

配置文件是IT项目中不可或缺的元素,它们允许程序在不同的环境或条件下灵活运行。

7.2.1 流媒体服务器配置要点

在配置文件中,我们可能会看到类似如下的配置项:

http { server { listen 80; location / { # RTSP over HTTP proxy configuration proxy_pass http://192.168.1.64:554; proxy_buffer_size 128k; proxy_buffers 4 256k; proxy_busy_buffers_size 512k; } }}这个示例展示了一个Nginx服务器的配置,它将RTSP流通过HTTP代理传递到端口80。配置要点包括:

-

proxy_pass:指定RTSP代理地址。 -

proxy_buffer_size等:设置缓冲区大小来优化流媒体传输。

7.2.2 客户端播放器配置详解

在客户端播放器的配置中,可能包含如下配置项:

var player = new jsmpeg.Player(\'http://127.0.0.1:5001/video_feed\', { canvas: document.querySelector(\'canvas\'), autostart: true, audio: false});这是一段使用jsmpeg库创建的视频播放器的JavaScript代码,其关键配置点包括:

-

Player构造器:初始化一个视频播放器实例。 -

canvas属性:指定视频显示的HTML5 -

autostart属性:设置播放器是否自动开始播放。

7.3 代码与配置的调试与优化

调试和优化代码及配置是提升软件性能的关键环节。

7.3.1 调试过程中常见问题及其解决方案

在调试示例代码时,可能遇到的问题及其解决方案:

- 帧率低 :增大缓冲区,优化网络条件。

- 视频卡顿 :检查网络带宽,优化编码器设置。

7.3.2 优化策略和性能评估方法

优化策略可以包括:

- 视频编码优化 :使用H.264编码,调整帧率和分辨率。

- Web服务器配置 :优化Nginx配置,例如启用

proxy_cache。

性能评估方法可能涉及:

- 基准测试 :记录不同配置下的帧率和响应时间。

- 用户体验调研 :进行实际用户的观看体验测试。

通过以上章节,我们已经深入探讨了示例代码和配置文件在RTSP视频流处理中的应用和优化方法。理解这些知识点,对于从事IT行业的专业人士来说,不仅可以提升自身技能,还可以在实际工作中更加高效地处理相关任务。

本文还有配套的精品资源,点击获取

简介:本文介绍了如何在Web浏览器中展示海康威视网络摄像机的RTSP视频流。重点在于理解RTSP协议和解决浏览器兼容性问题。由于现代浏览器安全限制,不能直接嵌入RTSP视频流,所以需要借助HTML5 MSE或WebRTC技术。本文详细解释了将RTSP视频转换为浏览器可接受格式的过程,包括使用ffmpeg和可能需要的第三方库,并提供了配置服务器和JavaScript控制的步骤。压缩包”hk-master”中可能包含实现这些技术的示例代码。读者需要注意,实现过程中可能需要根据具体环境调整代码,例如处理防火墙和NAT问题。

本文还有配套的精品资源,点击获取