3D检测笔记:3D目标检测算法基础_3d框检测有哪些算法

目录

前言

本文前半部分介绍行内相关基础知识,对基于激光雷达点云的3D目标检测算法进行一个概论性的总结。

目标检测框架

类似二维视觉算法,基于三维点云的算法框架一般也采用主干网络+任务头的设计。

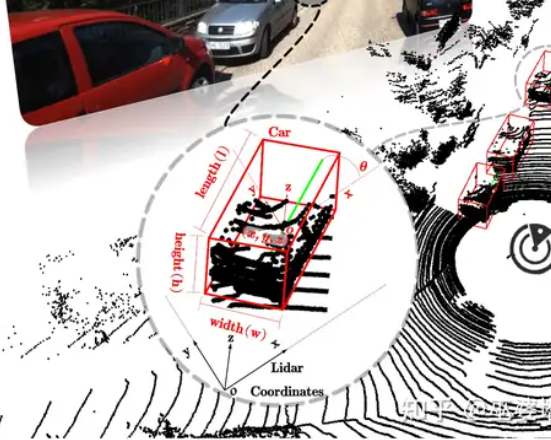

如上图所示,对于基于点云数据的三维算法输入的原始数据为三维坐标(x,y,z)+反射率(R),其中反射率与反射的物体材质相关。

目标检测评价指标

3D目标检测输出的结果一般是一个3Dbounding boxes(3D BBox),包含了长(L),宽(W),高(H),以及中心点位置(X,Y,Z)以及旋转角度(θ)

单一指标

3D目标检测的评价指标与2D目标检测的类似。首先根据标注框与预测框的 3D IOU 与阈值比较,判定预测结果是否为真,有一下三种情况:

- TruePositivte(TP):检测到目标。

- FalsePositivet(FP): 检测错误。

- FalseNegative(FN):漏检。

根据上面的指标可以计算出:

P r e c i s i o n = T P T P + F P Precision = \\frac{TP}{TP+FP}Precision=TP+FPTP

Precision即为所有预测为真的结果中实际为真的比例,代表对类别模型的识别准确率。当然,准确率高不意味着模型性能好,如果还遗漏很多未检出的目标模型性能也是不行的。因此还有Recall(召回率)参数,用来表征该类别的查全率:

R e c a l l = T P T P + F N Recall = \\frac{TP}{TP+FN}Recall=TP+FNTP

模型只有识别的准确率高,并且漏检的数量低才是是好模型。因此评价目标检测模型的性能必须综合Precise与Recall。

综合指标

-

AP(Average Precision)

在每次训练完后记录该轮的Recall以及Precision。当所有轮次结束后,以Recall为横坐标,Precision为纵坐标,绘制P-R曲线。

计算P-R曲线的面积即可得到AP指标的值。

A P = S p r AP = S_{pr} AP=Spr -

mAP(mean Average Precision)

前面AP的计算是基于某一种类别的指标,我们的目标检测器一般能识别多个种类的目标,当然模型对不同类别的物体的识别能力是不同的,mAP就是把各个类别的AP值求平均,得到模型整体的识别性能:

m A P = ∑ m A P m mAP = \\frac{\\sum_{}^{m}AP}{m} mAP=m∑mAP

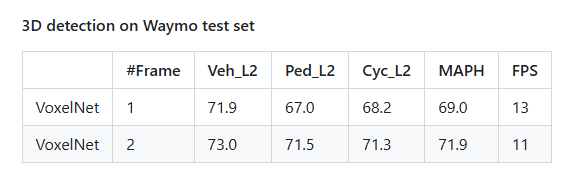

下面以centerpoint的指标截图为例:

m A P H = 71.9 + 67.0 + 68.2 3 ≈ 69 mAPH = \\frac{71.9+67.0+68.2}{3} \\approx 69 mAPH=371.9+67.0+68.2≈69

3D检测算法分类

3D检测算法根据输入的数据大致可以分为纯点云、纯视觉、多模态融合这三种方法。

- 纯点云方法

基于原始点云数据直接进行3D目标检测,核心是处理点云的空间结构。

空间栅格化:将点云划分成规则的体素或柱状单元,典型算法有:

体素 - voxel_net:通过体素化实现点云的离散化表示,适合大规模点云的高效处理。

柱状 - point pillars:将点云沿垂直方向分层,通过柱状特征聚合提升检测精度。

点集方法:直接对点云点集进行特征提取与分类,典型算法有:

point_net / point_net++:通过多层感知机(MLP)对点集特征进行编码,逐步提升特征表达能力。 - 纯视觉方法

依托图像(如RGB、深度图)进行3D目标检测,核心是通过视觉信息推断深度与空间关系。

深度估计:通过单目或多目视觉技术估算场景深度,辅助3D定位。

伪点云:将图像信息转换为“伪点云”形式,再采用类似纯点云的方法进行检测,融合视觉与点云的检测逻辑。 - 多模态融合方法

结合点云、图像、激光雷达等多种传感器数据,通过特征级或决策级融合提升检测鲁棒性,是当前3D目标检测的主流方向之一。

3D检测算法发展

可以参考专栏里后面这篇文章,转载自知乎博主@巫婆塔里的工程师的一篇文章。