【开源项目】 Xget 一键解决 Docker 拉取超时,下载 GitHub 代码提速 3 倍_xget github

引言

最近频繁在 GitHub 拉代码、Docker Hub 拖镜像,或是从 Hugging Face 下模型时,总被网络超时和龟速下载折磨。直到发现 Xget一个开源的资源加速引擎,用起来简单直接,效果却意外地好。下面分享我的实测体验和配置方法。

正文

1. Xget 是什么?

Xget 是一个轻量级下载加速服务,核心是利用 Cloudflare 全球 330+ 边缘节点实现资源就近分发。支持 HTTP/3 协议和智能压缩(如 Brotli),实测下载延迟可压到 50 ms 内,传输效率提升 30%~60%。它不依赖复杂代理,而是通过统一前缀替换实现加速,比如将 https://github.com/ 替换为 https://xget.xi-xu.me/gh/。

2. 哪些场景适用?

覆盖主流开发和数据平台:

- 代码托管**:GitHub、GitLab(完整支持 Git 协议,包括

clone/push/LFS) - 包管理:npm、PyPI、conda、Maven

- AI/ML:Hugging Face 模型加速、OpenAI/Gemini API 代理

- 容器镜像:Docker Hub、GHCR、GCR(兼容

docker pull和 Kubernetes) - 其他:Linux 软件源(apt/dnf)、ArXiv 论文等。

3. 开箱即用的公共实例

直接使用官方公共实例 https://xget.xi-xu.me ,无需注册:

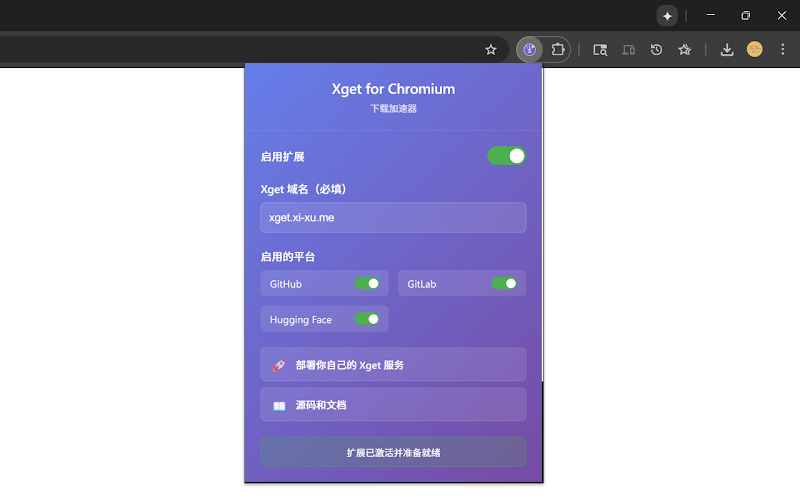

# 加速 GitHub 下载 wget https://xget.xi-xu.me/gh/microsoft/vscode/archive/refs/heads/main.zip # 加速 Hugging Face 模型 curl -O https://xget.xi-xu.me/hf/bert-base-uncased/resolve/main/pytorch_model.bin # Git 全局加速(一劳永逸) git config --global url.\"https://xget.xi-xu.me/gh/\".insteadOf \"https://github.com/\"若需浏览器自动重定向,可安装 Xget Now 扩展。

4. 私有化部署(3 分钟搞定)

公共实例偶尔限速?可一键部署到 Cloudflare Workers:

- 点击 Xget GitHub 仓库的 \"Deploy to Cloudflare Workers\" 按钮

- 登录 Cloudflare 账户,按提示授权

- 部署完成后,将脚本中的

xget.xi-xu.me替换为你的 Workers 域名(如xget.your-name.workers.dev)。

5. 安全与稳定性设计

- 安全防护:默认启用 HSTS、CSP 安全标头,过滤路径遍历攻击,仅允许 GET/HEAD 方法。

- 容错机制:请求超时 30 秒自动终止,失败时指数退避重试(最多 3 次)。

- 缓存优化:边缘节点缓存 30 分钟,重复下载接近瞬时完成。

6. 进阶使用技巧

- 容器镜像加速**:在 Docker 配置中添加镜像源:

// /etc/docker/daemon.json { \"registry-mirrors\": [\"https://xget.xi-xu.me/cr/ghcr\"] }- AI 推理 API 加速**:

import openai client = openai.OpenAI( api_key=\"YOUR_KEY\", base_url=\"https://xget.xi-xu.me/ip/openai/v1\" # 通过 Xget 代理 )- 多线程榨干带宽**:配合

aria2分片下载:

aria2c -x 16 https://xget.xi-xu.me/hf/microsoft/DialoGPT-large/resolve/main/pytorch_model.bin总结

Xget 的核心优势是简洁:不需要折腾镜像源列表或代理配置,一个 URL 前缀解决多平台加速。实测 GitHub 大仓库克隆从 10 分钟降到 2 分钟,Hugging Face 模型下载速度跑满带宽。对于偶尔需要跨境资源的开发者,它比自建 CDN 更轻量;而对高频需求者,一键私有部署也足够灵活。项目完全开源(GPL-3.0),代码在 GitHub,建议直接上手试试公共实例,再决定是否部署私有节点。

往期回顾:

🔥【开源项目】高效入门视觉强化学习,告别零散资料,一个开源项目搞定500+资源

🔥【开源项目】AIRI 一个能陪你打游戏、交谈的开源 AI 伴侣(二次元老婆)

🔥【开源项目】我在电脑上“养”了个能干活的AI助手:NeuralAgent上手记录