RNN模型数学推导过程(笔记)

一、定义

-

隐藏状态: 这是RNN的“记忆”或“状态”所在。它是一个向量(

h_t),总结了从序列开始(t=0)到当前时间步t所处理过的所有信息。h_t被传递给下一个时间步t+1,用于计算h_{t+1}。 -

输入: 在时间步

t,网络接收该时间步的输入向量x_t。 -

输出: 在时间步

t,网络可以产生一个输出向量y_t(例如,预测下一个词、分类当前情绪等)。y_t通常基于当前的隐藏状态h_t计算得出。

二、数学推导过程

标准的RNN单元在每个时间步 t 执行以下计算:

-

计算新的隐藏状态

h_t:

-

计算当前输出

y_t:

-

参数共享

RNN的一个关键特征是参数共享。

-

权重矩阵

W_{hh},W_{xh},W_{hy} -

偏置向量

b_h,b_y

在所有时间步 t 上都是相同的。这意味着无论序列有多长,网络都使用同一套参数来处理序列中的每一个元素。这极大地减少了需要学习的参数数量,使模型能够泛化到不同长度的序列,也体现了“循环”的本质:相同的计算单元在每个时间步重复使用。

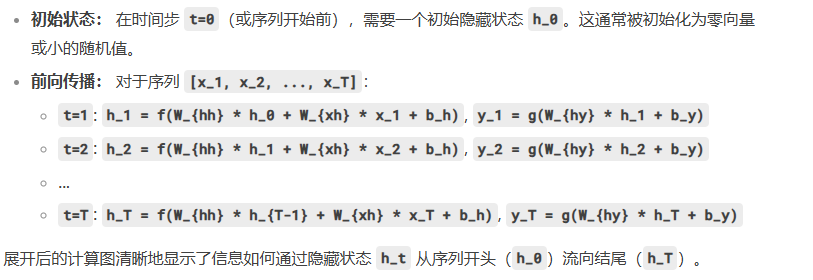

1、处理整个序列:展开计算图

为了更清晰地理解信息流动和便于实现(尤其是反向传播),我们通常将RNN在时间维度上“展开”。

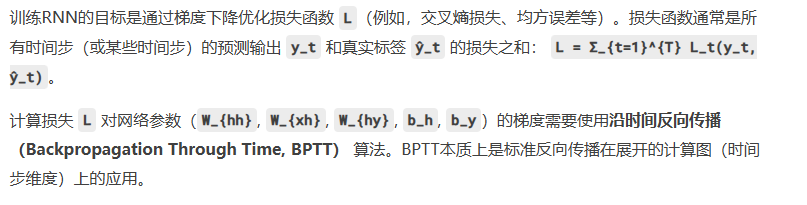

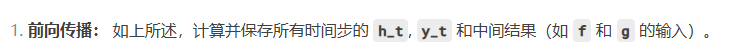

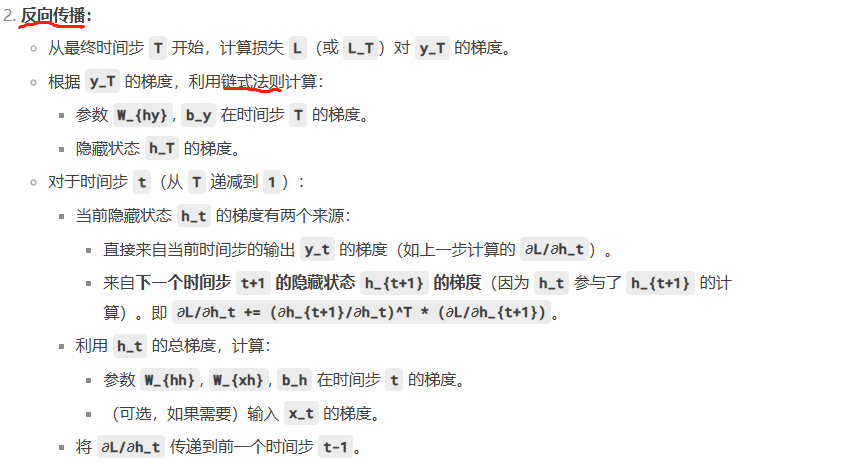

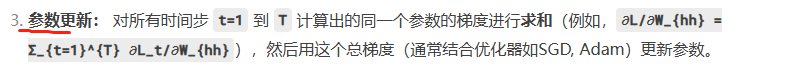

2、反向传播:BPTT(沿时间反向传播)

3、推导过程

三、核心挑战:梯度消失/爆炸问题

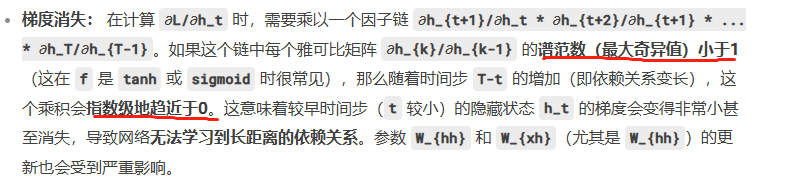

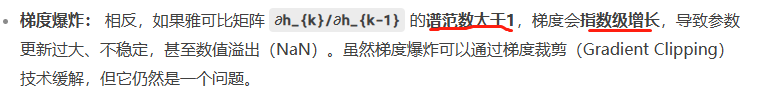

BPTT揭示了标准RNN的一个致命弱点:

1、梯度消失

2、梯度爆炸

四、为什么标准RNN难以学习长期依赖?

正是因为梯度消失问题,标准RNN的隐藏状态 h_t 主要受最近几个时间步的输入影响。当序列很长时,网络几乎“忘记”了序列开头的信息。这严重限制了RNN处理长序列的能力。

五、总结:标准RNN的数学原理