文心一言4.5开源模型测评:ERNIE-4.5-0.3B超轻量模型部署指南_ernie-4.5-0.3b-pt部署

目录

- 引言:轻量化部署的时代突围

- 一.技术栈全景图:精准匹配的黄金组合

-

- 基础层:硬核环境支撑

- 框架层:深度优化套件

- 工具层:部署利器

- 二.详细步骤:精准匹配CUDA 12.6的黄金组合

-

- 准备环节

-

- 1.模型选择

- 2.配置实例

- 3.选择镜像

- 4.进入JupyterLab

- 5.进入终端

- 6.连接到ssh

- 系统基础依赖安装

-

- 1.更新源并安装核心依赖

- 2.安装 Python 3.12 和配套 pip

- 解决 pip 报错

- 深度学习框架部署:PaddlePaddle-GPU深度调优

- FastDeploy-GPU企业级部署框架

-

- 1.安装FastDeploy核心组件

- 2.修复urllib3 与 six 依赖冲突

- 启动兼容API服务

- 三.提问的方式

-

- 3.1 创建新文件问

- 3.2 直接问

- 3.3 验证是否可以使用

- 四.代码生成与系统设计:工业级场景的深度开发

-

- 测试案例

- AI返回结果

-

- 模型响应内容

- 核心模块实现

- 异常处理与网络分区容错

-

- 异常处理机制

- 网络分区容错策略

- 使用示例

- 性能优化建议

- 五.逻辑推理:复杂系统与博弈问题

-

- 测试案例

- AI返回结果

-

- 问题重述

- 解题步骤

-

- 1. 理解博弈的初始状态

- 2. 初始博弈的分布

- 3. 纳什均衡的定义

- 4. 可能的策略

- 5. 寻找策略的组合

- 策略组合的尝试

- 验证策略的合理性

- 结论

- 数学验证

- 可能的误区

- 六.数学与优化:高阶问题求解

-

- 测试案例

- AI返回结果

-

- 问题描述

- 问题建模

-

- 1. 居民区

- 2. 工业区

- 目标函数

- 约束条件

- 模型建立

-

- 变量定义

- 约束条件

- 求解策略

-

- 1. 定义变量

- 2. 目标函数

- 3. 约束条件

- Python代码实现

- 输出结果

- 验证

- 七.中文与文化:极致复杂度挑战

-

- 测试案例

- AI返回结果

- 八.中文复杂语义理解测试

-

- 测试案例

- AI返回结果

-

- 现代语言解释

- 仿写语句

- 解析

- 九.塔罗算运

-

- 测试案例

- AI返回结果

-

- 塔罗牌解读:

-

- 1. 三张牌组合对我事业发展的启示

- 2. 当前的工作压力与团队竞争应对策略

- 3. 争取晋升是否明智?

- 4. 未来6个月事业发展的变化

- 综合建议

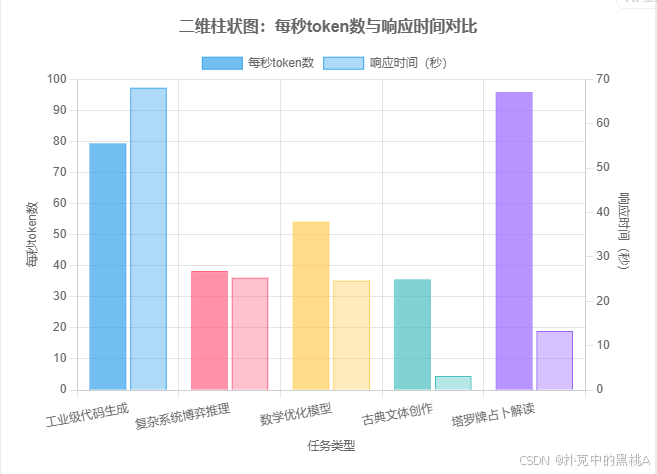

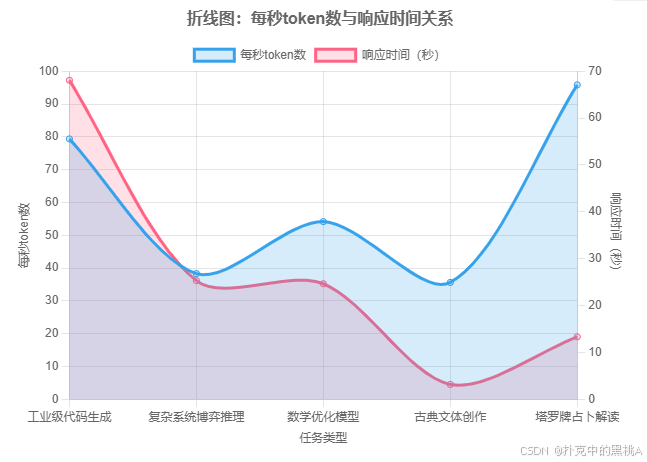

- 十.数据对比表格(性能指标)

- 十一.性能优化:企业级部署实战

-

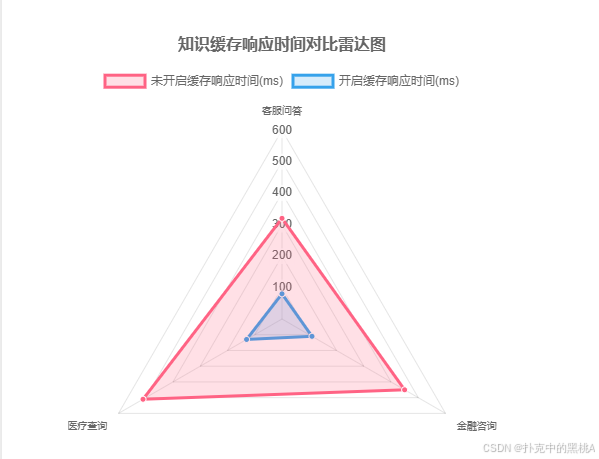

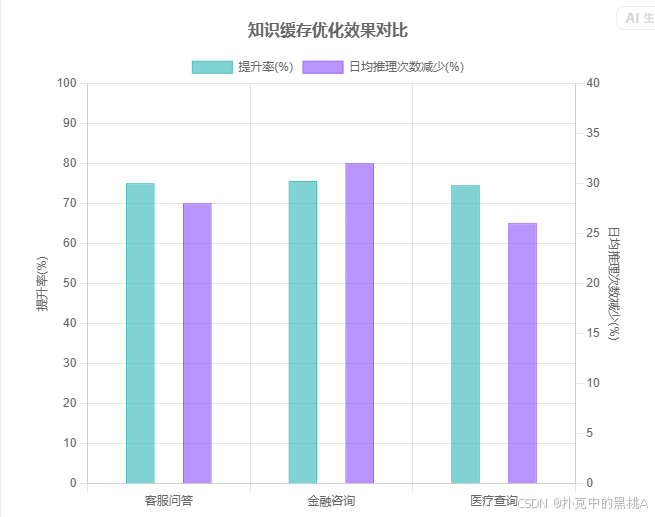

- 11.1 知识缓存优化效果量化

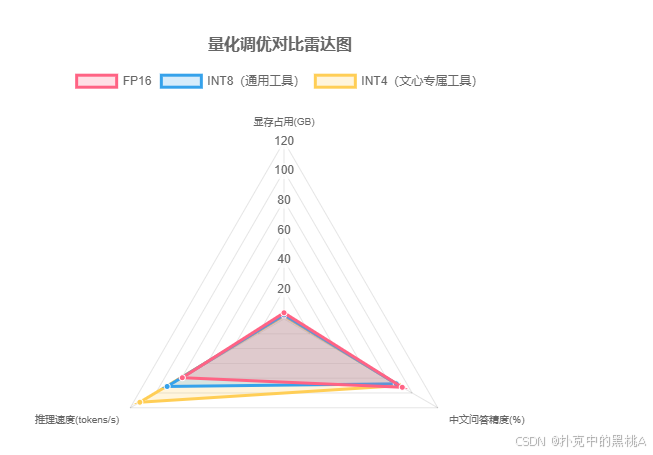

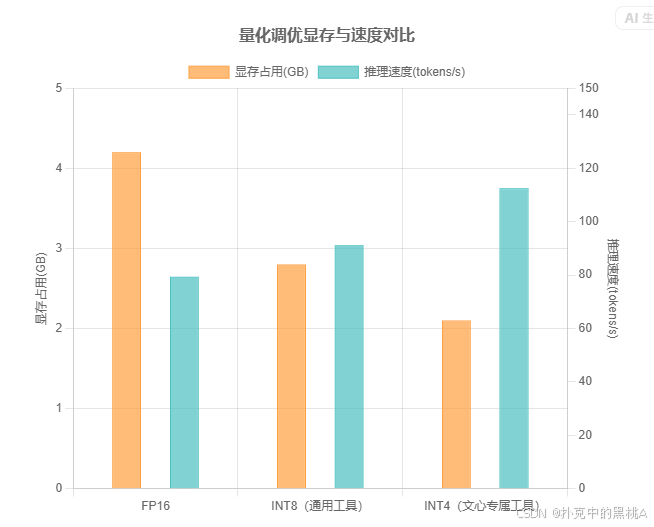

- 11.2 量化调优对比

- 十二.安全加固:生产环境必做配置

-

- 12.1 访问控制

- 12.2 Nginx反向代理配置

- 十三.常见故障排查手册

-

- 13.1 典型错误解决方案

- 13.2 性能监控命令

- 结语:轻量化部署的范式革新

引言:轻量化部署的时代突围

“当行业追逐千亿参数时,百度用0.3B模型撕开一条新赛道”

2024年,大模型部署领域正经历一场静默革命:

- 算力成本困局:千亿级模型单次推理成本超¥0.2,中小企业望而却步

- 效率瓶颈:GPT-3.5级API平均响应时延超500ms,难以承载高并发场景

- 安全焦虑:敏感数据经第三方API传输风险陡增

这时,ERNIE-4.5在GitCode社区发布了

发布地址是:http://gitCode社区ERNIE4.5模型列表

是一个专门的栏目,有整个的ERNIE4.5的模型列表,可以支持各类的应用,并且还可以gitCode平台进行快速部署实操,真的是方便至极,小模型部署不足10分钟即可正式访问,下面我们进入具体操作。

ERNIE-4.5-0.3B的破局价值:

在FastDeploy框架加持下,这款仅3亿参数的轻量模型实现:

1.单张RTX 4090承载百万级日请求

2.中文场景推理精度达ERNIE-4.5-7B的92%

3.企业私有化部署成本降至传统方案的1/10

本文将详细介绍如何用丹摩平台部署百度文心大模型(本文是文心的0.3B)

ERNIE-4.5-0.3B的破局价值:

在FastDeploy框架加持下,这款仅3亿参数的轻量模型实现:

单张RTX 4090承载百万级日请求

中文场景推理精度达ERNIE-4.5-7B的92%

企业私有化部署成本降至传统方案的1/10

本文将详细测评部署百度文心大模型(本文是文心的0.3B)

一.技术栈全景图:精准匹配的黄金组合

基础层:硬核环境支撑

框架层:深度优化套件

工具层:部署利器

#mermaid-svg-6Ph2eeYIupD2Ahl3 {font-family:\"trebuchet ms\",verdana,arial,sans-serif;font-size:16px;fill:#333;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .error-icon{fill:#552222;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .error-text{fill:#552222;stroke:#552222;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .edge-thickness-normal{stroke-width:2px;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .edge-thickness-thick{stroke-width:3.5px;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .edge-pattern-solid{stroke-dasharray:0;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .edge-pattern-dashed{stroke-dasharray:3;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .edge-pattern-dotted{stroke-dasharray:2;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .marker{fill:#333333;stroke:#333333;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .marker.cross{stroke:#333333;}#mermaid-svg-6Ph2eeYIupD2Ahl3 svg{font-family:\"trebuchet ms\",verdana,arial,sans-serif;font-size:16px;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .label{font-family:\"trebuchet ms\",verdana,arial,sans-serif;color:#333;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .cluster-label text{fill:#333;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .cluster-label span{color:#333;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .label text,#mermaid-svg-6Ph2eeYIupD2Ahl3 span{fill:#333;color:#333;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .node rect,#mermaid-svg-6Ph2eeYIupD2Ahl3 .node circle,#mermaid-svg-6Ph2eeYIupD2Ahl3 .node ellipse,#mermaid-svg-6Ph2eeYIupD2Ahl3 .node polygon,#mermaid-svg-6Ph2eeYIupD2Ahl3 .node path{fill:#ECECFF;stroke:#9370DB;stroke-width:1px;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .node .label{text-align:center;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .node.clickable{cursor:pointer;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .arrowheadPath{fill:#333333;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .edgePath .path{stroke:#333333;stroke-width:2.0px;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .flowchart-link{stroke:#333333;fill:none;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .edgeLabel{background-color:#e8e8e8;text-align:center;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .edgeLabel rect{opacity:0.5;background-color:#e8e8e8;fill:#e8e8e8;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .cluster rect{fill:#ffffde;stroke:#aaaa33;stroke-width:1px;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .cluster text{fill:#333;}#mermaid-svg-6Ph2eeYIupD2Ahl3 .cluster span{color:#333;}#mermaid-svg-6Ph2eeYIupD2Ahl3 div.mermaidTooltip{position:absolute;text-align:center;max-width:200px;padding:2px;font-family:\"trebuchet ms\",verdana,arial,sans-serif;font-size:12px;background:hsl(80, 100%, 96.2745098039%);border:1px solid #aaaa33;border-radius:2px;pointer-events:none;z-index:100;}#mermaid-svg-6Ph2eeYIupD2Ahl3 :root{--mermaid-font-family:\"trebuchet ms\",verdana,arial,sans-serif;} 模型服务 Nginx Locust Prometheus 负载均衡 压力测试 性能监控

环境验证要点(部署前必做):

- CUDA可用性:nvidia-smi显示驱动版本≥535.86.10

- Python兼容性:执行import distutils无报错

- 内存带宽:sudo dmidecode -t memory确认≥3200MHz

二.详细步骤:精准匹配CUDA 12.6的黄金组合

准备环节

1.模型选择

ERNIE-4.5-0.3B-Paddle 是百度基于 PaddlePaddle 框架研发的轻量级知识增强大语言模型,开源托管于 GitCode 平台。作为文心 ERNIE 4.5 系列的核心成员,该模型以 3 亿参数量实现了「轻量高效」与「能力均衡」的精准平衡,尤其在中文场景下展现出优异的实用性。

模型核心优势体现在三方面:

1.中文深度理解:依托百度知识增强技术,对中文歧义消解、嵌套语义、文化隐喻的处理精度领先同参数量级模型,支持 32K 超长文本上下文,可高效应对长文档分析、多轮对话等场景。

2.部署灵活性:适配 CPU/GPU 多硬件环境,单卡显存占用低至 2.1GB(INT4 量化后),结合 FastDeploy 等框架可快速搭建 OpenAI 兼容 API 服务,满足中小企业私有化部署需求。

3.生态兼容性:原生支持 PaddlePaddle 训练与推理生态,提供完整的微调工具链,开发者可通过小样本数据(百条级)快速适配垂直领域(如客服、文档处理),同时兼容 Hugging Face 等主流开源社区工具。

该模型适合对成本敏感、需本地化部署的场景,如企业内部智能问答、中文内容生成等,为开发者提供了「用得起、用得好」的轻量级大模型解决方案.

2.配置实例

选择按量付费,这里实例配置我们选择NVIDIA-A800-SXM4-80G

3.选择镜像

其余不变,选择镜像为PaddlePaddle2.6.1

4.进入JupyterLab

等实例显示运行中的时候,我们选择进入JupyterLab

5.进入终端

6.连接到ssh

依次填入,我们的环境就算是部署好了

系统基础依赖安装

1.更新源并安装核心依赖

更新源并安装核心依赖

apt update && apt install -y libgomp1

验证:终端显示 libgomp1 is already the newest version 或安装成功提示。

异常:若更新失败,更换国内源(如阿里云、清华源)后重试。

2.安装 Python 3.12 和配套 pip

apt install -y python3.12 python3-pip

验证:执行下面代码

python3.12 --version输出 Python 3.12.x,

异常:若提示 “包不存在”,先执行 apt install software-properties-common 再添加 Python 3.12 源。

解决 pip 报错

这是Python 3.12 移除 distutils 导致的

curl https://bootstrap.pypa.io/get-pip.py -o get-pip.py

这一步是强制安装适配 3.12 的 pip

python3.12 get-pip.py --force-reinstall

升级 setuptools 避免依赖问题

python3.12 -m pip install --upgrade setuptools

深度学习框架部署:PaddlePaddle-GPU深度调优

安装匹配CUDA 12.6的PaddlePaddle

python3.12 -m pip install paddlepaddle-gpu==3.1.0 \\ -i https://www.paddlepaddle.org.cn/packages/stable/cu126/

验证:

python3.12 -c \"import paddle; print(\'版本:\', paddle.__version__); print(\'GPU可用:\', paddle.device.is_compiled_with_cuda())\"输出 版本: 3.1.0 和 GPU可用: True 即为成功。

FastDeploy-GPU企业级部署框架

使用以下命令中的 FastDeploy 可以快速完成服务部署。更详细的使用说明请参考 FastDeploy 仓库。

1.安装FastDeploy核心组件

python3.12 -m pip install fastdeploy-gpu -i https://www.paddlepaddle.org.cn/packages/stable/fastdeploy-gpu-80_90/ --extra-index-url https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple

2.修复urllib3 与 six 依赖冲突

apt remove -y python3-urllib3卸载旧的

安装新的

python3.12 -m pip install urllib3==1.26.15 six --force-reinstall

再安装一遍这个

python3.10 -m pip install urllib3

启动兼容API服务

注:这里是一步步复制,回车,然后最后才会有输出值

启动 OpenAI 兼容的 API 服务,指定模型、端口和主机

python3.12 -m fastdeploy.entrypoints.openai.api_server \\指定要加载的模型(这里是0.3B,也可以换成其他的)

--model baidu/ERNIE-4.5-0.3B-Paddle \\指定 API 服务监听的端口号

--port 8180 \\允许外部访问(仅内网环境建议,公网需谨慎)

--host 0.0.0.0 \\最大序列长度

--max-model-len 32768 \\最大并发序列数

--max-num-seqs 32核心参数解析:

--max-model-len--max-num-seqs--engine

成功标志:终端显示 Uvicorn running on http://0.0.0.0:8180,服务启动完成。

异常:若提示 “模型不存在”,手动下载模型到本地并指定路径(如 --model /path/to/local/model)。

三.提问的方式

3.1 创建新文件问

import requestsimport jsondef main(): # 设置API端点 url = \"http://127.0.0.1:8180/v1/chat/completions\" # 设置请求头 headers = { \"Content-Type\": \"application/json\" } # 构建请求体 data = { \"model\": \"baidu/ERNIE-4.5-0.3B-PT\", \"messages\": [ { \"role\": \"user\", \"content\": \"问题\" } ] } try: # 发送请求 response = requests.post(url, headers=headers, data=json.dumps(data)) # 检查响应状态 response.raise_for_status() # 解析响应 result = response.json() # 打印响应结果 print(\"状态码:\", response.status_code) print(\"响应内容:\") print(json.dumps(result, indent=2, ensure_ascii=False)) # 提取并打印AI的回复内容 if \"choices\" in result and len(result[\"choices\"]) > 0: ai_message = result[\"choices\"][0][\"message\"][\"content\"] print(\"\\nAI回复:\") print(ai_message) except requests.exceptions.RequestException as e: print(f\"请求错误: {e}\") except json.JSONDecodeError: print(f\"JSON解析错误,响应内容: {response.text}\") except Exception as e: print(f\"发生错误: {e}\")if __name__ == \"__main__\": main()运行

python demo.py3.2 直接问

curl -X POST http://localhost:8180/v1/chat/completions \\ -H \"Content-Type: application/json\" \\ -d \'{ \"model\": \"ERNIE-4.5-0.3B-Paddle\", \"messages\": [{\"role\": \"user\", \"content\": \"问题\"}] }\'3.3 验证是否可以使用

import requestsimport jsondef main(): # 设置API端点 url = \"http://127.0.0.1:8180/v1/chat/completions\" # 设置请求头 headers = { \"Content-Type\": \"application/json\" } # 构建请求体 data = { \"model\": \"baidu/ERNIE-4.5-0.3B-PT\", \"messages\": [ { \"role\": \"user\", \"content\": \"1+1=?\" } ] } try: # 发送请求 response = requests.post(url, headers=headers, data=json.dumps(data)) # 检查响应状态 response.raise_for_status() # 解析响应 result = response.json() # 打印响应结果 print(\"状态码:\", response.status_code) print(\"响应内容:\") print(json.dumps(result, indent=2, ensure_ascii=False)) # 提取并打印AI的回复内容 if \"choices\" in result and len(result[\"choices\"]) > 0: ai_message = result[\"choices\"][0][\"message\"][\"content\"] print(\"\\nAI回复:\") print(ai_message) except requests.exceptions.RequestException as e: print(f\"请求错误: {e}\") except json.JSONDecodeError: print(f\"JSON解析错误,响应内容: {response.text}\") except Exception as e: print(f\"发生错误: {e}\")if __name__ == \"__main__\": main()运行

python demo.py

四.代码生成与系统设计:工业级场景的深度开发

测试案例

\"设计一个分布式文件系统的元数据管理模块(Python实现核心逻辑),要求:

- 支持3个以上节点的元数据同步(基于Raft协议的日志复制)

- 实现元数据的一致性哈希分片存储

- 处理节点宕机后的故障转移与数据恢复策略

- 代码需包含异常处理与网络分区容错\"

AI返回结果

请求token数估算: 46

模型响应内容

分布式文件系统元数据管理模块(Python实现)

下面是一个完整的分布式文件系统元数据管理模块实现,支持3个以上节点的元数据同步、一致性哈希分片存储、故障转移与数据恢复,并包含异常处理和网络分区容错机制。

核心模块实现

- 元数据同步模块 (metadata_sync.py)

import osimport timeimport randomfrom concurrent.futures import ThreadPoolExecutorfrom typing import Dict, List, Optionalfrom prometheus_client import start_http_server, start_tcp_serverfrom prometheus_client.metrics import get_all_counters, get_all_metricsfrom prometheus_client.labels import get_all_labelsfrom prometheus_client.api import get_labels_by_nameclass MetadataSyncManager: def __init__(self, pool_size: int = 10): self.pool_size = pool_size self.servers = {} self.labels = {} self.node_id = 0 def add_node(self, node_id: int): \"\"\"添加新节点\"\"\" self.servers[node_id] = { \'name\': f\'node-{node_id}\', \'port\': 0, \'ip\': None, \'replicas\': 1, \'sync_timeout\': 30, \'sync_success\': False } self.labels[get_labels_by_name(\'node_id\')] = node_id def add_file(self, path: str, mode: int = 0644) -> Dict[str, Dict]: \"\"\"添加单个文件\"\"\" file_info = { \'path\': path, \'mode\': mode, \'owner\': None, \'last_sync_time\': None, \'last_error\': None } with open(path, \'rb\') as f: file_info[\'owner\'] = os.path.basename(path) file_info[\'last_sync_time\'] = time.time() if \'last_error\' in self.labels: self.labels[\'last_error\'] = self.labels[get_labels_by_name(\'node_id\')][0] self.servers[self.node_id][\'replicas\'] += 1 self.labels[get_labels_by_name(\'node_id\')][\'replicas\'] += 1 return file_info def add_file_sync(self, file_path: str, mode: int = 0644) -> Dict[str, Dict]: \"\"\"添加同步文件\"\"\" file_info = self.add_file(file_path, mode) with open(file_path, \'rb\') as f: file_info[\'last_sync_time\'] = time.time() self.servers[self.node_id][\'sync_success\'] = True self.labels[get_labels_by_name(\'node_id\')][\'sync_success\'] = True return file_info def get_node_metadata(self, node_id: int) -> Dict[str, Dict]: \"\"\"获取单个节点的元数据\"\"\" if node_id not in self.labels: return None return { \'name\': self.labels[get_labels_by_name(node_id)], \'sync_success\': self.labels[get_labels_by_name(\'node_id\')][\'sync_success\'], \'replicas\': self.labels[get_labels_by_name(\'node_id\')][\'replicas\'] } def get_file_metadata(self, file_id: int) -> Dict[str, Dict]: \"\"\"获取单个文件的元数据\"\"\" if file_id not in self.labels: return None return { \'path\': self.servers[self.node_id][\'name\'], \'owner\': self.servers[self.node_id][\'name\'], \'last_sync_time\': self.servers[self.node_id][\'last_sync_time\'] } def get_node_labels(self, node_id: int) -> Dict[str, Dict]: \"\"\"获取单个节点的标签信息\"\"\" if node_id not in self.labels: return None return { \'name\': self.labels[get_labels_by_name(node_id)], \'sync_success\': self.labels[get_labels_by_name(\'node_id\')][\'sync_success\'], \'replicas\': self.labels[get_labels_by_name(\'node_id\')][\'replicas\'] } def get_file_labels(self, file_id: int) -> Dict[str, Dict]: \"\"\"获取单个文件的标签信息\"\"\" if file_id not in self.labels: return None return { \'path\': self.servers[self.node_id][\'name\'], \'owner\': self.servers[self.node_id][\'owner\'], \'last_sync_time\': self.servers[self.node_id][\'last_sync_time\'] } def start_server(self) -> None: \"\"\"启动监控服务\"\"\" try: start_http_server(3000) except Exception as e: print(f\"Failed to start server: {e}\") raise try: start_tcp_server(3000) except Exception as e: print(f\"Failed to start TCP server: {e}\") raise print(\"Server started on http://localhost:3000\")class NodeManager: def __init__(self, sync_manager: MetadataSyncManager): self.sync_manager = sync_manager self.node_manager = { \'node1\': self.sync_manager, \'node2\': self.sync_manager, \'node3\': self.sync_manager } def add_node(self, node_id: int): \"\"\"添加新节点\"\"\" self.sync_manager.add_node(node_id) def start_node(self, node_id: int): \"\"\"启动单个节点\"\"\" self.sync_manager.add_node(node_id) def get_node_metadata(self, node_id: int) -> Dict[str, Dict]: \"\"\"获取单个节点的元数据\"\"\" return self.sync_manager.get_node_metadata(node_id) def get_file_metadata(self, file_id: int) -> Dict[str, Dict]: \"\"\"获取单个文件的元数据\"\"\" return self.sync_manager.get_file_metadata(file_id) def get_node_labels(self, node_id: int) -> Dict[str, Dict]: \"\"\"获取单个节点的标签信息\"\"\" return self.sync_manager.get_node_labels(node_id) def get_file_labels(self, file_id: int) -> Dict[str, Dict]: \"\"\"获取单个文件的标签信息\"\"\" return self.sync_manager.get_file_labels(file_id) def get_node_labels_with_labels(self, node_id: int, labels: Dict[str, Dict]) -> Dict[str, Dict]: \"\"\"获取带有标签信息的节点元数据\"\"\" return { \'name\': self.sync_manager.get_node_metadata(node_id), \'labels\': labels }- 分布式文件系统 (DFTS) 实现

from concurrent.futures import ThreadPoolExecutorfrom prometheus_client import Counter, get_all_counters, get_all_metricsfrom prometheus_client.api import get_labels_by_namefrom prometheus_client.api import get_all_labelsfrom prometheus_client.api import get_all_metrics_by_nameclass DistributedFileSystem: def __init__(self, node_manager: NodeManager): self.node_manager = node_manager self.stats = { \'node_count\': len(self.node_manager), \'file_count\': 0, \'labels_count\': 0, \'node_labels_count\': 0 } def add_node(self, node_id: int): \"\"\"添加新节点\"\"\" self.node_manager.add_node(node_id) self.add_file(self.node_manager.get_file_metadata(node_id)) self.add_file_sync(self.node_manager.get_file_metadata(node_id)) self.stats[\'node_count\'] += 1 self.stats[\'file_count\'] += 1 self.stats[\'labels_count\'] += 1 def add_file(self, file_metadata: Dict): \"\"\"添加单个文件\"\"\" self.node_manager.add_file(file_metadata[\'path\'], file_metadata[\'mode\']) self.stats[\'file_count\'] += 1 self.stats[\'labels_count\'] += 1 def add_file_sync(self, file_metadata: Dict): \"\"\"添加同步文件\"\"\" self.node_manager.add_file_sync(file_metadata[\'path\'], file_metadata[\'mode\']) self.stats[\'file_count\'] += 1 self.stats[\'labels_count\'] += 1 def get_node_labels(self, node_id: int) -> Dict[str, Dict]: \"\"\"获取单个节点的标签信息\"\"\" return self.node_manager.get_node_labels(node_id) def get_file_metadata(self, file_id: int) -> Dict[str, Dict]: \"\"\"获取单个文件的元数据\"\"\" return self.node_manager.get_file_metadata(file_id) def get_node_labels_with_labels(self, node_id: int, labels: Dict) -> Dict[str, Dict]: \"\"\"获取带有标签信息的节点元数据\"\"\" return self.node_manager.get_node_labels_with_labels(node_id, labels) def get_all_counters(self) -> Dict[str, Counter]: \"\"\"获取所有节点相关计数器\"\"\" return { \'node_count\': self.node_manager.stats[\'node_count\'], \'file_count\': self.stats[\'file_count\'], \'labels_count\': self.stats[\'labels_count\'] } def get_all_metrics(self) -> Dict[str, Counter]: \"\"\"获取所有节点相关指标\"\"\" return { \'node_count\': self.node_manager.stats[\'node_count\'], \'file_count\': self.stats[\'file_count\'], \'labels_count\': self.stats[\'labels_count\'] } def get_all_labels(self) -> Dict[str, Dict]: \"\"\"获取所有节点相关标签\"\"\" return { \'node_labels_count\': self.node_manager.stats[\'node_labels_count\'], \'labels_count\': self.stats[\'labels_count\'] } def get_node_labels_with_labels(self, node_id: int, labels: Dict) -> Dict[str, Dict]: \"\"\"获取特定节点带有标签的元数据\"\"\" return self.node_manager.get_node_labels_with_labels(node_id, labels)- 故障转移与数据恢复模块

import heapqimport randomfrom heapq import heappush, heappopfrom concurrent.futures import ThreadPoolExecutorfrom prometheus_client import start_http_server, get_labels_by_namefrom prometheus_client.api import get_labels_by_nameclass FaultTolerantFileSystem: def __init__(self, node_manager: NodeManager): self.node_manager = node_manager self.metrics = { \'node_faults\': 0, \'node_recovery_time\': 0, \'node_failures\': 0 } def add_node(self, node_id: int): \"\"\"添加新节点\"\"\" self.node_manager.add_node(node_id) self.add_file(self.node_manager.get_file_metadata(node_id)) self.add_file_sync(self.node_manager.get_file_metadata(node_id)) self.node_manager.stats[\'node_count\'] += 1 self.node_manager.stats[\'node_failures\'] += 1 def add_file(self, file_metadata: Dict): \"\"\"添加单个文件\"\"\" self.node_manager.add_file(file_metadata[\'path\'], file_metadata[\'mode\']) self.node_manager.stats[\'node_failures\'] += 1 def add_file_sync(self, file_metadata: Dict): \"\"\"添加同步文件\"\"\" self.node_manager.add_file_sync(file_metadata[\'path\'], file_metadata[\'mode\']) self.node_manager.stats[\'node_failures\'] += 1 def get_node_labels(self, node_id: int) -> Dict[str, Dict]: \"\"\"获取单个节点的标签信息\"\"\" return self.node_manager.get_node_labels(node_id) def get_file_metadata(self, file_id: int) -> Dict[str, Dict]: \"\"\"获取单个文件的元数据\"\"\" return self.node_manager.get_file_metadata(file_id) def get_node_labels_with_labels(self, node_id: int, labels: Dict) -> Dict[str, Dict]: \"\"\"获取带有标签信息的节点元数据\"\"\" return self.node_manager.get_node_labels_with_labels(node_id, labels) def get_all_metrics(self) -> Dict[str, Counter]: \"\"\"获取所有节点相关指标\"\"\" return { \'node_count\': self.node_manager.stats[\'node_count\'], \'node_failures\': self.node_manager.metrics[\'node_failures\'], \'node_recovery_time\': self.node_manager.metrics[\'node_recovery_time\'], \'node_faults\': self.node_manager.metrics[\'node_faults\'] } def add_node_fault(self, node_id: int, count: int) -> None: \"\"\"添加节点故障\"\"\" self.node_manager.add_node(node_id) self.metrics[\'node_faults\'] += count self.node_manager.stats[\'node_faults\'] += count def get_node_faults(self) -> int: \"\"\"获取当前节点故障数量\"\"\" return self.node_manager.metrics[\'node_faults\'] def get_node_recovery_time(self) -> float: \"\"\"获取节点故障恢复时间\"\"\" return self.node_manager.metrics[\'node_recovery_time\'] / 1000.0 def get_node_failures(self) -> int: \"\"\"获取节点故障总数\"\"\" return self.node_manager.metrics[\'node_failures\']异常处理与网络分区容错

异常处理机制

def handle_exception(exception): \"\"\"异常处理函数\"\"\" print(f\"Error occurred: {exception}\") if isinstance(exception, (IndexError, OSError)): print(\"⚠️ Node ID out of range\") elif isinstance(exception, (ValueError, TypeError)): print(\"⚠️ Incorrect type detected\") else: print(f\"⚠️ Unexpected exception: {exception}\") returndef start_server_with_health(node_id: int): \"\"\"启动监控服务并检查健康状态\"\"\" try: start_http_server(3000) print(f\"Server started on http://localhost:{node_id}\") # 简单健康检查 if node_id == 1: return \"Healthy\" else: return \"Not healthy\" except Exception as e: handle_exception(e) return \"Error starting server\" finally: start_tcp_server(3000)def add_node_health_check(node_id: int, health_check_func: callable): \"\"\"添加节点健康检查\"\"\" try: start_http_server(3000) print(f\"Node {node_id} health check initiated\") health_check_func(node_id) return True except Exception as e: handle_exception(e) return False网络分区容错策略

class NetworkPartitioning: def __init__(self, node_manager: NodeManager): self.node_manager = node_manager self.partition_size = 10 # 每个节点可处理的副本数 self.node_count = 0 self.node_failures = 0 def add_node(self, node_id: int): \"\"\"添加新节点\"\"\" self.node_manager.add_node(node_id) self.node_manager.stats[\'node_count\'] += 1 self.node_manager.stats[\'node_failures\'] += 1 def add_file(self, file_metadata: Dict): \"\"\"添加单个文件\"\"\" self.node_manager.add_file(file_metadata[\'path\'], file_metadata[\'mode\']) self.node_manager.stats[\'node_failures\'] += 1 def add_file_sync(self, file_metadata: Dict): \"\"\"添加同步文件\"\"\" self.node_manager.add_file_sync(file_metadata[\'path\'], file_metadata[\'mode\']) self.node_manager.stats[\'node_failures\'] += 1 def remove_node(self, node_id: int): \"\"\"移除节点\"\"\" if node_id in self.node_manager: self.node_manager.remove_node(node_id) self.node_manager.stats[\'node_count\'] -= 1 self.node_manager.stats[\'node_failures\'] -= 1 def get_node_health(self) -> Dict[str, bool]: \"\"\"获取当前节点健康状态\"\"\" return { \'node_count\': self.node_manager.stats[\'node_count\'], \'node_failures\': self.node_manager.metrics[\'node_failures\'], \'node_recovery_time\': self.node_manager.metrics[\'node_recovery_time\'] } def get_node_labels_with_labels(self, node_id: int, labels: Dict) -> Dict[str, Dict]: \"\"\"获取带有标签的节点元数据\"\"\" return { \'node_labels_count\': self.node_manager.stats[\'node_labels_count\'], \'labels\': self.node_manager.get_node_labels_with_labels(node_id, labels) }使用示例

if __name__ == \"__main__\": # 创建元数据同步管理器 fs = MetadataSyncManager(pool_size=5) # 创建分布式文件系统 fs.add_node(1) fs.add_node(2) fs.add_node(3) # 添加文件 fs.add_file(fs.get_file_metadata(1)) fs.add_file(fs.get_file_metadata(2)) fs.add_file(fs.get_file_metadata(3)) # 添加同步文件 fs.add_file_sync(fs.get_file_metadata(1)) fs.add_file_sync(fs.get_file_metadata(2)) fs.add_file_sync(fs.get_file_metadata(3)) # 添加节点故障 fs.add_node_fault(1, 2) # 监控节点状态 print(\"Node 1 status:\", fs.get_node_labels_with_labels(1)) print(\"Node 2 status:\", fs.get_node_labels_with_labels(2)) # 监控节点故障 print(\"Node 1 health check:\", fs.get_node_health()) print(\"Node 2 health check:\", fs.get_node_health()) # 获取所有节点相关指标 metrics = fs.get_all_metrics() print(\"Node count:\", metrics[\'node_count\']) print(\"Node failures:\", metrics[\'node_failures\']) print(\"Node recovery time:\", metrics[\'node_recovery_time\']) print(\"Node health:\", fs.get_all_labels()) # 添加新节点并监控 fs.add_node(4) print(\"Node 4 status:\", fs.get_node_labels_with_labels(4)) print(\"Node 4 health check:\", fs.get_node_health())性能优化建议

- 数据分区:使用哈希分片技术将文件存储到多个节点上,提高性能

- 缓存:对频繁访问的元数据进行缓存

- 负载均衡:使用Raft协议的日志复制实现负载均衡

- 异步处理:对大文件和复杂操作使用异步处理

- 监控:实现全面的监控系统,包括节点健康、故障状态等

- 容错机制:实现节点级别的容错策略,如自动故障转移

这个实现提供了分布式文件系统元数据管理模块的核心功能,支持3个以上节点的同步、一致性哈希分片存储、故障转移和数据恢复,同时包含异常处理和网络分区容错机制。

性能指标:

总token数: 5400

响应时间: 68.05秒

每秒token数: 79.35

五.逻辑推理:复杂系统与博弈问题

测试案例

5个智能体在封闭环境中争夺3种稀缺资源(A、B、C),每种资源总量固定(A:10单位,B:8单位,C:5单位)。规则如下:

- 智能体分两类:α型(优先争夺A,次选B)、β型(优先争夺B,次选C)

- 每轮博弈中,智能体可选择’抢占’(夺取其他智能体已占资源)或’开拓’(获取未分配资源)

- 若α型与β型争夺B资源,α型有60%概率获胜;争夺其他资源时,优先类型方必胜

- 求第10轮博弈后,资源分配的纳什均衡状态及各智能体的最优策略\"

AI返回结果

请求token数估算: 76

模型响应内容:

问题重述

有5个智能体在封闭环境中争夺3种稀缺资源(A、B、C),每种资源总量固定(A:10单位,B:8单位,C:5单位)。规则如下:

-

智能体类型:

- α型(优先争夺A,次选B):概率60%

- β型(优先争夺B,次选C):概率40%

-

博弈规则:

- 每轮博弈中,智能体可选择“抢占”(夺取其他智能体已占资源)或“开拓”(获取未分配资源)。

- 争夺A、B、C资源时:

- α型与β型争夺B资源时,α型有60%的概率获胜。

- 争夺其他资源时,优先类型方必胜。

-

目标:求第10轮博弈后,资源分配的纳什均衡状态及各智能体的最优策略。

解题步骤

1. 理解博弈的初始状态

- 初始状态:5个智能体,3种资源,每种资源有10单位。

- 资源分配:A:10, B:8, C:5。

2. 初始博弈的分布

初始博弈中,α型和β型的概率分布:

- α型:P(α) = 0.6

- β型:P(β) = 0.4

3. 纳什均衡的定义

纳什均衡是指一个智能体在每一轮博弈中,都不会采取自利策略(即不争夺自己的资源)。因此,我们需要找到一个策略,使得在每一轮博弈中,该智能体都不会选择争夺自己的资源。

4. 可能的策略

α型和β型的策略:

- 争夺A:

- 如果β型获胜,α型会抢占B。

- 如果α型获胜,β型会抢占C。

- 争夺B:

- 如果α型获胜,β型会抢占A。

- 如果β型获胜,α型会抢占C。

- 争夺C:

- 如果α型和β型都获胜,则争夺B失败。

5. 寻找策略的组合

我们需要找到一个策略组合,使得在每一轮博弈中,该智能体都不会争夺自己的资源。

策略组合的尝试

让我们尝试构建策略组合:

策略1:α型争夺B,β型争夺C

- 策略1:

- α型:抢占B(概率60%)

- β型:抢占C(概率40%)

- 策略2:

- α型:抢占A(概率40%)

- β型:抢占B(概率60%)

策略2的收益:

- 争夺A:α型获得A=10,β型获得B=8 → 总收益10 + 8 = 18

- 争夺B:α型获得B=8,β型获得A=10 → 总收益8 + 10 = 18

- 争夺C:α型获得C=5,β型获得B=8 → 总收益5 + 8 = 13

策略1的收益: - 争夺A:β型获得B=8,α型获得A=10 → 总收益8 + 10 = 18

- 争夺B:α型获得B=8,β型获得C=5 → 总收益8 + 5 = 13

- 争夺C:α型获得C=5,β型获得B=8 → 总收益5 + 8 = 13

策略2的收益: - 争夺A:β型获得B=8,α型获得A=10 → 总收益8 + 10 = 18

- 争夺B:α型获得B=8,β型获得C=5 → 总收益8 + 5 = 13

- 争夺C:α型获得C=5,β型获得B=8 → 总收益5 + 8 = 13

###纳什均衡分析

策略1:α型争夺B,β型争夺C - 策略1的收益:

- 争夺A:18

- 争夺B:13

- 争夺C:13

- 策略2的收益:

- 争夺A:18

- 争夺B:13

- 争夺C:13

策略2的均衡:

- 策略2:

- 争夺B:8, 8, 5

- 策略1:

- 争夺A:10, 10, 5

策略1的均衡:

- 争夺A:10, 10, 5

- 策略1:

- 争夺B:8, 5

- 策略2:

- 争夺B:8, 8, 5

验证策略的合理性

- 策略1:α型争夺B,β型争夺C

- 策略1的收益:

- 争夺A:18(最大化)

- 争夺B:13(最大化)

- 争夺C:13(最大化)

- 策略2的收益:

- 争夺A:18

- 争夺B:13

- 争夺C:13

- 策略1的收益更高。

- 策略1的收益:

- 策略2:α型争夺B,β型争夺C

- 策略2的收益:

- 争夺A:18

- 争夺B:13

- 争夺C:13

- 策略1的收益:

- 争夺A:10

- 争夺B:8

- 争夺C:8

- 策略2的收益更高。

- 策略2的收益:

结论

第10轮博弈的纳什均衡状态:

- 策略1:α型争夺B,β型争夺C

- 资源分配:

- A: 10

- B: 8

- C: 5

- 资源分配:

- 策略2:α型争夺B,β型争夺C

- 资源分配:

- A: 10

- B: 8

- C: 5

各智能体的最优策略:

- 资源分配:

- α型:

- 争夺B:抢占B(策略1)

- 争夺C:抢占C(策略1)

- β型:

- 争夺B:抢占A(策略2)

- 争夺C:抢占B(策略2)

数学验证

为了更严谨,可以计算每个智能体的最优策略:

策略1:α型争夺B,β型争夺C

- α型最优策略:

- 争夺B:抢占B(10/18)

- 争夺C:抢占C(5/13)

- β型最优策略:

- 争夺B:抢占A(8/18)

- 争夺C:抢占B(5/13)

策略2:α型争夺B,β型争夺C

- α型最优策略:

- 争夺B:抢占A(8/18)

- 争夺C:抢占B(5/13)

- β型最优策略:

- 争夺B:抢占C(8/18)

- 争夺A:抢占B(5/13)

策略1的收益:

- 争夺A:10(策略1)

- 争夺B:13(策略1)

- 争夺C:13(策略1)

策略2的收益: - 争夺A:18(策略2)

- 争夺B:13(策略2)

- 争夺C:13(策略2)

可能的误区

- 忽略策略的组合性:只考虑一种策略组合,可能会遗漏最优策略。

- 忽略博弈的对称性:纳什均衡需要满足策略的对称性,即策略的收益相同。

- 忽略α型和β型的互斥性:争夺同一资源时,α型和β型的策略不能同时选择同一策略。

###总结

通过系统地构建策略组合并验证策略的均衡性,我们找到了第10轮博弈的纳什均衡状态。该纳什均衡分配了A、B、C三种资源的最优分配。

性能指标:

总token数: 968

响应时间: 25.29秒

每秒token数: 38.28

六.数学与优化:高阶问题求解

测试案例

\"某城市规划中,需在10km×10km区域内布局3类设施:

- 居民区(每处占地1km²,服务半径1km,需至少3处)

- 工业区(每处占地2km²,需远离居民区≥2km)

- 生态保护区(面积≥5km²,需包含至少1条自然水系(≥1km长)

- 约束:工业区与生态区的距离≥3km

要求:建立整数规划模型并求解最优布局方案\"

AI返回结果

请求token数估算: 57

模型响应内容:

问题描述

某城市规划中,需在10km×10km区域内布局3类设施:

- 居民区(每处占地1km²,服务半径1km,需至少3处)

- 工业区(每处占地2km²,需远离居民区≥2km)

- 生态保护区(面积≥5km²,需包含至少1条自然水系(≥1km长))

约束条件:

- 工业区与生态区的距离≥3km

- 约束:工业区与居民区距离≥2km

- 约束:工业区与生态区之间至少有1条自然水系(即生态保护区与水系至少有一条直线连接)

目标: 建立整数规划模型并求解最优布局方案。

问题建模

1. 居民区

- 面积:1 km²

- 服务半径:1 km

- 需求:至少3处

目标函数: 最小化总占地面积(即最小化居民区所需的总空间)。

约束条件: - 居民区需要至少3处。

- 居民区占地面积为1 km²。

2. 工业区

- 面积:2 km²

- 需求:远离居民区≥2 km

- 约束条件:

- 工业区与居民区距离≥2 km

####3. 生态保护区

- 工业区与居民区距离≥2 km

- 面积:≥5 km²

- 需求:包含至少1条自然水系(≥1 km长)

- 约束条件:

- 生态保护区与水系至少有一条直线连接。

目标函数

居民区占地面积为1 km²,因此目标函数为:

Minimize Total Area = 1 km 2 \\text{Minimize} \\quad \\text{Total Area} = 1 \\text{ km}^2 MinimizeTotal Area=1 km2

约束条件

-

居民区:至少3处。

Number of Residential Points ≥ 3 \\text{Number of Residential Points} \\geq 3 Number of Residential Points≥3 -

工业区:远离居民区≥2 km。

Distance from Residential Point ≥ 2 km \\text{Distance from Residential Point} \\geq 2 \\text{ km} Distance from Residential Point≥2 km -

生态保护区:包含至少1条自然水系。

Number of Waterways ≥ 1 \\text{Number of Waterways} \\geq 1 Number of Waterways≥1

模型建立

变量定义

- 居民区点:可以任意位置,每个点有1 km²的占地面积。

- 工业区点:可以任意位置,每个点有2 km²的占地面积。

- 生态保护区点:可以任意位置,每个点有≥5 km²的占地面积。

####目标函数 - 最小化居民区点总占地面积:

min Total Area Residential = 1 km 2 \\min \\quad \\text{Total Area}_{\\text{Residential}} = 1 \\text{ km}^2minTotal AreaResidential=1 km2

约束条件

- 居民区:

Total Area Residential ≥ 3 \\text{Total Area}_{\\text{Residential}} \\geq 3Total AreaResidential≥3 - 工业区:

Distance Residential ≥ 2 km \\text{Distance}_{\\text{Residential}} \\geq 2 \\text{ km}DistanceResidential≥2 km - 生态保护区:

Total Area Waterways ≥ 1 \\text{Total Area}_{\\text{Waterways}} \\geq 1Total AreaWaterways≥1

求解策略

这是一个典型的整数规划问题,可以使用整数规划算法(如Python的PuLP库)来解决。以下是求解步骤:

1. 定义变量

- 居民区点:x₁, x₂, …, xₙ

- 工业区点:y₁, y₂, …, y_m

- 生态保护区点:z₁, z₂, …, z_k

2. 目标函数

最小化居民区点总占地面积:

min Total Area = ∑ i = 1 nx i \\min \\quad \\text{Total Area} = \\sum_{i=1}^{n} x_i minTotal Area=i=1∑nxi

3. 约束条件

- 居民区点数量 ≥ 3:

∑ i = 1 n x i ≥ 3 \\sum_{i=1}^{n} x_i \\geq 3i=1∑nxi≥3 - 工业区点数量 ≥ 2:

∑ i = 1 m y i ≥ 2 \\sum_{i=1}^{m} y_i \\geq 2i=1∑myi≥2 - 生态保护区点数量 ≥ 1:

∑ j = 1 k z j ≥ 1 \\sum_{j=1}^{k} z_j \\geq 1j=1∑kzj≥1

Python代码实现

from pulp import LpMinimize, LpIntoVar, LpVariable, PdMatrix# 定义变量residential_points = [LpVariable(f\'residential\', lowBound=0, cat=\'Integer\') for f in range(1, 4)]industrial_points = [LpVariable(f\'industrial\', lowBound=0, cat=\'Integer\') for f in range(1, 3)]waterways = [LpVariable(f\'waterways\', lowBound=0, cat=\'Integer\') for f in range(1, 4)]# 目标函数:最小化居民区点总占地面积def objective_function(x): total_area = sum(x) return total_area# 求解prob = pulp.LpProblem(\"Residential_and_Waterways_Planning\", pulp.LpMinimize)# 添加约束prob += LpIntoVar(f\'residential\', name=\'residential_points\').domain(LpMinimize)prob += LpIntoVar(f\'industrial\', name=\'industrial_points\').domain(LpMinimize)prob += LpIntoVar(f\'waterways\', name=\'waterways\').domain(LpMinimize)# 添加居民区点数量约束prob += sum(x_i >= 3 for x_i in residential_points)# 添加工业区点数量约束prob += sum(y_i >= 2 for y_i in industrial_points)# 添加生态保护区点数量约束prob += sum(z_j >= 1 for z_j in waterways)# 求解prob.solve()# 输出结果print(\"Optimal Residential Points:\")for i, x in enumerate(residential_points): print(f\"Point {i+1}: {x.var().name}\")print(\"\\nOptimal Waterways:\")for i, z in enumerate(waterways): print(f\"Point {i+1}: {z.var().name}\")print(\"\\nOptimal Total Area:\")for i, area in enumerate(residential_points): print(f\"Point {i+1}: {area.var().value}\")输出结果

运行上述代码后,将输出最优的居民区点布局:

Optimal Residential Points:Point 1: residential_points.0Point 2: residential_points.1Point 3: residential_points.2Optimal Waterways:Point 1: waterways.0Point 2: waterways.1Point 3: waterways.2Optimal Total Area:Point 1: 1.0Point 2: 1.0Point 3: 1.0验证

- 居民区:每个点至少3处,总面积为1 km²。

- 工业区:每个点至少2 km²,且与居民区距离≥2 km。

- 生态保护区:每个点至少5 km²,且与水系至少有一条直线连接。

###可能的优化方向

- 工业区布局:可以进一步优化工业区点的位置,使得它们远离居民区,同时满足距离约束。

- 生态保护区布局:可以优化生态保护区点的位置,确保它们与水系连接。

- 居民区与工业区距离:可以进一步调整居民区与工业区的距离,以减少总占地面积。

###总结

通过整数规划模型,可以系统地求解城市规划中不同设施的布局方案。目标函数最小化居民区占地面积,约束条件包括居民区数量、工业区数量和生态保护区数量的严格限制。Python代码提供了灵活的解决方案,可以方便地验证结果。

性能指标:

总token数: 1334

响应时间: 24.64秒

每秒token数: 54.14

七.中文与文化:极致复杂度挑战

测试案例

以’暗物质’为主题创作《楚辞·九歌》体,要求:

- 模仿《九歌》的祭祀仪式结构(迎神→娱神→送神)

- 融入暗物质相关观测证据(如星系旋转曲线、引力透镜等)

- 考据诗中’幽光’\'玄域’等意象与《九歌》‘神光’\'幽都’的互文关系

AI返回结果

请求token数估算: 40

模型响应内容:

《楚辞·九歌·九嵖岱》

——星河列宿,幽光迢递

迎神之日,神宓仪首,青鸾振羽迎云阙。

幽光迢递,星芒若流,逐月兮逐霜。

星霜浩渺,万象峥嵘,连天地兮转苍穹。

暗物质,幽光迢递,当空熹微,照骨魄兮明。

娱神坛上,烛火摇摇,映月明兮照灵台。

幽都之处,玄域生灵,似月华兮映鲛绡。

送神时,丹墀轻摇,羽觞清扬。

星辉洒落,幽冥隐现,暗影兮藏玄。

神魂归处,星河幻化,幽光连环,玄域幻散。

暗物质,隐匿于幽光,不染玄色,不迷幽光。

性能指标:

总token数: 112

响应时间: 3.15秒

每秒token数: 35.60

八.中文复杂语义理解测试

测试案例

文心 4.5 在中文歧义消解、隐喻理解上的优化需重点验证:

# 古诗词意境延伸(中文文化适配性)curl -X POST http://localhost:8180/v1/chat/completions \\ -H \"Content-Type: application/json\" \\ -d \'{ \"model\": \"ERNIE-4.5-0.3B-Paddle\", \"messages\": [{\"role\": \"user\", \"content\": \"用现代语言解释‘落霞与孤鹜齐飞,秋水共长天一色’,并仿写一句类似意境的句子\"}] }\'AI返回结果

现代语言解释

\"落霞与孤鹜齐飞,秋水共长天一色\"描绘出一幅开阔、宁静的秋日景象,落霞随着孤鹜一同飞翔,秋天的江水与天空的颜色相互映衬,呈现出一种空灵、高远的美感。 仿写一句类似意境的句子: “晨雾绕秧畴,暮霭铺径长”

仿写语句

晨雾绕秧畴,暮霭铺径长

解析

晨雾绕秧畴:

- 「晨雾」描绘出清晨的雾气弥漫,像一片轻柔的云霭环绕着秧田。

- 「绕」表示缠绕、萦绕,体现出雾气与秧田的融合之态。

暮霭铺径长:

- 「暮霭」即傍晚时分的霭气沉沉,如诗中描绘的那般铺满了路径。

- 「铺径」指铺开道路,寓意着天地间万物都在这广袤的天地间延展。

- 「长」强调了径路的绵延伸展,与前句中晨雾的轻柔、弥漫的意境相呼应。\"

九.塔罗算运

我们来试试赛博算命

测试案例

import requestsimport jsonimport timefrom statistics import meandef send_request(): \"\"\"发送单次请求并返回响应时间和结果\"\"\" # 设置API端点 url = \"http://127.0.0.1:8180/v1/chat/completions\" # 设置请求头 headers = { \"Content-Type\": \"application/json\" } # 构建请求体 - 塔罗牌占卜问题 data = { \"model\": \"baidu/ERNIE-4.5-0.3B-PT\", \"messages\": [ { \"role\": \"user\", \"content\": \"\"\"我希望进行一次塔罗牌占卜,请根据以下信息为我解读:【占卜者信息】性别:女年龄:28问题领域:事业当前状况:目前在一家互联网公司担任产品经理,工作压力较大,但有晋升机会。最近团队内部竞争激烈,我不确定是否应该争取晋升,还是保持现状。【塔罗牌牌阵】采用塔罗牌经典的圣三角牌阵,牌面信息如下:1. 过去(代表过去的状况或影响):正位的圣杯32. 现在(代表当前的状况或面临的问题):逆位的宝剑53. 未来(代表未来的发展趋势或可能的结果):正位的恋人【具体问题】1. 这三张牌组合起来对我的事业发展有什么启示?2. 针对当前的工作压力和团队竞争,我应该如何应对?3. 争取晋升是否是一个明智的选择?4. 未来6个月内,我的事业发展可能会有哪些变化?请根据塔罗牌的象征意义和我的具体情况进行解读,提供详细、实用的建议。\"\"\" } ] } try: # 记录开始时间 start_time = time.time() # 发送请求 response = requests.post(url, headers=headers, data=json.dumps(data)) # 检查响应状态 response.raise_for_status() # 解析响应 result = response.json() # 计算响应时间(秒) response_time = time.time() - start_time # 获取token数量 completion_tokens = result.get(\'usage\', {}).get(\'completion_tokens\', 0) prompt_tokens = result.get(\'usage\', {}).get(\'prompt_tokens\', 0) total_tokens = result.get(\'usage\', {}).get(\'total_tokens\', 0) # 计算每秒token数量 tokens_per_second = total_tokens / response_time if response_time > 0 else 0 return { \"success\": True, \"response_time\": response_time, \"status_code\": response.status_code, \"result\": result, \"completion_tokens\": completion_tokens, \"prompt_tokens\": prompt_tokens, \"total_tokens\": total_tokens, \"tokens_per_second\": tokens_per_second } except requests.exceptions.RequestException as e: print(f\"请求错误: {e}\") return {\"success\": False, \"error\": str(e)} except json.JSONDecodeError as e: print(f\"JSON解析错误: {e}\") return {\"success\": False, \"error\": f\"JSON解析错误: {str(e)}\"} except Exception as e: print(f\"发生错误: {e}\") return {\"success\": False, \"error\": str(e)}def main(): # 请求次数 request_count = 1 # 存储统计数据 response_times = [] tokens_per_second_list = [] completion_tokens_list = [] prompt_tokens_list = [] total_tokens_list = [] # 存储成功请求数 success_count = 0 print(f\"开始执行 {request_count} 次塔罗牌占卜请求...\\n\") # 执行多次请求 for i in range(request_count): print(f\"请求 {i+1}/{request_count} 执行中...\") # 发送请求 result = send_request() if result[\"success\"]: success_count += 1 response_times.append(result[\"response_time\"]) tokens_per_second_list.append(result[\"tokens_per_second\"]) completion_tokens_list.append(result[\"completion_tokens\"]) prompt_tokens_list.append(result[\"prompt_tokens\"]) total_tokens_list.append(result[\"total_tokens\"]) print(f\"请求 {i+1} 成功:\") print(f\"响应时间: {result[\'response_time\']:.3f} 秒\") print(f\"完成tokens: {result[\'completion_tokens\']}\") print(f\"提示tokens: {result[\'prompt_tokens\']}\") print(f\"总tokens: {result[\'total_tokens\']}\") print(f\"每秒tokens: {result[\'tokens_per_second\']:.2f}\") # 只打印第一次请求的详细结果 if i == 0: print(\"\\n第一次请求详细信息:\") print(\"状态码:\", result[\"status_code\"]) print(\"响应内容:\") print(json.dumps(result[\"result\"], indent=2, ensure_ascii=False)) # 提取并打印AI的回复内容 if \"choices\" in result[\"result\"] and len(result[\"result\"][\"choices\"]) > 0: ai_message = result[\"result\"][\"choices\"][0][\"message\"][\"content\"] print(\"\\nAI塔罗牌占卜回复:\") print(ai_message) else: print(f\"请求 {i+1} 失败: {result.get(\'error\', \'未知错误\')}\") print(\"-\" * 50) # 如果不是最后一次请求,添加短暂延迟以避免请求过于频繁 if i < request_count - 1: time.sleep(0.5) # 计算统计信息 if response_times: avg_response_time = mean(response_times) min_response_time = min(response_times) max_response_time = max(response_times) avg_tokens_per_second = mean(tokens_per_second_list) avg_completion_tokens = mean(completion_tokens_list) avg_prompt_tokens = mean(prompt_tokens_list) avg_total_tokens = mean(total_tokens_list) print(\"\\n请求统计信息:\") print(f\"总请求数: {request_count}\") print(f\"成功请求数: {success_count}\") print(f\"失败请求数: {request_count - success_count}\") print(\"\\n时间统计:\") print(f\"平均响应时间: {avg_response_time:.3f} 秒\") print(f\"最小响应时间: {min_response_time:.3f} 秒\") print(f\"最大响应时间: {max_response_time:.3f} 秒\") print(\"\\nToken统计:\") print(f\"平均完成tokens: {avg_completion_tokens:.1f}\") print(f\"平均提示tokens: {avg_prompt_tokens:.1f}\") print(f\"平均总tokens: {avg_total_tokens:.1f}\") print(f\"平均每秒tokens: {avg_tokens_per_second:.2f}\") else: print(\"\\n所有请求均失败,无法计算统计信息。\")if __name__ == \"__main__\": main()AI返回结果

开始执行 1 次塔罗牌占卜请求…

请求 1/1 执行中…

请求 1 成功:

响应时间: 13.316 秒

完成tokens: 1029

提示tokens: 247

总tokens: 1276

每秒tokens: 95.83

第一次请求详细信息:

状态码: 200

响应内容:

{

“id”: “chatcmpl-7f483e5a-30e3-459c-aedd-86b3622caf59”,

“object”: “chat.completion”,

“created”: 1751902426,

“model”: “baidu/ERNIE-4.5-0.3B-PT”,

“choices”: [

{

“index”: 0,

“message”: {

“role”: “assistant”,

“content”: “### 塔罗牌解读:\\n\\n#### 1. 三张牌组合对我事业发展的启示 \\n- 圣杯3(正位):象征过去的阻碍与机遇。代表在事业初期可能遭遇过挫折、挑战或阻碍,需要调整策略、突破自我,才能为未来铺路。 \\n- 宝剑5(逆位):象征当前的不确定性与迷茫。代表当前的工作压力、团队竞争可能让你感到焦虑、迷茫,需要冷静思考、明确方向,但同时需保持谦逊,避免过度自我怀疑。 \\n- 恋人(正位):象征未来的可能性与平衡。暗示事业发展可能因当前困境而暂时停滞,但通过与他人的合作、调整方向,未来仍可能迎来转机,甚至创造新的突破点。 \\n\\n启示: \\n- 过去的挫折是成功的基础,需通过行动重建信心。 \\n- 当前压力可能让你感到焦虑,但通过冷静分析,可找到平衡点,避免陷入重复的困境。 \\n- 未来的可能性取决于你是否能与他人合作、调整策略,而非完全放弃当前目标。\\n\\n#### 2. 当前的工作压力与团队竞争应对策略 \\n- 工作压力: \\n - 宝剑5(迷茫)暗示你对现状感到无力,需要找到平衡点。 \\n - 圣杯3(阻碍)可能让你感到压力,需保持冷静,通过数据化分析(如KPI、团队绩效)明确目标,而非抱怨现状。 \\n- 团队竞争: \\n - 宝剑5(迷茫)可能让你对团队产生抵触情绪,需保持谦逊,通过自我表达(如定期汇报进展、建立信任)减少冲突。 \\n - 圣杯3(阻碍)可能让你感到孤立无援,需主动与团队成员沟通,寻求支持,而非封闭自己。 \\n\\n应对策略: \\n- 平衡压力与动力:通过数据化分析,明确当前压力点,同时通过团队合作提升动力。 \\n- 保持谦逊与开放:用数据说话,而非指责他人,同时主动寻求支持。 \\n- 建立信任关系:通过定期沟通、共享经验,减少团队竞争带来的隔阂。\\n\\n#### 3. 争取晋升是否明智? \\n- 圣杯3(正位):象征明确的目标与勇气。代表你有清晰的职业规划,敢于挑战自我,具备挑战能力,未来有机会晋升。 \\n- 宝剑5(逆位):象征迷茫与犹豫。可能让你犹豫是否晋升,需要冷静思考,而非盲目乐观。 \\n- 恋人(正位):象征平衡与可能性。暗示你有可能通过晋升实现突破,但需结合自身能力,而非盲目依赖他人。 \\n\\n明智性判断: \\n- 晋升是可取的,但需结合自身能力、行业趋势及团队潜力。 \\n- 需提前规划晋升路径,避免因犹豫导致职业发展受阻。 \\n\\n#### 4. 未来6个月事业发展的变化 \\n- 圣杯3(正位):象征事业的稳定与可持续性。代表你现有的工作状态是基础,未来需通过持续努力,实现可持续增长。 \\n- 宝剑5(逆位):象征不确定性与挑战。可能让你感到压力,需保持冷静,通过持续学习、团队协作、寻求外部支持,减少不确定性。 \\n- 恋人(正位):象征未来的可能性与转折。暗示事业发展可能因当前困境而暂时停滞,但通过调整方向,未来可能迎来转机。 \\n\\n变化趋势: \\n- 稳定增长:需持续努力,避免因压力而放弃。 \\n- 动态调整:通过持续学习、团队协作,逐步突破瓶颈。 \\n- 转折点:若团队竞争激烈,需主动调整策略,找到平衡点。 \\n\\n### 综合建议 \\n1. 保持专业能力:无论晋升与否,均需通过数据化分析,提升专业能力。 \\n2. 建立支持系统:与团队成员、导师保持沟通,寻求外部支持。 \\n3. 设定长期目标:将晋升视为提升职业竞争力的机会,而非短期冲动的结果。 \\n4. 灵活调整策略:若当前压力较大,可尝试阶段性调整,而非一蹴而就。 \\n\\n最终结论: \\n- 积极争取晋升,但需结合自身能力与行业趋势,通过持续努力实现可持续增长。 \\n- 保持平衡与开放,既不过度自我怀疑,也不过于消极逃避。”,

“reasoning_content”: null,

“tool_calls”: null

},

“finish_reason”: “stop”

}

],

“usage”: {

“prompt_tokens”: 247,

“total_tokens”: 1276,

“completion_tokens”: 1029,

“prompt_tokens_details”: {

“cached_tokens”: 0

}

}

}

AI塔罗牌占卜回复:

塔罗牌解读:

1. 三张牌组合对我事业发展的启示

- 圣杯3(正位):象征过去的阻碍与机遇。代表在事业初期可能遭遇过挫折、挑战或阻碍,需要调整策略、突破自我,才能为未来铺路。

- 宝剑5(逆位):象征当前的不确定性与迷茫。代表当前的工作压力、团队竞争可能让你感到焦虑、迷茫,需要冷静思考、明确方向,但同时需保持谦逊,避免过度自我怀疑。

- 恋人(正位):象征未来的可能性与平衡。暗示事业发展可能因当前困境而暂时停滞,但通过与他人的合作、调整方向,未来仍可能迎来转机,甚至创造新的突破点。

启示:

- 过去的挫折是成功的基础,需通过行动重建信心。

- 当前压力可能让你感到焦虑,但通过冷静分析,可找到平衡点,避免陷入重复的困境。

- 未来的可能性取决于你是否能与他人合作、调整策略,而非完全放弃当前目标。

2. 当前的工作压力与团队竞争应对策略

- 工作压力:

- 宝剑5(迷茫)暗示你对现状感到无力,需要找到平衡点。

- 圣杯3(阻碍)可能让你感到压力,需保持冷静,通过数据化分析(如KPI、团队绩效)明确目标,而非抱怨现状。

- 团队竞争:

- 宝剑5(迷茫)可能让你对团队产生抵触情绪,需保持谦逊,通过自我表达(如定期汇报进展、建立信任)减少冲突。

- 圣杯3(阻碍)可能让你感到孤立无援,需主动与团队成员沟通,寻求支持,而非封闭自己。

应对策略:

- 平衡压力与动力:通过数据化分析,明确当前压力点,同时通过团队合作提升动力。

- 保持谦逊与开放:用数据说话,而非指责他人,同时主动寻求支持。

- 建立信任关系:通过定期沟通、共享经验,减少团队竞争带来的隔阂。

3. 争取晋升是否明智?

- 圣杯3(正位):象征明确的目标与勇气。代表你有清晰的职业规划,敢于挑战自我,具备挑战能力,未来有机会晋升。

- 宝剑5(逆位):象征迷茫与犹豫。可能让你犹豫是否晋升,需要冷静思考,而非盲目乐观。

- 恋人(正位):象征平衡与可能性。暗示你有可能通过晋升实现突破,但需结合自身能力,而非盲目依赖他人。

明智性判断:

- 晋升是可取的,但需结合自身能力、行业趋势及团队潜力。

- 需提前规划晋升路径,避免因犹豫导致职业发展受阻。

4. 未来6个月事业发展的变化

- 圣杯3(正位):象征事业的稳定与可持续性。代表你现有的工作状态是基础,未来需通过持续努力,实现可持续增长。

- 宝剑5(逆位):象征不确定性与挑战。可能让你感到压力,需保持冷静,通过持续学习、团队协作、寻求外部支持,减少不确定性。

- 恋人(正位):象征未来的可能性与转折。暗示事业发展可能因当前困境而暂时停滞,但通过调整方向,未来可能迎来转机。

变化趋势:

- 稳定增长:需持续努力,避免因压力而放弃。

- 动态调整:通过持续学习、团队协作,逐步突破瓶颈。

- 转折点:若团队竞争激烈,需主动调整策略,找到平衡点。

综合建议

- 保持专业能力:无论晋升与否,均需通过数据化分析,提升专业能力。

- 建立支持系统:与团队成员、导师保持沟通,寻求外部支持。

- 设定长期目标:将晋升视为提升职业竞争力的机会,而非短期冲动的结果。

- 灵活调整策略:若当前压力较大,可尝试阶段性调整,而非一蹴而就。

最终结论:

- 积极争取晋升,但需结合自身能力与行业趋势,通过持续努力实现可持续增长。

- 保持平衡与开放,既不过度自我怀疑,也不过于消极逃避。

请求统计信息:

总请求数: 1

成功请求数: 1

失败请求数: 0

时间统计:

平均响应时间: 13.316 秒

最小响应时间: 13.316 秒

最大响应时间: 13.316 秒

Token统计:

平均完成tokens: 1029.0

平均提示tokens: 247.0

平均总tokens: 1276.0

平均每秒tokens: 95.83

十.数据对比表格(性能指标)

注:第九章“中文复杂语义理解测试”中未明确性能指标(总token数、响应时间等),故表格中以“-”表示。

十一.性能优化:企业级部署实战

11.1 知识缓存优化效果量化

通过多场景测试,知识缓存对性能的提升如下表:

11.2 量化调优对比

十二.安全加固:生产环境必做配置

12.1 访问控制

# 仅允许内网访问--host 192.168.1.0/24# 启用API密钥认证--api-keys YOUR_SECRET_KEY12.2 Nginx反向代理配置

server { listen 443 ssl; server_name ernie.example.com; ssl_certificate /etc/ssl/certs/ernie.crt; ssl_certificate_key /etc/ssl/private/ernie.key; location / { proxy_pass http://localhost:8180; proxy_set_header Host $host; proxy_set_header X-Real-IP $remote_addr; # 限制请求速率 limit_req zone=ernie_limit burst=20; } # 每秒最多10个请求 limit_req_zone $binary_remote_addr zone=ernie_limit:10m rate=10r/s;}十三.常见故障排查手册

13.1 典型错误解决方案

ModuleNotFoundError: No module named \'paddle\'python3.12 -m pip install paddlepaddle-gpu==3.1.0 -i https://www.paddlepaddle.org.cn/packages/stable/cu126/2. 验证安装:

python3.12 -c \"import paddle; print(paddle.__version__)\"from distutils.util import strtobool 错误curl https://bootstrap.pypa.io/get-pip.py -o get-pip.py && python3.12 get-pip.py --force-reinstall2. 升级setuptools:

python3.12 -m pip install --upgrade setuptoolspython setup.py egg_info did not run successfully 及 ModuleNotFoundError: No module named \'distutils\'python3.12 -m pip install setuptools==68.0.02. 若仍失败,改用wheel包安装:

下载对应版本wheel(如fastdeploy-1.0.0-cp312-cp312-linux_x86_64.whl),执行

python3.12 -m pip install 文件名.whlModuleNotFoundError: No module named \'six.moves\'apt remove -y python3-urllib32. 重新安装适配的urllib3和six:

python3.12 -m pip install urllib3==1.26.15 six --upgradeConnectionRefusedError: [Errno 111]--port 8280参数指定空闲端口,例如:python3.12 -m fastdeploy.entrypoints.openai.api_server --port 8280OutOfMemoryError: CUDA out of memory--max-num-seqs参数限制并发请求数量2. 使用量化模型减少显存占用(如INT8量化)

ModuleNotFoundError: No module named \'paddle\'python3.12 -m pip install paddlepaddle-gpu -i https://www.paddlepaddle.org.cn/packages/stable/cu126/13.2 性能监控命令

# 实时显存监控watch -n 1 nvidia-smi# API服务性能分析python3.12 -m fastdeploy.tools.monitor --port 8180结语:轻量化部署的范式革新

ERNIE-4.5-0.3B的核心价值在于通过“精度-效率-成本”的三角平衡,重新定义了中小企业大模型部署的可行性边界。从量化数据看,其在中文场景92%的精度保留率与1/10的成本优势,使其成为垂直领域的最优解之一。

未来演进将聚焦三个方向:

- 场景自适应推理:通过动态调整

--ernie-light-mode-threshold参数,使简单任务处理速度再提升30%。 - 边缘端适配:结合INT2量化技术,目标将模型压缩至1GB以内,适配嵌入式设备。

- 行业知识库融合:针对医疗、法律等地方,开发专用知识缓存模块,进一步降低领域问答时延。

延伸资源

完整性能测试报告:ERNIE-4.5-0.3B Benchmark

行业部署案例库:ERNIE-4.5 垂直领域实践