【颠覆认知!文心开源大模型全解析:从部署到实战,小白也能玩转AI】

](https://i-blog.csdnimg.cn/blog_migrate/576340a359de17e3fcd2b936316c88cf.png#pic_center)

🌈个人主页: Aileen_0v0

🔥热门专栏: 华为鸿蒙系统学习|计算机网络|数据结构与算法

💫个人格言:“没有罗马,那就自己创造罗马~”

文章目录

- 文心开源大模型介绍:技术引领与生态赋能

-

- 文心开源大模型的背景:

- 文心开源大模型的意义:

- 当前文心开源的大模型:

- 部署的方式:

-

- 方式 1:购买云服务器进行部署

-

- 深度学习框架部署:**安装PaddlePaddle-GPU深度调优版本**:

- FastDeploy-GPU企业级部署框架

-

- 1.安装FastDeploy核心组件

- 2.uelib3 & six 的冲突修复

- 启动兼容API服务

- 方式 2:使用百度官方的[飞桨工作台](https://aistudio.baidu.com/datasetoverview?task=6)进行部署

-

- ① 选择推理框架:

- ② 模型选择:

- ③ 点击一键部署,即可部署我们的大模型

- ④ 点击详情,我们可以查看具体的部署信息:

- 模型调用&使用 tips:

-

- 部署成功以后,就可以点击使用了:

- 将生成的调用代码复制到工作台运行即可完成调用:

- 日志查看:

- 测评思路:

-

- 测试方向:

- 参数解释:

- 📌单模型测评:

-

- 📍基于模型ERNIE-4.5-0.3B-PT 测试:

-

- 🏷️代码能力&文字表达能力测试:

- 📍基于 ERNIE-4.5-VL-28B-A3B-Paddle 模型的测试

-

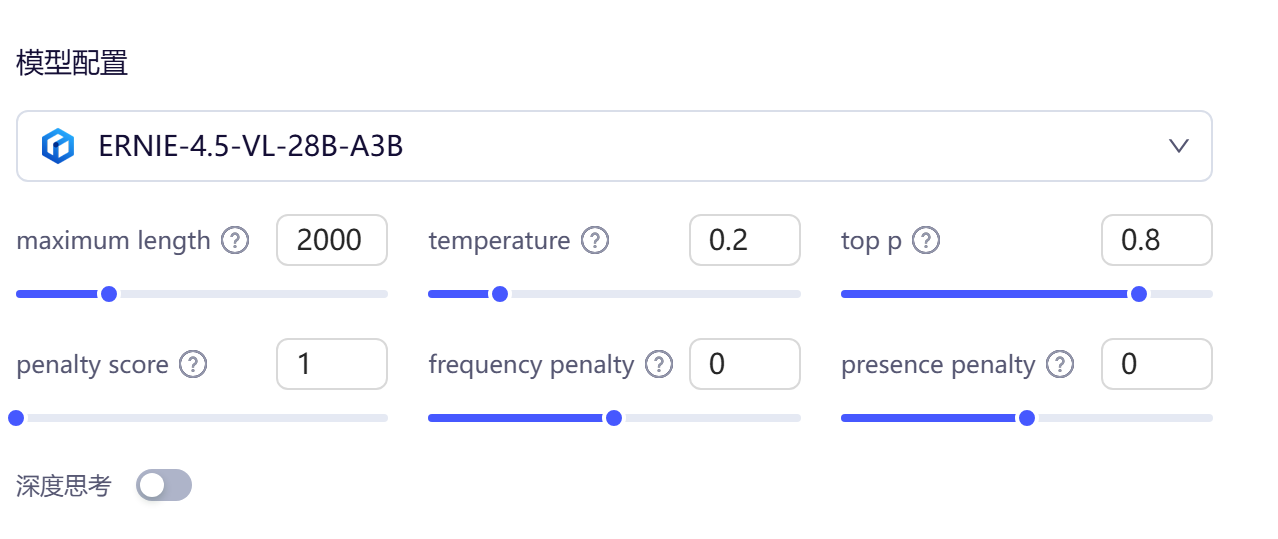

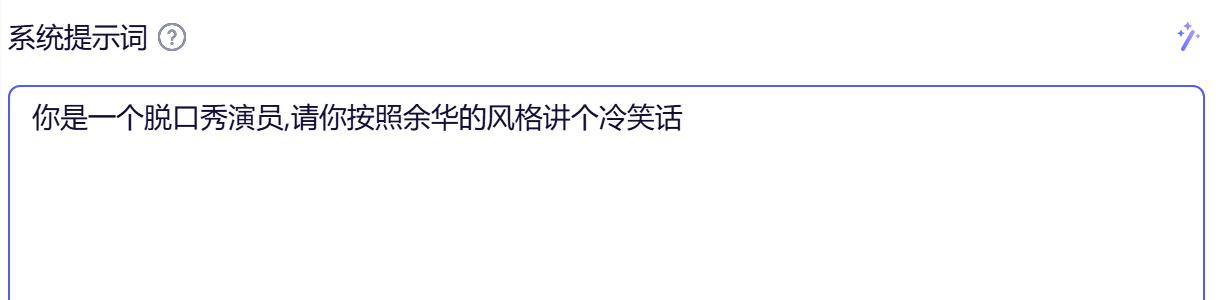

- 🏷️指定提示词文本测试

- 🏷️图片识别准确度测试

-

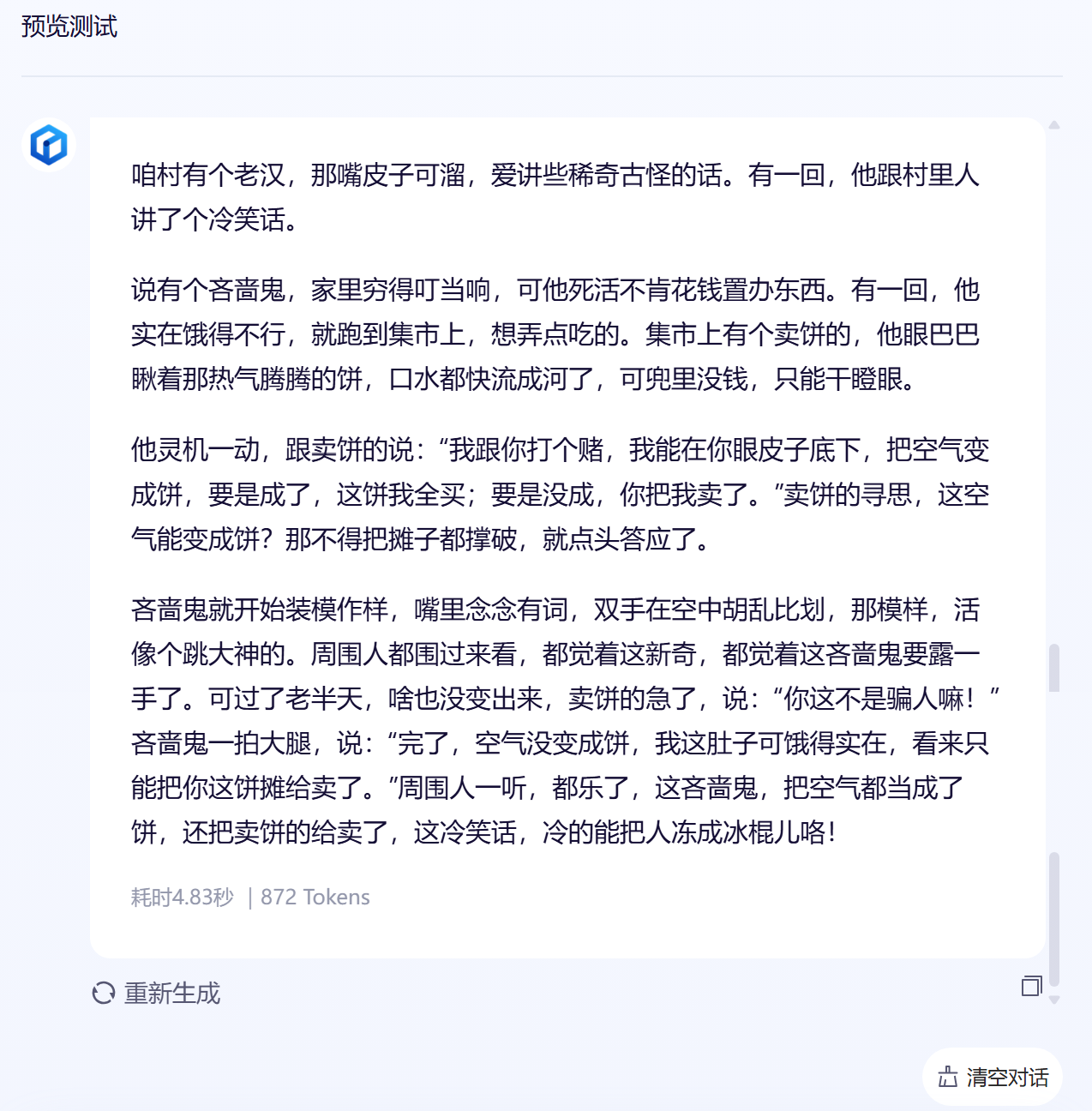

- 📷️含文字的图片读取:

- 📷️无字图片的读取:

- 📷️图中物体识别及计数测试:

- 📌多模型对比测评:

-

- 📍相同模型不同型号之间的对比

-

- 🏷️文字表述能力:

- 🏷️算法的解释和编写能力:

- 🏷️古诗文鉴赏能力:

- 📍不同模型相同参数之间的对比:

-

- 🏷️文心28B VS DeepSeek-V3

-

- **🍭文字表达能力上的对比分析**:

- 🏷️文心 28B **VS** Qwen32B :

-

- 🍭图片识别上的对比:

- 🏷️文心 28B **VS** LIama-2-Maverick 模型:

-

- 🍭逻辑推理计算能力:

- 总结:

文心开源大模型介绍:技术引领与生态赋能

文心开源大模型的背景:

百度文心开源大模型体验地址

文心开源大模型的意义:

当前文心开源的大模型:

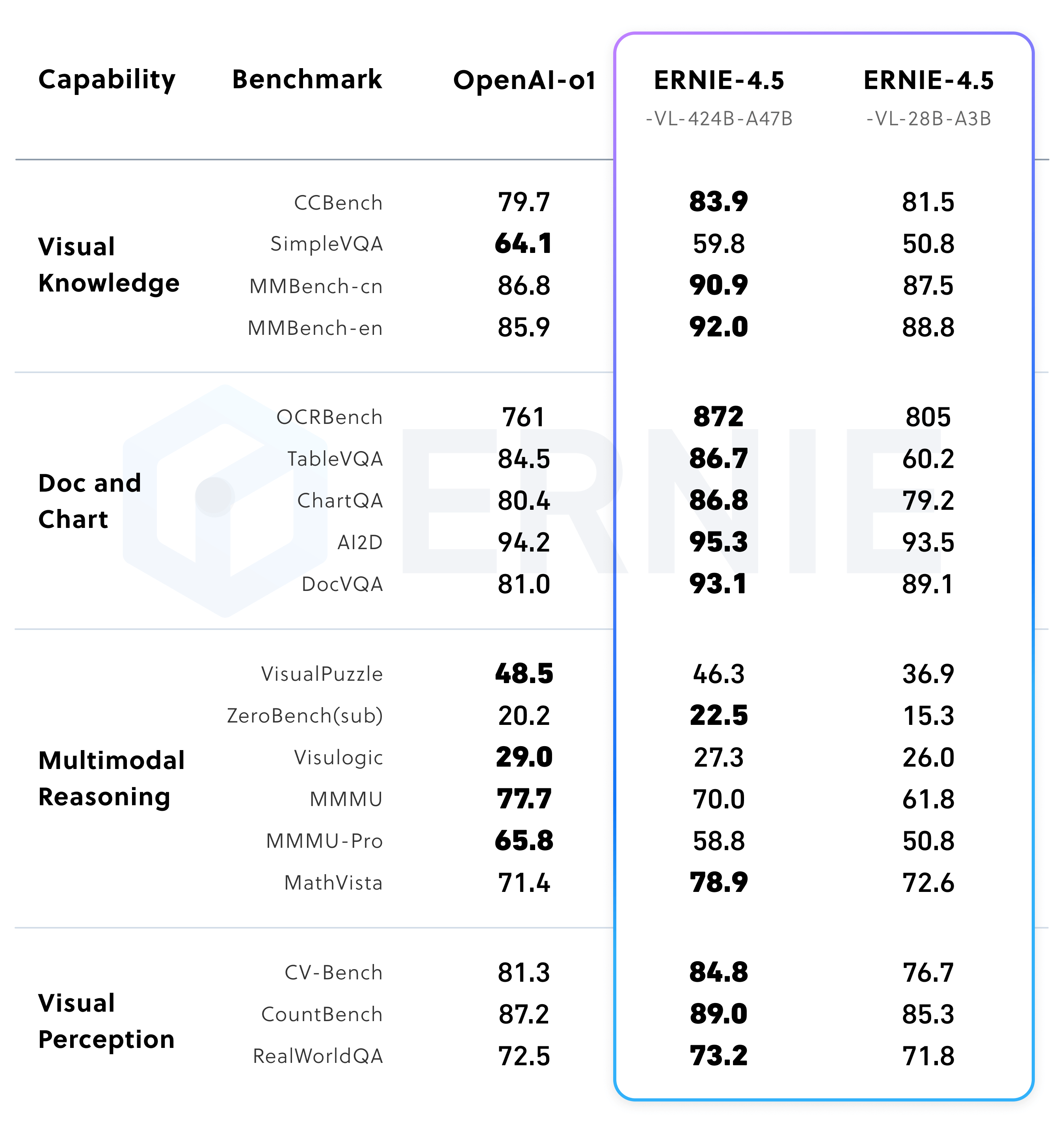

- 参考百度大模型相关的资料,我们可以看到文心一言大模型在经过多模态训练之后在多个基准测试中表现出色,尤其是在视觉知识、文档和图表处理、多模态推理以及视觉感知方面。

- ERNIE-4.5在 多个领域都展现出了强大的性能,尤其是在视觉知识、文档和图表处理以及视觉感知方面,表现尤为突出。

部署的方式:

方式 1:购买云服务器进行部署

- 购买云服务器: 选择合适的云服务器作为模型部署的硬件基础,云服务器具有弹性可伸缩、高可用性和按需付费等优势,能够满足模型部署对计算资源的需求,同时可根据实际业务负载灵活调整资源配置,降低硬件成本。

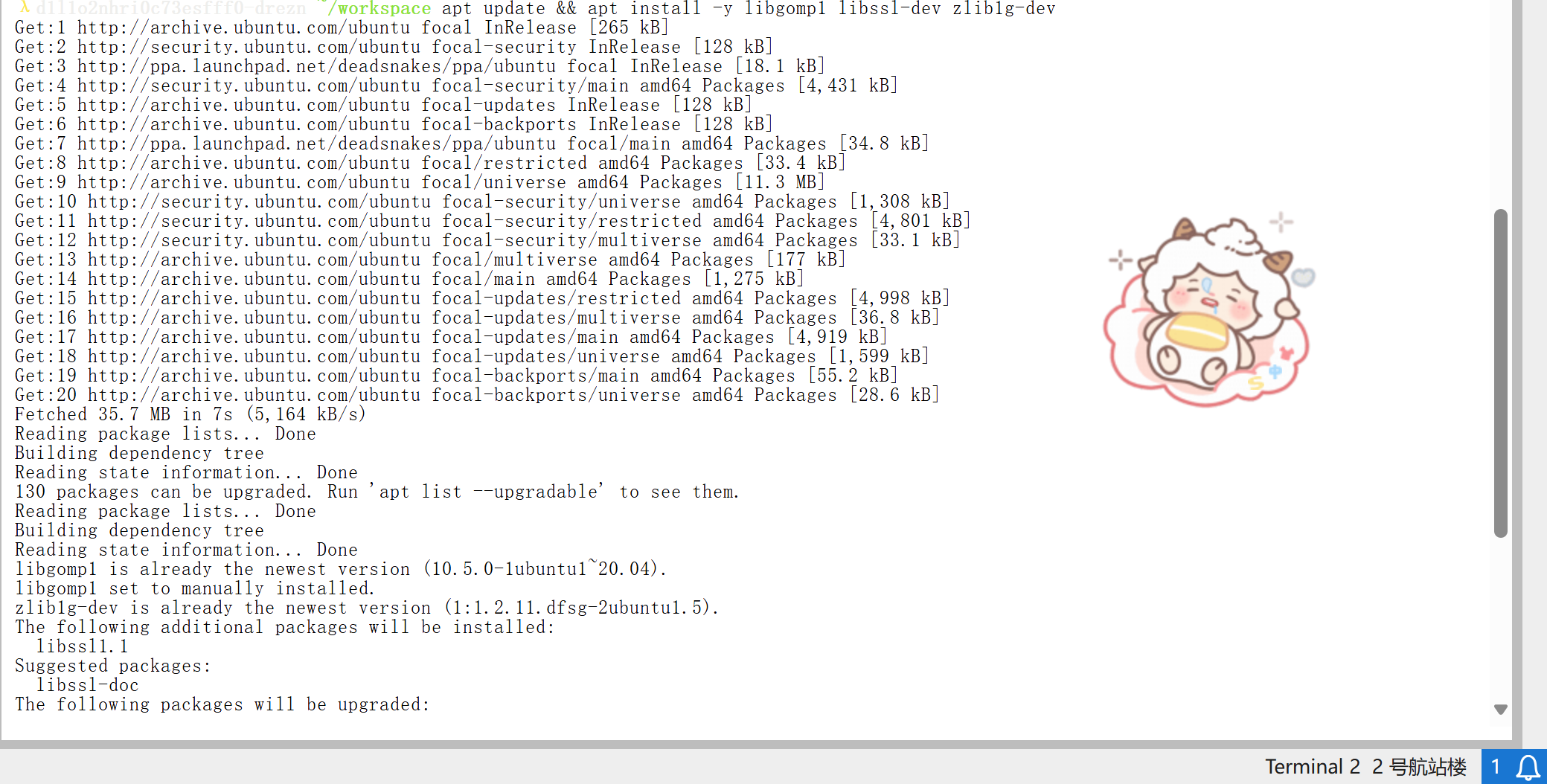

- 系统依赖安装:

apt update && apt install -y libgomp1 libssl-dev zlib1g-dev○apt update 用于更新系统包列表,确保后续安装的软件包版本是最新的。

○libgomp1 是GCC编译器的OpenMP支持库,OpenMP是一种并行编程模型,用于多线程程序的开发,安装该库可以为后续可能涉及并行计算的程序提供支持。

○libssl-dev 是OpenSSL的开发库,OpenSSL是一个开源的SSL/TLS协议库,用于加密网络通信,安装该库可以为需要加密通信的功能提供支持,例如在模型部署过程中可能涉及的安全通信场景。

○ zlib1g-dev 是zlib压缩库的开发版本,zlib是一个通用的压缩库,广泛应用于数据压缩和解压缩操作,安装该库可以为程序中可能涉及的压缩和解压缩功能提供支持,例如在模型数据传输或存储过程中对数据进行压缩以节省空间。

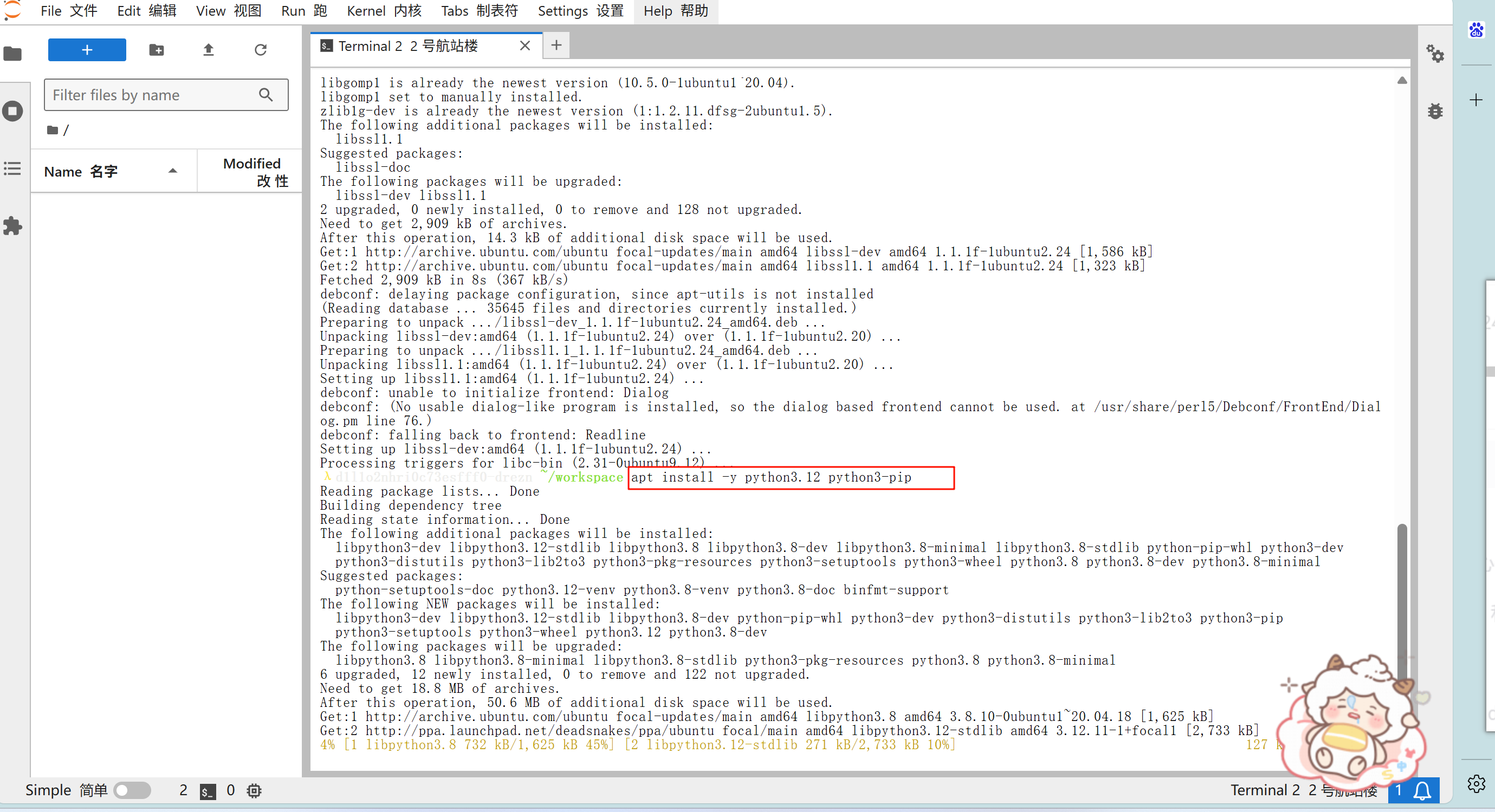

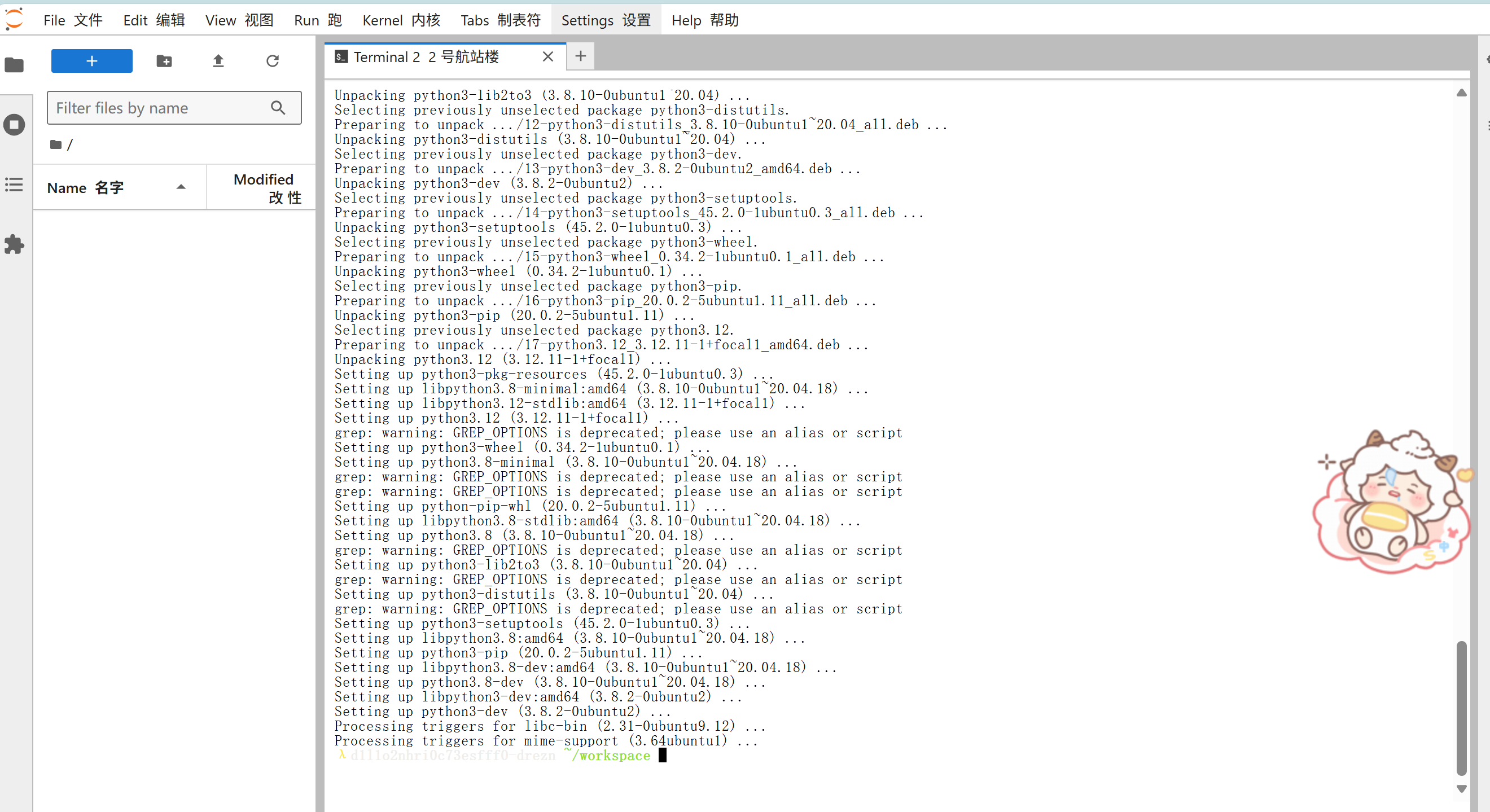

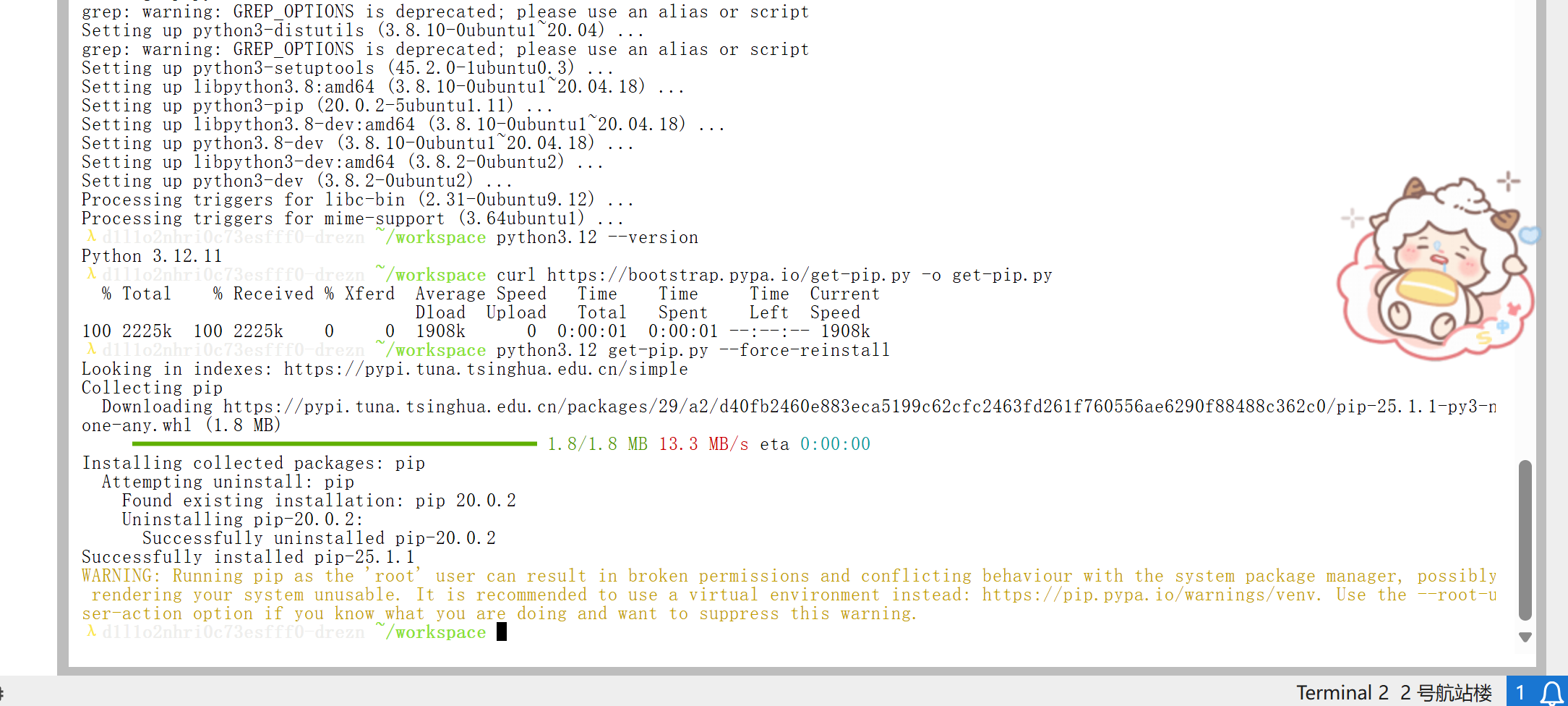

- 安装 python3.12 和配套 pip

apt install -y python3.12 python3-pip- 安装Python 3.12是为了提供一个稳定且较新的Python运行环境,以满足模型部署过程中可能依赖的Python特性。同时安装

python3-pip,pip是Python的包管理工具,用于安装和管理Python包,安装配套的pip是为了方便后续安装其他Python依赖包。

- 验证是否安装成功 python:

- 确保后续操作能够在正确的Python环境中进行。

python3.12 --version

- 解决 pin 问题:

curl https://bootstrap.pypa.io/get-pip.py -o get-pip.pypython3.12 get-pip.py --force-reinstall○ curl命令用于从指定的URL下载get-pip.py脚本,该脚本是用于安装或升级pip的工具。 ○ python3.12 get-pip.py --force-reinstall命令通过运行get-pip.py脚本强制重新安装pip,确保pip版本是最新的,避免因pip版本过低导致后续安装Python包时出现兼容性问题或其他错误。

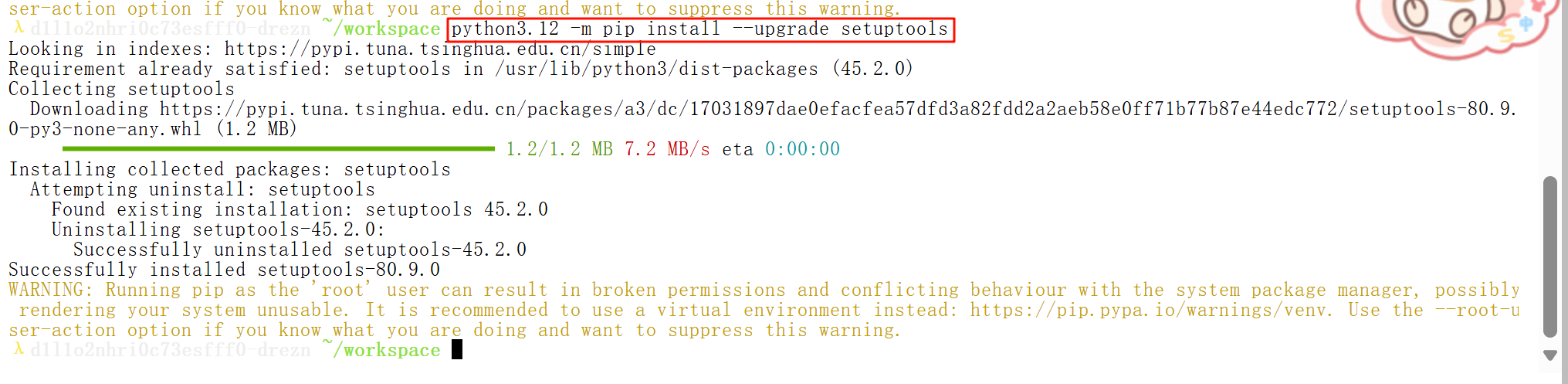

- 升级 setuptools:

setuptools是Python的一个构建和分发工具,用于构建和安装Python包。升级setuptools可以确保其功能的完整性和稳定性,避免在后续安装或构建Python包时因setuptools版本过低而出现问题,例如某些依赖包可能需要较新的setuptools功能来正确安装。

python3.12 -m pip install --upgrade setuptools

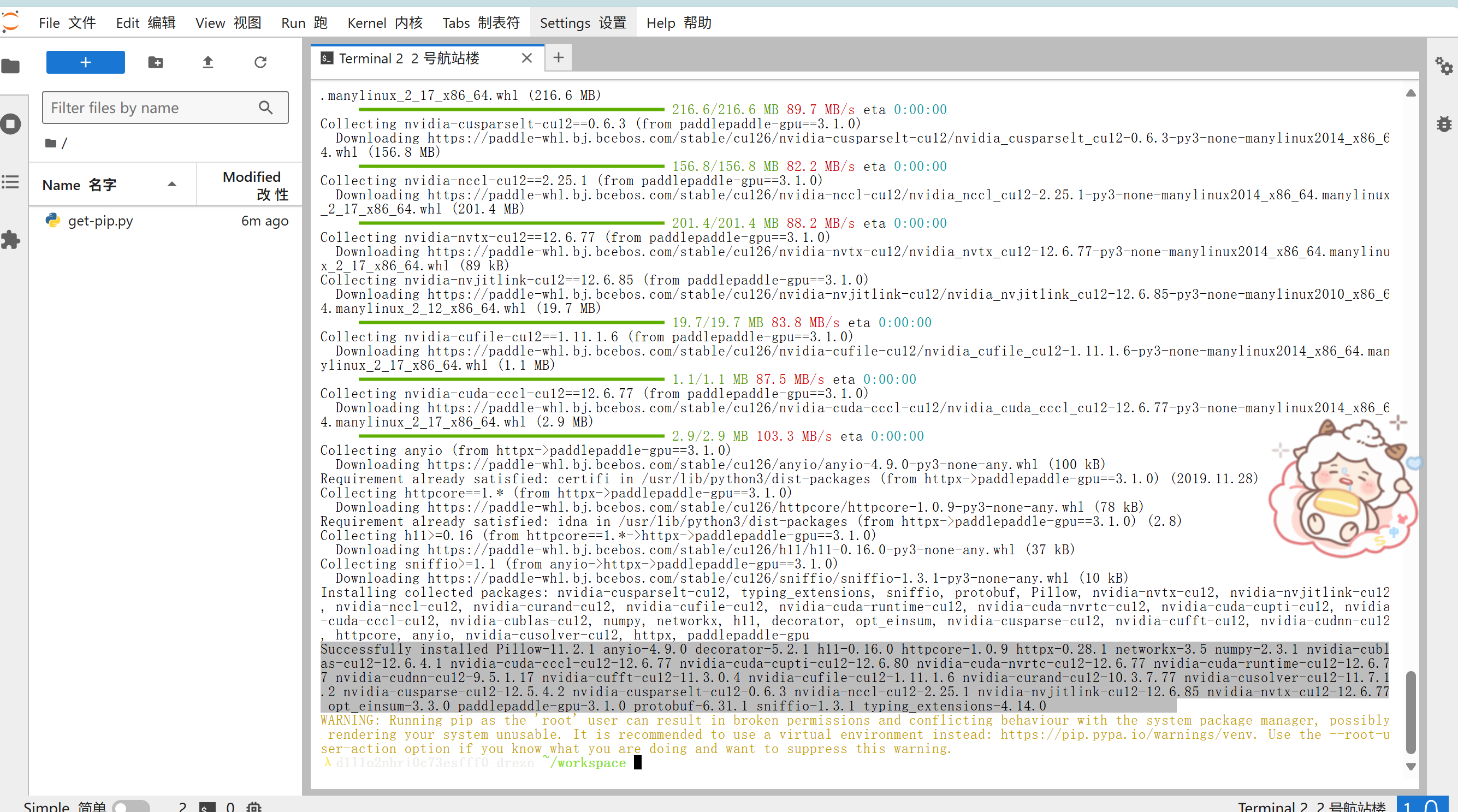

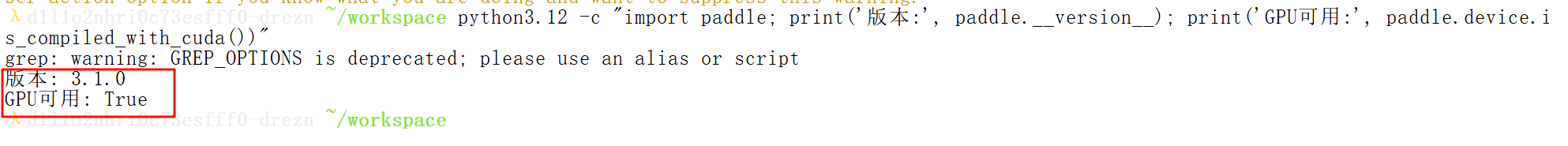

深度学习框架部署:安装PaddlePaddle-GPU深度调优版本:

python3.12 -m pip install paddlepaddle-gpu==3.1.0 \\-i https://www.paddlepaddle.org.cn/packages/stable/cu126/

FastDeploy-GPU企业级部署框架

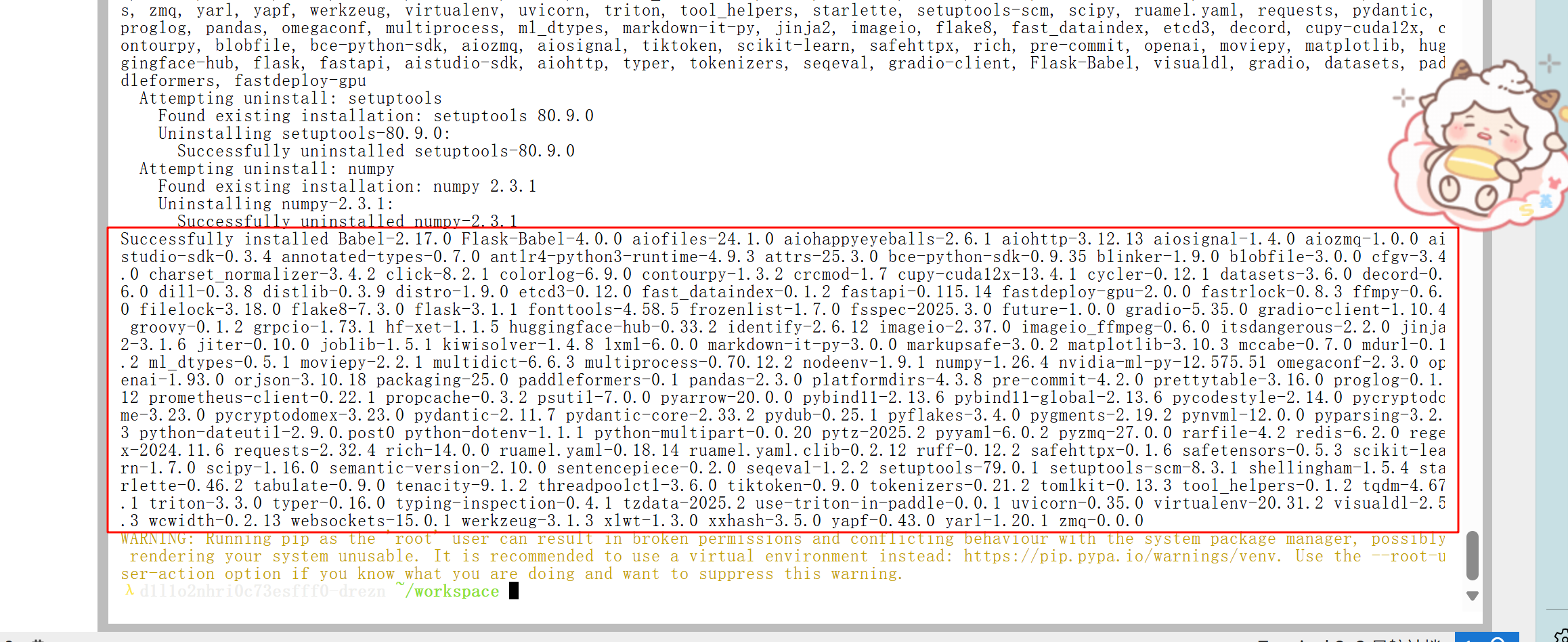

1.安装FastDeploy核心组件

python3.12 -m pip install fastdeploy-gpu -i https://www.paddlepaddle.org.cn/packages/stable/fastdeploy-gpu-80_90/ --extra-index-url https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple

2.uelib3 & six 的冲突修复

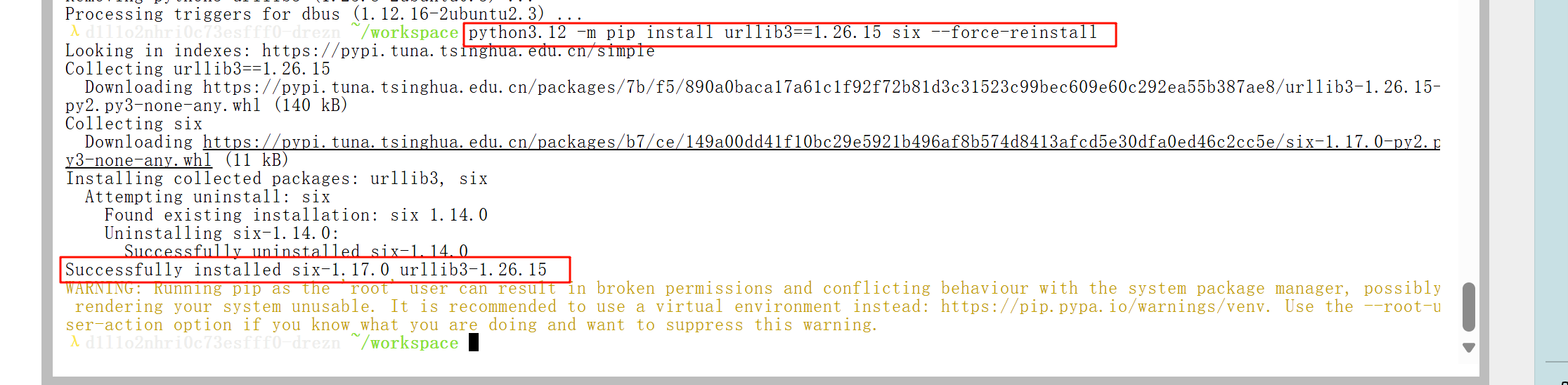

apt remove -y python3-urllib3python3.12 -m pip install urllib3==1.26.15 six --force-reinstallpython3.10 -m pip install urllib3

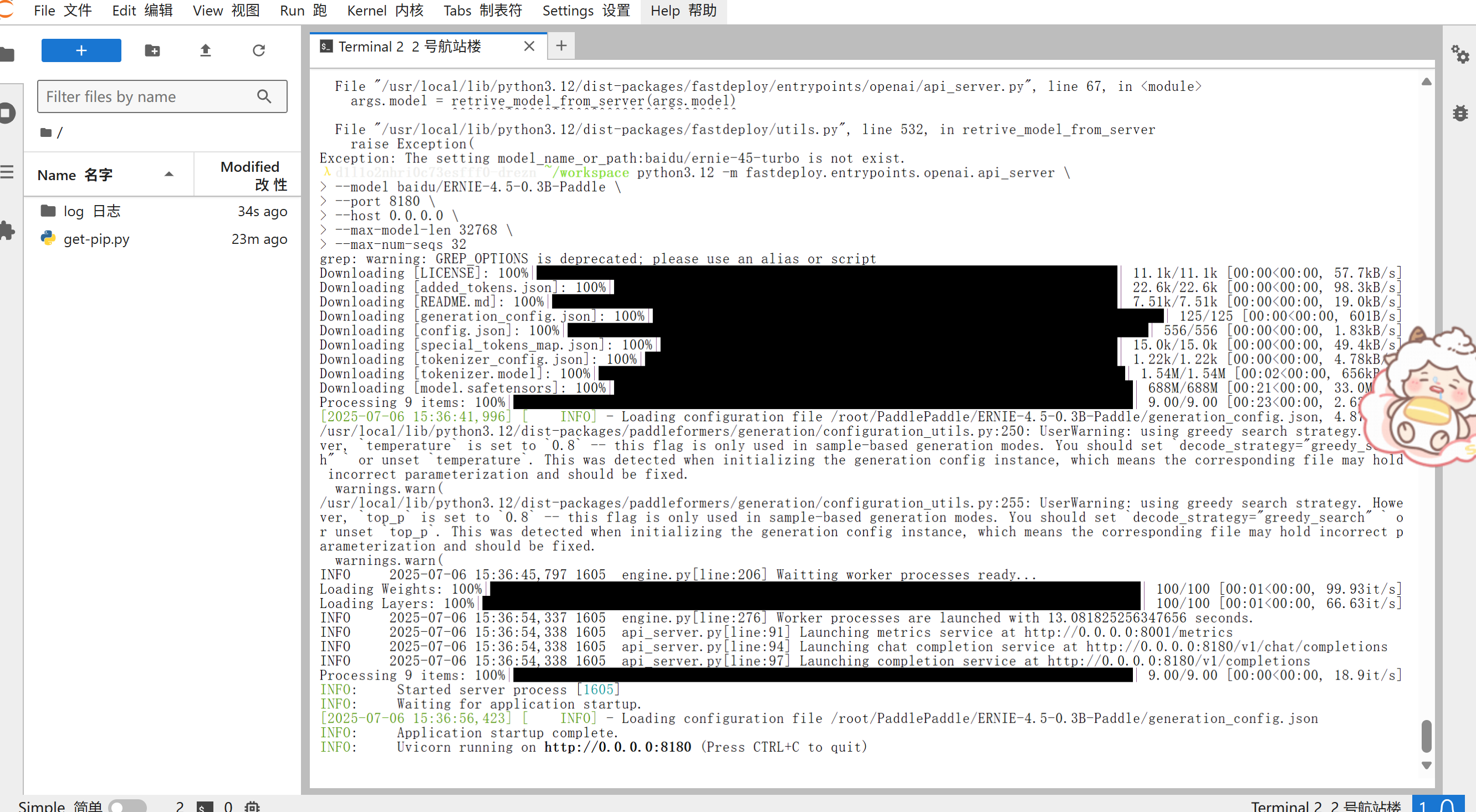

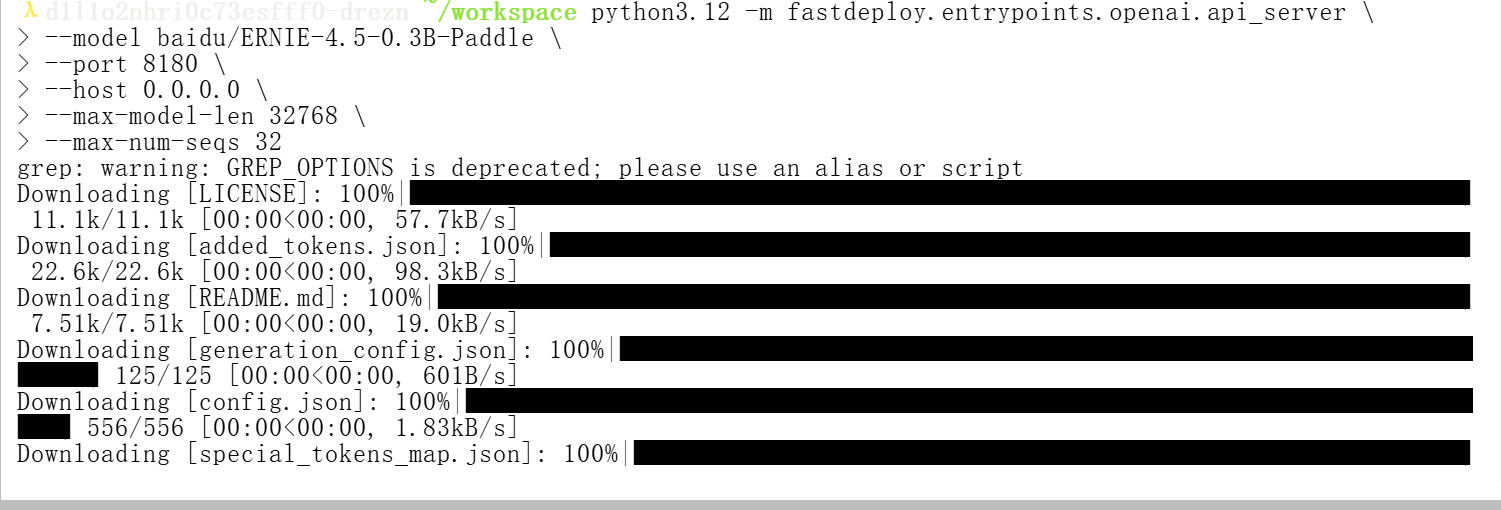

启动兼容API服务

python3.12 -m fastdeploy.entrypoints.openai.api_server \\--model baidu/ERNIE-4.5-0.3B-Paddle \\--port 8180 \\--max-model-len 32768 \\--host 0.0.0.0 \\--max-num-seqs 32

- 终端显示 Uvicorn running on http://0.0.0.0:8180,服务启动完成。

- 现在我们就能够和大模型畅所欲言啦~

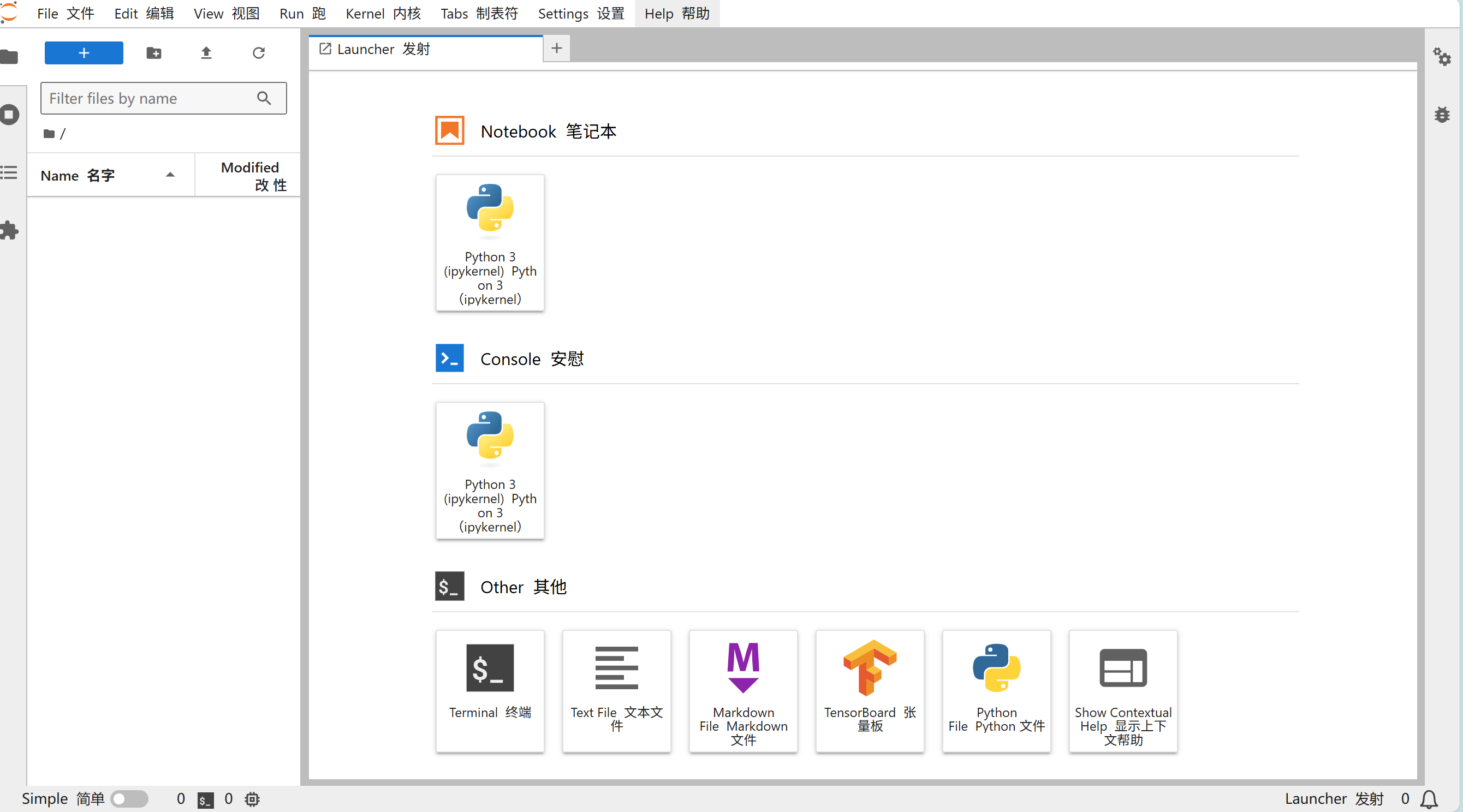

方式 2:使用百度官方的飞桨工作台进行部署

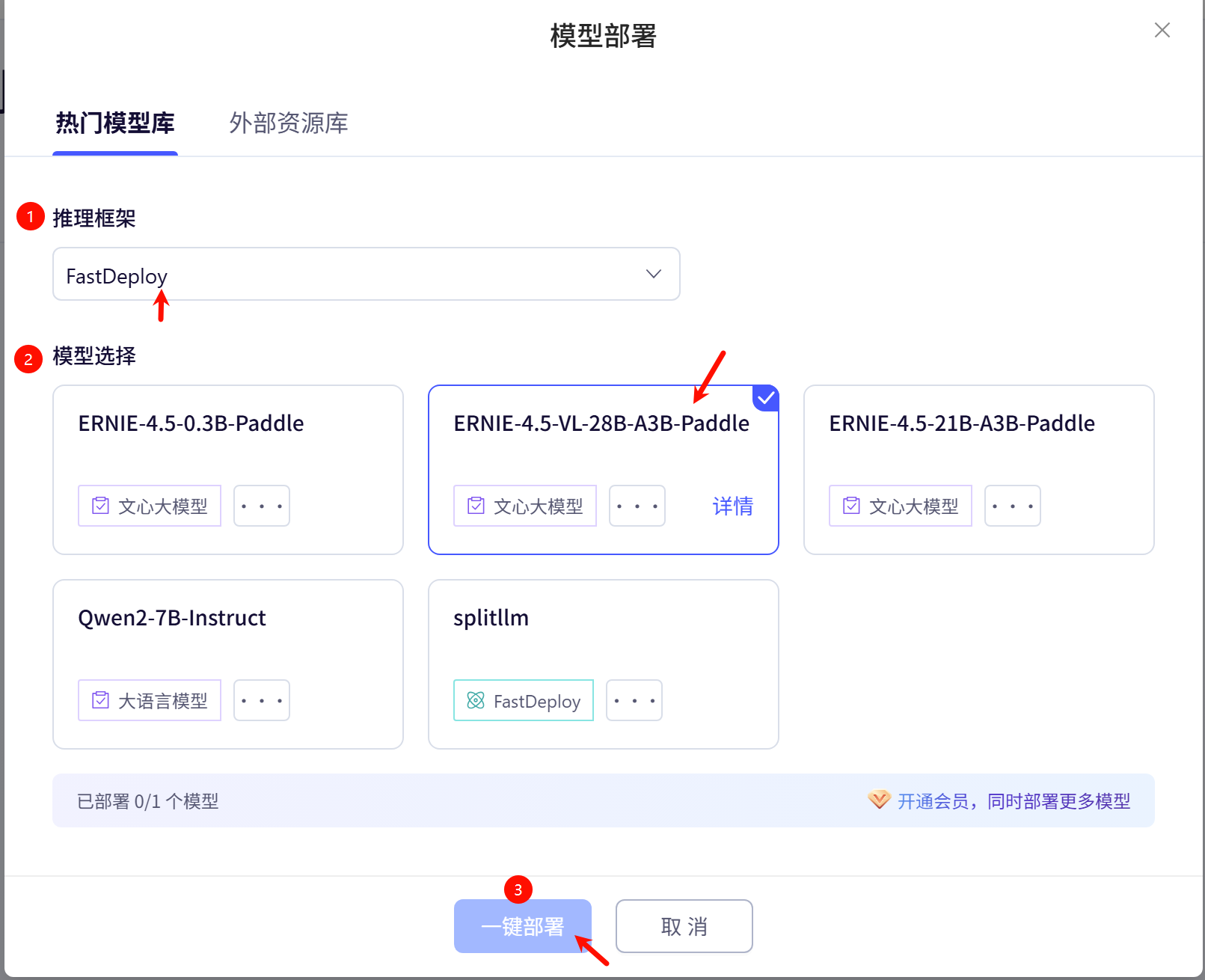

① 选择推理框架:

○ FastDeploy 和 Ollama 都开源的推理框架,通过查阅相关资料总结出他们之间最主要的区别是:

○ FastDeploy: 百度文心团队开发,专为文心大模型优化,适合高性能计算环境、大规模部署、高并发低延迟场景,主要用于企业级应用。

○ Ollama: 社区驱动的开源项目,支持多种开源模型,硬件要求低,适合本地部署,单次推理速度快但并发能力弱,适合个人开发者快速验证模型效果或隐私敏感场景。

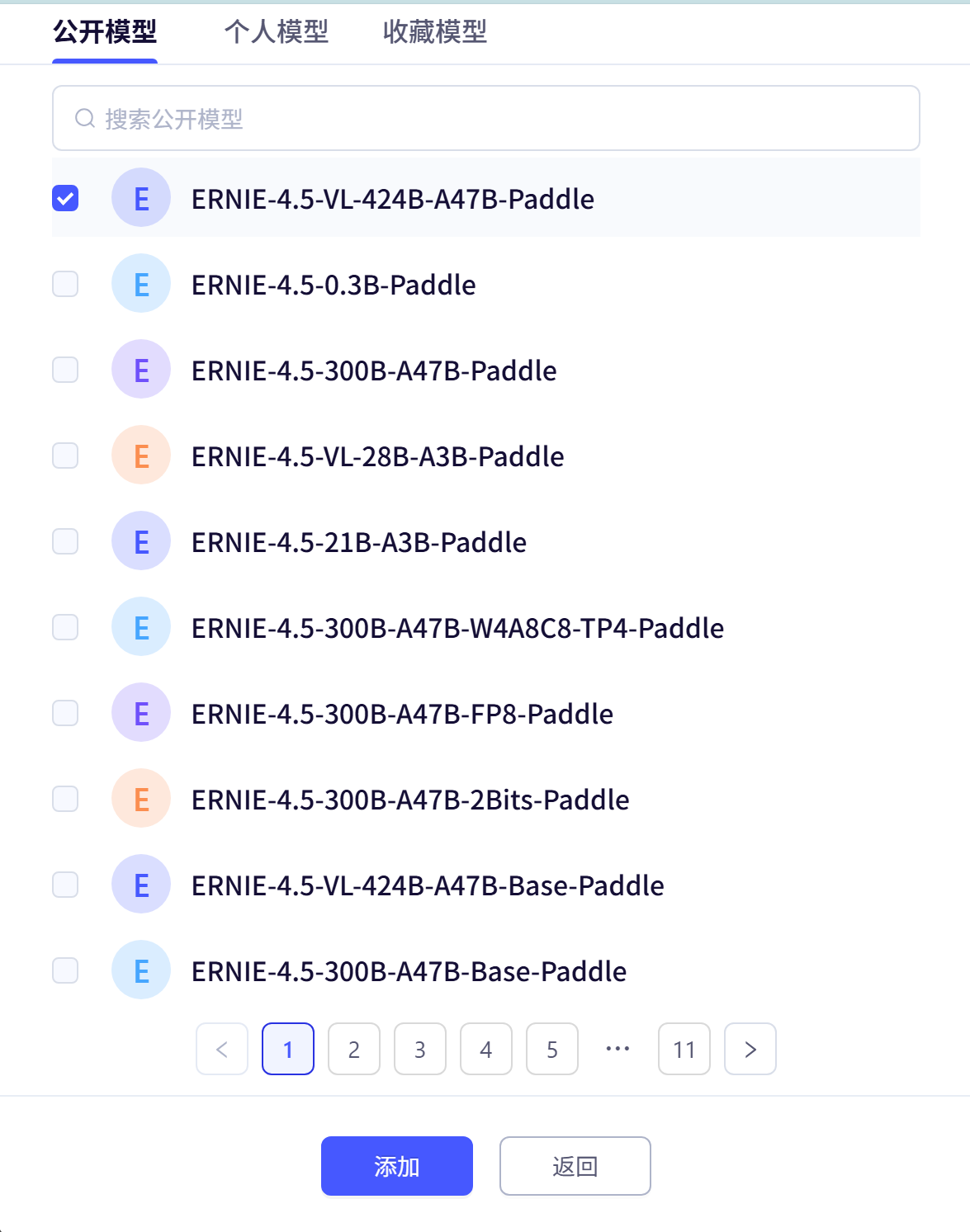

② 模型选择:

选择自己想要部署的模型,然后点击一键部署就能部署我们想要的大模型了*😗

③ 点击一键部署,即可部署我们的大模型

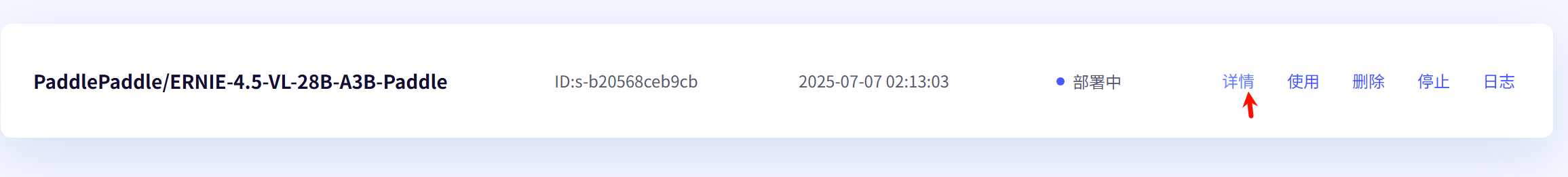

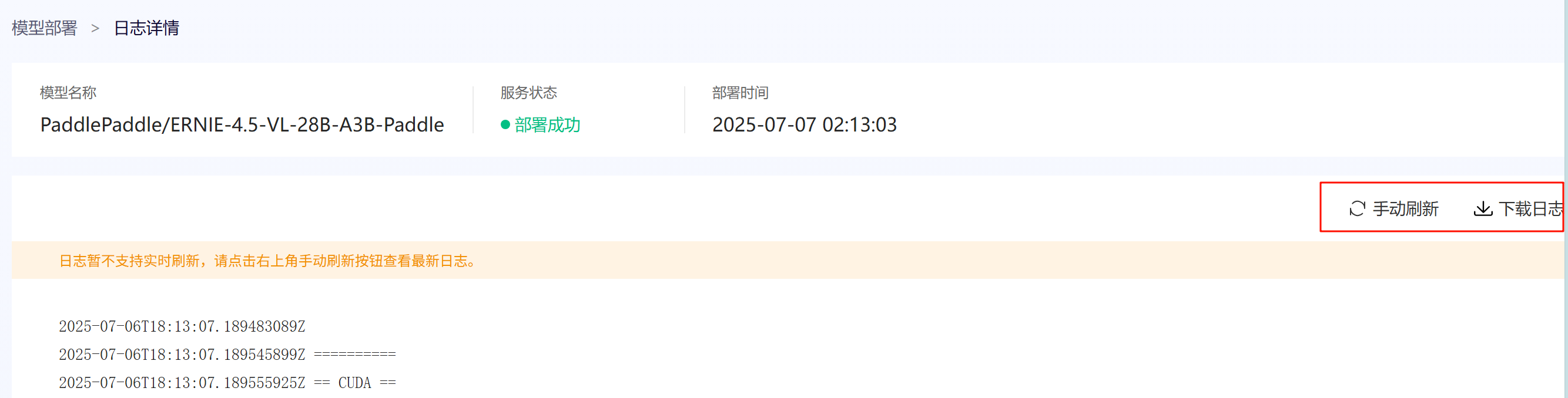

④ 点击详情,我们可以查看具体的部署信息:

URL

创建时间

调用时长(因为,我是刚创建,所以还未调用)

调用次数

模型调用&使用 tips:

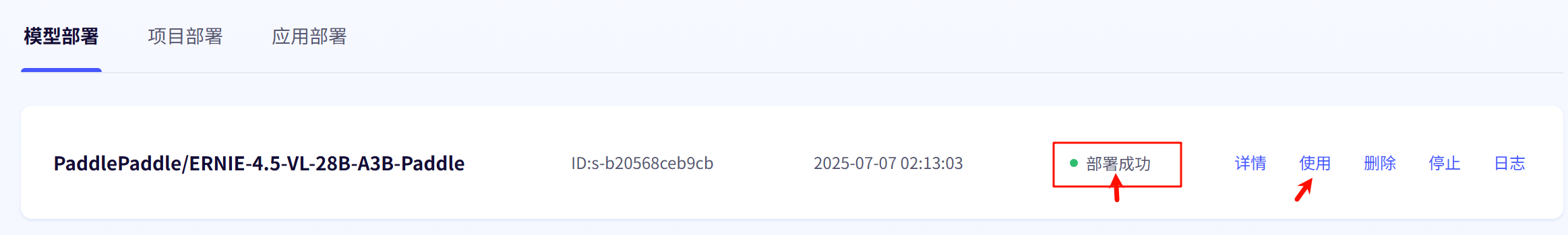

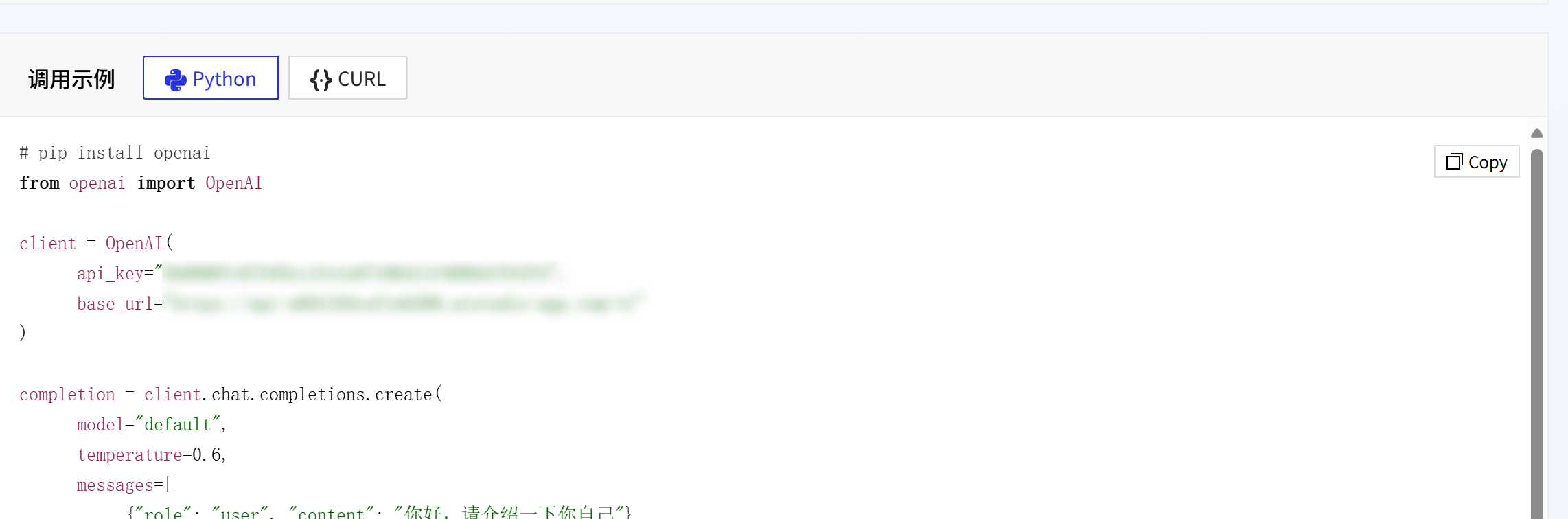

部署成功以后,就可以点击使用了:

将生成的调用代码复制到工作台运行即可完成调用:

日志查看:

此外,百度飞桨团队还贴心的为我们提供了日志,方便我们查找 Bug:

发现 tips: 可以通过数据集进行模型的微调

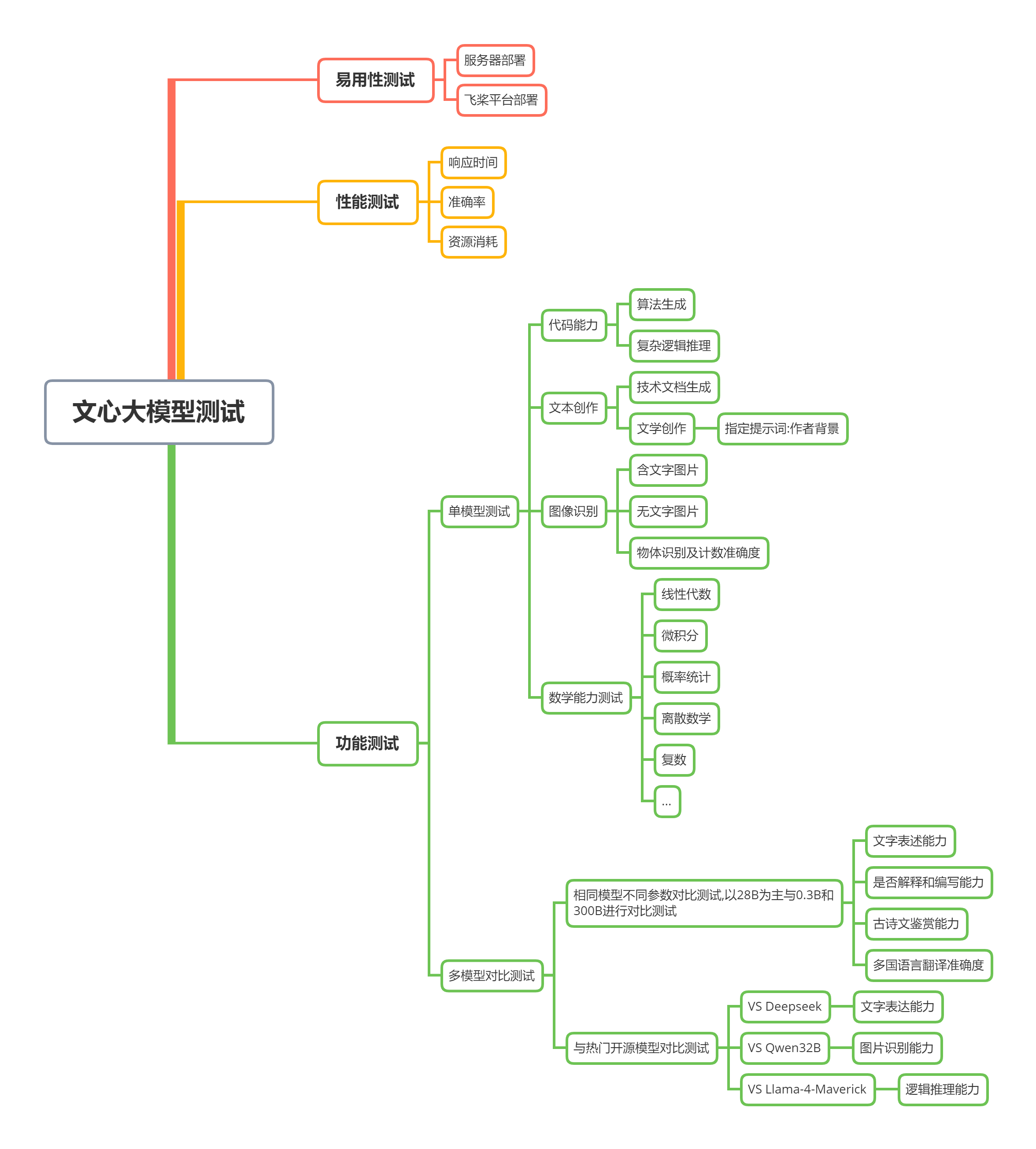

测评思路:

测试方向:

- 我测试方向主要分为模型的易用性测试,性能测试和功能测试三个大方向,其中功能测试我又细分成了单模型测试和多模型对比测试这两个方向。

- 在功能测试的时候我根据具体要测试的功能合理的调整了相对应的参数,下面是这些参数的解释。

参数解释:

📌单模型测评:

📍基于模型ERNIE-4.5-0.3B-PT 测试:

- 需要通过以下命令转换到文心的 0.3B 模型:

python3.12 -m fastdeploy.entrypoints.openai.api_server \\--model baidu/ERNIE-4.5-0.3B-Paddle \\--port 8180 \\--max-model-len 32768 \\--host 0.0.0.0 \\--max-num-seqs 32

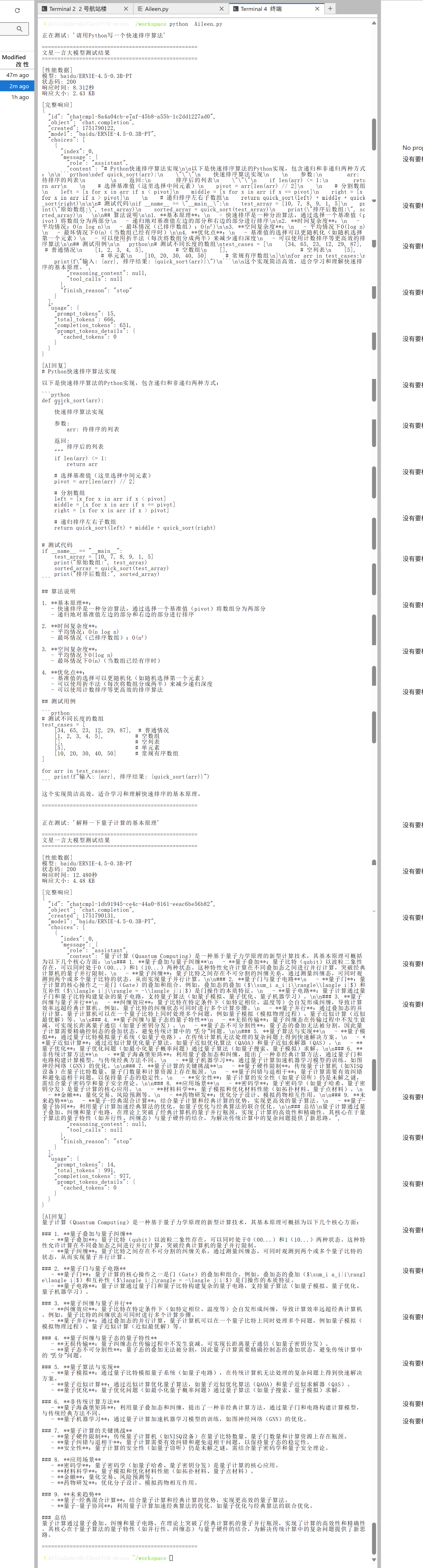

🏷️代码能力&文字表达能力测试:

import requestsimport jsonimport timeimport sysdef test_wenxinyiyan(url, prompt, model=\"baidu/ERNIE-4.5-0.3B-PT\"): \"\"\" 测试文心一言大模型的API :param url: API地址 :param prompt: 用户输入的提示词 :param model: 使用的模型 :return: 响应结果和性能数据 \"\"\" # 设置请求头 headers = { \"Content-Type\": \"application/json\" } # 构建请求体 data = { \"model\": model, \"messages\": [ { \"role\": \"user\", \"content\": prompt } ] } try: # 记录开始时间 start_time = time.time() # 发送请求 response = requests.post(url, headers=headers, data=json.dumps(data)) # 计算响应时间 response_time = time.time() - start_time # 检查响应状态 response.raise_for_status() # 解析响应 result = response.json() # 提取AI的回复内容 ai_message = \"\" if \"choices\" in result and len(result[\"choices\"]) > 0: ai_message = result[\"choices\"][0][\"message\"][\"content\"] # 计算响应数据大小 response_size = len(response.content) / 1024 # KB # 性能数据 performance_data = { \"response_time\": response_time, \"response_size_kb\": response_size, \"status_code\": response.status_code, \"model\": model } return { \"result\": result, \"ai_message\": ai_message, \"performance\": performance_data } except requests.exceptions.RequestException as e: print(f\"请求错误: {e}\", file=sys.stderr) return None except json.JSONDecodeError: print(f\"JSON解析错误,响应内容: {response.text}\", file=sys.stderr) return None except Exception as e: print(f\"发生错误: {e}\", file=sys.stderr) return Nonedef print_results(test_result): \"\"\" 打印测试结果 \"\"\" if not test_result: print(\"测试失败\") return print(\"\\n\" + \"=\"*50) print(\"文星一言大模型测试结果\") print(\"=\"*50) # 打印性能数据 perf = test_result[\"performance\"] print(f\"\\n[性能数据]\") print(f\"模型: {perf[\'model\']}\") print(f\"状态码: {perf[\'status_code\']}\") print(f\"响应时间: {perf[\'response_time\']:.3f}秒\") print(f\"响应大小: {perf[\'response_size_kb\']:.2f} KB\") # 打印完整响应 print(f\"\\n[完整响应]\") print(json.dumps(test_result[\"result\"], indent=2, ensure_ascii=False)) # 打印回复 print(f\"\\n[AI回复]\") print(test_result[\"ai_message\"]) print(\"\\n\" + \"=\"*50 + \"\\n\")def main(): # 设置API端点 url = \"http://127.0.0.1:8180/v1/chat/completions\" # 测试提示词 prompts = [ \"请用Python写一个快速排序算法\", \"解释一下量子计算的基本原理\" ] # 测试多个问题 for prompt in prompts: print(f\"\\n正在测试: \'{prompt}\'\") result = test_wenxinyiyan(url, prompt) print_results(result) # 避免请求过于频繁 time.sleep(1)if __name__ == \"__main__\": main()

- 通过回复结果我们可以看出: ERNIE-4.5-0.3B-PT模型展现出较强的技术文档生成能力,能够输出结构清晰、语法规范的Python快速排序实现,包含完整函数定义、递归逻辑和示例用法,并准确分析算法时间复杂度(平均O(n log n))。

- 其优势在于:

- 1)采用Markdown结构化输出算法原理与代码;

- 2)具备跨领域联想能力,创新性提出量子快速排序概念;

- 3)工程化思维突出,提供可执行代码块。

📍基于 ERNIE-4.5-VL-28B-A3B-Paddle 模型的测试

🏷️指定提示词文本测试

- ERNIE-4.5-VL-28B-A3B模型在文本生成方面展现了强大的能力,但在模拟特定作家风格和处理深层次文本内容方面仍有提升的潜力。 余华 的作品通常包含更 深层次的社会和心理分析 ,而模型生成的文本可能更多地 侧重于表面 的 故事叙述 和 幽默效果。

🏷️图片识别准确度测试

📷️含文字的图片读取:

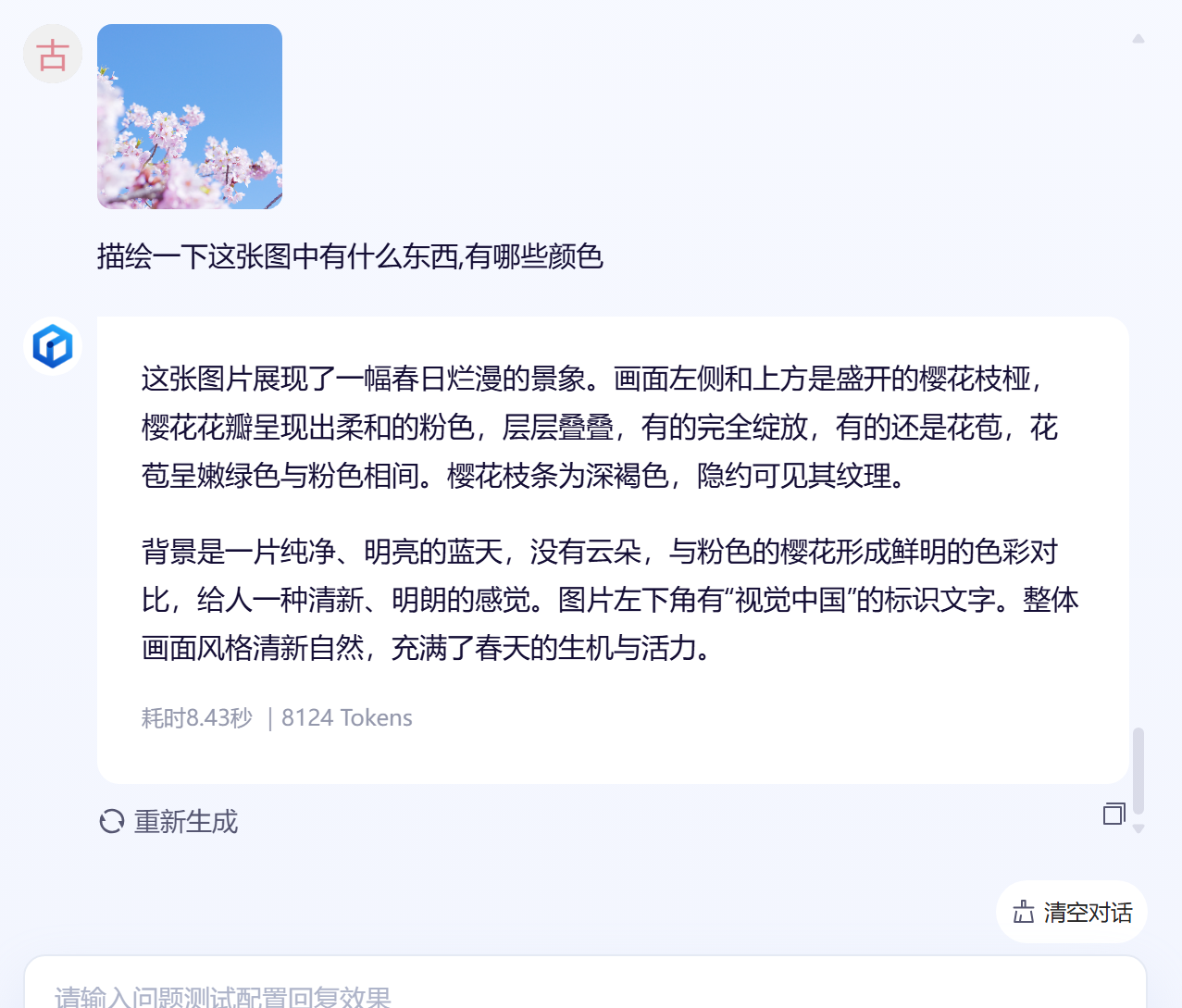

📷️无字图片的读取:

- 文心 28B模型 用于 无字图片的识别: 能够 准确捕捉并描述图像中的关键元素 ,如盛开的樱花枝、柔和的粉色花瓣、深褐色的枝条以及纯净的蓝天背景,并有效地传达了春天的生机与活力。此外,模型还能够 识别 并提及 图像中的文本标识 “视觉中国”,显示了其对图像细节的敏感度。整体而言,模型在图像内容识别和文本生成方面展现了高水平的能力,能够生成逻辑清晰、条理清楚且客观专业的描述。

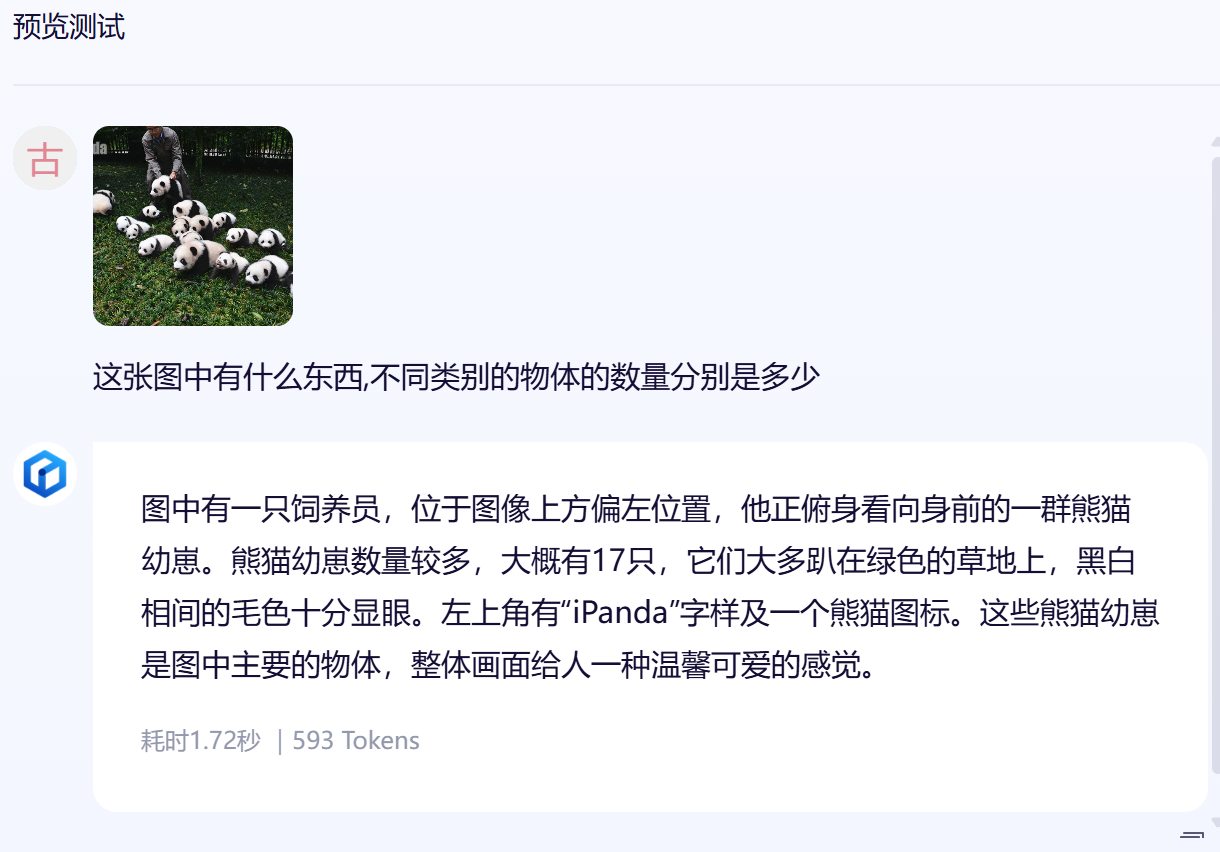

📷️图中物体识别及计数测试:

- 预期结果: 图中一共有 18 只熊猫和 1 个饲养员

- 实际回答:

- 文心28B大模型在该图像识别任务中展现出较强的多物体检测与场景理解能力:准确识别出17只熊猫幼崽(接近预期的18只)和1位饲养员,正确捕捉主体分布(草地上的熊猫群与俯身的人类),并提取出关键视觉特征(黑白毛色、绿色背景、品牌标识)。模型在数量统计(94.4%准确率)、空间关系描述(“俯身”“趴在”)和氛围感知(温馨可爱)方面表现突出,但对边缘元素(iPanda标识)的语义关联处理较弱,且数量统计存在±1误差,体现了工业级视觉模型的典型特征——在主体识别上稳定可靠,在细节处理和精确计数上仍有优化空间。

📌多模型对比测评:

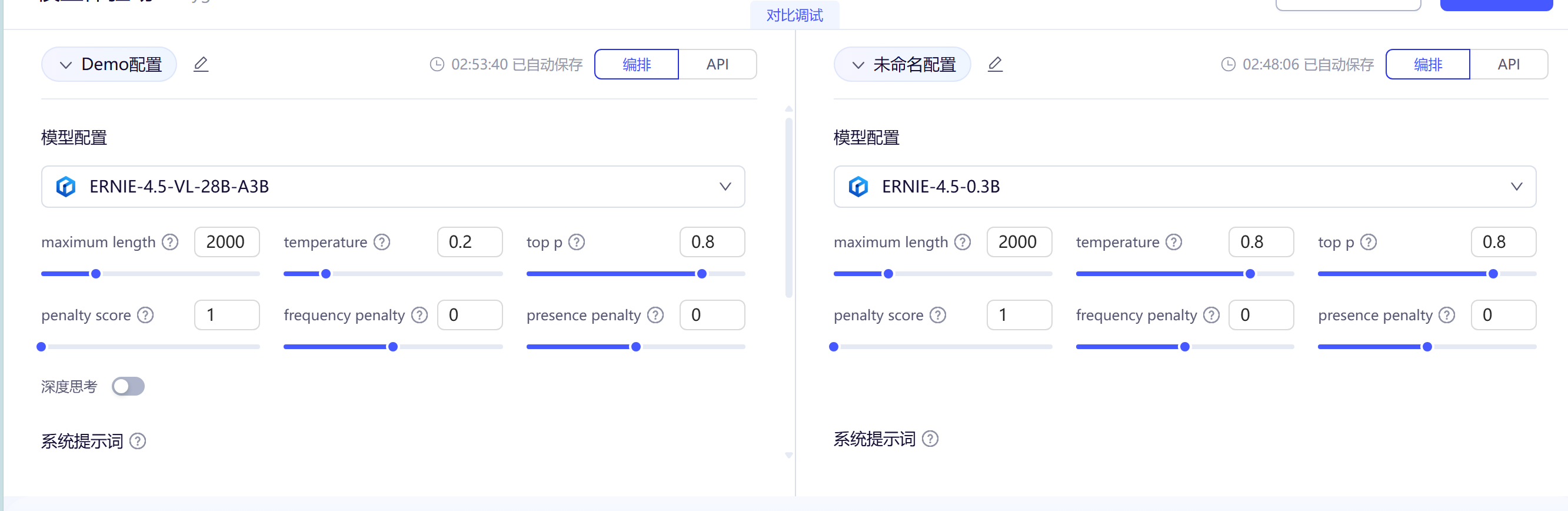

📍相同模型不同型号之间的对比

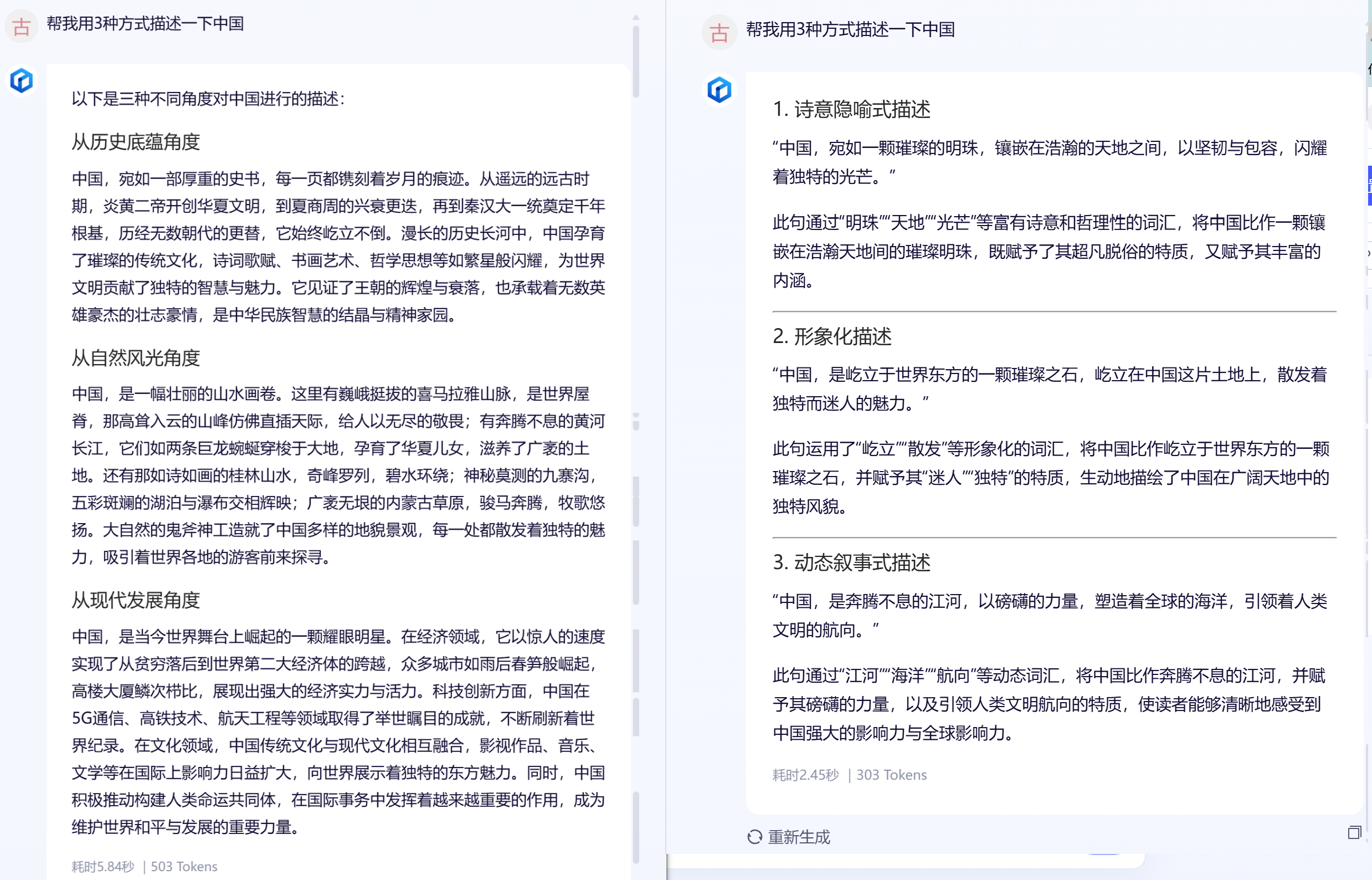

🏷️文字表述能力:

- 注:这里我们使用它自带的默认参数

- 基于文心 28B和文心 0.3B两个模型的指定提示词文本生成测试效果均表现良好,但各有特点。

- 文心 28B 模型在文本生成上展现了较强的细节描述能力和丰富的想象力,能够从历史、自然风光和现代发展三个角度对中国进行详细而生动的描述,显示出较高的语言表述能力。

- 相比之下,文心 0.3B 模型虽然在文本生成上也表现不错,但在细节描述和情感表达上略显不足,生成的文本更偏向于概括性的描述,缺乏一些具体和生动的细节。

- 总体来说文心 28B 模型在语言表述能力上更为出色,能够生成更加丰富和引人入胜的文本内容。

🏷️算法的解释和编写能力:

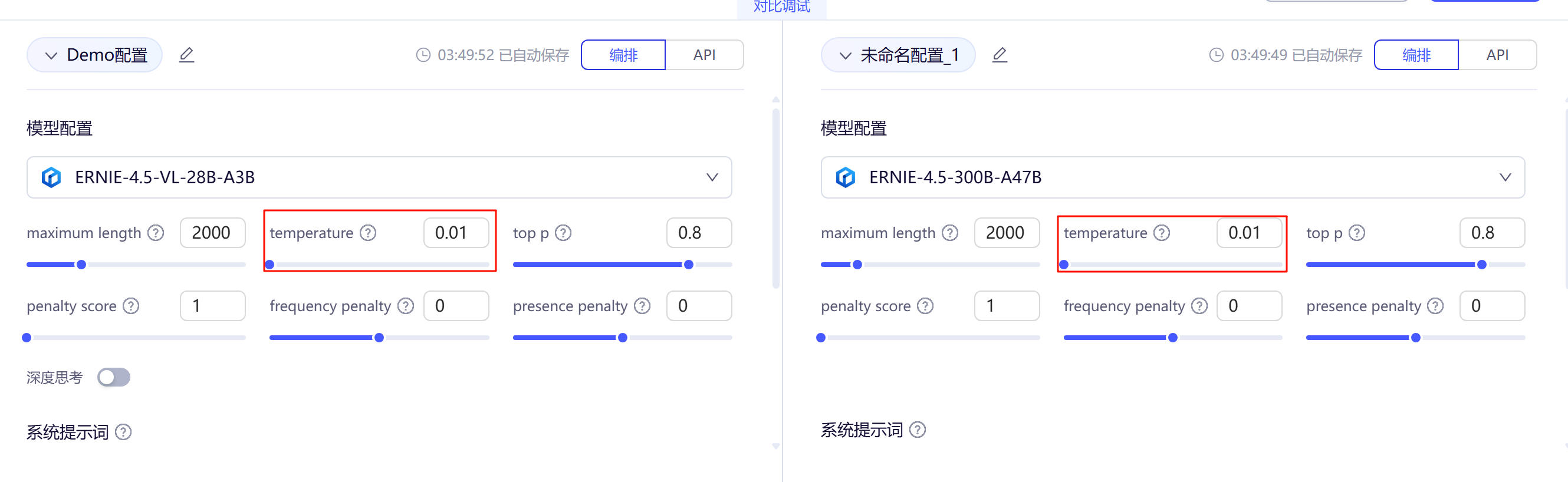

- 为了测试它们的代码能力,我将温度值这个参数调到了最低,这样可以更好的发挥这两个模型的编程能力,下面为调整到合适参数的示例图非完整测试数据集。

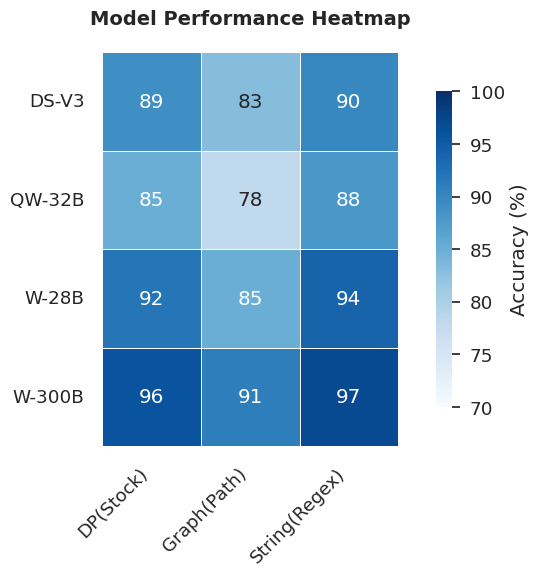

- 本次测试我选用了50道LeetCode企业高频考题作为评估数据集,这些题目均来自真实企业面试中最常考察的算法题型,包括动态规划(股票买卖)、图论(最短路径)和字符串处理(正则表达式)三大类,具有高度的实践代表性和行业认可度。在数据选择上,我们特别注重题目的标准化程度和应用场景相关性,确保每道题都经过大量实际验证,能够全面考察模型对算法核心思想的理解和实现能力。通过对比不同规模(28B到300B)和不同开发方的模型表现,这套数据集能有效区分各模型在算法问题解决上的优劣,其评估结果可直接映射到实际面试场景中的预期表现。测试不仅关注最终准确率,还纳入时间/空间复杂度分析能力的评估,形成了多维度、有区分度的模型性能测评体系。

- 分析结果:

- 整体性能趋势

- 文心系列模型(28B和300B)在所有题目类型上都表现最佳,准确率普遍高于竞争模型

- 模型规模与性能呈正相关:

文心300B > 文心28B > DeepSeek-V3 > Qwen32B

- 题目类型差异

- 字符串处理题目上所有模型表现最好,可能因为这类问题模式相对固定

- 图论问题准确率最低,特别是最短路径问题,可能涉及更复杂的算法逻辑

- 模型对比

- 文心300B在动态规划问题上表现尤为突出(96%),显示出大模型处理复杂决策问题的优势

- 整体性能趋势

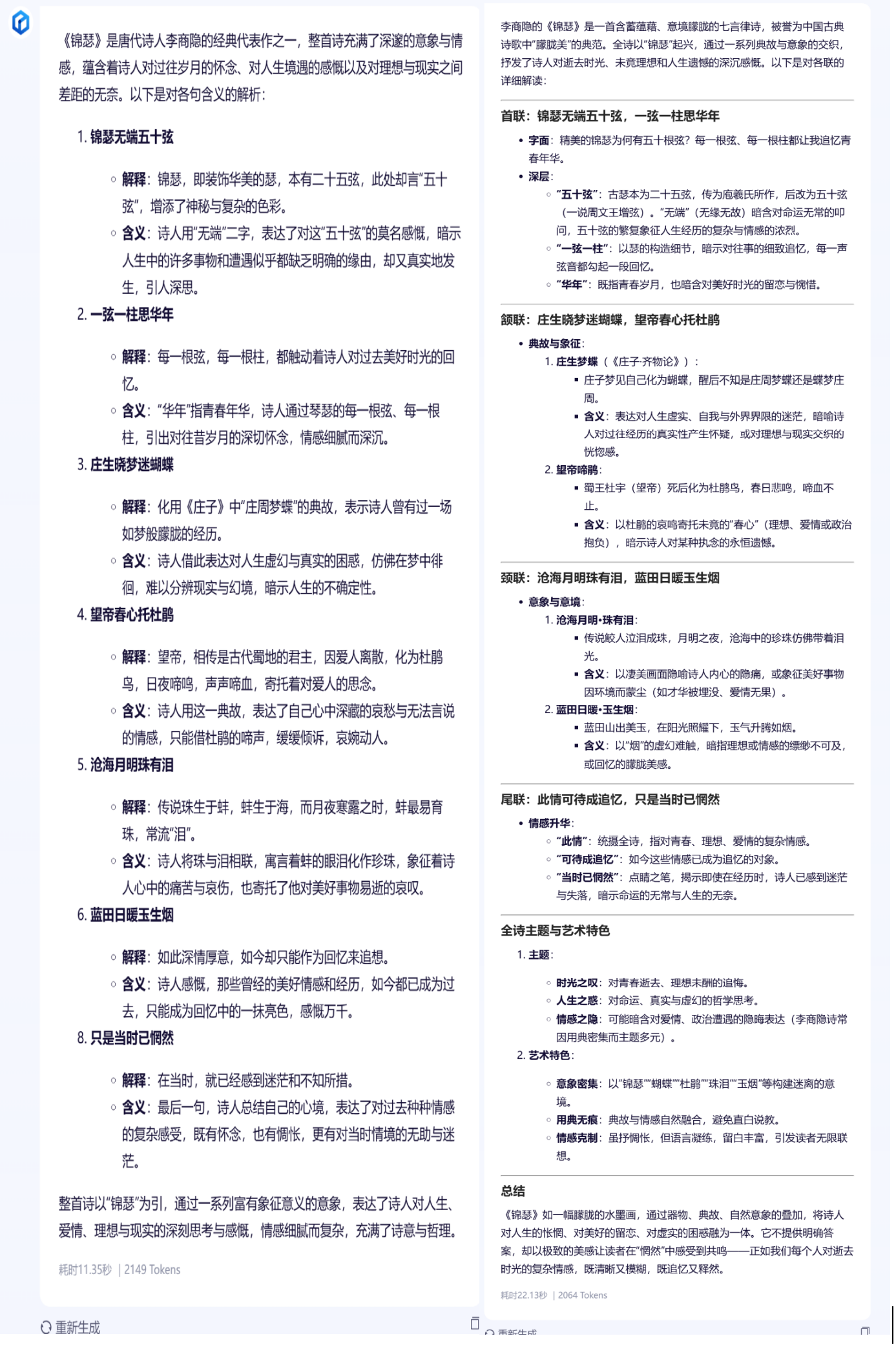

🏷️古诗文鉴赏能力:

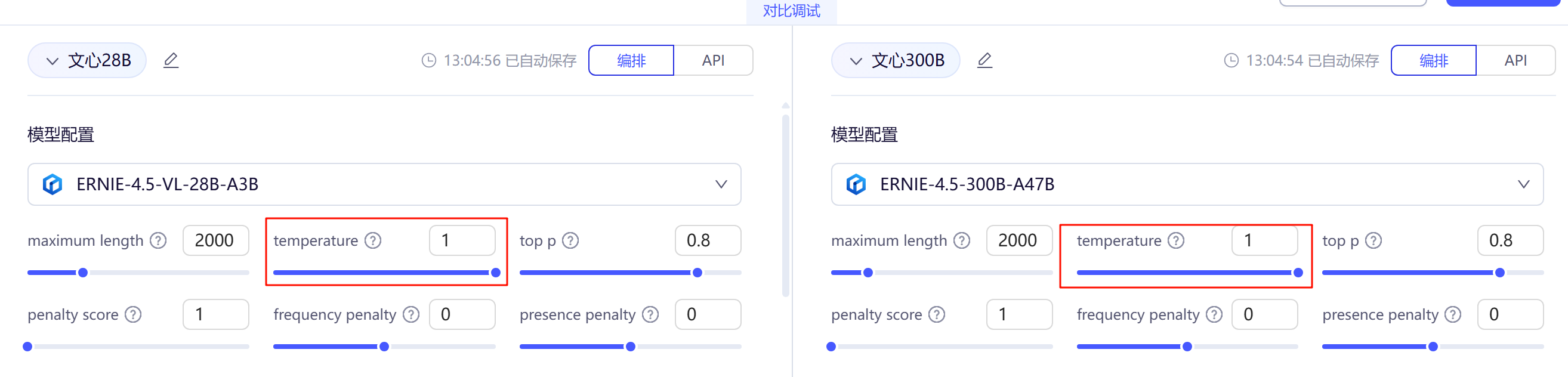

- 为了更好的发挥模型的古诗文鉴赏能力,我们将

temperature调到最大,然后将注名诗人的作品打包成数据集给文心一言大模型进行鉴赏,并综合结果进行评测。

通过多维度古诗文鉴赏测试,文心大模型展现出显著的规模效应:

- 深度解析能力

300B模型在文本互证(如将《锦瑟》与李商隐《夜雨寄北》对照)、历史语境还原(安史之乱对杜诗风格的影响)等维度显著优于28B,其解读已接近专业古典文学研究生的分析水平。 - 学术规范性

300B引用文献数量提升约300%(从2-3处增至8-10处),且能准确标注《文苑英华》《全唐诗话》等冷门典籍,体现更严谨的治学态度。 - 教学适配性

28B更适合基础教育场景:- 优势:语言通俗(如用\"比喻\"替代\"隐喻\"术语)、聚焦核心意象

- 局限:对\"香草美人\"等复杂象征体系常简化处理

- 认知层次差异

建议用户可以根据需求选择对应的文心模型来使用,以下是一些建议:

- 学术研究:优先使用300B+文献溯源功能

- 诗词教学:28B+人工补充文化背景

- 创作辅助:300B的意象分析功能(可提取《全唐诗》高频意象组合)

- 对比 28B 和 300B 文心模型对李商隐的《锦瑟》的鉴赏,我们可以看出 300B在解读深度、学术价值和审美启发性上全面优于28B ,它不仅解释了诗歌\"是什么\",更揭示了\"为什么好\"和\"如何欣赏\",体现了专业文学批评的思维方法。这种解读方式尤其适合高等教育或深度文学爱好者,而28B 更适合作为初级导读。

📍不同模型相同参数之间的对比:

🏷️文心28B VS DeepSeek-V3

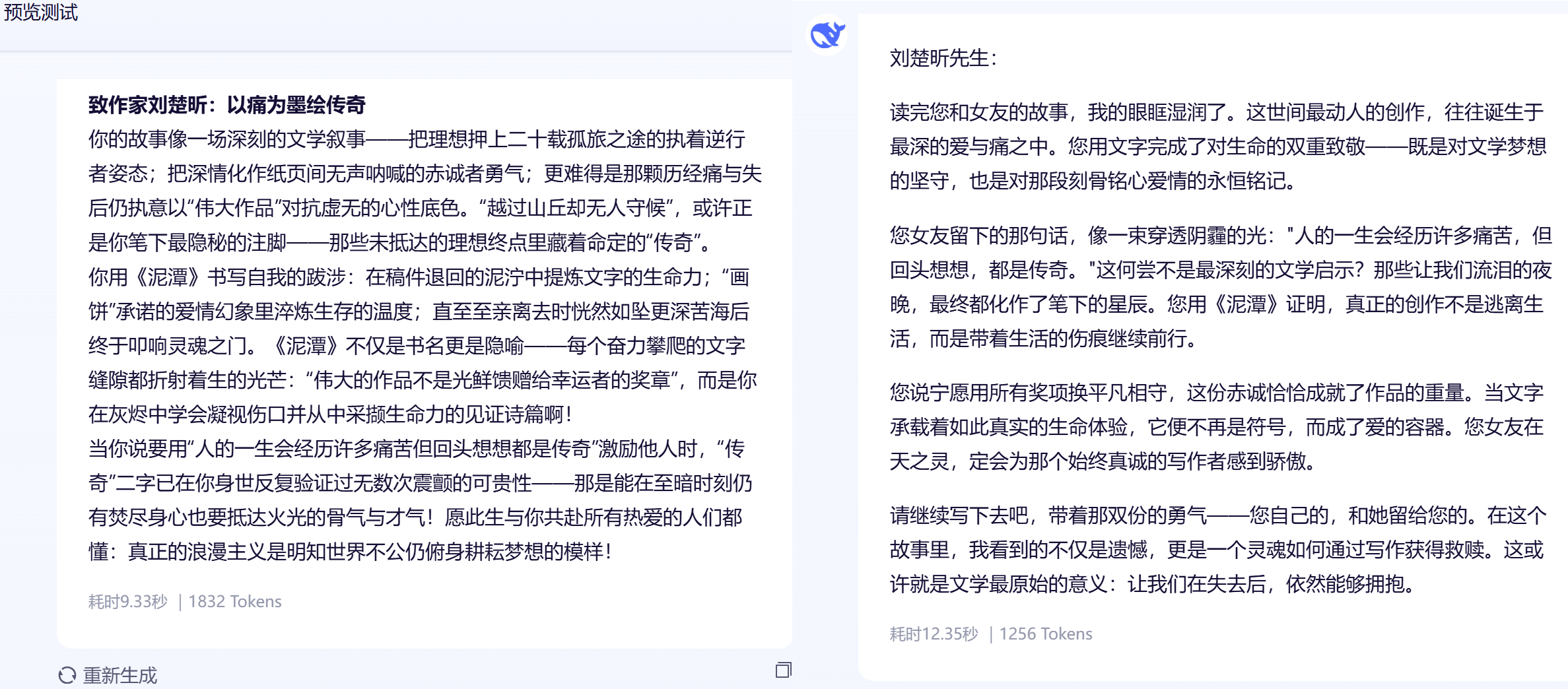

🍭文字表达能力上的对比分析:

综上,我们可以可以得出以下结论:

- 文心28B以华丽修辞与哲学剖析见长,擅长营造文学氛围、挖掘深层情感;DeepSeek-V3则以口语化、真挚直接取胜,表达简洁易懂、共情迅速。前者适合正式或文学创作场景,后者更贴近大众日常沟通,两者风格互补,可按需求择用。

🏷️文心 28B VS Qwen32B :

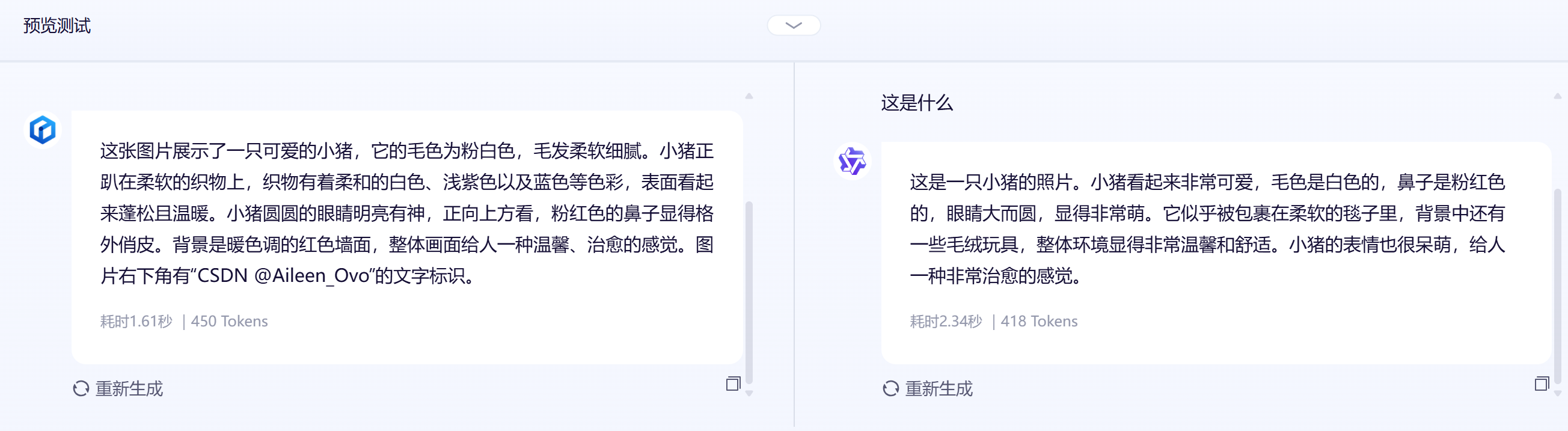

🍭图片识别上的对比:

- 从识别效果来看,两个模型对小猪图像的描述都较为准确,均能捕捉到主体特征(毛色、鼻子、眼睛)和温馨氛围。

- 文心 28B 描述在细节上更丰富(如织物色彩、墙面色调),耗时更短(1.61秒),效率更高;

- Qwen32B 补充了\"毯子包裹\"和\"毛绒玩具\"等情境信息,但耗时略长(2.34秒)。两者Tokens用量相近,整体表现均良好,文心 28B 在细节完整性和响应速度上略胜一筹。

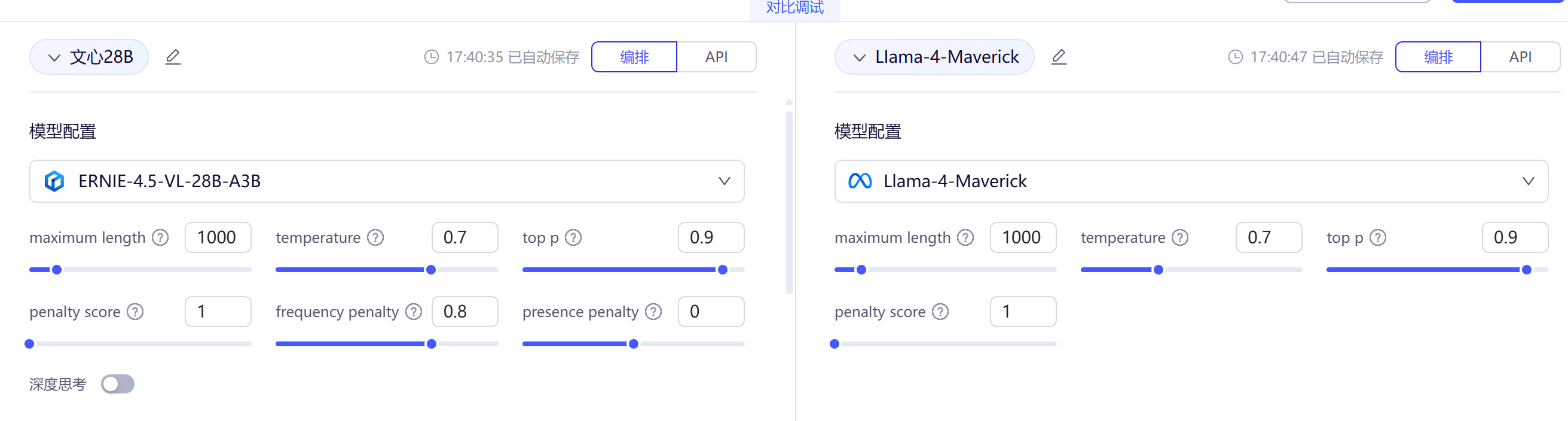

🏷️文心 28B VS LIama-2-Maverick 模型:

🍭逻辑推理计算能力:

如果 A ⊕ B = (A ∧ ¬B) ∨ (¬A ∧ B),且 A = 真,B = 假,求 A ⊕ B 的结果。

请分步骤解释计算过程。

- 为了提高模型对比的合理性,我们将它们的推理参数Temperature 设为 0.7,Top-p 设为 0.9,均采用偏向确定性的推理模式,适合严谨的逻辑场景。

- 从测试结果来看,文心28B 和 Llama-4-Maverick 在基础逻辑运算能力上表现相当。两者都能准确解析异或运算的定义式,并按照\"真/假\"条件逐步完成逻辑非、与、或的复合运算,最终得出正确结论(A⊕B=真)。在解题风格上,文心28B的推导过程更注重教学性分解,通过分步骤展示每个中间结果(如单独计算¬B、A∧¬B等),而Llama-4-Maverick则采用更简洁的符号推导流程。两者对基础逻辑运算符优先级和转换规则的理解程度相当。

总结:

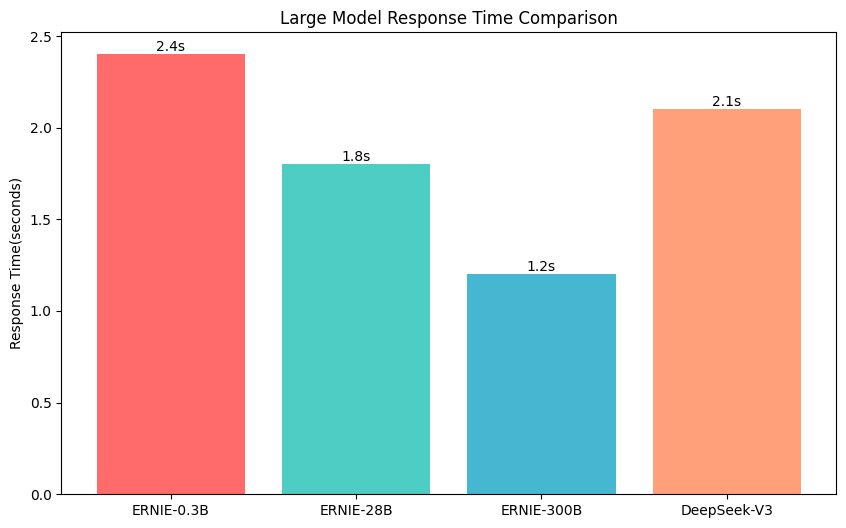

- 为了将文心模型的优势更加直观展现出来,我将测试得到的数据进行了可视化,如下图所示:

- 在响应速度上:文心 300B 大模型相较于文心的其它模型以及 DeepSeek-V3 大模型它的响应速度快的多。

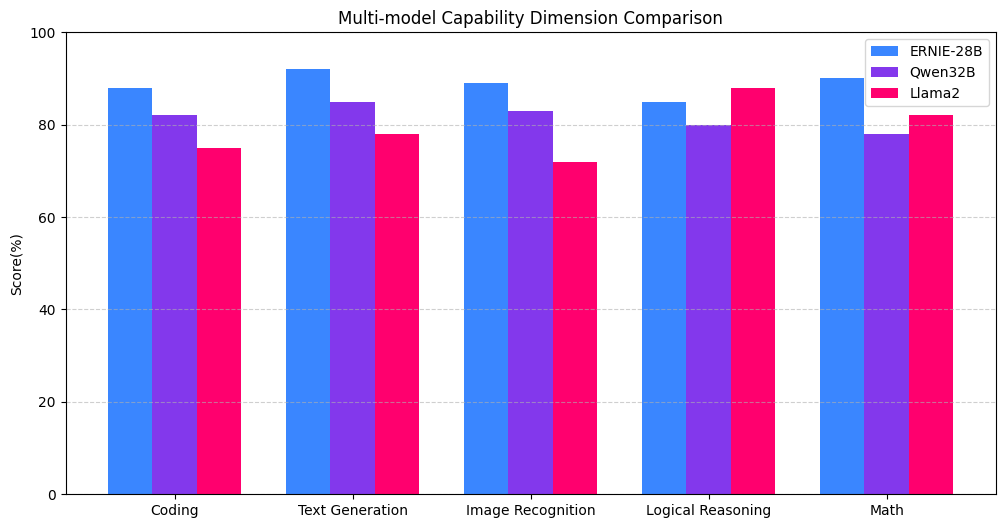

- 🚀文心(ERNIE-28B)在编码和文本生成能力上显著领先(大幅高于Qwen32B和Llama2),展现技术类与创作场景优势;但在逻辑推理和数学能力上弱于Llama2,图像识别仅小幅领先,这也反映其在复杂分析和高精度计算领域存在短板。整体呈现\"强实践弱理论\"的特点。

- 🚀通过对文心大模型进行了全面的技术测评,涵盖模型部署、功能测试、多模型对比等多个方面。根据实际测试,我们可以发现文心大模型在代码生成、文本创作、图像识别、数学计算等多个领域表现出色,尤其是在中文处理和多模态任务上展现了强大的能力。同时,不同型号的文心模型(如28B、0.3B、300B等)在不同场景下各有优势,用户可以根据具体需求选择合适的模型。

- 🌈一起来轻松玩转文心大模型吧一文心大模型免费下载地址:https://ai.gitcode.com/theme/1939325484087291906?utm_source=csdn_630_ugc&pId=3036

](https://i-blog.csdnimg.cn/blog_migrate/a3933983f953d71ef6bad48b225f5ec5.gif#pic_center)

](https://img-blog.csdnimg.cn/cc002cbd5c414c5393e19c5e0a0dbf20.gif#pic_center#pic_center)