盘点免费且靠谱的AI大模型 API,统一封装,任性调用!_免费的ai接口

现在做大模型,还有靠谱且免费的 API 接口吗?

靠谱的不免费,免费的不靠谱,鱼和熊掌不可兼得?

非也!

对于简单的指令而言,绝大部分免费的 LLM API 还是能打的,本文就给大家介绍几款,猴哥亲测好用的免费的 API 接口!

1. 免费 LLM API 汇总(持续更新中)

- RPM:每分钟处理的请求数量;

- TPM:每分钟处理的Token数量;

- RPD:每天处理的请求数量;

- QPS:每秒内处理的请求数量;

- 并发数:系统同时处理的请求数量。

接下来,我们一起梳理下各家的 API 调用示例代码,以及如何把它们接入 OneAPI,方便集成到兼容 OpenAI 格式的应用中!

关于如何使用 OneAPI,可以围观教程:OneAPI-接口管理和分发神器。

2. 讯飞星火大模型

调用示例代码见:拒绝Token焦虑,盘点可白嫖的6款LLM大语言模型API

当然,更简洁的方式是:接入 OneAPI!

添加一个新的渠道,类型选择讯飞星火认知,模型处手动填入spark-lite。

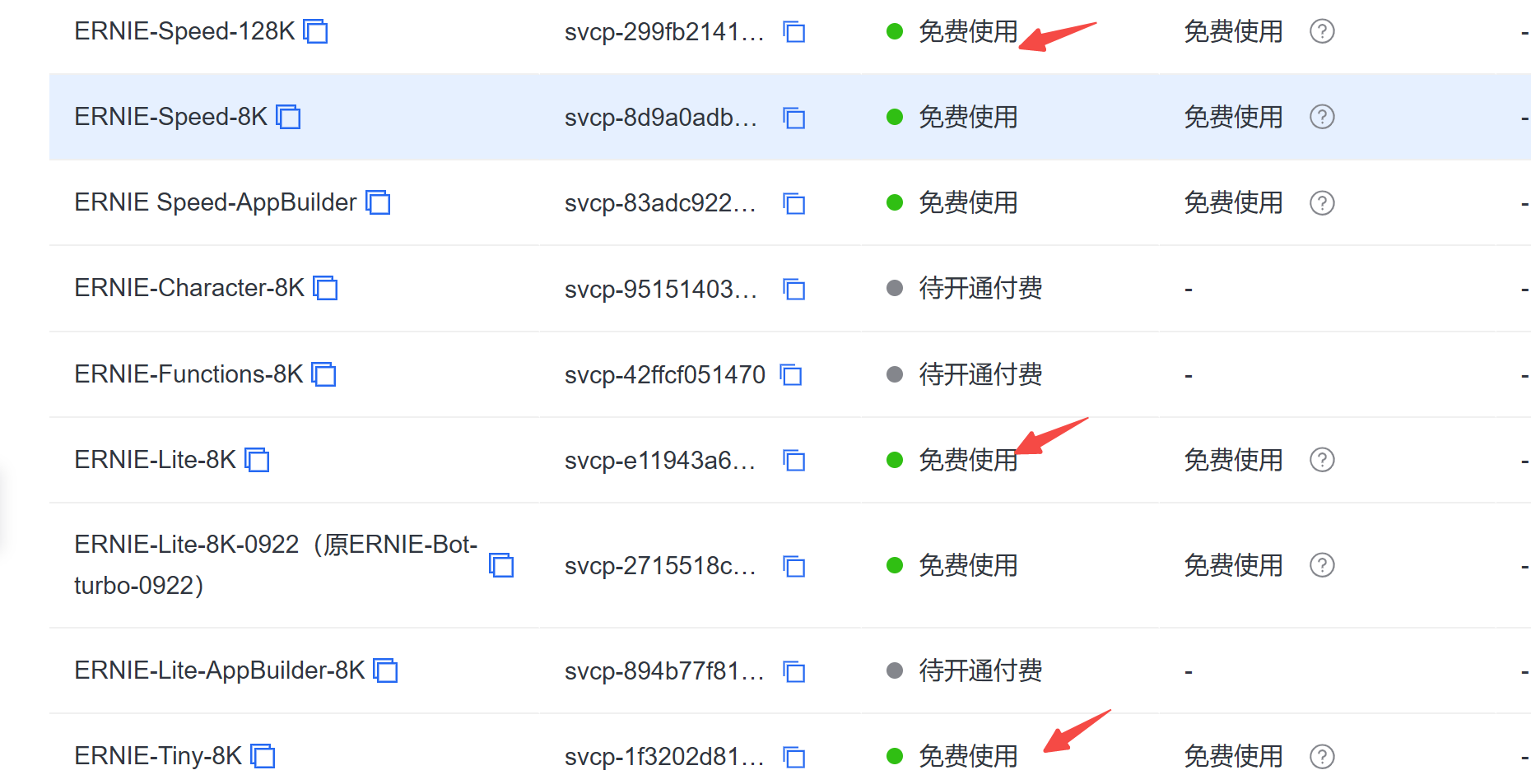

3. 百度千帆大模型

首先,到千帆平台上开通免费的模型:https://console.bce.baidu.com/qianfan/ais/console/onlineService

然后,到应用接入中创建应用,获取API Key、Secret Key

最后,调用示例代码:

import requestsimport jsonAPI_KEY = \"xxx\"SECRET_KEY = \"xxx\"def get_access_token(): \"\"\" 使用 AK,SK 生成鉴权签名(Access Token) \"\"\" url = \"https://aip.baidubce.com/oauth/2.0/token\" params = {\"grant_type\": \"client_credentials\", \"client_id\": API_KEY, \"client_secret\": SECRET_KEY} return str(requests.post(url, params=params).json().get(\"access_token\")) url = \"https://aip.baidubce.com/rpc/2.0/ai_custom/v1/wenxinworkshop/chat/ernie_speed?access_token=\" + get_access_token()payload = json.dumps({ \"messages\": [ { \"role\": \"user\", \"content\": \"你好\" }, ]})headers = { \'Content-Type\': \'application/json\'}response = requests.request(\"POST\", url, headers=headers, data=payload)print(response.text)当然,更简洁的方式是:接入 OneAPI!

添加一个新的渠道,类型选择百度文心千帆,模型处只保留你开通的免费模型。

4. 腾讯混元大模型

腾讯云的产品,接入地址:https://console.cloud.tencent.com/hunyuan/start

新用户首先要开通,然后点击创建密钥,到新页面,新建密钥。

首次记得保存!后续不支持查询!

混元大模型的调用接口,鉴权非常麻烦,最好安装它的 SDK 进行使用。

当然,更简洁的方式是:接入 OneAPI!

添加一个新的渠道,类型选择腾讯混元,模型处需要手动填入hunyuan-lite。

在下面的密钥处填入你的:APPID|SecretId|SecretKey。

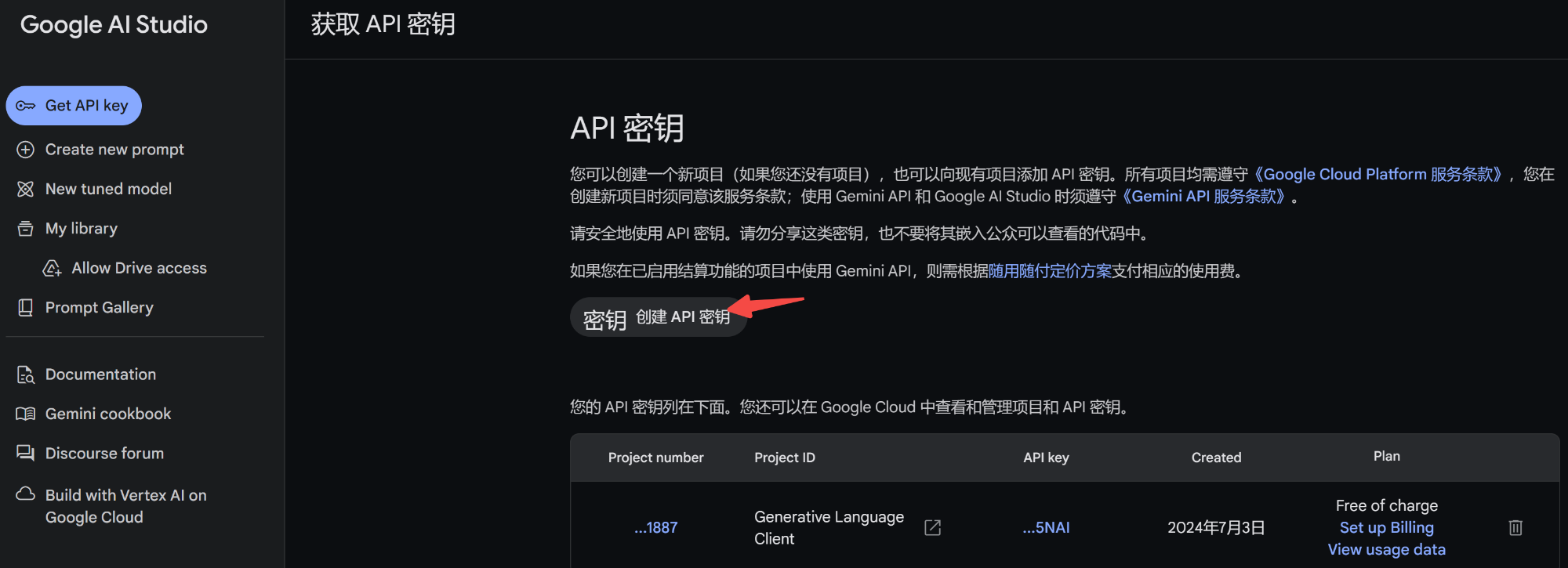

5. Google Gemini

Google Gemini 集成在 Google AI Studio中。

首先需要创建一个项目,然后获取 API 密钥。

API 密钥获取地址:https://aistudio.google.com/app/apikey

在 API 价格文档中,可以看到各个模型的限速详情:https://ai.google.dev/pricing

调用示例代码:

import requestsimport json# 设置请求的URL和API密钥url = \"https://generativelanguage.googleapis.com/v1beta/models/gemini-1.5-flash-latest:generateContent\"api_key = \"xxx\" # 替换为你的API密钥headers = { \"Content-Type\": \"application/json\"}data = {\"contents\": [{\"parts\": [{\"text\": \"Explain how AI works\"}]}]}response = requests.post(f\"{url}?key={api_key}\", headers=headers, data=json.dumps(data))print(response.json())如果是国内 IP,是调不通的,会报下面的错误:

{\'error\': {\'code\': 400, \'message\': \'User location is not supported for the API use.\', \'status\': \'FAILED_PRECONDITION\'}}因此,请自行备好梯子,或在代码中加上海外 IP 的代理!

当然,更简洁的方式是:接入 OneAPI!

添加一个新的渠道,类型选择Google Gemini,模型处只保留你开通的免费模型。

6. All in One

如果你还在因适配各种 LLM 接口而苦恼,强烈推荐使用 OneAPI 管理自己的各种 LLM API!

关于如何使用 OneAPI,可以围观之前的教程:OneAPI-接口管理和分发神器

写在最后

本文盘点了几款免费又好用的 LLM API,并接入了 OneAPI 统一管理!

你要问目前这些免费的 API 中,哪个更能打?

我要说:Google 家的 gemini-pro-1.5 指令遵循最佳,没有之一!

不知你的体验如何?欢迎评论区交流!

如果本文对你有帮助,不妨点个免费的赞和收藏备用。

有任何问题欢迎通过公众号找到我,一起打怪升级。