HDFS读写原理深度解析:从流程到故障排查

前言

HDFS(Hadoop Distributed File System)作为大数据生态系统的基石,其读写机制的高效性和可靠性直接影响着整个大数据平台的性能。本文将深入剖析HDFS的读写原理,详细介绍读写流程中各组件的交互关系,并基于这些原理分析常见问题的排查方法。

1. HDFS核心组件回顾

在深入读写流程之前,我们先回顾一下HDFS的核心组件:

1.1 NameNode

- 作用:元数据管理中心,维护文件系统的目录树和文件块映射信息

- 核心数据结构:

FSImage:文件系统元数据的快照EditLog:记录文件系统的变更操作BlockMap:块ID到DataNode的映射关系

1.2 DataNode

- 作用:实际存储数据块,执行读写操作

- 核心功能:

- 数据块的存储和管理

- 向NameNode定期发送心跳和块报告

- 执行数据块的复制、删除等操作

1.3 Client

- 作用:用户程序与HDFS交互的接口

- 核心组件:

DistributedFileSystem:文件系统操作接口DFSInputStream:读数据流DFSOutputStream:写数据流

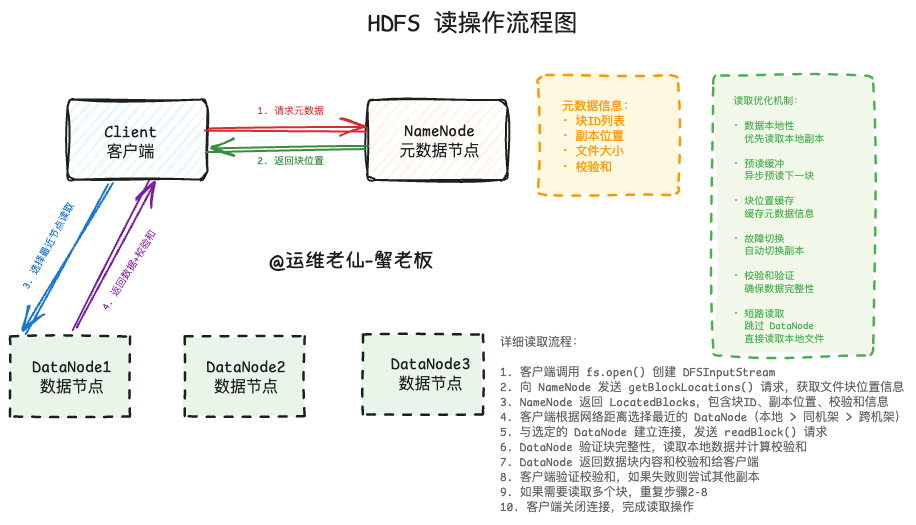

2. HDFS读操作详解

2.1 读操作整体流程

2.2 详细读流程分析

步骤1:客户端发起读请求

// 客户端代码示例FileSystem fs = FileSystem.get(conf);FSDataInputStream inputStream = fs.open(new Path(\"/user/data/file.txt\"));客户端通过DistributedFileSystem.open()方法创建DFSInputStream对象。

步骤2:向NameNode请求文件元数据

Client -> NameNode: getBlockLocations(filename, start, length)交互详情:

- 客户端发送RPC请求到NameNode

- 请求参数包括:文件路径、读取起始位置、读取长度

- NameNode检查文件权限和存在性

步骤3:NameNode返回块位置信息

NameNode -> Client: LocatedBlocks返回信息包括:

- 文件对应的所有数据块列表

- 每个数据块的副本位置(DataNode地址列表)

- 块的大小和校验和信息

步骤4:客户端选择最近的DataNode

// 客户端选择策略private DatanodeInfo chooseDataNode(LocatedBlock block) { DatanodeInfo[] nodes = block.getLocations(); // 选择网络距离最近的DataNode return getBestNode(nodes);}选择策略:

- 优先选择本地DataNode(同一节点)

- 选择同机架的DataNode

- 选择其他机架的DataNode

步骤5:从DataNode读取数据

Client -> DataNode: readBlock(blockId, offset, length)DataNode -> Client: block data + checksum读取过程:

- 建立与DataNode的TCP连接

- 发送读块请求

- DataNode验证块的完整性

- 返回数据和校验和

步骤6:客户端验证和处理数据

// 校验和验证private void verifyChecksum(byte[] data, byte[] checksum) { // 计算数据的校验和 byte[] computedChecksum = computeChecksum(data); // 与DataNode返回的校验和比较 if (!Arrays.equals(computedChecksum, checksum)) { // 校验失败,尝试其他副本 tryNextReplica(); }}2.3 读操作中的关键优化

2.3.1 预读机制

// DFSClient中的预读缓冲private void readAhead() { if (readBuffer.remaining() < readAheadLength) { // 异步预读下一个块 asyncReadNextBlock(); }}2.3.2 块缓存

客户端会缓存最近访问的块位置信息,减少与NameNode的交互。

2.3.3 故障切换

如果某个DataNode读取失败,客户端会自动切换到其他副本。

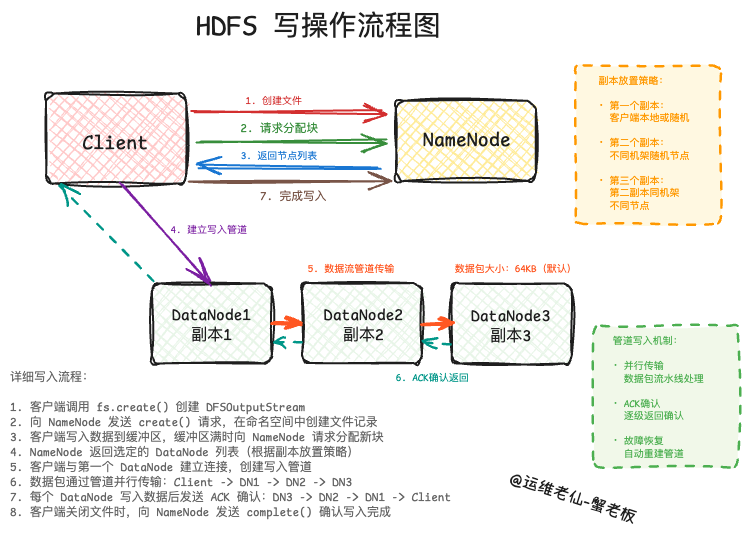

3. HDFS写操作详解

3.1 写操作整体流程

3.2 详细写流程分析

步骤1:客户端发起写请求

// 客户端写入代码FileSystem fs = FileSystem.get(conf);FSDataOutputStream outputStream = fs.create(new Path(\"/user/data/output.txt\"));步骤2:向NameNode请求创建文件

Client -> NameNode: create(filename, permissions, replication, blockSize)NameNode处理:

- 检查文件是否已存在

- 验证父目录权限

- 在文件系统命名空间中创建文件记录

- 返回创建成功确认

步骤3:客户端写入数据到缓冲区

// DFSOutputStream内部缓冲机制private void writeToBuffer(byte[] data) { dataQueue.addLast(new Packet(data)); if (dataQueue.size() >= maxPacketsInFlight) { flushBuffer(); // 触发实际写入 }}步骤4:请求分配新的数据块

当缓冲区满或显式刷新时:

Client -> NameNode: addBlock(filename)NameNode响应:

- 选择存储该块的DataNode列表

- 返回

LocatedBlock对象,包含块ID和DataNode位置

步骤5:建立DataNode写入管道

Client -> DataNode1 -> DataNode2 -> DataNode3管道建立过程:

// 建立写入管道private void setupPipeline(DatanodeInfo[] nodes, StorageType[] storageTypes) { // 连接第一个DataNode Socket socket = new Socket(nodes[0].getIpAddr(), nodes[0].getXferPort()); // 发送写入请求,包含整个管道信息 DataTransferProtocol.Sender sender = new DataTransferProtocol.Sender(socket); sender.writeBlock(blockId, blockToken, nodes, storageTypes, 0, 0, 0, checksum);}步骤6:数据流通过管道写入

Client -> DataNode1: packet1DataNode1 -> DataNode2: packet1DataNode2 -> DataNode3: packet1DataNode3 -> DataNode2: ack1DataNode2 -> DataNode1: ack1 DataNode1 -> Client: ack1数据包处理:

- 每个数据包包含64KB数据(默认)

- DataNode收到数据包后立即转发给下游

- 同时将数据写入本地磁盘

- 写入完成后发送ACK确认

步骤7:处理写入确认

// 确认队列管理private void processAcks() { while (!ackQueue.isEmpty()) { Packet packet = ackQueue.removeFirst(); if (packet.acked) { // 包已确认,可以释放内存 packet.release(); } else { // 包未确认,可能需要重传 handleFailure(packet); } }}步骤8:关闭文件和最终确认

// 文件关闭流程public void close() { flushBuffer(); // 刷新剩余数据 // 向NameNode确认文件写入完成 namenode.complete(filename, clientName, lastBlock, fileId);}3.3 写操作中的关键机制

3.3.1 数据包管道

- 并行写入:数据包在管道中并行传输

- 流水线处理:提高写入吞吐量

- 确认机制:保证数据完整性

3.3.2 副本放置策略

// 默认副本放置策略private DatanodeInfo[] chooseTargets(int replicationFactor) { List<DatanodeInfo> targets = new ArrayList<>(); // 第一个副本:客户端所在节点或随机节点 targets.add(chooseLocalNode()); // 第二个副本:不同机架的随机节点 targets.add(chooseRemoteRack()); // 第三个副本:第二个副本同机架的不同节点 targets.add(chooseSameRackAsSecond()); return targets.toArray(new DatanodeInfo[0]);}3.3.3 故障恢复机制

// 管道故障处理private void handlePipelineFailure(IOException e) { // 移除失败的DataNode removeFailedDatanode(); // 重建管道 setupNewPipeline(); // 重传未确认的数据包 retransmitPackets();}4. 组件交互关系深度分析

4.1 读操作中的组件交互

NameNode与Client的交互

#mermaid-svg-yv3MdYICROdCZaIJ {font-family:\"trebuchet ms\",verdana,arial,sans-serif;font-size:16px;fill:#333;}#mermaid-svg-yv3MdYICROdCZaIJ .error-icon{fill:#552222;}#mermaid-svg-yv3MdYICROdCZaIJ .error-text{fill:#552222;stroke:#552222;}#mermaid-svg-yv3MdYICROdCZaIJ .edge-thickness-normal{stroke-width:2px;}#mermaid-svg-yv3MdYICROdCZaIJ .edge-thickness-thick{stroke-width:3.5px;}#mermaid-svg-yv3MdYICROdCZaIJ .edge-pattern-solid{stroke-dasharray:0;}#mermaid-svg-yv3MdYICROdCZaIJ .edge-pattern-dashed{stroke-dasharray:3;}#mermaid-svg-yv3MdYICROdCZaIJ .edge-pattern-dotted{stroke-dasharray:2;}#mermaid-svg-yv3MdYICROdCZaIJ .marker{fill:#333333;stroke:#333333;}#mermaid-svg-yv3MdYICROdCZaIJ .marker.cross{stroke:#333333;}#mermaid-svg-yv3MdYICROdCZaIJ svg{font-family:\"trebuchet ms\",verdana,arial,sans-serif;font-size:16px;}#mermaid-svg-yv3MdYICROdCZaIJ .actor{stroke:hsl(259.6261682243, 59.7765363128%, 87.9019607843%);fill:#ECECFF;}#mermaid-svg-yv3MdYICROdCZaIJ text.actor>tspan{fill:black;stroke:none;}#mermaid-svg-yv3MdYICROdCZaIJ .actor-line{stroke:grey;}#mermaid-svg-yv3MdYICROdCZaIJ .messageLine0{stroke-width:1.5;stroke-dasharray:none;stroke:#333;}#mermaid-svg-yv3MdYICROdCZaIJ .messageLine1{stroke-width:1.5;stroke-dasharray:2,2;stroke:#333;}#mermaid-svg-yv3MdYICROdCZaIJ #arrowhead path{fill:#333;stroke:#333;}#mermaid-svg-yv3MdYICROdCZaIJ .sequenceNumber{fill:white;}#mermaid-svg-yv3MdYICROdCZaIJ #sequencenumber{fill:#333;}#mermaid-svg-yv3MdYICROdCZaIJ #crosshead path{fill:#333;stroke:#333;}#mermaid-svg-yv3MdYICROdCZaIJ .messageText{fill:#333;stroke:#333;}#mermaid-svg-yv3MdYICROdCZaIJ .labelBox{stroke:hsl(259.6261682243, 59.7765363128%, 87.9019607843%);fill:#ECECFF;}#mermaid-svg-yv3MdYICROdCZaIJ .labelText,#mermaid-svg-yv3MdYICROdCZaIJ .labelText>tspan{fill:black;stroke:none;}#mermaid-svg-yv3MdYICROdCZaIJ .loopText,#mermaid-svg-yv3MdYICROdCZaIJ .loopText>tspan{fill:black;stroke:none;}#mermaid-svg-yv3MdYICROdCZaIJ .loopLine{stroke-width:2px;stroke-dasharray:2,2;stroke:hsl(259.6261682243, 59.7765363128%, 87.9019607843%);fill:hsl(259.6261682243, 59.7765363128%, 87.9019607843%);}#mermaid-svg-yv3MdYICROdCZaIJ .note{stroke:#aaaa33;fill:#fff5ad;}#mermaid-svg-yv3MdYICROdCZaIJ .noteText,#mermaid-svg-yv3MdYICROdCZaIJ .noteText>tspan{fill:black;stroke:none;}#mermaid-svg-yv3MdYICROdCZaIJ .activation0{fill:#f4f4f4;stroke:#666;}#mermaid-svg-yv3MdYICROdCZaIJ .activation1{fill:#f4f4f4;stroke:#666;}#mermaid-svg-yv3MdYICROdCZaIJ .activation2{fill:#f4f4f4;stroke:#666;}#mermaid-svg-yv3MdYICROdCZaIJ .actorPopupMenu{position:absolute;}#mermaid-svg-yv3MdYICROdCZaIJ .actorPopupMenuPanel{position:absolute;fill:#ECECFF;box-shadow:0px 8px 16px 0px rgba(0,0,0,0.2);filter:drop-shadow(3px 5px 2px rgb(0 0 0 / 0.4));}#mermaid-svg-yv3MdYICROdCZaIJ .actor-man line{stroke:hsl(259.6261682243, 59.7765363128%, 87.9019607843%);fill:#ECECFF;}#mermaid-svg-yv3MdYICROdCZaIJ .actor-man circle,#mermaid-svg-yv3MdYICROdCZaIJ line{stroke:hsl(259.6261682243, 59.7765363128%, 87.9019607843%);fill:#ECECFF;stroke-width:2px;}#mermaid-svg-yv3MdYICROdCZaIJ :root{--mermaid-font-family:\"trebuchet ms\",verdana,arial,sans-serif;}ClientNameNodegetBlockLocations()LocatedBlocks检查权限\\n查找块位置\\n返回副本信息ClientNameNode

关键点:

- NameNode不参与实际数据传输

- 提供元数据服务,支持客户端定位数据

- 维护文件到块的映射关系

DataNode与Client的交互

#mermaid-svg-mhvywAGhy3CUnoAj {font-family:\"trebuchet ms\",verdana,arial,sans-serif;font-size:16px;fill:#333;}#mermaid-svg-mhvywAGhy3CUnoAj .error-icon{fill:#552222;}#mermaid-svg-mhvywAGhy3CUnoAj .error-text{fill:#552222;stroke:#552222;}#mermaid-svg-mhvywAGhy3CUnoAj .edge-thickness-normal{stroke-width:2px;}#mermaid-svg-mhvywAGhy3CUnoAj .edge-thickness-thick{stroke-width:3.5px;}#mermaid-svg-mhvywAGhy3CUnoAj .edge-pattern-solid{stroke-dasharray:0;}#mermaid-svg-mhvywAGhy3CUnoAj .edge-pattern-dashed{stroke-dasharray:3;}#mermaid-svg-mhvywAGhy3CUnoAj .edge-pattern-dotted{stroke-dasharray:2;}#mermaid-svg-mhvywAGhy3CUnoAj .marker{fill:#333333;stroke:#333333;}#mermaid-svg-mhvywAGhy3CUnoAj .marker.cross{stroke:#333333;}#mermaid-svg-mhvywAGhy3CUnoAj svg{font-family:\"trebuchet ms\",verdana,arial,sans-serif;font-size:16px;}#mermaid-svg-mhvywAGhy3CUnoAj .actor{stroke:hsl(259.6261682243, 59.7765363128%, 87.9019607843%);fill:#ECECFF;}#mermaid-svg-mhvywAGhy3CUnoAj text.actor>tspan{fill:black;stroke:none;}#mermaid-svg-mhvywAGhy3CUnoAj .actor-line{stroke:grey;}#mermaid-svg-mhvywAGhy3CUnoAj .messageLine0{stroke-width:1.5;stroke-dasharray:none;stroke:#333;}#mermaid-svg-mhvywAGhy3CUnoAj .messageLine1{stroke-width:1.5;stroke-dasharray:2,2;stroke:#333;}#mermaid-svg-mhvywAGhy3CUnoAj #arrowhead path{fill:#333;stroke:#333;}#mermaid-svg-mhvywAGhy3CUnoAj .sequenceNumber{fill:white;}#mermaid-svg-mhvywAGhy3CUnoAj #sequencenumber{fill:#333;}#mermaid-svg-mhvywAGhy3CUnoAj #crosshead path{fill:#333;stroke:#333;}#mermaid-svg-mhvywAGhy3CUnoAj .messageText{fill:#333;stroke:#333;}#mermaid-svg-mhvywAGhy3CUnoAj .labelBox{stroke:hsl(259.6261682243, 59.7765363128%, 87.9019607843%);fill:#ECECFF;}#mermaid-svg-mhvywAGhy3CUnoAj .labelText,#mermaid-svg-mhvywAGhy3CUnoAj .labelText>tspan{fill:black;stroke:none;}#mermaid-svg-mhvywAGhy3CUnoAj .loopText,#mermaid-svg-mhvywAGhy3CUnoAj .loopText>tspan{fill:black;stroke:none;}#mermaid-svg-mhvywAGhy3CUnoAj .loopLine{stroke-width:2px;stroke-dasharray:2,2;stroke:hsl(259.6261682243, 59.7765363128%, 87.9019607843%);fill:hsl(259.6261682243, 59.7765363128%, 87.9019607843%);}#mermaid-svg-mhvywAGhy3CUnoAj .note{stroke:#aaaa33;fill:#fff5ad;}#mermaid-svg-mhvywAGhy3CUnoAj .noteText,#mermaid-svg-mhvywAGhy3CUnoAj .noteText>tspan{fill:black;stroke:none;}#mermaid-svg-mhvywAGhy3CUnoAj .activation0{fill:#f4f4f4;stroke:#666;}#mermaid-svg-mhvywAGhy3CUnoAj .activation1{fill:#f4f4f4;stroke:#666;}#mermaid-svg-mhvywAGhy3CUnoAj .activation2{fill:#f4f4f4;stroke:#666;}#mermaid-svg-mhvywAGhy3CUnoAj .actorPopupMenu{position:absolute;}#mermaid-svg-mhvywAGhy3CUnoAj .actorPopupMenuPanel{position:absolute;fill:#ECECFF;box-shadow:0px 8px 16px 0px rgba(0,0,0,0.2);filter:drop-shadow(3px 5px 2px rgb(0 0 0 / 0.4));}#mermaid-svg-mhvywAGhy3CUnoAj .actor-man line{stroke:hsl(259.6261682243, 59.7765363128%, 87.9019607843%);fill:#ECECFF;}#mermaid-svg-mhvywAGhy3CUnoAj .actor-man circle,#mermaid-svg-mhvywAGhy3CUnoAj line{stroke:hsl(259.6261682243, 59.7765363128%, 87.9019607843%);fill:#ECECFF;stroke-width:2px;}#mermaid-svg-mhvywAGhy3CUnoAj :root{--mermaid-font-family:\"trebuchet ms\",verdana,arial,sans-serif;}ClientDataNode建立连接readBlock(blockId)数据块 + 校验和验证块完整性\\n读取本地数据\\n计算校验和ClientDataNode

4.2 写操作中的组件交互

三方协调机制

#mermaid-svg-kxx8Pvl4whS4eT6b {font-family:\"trebuchet ms\",verdana,arial,sans-serif;font-size:16px;fill:#333;}#mermaid-svg-kxx8Pvl4whS4eT6b .error-icon{fill:#552222;}#mermaid-svg-kxx8Pvl4whS4eT6b .error-text{fill:#552222;stroke:#552222;}#mermaid-svg-kxx8Pvl4whS4eT6b .edge-thickness-normal{stroke-width:2px;}#mermaid-svg-kxx8Pvl4whS4eT6b .edge-thickness-thick{stroke-width:3.5px;}#mermaid-svg-kxx8Pvl4whS4eT6b .edge-pattern-solid{stroke-dasharray:0;}#mermaid-svg-kxx8Pvl4whS4eT6b .edge-pattern-dashed{stroke-dasharray:3;}#mermaid-svg-kxx8Pvl4whS4eT6b .edge-pattern-dotted{stroke-dasharray:2;}#mermaid-svg-kxx8Pvl4whS4eT6b .marker{fill:#333333;stroke:#333333;}#mermaid-svg-kxx8Pvl4whS4eT6b .marker.cross{stroke:#333333;}#mermaid-svg-kxx8Pvl4whS4eT6b svg{font-family:\"trebuchet ms\",verdana,arial,sans-serif;font-size:16px;}#mermaid-svg-kxx8Pvl4whS4eT6b .actor{stroke:hsl(259.6261682243, 59.7765363128%, 87.9019607843%);fill:#ECECFF;}#mermaid-svg-kxx8Pvl4whS4eT6b text.actor>tspan{fill:black;stroke:none;}#mermaid-svg-kxx8Pvl4whS4eT6b .actor-line{stroke:grey;}#mermaid-svg-kxx8Pvl4whS4eT6b .messageLine0{stroke-width:1.5;stroke-dasharray:none;stroke:#333;}#mermaid-svg-kxx8Pvl4whS4eT6b .messageLine1{stroke-width:1.5;stroke-dasharray:2,2;stroke:#333;}#mermaid-svg-kxx8Pvl4whS4eT6b #arrowhead path{fill:#333;stroke:#333;}#mermaid-svg-kxx8Pvl4whS4eT6b .sequenceNumber{fill:white;}#mermaid-svg-kxx8Pvl4whS4eT6b #sequencenumber{fill:#333;}#mermaid-svg-kxx8Pvl4whS4eT6b #crosshead path{fill:#333;stroke:#333;}#mermaid-svg-kxx8Pvl4whS4eT6b .messageText{fill:#333;stroke:#333;}#mermaid-svg-kxx8Pvl4whS4eT6b .labelBox{stroke:hsl(259.6261682243, 59.7765363128%, 87.9019607843%);fill:#ECECFF;}#mermaid-svg-kxx8Pvl4whS4eT6b .labelText,#mermaid-svg-kxx8Pvl4whS4eT6b .labelText>tspan{fill:black;stroke:none;}#mermaid-svg-kxx8Pvl4whS4eT6b .loopText,#mermaid-svg-kxx8Pvl4whS4eT6b .loopText>tspan{fill:black;stroke:none;}#mermaid-svg-kxx8Pvl4whS4eT6b .loopLine{stroke-width:2px;stroke-dasharray:2,2;stroke:hsl(259.6261682243, 59.7765363128%, 87.9019607843%);fill:hsl(259.6261682243, 59.7765363128%, 87.9019607843%);}#mermaid-svg-kxx8Pvl4whS4eT6b .note{stroke:#aaaa33;fill:#fff5ad;}#mermaid-svg-kxx8Pvl4whS4eT6b .noteText,#mermaid-svg-kxx8Pvl4whS4eT6b .noteText>tspan{fill:black;stroke:none;}#mermaid-svg-kxx8Pvl4whS4eT6b .activation0{fill:#f4f4f4;stroke:#666;}#mermaid-svg-kxx8Pvl4whS4eT6b .activation1{fill:#f4f4f4;stroke:#666;}#mermaid-svg-kxx8Pvl4whS4eT6b .activation2{fill:#f4f4f4;stroke:#666;}#mermaid-svg-kxx8Pvl4whS4eT6b .actorPopupMenu{position:absolute;}#mermaid-svg-kxx8Pvl4whS4eT6b .actorPopupMenuPanel{position:absolute;fill:#ECECFF;box-shadow:0px 8px 16px 0px rgba(0,0,0,0.2);filter:drop-shadow(3px 5px 2px rgb(0 0 0 / 0.4));}#mermaid-svg-kxx8Pvl4whS4eT6b .actor-man line{stroke:hsl(259.6261682243, 59.7765363128%, 87.9019607843%);fill:#ECECFF;}#mermaid-svg-kxx8Pvl4whS4eT6b .actor-man circle,#mermaid-svg-kxx8Pvl4whS4eT6b line{stroke:hsl(259.6261682243, 59.7765363128%, 87.9019607843%);fill:#ECECFF;stroke-width:2px;}#mermaid-svg-kxx8Pvl4whS4eT6b :root{--mermaid-font-family:\"trebuchet ms\",verdana,arial,sans-serif;}ClientNameNodeDataNode1DataNode2DataNode3create() / addBlock()分配DataNode列表建立写入管道转发建立请求转发建立请求确认建立确认建立管道建立成功ClientNameNodeDataNode1DataNode2DataNode3

4.3 心跳和块报告机制

DataNode到NameNode的周期性通信

// DataNode心跳发送public HeartbeatResponse sendHeartbeat() { HeartbeatResponse response = namenode.sendHeartbeat( datanodeRegistration, storageReports, cacheCapacity, cacheUsed, xmitsInProgress, xceiverCount, failedVolumes.size() ); return response;}心跳信息包含:

- DataNode状态信息

- 存储使用情况

- 当前传输数量

- 失效卷数量

块报告机制

// 块报告发送public void blockReport() { StorageBlockReport[] reports = getBlockReports(); namenode.blockReport(datanodeRegistration, reports);}5. 常见问题与故障排查

5.1 读操作相关问题

5.1.1 读取性能慢

可能原因:

-

网络延迟高

- 表现:客户端与DataNode之间网络不稳定

- 排查:检查网络延迟

ping DataNode_IP - 解决:优化网络配置或调整副本放置策略

-

磁盘IO瓶颈

- 表现:DataNode磁盘使用率高

- 排查:

iostat -x 1查看磁盘使用情况 - 解决:增加磁盘或优化磁盘分布

-

数据倾斜

- 表现:某些DataNode访问频率过高

- 排查:查看DataNode负载分布

- 解决:重新平衡数据分布

排查工具和命令:

# 查看文件块分布hdfs fsck /path/to/file -files -blocks -locations# 查看DataNode状态hdfs dfsadmin -report# 监控读取性能hdfs dfsadmin -printTopology5.1.2 数据读取错误

可能原因:

-

块损坏

- 表现:校验和验证失败

- 排查:检查DataNode日志中的校验和错误

- 解决:HDFS会自动从其他副本读取

-

副本不足

- 表现:所有副本都不可用

- 排查:

hdfs fsck -list-corruptfileblocks - 解决:从备份恢复或重新生成数据

故障排查示例:

# 检查文件完整性hdfs fsck /user/data/file.txt -files -blocks# 查看损坏的块hdfs fsck / -list-corruptfileblocks# 强制删除损坏的文件hdfs fsck / -delete5.2 写操作相关问题

5.2.1 写入性能慢

可能原因:

-

管道建立失败

- 表现:频繁重建写入管道

- 排查:查看客户端日志中的管道重建信息

- 解决:检查DataNode健康状态

-

磁盘空间不足

- 表现:写入过程中DataNode失败

- 排查:

df -h检查DataNode磁盘空间 - 解决:清理磁盘空间或添加存储

-

网络带宽不足

- 表现:数据传输缓慢

- 排查:网络监控工具查看带宽使用

- 解决:优化网络配置或分散写入负载

性能调优参数:

<configuration> <property> <name>dfs.client.write.packet.size</name> <value>131072</value> </property> <property> <name>dfs.client.write.max-packets-in-flight</name> <value>80</value> </property> <property> <name>dfs.blocksize</name> <value>268435456</value> </property></configuration>5.2.2 写入失败和数据丢失

可能原因:

-

管道故障

- 表现:写入过程中管道断开

- 排查:客户端和DataNode日志

- 解决:自动重建管道,重传数据

-

NameNode故障

- 表现:无法分配新块或完成文件

- 排查:NameNode日志和状态

- 解决:NameNode高可用切换

故障恢复机制:

// 租约恢复机制public void recoverLease(String filename) { // NameNode检查文件租约状态 if (isLeaseExpired(filename)) { // 执行块恢复 recoverBlocks(filename); // 重新分配租约 assignLease(filename, newClient); }}5.3 系统级故障排查

5.3.1 监控和诊断工具

1. HDFS Web UI

- NameNode Web界面:

http://namenode:9870 - 查看集群状态、块信息、DataNode健康状态

2. 命令行工具

# 集群健康检查hdfs dfsadmin -report# 安全模式管理hdfs dfsadmin -safemode gethdfs dfsadmin -safemode leave# 文件系统检查hdfs fsck / -files -blocks -locations# 负载均衡hdfs balancer -threshold 103. 日志分析

# NameNode日志tail -f $HADOOP_HOME/logs/hadoop-namenode-*.log# DataNode日志tail -f $HADOOP_HOME/logs/hadoop-datanode-*.log# 客户端日志tail -f $HADOOP_HOME/logs/hadoop-client-*.log5.3.2 性能监控指标

关键指标:

-

吞吐量指标

- 读写速度(MB/s)

- IOPS(每秒操作数)

- 延迟(响应时间)

-

资源使用指标

- CPU使用率

- 内存使用率

- 磁盘使用率

- 网络带宽使用

-

HDFS特定指标

- 块副本数量

- 损坏块数量

- DataNode活跃数量

- 安全模式状态

监控脚本示例:

#!/bin/bash# HDFS健康检查脚本echo \"=== HDFS集群状态 ===\"hdfs dfsadmin -report | grep -E \"Live datanodes|Dead datanodes|Decommissioning datanodes\"echo \"=== 文件系统使用情况 ===\"hdfs dfs -df -h /echo \"=== 损坏块检查 ===\"hdfs fsck / -list-corruptfileblocks | wc -lecho \"=== 副本不足的块 ===\"hdfs fsck / | grep \"Under replicated blocks\"6. 最佳实践和优化建议

6.1 读操作优化

-

客户端优化

// 调整读取缓冲区大小conf.setInt(\"io.file.buffer.size\", 131072); // 128KB// 启用短路读取conf.setBoolean(\"dfs.client.read.shortcircuit\", true); -

数据本地性优化

- 确保计算任务运行在数据所在节点

- 使用Hadoop的机架感知功能

6.2 写操作优化

-

批量写入

// 使用更大的缓冲区FSDataOutputStream out = fs.create(path, true, 1048576); // 1MB buffer -

合理设置副本数

# 根据重要性设置不同的副本数hdfs dfs -setrep 2 /user/temp/ # 临时数据hdfs dfs -setrep 3 /user/important/ # 重要数据

6.3 系统调优

-

JVM参数优化

# NameNode JVM参数export HADOOP_NAMENODE_OPTS=\"-Xmx8g -XX:+UseG1GC -XX:MaxGCPauseMillis=200\"# DataNode JVM参数 export HADOOP_DATANODE_OPTS=\"-Xmx4g -XX:+UseParallelGC\" -

操作系统优化

# 调整文件描述符限制echo \"* soft nofile 65536\" >> /etc/security/limits.confecho \"* hard nofile 65536\" >> /etc/security/limits.conf# 优化网络参数echo \"net.core.rmem_max = 134217728\" >> /etc/sysctl.confecho \"net.core.wmem_max = 134217728\" >> /etc/sysctl.conf

总结

HDFS的读写机制通过精心设计的组件协作,实现了高吞吐量、高可靠性的分布式存储。理解这些原理不仅有助于系统优化,更重要的是能够在出现问题时快速定位和解决。

关键要点:

- 读操作注重数据本地性和故障切换

- 写操作通过管道机制实现高效的数据复制

- 组件交互遵循职责分离原则,NameNode负责元数据,DataNode负责数据存储

- 故障排查需要结合日志分析、监控指标和系统工具

- 性能优化需要从客户端、集群配置和系统层面综合考虑

掌握这些原理和方法,能够帮助我们更好地运维和优化HDFS集群,确保大数据平台的稳定运行。