嵌入式AI?

就当做嵌入式的一个外设来看待就行了。

什么是嵌入式AI

嵌入式 AI(Embedded AI)是指将人工智能技术与算法集成到嵌入式系统中,使设备能够在本地(无需依赖云端服务器)实现数据处理、分析和决策的技术形态。它融合了嵌入式系统的实时性、低功耗特性与AI 的智能化能力,让传统硬件设备具备 “边端智能”,适用于对响应速度、隐私保护、网络依赖性要求高的场景。

核心特点

本地化运行

无需联网即可完成数据处理和决策,避免网络延迟和断网风险(如自动驾驶汽车在隧道中实时避障)。

保护用户隐私:敏感数据(如人脸、医疗信息)无需上传云端,直接在设备端处理。

低功耗与轻量化

受限于嵌入式设备的算力和电池容量(如智能手环、智能家居设备),需对 AI 模型进行压缩优化(如模型剪枝、量化、知识蒸馏),使其适配低功耗芯片(如 ARM 处理器、NPU 神经处理单元)。

实时性与可靠性

适用于对延迟敏感的场景(如工业机器人实时抓取、智能摄像头动态追踪),要求算法响应时间在毫秒级。

技术架构与关键组件

1. 硬件层

嵌入式处理器:

传统 MCU(微控制器,如 STM32):算力较低,适合简单 AI 任务(如传感器数据分类);

异构计算芯片:

CPU+GPU(如 NVIDIA Jetson 系列):适合中高算力需求(如图像处理);

CPU+NPU(如华为海思麒麟芯片):专为 AI 设计的神经处理单元,高效处理矩阵运算。

传感器:摄像头、麦克风、加速度计等,为 AI 模型提供输入数据(如视觉识别、语音唤醒)。

2. 软件层

AI 框架与工具链:

轻量化框架:TensorFlow Lite、PyTorch Mobile、ONNX Runtime,用于模型部署和推理;

模型优化工具:量化(将浮点运算转为定点运算)、剪枝(删除冗余神经元)、蒸馏(用小模型学习大模型知识)。

实时操作系统(RTOS):如 FreeRTOS、QNX,确保 AI 任务与设备控制任务的调度协同。

3. 算法层

适配嵌入式场景的 AI 算法:

计算机视觉:轻量化 CNN(如 MobileNet、ShuffleNet)用于目标检测、人脸识别;

语音处理:Keyword Spotting(关键词检测)、语音命令识别(如 “开灯”),模型参数量可压缩至数百 KB;

传感器融合:结合多传感器数据(如摄像头 + IMU),通过卡尔曼滤波等算法提升决策可靠性。

典型应用场景

1. 智能硬件与消费电子

智能家居:智能音箱本地语音唤醒(无需联网即可响应 “小爱同学”);智能门锁实时人脸识别开锁。

可穿戴设备:智能手表通过心率数据本地分析异常心跳(如房颤预警),减少云端数据传输。

2. 工业与智能制造

智能质检:嵌入式视觉系统在生产线上实时检测产品缺陷(如电路板焊点不良),替代人工目检。

工业机器人:机械臂通过本地 AI 算法动态避障(如识别工人靠近时减速),提升协作安全性。

3. 汽车与自动驾驶

车载 AI:ADAS(高级驾驶辅助系统)本地处理摄像头数据,实现车道偏离预警、行人检测;

智能座舱:驾驶员疲劳监测(通过摄像头分析眨眼频率)、手势控制空调调节,响应时间 < 100ms。

4. 医疗与健康

便携式医疗设备:血糖仪通过图像识别本地分析试纸结果,避免数据泄露;

手术机器人:嵌入式 AI 实时计算手术器械位置,辅助医生精准操作。

挑战与未来趋势

挑战

算力与能效平衡:如何在低功耗芯片上运行复杂 AI 模型(如 Transformer),需依赖存算一体架构、神经形态芯片等新技术。

模型压缩与适配:不同设备硬件差异大,需自动化工具链实现 “一次训练,多端部署”。

实时性与安全性冲突:本地化计算需兼顾数据加密(如联邦学习在嵌入式场景的应用)。

未来趋势

边缘 - 云端协同:简单任务本地处理,复杂任务调用云端算力(如智能家居通过边缘网关分担服务器压力)。

自监督学习与在线学习:设备在运行中自动更新模型(如智能摄像头通过新场景数据持续优化识别能力)。

专用硬件创新:类脑芯片(如 Intel Loihi)模拟神经元工作机制,进一步降低 AI 推理功耗。

总结

嵌入式 AI 让设备从 “被动执行指令” 升级为 “主动感知决策”,是 AI 技术从云端走向物理世界的关键落地形态。随着硬件算力提升和算法优化,未来嵌入式 AI 将渗透到更多 “哑设备”,推动 “万物智能” 时代的到来 —— 从耳机本地语音降噪,到工厂机器自主维护,嵌入式 AI 正重新定义人与设备的交互方式。

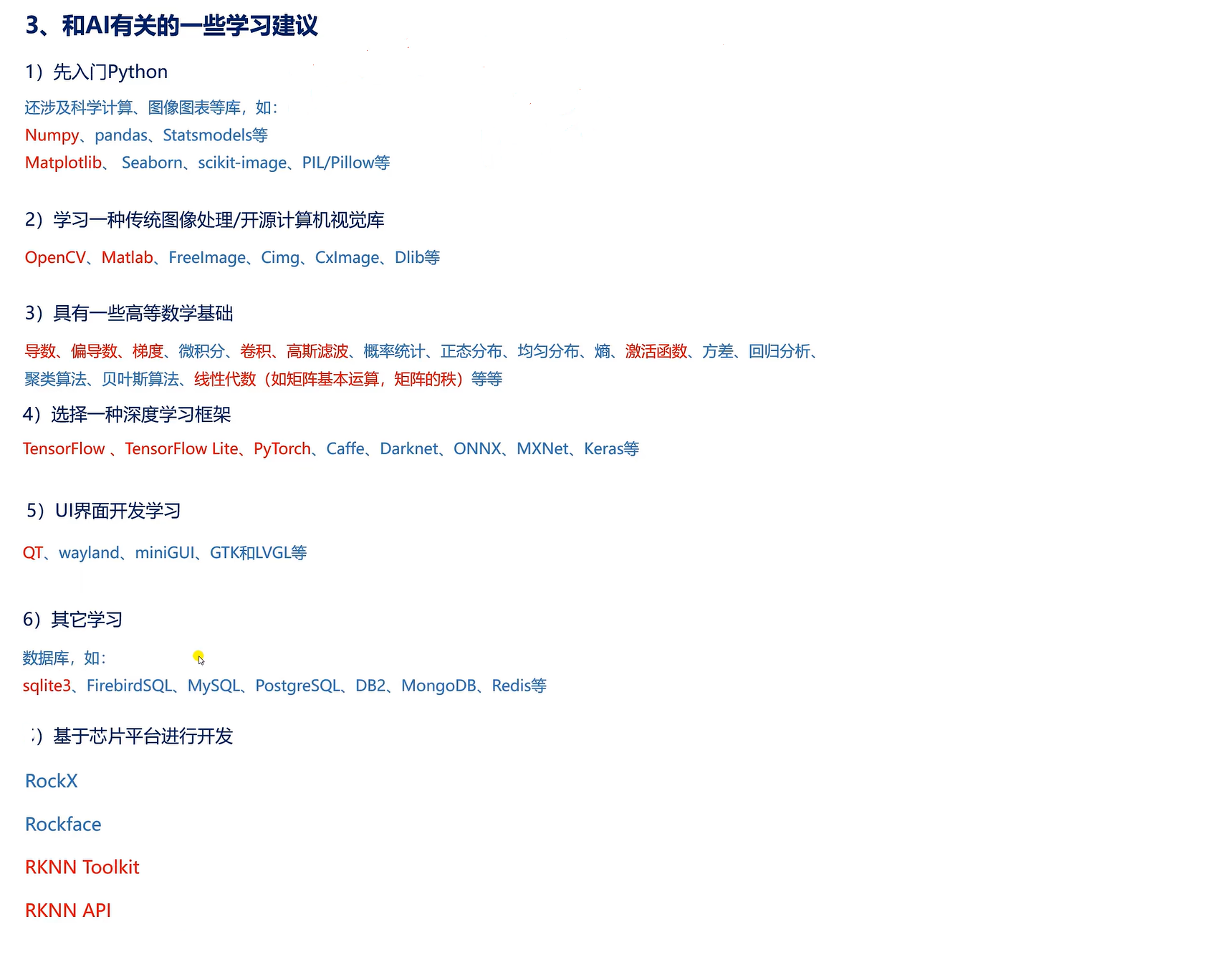

涉及到的技能

嵌入式结合AI需要掌握哪些AI方向的知识和技能?

嵌入式系统与 AI 的结合(如边缘 AI、智能物联网设备)需要在有限的计算资源(如 MCU、FPGA、边缘计算芯片)上实现 AI 模型的部署和运行,因此对 AI 知识的掌握需兼顾算法轻量化、硬件适配性和实时性。以下是需要重点掌握的 AI 方向知识和技能:

一、核心 AI 基础:轻量化模型与算法

1. 轻量级深度学习模型

目标:在低算力设备上运行 AI 任务,需平衡模型精度与计算量。

关键模型:

图像领域:MobileNet 系列(轻量级 CNN)、ShuffleNet、SqueezeNet;

自然语言处理(NLP):DistilBERT、ALBERT(BERT 轻量化版本)、T5 小型化模型;

语音处理:MobileNetV3-SSLD(语音识别)、EfficientNet-Lite(音频分类);

通用轻量化框架:TensorFlow Lite Micro、PyTorch Mobile、ONNX Runtime Lite。

技能要求:掌握模型压缩技术(如剪枝、量化、知识蒸馏),能将预训练模型转换为适合嵌入式的格式(如.tflite、.ptlite)。

2. 传统机器学习算法

适用场景:数据量小、实时性要求高的简单任务(如传感器数据分类)。

常用算法:

决策树、随机森林(用于状态预测);

隐马尔可夫模型(HMM,用于时序数据处理,如电机故障检测);

支持向量机(SVM,轻量级分类任务)。

优势:计算资源消耗低,无需大量数据训练,适合低端嵌入式设备(如 8 位 / 32 位 MCU)。

二、嵌入式 AI 开发全流程技能

3. 模型训练与部署流程

数据预处理:

针对嵌入式场景优化数据(如传感器噪声过滤、时序数据分帧);

掌握边缘设备数据采集工具(如 ROS 2、MQTT 协议)。

训练框架:

使用 PyTorch/TensorFlow 训练模型,结合 NVIDIA Jetson 等边缘开发平台调试;

熟悉迁移学习(Transfer Learning),利用预训练模型微调适配小数据集。

模型部署:

使用模型转换工具(如 TensorFlow Lite Converter、ONNX Optimizer)压缩模型;

优化内存占用和计算效率(如定点化量化、层融合)。

4. 嵌入式硬件与 AI 加速

硬件选型:

了解主流嵌入式 AI 芯片:

MCU 级:ARM Cortex-M 系列(带 DSP/NN 加速器,如 STM32H7)、RISC-V(如玄铁 C906);

边缘处理器:NVIDIA Jetson 系列(GPU+CPU)、高通 Hexagon(带 NPU)、地平线征程系列(BPU);

FPGA/ASIC:Xilinx Zynq(可编程逻辑 + AI 加速)、Intel Movidius(VPU)。

硬件加速技术:

掌握神经网络加速器(NPU)原理,利用厂商 SDK(如 NVIDIA CUDA、ARM CMSIS-NN)优化模型推理;

了解异构计算(CPU+GPU+FPGA 协同),分配任务到最合适的硬件单元。

三、领域特定技术:结合嵌入式场景

5. 计算机视觉(CV)在嵌入式中的应用

典型任务:目标检测(如 YOLOv5s/Tiny YOLO)、姿态估计、二维码识别;

技能要求:

掌握轻量级 CV 框架(如 OpenCV Lite、TensorFlow Lite for Vision);

优化图像预处理流程(如灰度化、直方图均衡化)以减少计算量;

结合硬件特性(如 FPGA 并行计算)加速卷积运算。

6. 传感器融合与时序数据处理

场景:智能设备通过多传感器(如 IMU、摄像头、雷达)感知环境,需融合数据并实时决策。

技术:

时序模型:LSTM、GRU(用于传感器信号预测,如设备故障预警);

融合算法:卡尔曼滤波、扩展卡尔曼滤波(EKF),用于多传感器数据校准;

端到端模型:如 Temporal Convolutional Network(TCN)处理时序数据。

7. 语音与自然语言处理(NLP)

轻量化语音任务:关键词检测(KWS,如 “唤醒词识别”)、简单指令识别;

技术栈:

语音预处理:梅尔频率倒谱系数(MFCC)、短时傅里叶变换(STFT);

轻量级模型:MobileNet-SSLD(语音识别)、Keyword Spotting 模型(如 TensorFlow Lite Micro 的 KWS 示例);

端侧语音唤醒:基于能量检测和隐马尔可夫模型(HMM)的低功耗方案。

四、系统级优化与工程实践

8. 实时操作系统(RTOS)与任务调度

要求:AI 推理需与嵌入式系统的实时任务(如电机控制、通信)协同运行。

技能:

掌握 RTOS(如 FreeRTOS、Zephyr)的任务优先级管理、内存分配;

优化 AI 任务的执行周期,避免抢占关键实时线程。

9. 功耗与能效优化

嵌入式限制:电池供电设备需严格控制 AI 模型的功耗。

方法:

模型量化(如 8 位 / 4 位权重)降低计算能耗;

动态推理:根据输入数据特性选择性激活模型层(如 Skip Connection);

利用硬件低功耗模式(如 ARM Cortex-M 的 Sleep 模式)在非推理阶段节能。

10. 调试与测试工具

模型调试:使用 Netron 可视化模型结构,通过 TensorFlow Lite Model Analyzer 分析层耗时;

嵌入式调试:借助 JTAG 调试器(如 OpenOCD)跟踪 AI 推理过程中的内存和寄存器状态;

性能测试:测量模型推理延迟(Latency)、吞吐量(Throughput),验证实时性要求。

五、延伸技能:跨领域知识融合

11. 边缘计算与云计算协同

混合架构:复杂 AI 任务(如大数据训练)在云端完成,轻量级推理在边缘设备执行;

通信协议:MQTT、CoAP(低功耗物联网协议),用于边缘设备与云端的数据交互。

12. 硬件开发基础

必备知识:嵌入式 C/C++ 编程、ARM 汇编基础、GPIO / 外设控制(如 SPI/I2C/UART);

可选技能:FPGA 开发(Verilog/VHDL),用于自定义 AI 加速器设计。

学习路径建议

入门阶段:

掌握 Python 机器学习基础(Scikit-learn),用 TensorFlow Lite 实现简单模型(如 MNIST 手写识别)在嵌入式开发板(如 Arduino Nano 33 BLE Sense)上的部署。

进阶阶段:

学习轻量级模型原理(如 MobileNet),使用 NVIDIA Jetson Nano 开发视觉应用(如实时目标检测);

研究 RTOS 与 AI 的集成(如 FreeRTOS + TensorFlow Lite Micro)。

实战项目:

开发智能传感器节点(如基于 STM32H7 的环境监测 + 异常检测);

设计低功耗语音唤醒设备(结合 KWS 模型与 Energy Detection)。

总结

嵌入式 AI 的核心挑战是在资源受限条件下实现高效推理,因此需深入理解轻量化模型、硬件加速和系统优化。建议从具体场景(如智能家电、工业物联网)入手,结合开源框架(如 Edge Impulse)和开发板(如 Raspberry Pi + Coral USB Accelerator)进行实践,逐步积累从模型训练到嵌入式部署的全流程经验。

算力的衡量单位和标准

算力是衡量计算设备处理数据能力的关键指标,其衡量单位和标准随着技术发展不断演进。以下从单位分类、技术标准、应用场景差异等维度展开解析:

一、算力的核心衡量单位:从基础运算到专用场景

1. 通用计算单位:基于时间的运算次数

FLOPS(每秒浮点运算次数)

定义:衡量处理器执行浮点运算的速度,是 AI 算力最常用单位。

细分类型:

- GFLOPS(10^9 FLOPS):如主流 CPU 算力约 100 GFLOPS。

- TFLOPS(10^12 FLOPS):NVIDIA A100 GPU 算力达 19.5 TFLOPS(FP32)。

- PFLOPS(10^15 FLOPS):超级计算机 “富岳” 算力达 442 PFLOPS。

- EFLOPS(10^18 FLOPS):未来 E 级超算目标算力(如美国 “极光” 超算计划达 1.5EFLOPS)。

OPS(每秒运算次数)

适用场景:整数运算为主的场景(如边缘设备推理)。

单位:TOPS(10^12 OPS),如骁龙 8 Gen3 的 NPU 算力约 200 TOPS。

2. AI 专用衡量单位:兼顾精度与效率

FLOPS/W(每瓦特浮点运算次数)

定义:衡量算力的能耗比,是 AI 芯片重要指标(如 TPU v4 的 FLOPS/W 达 30 TFLOPS/W,优于 GPU)。

参数量(Parameters)

用于描述模型规模,如 GPT-4 参数量超 1 万亿,参数量越大通常算力需求越高。

内存带宽(Memory Bandwidth)

单位:GB/s,影响数据传输效率(如 H100 GPU 带宽达 2 TB/s,避免 “算力浪费”)。

二、算力标准的技术维度:精度、并行度与架构差异

1. 计算精度标准:不同任务的精度需求

FP32(32 位浮点)

- 传统深度学习训练标准,精度高但算力消耗大(如 A100 的 FP32 算力 19.5 TFLOPS)。

FP16/BF16(16 位浮点)

- 半精度计算,算力翻倍(A100 的 BF16 算力达 312 TFLOPS),适用于大模型训练。

INT8/INT4(整数精度)

- 推理阶段常用,算力进一步提升(如 A100 的 INT8 算力达 624 TOPS),模型压缩后精度损失可接受。

2. 并行计算标准:硬件架构的算力释放

SIMD(单指令多数据)

- CPU 通过 AVX-512 指令集实现并行计算(如每秒处理 8 个 512 位数据)。

MIMD(多指令多数据)

- GPU/TPU 的核心架构,数千个计算单元同时执行不同任务(如 GPU 的 CUDA 核心数超 1 万个)。

三、不同场景的算力衡量差异:从超算到边缘设备

应用场景 典型算力单位 算力需求范围 核心指标 超算 / 大模型训练 PFLOPS 100 PFLOPS~1 EFLOPS 浮点精度、分布式并行能力 云端 AI 推理 TFLOPS/TOPS 10 TFLOPS~1 PFLOPS 吞吐量(每秒处理请求数) 自动驾驶 TOPS 200 TOPS~1000 TOPS 低延迟(<50ms)、可靠性 手机 / IoT 设备 TOPS/mTOPS(毫 TOPS) 1 mTOPS~200 TOPS 能耗比(TOPS/W)、体积 量子计算 量子比特数 + 门操作速度 数十至数百万量子比特 量子纠错能力、相干时间

四、算力标准的行业与国际规范

1. 国际超算排名标准

TOP500 榜单:以 Linpack 基准测试的 FP64 算力为排名依据(如 “富岳” 以 442 PFLOPS 位列榜首)。

Green500 榜单:关注 FLOPS/W 能耗比,推动绿色算力发展(如 2023 年榜首系统达 52.1 GFLOPS/W)。

2. AI 芯片行业标准

MLPerf 基准测试:覆盖训练与推理场景,测试不同芯片在 ResNet、BERT 等模型上的算力表现(如 NVIDIA H100 在 MLPerf 推理中达 2142 TOPS)。

SPEC 基准(SPECint/SPECFP):通用 CPU 算力测试标准,衡量整数与浮点运算性能(如 Intel i9-13900K 的 SPECFP 分数约 4000)。

五、未来算力衡量的趋势:从 “量” 到 “质” 的升级

1. 新型计算范式的单位创新

量子算力:以量子门操作次数(如每秒百万次门操作)和量子比特数衡量(如 IBM 量子处理器达 127 量子比特)。

存算一体算力:以 “比特 / 秒・焦耳”(bit/s・J)衡量数据处理效率,突破传统冯・诺依曼架构瓶颈。

2. 算力网络的标准化

跨设备算力调度需统一接口标准(如 OpenSHMEM、MPI),实现云端、边缘、终端算力的协同衡量(如总有效算力 = 云端 PFLOPS + 边缘 TOPS× 并发数)。

总结:算力单位是技术需求的 “镜像”

从 FLOPS 到 TOPS,从 FP32 到 INT4,算力衡量标准始终与硬件架构、算法需求、应用场景深度绑定。未来,随着量子计算、存算一体等技术成熟,算力衡量将更关注 “效率” 与 “协同”—— 不仅是 “算得多快”,更是 “如何用最少算力解决最复杂问题”。对于普通用户,理解算力单位有助于根据需求选择云服务器、AI 芯片等设备,而行业则需通过标准化测试推动算力技术的迭代。

NPU算力的计算方法

在人工智能领域,NPU(神经网络处理器)的算力是衡量其性能的核心指标,其计算方法与硬件架构、数据精度、指令集等因素密切相关。以下是关于 NPU 算力计算的详细解析:

一、NPU 算力的核心概念与单位

算力的定义 算力指 NPU 在单位时间内(如每秒)可执行的计算操作数量,通常用于衡量其处理神经网络模型的速度。

常用算力单位

TOPS(Tera Operations Per Second):每秒万亿次操作,适用于整数运算(如 INT8、INT16)。

FLOPS(Floating Point Operations Per Second):每秒浮点运算次数,适用于浮点运算(如 FP16、FP32)。

1 TOPS = 10^12 次操作 / 秒,1 TFLOPS = 10^12 次浮点运算 / 秒。

二、NPU 算力的计算逻辑

NPU 的算力计算需结合硬件架构中的计算单元数量、时钟频率及单周期计算能力,公式如下:

通用计算公式

算力 = 计算单元数量 × 单单元计算密度 × 时钟频率 × 数据并行度分场景详细说明

以矩阵乘法(NN 核心操作)为例 NPU 的算力常通过矩阵运算(如 GEMM,通用矩阵乘法)的理论峰值来衡量:

假设 NPU 包含 M 个矩阵运算单元,每个单元可在 1 周期内完成 A×B×C 次乘加运算(如 A=16,B=16,C=16)。

时钟频率为 F GHz(1 GHz = 10^9 周期 / 秒)。 则算力为:

算力(TOPS)= M × A × B × C × F × 10^9 / 10^12(注:若为浮点运算,单位转为 FLOPS)考虑数据精度的计算密度

INT8 量化:每个操作处理 8 位整数,单精度存储量小,算力峰值高(因相同硬件可并行处理更多数据)。

FP32 浮点:每个操作处理 32 位浮点数,计算精度高但算力峰值较低(硬件资源占用更多)。

三、典型 NPU 架构的算力计算示例

以常见的脉动阵列(Systolic Array)架构为例:

硬件参数

阵列规模:128×128 个计算单元(PE,Processing Element)。

每个 PE 单周期可完成 1 次 INT8 乘加运算(如计算 A×B+C)。

时钟频率:2 GHz。

算力计算

单周期总运算量:128×128×1 = 16,384 次 INT8 操作。

每秒运算量:16,384 × 2×10^9 = 32.768×10^12 次 / 秒 = 32.768 TOPS。

四、影响算力计算的关键因素

数据精度与算力的关系

低精度(如 INT8):硬件可并行处理更多数据,算力峰值高,但需考虑量化对模型精度的影响。

高精度(如 FP32):算力峰值低,但适合训练阶段或对精度敏感的推理任务。

架构设计与并行度

计算单元的并行度(如多核心、多芯片互联)直接影响算力上限。

内存带宽与数据调度效率:若数据无法及时供给计算单元,会导致算力利用率(实际算力 / 理论峰值)下降。

指令集与算子优化

专用指令集(如针对卷积、池化的优化指令)可提升特定操作的算力表现。

五、实际应用中的算力评估

理论峰值与实际性能的差异

理论算力是硬件的最大潜力,但实际应用中受模型结构(如稀疏性)、数据调度、系统开销等因素影响,实际算力通常为理论值的 30%~70%。

常用 benchmark 工具

MLPerf:行业标准基准测试,涵盖训练与推理场景,综合评估算力与能效。

TensorFlow Benchmark:针对 TensorFlow 框架的算子性能测试。

六、总结:NPU 算力计算的核心步骤

明确硬件参数:计算单元数量、时钟频率、单周期运算能力。

确定数据精度与运算类型(INT8/FP32 等)。

根据架构特点选择计算模型(如矩阵运算公式)。

结合实际场景评估算力利用率,而非仅依赖理论峰值。

通过以上方法,可系统性地量化 NPU 的算力表现,为硬件选型、模型优化提供数据支撑。

AI芯片和普通芯片有什么区别?

AI 芯片和普通芯片存在多方面的区别,具体如下:

设计目标:

AI 芯片:专为人工智能应用设计,目标是加速人工智能算法的计算过程,如神经网络推理、深度学习等,针对大规模、高复杂度数据集处理进行优化。

普通芯片:也叫通用芯片,设计用于实现特定的通用功能,如处理器、存储器、逻辑电路等,追求高度的通用性和灵活性,以适应不同应用场景。

架构设计:

AI 芯片:采用专门架构,如 GPU(图形处理单元)、TPU(张量处理单元)、NPU(神经网络处理器)等,在加速矩阵计算和深度学习模型方面表现出色。

普通芯片:主要是通用处理器,如 CPU(中央处理器),其架构注重指令执行的完整性和通用性,由控制器和运算器等组成,以顺序执行指令为主。

计算能力:

AI 芯片:通常具有更强大的计算能力,尤其是在处理大规模、高维度数据集时,能实现更高效、快速的计算。例如,在深度学习任务中,AI 芯片可以并行处理大量数据,大大提高训练和推理速度。

普通芯片:虽然也能进行各种计算,但在处理特定的 AI 任务时,计算能力相对较弱,尤其是面对大规模矩阵运算和复杂的神经网络模型时,性能可能无法满足需求。

并行处理能力:

AI 芯片:设计注重并行性,能够同时处理多个数据,可同时处理大量数据,在深度学习模型的训练和推理中能更高效地执行,加速计算过程。

普通芯片:在处理任务时通常采用串行处理方式,即逐步执行每个指令,对于一些通用计算任务效果不错,但处理大规模矩阵计算等 AI 相关工作负载时效率较低。

内存和存储:

AI 芯片:具有更高效的内存和存储机制,以便在处理大规模数据时实现更快的存取速度和更低的功耗,通常配备高带宽内存,以满足快速数据传输需求。

普通芯片:内存和存储设计主要考虑通用场景,在处理 AI 任务的大规模数据时,可能存在存取速度慢、功耗较高的问题。

算法优化:

AI 芯片:针对人工智能算法进行了硬件级别的优化,例如在芯片架构中集成专门的计算单元来加速特定的 AI 运算,如卷积神经网络中的卷积运算等,能在特定任务上实现更高性能和效率。

普通芯片:没有针对 AI 算法的专门硬件优化,执行 AI 算法时需要依靠软件层面的优化来提高性能,但效果相对有限。

能耗效率:

AI 芯片:通常具有更低的能耗,在实现高性能的同时降低设备的发热和功耗,通过优化架构和制程工艺,提高每瓦特的计算能力,以满足移动设备和数据中心等对能耗的要求。

普通芯片:由于通用处理器的设计目标是胜任各种任务,在特定的 AI 工作负载下可能显得相对低效,处理大量数据时功耗较高,能效比相对较低。

适用领域:

AI 芯片:主要用于人工智能应用领域,如图像识别、语音识别、自然语言处理、自动驾驶、智能安防等,在这些领域能发挥其强大的计算能力和高效的处理优势。

普通芯片:广泛应用于各种电子设备中,包括个人电脑、服务器、移动设备、家电等,用于执行常规的计算任务,如文字处理、网页浏览、游戏运行等。

总的来说,大部分 AI 芯片相对于传统芯片来说较为专用,其架构和设计更专注于高效执行特定的 AI 任务,这限制了它们的通用性,但有助于提供更好的性能。

NPU

参考:

NPU的概念理解,以及和CPU/GPU的区别解析。 - AlphaGeek - 博客园

NPU(Neural Processing Unit),即神经网络处理单元,是一种专门为神经网络计算任务设计的硬件加速器。NPU的设计目标是提高深度学习模型,尤其是在推理(Inference)过程中,运算的效率和速度。它在人工智能(AI)应用中发挥着至关重要的作用,尤其是在处理大量并行计算时,相较于传统的CPU和GPU有着明显的优势。

NPU的通俗解释

想象一下,CPU是你电脑的大脑,负责处理各种日常任务,而GPU则像是一个专门的计算专家,处理那些需要大量数学运算的图像和视频渲染工作。NPU的出现,实际上是为了应对AI应用中的深度学习任务,它像一个专门的“AI计算专家”,能够高效地处理深度神经网络所需的大量矩阵运算和并行计算。

传统的计算硬件(如CPU和GPU)虽然也能够处理神经网络,但并不是最优化的。因为神经网络处理的特点是大量的矩阵乘法、加法等操作,而这些操作对硬件有特殊的要求。NPU就是为了解决这个问题而专门设计的,它的架构可以高效地处理神经网络所需的大量浮点运算,从而提升AI推理速度。

举例说明

NPU在智能手机中的应用:许多现代智能手机,例如华为的麒麟芯片系列,都配备了NPU,用于加速AI应用。比如人脸识别、语音助手、图像增强等任务,都能通过NPU在手机中高效完成,而不会影响手机的日常使用体验。

NPU在自动驾驶中的应用:自动驾驶系统需要实时处理来自车辆传感器(如摄像头、雷达等)的大量数据,进行图像识别、物体检测等深度学习任务。NPU可以在车辆上本地执行这些AI推理任务,以保证高效、低延迟的实时响应。

CPU GPU NPU TPU的区别?

CPU、GPU、NPU、TPU 是不同类型的处理器,在设计目标、架构、性能特点和应用场景上差异显著。以下从多个维度展开对比分析:

一、核心定义与设计目标

类型 全称 设计目标 CPU(中央处理器) Central Processing Unit 通用计算,处理多任务调度、逻辑控制、复杂指令,适合顺序执行的通用型计算。 GPU(图形处理器) Graphics Processing Unit 并行处理大量重复计算(如图形渲染),优化浮点运算和并行数据处理能力。 NPU(神经网络处理器) Neural Processing Unit 专为神经网络(如深度学习)设计,优化矩阵运算、向量计算和张量操作。 TPU(张量处理单元) Tensor Processing Unit 谷歌定制的专用芯片,针对深度学习中的张量运算(如矩阵乘法)进行硬件加速。 二、架构与性能特点对比

CPU:通用计算核心

架构特点:

少量高性能核心(通常 8 核~128 核),每个核心有复杂的控制单元和缓存系统(L1/L2/L3 缓存),擅长处理逻辑判断和串行任务。

指令集完整(如 x86、ARM),支持通用计算,但并行能力较弱。

性能优势:

适合处理操作系统调度、应用程序逻辑、复杂算法(如数据库查询、文件压缩)等 “多类型任务切换” 场景。

GPU:并行计算引擎

架构特点:

拥有大量计算核心(如 NVIDIA RTX 4090 含 16384 个 CUDA 核心),采用 SIMD(单指令多数据)架构,适合同时处理大量相同类型的数据。

缓存较小,内存带宽高,专注于浮点运算(如 3D 图形渲染中的矩阵变换)。

性能优势:

在图形渲染、科学计算(如物理模拟)、机器学习训练(早期依赖 GPU 并行加速)等场景中效率远超 CPU。

NPU:神经网络专用芯片

架构特点:

集成张量加速器(Tensor Core)、向量处理器等,针对神经网络的矩阵乘法(如卷积运算)、激活函数等操作优化。

采用脉动阵列(Systolic Array)等架构,减少数据搬运开销,提升能效比。

性能优势:

在 AI 推理任务(如图像识别、语音交互)中,比 GPU 更高效,功耗更低(如手机芯片中的 NPU)。

TPU:谷歌定制化 AI 芯片

架构特点:

专为 TensorFlow 框架设计,硬件层面深度优化张量运算,采用高带宽内存和专用互联结构。

第一代 TPU(2015 年)即集成 65536 个乘加单元,专注于深度学习推理和训练。

性能优势:

在谷歌云服务、AlphaGo 等场景中,处理深度学习任务的效率显著高于同期 GPU/CPU,是专用芯片的典型代表。

三、应用场景对比

类型 典型应用场景 举例 CPU 操作系统运行、办公软件、复杂逻辑控制(如服务器后台处理)、多任务调度。 电脑 CPU(Intel i9、AMD Ryzen)、服务器 CPU(Xeon、EPYC)。 GPU 3D 游戏渲染、影视特效制作、科学计算(如气象模拟)、早期 AI 训练(如 NVIDIA GPU)。 显卡(RTX 40 系列、Radeon RX 系列)、专业图形工作站。 NPU 终端设备 AI 推理(如手机拍照美颜、语音助手)、边缘计算(如智能摄像头)。 手机芯片(骁龙 8 Gen3 的 NPU、苹果 A17 Pro 的 Neural Engine)、AIoT 设备。 TPU 云端大规模深度学习训练(如谷歌翻译、自动驾驶模型训练)、超大规模 AI 推理服务。 谷歌 Cloud TPU、AlphaFold 蛋白质结构预测。 四、核心差异总结

设计理念:

CPU 是 “通用全能型选手”,适合复杂逻辑和多任务;

GPU 是 “并行计算能手”,适合重复密集型运算;

NPU/TPU 是 “AI 专项选手”,针对神经网络做硬件加速,TPU 更偏向定制化场景。

性能与能效:

在 AI 任务中,算力效率排序通常为:TPU ≈ NPU > GPU > CPU;

CPU 在通用任务中不可替代,GPU 在图形和科学计算中仍占主流,NPU/TPU 则专注于 AI 领域。

五、发展趋势

融合趋势:现代芯片常集成多种处理器,如手机 SoC(CPU+GPU+NPU)、AI 服务器(CPU+GPU/NPU/TPU),实现 “通用 + 专用” 协同计算。

场景分化:

终端设备(手机、家电)更依赖低功耗 NPU;

云端大规模 AI 训练仍以 GPU 集群(如 NVIDIA DGX)和专用 TPU 为主;

CPU 始终作为系统核心,协调各处理器分工。

通过以上对比,可清晰理解不同处理器的定位 —— 它们并非替代关系,而是根据计算需求的差异,在架构和功能上形成互补。

CUDA是什么?

CUDA(Compute Unified Device Architecture)是由 NVIDIA 开发的并行计算平台和编程模型,它允许开发者利用 NVIDIA GPU 的强大并行计算能力来加速通用计算任务。以下是关于 CUDA 的详细解析:

一、核心定义与定位

本质: CUDA 是一套软硬件结合的解决方案,包括硬件架构(GPU 中的计算核心)和软件编程模型(API、工具链、库),旨在让开发者用类似 C/C++ 等主流语言编写并行计算程序,而非仅用于图形渲染。

目标: 将 GPU 从传统的图形处理器拓展为通用并行计算处理器,解决 CPU 在处理大规模并行任务(如深度学习、科学计算)时的性能瓶颈问题。

二、技术架构与关键组件

硬件层面:GPU 的并行计算单元

流多处理器(Streaming Multiprocessor, SM): GPU 的核心计算单元,每个 SM 包含多个 CUDA 核心(如 NVIDIA Ampere 架构的 SM 含 128 个 CUDA 核心),可同时执行相同指令(SIMD 架构)。

内存层次结构:

全局内存(Global Memory):容量大但延迟高,用于存储大规模数据。

共享内存(Shared Memory):每个 SM 内的高速缓存,延迟低,用于同 SM 内线程间数据交换。

寄存器(Registers):每个线程专属的高速存储,访问速度最快。

软件层面:编程模型与工具链

编程模型:

线程层次结构:将计算任务拆分为大量线程(Thread),按 “线程块(Block)→网格(Grid)” 组织,实现并行计算。

CUDA C/C++:基于 C 语言扩展的编程接口,支持开发者定义并行函数(Kernel)在 GPU 上执行。

工具与库:

CUDA Toolkit:包含编译器(nvcc)、调试器(Nsight)、性能分析工具(nvprof)等。

加速库:如 CuDNN(深度学习神经网络加速)、CUDA-X AI(AI 工作流优化)、CUDA Math Library(数学函数加速)等,降低开发门槛。

三、工作原理:CPU 与 GPU 的协同计算

任务分工:

CPU 负责逻辑控制、串行任务(如数据预处理、任务调度)。

GPU 负责并行计算密集型任务(如矩阵乘法、大规模数据滤波),通过 CUDA 将任务拆解为数千个线程同时执行。

数据流转:

数据从 CPU 内存复制到 GPU 全局内存,GPU 计算完成后结果再传回 CPU。

优化方向:通过共享内存减少数据搬运开销,或利用 GPU 直接访问 CPU 内存(如 PCIe 4.0 的 Peer-to-Peer 技术)。

四、应用场景

科学与工程计算: 气象模拟、流体力学计算、分子动力学仿真(如 GROMACS 软件基于 CUDA 加速)。

深度学习与 AI: 模型训练(如 PyTorch、TensorFlow 通过 CUDA 调用 GPU 加速)、推理(如 NVIDIA TensorRT 基于 CUDA 优化)。

图形与视觉计算: 3D 渲染加速(如 Blender 的 CUDA 渲染模式)、视频编码 / 解码(NVENC/NVDEC 硬件加速)。

数据科学与大数据: 机器学习算法(如随机森林、K-means 聚类)、大数据分析(如 Apache Spark 结合 CUDA 加速)。

五、优势与局限性

优势

高性能并行计算:相比 CPU,GPU 的数千个 CUDA 核心可在浮点运算、矩阵操作等场景实现数十到数百倍的性能提升。

编程门槛低:基于 C 语言的 CUDA 编程模型比直接操作 GPU 硬件(如汇编)更易上手,且有丰富的库支持。

生态成熟:NVIDIA 长期维护 CUDA 生态,大量软件和框架(如深度学习框架、科学计算库)优先支持 CUDA。

局限性

硬件锁定:仅支持 NVIDIA GPU,AMD、Intel 的 GPU 需使用 OpenCL 等跨平台方案。

开发复杂度:并行算法设计(如线程同步、内存优化)需要一定经验,否则可能出现性能瓶颈。

数据搬运开销:CPU 与 GPU 之间的数据传输可能成为瓶颈,尤其在小批量任务中。

六、与其他并行计算方案的对比

方案 代表技术 优势 适用场景 CUDA NVIDIA GPU 性能强、生态完善 NVIDIA 平台的 AI、科学计算 OpenCL 跨平台(AMD/Intel) 跨硬件兼容 多厂商设备的通用并行计算 Metal Apple GPU 苹果生态优化 macOS/iOS 平台的图形与计算 DirectX Windows 图形 API 微软平台图形渲染 Windows 游戏与图形开发 七、发展趋势

技术迭代:NVIDIA 在最新架构(如 Hopper、Blackwell)中增强 CUDA 核心性能,引入 Tensor Core(张量核心)专门加速 AI 计算。

生态扩展:CUDA 逐渐支持更多编程语言(如 Python 通过 Numba 调用),并与容器技术(如 Docker)结合,简化部署流程。

异构计算融合:CUDA 与 CPU、FPGA 等异构芯片协同,形成 “CPU+GPU + 专用加速器” 的混合计算架构,提升整体效率。

总之,CUDA 是推动 GPU 从图形领域向通用计算领域拓展的关键技术,其核心价值在于通过软硬件协同,让开发者能够高效利用 NVIDIA GPU 的并行计算能力,解决传统 CPU 难以处理的大规模计算任务。

正点原子嵌入式AI课程

网上看到正点原子2023年开始发布过一套视频:【正点原子】AI人工智能深度学习(RV1126/RK3568/RK3588)

链接如下所示:

【正点原子】AI人工智能深度学习(RV1126/RK3568/RK3588)-第1期 准备篇_哔哩哔哩_bilibili

我大概看了下,还是比较适合当前的我来学习的。

认识RV1126/RK3568/RK3588:

RV1126、RK3568 和 RK3588 都是瑞芯微推出的芯片,以下是它们的相关介绍:

✔

RV1126

核心配置:采用 12nm 低功耗 AI 视觉处理器,基于四核 32 位 ARM Cortex - A7 架构,集成 NEON 和 FPU,主频高达 1.5GHz。每个核心都有 32KB I - cache 和 32KB D - cache 以及 512KB 共用二级缓存。

算力:内置 2.0Tops 神经网络处理器 NPU,支持 INT8/INT16,具有很强的网络模型兼容性,能方便实现 TensorFlow/MXNet/PyTorch/Caffe 等不同框架转换。

视频处理能力:支持 4K H.264/H.265 30fps 视频编码与解码,具备多级降噪、3 帧 HDR 等技术,可满足黑光全彩需求。

应用场景:广泛应用于人脸识别、手势识别、闸机门禁、智能安防、IPC 智能网络摄像头、智能门铃 / 猫眼、自助终端、智慧金融、智慧工地、智慧出行等行业。

✔

RK3568

核心配置:CPU 为四核 ARM Cortex - A55,主频最高 2.0GHz,GPU 为 ARM Mali - G52 2EE,支持 OpenGL ES 3.2/Vulkan 1.1,采用 22nm 制程工艺。

算力:NPU 算力为 0.8TOPS(INT8),支持轻量级 AI 推理。

视频处理能力:支持 4K@60fps 视频解码(H.265/H.264/VP9)和 1080p@60fps 编码,支持双屏异显(HDMI 2.0 + MIPI - DSI)。

应用场景:适用于中端智能终端,如 NAS、工控设备、广告机,以及轻量级 AI 边缘设备,如人脸识别门禁等。

✔

RK3588

核心配置:采用 8nm 制程工艺,CPU 为四核 Cortex - A76 + 四核 Cortex - A55(大小核设计),主频最高 2.4GHz,GPU 为 ARM Mali - G610 MP4,支持 OpenGL ES 3.2/Vulkan 1.2。

算力:NPU 算力为 6TOPS(INT8),支持多模态 AI 推理(如视觉、语音)。

视频处理能力:支持 8K@60fps 视频解码(H.265/H.264/AV1)和 8K@30fps 编码,支持八屏异显(HDMI 2.1、MIPI - DSI、eDP 等)。

应用场景:主要用于高端边缘计算,如 AI 服务器、工业机器人,复杂 AIoT 设备,如智能座舱、AR/VR 设备,以及超高清视频处理,如 8K 视频会议系统等。

大模型裁剪

有哪些方法可以缩小大模型的资源占用?

缩小大模型的资源占用是提高其部署效率和降低成本的关键。以下是一些常见且有效的方法,涵盖模型架构、训练策略、推理优化等多个方面:

一、模型压缩技术

参数量剪枝(Pruning)

原理:移除模型中冗余的权重(如接近零的权重)或神经元。

方法:

- 非结构化剪枝:删除单个权重(需要稀疏计算支持)。

- 结构化剪枝:删除整个神经元/通道(兼容通用硬件)。

工具:PyTorch的

torch.nn.utils.prune、TensorFlow的model_optimization。量化(Quantization)

原理:将模型参数从浮点数(如FP32)转换为低精度格式(如INT8)。

方法:

- 训练后量化(Post-training Quantization):无需重新训练,直接量化。

- 量化感知训练(QAT):在训练中模拟量化误差,提升精度。

工具:TensorRT、ONNX Runtime、TFLite。

知识蒸馏(Knowledge Distillation)

原理:用小模型(学生模型)学习大模型(教师模型)的输出或中间特征。

变体:

- 任务无关蒸馏:如TinyBERT蒸馏BERT的嵌入层和注意力矩阵。

- 数据增强:结合未标注数据(如UDify蒸馏多语言模型)。

低秩分解(Low-Rank Factorization)

原理:将大矩阵分解为多个小矩阵乘积(如SVD分解)。

适用场景:全连接层或注意力层的参数压缩。

二、高效模型架构设计

稀疏模型(Sparse Models)

使用稀疏注意力(如Longformer的局部注意力)或MoE(Mixture of Experts,如Switch Transformer)。

轻量级结构

示例:

- MobileBERT(基于BERT的轻量版)。

- DistilGPT-2(减少层数和隐藏维度)。

技术:深度可分离卷积、分组卷积(如ConvNeXt)。

三、训练策略优化

渐进式训练

- 先训练小模型,逐步增加参数(如渐进式层增长)。

参数共享

- 跨层共享权重(如ALBERT的跨层参数共享)。

动态计算

- 根据输入难度动态调整计算量(如早停机制或自适应深度)。

四、推理优化

批处理(Batching)与缓存

- 合并多个请求的推理计算,复用中间结果(如KV缓存用于自回归模型)。

硬件适配

- 使用专用加速库:

- GPU:TensorRT、FasterTransformer。

- CPU:ONNX Runtime、Intel OpenVINO。

- 针对边缘设备:TFLite for Mobile、Core ML。

五、系统级优化

模型切分(Model Parallelism)

- 流水线并行:将模型按层拆分到多设备(如GPipe)。

- 张量并行:将单个层的计算分布到多设备(如Megatron-LM)。

混合精度训练

- 结合FP16/FP32(需GPU支持,如NVIDIA A100的Tensor Core)。

六、其他技巧

权重共享与跨任务适配

- 多任务学习:共享底层参数(如MT-DNN)。

动态稀疏化

- 运行时根据输入激活部分模型(如BlockBERT)。

七、工具与框架推荐

压缩/蒸馏:HuggingFace

transformers、distilbert。量化:NVIDIA TensorRT、PyTorch

quantization。部署:ONNX、vLLM(针对LLM的高效推理)。

八、选择方法的考量因素

任务需求:高精度任务(如医疗)可能需要量化感知训练而非简单剪枝。

硬件限制:边缘设备优先选择结构剪枝+量化。

开发成本:知识蒸馏需要重新训练,而训练后量化可快速部署。

通过组合上述方法(如剪枝+量化+蒸馏),可以在保持模型性能的同时显著减少资源占用。例如,DistilBERT通过蒸馏将BERT体积减少40%,而INT8量化可进一步压缩4倍。

大模型的量化精度

大模型的量化精度是指将模型参数从高精度数据类型(如 float32)转换为低精度类型(如 int8、float16)的过程中,对数值表示精度的控制程度。量化精度直接影响模型的大小、推理速度、内存占用和预测准确性,以下是详细解析:

一、量化精度的核心类型及特点

1. 浮点型量化精度

类型 位数 数值范围 精度特点 典型应用场景 float32 32 位 ±1.2×10⁻³⁸ 至 ±3.4×10³⁸ 高精度,训练阶段主流类型 模型训练、学术研究(追求最高精度) float16/half 16 位 ±6.1×10⁻⁵ 至 ±6.5×10⁴ 半精度,保留小数部分 混合精度训练(如 A100 GPU 支持)、中等精度推理 bf16(BrainFloat16) 16 位 同 float16,但指数位设计不同 动态范围更广,适合大模型激活值 TensorFlow、PyTorch 的混合精度策略 float8 8 位 新兴类型(如 TF32 变种) 实验性方案,进一步压缩模型 未来边缘设备部署(如 Google 的 TPU 支持) 2. 整型量化精度

类型 位数 数值范围(有符号) 精度特点 典型应用场景 int8 8 位 -128 至 127 最低整型精度,无小数表示 模型压缩(如 LLM 量化后部署到手机) int16 16 位 -32768 至 32767 中等整型精度 服务器端推理(平衡速度与精度) int32 32 位 -2¹⁵ 至 2¹⁵-1 传统默认整型,数值范围广 训练阶段的索引、计数等非精度敏感操作 uint8 8 位 0 至 255 无符号整型,仅表示非负数 图像数据存储、非负权重量化 二、不同量化精度的技术实现与影响

1. 浮点型量化:保留小数,压缩动态范围

float16 vs bf16:

float16:5 位指数 + 10 位尾数,适合小数密集型数据(如权重)。

bf16:8 位指数 + 7 位尾数,适合激活值(动态范围大,允许少量精度损失)。

应用案例:

混合精度训练:用 float16/bf16 存储权重,float32 备份梯度,在 A100 GPU 上可加速 30%+。

2. 整型量化:舍弃小数,用整数近似

int8 量化的核心逻辑:

将 float32 权重映射到 [-128, 127] 的整数范围,公式:

int8_value = round(weight / scale),其中scale=float32_range/255推理时用 int8 计算,最后用 scale 还原结果,误差可控(如 LLaMA-2 量化后精度损失 < 1%)。

量化技术变种:

对称量化:正负范围对称(如 [-127, 127]),适合对称分布的权重。

非对称量化:范围为 [0, 255](uint8),适合激活值(非负数居多)。

分组量化:将权重分块(如 64 个一组),每组独立计算 scale,提升精度(如 GPTQ 算法)。

总结

大模型的量化精度本质是 “精度 - 速度 - 成本” 的平衡艺术:

float32/float16:训练与高精度推理的首选。

int8/int16:生产环境部署的主流方案,兼顾实用性与性价比。

int4/float8:未来边缘设备的趋势,但需硬件与算法同步升级。 选择量化精度时,需结合任务需求、硬件条件和可接受的精度损失,通过实测(如对比量化前后的困惑度、准确率)确定最优方案。

为什么大模型量化的时候还需要指定数据集?

大模型量化时指定数据集主要是为了在量化过程中校准模型精度,确保量化后的模型在实际应用场景中保持较好的性能。以下是具体原因及原理解析:

一、量化的核心矛盾:精度与效率的平衡

量化通过降低模型权重和激活值的位宽(如从 32 位浮点数→8 位整数)来压缩模型体积、加速推理,但这会引入精度损失。指定数据集的核心目标是最小化这种损失,其作用体现在以下环节:

二、数据集在量化中的关键作用

1. 校准量化参数(Calibration)

动态范围确定:量化需将浮点数值映射到有限的整数范围内(如 8 位对应 0-255),而不同数据的分布差异会影响映射精度。 例如:通过少量数据(如 100-500 张图像)计算权重和激活值的最大值 / 最小值或分位数(如 99.9% 分位),确定最优的量化比例(Scale)和零点(Zero Point),避免数值溢出或精度浪费。

示例代码逻辑(伪代码):

2. 模拟真实输入分布

大模型的性能与输入数据的分布强相关(如文本模型对不同领域文本的处理差异)。 通过指定与实际应用场景相似的数据集(如医疗文本、代码文本),量化过程能针对性地保留关键特征的精度。

案例:若量化后的模型用于医疗影像诊断,校准数据集需包含医疗影像而非自然图像,避免因数据分布差异导致诊断准确率下降。

3. 感知重要性加权

部分量化方法(如感知量化)会根据数据对模型输出的影响程度调整量化优先级。 例如:对高频出现或对分类结果影响大的特征(如图像中的边缘、文本中的关键词)分配更高的量化精度,这需要通过数据集分析特征重要性。

三、不同量化方法对数据集的依赖差异

量化方法 数据集依赖程度 作用机制 静态量化 低(可选) 仅需少量数据校准动态范围,适用于数据分布稳定的场景(如 ImageNet 图像分类)。 动态量化 中 通过数据统计激活值范围,避免溢出(如 GPT 模型的 KV 缓存激活值动态范围大)。 量化感知训练(QAT) 高 需要大量标注数据,在训练过程中模拟量化误差,让模型学习抗量化干扰的能力。 混合精度量化 低 自动选择 FP16/INT8 混合精度,需小数据集验证精度损失是否可接受。 四、不指定数据集的风险

精度大幅下降: 若随机选择校准数据(如与实际场景无关的图像),可能导致:

激活值动态范围估计偏差,如将原本范围为 [-100, 100] 的数值错误映射到 [-10, 10],导致大量信息截断。

关键特征(如文本中的稀有词汇、图像中的小目标)量化后失真,影响模型推理效果。

跨场景泛化性差: 例如:用通用新闻文本校准的语言模型,在法律文书场景下可能因词汇分布差异,导致实体识别准确率下降 10% 以上。

五、典型实践:数据集选择与用量

数据集要求:

代表性:覆盖实际应用中的输入分布(如语音模型需包含不同口音、噪声环境的音频)。

小规模:通常使用 100-1000 个样本即可(QAT 除外,需完整训练集),避免计算开销过大。

案例:

LLM 量化(如 Llama-2):使用 1000 条与下游任务相关的文本(如客服对话、学术摘要)校准,确保生成文本的流畅度和逻辑一致性。

视觉模型量化(如 YOLO):用 500 张包含目标物体的图像校准,重点保留边界框定位和类别预测的精度。

六、总结:数据集是量化的 “精度保护器”

量化本质是对模型进行 “有损压缩”,而数据集通过校准参数、匹配分布、保留关键特征三大机制,在压缩效率和模型精度间找到平衡点。这就像用实际场景的 “模板” 指导量化过程,避免因盲目降位宽导致模型 “失真”。

如果需要具体框架(如 Transformers、TensorRT)的量化数据集配置示例,可以进一步说明场景需求。

入门嵌入式AI的建议

参考:

参考

嵌入式向AI方向发展

(3 封私信 / 4 条消息) 嵌入式向AI方向发展 - 搜索结果 - 知乎

如何从嵌入式开发转型为嵌入式AI工程师:开启你的跨界转型之路 - 知乎

(3 封私信 / 6 条消息) 什么是嵌入式人工智能? - 知乎