深度学习与计算机视觉基础讲义完整指南

本文还有配套的精品资源,点击获取

简介:本讲义旨在为学习者提供深度学习和计算机视觉的基础知识,涵盖深度学习基础如神经网络结构、反向传播、激活函数等,以及计算机视觉领域的图像分类、目标检测和语义分割等关键技术。同时介绍了深度学习在实际领域如人脸识别、自动驾驶的应用,并详细探讨了著名的深度学习模型,包括训练和评估过程,以及目前流行的深度学习框架。通过本讲义的学习,学习者将获得全面的理论知识和实践能力。

1. 神经网络基础

神经网络的定义与组成

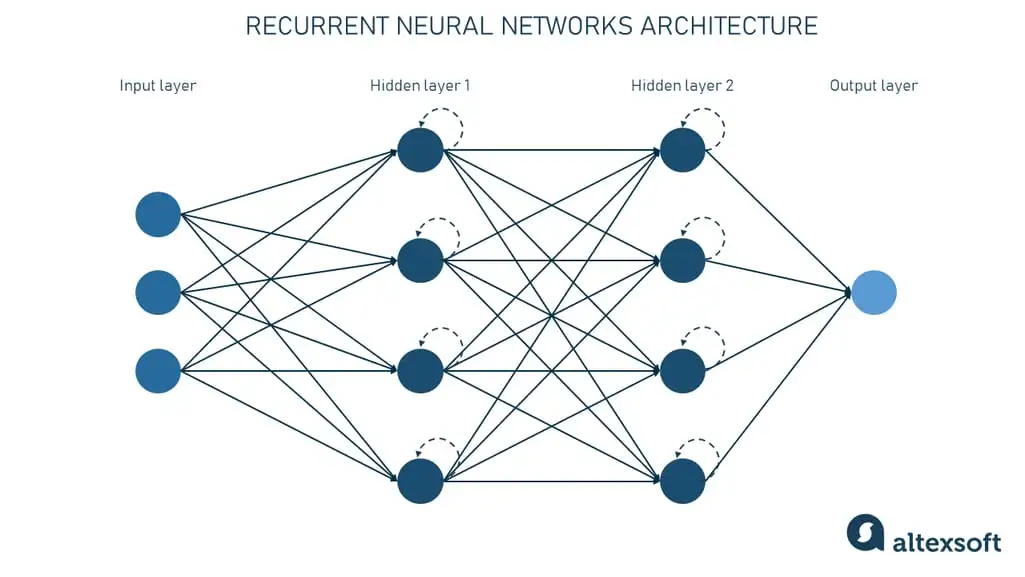

神经网络是一类模仿生物神经网络结构和功能的计算模型,它由大量的节点(或称为神经元)互相连接构成,用来学习数据中的模式和规律。最基础的神经网络包括输入层、隐藏层以及输出层。输入层接收原始数据,隐藏层负责数据的处理与特征提取,而输出层则是输出最终的预测结果。每一层由多个神经元组成,它们通过加权连接相互作用。每个连接都有一个权重,权重的大小决定了两个神经元之间连接的强度。

神经网络的工作原理

神经网络通过前向传播与反向传播两个主要过程工作。在前向传播阶段,输入信号逐层传递,通过神经元的加权求和和激活函数的作用,产生输出信号。反向传播则用于更新权重,通过计算损失函数关于权重的导数(梯度),利用梯度下降法等优化算法调整权重,以最小化模型输出与实际结果之间的差异。这个过程反复进行,直到网络的输出足够接近预期值或达到收敛条件。

神经网络的类型

神经网络根据结构的不同,可以分为前馈神经网络、递归神经网络、卷积神经网络等。前馈神经网络是最简单的神经网络类型,信号单向流动,没有反馈。递归神经网络能够处理序列数据,具有记忆能力,适用于自然语言处理、时间序列分析等地方。卷积神经网络擅长图像识别和处理,通过局部感受野和权值共享减少了参数的数量。每种类型的网络设计都有其独特的优势和应用场景,适用于解决不同类型的机器学习问题。

2. 反向传播与优化算法

深度学习中的优化算法是神经网络训练的核心,而理解这些算法背后的基本原理对于设计更高效的网络结构至关重要。本章我们将深入探讨反向传播算法的数学原理,以及在神经网络中如何应用链式法则来进行权重的更新。同时,我们会详细比较不同的优化算法,如SGD、Adam和RMSprop,并探索学习率调整策略和动量、权重衰减等因素对模型训练的影响。

2.1 反向传播算法的数学原理

2.1.1 梯度下降法

梯度下降是最基本的优化算法之一,它是一种迭代方法,用于求解无约束的优化问题。该算法的核心是利用损失函数对参数的梯度信息,通过不断迭代来找到使得损失函数值最小的参数值。对于神经网络而言,这个参数就是网络中的权重。

在梯度下降中,每次迭代更新参数的公式如下:

[ \\theta_{\\text{new}} = \\theta_{\\text{old}} - \\alpha \\cdot \\nabla_{\\theta}J(\\theta) ]

这里,( \\theta ) 表示参数,( J(\\theta) ) 表示损失函数,( \\alpha ) 是学习率,而 ( \\nabla_{\\theta}J(\\theta) ) 是损失函数相对于参数的梯度。

梯度下降法按照所有训练数据进行一次更新称为批量梯度下降(Batch Gradient Descent)。当批量大小为1时,称为随机梯度下降(Stochastic Gradient Descent,SGD)。为了平衡计算效率和梯度的稳定性,通常会选择一个介于两者之间的小批量(Mini-batch)梯度下降。

梯度下降法虽然简单有效,但它也有一些缺点,比如学习率的选择对算法性能影响很大,而且容易陷入局部最小值。

# Python中的SGD优化器示例from sklearn.linear_model import SGDClassifier# 假设我们已经加载了数据集X, ysgd = SGDClassifier(loss=\'log\')sgd.fit(X_train, y_train)# 该模型将使用SGD进行优化2.1.2 链式法则在神经网络中的应用

反向传播算法依赖于链式法则来计算梯度。链式法则是微积分中用于求复合函数导数的方法,它表示一个复合函数的导数等于外层函数在内层函数处的导数乘以内层函数的导数。

对于一个由多个层次组成的神经网络,损失函数可以看作是输入数据经过多层变换后得到的输出的复合函数。每层的变换都可以表示为参数化的函数,其导数可以表示为相对于这些参数的偏导数。

在反向传播中,我们首先计算损失函数相对于最终输出层的导数,然后使用链式法则依次向后计算每一层的梯度,直到输入层。这一过程中,每一层的梯度信息都用于更新上一层的参数,从而实现了整个网络的优化。

这个过程可以用以下伪代码表示:

def backward_pass(): # 反向传播计算误差对每个权重的梯度 for layer in reversed(range(num_layers)): # 假设dL/dz是损失函数关于当前层输出z的梯度 dz = calculate_gradient(loss_function, layer) # 使用链式法则计算dL/dz对每一层参数的梯度 for param in layer.parameters(): dL_dparam = dz * derivative_of_layer_output(param) # 更新梯度 param.grad += dL_dparam# 在训练循环中调用backward_pass()2.2 常见的优化算法

2.2.1 SGD、Adam、RMSprop等优化器的对比

SGD是最基础的优化算法之一,它在更新权重时只考虑单个样本(或小批量样本)的梯度,因此计算效率高但方向可能不够稳定。为了提高SGD的性能,研究者提出了许多改进的优化算法,其中比较著名的包括Adam、RMSprop等。

Adam优化器结合了动量(Momentum)和RMSprop两种机制,旨在加速学习过程同时减少震荡。它通过计算梯度的一阶矩估计(即平均)和二阶矩估计(即未中心化的方差)来调整学习率。在许多场景下,Adam展现出了优越的性能。

RMSprop是另一种用于深度学习的优化算法,它的目标是修正AdaGrad中学习率逐渐减小的问题。RMSprop通过累积过去梯度的平方来调整学习率,避免了学习率快速下降导致的优化过程停滞。

下面是一些优化算法的比较:

| 优化器 | 特点 | 适用场景 | | --- | --- | --- | | SGD | 计算简单,但收敛速度慢,容易陷入局部最小值 | 数据量小,问题简单 | | Adam | 结合了Momentum和RMSprop的优势,自适应调整学习率 | 大多数深度学习任务 | | RMSprop | 修正AdaGrad的学习率衰减问题,适用于非平稳目标 | 循环神经网络,特别是具有大规模参数的任务 |

from keras.optimizers import Adam, SGD, RMSprop# 初始化不同的优化器sgd = SGD(lr=0.01, momentum=0.9)rmsprop = RMSprop(lr=0.001)adam = Adam(lr=0.001)# 优化器的参数可以根据问题调整2.2.2 学习率调整策略

学习率是影响模型训练速度和效果的关键超参数之一。固定的学习率可能会导致训练过程中的问题,如学习率太大可能导致模型在最优点附近震荡,而学习率太小则会导致训练速度过慢。因此,研究者提出了一些动态调整学习率的策略,比如学习率衰减、周期性调整等。

学习率衰减指的是随着训练的进行,逐步减小学习率。一个简单的学习率衰减策略是每经过固定数量的epoch后,将学习率乘以一个小于1的衰减因子。周期性调整则是在训练过程中按照周期性的模式来增加或减少学习率。

# Keras中的学习率衰减示例from keras.callbacks import LearningRateSchedulerdef scheduler(epoch, lr): if epoch < 10: return lr else: return lr * tf.math.exp(-0.1)lr_scheduler = LearningRateScheduler(scheduler)2.2.3 动量和权重衰减的影响

动量(Momentum)在SGD的基础上引入了惯性概念,即考虑之前累积的梯度信息来调整当前的梯度方向。在训练过程中,动量会帮助算法加速穿越平面,同时抑制震荡。权重衰减(weight decay)是一种防止过拟合的技术,通过在损失函数中添加一个惩罚项,使得大的权重在训练过程中逐渐减小。

在实践中,动量和权重衰减通常是结合使用的。权重衰减可以看作是对权重的梯度应用了一个额外的衰减因子,而动量则有助于在参数空间中更快速、更稳定地收敛。

# 使用动量和权重衰减的优化器配置示例from keras.optimizers import SGDsgd = SGD(lr=0.01, momentum=0.9, nesterov=True, decay=1e-4)通过本章节的介绍,我们了解了反向传播算法的数学原理,包括梯度下降法和链式法则的应用。同时,我们也探讨了常见的优化算法,学习率调整策略,以及动量和权重衰减的影响。这些优化技术和策略是训练神经网络不可或缺的组成部分,对模型的性能和收敛速度都有着深远的影响。在后续章节中,我们将继续深入探讨深度学习的其他重要概念。

3. 激活函数与损失函数

3.1 激活函数详解

激活函数在神经网络中扮演着至关重要的角色,它负责引入非线性因素,使得网络能够学习和执行更加复杂的功能。接下来,我们将深入探讨几种常用的激活函数,以及它们在性能方面的影响。

3.1.1 Sigmoid、ReLU及其变种的特性

Sigmoid函数

Sigmoid函数是一种最早被广泛使用的激活函数,它的数学表达式为:

f(x) = \\frac{1}{1 + e^{-x}}Sigmoid函数将输入压缩到(0,1)区间内,使其适合表示概率,这在二分类问题中特别有用。然而,Sigmoid函数也存在一些缺点,如梯度消失问题,特别是当输入远离原点时,函数的导数接近于零,这会减慢网络的学习速度。

ReLU函数

ReLU(Rectified Linear Unit)函数的提出是为了缓解Sigmoid函数存在的梯度消失问题。ReLU函数的数学表达式为:

f(x) = max(0, x)ReLU函数只对正数进行激活,对于负数则输出为零,这简化了计算并加快了训练速度。然而,ReLU函数也存在所谓的“死亡ReLU”问题,即一旦输入为负,ReLU单元就永远不会被激活,梯度也不会流向该单元。

ReLU变种

为了克服ReLU的缺陷,研究人员提出了多个变种,例如:

- Leaky ReLU:允许一个小的梯度在负数部分流动,以防止单元“死亡”。

- Parametric ReLU(PReLU):Leaky ReLU的一个变种,其中负数部分的斜率是一个可学习的参数。

变种的使用旨在保持ReLU快速训练的优势,同时减少其不足的影响。

3.1.2 激活函数的选择对性能的影响

在选择激活函数时,应考虑如下因素:

- 网络的深度:对于深层网络,ReLU及其变种更为合适,因为它们能够缓解梯度消失问题。

- 网络的类型:对于输出层为概率分布的二分类问题,Sigmoid或Softmax可能更合适。

- 收敛速度:ReLU及其变种通常比Sigmoid和Tanh收敛得更快。

在实际应用中,激活函数的选择往往需要结合问题的性质和实验结果来确定。

import numpy as np# 以ReLU函数为例,下面是一个简单的Python实现def relu(x): return np.maximum(0, x)# 测试ReLU函数x = np.array([-1, 1, 2])print(relu(x)) # 输出应为 [0 1 2]此代码展示了如何在Python中实现ReLU函数,并对其进行了简单的测试。

3.2 损失函数概念

损失函数是衡量模型预测值和真实值之间差异的一种方式,它是优化过程中用来更新权重的核心。损失函数的选择直接影响模型的训练效率和最终的性能。

3.2.1 分类问题损失函数:交叉熵

交叉熵是在分类问题中广泛使用的损失函数,特别是在多分类问题中。对于两个概率分布P和Q,它们的交叉熵定义为:

H(P, Q) = -\\sum_{x} P(x) \\log Q(x)在神经网络中,交叉熵损失函数衡量的是模型预测概率分布和真实标签概率分布之间的差异。对于一个N类分类问题,交叉熵损失函数的数学表达式为:

L(y, \\hat{y}) = -\\sum_{i=1}^{N} y_i \\log \\hat{y}_i 其中 y 是真实标签的独热编码, \\hat{y} 是模型预测的概率分布。

3.2.2 回归问题损失函数:均方误差

均方误差(MSE)是回归问题中常用的损失函数,用于衡量模型预测值与实际值之间的平均平方差异。对于一组预测值和实际值,MSE定义为:

MSE = \\frac{1}{N}\\sum_{i=1}^{N} (\\hat{y}_i - y_i)^2 其中 y_i 是实际值, \\hat{y}_i 是预测值,N是样本数量。

3.2.3 损失函数的设计原则和选择

设计损失函数时,应该遵循一些基本原则,比如损失函数应该能够有效地反映模型的预测误差,并且易于优化。此外,损失函数应该与问题的类型相匹配,例如分类问题和回归问题应该使用不同的损失函数。

在选择损失函数时,需要考虑如下因素:

- 问题类型:分类问题使用交叉熵,回归问题使用MSE。

- 数据分布:是否是不平衡的数据集,对于不平衡数据集可能需要自定义损失函数。

- 优化目标:目标函数是否对异常值敏感,需要使用如Huber损失的鲁棒性损失函数。

from sklearn.metrics import mean_squared_error, log_loss# 假设有真实值和预测值y_true = np.array([0, 1, 1, 0])y_pred = np.array([0.1, 0.9, 0.8, 0.2])# 计算MSEmse = mean_squared_error(y_true, y_pred)print(f\"MSE: {mse}\")# 计算交叉熵损失交叉熵 = log_loss(y_true, y_pred)print(f\"交叉熵: {交叉熵}\") 以上代码展示了如何在Python中计算均方误差和交叉熵损失函数,使用了 sklearn 库中的相应函数。

表格:常见损失函数及其适用情况

| 损失函数类型 | 适用情况 | 公式 | 优点 | 缺点 | | --- | --- | --- | --- | --- | | 交叉熵 | 多类分类问题 | $-\\sum_{i=1}^{N} y_i \\log \\hat{y} i$ | 反映概率分布差异,适合概率输出 | 对概率估计不准确时惩罚过大 | | 均方误差 (MSE) | 回归问题 | $\\frac{1}{N}\\sum {i=1}^{N} (\\hat{y} i - y_i)^2$ | 计算简单,对异常值敏感 | 对异常值过于敏感,可能导致梯度不稳定 | | 绝对误差 (MAE) | 回归问题 | $\\frac{1}{N}\\sum {i=1}^{N} |\\hat{y}_i - y_i|$ | 对异常值鲁棒性强 | 计算梯度不如MSE简单 |

mermaid流程图:损失函数的选择流程

graph TD A[开始] --> B{确定问题类型} B -->|分类| C[交叉熵] B -->|回归| D[MSE或MAE] C --> E{是否平衡数据集} D --> E E -->|是| F[结束] E -->|否| G[考虑使用自定义或鲁棒性损失函数] G --> F通过上述内容,我们不仅深入理解了激活函数和损失函数在神经网络中的作用和选择标准,而且还通过代码实例和可视化表格,将这些理论知识与实践相结合。在后续的章节中,我们将进一步探讨深度学习模型的结构与训练,以及深度学习在计算机视觉中的应用。

4. 深度学习模型结构与训练

4.1 深度学习模型结构

深度学习模型的核心在于其结构设计,不同的网络结构可以解决不同类型的机器学习问题。本小节将深入探讨卷积神经网络(CNN),它在图像和视频处理领域中表现出了卓越的能力。

4.1.1 卷积神经网络(CNN)的基本组成

卷积神经网络是一种深度前馈神经网络,其结构特别适合处理具有网格状拓扑结构的数据,如图像。CNN 的关键组成部分包括卷积层(Convolutional layer)、激活函数(Activation function)、池化层(Pooling layer)和全连接层(Fully connected layer)。

卷积层 :其作用是提取输入数据的局部特征,通过卷积核(filter)在输入数据上滑动来进行特征提取。卷积核的参数在训练过程中会自动调整,以学习最能够代表数据特征的模式。

import tensorflow as tf# 创建一个简单的卷积层模型model = tf.keras.Sequential([ tf.keras.layers.Conv2D(filters=32, kernel_size=(3, 3), activation=\'relu\', input_shape=(28, 28, 1))])激活函数 :通常在卷积层之后,提供非线性变换能力。在卷积神经网络中,ReLU 激活函数(Rectified Linear Unit)因其简单高效而广受欢迎。它将所有负值置为零,同时保持正值不变。

# ReLU激活层model.add(tf.keras.layers.Activation(\'relu\'))池化层 :通过降低数据的空间尺寸来减少参数数量和计算量,并防止过拟合。最常用的池化操作是最大池化(Max Pooling)。

# 添加一个最大池化层model.add(tf.keras.layers.MaxPooling2D(pool_size=(2, 2)))全连接层 :位于 CNN 的末端,用于将学习到的特征映射到样本标记空间。全连接层的输出常常会经过一个Softmax层,用于多分类问题。

# 添加一个全连接层model.add(tf.keras.layers.Dense(units=10))4.1.2 典型CNN模型的架构与特点

在本节中,我们将介绍几种具有里程碑意义的CNN架构及其特点,包括LeNet-5、AlexNet、VGGNet、GoogLeNet和ResNet。

LeNet-5 :1998年由Yann LeCun提出,是最早用于手写数字识别的卷积神经网络之一。它证明了卷积神经网络在图像识别任务中的有效性。

AlexNet :2012年ImageNet大规模视觉识别挑战赛(ILSVRC)的冠军模型,它引入了ReLU激活函数和Dropout技术,并通过GPU加速训练,开启了深度学习的新时代。

VGGNet :由牛津大学的视觉几何组(VGG)提出,具有多个连续卷积层(3x3卷积核和2x2池化层),通过增加深度来提升模型性能。

# VGGNet风格的模型model = tf.keras.applications.VGG16(weights=None, input_shape=(224, 224, 3))GoogLeNet :通过引入Inception模块,有效减少了计算资源的使用,并增强了网络的表现。Inception模块能够在不同的尺度上捕捉信息,并通过多尺度特征融合来提高模型的识别能力。

ResNet :残差网络,它引入了残差学习框架来训练更深的网络,解决了随着网络深度增加而出现的梯度消失和退化问题。通过跳跃连接(skip connection),使得网络可以学习到恒等映射。

# ResNet风格的模型model = tf.keras.applications.ResNet50(weights=None, input_shape=(224, 224, 3))4.2 训练与评估方法

4.2.1 过拟合与欠拟合的诊断与对策

在训练深度学习模型时,我们经常遇到过拟合和欠拟合的问题。过拟合指的是模型在训练数据上表现很好,但在新的、未见过的数据上表现较差;欠拟合则是指模型没有足够的能力学习训练数据中的复杂模式。

对策:

- 数据增强 :通过随机变换如旋转、缩放、剪切等操作来增加训练数据的多样性,减少过拟合。

- 正则化技术 :添加L1或L2正则化项到损失函数中,或使用Dropout来减少神经元之间的共适应性。

- 简化模型结构 :如果模型过于复杂,尝试减少层数或神经元数目。

- 提前停止 :在验证集的性能不再提升时停止训练。

- 增加训练数据 :提供更多样化的训练样本来帮助模型学习更广泛的特征。

4.2.2 模型评估指标

在深度学习中,我们用各种评估指标来衡量模型的性能,常见的指标包括准确度(Accuracy)、精确度(Precision)、召回率(Recall)、F1分数(F1 Score)和ROC曲线下的面积(AUC)。

from sklearn.metrics import accuracy_score, precision_score, recall_score, f1_score, roc_auc_score# 假设y_true和y_pred分别是真实标签和预测标签y_true = [1, 0, 0, 1, 1]y_pred = [0, 0, 1, 1, 1]# 计算评估指标accuracy = accuracy_score(y_true, y_pred)precision = precision_score(y_true, y_pred)recall = recall_score(y_true, y_pred)f1 = f1_score(y_true, y_pred)4.2.3 超参数调优的策略

超参数调优是提高模型性能的关键步骤之一。常见的超参数调优方法包括网格搜索(Grid Search)、随机搜索(Random Search)、贝叶斯优化(Bayesian Optimization)和遗传算法(Genetic Algorithm)。

graph LRA[开始超参数调优] --> B[定义超参数搜索范围]B --> C[选择调优策略]C --> D[网格搜索]C --> E[随机搜索]C --> F[贝叶斯优化]C --> G[遗传算法]D --> H[评估模型性能]E --> HF --> HG --> HH --> I{是否满足终止条件}I --> |是| J[结束调优]I --> |否| C网格搜索是一种穷举的方法,它遍历所有预定义的超参数组合。随机搜索则是在参数空间中随机选择点进行评估,通常更快且效果不错。贝叶斯优化使用概率模型来指导搜索,而遗传算法则是模拟自然选择和遗传学中的交叉和变异操作来寻找最优解。

综上所述,深度学习模型结构与训练是一个多方面考虑的问题,涉及模型架构设计、训练过程的优化和模型的评估。这些技巧和方法的恰当运用,能够帮助我们训练出更加强大和鲁棒的深度学习模型。

5. 深度学习在计算机视觉中的应用

5.1 图像表示方法

5.1.1 图像预处理与数据归一化

在深度学习模型中,输入数据的预处理与归一化是至关重要的步骤。对于计算机视觉任务而言,图像数据通常是多维的像素数组。为了使模型训练更为高效和稳定,需要对图像进行适当的预处理。

首先,图像数据预处理包括尺寸调整、归一化、中心化和增强等。调整尺寸是为了统一输入数据的大小,这在多尺度的深度学习框架中尤为重要。归一化主要是将图像的像素值缩放到0到1之间,或者使用标准化方法将其转换为均值为0,标准差为1的分布。中心化是通过减去数据集的平均值来消除输入数据的均值偏差。数据增强技术如随机裁剪、旋转、翻转等可以增加模型的泛化能力。

数据归一化是确保数据分布合理的关键步骤,它有助于加速模型训练的收敛速度。例如,使用如下公式进行归一化:

normalized_image = (image - image.min()) / (image.max() - image.min())上述代码将图像数据归一化到0到1的范围内,确保训练过程中的数值稳定性。

5.1.2 图像的特征表示技术

在计算机视觉中,图像的特征提取是将原始像素信息转化为能够表达视觉内容的数值表示。深度学习模型如卷积神经网络(CNN)能够自动学习从低级到高级的图像特征表示。

常用的图像特征表示技术包括边缘检测、SIFT(尺度不变特征变换)、HOG(方向梯度直方图)等传统方法,以及深度学习中的卷积层特征提取。卷积神经网络通过多个卷积层和池化层的堆叠,能够提取出越来越抽象的特征表示,这对于图像分类、目标检测等任务至关重要。

使用深度学习框架中的预训练模型提取图像特征已经成为一种流行的方法。这些预训练模型在大型数据集上训练,具有强大的特征提取能力。例如,在PyTorch中,可以使用如下代码来提取预训练模型的特征:

from torchvision import models, transformsfrom PIL import Image# 加载预训练模型model = models.resnet50(pretrained=True)# 图像预处理流程preprocess = transforms.Compose([ transforms.Resize(256), transforms.CenterCrop(224), transforms.ToTensor(), transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]),])# 加载图像,转换为模型需要的格式,并进行预处理image = Image.open(\"path/to/image.jpg\")tensor_image = preprocess(image).unsqueeze(0)# 使用模型提取特征with torch.no_grad(): model.eval() features = model(tensor_image)# features 包含了提取的特征,可以用于下游任务通过这种预处理和特征提取,我们能够获得用于各种计算机视觉任务的有效特征表示。

5.2 图像分类技术

5.2.1 基于深度学习的图像分类流程

图像分类是深度学习在计算机视觉中的一个基础应用,任务是将输入的图像分配到预定义的类别中。基于深度学习的图像分类流程涉及以下几个关键步骤:

-

数据准备 :收集并标注大量的图像数据,分为训练集、验证集和测试集。图像需要进行预处理,如上所述。

-

模型选择 :选择一个合适的深度学习模型。对于图像分类,卷积神经网络(CNN)是首选模型。

-

训练模型 :使用训练集数据训练CNN模型。在训练过程中,应用优化算法如SGD、Adam等调整网络权重。

-

验证模型 :在验证集上评估模型性能,根据性能反馈调整超参数,如学习率、批次大小等。

-

测试模型 :使用测试集测试模型的最终性能。

-

模型部署 :将训练好的模型部署到实际应用中。

在PyTorch中,我们可以快速搭建一个简单的CNN模型并进行训练:

import torchimport torch.nn as nnimport torch.optim as optimfrom torchvision import datasets, transforms, models# 定义CNN模型结构class Net(nn.Module): def __init__(self): super(Net, self).__init__() self.conv1 = nn.Conv2d(3, 64, 3) self.pool = nn.MaxPool2d(2, 2) self.conv2 = nn.Conv2d(64, 128, 3) self.fc1 = nn.Linear(128 * 56 * 56, 1024) self.fc2 = nn.Linear(1024, 512) self.fc3 = nn.Linear(512, 10) def forward(self, x): x = self.pool(torch.relu(self.conv1(x))) x = self.pool(torch.relu(self.conv2(x))) x = x.view(-1, 128 * 56 * 56) x = torch.relu(self.fc1(x)) x = torch.relu(self.fc2(x)) x = self.fc3(x) return x# 初始化网络和优化器model = Net()optimizer = optim.Adam(model.parameters(), lr=0.001)# 数据加载和预处理transform = transforms.Compose([ transforms.Resize(256), transforms.CenterCrop(224), transforms.ToTensor(), transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])])# 假设已有数据集和数据加载器train_loader, valid_loader, test_loader = ...# 训练过程for epoch in range(epochs): model.train() running_loss = 0.0 for images, labels in train_loader: optimizer.zero_grad() outputs = model(images) loss = criterion(outputs, labels) loss.backward() optimizer.step() running_loss += loss.item() print(f\'Epoch {epoch + 1}/{epochs}, Loss: {running_loss / len(train_loader)}\')# 评估模型model.eval()correct = 0total = 0with torch.no_grad(): for images, labels in valid_loader: outputs = model(images) _, predicted = torch.max(outputs.data, 1) total += labels.size(0) correct += (predicted == labels).sum().item()print(f\'Accuracy on the validation set: {100 * correct / total}%\')通过上述代码,我们建立了一个简单的CNN模型,并展示了如何训练和评估模型。实际应用中,我们可能会使用更复杂的模型和更多的数据增强技术以获得更好的性能。

5.2.2 图像分类中的迁移学习策略

迁移学习是深度学习中非常有用的一个策略,尤其在数据不足的情况下。它利用在大规模数据集(如ImageNet)上预训练得到的模型,将其应用到特定任务上。

迁移学习的核心思想是将预训练模型的知识迁移到新任务。在图像分类中,通常会替换预训练模型的最后一层,以适应新的分类任务。在PyTorch中,可以使用以下代码进行迁移学习:

# 加载预训练模型并冻结特征提取层参数model = models.resnet50(pretrained=True)for param in model.parameters(): param.requires_grad = False# 替换最后的全连接层以匹配新的分类任务num_features = model.fc.in_featuresmodel.fc = nn.Linear(num_features, num_classes)# 定义损失函数和优化器criterion = nn.CrossEntropyLoss()optimizer = optim.Adam(model.fc.parameters(), lr=0.001)# 训练和评估模型在上述代码中,我们冻结了除最后全连接层以外的所有层的参数,然后只训练这个全连接层。这大大减少了需要训练的参数数量,缩短了训练时间,同时提高了在小数据集上的性能。

5.3 目标检测方法

5.3.1 检测算法概述:R-CNN、YOLO、SSD

目标检测是计算机视觉的核心任务之一,旨在识别图像中的所有目标,并确定它们的位置和类别。主要的深度学习目标检测方法包括R-CNN系列、YOLO(You Only Look Once)和SSD(Single Shot MultiBox Detector)。

-

R-CNN (Regions with CNN features)是目标检测的开创性工作之一,通过区域建议网络(Region Proposal Network)提取潜在目标区域,再对这些区域进行分类和边界框回归。

-

YOLO 将目标检测作为单个回归问题,将图像分割成一系列网格,并预测每个网格中的目标及其边界框。YOLO模型因其速度快而受到青睐,适用于实时检测任务。

-

SSD 结合了R-CNN的边界框回归和YOLO的单阶段检测的优点,可以在一个单独的深度网络中同时检测不同尺度的目标。

这些方法都有其特点和适用场景。在实际应用中,选择合适的方法需要考虑准确度、速度和应用场景的具体需求。

5.3.2 目标检测的评价指标

目标检测模型的性能评估通常使用特定的评价指标,这些指标包括精度(Precision)、召回率(Recall)和平均精度均值(Mean Average Precision, mAP)等。

- 精度 表示检测出的目标中正确预测的比例。

- 召回率 表示所有真实目标被正确检测出的比例。

- mAP 是衡量模型性能的综合指标,它考虑了精度和召回率,是一个检测模型好坏的重要标准。

在实际应用中,我们希望同时获得高的精度和召回率,而mAP为我们提供了这样一个衡量模型综合性能的指标。例如,可以使用以下代码计算mAP:

import numpy as npfrom sklearn.metrics import average_precision_scoredef calculate_map(detections, ground_truths): ap_scores = [] for class_id in range(num_classes): # 检测结果和真实标签按置信度排序 sorted_indices = np.argsort(-detections[:, class_id+1]) sorted_detections = detections[sorted_indices, :] sorted_ground_truths = ground_truths[sorted_indices, :] tp = np.cumsum(sorted_ground_truths[:, class_id]) fp = np.cumsum(sorted_detections[:, class_id]) - tp # 计算每个类别在各个阈值下的精度和召回率 precision = tp / (tp + fp) recall = tp / (tp + np.sum(sorted_ground_truths[:, class_id])) # 插值计算每个点的平均精度 ap = average_precision_score(sorted_ground_truths[:, class_id], sorted_detections[:, class_id+1]) ap_scores.append(ap) return np.mean(ap_scores)# 假设detections和ground_truths为检测结果和真实标签map_score = calculate_map(detections, ground_truths)print(f\'Mean Average Precision: {map_score}\')通过上述代码,我们计算了模型在所有类别上的mAP值,该值能够综合反映模型的检测性能。

以上就是深度学习在计算机视觉中应用的第五章内容。通过对图像表示方法、图像分类技术和目标检测方法的探讨,我们可以看到深度学习如何推动计算机视觉的发展。在接下来的章节中,我们将进一步探索深度学习在其他高级技术中的应用。

6. 进阶技术与应用实例

6.1 语义分割技术

6.1.1 语义分割的基本概念

语义分割技术是计算机视觉领域的一个核心任务,它旨在将图像分割成多个具有明确含义的区域,每个区域对应于一个特定的类别标签。不同于简单的图像分类,语义分割关注的是像素级别的分类,即为图像中的每一个像素分配一个类别标签。

这种技术广泛应用于自动驾驶、医学影像分析等地方,对于理解图像内容具有重要意义。语义分割通常需要大量标记数据进行训练,而且要求深度学习模型不仅要有高度的判别能力,还要有足够的空间分辨率来处理每个像素的分类问题。

6.1.2 全卷积网络(FCN)的应用实例

全卷积网络(FCN)是实现语义分割的一种有效网络结构。FCN摒弃了传统卷积神经网络中的全连接层,只由卷积层和池化层组成,这使得FCN可以接受任意尺寸的输入并产生相应大小的输出。

在具体应用中,一个FCN模型首先使用标准的卷积网络提取图像特征,然后通过上采样层逐步恢复图像的原始尺寸,从而对每个像素进行分类。例如,在自动驾驶场景中,FCN能够对路面、行人、车辆等进行精细的语义分割,从而为车辆导航提供重要的视觉信息。

# 示例:构建一个简单的FCN模型结构from keras.models import Modelfrom keras.layers import Input, Conv2D, Conv2DTranspose, MaxPooling2Ddef simple_fcn(input_shape): inputs = Input(shape=input_shape) conv1 = Conv2D(64, 3, activation=\'relu\', padding=\'same\', name=\'conv1\')(inputs) pool1 = MaxPooling2D(pool_size=(2, 2), name=\'pool1\')(conv1) conv2 = Conv2D(128, 3, activation=\'relu\', padding=\'same\', name=\'conv2\')(pool1) pool2 = MaxPooling2D(pool_size=(2, 2), name=\'pool2\')(conv2) conv3 = Conv2D(256, 3, activation=\'relu\', padding=\'same\', name=\'conv3\')(pool2) up1 = Conv2DTranspose(128, 2, strides=(2, 2), padding=\'same\', name=\'up1\')(conv3) merge1 = concatenate([conv2, up1], axis=3) up2 = Conv2DTranspose(64, 2, strides=(2, 2), padding=\'same\', name=\'up2\')(merge1) merge2 = concatenate([conv1, up2], axis=3) output = Conv2DTranspose(1, 2, strides=(2, 2), padding=\'same\', activation=\'sigmoid\', name=\'output\')(merge2) model = Model(inputs=[inputs], outputs=[output]) return modelmodel = simple_fcn((None, None, 3))model.summary()在上面的代码中,我们构建了一个简单的FCN模型。首先,我们定义了一个输入层,然后经过三次卷积和最大池化操作得到深层特征,接着通过转置卷积层进行上采样操作,最后通过一个卷积层输出每个像素的分类结果。

6.2 图像生成原理

6.2.1 生成对抗网络(GAN)的基本原理

生成对抗网络(GAN)是由两部分组成的神经网络系统:生成器(Generator)和判别器(Discriminator)。生成器的目标是生成尽可能真实的数据样本,而判别器的目标是区分真实数据和生成器生成的假数据。

在训练过程中,生成器尝试欺骗判别器,使其无法区分生成的数据和真实数据;与此同时,判别器学习变得更加擅长于识别假数据。随着训练的深入,两个网络互相竞争,最终达到一种动态平衡,生成器能够产生逼真的图像。

6.2.2 VAE(变分自编码器)及其与GAN的对比

变分自编码器(VAE)是另一种用于生成数据的深度学习模型。VAE通过编码器将数据映射到潜在空间的分布,然后通过解码器从这个潜在空间生成数据样本。与GAN不同,VAE使用概率分布来实现数据的生成,通常会得到更平滑、连续的生成样本。

虽然VAE和GAN都能够生成数据,但它们在生成数据的质量和多样性上存在差异。GAN因其生成的样本更加逼真、细节丰富而广受欢迎,而VAE则在生成可控性和数据连续性方面表现更佳。

6.3 面向CV的应用实例分析

6.3.1 自动驾驶中的视觉系统

在自动驾驶技术中,计算机视觉系统是实现车辆环境感知的关键。视觉系统通常包含一系列复杂的深度学习模型,用于执行语义分割、目标检测、物体跟踪等任务,帮助车辆识别道路边界、交通标志、行人和障碍物。

例如,语义分割技术能够帮助自动驾驶汽车准确地理解道路情况,包括车道线、行人道、植被和建筑等,从而进行安全行驶决策。此外,目标检测算法可以识别并追踪道路上的车辆、行人、自行车等动态对象,提高自动驾驶系统的安全性和可靠性。

6.3.2 医学影像分析中的深度学习应用

深度学习在医学影像分析领域同样具有巨大的潜力。例如,通过深度学习模型对CT、MRI图像进行分割,可以帮助医生更准确地诊断疾病,如癌症、肺炎等。此外,深度学习还可以用于预测疾病的发展趋势,为患者提供个性化的治疗方案。

在实际应用中,医生可以利用深度学习模型对影像进行预处理,提高图像质量和诊断效率。例如,通过图像去噪、增强对比度等技术,可以使得原本难以识别的病灶变得更加清晰,辅助医生进行准确判断。

在这些应用中,深度学习不仅仅是作为一个工具,而是成为推动医疗技术发展的重要动力,大大提高了疾病的诊断和治疗能力。

本文还有配套的精品资源,点击获取

简介:本讲义旨在为学习者提供深度学习和计算机视觉的基础知识,涵盖深度学习基础如神经网络结构、反向传播、激活函数等,以及计算机视觉领域的图像分类、目标检测和语义分割等关键技术。同时介绍了深度学习在实际领域如人脸识别、自动驾驶的应用,并详细探讨了著名的深度学习模型,包括训练和评估过程,以及目前流行的深度学习框架。通过本讲义的学习,学习者将获得全面的理论知识和实践能力。

本文还有配套的精品资源,点击获取