Docker搭建Hadoop分布式学习环境以及演示简单的文件上传_docker 可以安装hadoop 环境吗

目录

引言

1.环境准备与项目获取

2.镜像准备与容器启动

3.进入容器并启动Hadoop服务

4.文件上传演示

5.常见问题与优化

6.总结

7.附加

引言

1.环境准备与项目获取

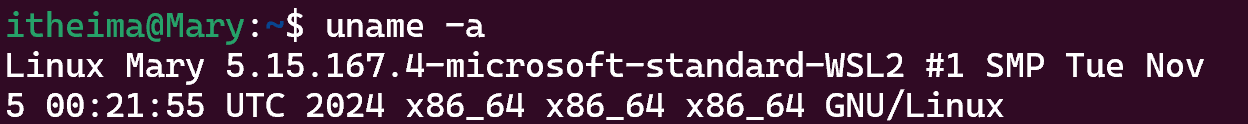

我的环境是win11系统,启用了WSL2,虚拟机是Ubuntu安装的Docker版本是28.2.2

- 查看自己的系统内核信息

uname -a

- 查看Docker版本

docker --version

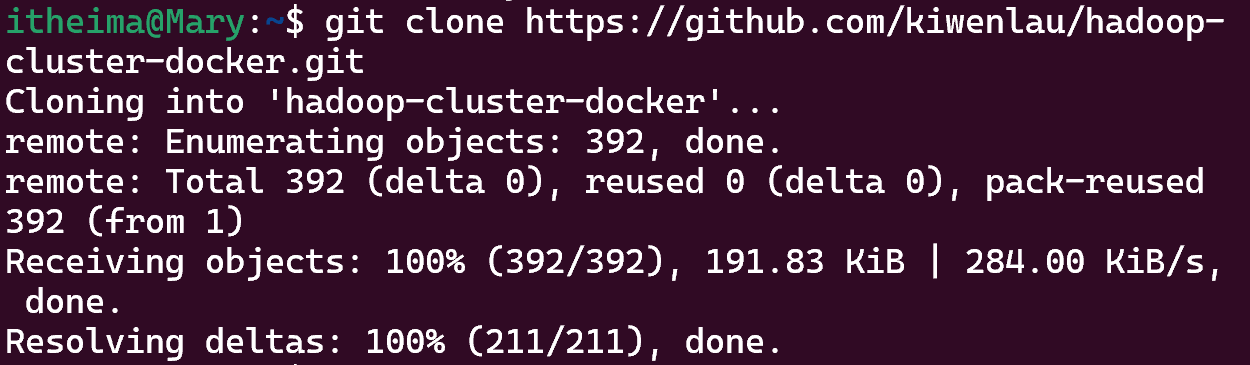

- 用GitHub上的这个项目https://github.com/kiwenlau/hadoop-cluster-docker

git clone https://github.com/kiwenlau/hadoop-cluster-docker.git

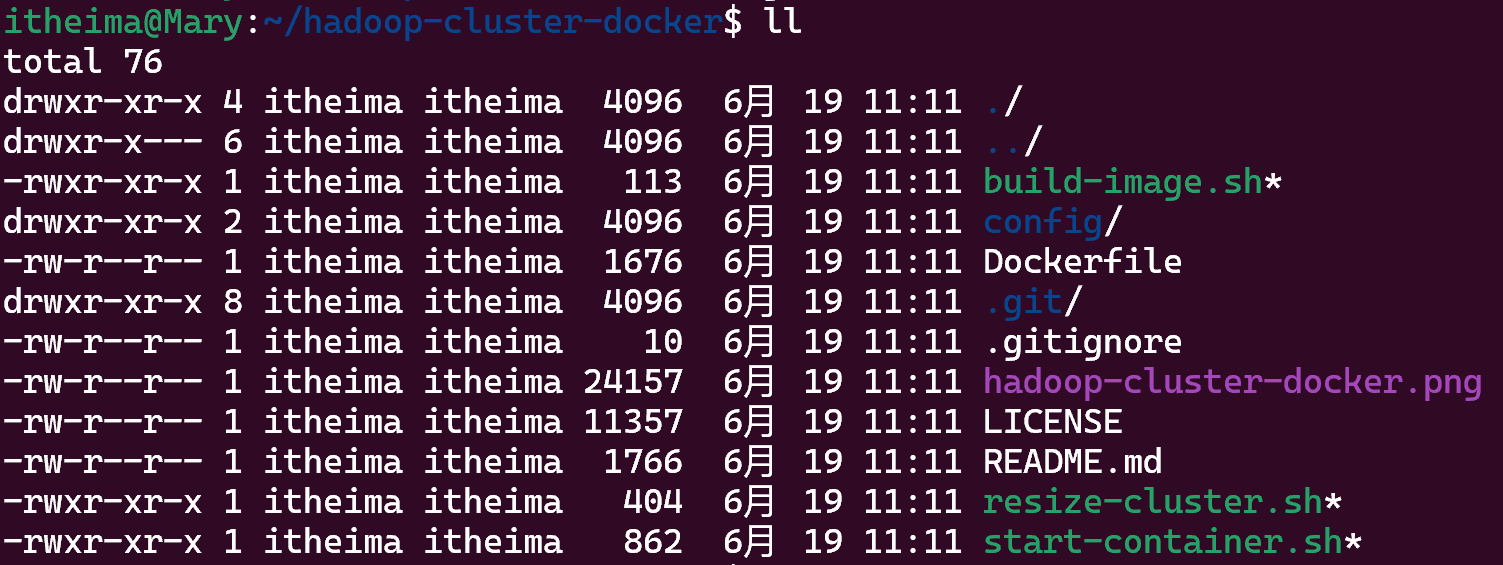

- 进入项目目录

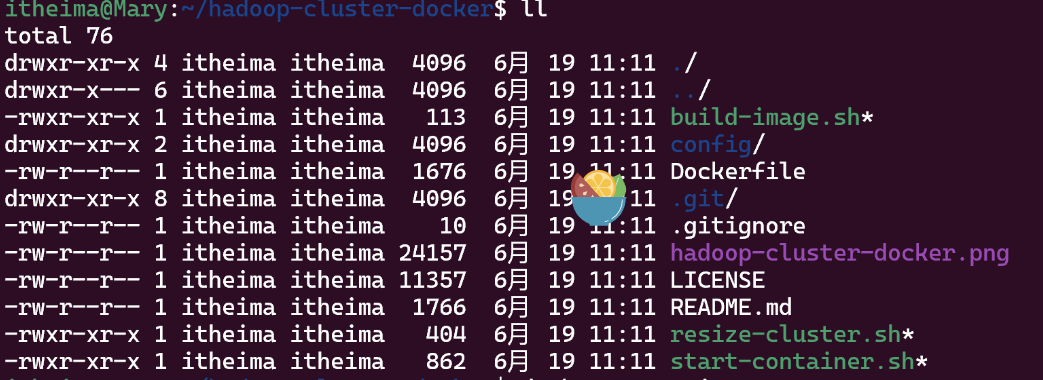

cd hadoop-cluster-dockerll查看项目结构

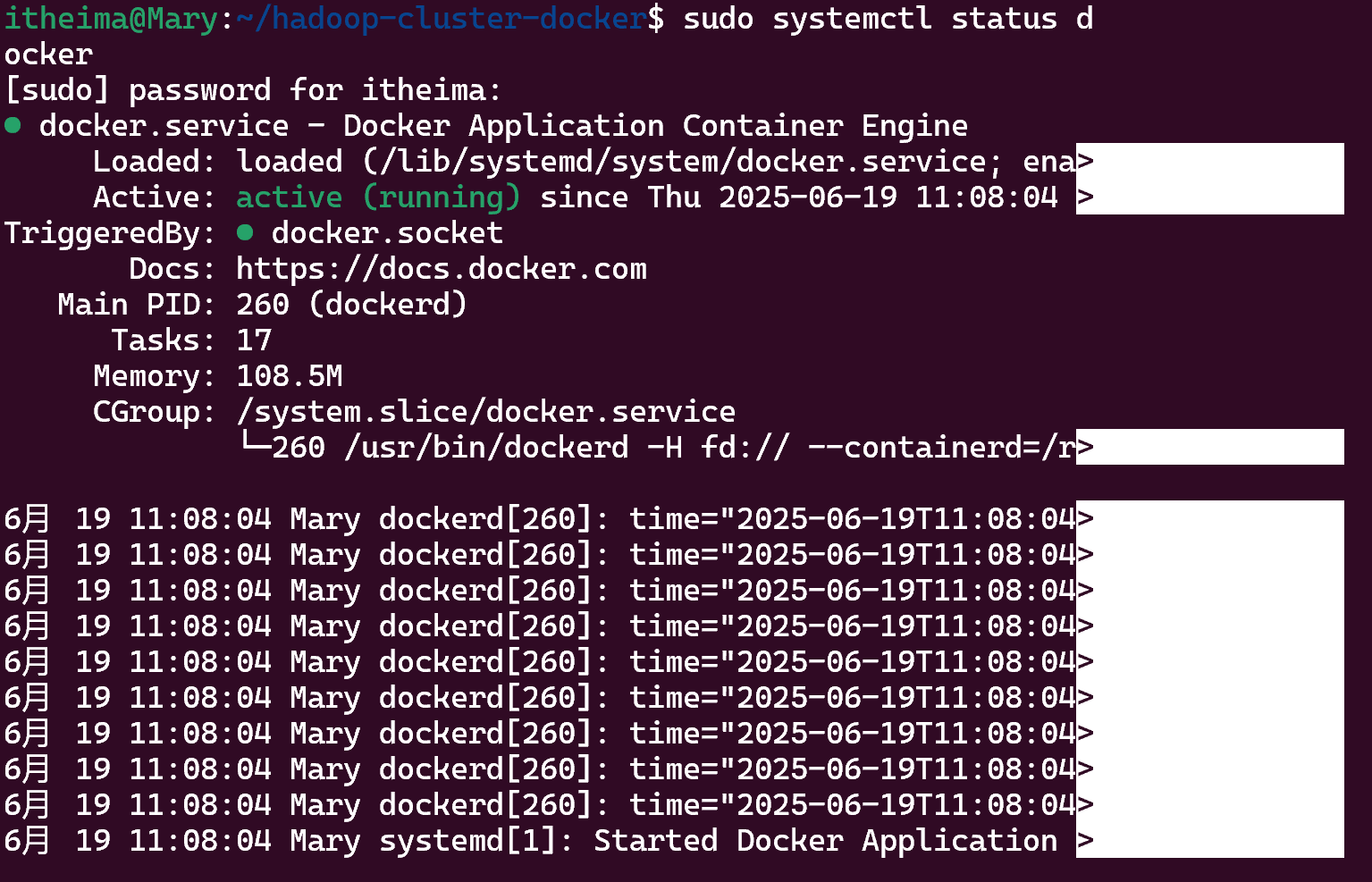

- 检查Docker状态

sudo systemctl status docker

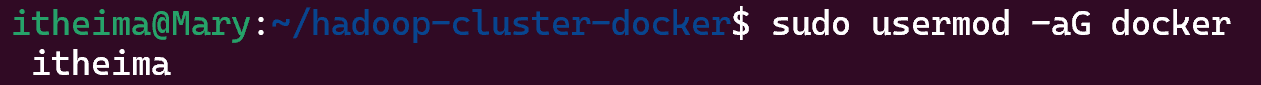

- 添加当前用户到docker组,避免每次使用sudo

sudo usermod -aG docker

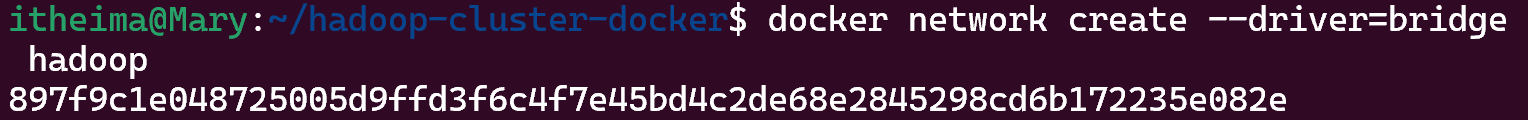

- 创建专用网络用于容器通行

docker network create --driver=bridge hadoop

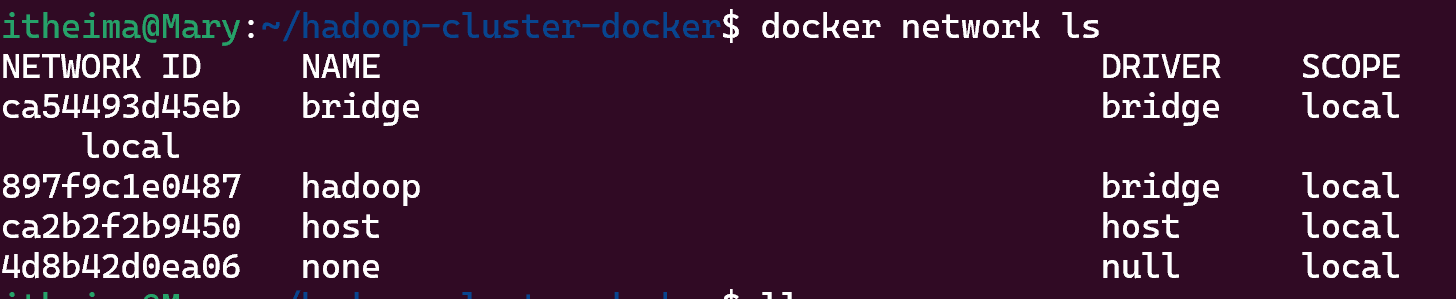

- 确认网络是否创建成功

docker network ls

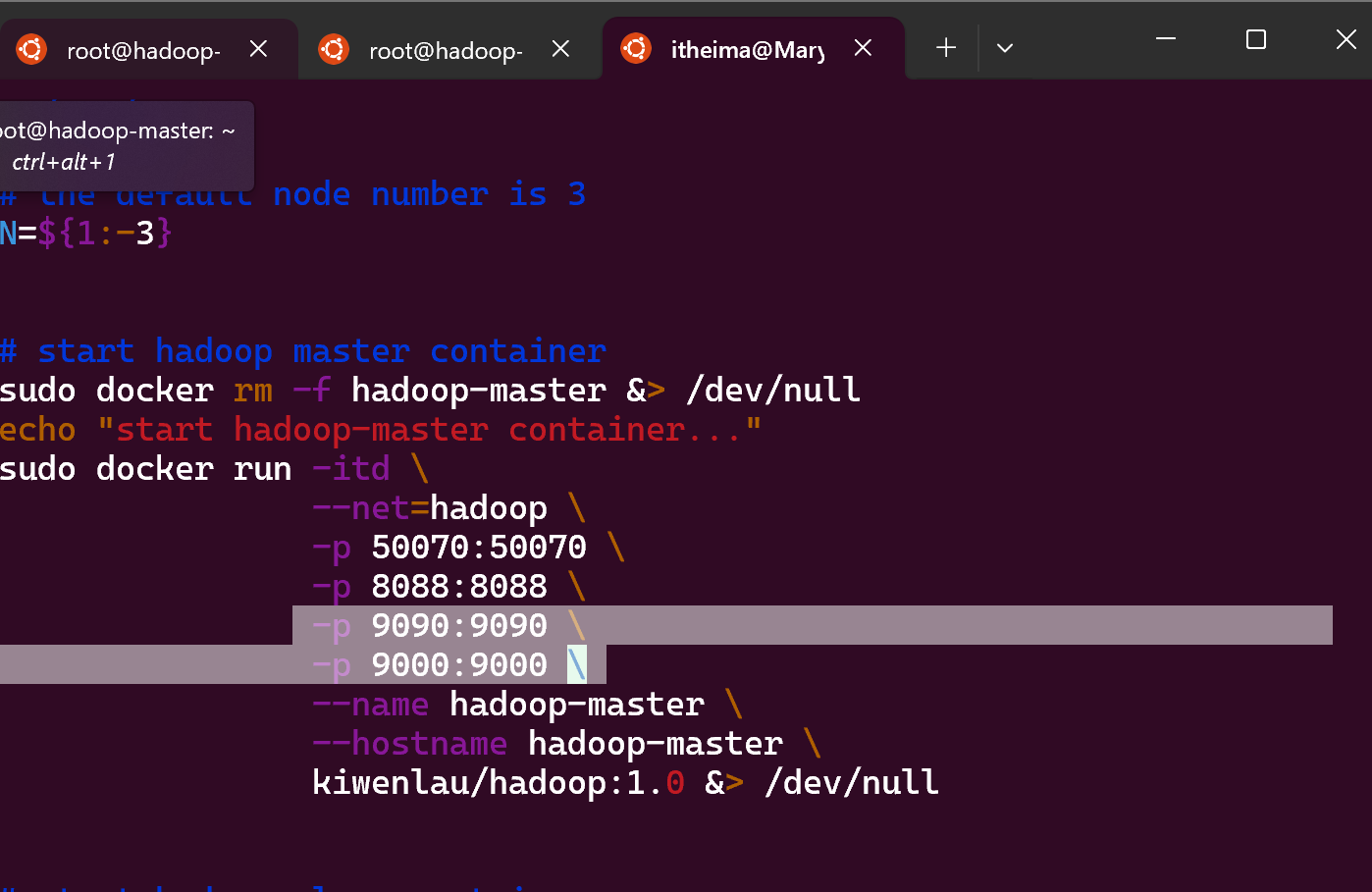

- 在start-container.sh文件中再添加两个开放的接口

vim start-container.sh

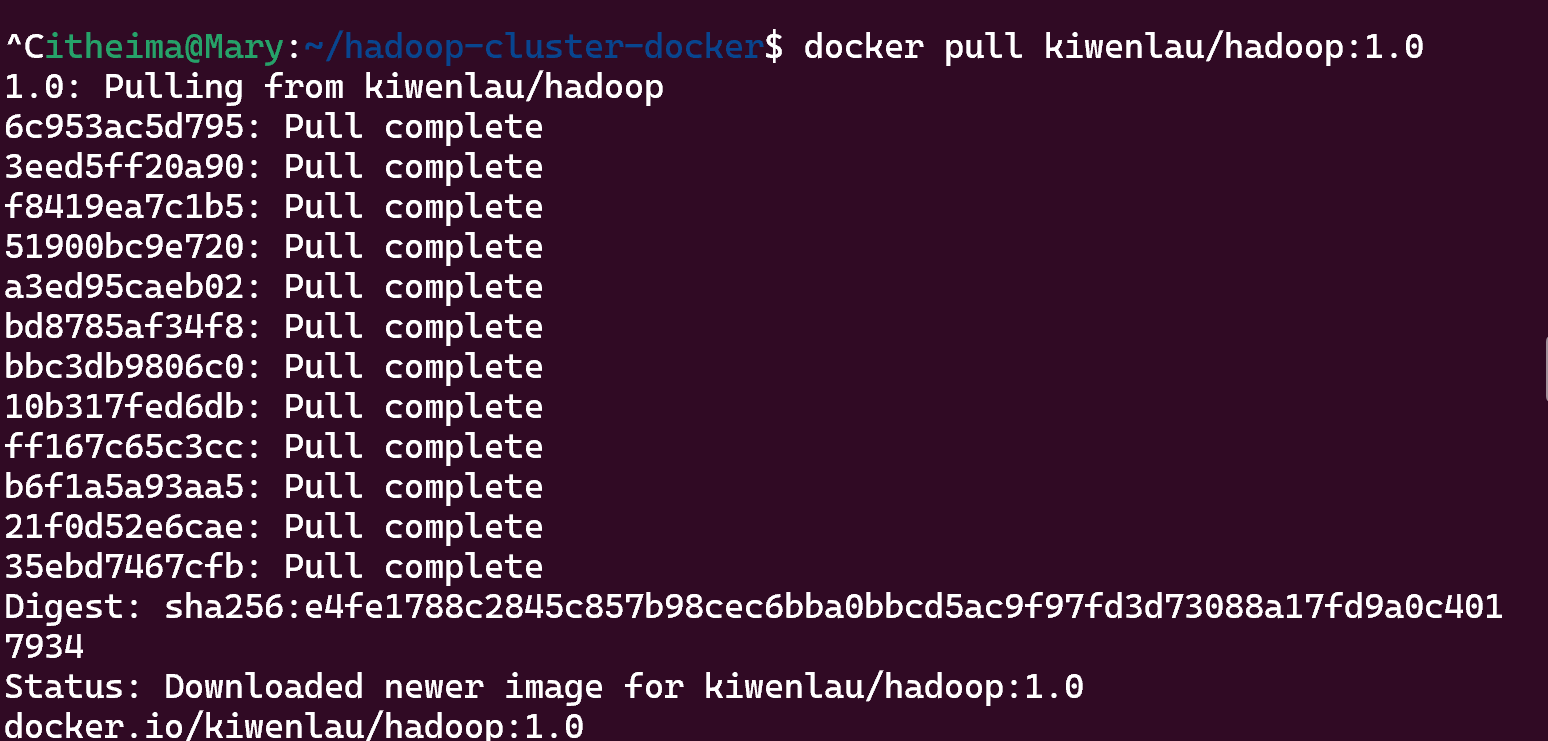

2.镜像准备与容器启动

- 拉取刚git的Hadoop镜像,过程大概要几分钟,耐心等候

docker pull kiwenlau/hadoop:1.0

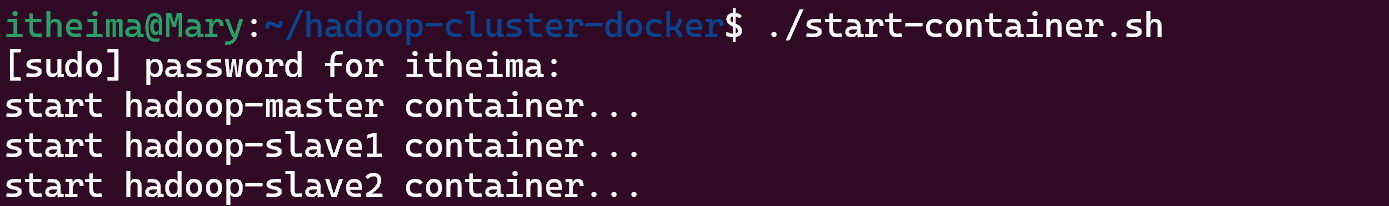

- 启动容器

./start-container.sh

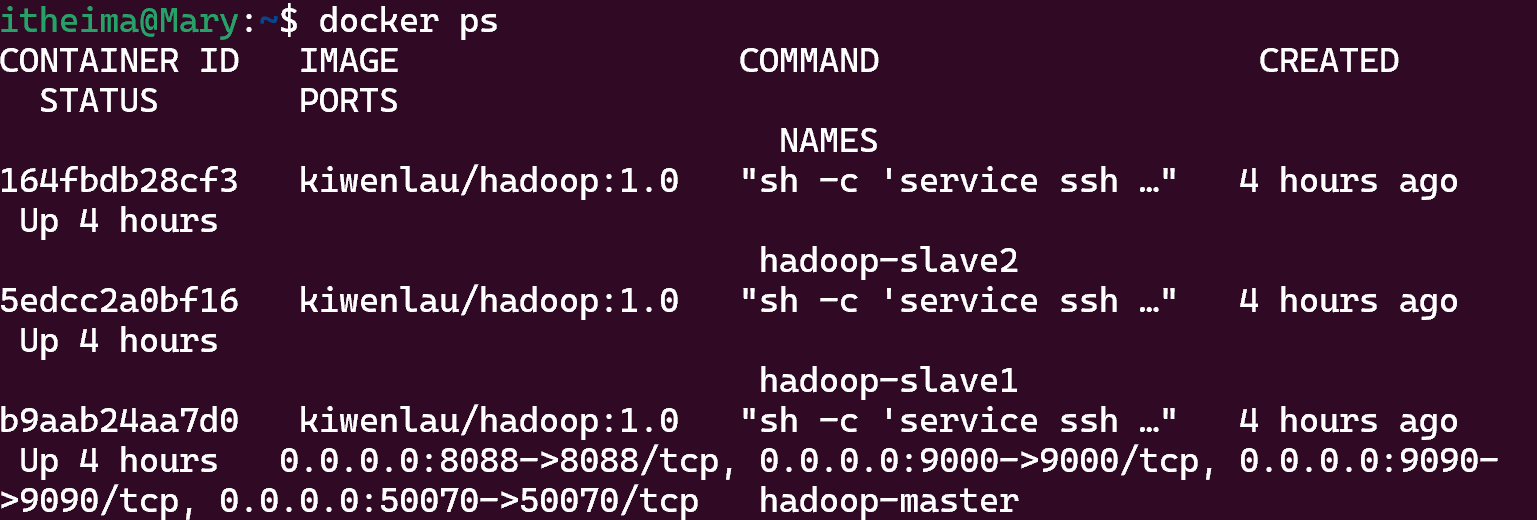

- 再开一个Ubuntu终端窗口查看运行中的容器

docker ps

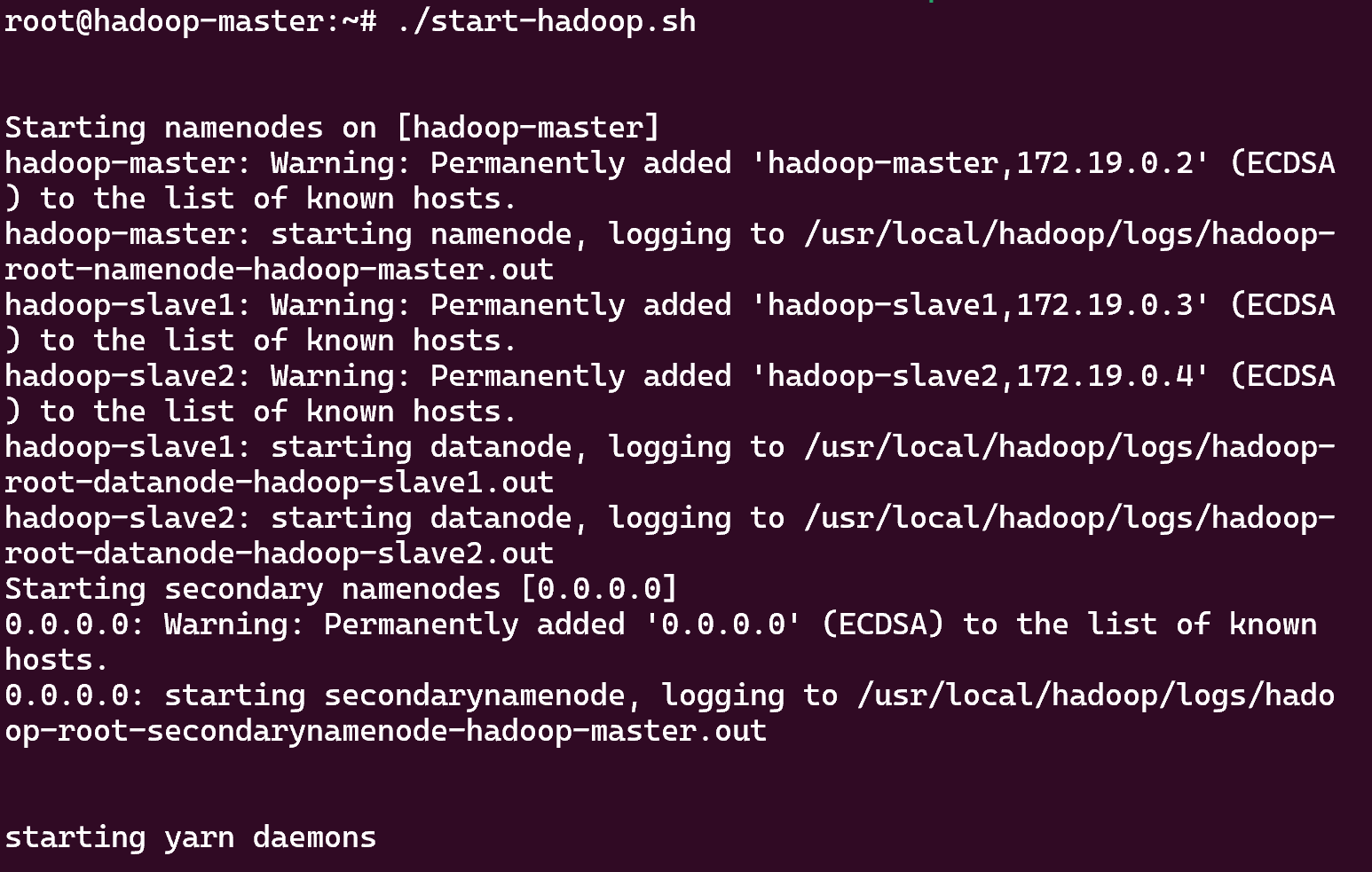

3.进入容器并启动Hadoop服务

- 在新终端窗口中进入主节点容器

docker exec -it hadoop-master bash

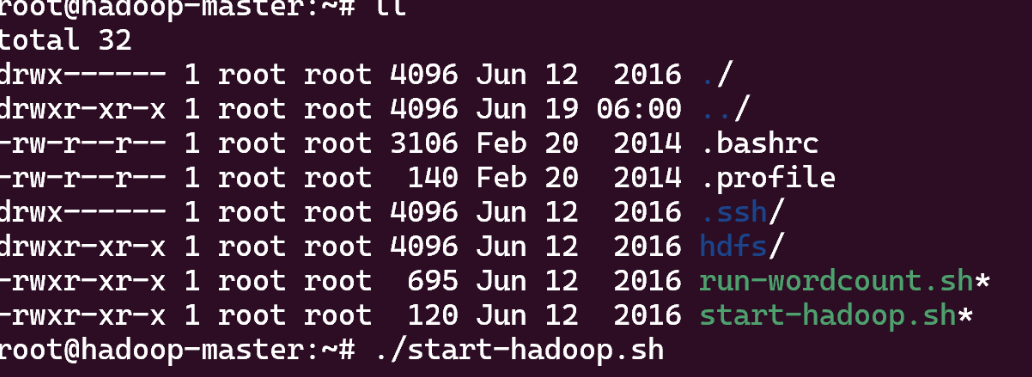

- 在容器内(旧终端窗口)中启动HDFS和YARN服务

./start-hadoop.sh

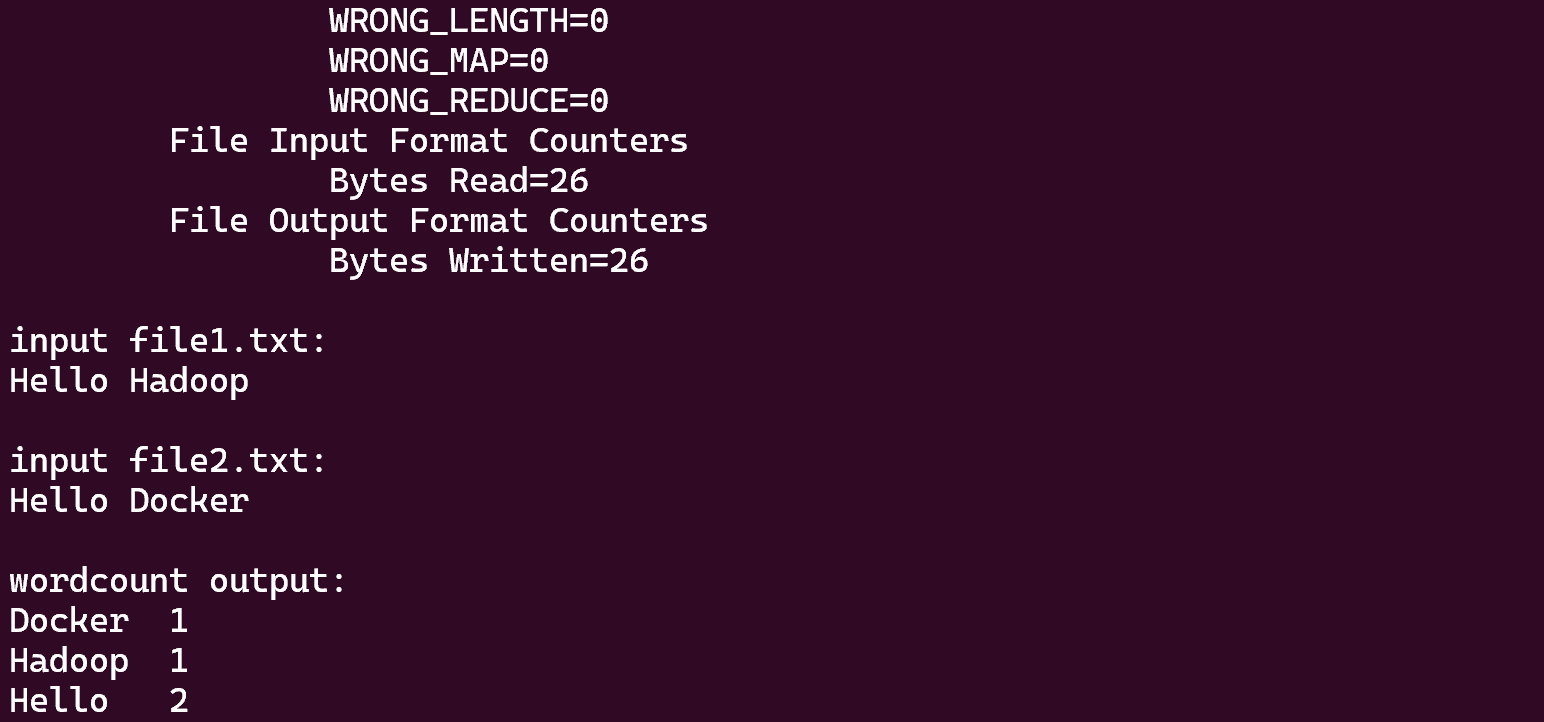

- 验证Hadoop集群功能 忽略掉一长串info最后得到这个

./run-wordcount.sh

4.文件上传演示

- 在容器内(旧终端窗口)创建测试文件,进入之后输入想要的内容

vi test1.txt

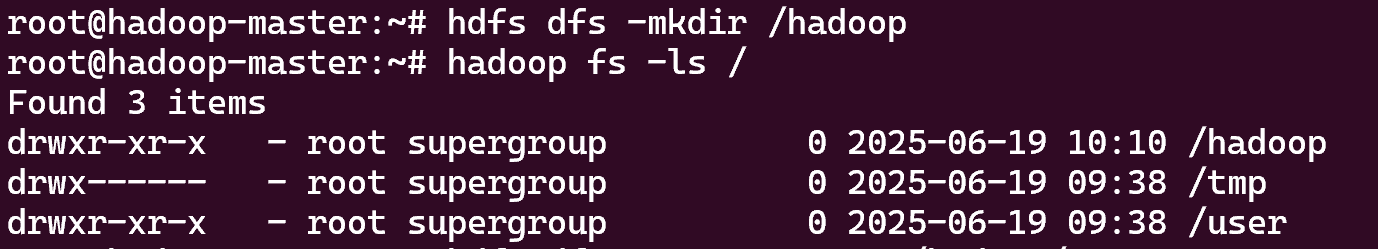

- 在HDFS创建目录并查看

hdfs dfs -mkdir /hadoop

- 上传文件到HDFS,查看HDFS目录内容

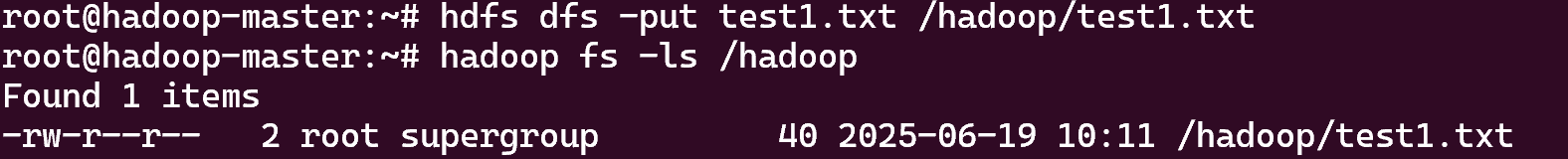

hdfs dfs -put test1.txt /hadoop/test1.txthadoop fs -ls /hadoop

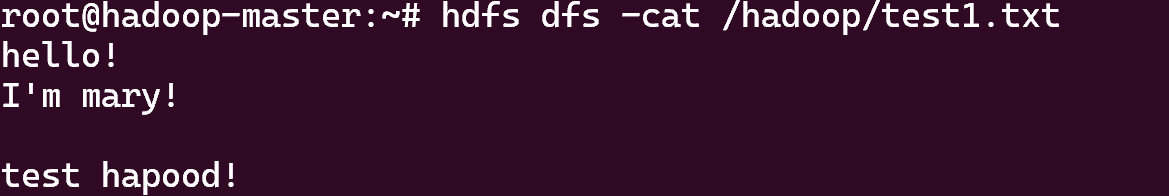

- 查看文件内容

hdfs dfs -cat /hadoop/test1.txt

5.常见问题与优化

hadoop-cluster-docker项目的目录,start-container.sh脚本可以一键启动 Hadoop 集群容器(创建并运行 master + slave 节点)

- Hadoop 集群的

hadoop-master节点容器,run - wordcount.sh脚本运行 MapReduce 单词统计示例(验证 Hadoop 集群功能的常用测试脚本) start - hadoop.sh脚本启动 Hadoop 集群服务

6.总结

- 强调Docker化Hadoop对学习与开发的效率提升。

7.附加

- itheima是我刚学虚拟机看黑马网课设置的,本人和黑马机构没有任何关系,只是懒得找改名教程改名,如有侵权请提醒我立刻改名