阿里开源 Wan2.2:视频生成迈入电影级时代,部署教程全解析_wan2.2部署

0.前言

阿里巴巴于2025年7月28日正式开源了Wan2.2 作为阿里云推出的升级版视频生成模型,凭借其先进的技术架构、开源特性以及丰富的功能,为视频生成领域带来了新的可能性。随着技术的不断进步,Wan2.2 将在短剧、广告、电影等多个领域发挥重要作用,推动整个行业向前发展

一张图给大家展示

下面详细给大家介绍一下它的技术和能力亮点。

1.核心技术与能力亮点

-

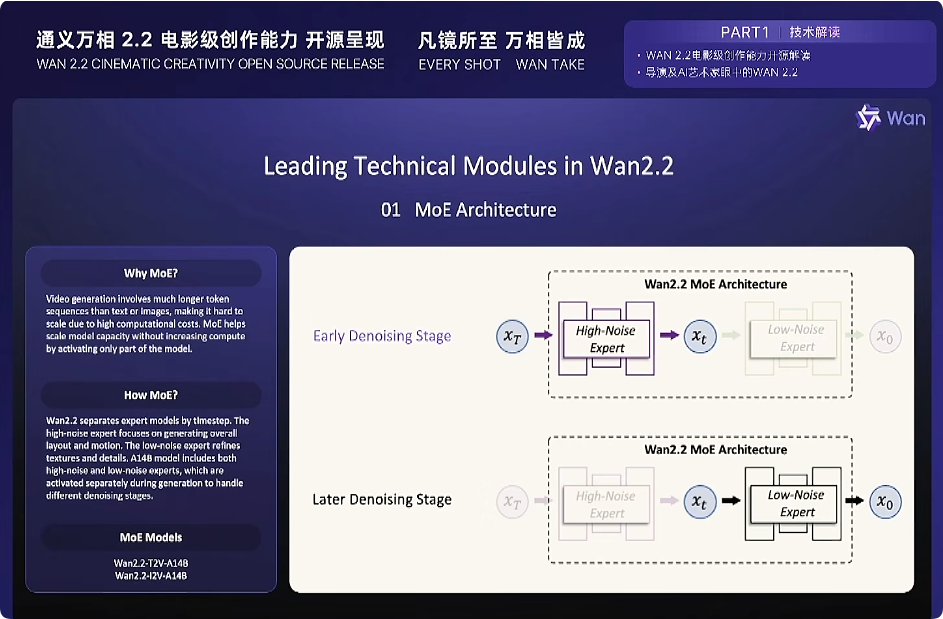

有效的 MoE 架构

Wan2.2 在视频扩散模型中引入了混合专家(MoE)架构。通过使用专门的强大专家模型跨时间步分离去噪过程,这扩大了整体模型容量,同时保持相同的计算成本。

-

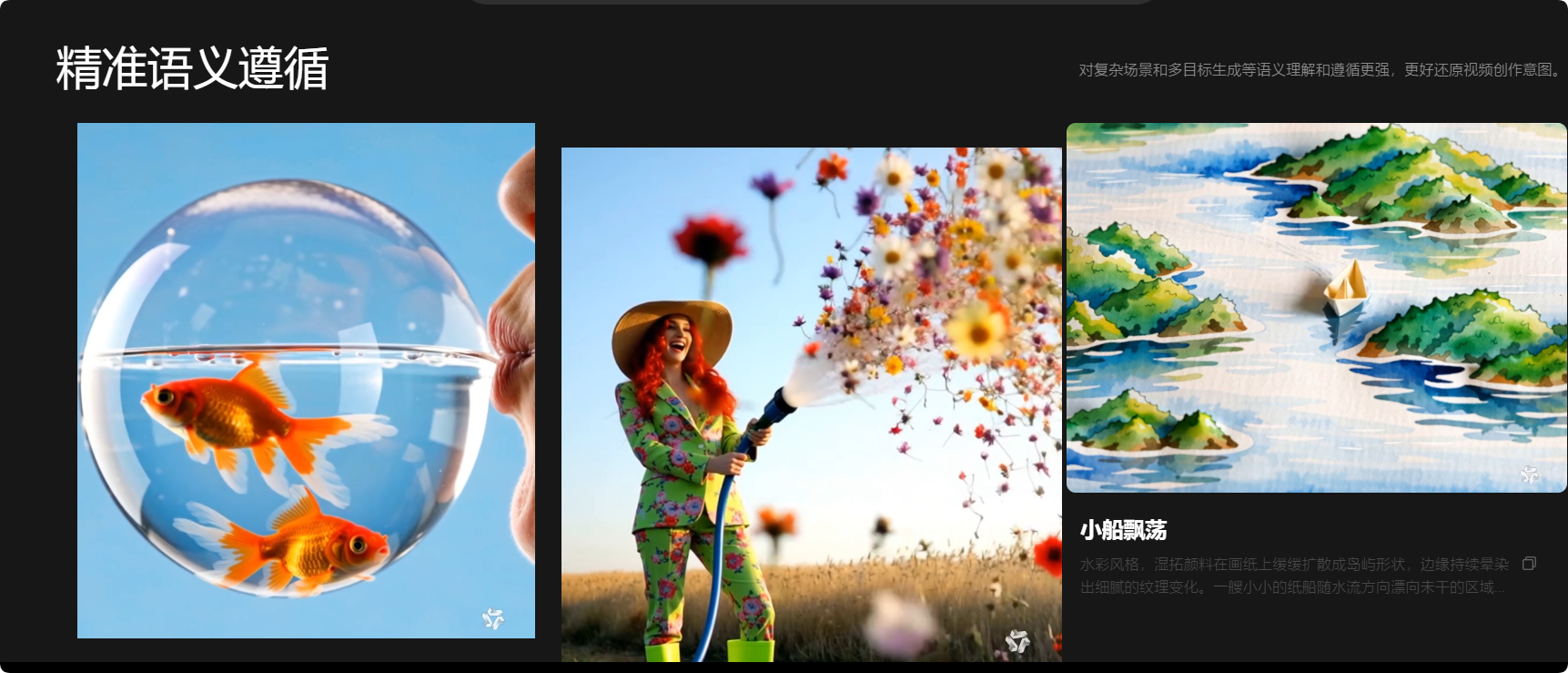

电影级美学

Wan2.2 引入了精心策划的美学数据,包含详细的照明、构图、对比度、色调等标签。这使得电影风格的生成更加精确和可控,便于创建具有可定制美学偏好的视频。

-

复杂的运动生成

与 Wan2.1 相比,Wan2.2 训练的数据量显著增加,图像增加了 +65.6%,视频增加了 +83.2%。这一扩展显著增强了模型在多个维度上的泛化能力,如运动、语义和美学,在所有开源和闭源模型中达到了顶级性能。

-

高效的高清混合TI2V****

Wan2.2 开源了一个基于我们先进的 Wan2.2-VAE 构建的 5B 模型,实现了 16×16×4 的压缩比。该模型支持 720P 分辨率、24fps 的文本到视频和图像到视频生成,并且可以在消费级显卡(如 4090)上运行。它是目前可用的最快的 720P@24fps 模型之一,能够同时服务于工业和学术领域。

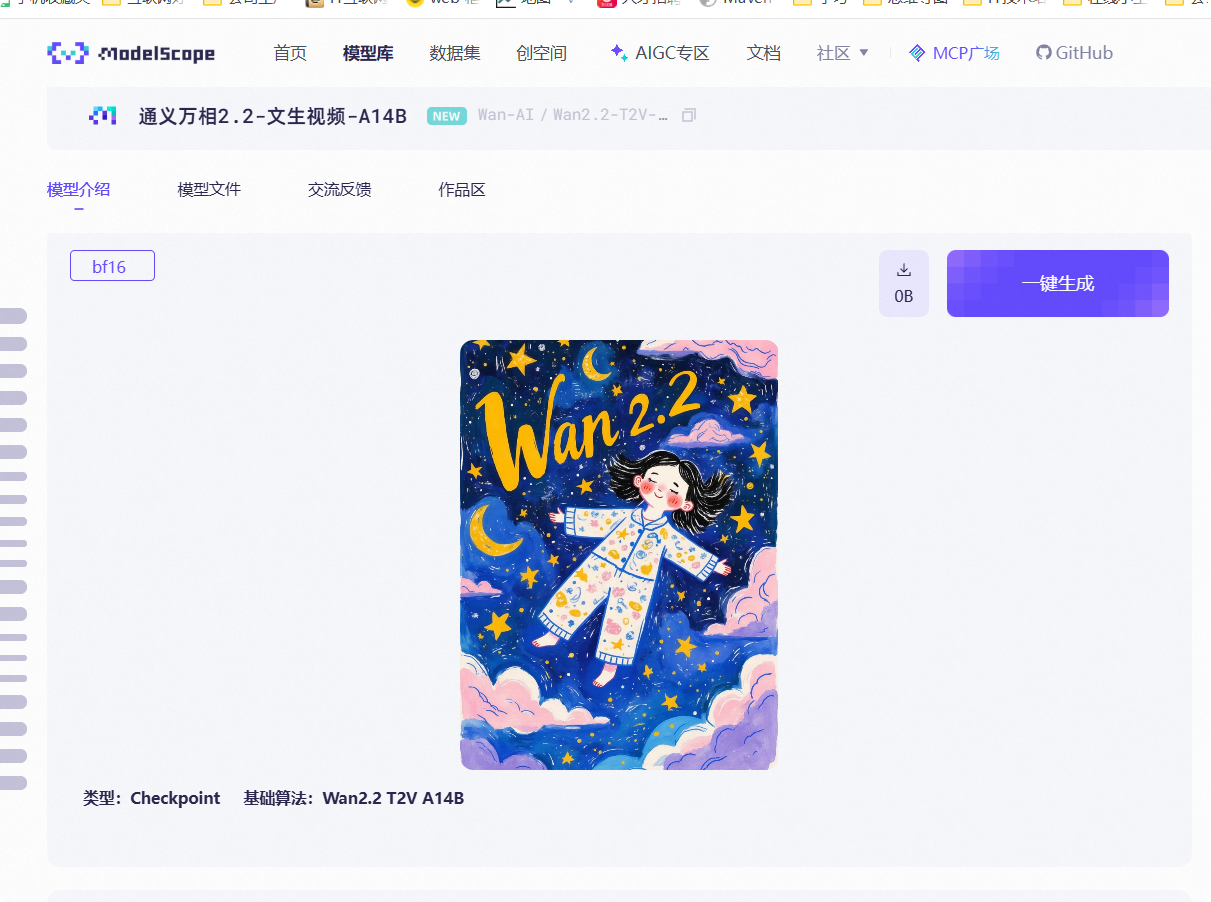

目前开源的有3个版本万相2.2-文生视频-A14B、万相2.2-图生视频-A14B、万相2.2-图文生视频-5B

1.万相2.2-文生视频-A14B

文生视频-A14B 模型支持生成时长为5秒、分辨率为480P和720P的视频。该模型采用混合专家模型(MoE)结构,提供了卓越的视频生成质量。在我们全新的基准测试集Wan-Bench 2.0 上,该模型在大多数关键评估维度上均超越了领先的商业模型。

2.万相2.2-图生视频-A14B

图生视频-A14B模型是一款专为图生视频设计的模型,支持480P和720P两种分辨率。该模型采用混合专家模型(MoE)结构,实现了更稳定的视频生成,减少了不合理的镜头移动,并为多样化的风格化场景提供了更好的支持。

3.万相2.2-图文生视频-5B

图文生视频-5B 模型基于先进的万相2.2-VAE 构建,实现了 16×16×4 的压缩率。该模型支持以 24fps 的帧率生成 720P 分辨率的文生视频和图生视频,并且可以在单张消费级GPU(如 4090)上运行。它是目前速度最快的 720P@24fps模型之一,能够同时满足行业应用和学术研究的需求。

目前模型已经托管在ModeScope 、Hugging face、LiblibAI、TensorArt & Tuse、SeaArt AI 等平台托管。

上面给大家展示了模型的能力, 效果到底如何呢?下面手把手带大家在启智平台部署和搭建,我们感受一下吧。

2.模型部署

模型社区启动资源

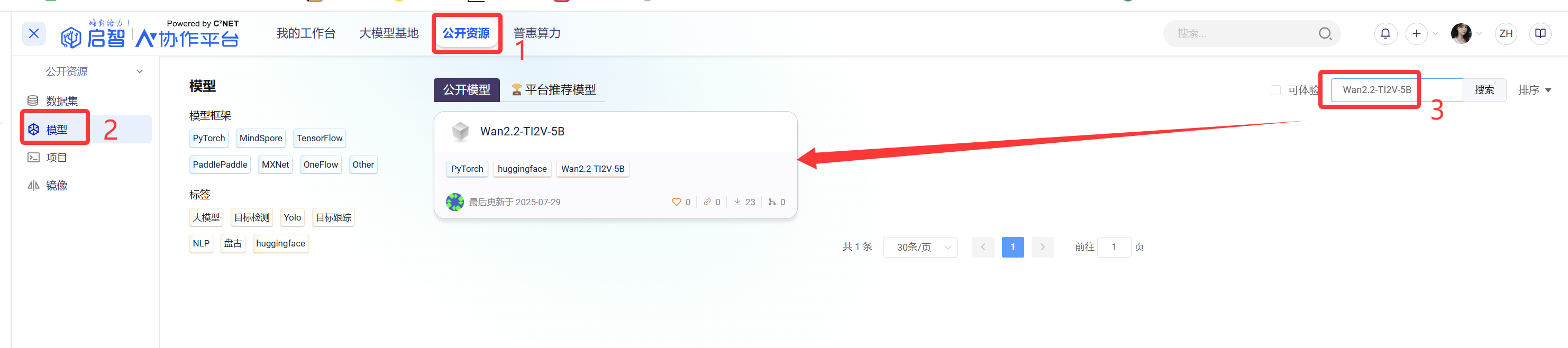

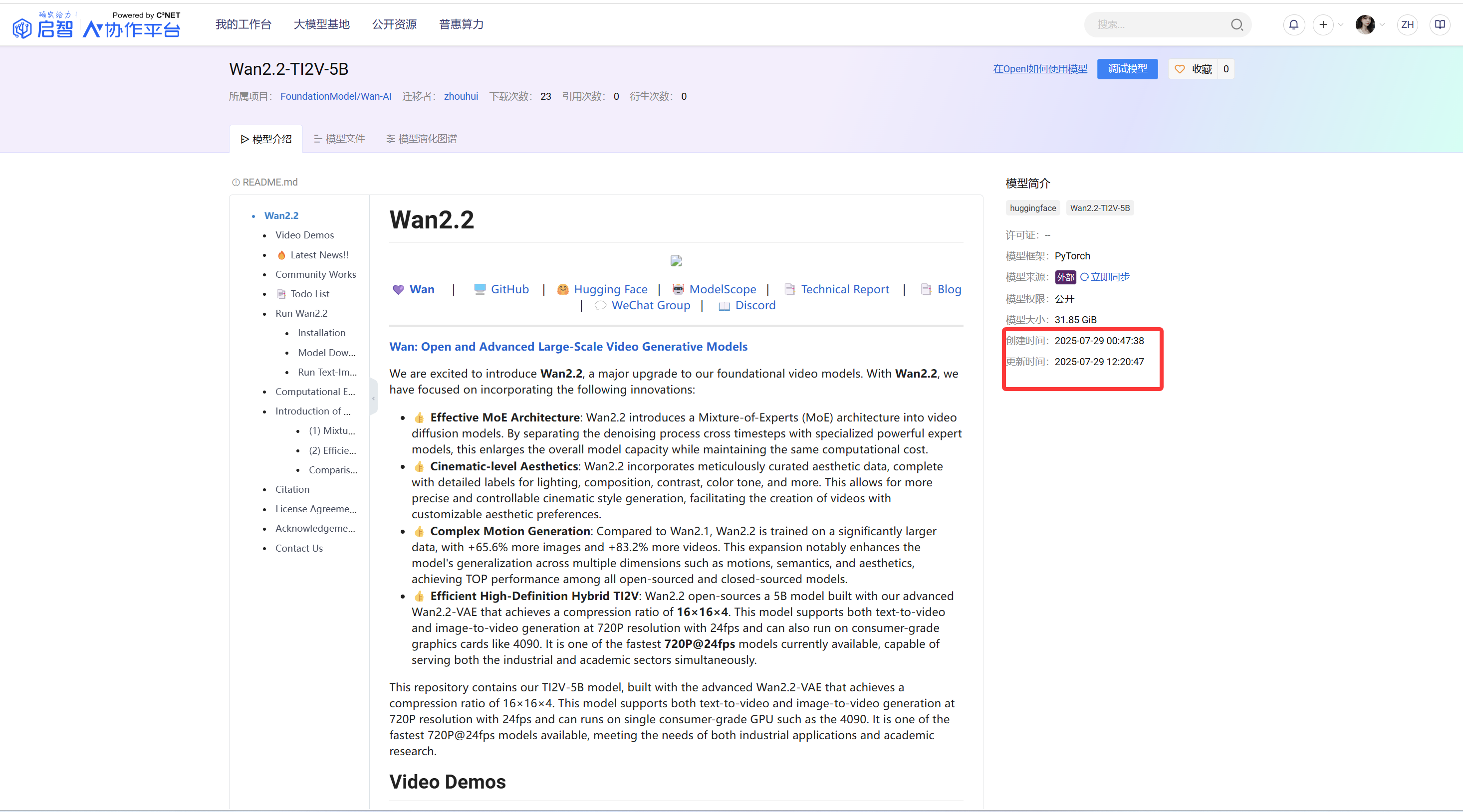

登录启智算力平台https://openi.pcl.ac.cn/

在公开资源-模型-查找-Wan2.2-TI2V-5B

我们点开这个模型 可以看到模型相关信息,模型是我昨天晚上迁移到7月29日中午才全部迁移完成。(迁移启智平台后面模型加载就快了)

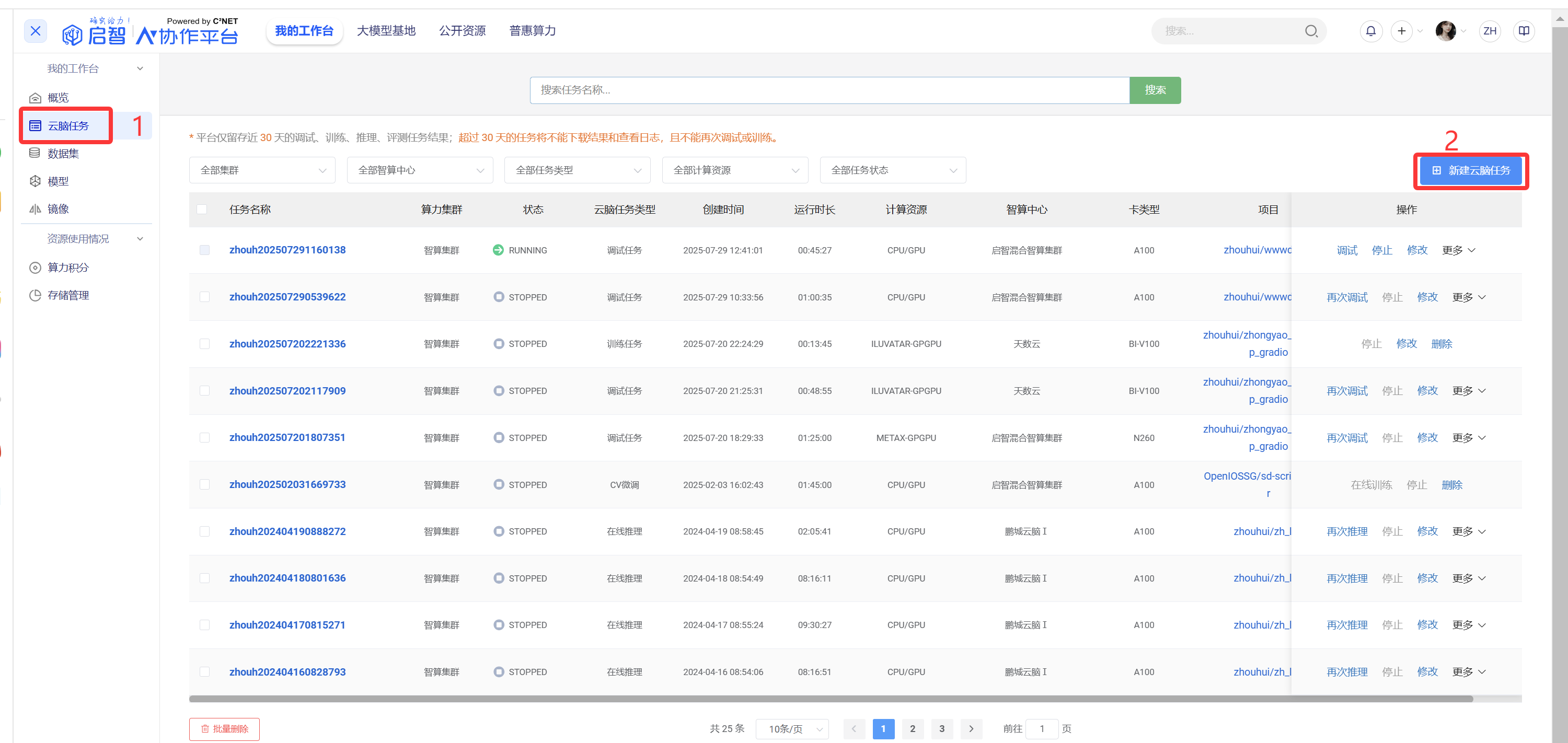

接下来我们在云脑任务中创建一个模型训练任务

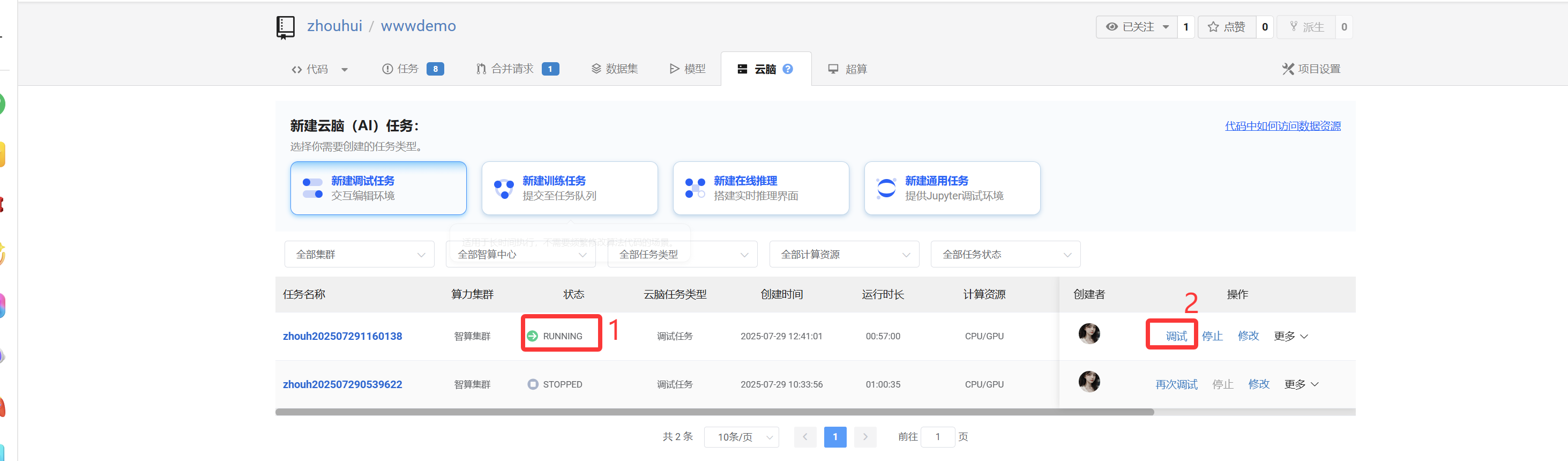

创建好新项目后点击云脑,创建调试任务

在新建调试任务中我们选择下面的资源。

计算资源:英伟达GPU

资源规格:GPU1*A100(显存:40GB) CPU:8 内存:50GB

参数设置 这里我们主要是选择镜像 和选择模型

镜像可用填写魔搭社区提供的最新的镜像modelscope-registry.us-west-1.cr.aliyuncs.com/modelscope-repo/modelscope:ubuntu22.04-cuda12.4.0-py311-torch2.6.0-1.28.0-LLM

把这个填入到模型镜像输入框中

当然也可以从选择镜像中选择平台提供的模型镜像,这块主要考虑平台镜像比较老,不一定满足最新模型的调试,我这里就用魔搭社区提供的镜像。

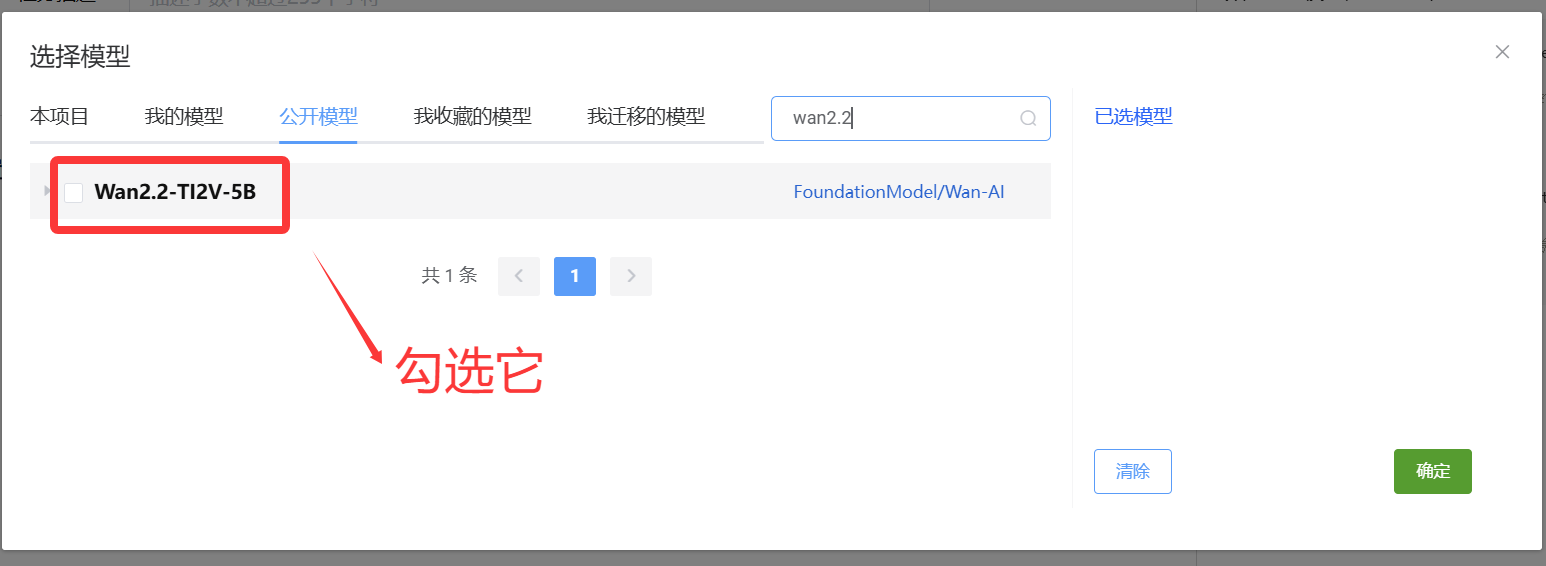

选择模型 这我们可以选择我上面下载好的模型

当然如果我们不勾选镜像,进入容器内部在下载也可以的,考虑模型启动时间我们这里先不加载模型。

上面设置好后,就可以点击 点击新建任务创建等待服务器分配资源了。

等待服务器分配好资源后如下图,当服务器资源状态是RUNNING 状态后,点击调试按钮进入nodebook界面

模型下载

我们进入nodebook调试界面看到下面的界面

接下来我们需要把模型权重下载下来。

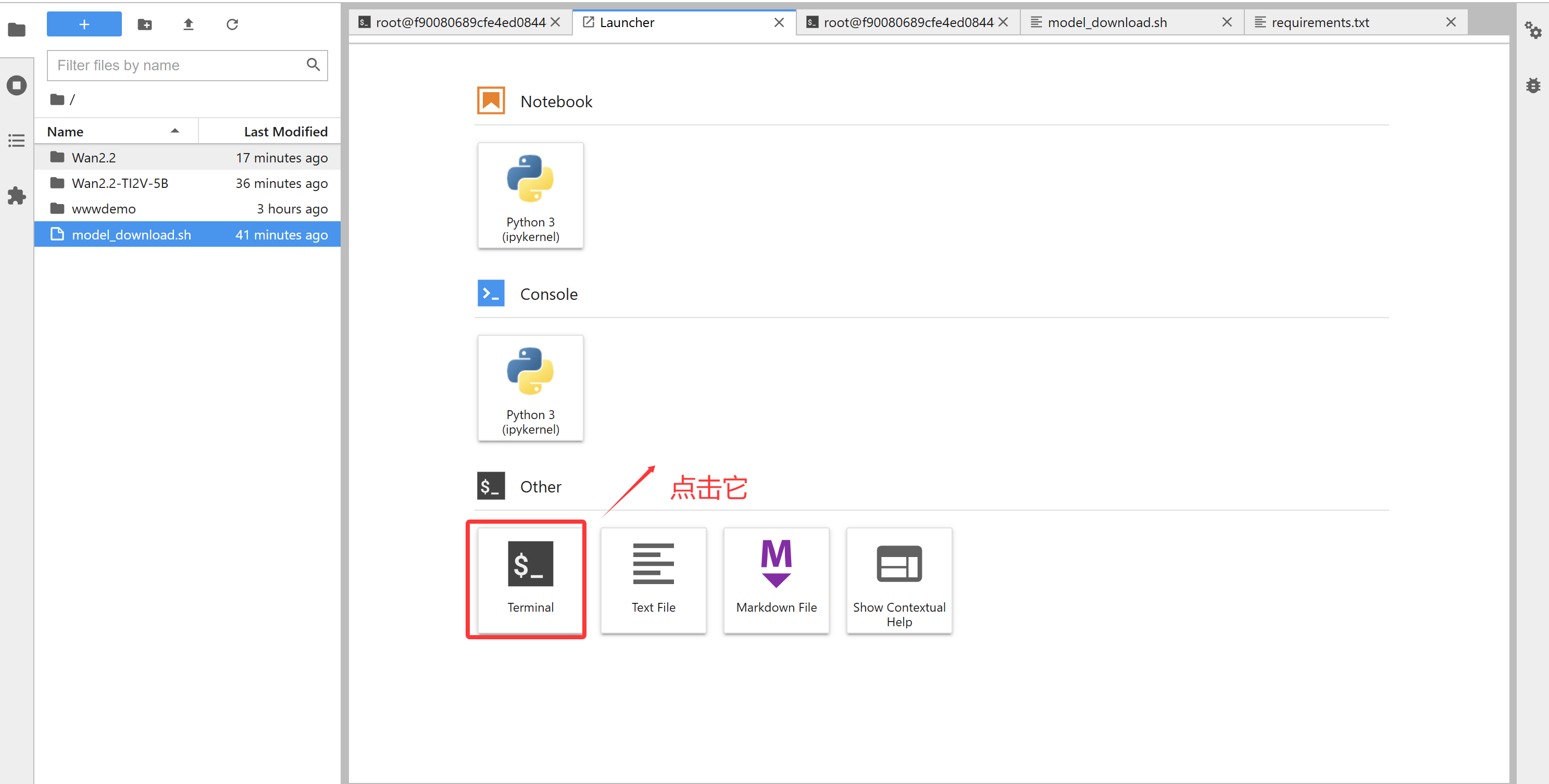

我们打开一个终端命令

在shell窗口中,我们输入下面命令下载模型权重

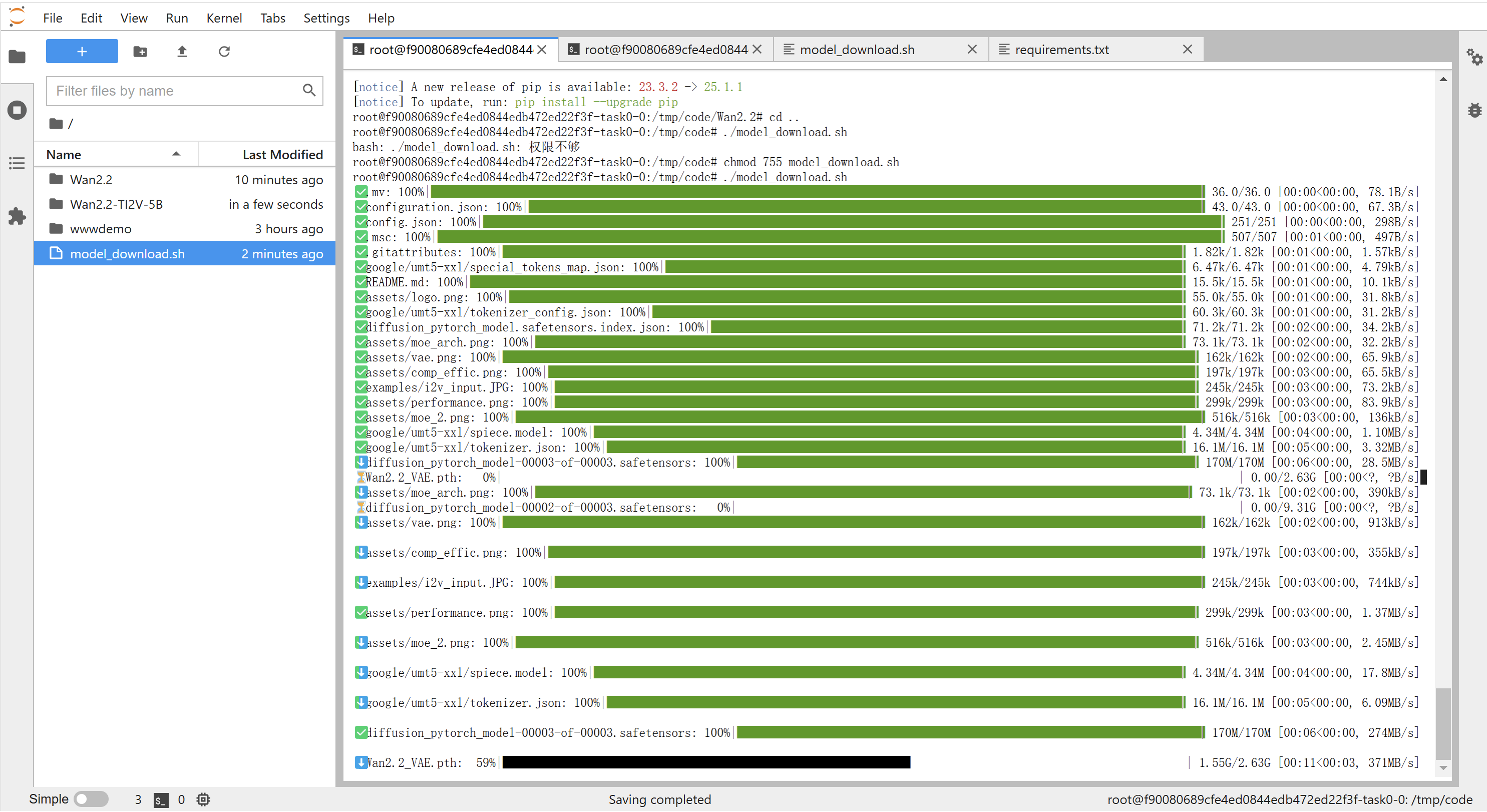

#启智平台pip install openi -U chmod 755 model_download.sh ./model_download.sh这里我们刚才是没下载模型的,所以我们可以借助一个叫做model_download.sh 脚本来实现模型权重的下载

model_download.sh

#!/bin/bash# 定义变量model_user_name=\" FoundationModel/Wan-AI\"model_name=\"Wan2.2-TI2V-5B\"save_path=\"/tmp/code/Wan2.2-TI2V-5B\"# 检查保存路径是否存在,如果不存在则创建if [ ! -d \"$save_path\" ]; then mkdir -p \"$save_path\"fi# 调用 openi 命令下载模型openi model download $model_user_name $model_name --save_path $save_path

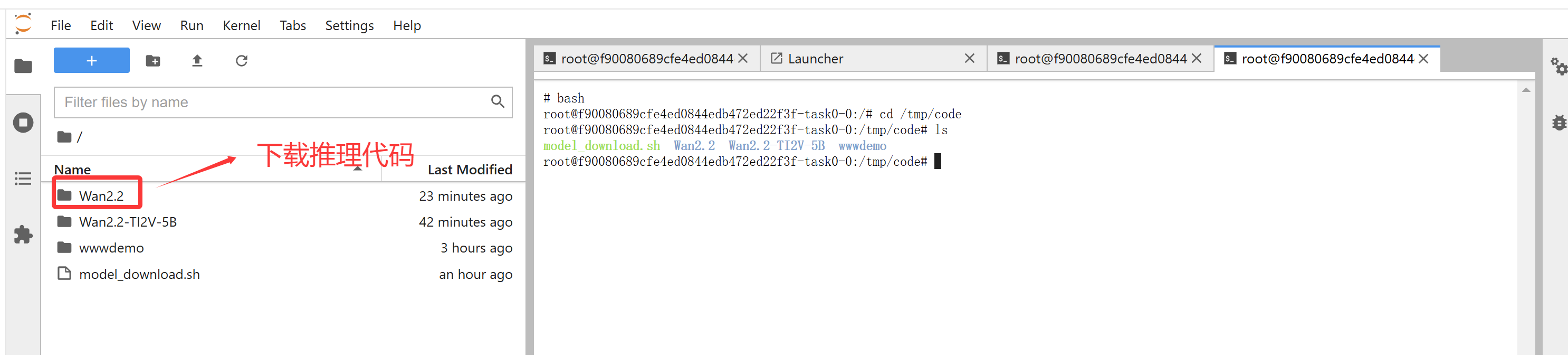

模型推理

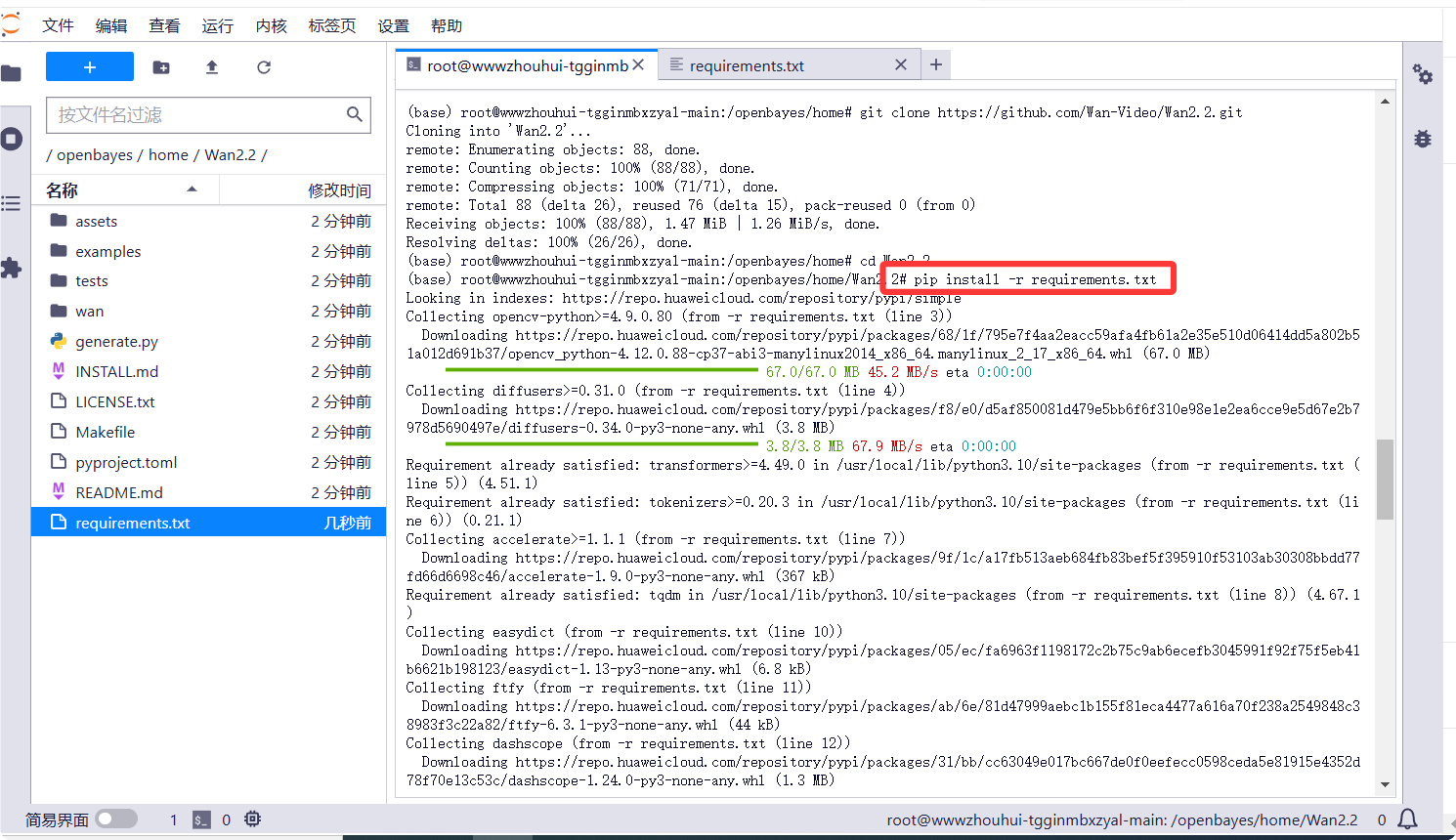

接下来我们在github上下载模型推理代码,我们在shell窗口输入如下命令

git clone https://ghfast.top/https://github.com/Wan-Video/Wan2.1.gitcd Wan2.1

依赖包的安装

pip install -r requirements.txt

cli inference

接下来来我们使用cli 命令行测试验证一下模型是否能够推理成功

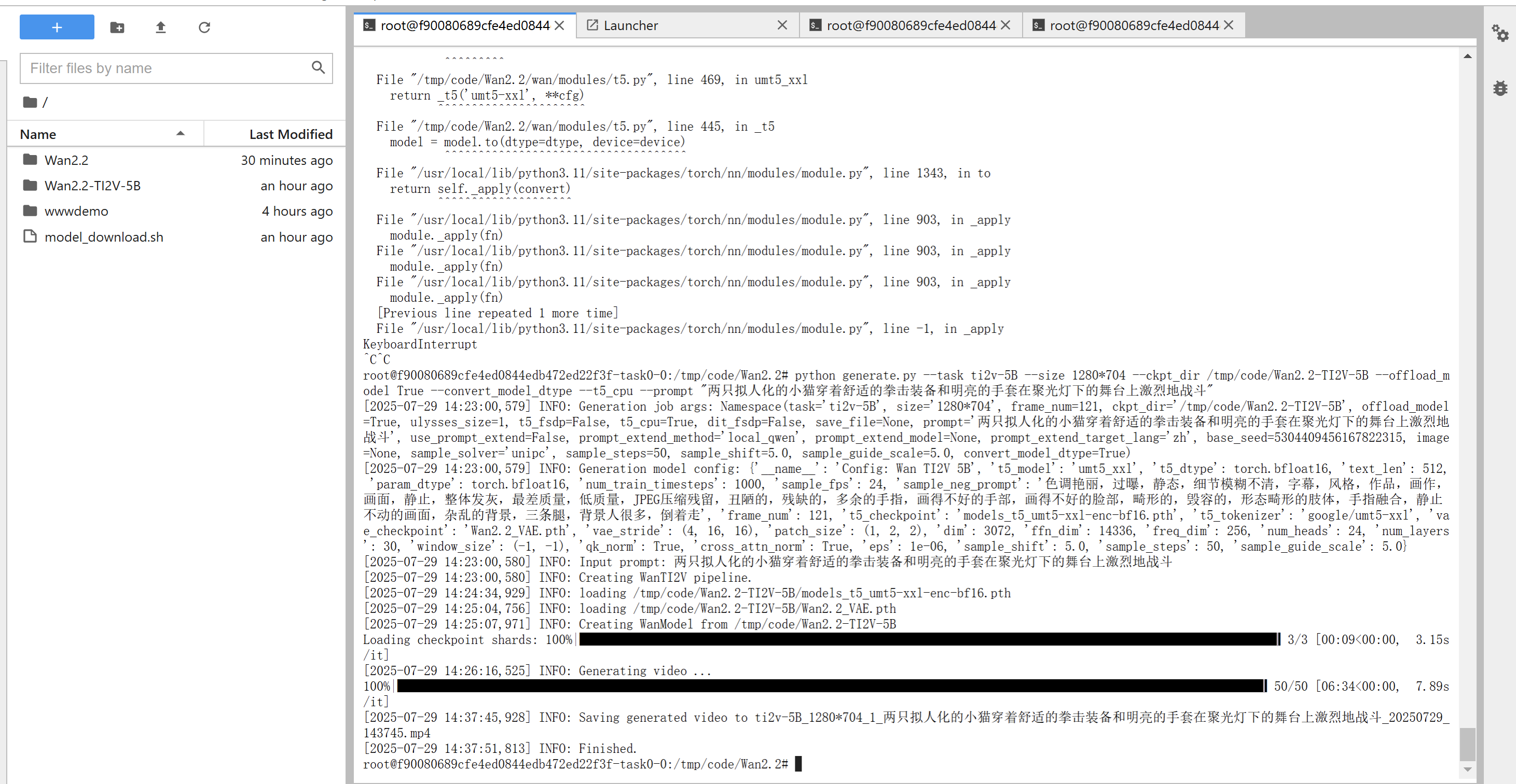

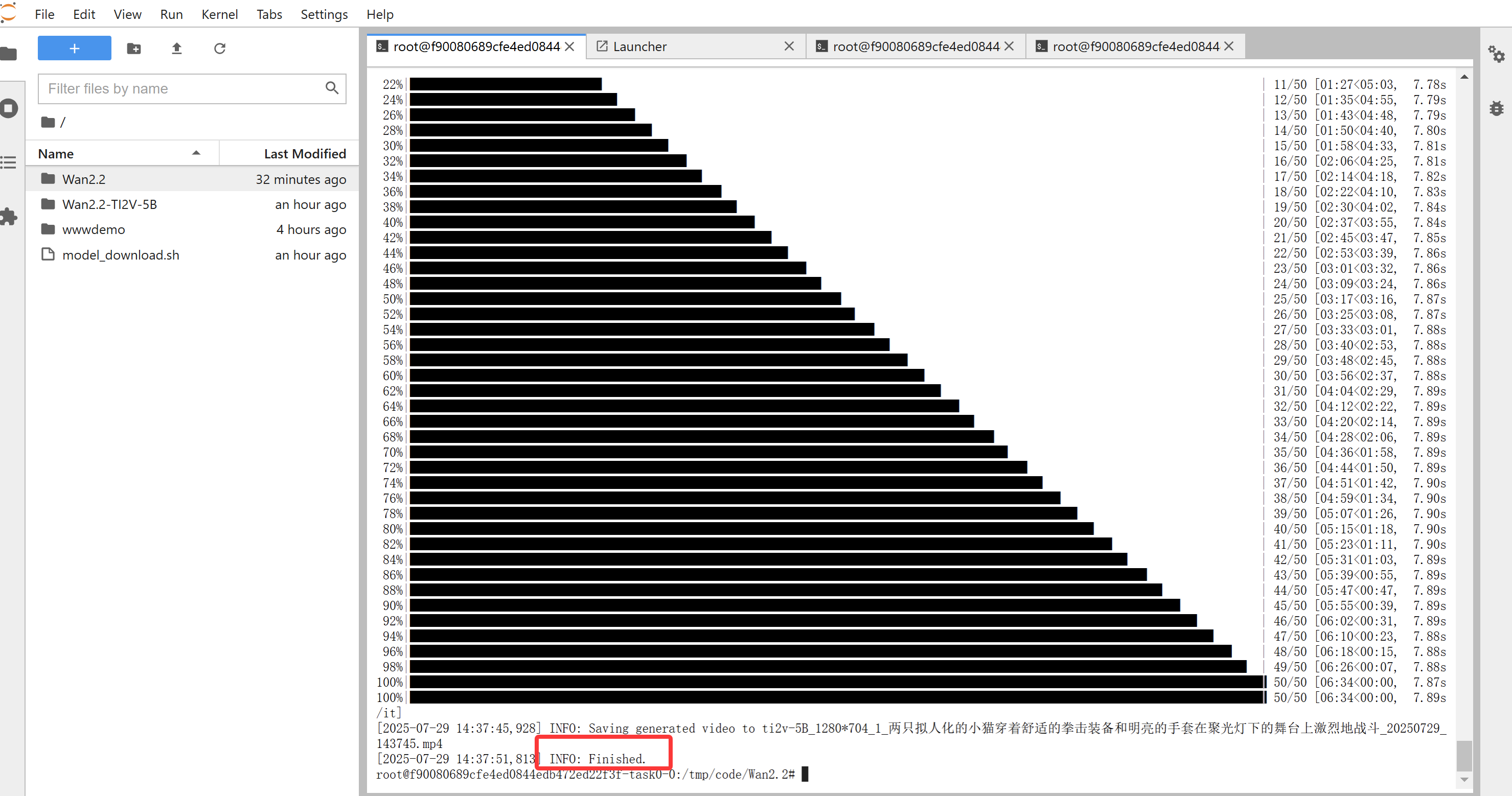

cd /tmp/code/Wan2.2python generate.py --task ti2v-5B --size 1280*704 --ckpt_dir /tmp/code/Wan2.2-TI2V-5B --offload_model True --convert_model_dtype --t5_cpu --prompt \"两只拟人化的小猫穿着舒适的拳击装备和明亮的手套在聚光灯下的舞台上激烈地战斗\"程序运行加载模型,第一次运行会比较慢一点。

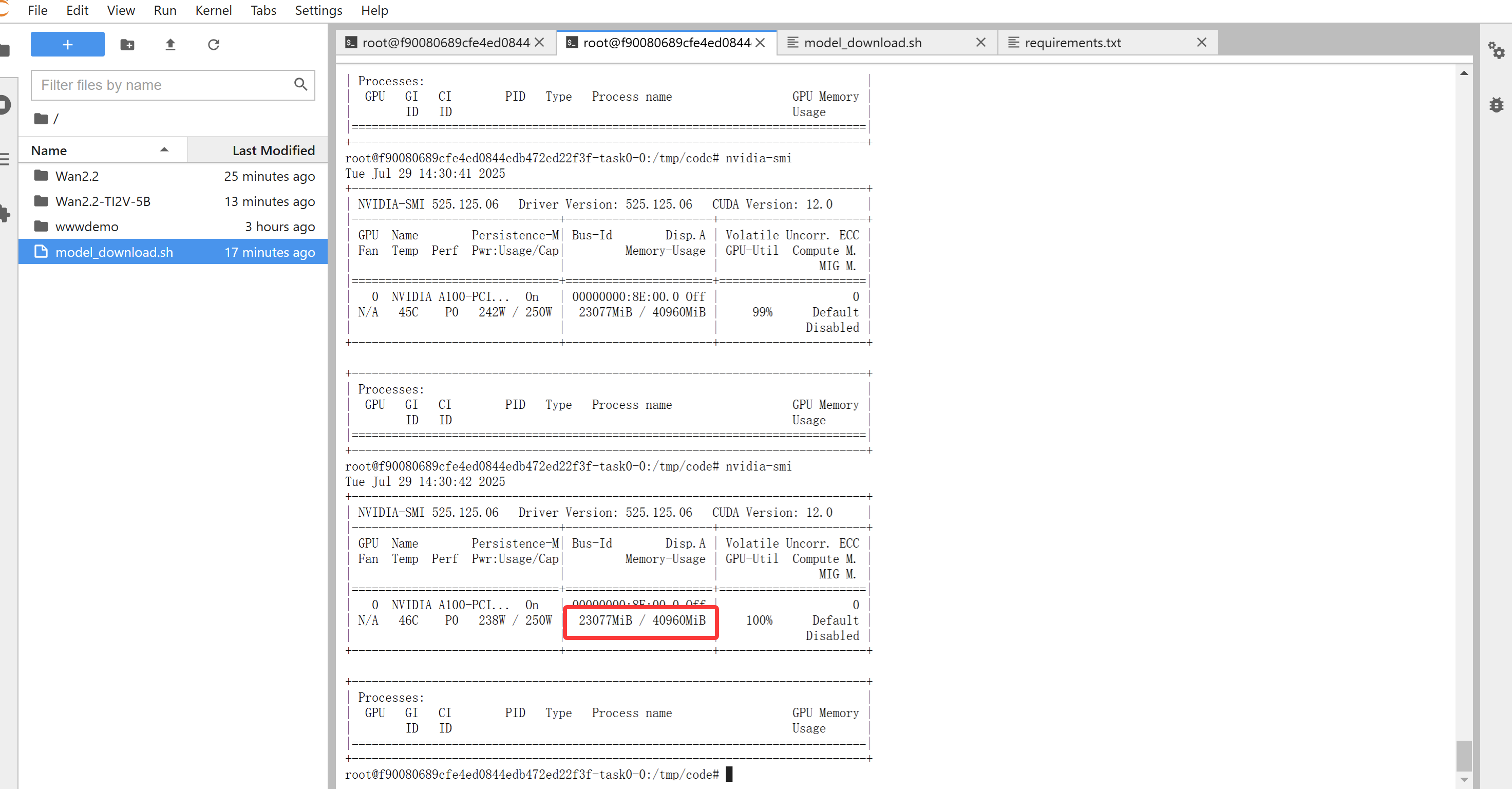

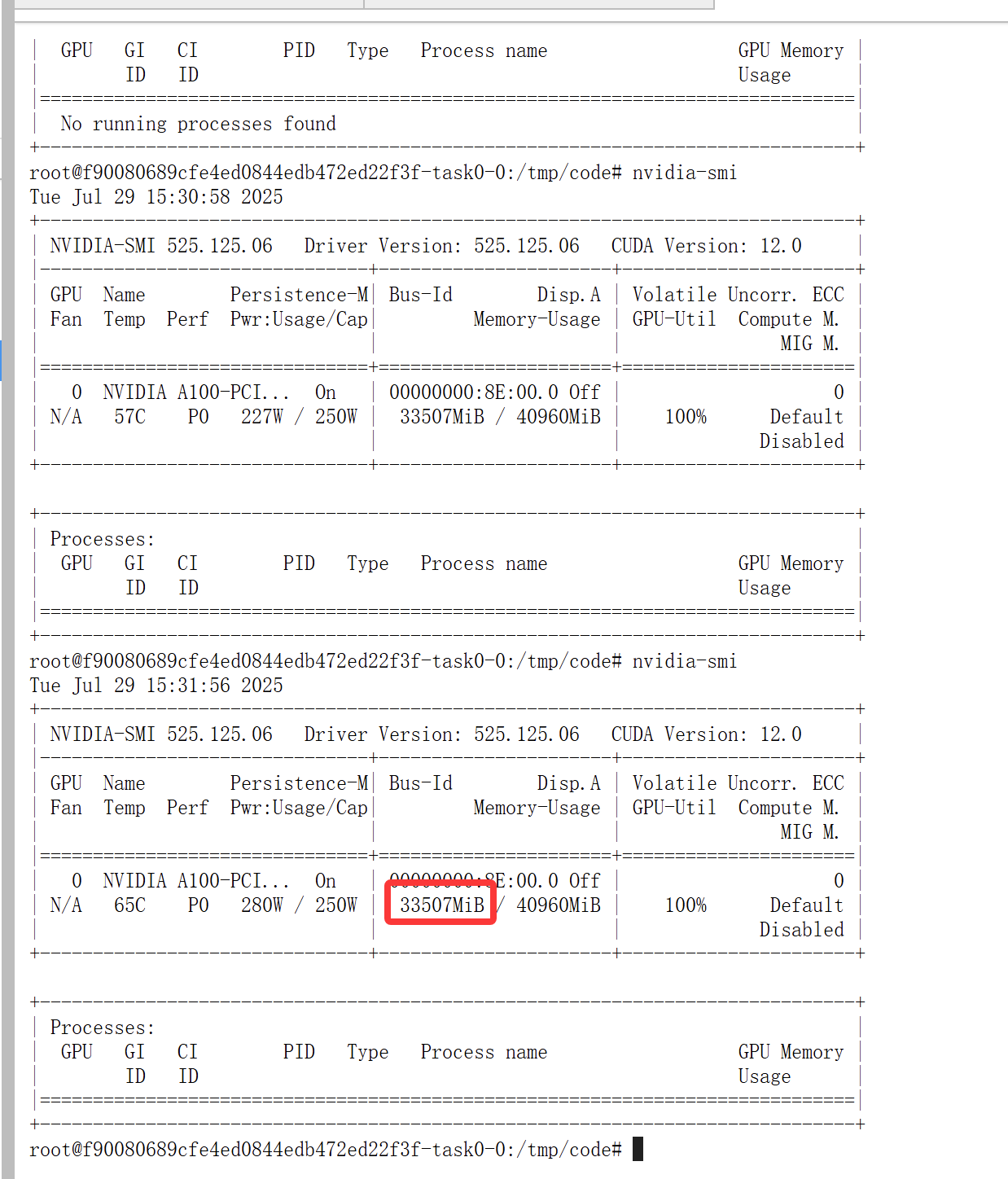

推理中显卡资源情况查看

这个推理时间其实有点长。我算了一下提出模型加载时间大概消耗了10分钟

完成推理后我们看一下视频生成的效果

以上我们用官方提供的方式generate.py实现了基于Wan2.2-TI2V-5B模型的推理。从提供的DEMO和模型的代码里面来看有不少好玩的东西。

第二次测试

python generate.py --task ti2v-5B --size 1280*704 --ckpt_dir /tmp/code/Wan2.2-TI2V-5B --prompt \"一段关于中药人参的短视频。视频风格:纪录片、特写镜头。画面内容:首先是人参药材的特写镜头,缓慢旋转展示细节;然后展示其生长的自然环境;最后是它被用于传统中医的场景,比如煎药或者入药。整个视频节奏舒缓,配乐为典雅的中国古典音乐。\"这个去掉了–offload_model True --convert_model_dtype --t5_cpu 后跑出来的,发现显存消耗还是挺大的

我们在看一下生产的效果:

测试下来感觉还是有点慢,画面效果都还不错。呵呵大家还是看一下官方宣传的视频效果吧。

3.总结:

今天主要带大家了解了阿里巴巴于 2025 年 7 月 28 日开源的视频生成模型 —— 通义万相 Wan2.2,并详细介绍了其核心技术、能力亮点以及部署和推理过程。

Wan2.2 作为阿里云推出的升级版视频生成模型,具有诸多令人瞩目的亮点。它引入有效的 MoE 架构,在不增加计算成本的情况下扩大了整体模型容量;凭借精心策划的美学数据,实现了电影级美学的精确可控生成;通过增加训练数据量,显著增强了复杂运动生成的泛化能力;开源的 5B 模型实现了高效的高清混合 TI2V,支持 720P 分辨率、24fps 的文本到视频和图像到视频生成,且能在消费级显卡上运行。目前开源的三个版本 “万相 2.2 - 文生视频 - A14B”、“万相 2.2 - 图生视频 - A14B”、“万相 2.2 - 图文生视频 - 5B” 也各有优势,能满足不同场景的需求。

在部署方面,我们详细介绍了如何在启智平台进行模型社区启动资源的操作、模型下载以及模型推理。通过实际的推理测试,我们发现虽然推理时间较长,但生成的视频画面效果不错。

由于时间关系,本次测试未进行详细的对比和评估。不过,从模型的功能和提供的 DEMO 来看,通义万相 Wan2.2 具有很大的应用潜力,能够在短剧、广告、电影等多个领域发挥重要作用,推动整个视频生成行业向前发展。感兴趣的小伙伴可以按照本文步骤去尝试,探索该模型更多的应用场景。今天的分享就到这里结束了,我们下一篇文章见。

#通义万相#、#极速通关72h计划#