阿里达摩院开源具身智能三大件,机器人+AI很无敌

目录

前言

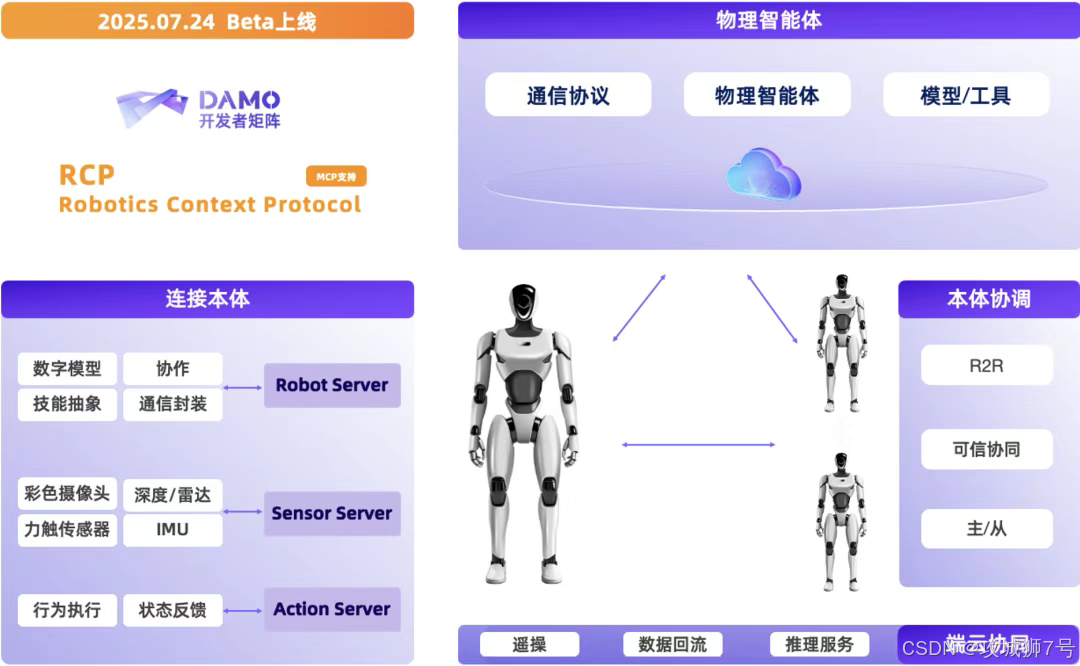

一、主角登场:RynnRCP——机器人的“普通话”和“小脑”

1.1 RCP框架:机器人的“USB-C”标准接口

1.2 RobotMotion:从“想法”到“动作”的翻译官

二、两大“外挂”:让机器人的大脑更懂世界、更懂操作

2.1 世界理解模型 RynnEC:给机器人一双“慧眼”

2.2 视觉-语言-动作模型 RynnVLA-001:手把手教会机器人“干活”

三、强强联合:当“三大件”合体时会发生什么?

四、开源的意义:不止是炫技,更是铺路

🎬 攻城狮7号:个人主页

🔥 个人专栏:《AI前沿技术要闻》

⛺️ 君子慎独!

🌈 大家好,欢迎来访我的博客!

⛳️ 此篇文章主要介绍 阿里达摩院开源具身智能三大件

📚 本期文章收录在《AI前沿技术要闻》,大家有兴趣可以自行查看!

⛺️ 欢迎各位 ✔️ 点赞 👍 收藏 ⭐留言 📝!

前言

我们生活在一个AI飞速发展的时代。AI会画画,会写诗,会编程,甚至能在“图寻”游戏中击败99%的人类。我们不禁会问:既然AI的大脑已经如此聪明,为什么我家里还没有一个能端茶倒水、整理房间的机器人管家?

波士顿动力公司的机器狗视频刷爆全网,特斯拉的人形机器人擎天柱也频频亮相,但这些酷炫的“明星”离我们的日常生活,似乎总隔着一层看不见的墙。

这堵墙,就是具身智能(Embodied AI)领域长期以来最大的痛点——“巴别塔困境”。

简单来说,就是AI的大脑(模型)和机器人的身体(硬件)之间,语言不通,无法有效沟通。每个机器人厂商、每个传感器、每个AI模型,都有自己的一套“方言”,导致开发一个智能机器人,就像用一堆互不兼容的零件去组装一台电脑,过程痛苦,效率低下。

现在,阿里达摩院站了出来,他们不只是发布了一两个更聪明的AI模型,而是祭出了一套“组合拳”,试图从根源上解决这个“巴别塔困境”。他们开源的具身智能“三大件”,就像是在为全世界的机器人,打造一套通用的“神经系统”。

开源链接:

机器人上下文协议 RynnRCP

https://github.com/alibaba-damo-academy/RynnRCP

视觉 - 语言 - 动作模型 RynnVLA-001

https://github.com/alibaba-damo-academy/RynnVLA-001

世界理解模型 RynnEC

https://github.com/alibaba-damo-academy/RynnEC

一、主角登场:RynnRCP——机器人的“普通话”和“小脑”

这次阿里开源的“三大件”里,最核心、最具革命性的,不是某个具体的AI模型,而是一套名为RynnRCP(机器人上下文协议)的框架。

如果说以前的机器人开发,是在逼着说粤语的AI大脑,去指挥一个说上海话的机械臂,中间还得配一个蹩脚的翻译。那么RynnRCP的目标,就是推广一套“普通话”,让大脑和身体能够无障碍交流。

它主要由两部分组成,我们可以把它想象成机器人的“通信协议”和“运动中枢”。

1.1 RCP框架:机器人的“USB-C”标准接口

这部分解决的是“连接”的问题。它为机器人本体、摄像头、力传感器等各种硬件,提供了一套标准化的接口。

这就像我们现在用的USB-C接口。无论你的手机是哪个牌子,充电器是哪家产的,只要接口对了,就能插上充电。RCP框架就是要成为具身智能领域的“USB-C”,让开发者可以像搭乐高一样,把不同厂商的机器人硬件和AI模型“即插即用”地组合在一起,而不用再为繁琐的适配问题焦头烂额。

1.2 RobotMotion:从“想法”到“动作”的翻译官

这部分解决的是“执行”的问题。AI大脑思考问题,通常是高层次、低频率的指令,比如“拿起桌上的苹果”。但机器人的电机需要的是高频率、精确到毫秒的连续控制信号,比如“左臂关节A旋转0.1度,关节B收紧0.5度……”。

RobotMotion就扮演了这个“翻译官”和“小脑”的角色。它能将AI大脑的抽象“想法”,实时地转化为机器人身体可以理解的、平滑且符合物理规律的精确“动作”。它确保了机器人不会因为“听不懂”指令而变得动作僵硬、磕磕绊绊,而是能像一个真正的生命体一样,流畅自然地完成任务。

二、两大“外挂”:让机器人的大脑更懂世界、更懂操作

有了这套“通用神经系统”,大脑和身体的沟通渠道被打通了。但一个真正智能的机器人,还需要一个足够强大的大脑。于是,达摩院同时开源了另外两件“神器”,作为这套系统的“最佳拍档”。

2.1 世界理解模型 RynnEC:给机器人一双“慧眼”

这个模型,解决的是机器人“看懂世界”的问题。它赋予了机器人强大的环境感知和理解能力。

过去的机器人看世界,可能只是识别出一堆像素点和边缘。而搭载了RynnEC的机器人,看到的是一个结构化的、充满意义的世界。它能仅凭摄像头拍到的视频,就理解出“在客厅的茶几上,有一个红色的苹果,旁边放着一串香蕉,距离我大约1.5米”。它能从位置、功能、数量等11个维度去全面解析一个场景。

这就像给机器人安装了一双“慧眼”和与之匹配的“空间想象力”,让它在与物理世界交互时,不再是一个“盲人”。

2.2 视觉-语言-动作模型 RynnVLA-001:手把手教会机器人“干活”

这个模型,解决的是机器人“学会技能”的问题。它是一个出色的“模仿大师”。

它的训练方式很特别:去学习海量的、人类第一人称视角的操作视频。比如,它看了成千上万个“如何倒一杯水”的视频后,就能理解这个任务的完整动作链条,并将其“翻译”成机器人手臂的操控指令。

通过这种方式学到的技能,不再是生硬的、预设的程序,而是更连贯、更平滑、更接近人类的自然动作。它让机器人不仅知道“该做什么”(what),更学会了“该怎么做”(how)。

三、强强联合:当“三大件”合体时会发生什么?

现在,让我们把这“三大件”组装起来,看看一个完整的任务是如何被执行的。

你对家里的机器人说:“能帮我把桌上的那杯水拿过来吗?”

(1)首先,RynnEC(世界理解模型)开始工作。它通过摄像头扫描房间,在复杂的环境里精准地定位到“桌子”,并在桌子上识别出“杯子”和里面的“水”。它构建了一个关于当前环境的实时“心理地图”。

(2)接着,AI大脑(比如一个大语言模型)进行决策。它理解了你的指令,并结合RynnEC提供的环境信息,生成了一个行动计划:“移动到桌子旁边 -> 伸出机械臂 -> 抓取杯子 -> 移动到主人面前 -> 递上杯子”。

(3)然后,RynnVLA-001(视觉-语言-动作模型)接过任务。它根据“抓取杯子”这个指令,调用它从无数视频中学来的“抓杯子”技能包,生成一系列连贯、平滑的动作序列。

(4)最后,RynnRCP(机器人上下文协议)登场。它的RobotMotion模块,将这些动作序列“翻译”成机械臂每个关节、每个电机能听懂的精确指令,并通过RCP框架这个“通用接口”,驱动机器人平稳地完成整个任务。

你看,从感知、理解、决策到执行,这“三大件”完美地构成了一个流畅的闭环。它们共同解决了一个核心问题:如何让AI的智慧,真正地、高效地、顺滑地流淌到机器人的每一个“神经末梢”。

四、开源的意义:不止是炫技,更是铺路

阿里达摩院将这套核心技术开源,其意义远超一次单纯的技术发布。

这是在“建标准、搭平台”。通过推广RynnRCP这套“普通话”,阿里正在试图为整个具身智能行业建立一套通用的开发标准。这能极大地降低开发门槛,让无数的中小企业、科研机构和独立开发者,都能站在巨人的肩膀上,去创造更多样、更有趣的机器人应用。

这是在“催化生态”。一个繁荣的技术生态,远比一两个明星产品更重要。阿里正在扮演那个“铺路人”的角色。路铺好了,自然会有各式各样的“车”(机器人应用)在上面跑起来。而作为道路的建设者,阿里无疑将在未来的具身智能生态中,占据一个极其重要的核心位置。

对于我们所有人来说,这意味着那个只存在于科幻电影中的智能机器人时代,可能真的离我们不远了。当造机器人的“巴别塔”被推倒后,创新的速度,或许将远超我们的想象。

看到这里了还不给博主点一个:

⛳️ 点赞☀️收藏 ⭐️ 关注!

💛 💙 💜 ❤️ 💚💓 💗 💕 💞 💘 💖

再次感谢大家的支持!

你们的点赞就是博主更新最大的动力!