Python从0到100(一百):基于Transformer的时序数据建模与实现详解_transformer时序建模

前言:零基础学Python:Python从0到100最新最全教程。 想做这件事情很久了,这次我更新了自己所写过的所有博客,汇集成了Python从0到100,共一百节课,帮助大家一个月时间里从零基础到学习Python基础语法、Python爬虫、Web开发、 计算机视觉、机器学习、神经网络以及人工智能相关知识,成为学业升学和工作就业的先行者!

【优惠信息】 • 新专栏订阅前500名享9.9元优惠 • 订阅量破500后价格上涨至19.9元 • 订阅本专栏可免费加入粉丝福利群,享受:

- 所有问题解答

-专属福利领取欢迎大家订阅专栏:零基础学Python:Python从0到100最新最全教程!

本文目录:

-

- 一、Transformer在时序数据处理中的理论基础与创新点

-

- 1. 传统时序模型的局限性

- 2. Transformer的核心创新

- 3. 技术优势分析

- 二、Transformer时序架构设计详解

-

- 1. 整体架构概览

- 2. 核心组件详细分析

-

- 2.1 多头自注意力机制(Multi-Head Self-Attention)

- 2.2 位置编码(Positional Encoding)

- 2.3 Transformer编码器块(Transformer Encoder Block)

- 3. 完整的时序Transformer网络架构

- 4. 模型配置与超参数设置

- 三、技术细节与实现要点

-

- 1. 自注意力机制的计算复杂度优化

- 2. 位置编码的改进策略

- 3.Transformer与传统方法的性能对比

- 文末送书

-

- 参与方式

- `本期推荐1:`《华为仓颉语言编程从入门到精通》

- `本期推荐2:`《DeepSeek源码深度解析》

Transformer for Time Series (TTS-Transformer) 是一种基于自注意力机制的深度神经网络架构,专门针对时序数据处理进行优化设计。它通过多头自注意力机制捕获时序数据中的长距离依赖关系,同时结合位置编码和层归一化等技术,在保持计算效率的同时显著提升了模型对复杂时序模式的建模能力和预测精度。

一、Transformer在时序数据处理中的理论基础与创新点

1. 传统时序模型的局限性

传统的时序数据处理方法,如循环神经网络(RNN)、长短期记忆网络(LSTM)等,在处理长序列时序数据时存在诸多限制:

-

长距离依赖建模困难:传统RNN系列模型在处理长序列时容易出现梯度消失或梯度爆炸问题,难以有效捕获长距离的时序依赖关系。在实际应用中,重要的时序模式可能跨越很长的时间跨度。

-

序列化计算限制:RNN的递归结构要求按时间步顺序计算,无法并行化处理,导致训练和推理效率低下,特别是在处理长序列时计算时间显著增加。

-

信息瓶颈问题:隐藏状态需要承载所有历史信息,随着序列长度增加,早期信息可能被后期信息覆盖,造成信息损失。

-

上下文理解有限:传统模型主要依赖局部时序信息,对全局时序模式的理解能力有限,难以捕获复杂的时序交互关系。

这些限制推动了研究者探索更加高效和强大的时序建模方法,Transformer架构正是在这一背景下被引入时序数据处理领域。

2. Transformer的核心创新

Transformer通过以下核心机制解决传统时序模型的问题:

- 多头自注意力机制:能够直接建模序列中任意两个位置之间的依赖关系,有效解决长距离依赖问题

- 并行计算能力:摒弃了递归结构,实现序列的并行处理,大幅提升计算效率

- 位置编码技术:通过正弦余弦位置编码保持时序信息的顺序性

- 多层堆叠设计:通过多层Transformer块逐步提取更高层次的时序特征表示

- 残差连接与层归一化:保证深层网络的训练稳定性和梯度传播效果

3. 技术优势分析

相比传统的时序处理方法,Transformer展现出显著的技术优势:

-

强大的长距离建模能力:自注意力机制使模型能够直接访问序列中的任意位置,有效捕获长距离依赖关系。

-

并行计算优势:去除递归结构后,可以充分利用现代GPU的并行计算能力,显著提升训练和推理速度。

-

灵活的注意力模式:多头注意力机制能够学习不同类型的时序关系,提供更丰富的特征表示。

-

可解释性增强:注意力权重可以直观地显示模型关注的时序位置,提供了良好的可解释性。

-

迁移学习友好:预训练的Transformer模型可以有效地迁移到不同的时序任务中。

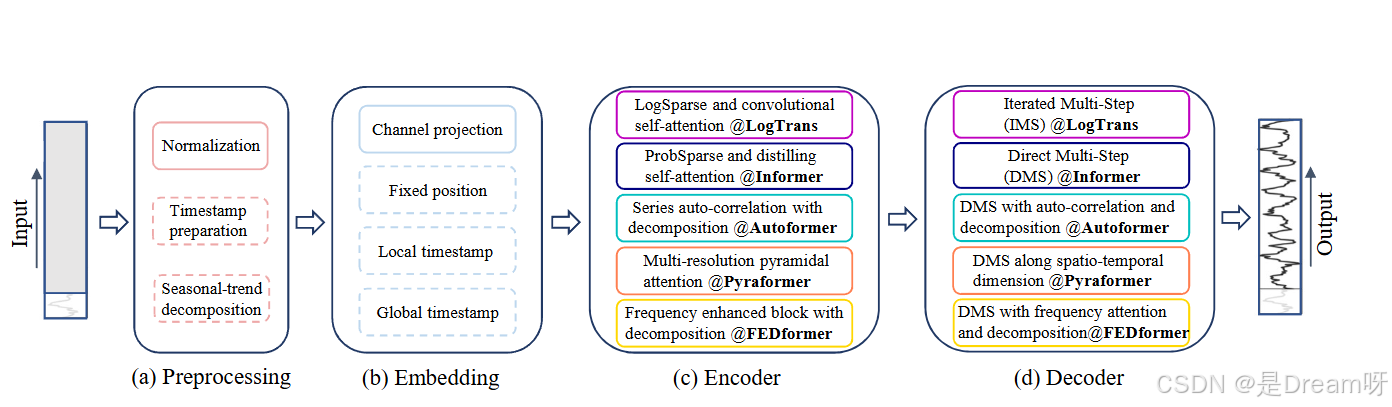

二、Transformer时序架构设计详解

1. 整体架构概览

TTS-Transformer采用编码器-解码器的设计思路,主要由以下几个核心组件构成:

- 输入嵌入层(Input Embedding):将时序数据转换为高维特征表示

- 位置编码层(Positional Encoding):为序列添加位置信息

- 多层Transformer编码器(Multi-layer Transformer Encoder):通过自注意力机制提取时序特征

- 输出层(Output Layer):根据任务需求进行分类或回归预测

这种模块化设计不仅提高了代码的可维护性,还使得网络结构具有良好的灵活性和可扩展性。

2. 核心组件详细分析

2.1 多头自注意力机制(Multi-Head Self-Attention)

多头自注意力机制是Transformer的核心创新,负责捕获序列中不同位置之间的依赖关系。

import torchimport torch.nn as nnimport torch.nn.functional as Fimport mathclass MultiHeadAttention(nn.Module): def __init__(self, d_model, n_heads, dropout=0.1): super(MultiHeadAttention, self).__init__() assert d_model % n_heads == 0 self.d_model = d_model self.n_heads = n_heads self.d_k = d_model // n_heads # 线性变换层 self.W_q = nn.Linear(d_model, d_model, bias=False) self.W_k = nn.Linear(d_model, d_model, bias=False) self.W_v = nn.Linear(d_model, d_model, bias=False) self.W_o = nn.Linear(d_model, d_model) self.dropout = nn.Dropout(dropout) self.scale = math.sqrt(self.d_k) def forward(self, query, key, value, mask=None): batch_size = query.size(0) seq_len = query.size(1) # 线性变换并重塑为多头形式 Q = self.W_q(query).view(batch_size, seq_len, self.n_heads, self.d_k).transpose(1, 2) K = self.W_k(key).view(batch_size, seq_len, self.n_heads, self.d_k).transpose(1, 2) V = self.W_v(value).view(batch_size, seq_len, self.n_heads, self.d_k).transpose(1, 2) # 计算注意力分数 scores = torch.matmul(Q, K.transpose(-2, -1)) / self.scale # [batch, heads, seq_len, seq_len] # 应用掩码(如果提供) if mask is not None: scores = scores.masked_fill(mask == 0, -1e9) # 计算注意力权重 attention_weights = F.softmax(scores, dim=-1) attention_weights = self.dropout(attention_weights) # 应用注意力权重 context = torch.matmul(attention_weights, V) # [batch, heads, seq_len, d_k] # 合并多头结果 context = context.transpose(1, 2).contiguous().view( batch_size, seq_len, self.d_model ) # 最终线性变换 output = self.W_o(context) return output, attention_weights多头自注意力机制的设计体现了以下核心思想:

- 多头并行处理:通过多个注意力头并行计算,捕获不同类型的时序关系

- 缩放点积注意力:使用缩放因子√d_k避免softmax函数进入饱和区域

- 线性变换组合:通过Query、Key、Value的线性变换实现特征空间的灵活映射

2.2 位置编码(Positional Encoding)

由于自注意力机制本身无法感知序列的顺序信息,位置编码的引入至关重要:

class PositionalEncoding(nn.Module): def __init__(self, d_model, max_seq_length=5000, dropout=0.1): super(PositionalEncoding, self).__init__() self.dropout = nn.Dropout(dropout) # 创建位置编码矩阵 pe = torch.zeros(max_seq_length, d_model) position = torch.arange(0, max_seq_length).unsqueeze(1).float() # 计算除数项 div_term = torch.exp(torch.arange(0, d_model, 2).float() * -(math.log(10000.0) / d_model)) # 应用正弦和余弦函数 pe[:, 0::2] = torch.sin(position * div_term) # 偶数位置 pe[:, 1::2] = torch.cos(position * div_term) # 奇数位置 pe = pe.unsqueeze(0) # [1, max_seq_length, d_model] self.register_buffer(\'pe\', pe) def forward(self, x): # x.shape: [batch_size, seq_length, d_model] seq_length = x.size(1) x = x + self.pe[:, :seq_length] return self.dropout(x)位置编码的设计原理:

- 正弦余弦函数:利用不同频率的正弦余弦函数为每个位置生成唯一的编码

- 相对位置感知:通过数学性质使模型能够学习相对位置关系

- 长度适应性:能够处理训练时未见过长度的序列

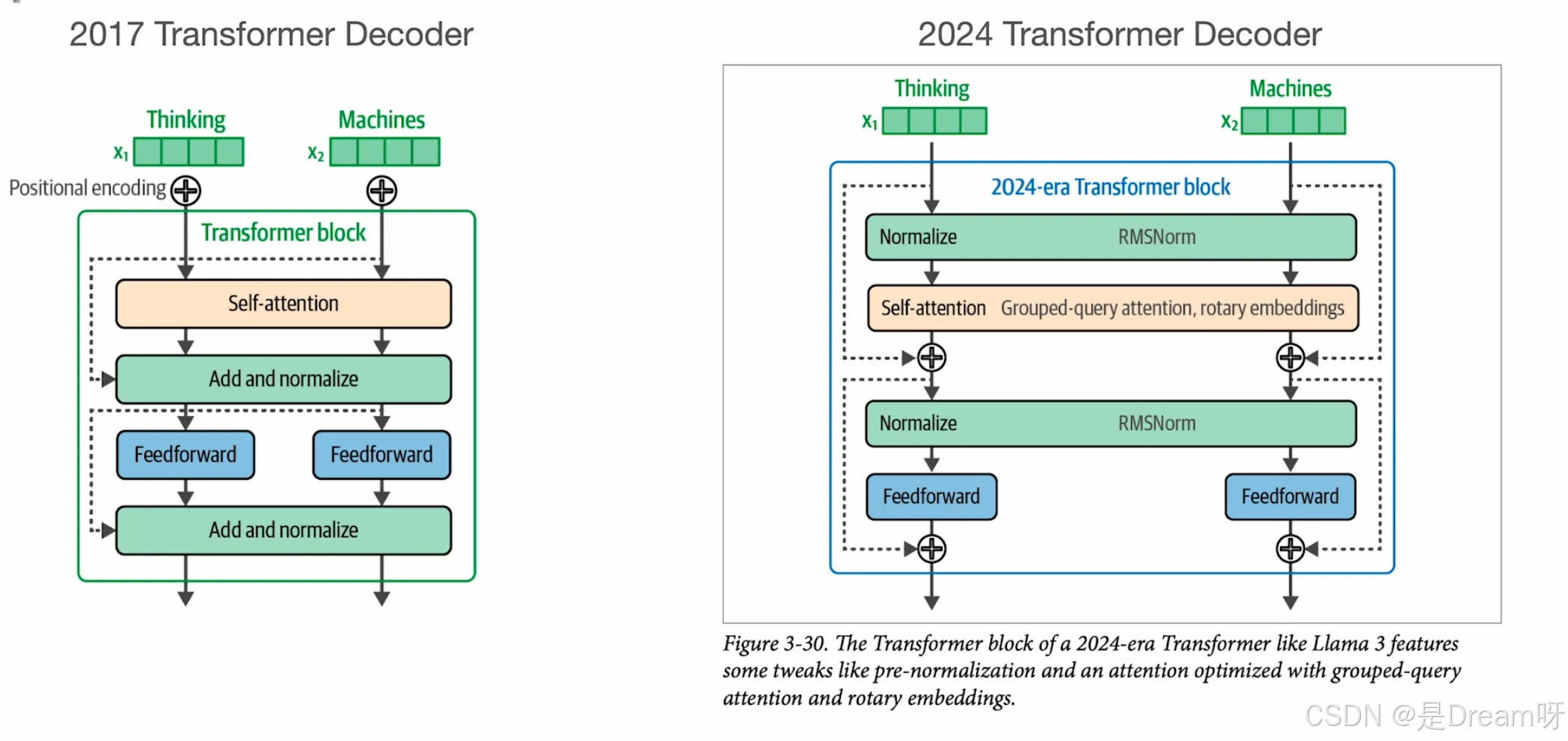

2.3 Transformer编码器块(Transformer Encoder Block)

class TransformerEncoderBlock(nn.Module): def __init__(self, d_model, n_heads, d_ff, dropout=0.1): super(TransformerEncoderBlock, self).__init__() # 多头自注意力层 self.self_attention = MultiHeadAttention(d_model, n_heads, dropout) # 前馈神经网络 self.feed_forward = nn.Sequential( nn.Linear(d_model, d_ff), nn.ReLU(), nn.Dropout(dropout), nn.Linear(d_ff, d_model), nn.Dropout(dropout) ) # 层归一化 self.norm1 = nn.LayerNorm(d_model) self.norm2 = nn.LayerNorm(d_model) self.dropout = nn.Dropout(dropout) def forward(self, x, mask=None): # 多头自注意力 + 残差连接 + 层归一化 attn_output, attention_weights = self.self_attention(x, x, x, mask) x = self.norm1(x + self.dropout(attn_output)) # 前馈网络 + 残差连接 + 层归一化 ff_output = self.feed_forward(x) x = self.norm2(x + ff_output) return x, attention_weights编码器块的关键设计元素:

- 残差连接:解决深层网络的梯度消失问题,促进信息流动

- 层归一化:稳定训练过程,加速收敛

- 前馈网络:增加模型的非线性表达能力

3. 完整的时序Transformer网络架构

class TimeSeriesTransformer(nn.Module): def __init__(self, input_dim, d_model, n_heads, n_layers, d_ff, max_seq_length, num_classes, dropout=0.1): super(TimeSeriesTransformer, self).__init__() self.d_model = d_model # 输入嵌入层 self.input_embedding = nn.Linear(input_dim, d_model) # 位置编码 self.positional_encoding = PositionalEncoding(d_model, max_seq_length, dropout) # Transformer编码器层 self.transformer_blocks = nn.ModuleList([ TransformerEncoderBlock(d_model, n_heads, d_ff, dropout) for _ in range(n_layers) ]) # 全局平均池化 self.global_avg_pool = nn.AdaptiveAvgPool1d(1) # 分类头 self.classifier = nn.Sequential( nn.Linear(d_model, d_model // 2), nn.ReLU(), nn.Dropout(dropout), nn.Linear(d_model // 2, num_classes) ) # 参数初始化 self._init_parameters() def _init_parameters(self): for module in self.modules(): if isinstance(module, nn.Linear): nn.init.xavier_uniform_(module.weight) if module.bias is not None: nn.init.zeros_(module.bias) def create_padding_mask(self, x, pad_token=0): \"\"\"创建填充掩码\"\"\" # 假设pad_token用于标识填充位置 mask = (x != pad_token).unsqueeze(1).unsqueeze(2) return mask def forward(self, x, mask=None): \"\"\" Args: x: [batch_size, seq_length, input_dim] mask: [batch_size, 1, 1, seq_length] 可选的掩码 Returns: output: [batch_size, num_classes] attention_weights: 各层的注意力权重 \"\"\" batch_size, seq_length, input_dim = x.shape # 输入嵌入 x = self.input_embedding(x) # [batch_size, seq_length, d_model] x = x * math.sqrt(self.d_model) # 缩放嵌入 # 位置编码 x = self.positional_encoding(x) # 存储注意力权重 attention_weights = [] # 通过Transformer编码器层 for transformer_block in self.transformer_blocks: x, attn_weights = transformer_block(x, mask) attention_weights.append(attn_weights) # 全局平均池化:[batch_size, seq_length, d_model] -> [batch_size, d_model] x = x.transpose(1, 2) # [batch_size, d_model, seq_length] x = self.global_avg_pool(x).squeeze(-1) # [batch_size, d_model] # 分类预测 output = self.classifier(x) # [batch_size, num_classes] return output, attention_weights4. 模型配置与超参数设置

# 模型配置示例config = { \'input_dim\': 6, # 输入特征维度(如传感器数据的6个维度) \'d_model\': 256, # 模型隐藏维度 \'n_heads\': 8, # 多头注意力的头数 \'n_layers\': 6, # Transformer层数 \'d_ff\': 1024, # 前馈网络隐藏维度 \'max_seq_length\': 512, # 最大序列长度 \'num_classes\': 6, # 分类类别数 \'dropout\': 0.1 # Dropout概率}# 实例化模型model = TimeSeriesTransformer(**config)# 打印模型信息print(f\"模型参数量: {sum(p.numel() for p in model.parameters() if p.requires_grad):,}\")三、技术细节与实现要点

1. 自注意力机制的计算复杂度优化

标准自注意力机制的计算复杂度为O(n²d),其中n为序列长度,d为特征维度。对于长序列,这会导致显著的计算和内存开销:

class EfficientAttention(nn.Module): \"\"\"优化版本的注意力机制,适用于长序列\"\"\" def __init__(self, d_model, n_heads, dropout=0.1, max_seq_length=5000): super().__init__() self.d_model = d_model self.n_heads = n_heads self.d_k = d_model // n_heads # 使用更小的key维度进行近似 self.reduced_dim = min(64, self.d_k) self.W_q = nn.Linear(d_model, n_heads * self.reduced_dim, bias=False) self.W_k = nn.Linear(d_model, n_heads * self.reduced_dim, bias=False) self.W_v = nn.Linear(d_model, d_model, bias=False) self.W_o = nn.Linear(d_model, d_model) self.dropout = nn.Dropout(dropout) def forward(self, query, key, value, mask=None): B, L, D = query.shape # 降维处理Q和K Q = self.W_q(query).view(B, L, self.n_heads, self.reduced_dim).transpose(1, 2) K = self.W_k(key).view(B, L, self.n_heads, self.reduced_dim).transpose(1, 2) V = self.W_v(value).view(B, L, self.n_heads, self.d_k).transpose(1, 2) # 计算注意力(降维后的复杂度更低) scores = torch.matmul(Q, K.transpose(-2, -1)) / math.sqrt(self.reduced_dim) if mask is not None: scores.masked_fill_(mask == 0, -1e9) attn = F.softmax(scores, dim=-1) attn = self.dropout(attn) context = torch.matmul(attn, V).transpose(1, 2).contiguous().view(B, L, D) output = self.W_o(context) return output, attn2. 位置编码的改进策略

针对时序数据的特点,可以采用更加灵活的位置编码策略:

class LearnablePositionalEncoding(nn.Module): \"\"\"可学习的位置编码\"\"\" def __init__(self, d_model, max_seq_length=5000, dropout=0.1): super().__init__() self.dropout = nn.Dropout(dropout) # 使用可学习的参数代替固定的正弦余弦编码 self.pe = nn.Parameter(torch.randn(1, max_seq_length, d_model) * 0.1) def forward(self, x): seq_len = x.size(1) x = x + self.pe[:, :seq_len] return self.dropout(x)class RelativePositionalEncoding(nn.Module): \"\"\"相对位置编码,更适合时序数据\"\"\" def __init__(self, d_model, max_relative_position=128): super().__init__() self.d_model = d_model self.max_relative_position = max_relative_position # 相对位置嵌入 vocab_size = max_relative_position * 2 + 1 self.relative_position_embeddings = nn.Embedding(vocab_size, d_model) def forward(self, length): \"\"\"生成相对位置编码矩阵\"\"\" range_vec = torch.arange(length) distance_mat = range_vec[None, :] - range_vec[:, None] distance_mat_clipped = torch.clamp( distance_mat, -self.max_relative_position, self.max_relative_position ) final_mat = distance_mat_clipped + self.max_relative_position embeddings = self.relative_position_embeddings(final_mat) return embeddings3.Transformer与传统方法的性能对比

内存效率高

训练速度慢

局部特征提取强

感受野受限

并行计算友好

内存需求大

性能均衡

调参困难

Transformer架构在时序数据处理领域取得了显著突破,主要得益于其自注意力机制所带来的长距离依赖建模能力,能够直接捕捉序列中任意位置之间的关系,有效克服了传统RNN在处理远程依赖时的局限。同时,Transformer摒弃了递归结构,实现了高度并行化的计算,大幅提升了模型的训练与推理效率。在多个时序数据集上展现出的优异性能也证明了其出色的泛化能力。此外,通过注意力权重的可视化,Transformer具备良好的可解释性,有助于深入理解模型的决策逻辑。

文末送书

参与方式

免费包邮送三本! Dream送书活动——第六十五期:《华为仓颉语言编程从入门到精通》、《DeepSeek源码深度解析》

参与方式:

1.点赞收藏文章

2.在评论区留言:人生苦短,我用Python!(多可评论三条)

3.随机抽取3位免费送出!

4.截止时间: 2025-06-25

上期中奖名单:一寸星河、W✘098、Sunlightʊə

本期推荐1:《华为仓颉语言编程从入门到精通》《华为仓颉语言编程从入门到精通》

华为仓颉语言编程从新手到专家实战宝典:系统讲解 + 项目实战 + 多媒体教学资源,构建从入门到精通的完整学习路径,助力成为鸿蒙开发专家。

京东:https://item.jd.com/15006134.html

实战讲解:通过实际项目案例帮助读者掌握仓颉的使用技巧,提升实践能力。

配套资源丰富:460页教学PPT + 490分钟实战讲解视频,全栈级仓颉开发教程,助你快速掌握鸿蒙生态核心语言。

仓颉与华为技术生态深度结合:从基础语法到实战应用,用仓颉开启华为智能开发新时代。

高效编码:帮助开发者提升编码效率,特别是在大规模数据处理和高性能计算场景中。

前瞻性技术:探索仓颉语言在未来技术发展中的应用潜力,展现其在人工智能、云计算等地方的前景。

内容简介

华为自研的仓颉语言作为一款面向全场景应用开发的现代编程语言,通过现代语言特性的集成、全方位的编译优化和运行时实现,以及开箱即用的工具链支持,为开发者打造了友好的开发体验和卓越的程序性能。

本书循序渐进地讲解了仓颉语言的核心知识,并通过具体实例的实现过程演练了开发仓颉语言程序的关键方法和流程。全书共 19 章,分别讲解了从仓颉语言的基础语法、数据结构、面向对象编程、网络编程到多线程与并发处理等内容,最后通过实战项目——圆角图片视图库的开发,系统展示了仓颉语言的核心语法知识和实际应用技巧。

本书通俗易懂而不失技术深度,案例丰富,实用性强,涵盖了华为开发技术的最新动态和实践案例,同时涵盖了其他同类图书中很少涉及的开发工具与平台介绍。本书适合华为仓颉编程语言的初学者和进阶读者作为自学教程,也可作为培训学校和各大院校的相关专业的教学参考书。

本期推荐2:《DeepSeek源码深度解析》《DeepSeek源码深度解析》

DeepSeek源码底层逻辑与架构哲学:从架构设计到实战部署,解密MoE内核与多模态融合,赠送67GB学习资源,快速掌握从源码阅读到二次开发的全流程技能

京东:https://item.jd.com/15021762.html

1.源码逐层拆解:从架构设计到工程实现策略,全面驾驭DeepSeek技术生态。

2.解密MoE内核与多模态融合:涵盖文本、视觉及跨模态数据处理,探索MoE技术实现高效的模型训练和推理的精髓。

3.核心算法解读:逐步解析关键算法与数据流处理过程,从源码层面深入探讨模型训练、推理和优化的实现细节。

4.实战指导:案例驱动的实战讲解,带领读者快速掌握从源码阅读到二次开发的全流程技能。

内容简介

本书是一本系统讲解DeepSeek源码及其核心实现原理的技术指南,内容覆盖了从基础概念到高级应用的全流程知识。全书共7章,结构层层递进。第1章对DeepSeek进行了全面概述,帮助读者构建对DeepSeek系统的整体认知。第2章聚焦于环境搭建、代码获取与模型部署接入,为后续深入研究提供基础。第3章深入探讨了MoE(混合专家模型)的基本原理、功能模块与优化技术。第4章详细解析了DeepSeek-V3模型的架构知识,并通过测试验证展示了系统的实际效果。第5章围绕统一多模态大模型展开,介绍了Janus系列架构、核心技术及工具模块。第6章针对高分辨率图像场景,探讨了结合MoE、细粒度特征提取与视觉/语言适配器的多模态模型的知识。第7章聚焦DeepSeek-R1推理大模型,展示了DeepSeek在推理性能与自我进化方面的探索。

本书适合人工智能工程师、深度学习研究者、AI产品开发人员及高校师生阅读。无论您是希望夯实开源模型基础,还是寻找前沿实战案例,本书都将为您提供全面而深入的参考与指导。