智能制造的空间度量:机器视觉标定技术解析

今天咱们来聊机器视觉的关键技术——视觉标定。就像你新买的眼镜需要验光师调试一样,当相机装上工业机器人或者自动化设备时,也得先经过这套\"视力矫正\"流程。想象下,如果机器把1厘米看成2厘米,那装配零件时绝对会引发灾难现场对吧?

先说个有意思的现象:人类婴儿其实也要经历类似的\"视觉标定\"。研究发现,新生儿需要6-8个月才能准确判断物体距离,这个过程和机器视觉的标定原理惊人相似。不过机器的学习速度可比人类宝宝快多了,通常只需要几分钟到几小时就能完成。

一、标定的核心三要素

现在咱们拆解下标定的核心三要素:镜头畸变、坐标系转换和像素当量。

镜头畸变

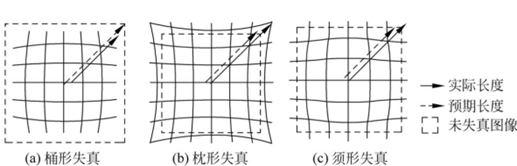

相机镜头并非理想的光学元件,其制造工艺与组装偏差会导致两类典型畸变:径向畸变与切向畸变。镜头径向畸变就像哈哈镜效果,广角镜头尤其明显——直线变曲线,圆形成椭圆。切向畸变则源于镜头与图像平面的微小倾斜,导致画面局部拉伸或压缩。这些畸变会使直线变弯、尺寸失真,直接影响测量精度。

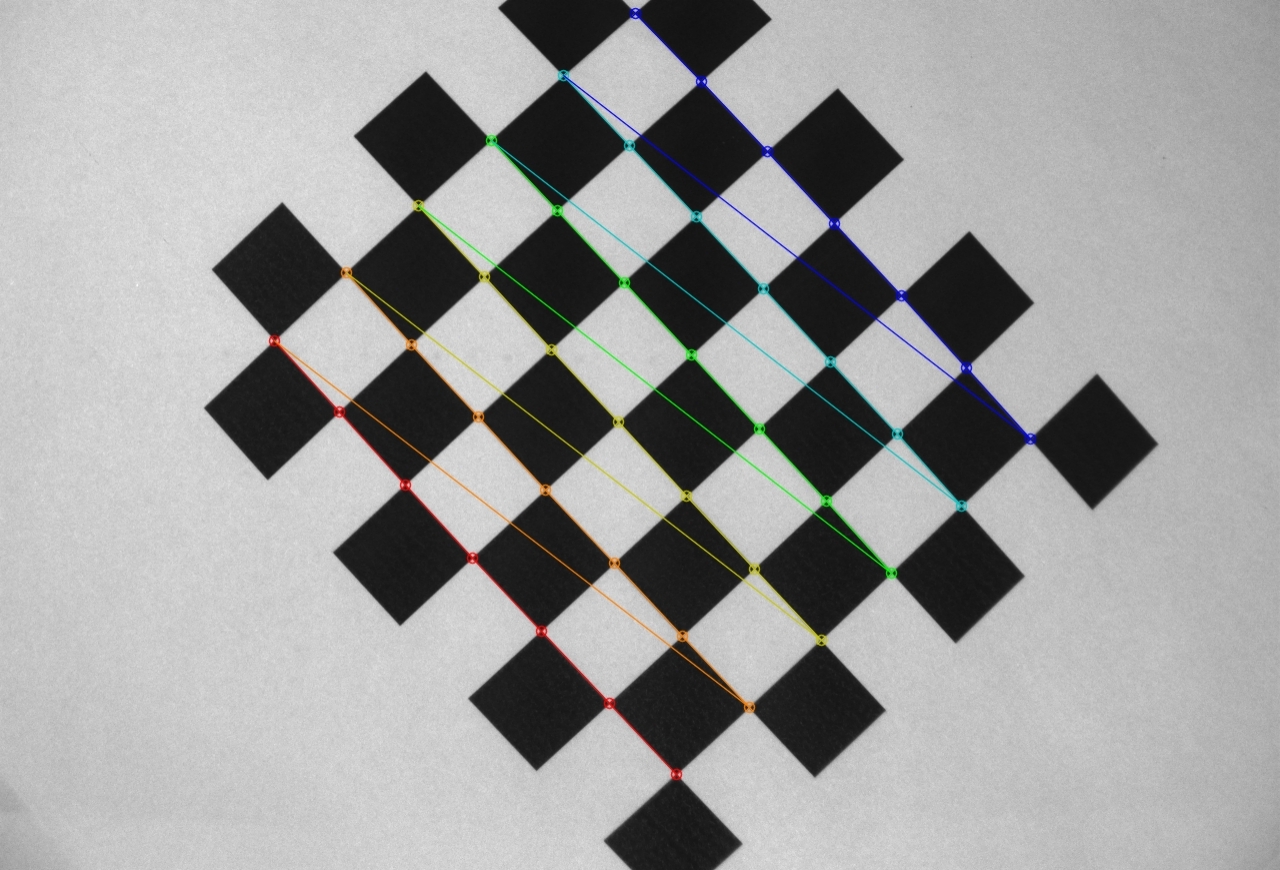

工程师们一般用棋盘格标定板来解决这个问题。当相机从不同角度拍摄棋盘格照片后,算法就能反向推算出畸变参数。

坐标系转换

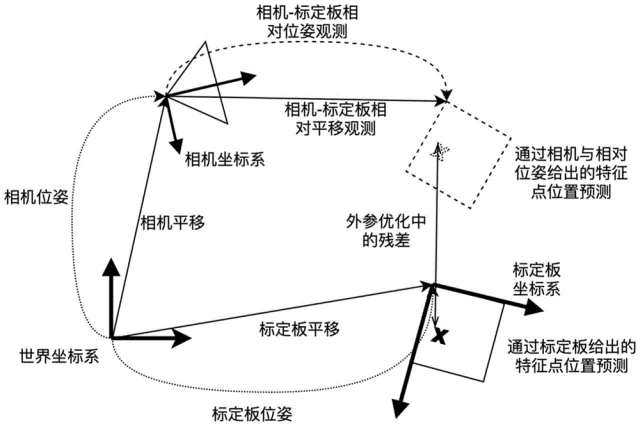

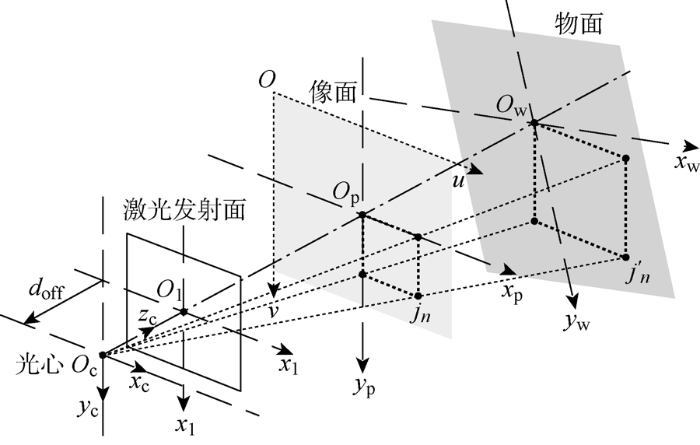

坐标系转换的本质是像素坐标系(图像中的像素位置)、成像平面坐标系(镜头映射的物理平面)、相机坐标系(相机自身的三维空间)与世界坐标系(物体实际位置)之间的数学转换关系。比如机械臂上的相机看到零件的位置,需要转换成机器人底座坐标系的坐标。

像素当量

像素当量则是建立虚拟和现实的丈量标准。通过已知尺寸的标定板,算法能计算出每个像素代表多少毫米。这个参数会直接影响测量精度,比如检测手机屏幕划痕时,1个像素的误差可能就意味着0.02毫米的误判。现在顶级工业相机的标定精度能达到亚像素级别,相当于能在足球场上识别出一根头发丝的粗细。

二、标定方法

传统标定法

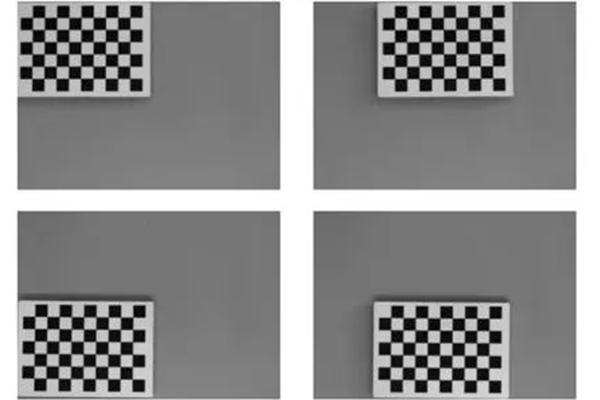

以棋盘格标定板为例,通过拍摄不同角度的标定板图像,提取角点坐标,结合已知的方格物理尺寸,可计算出相机的内外参数。该方法精度可达亚像素级,但需拍摄至少15组图像,且对标定板平整度、光照条件要求严格。

主动视觉标定法

无需标定物,但要求相机按预设轨迹运动(如平移、旋转)。通过分析运动过程中图像特征点的变化,结合已知位移数据,可反推出相机参数。例如,控制机械臂携带相机做圆周运动,利用特征点轨迹的圆心与半径,可求解相机的旋转与平移参数。该方法适用于无法放置标定物的场景但需高精度运动控制平台,成本较高。

自标定法

利用图像中的自然几何特征(如平行线、消失点)或场景结构(如建筑物边缘)计算相机参数。例如,通过检测多张图像中的平行线交点(消失点),可推导出相机的主点坐标与焦距。该方法灵活性强,但依赖环境特征,稳定性低于传统标定法。

总的来说,标定过程就像给机器做全身体检:先调整光圈焦距避免过曝(就像我们眯眼看强光),再用标定法计算内参(镜头的\"近视度数\"),最后通过手眼标定确定外参(\"脖子\"和\"身体\"的连接关系)。最终确保看到的画面严丝合缝。

三、视觉标定精度验证

同时,在标定过程中也需要注意现场环境条件,不然在精度验证环节很容易翻车。比如标定时没注意环境温湿度变化,结果早上合格的系统下午就\"老花眼\"了。所以现在高端方案都会加入温度补偿算法,就像给相机戴了恒温护目镜。另外震动也是隐形杀手,需要采用防震支架,否则流水线因为传送带抖动导致标定失效。

在智能制造浪潮中,视觉标定技术正朝着更高精度、更快速度、更强适应性的方向发展。从精密装配到自动驾驶,机器视觉标定技术如同工业世界的\"空间度量\",确保着虚拟像素与物理现实的精确对应。这项看似基础的技术,实则是智能制造大厦的基石。